#HMM

马尔可夫链(英语:Markov chain),又称离散时间马尔可夫链(discrete-time Markov chain,缩写为DTMC),因俄国数学家安德烈·马尔可夫(俄语:Андрей Андреевич Марков)得名,为状态空间中经过从一个状态到另一个状态的转换的随机过程。

隐马尔可夫模型包含5个要素:初始概率分布,状态转移概率分布,观测概率分布,所有可能状态的集合,所有可能观测的集合。

隐马尔可夫模型HMM是结构最简单的动态贝叶斯网络,是有向图模型。

#注意要点

- ##两点马尔可夫性质:[可以理解为无记忆性;留意:NLP问题会涉及

- ###下一个状态的概率分布只与当前状态有关

- ###下个时刻的观测只与其相对应的状态有关

- ##最大熵马尔可夫模型为什么会产生标注偏置问题?如何解决?

- ##HMM为什么是生成模型

- ####因为HMM直接对联合概率分布建模;相对而言,条件随机场CRF直接对条件概率建模,所以判别模型。

- ####HMM在处理NLP词性标注和实体识别任务中的局限性

- ####在序列标注问题,隐状态(标注)不仅和单个观测状态相关,还和观察序列的长度、上下文等信息相关。例如词性标注问题中,一个词被标注为动词还是名词,不仅与它本身前一个词的标注有关,还依赖于上下文的其他词

- 隐马尔可夫模型包括概率计算问题、预测问题、学习问题三个基本问题

-

(1)概率计算问题:已知模型的所有参数,计算观测序列Y出现的概率,可 使用前向和后向算法求解。

(2)预测问题:已知模型所有参数和观测序列Y,计算最可能的隐状态序 列X,可使用经典的动态规划算法——维特比算法来求解最可能的状态序列。

(3)学习问题:已知观测序列Y,求解使得该观测序列概率最大的模型参 数,包括隐状态序列、隐状态之间的转移概率分布以及从隐状态到观测状态的概 率分布,可使用Baum-Welch算法进行参数的学习,Baum-Welch算法是最大期望算 法的一个特例。##浅谈最大熵模型

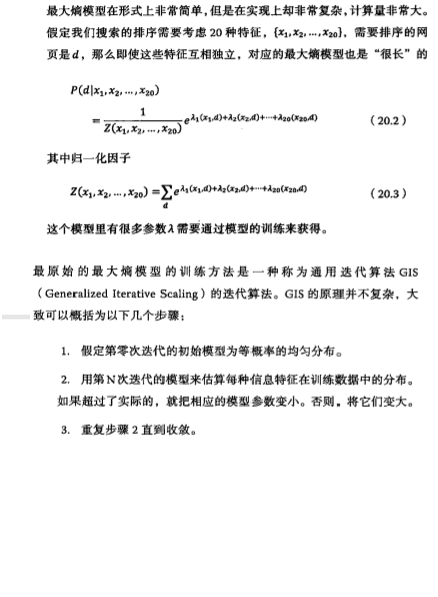

最大熵就是保留全部的不确定性,将风险降到最小。

应用在词性标注,语法分析机器翻译等NLP任务中。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?