1.定义

Kafka传统定义: Kafka是一个分布式的基于发布/订阅模式的消息队列(MessageQueue) ,主要应用于大数据实时处理领域。

发布/订阅:消息的发布者不会将消息直接发送给特定的订阅者,而是将发布的消息分为不同的类别,订阅者只接收感兴趣的消息

Kafka最新定义:Kafka是一个开源的分布式事件流平台 (Event StreamingPlatform),被数千家公司用于高性能数据管道、流分析、数据集成和关键任务应用

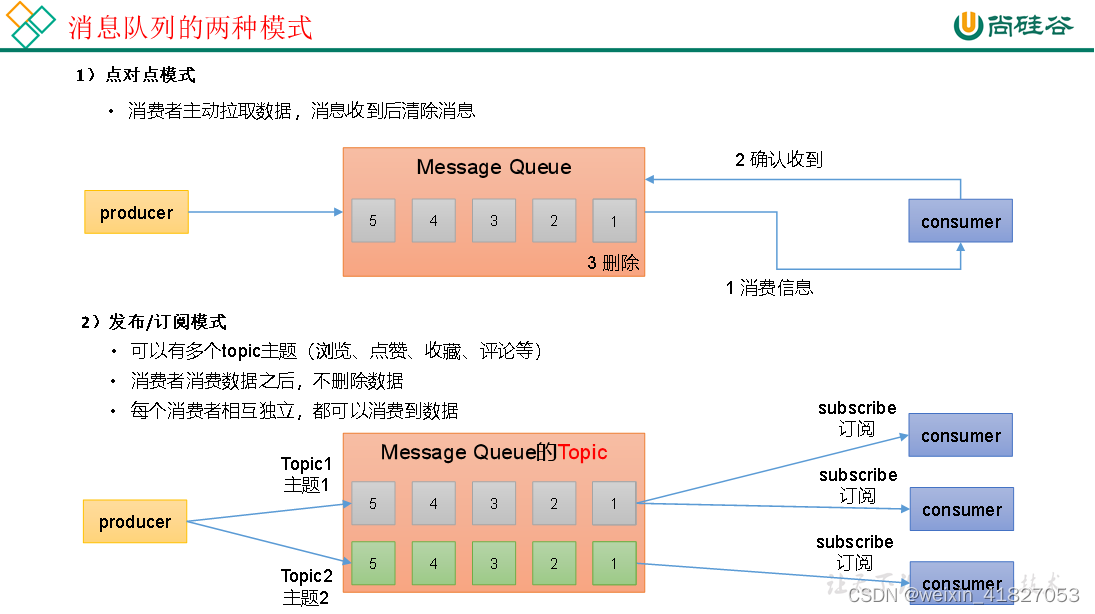

2.消息队列的两种方式

点对点模式

发布订阅模式

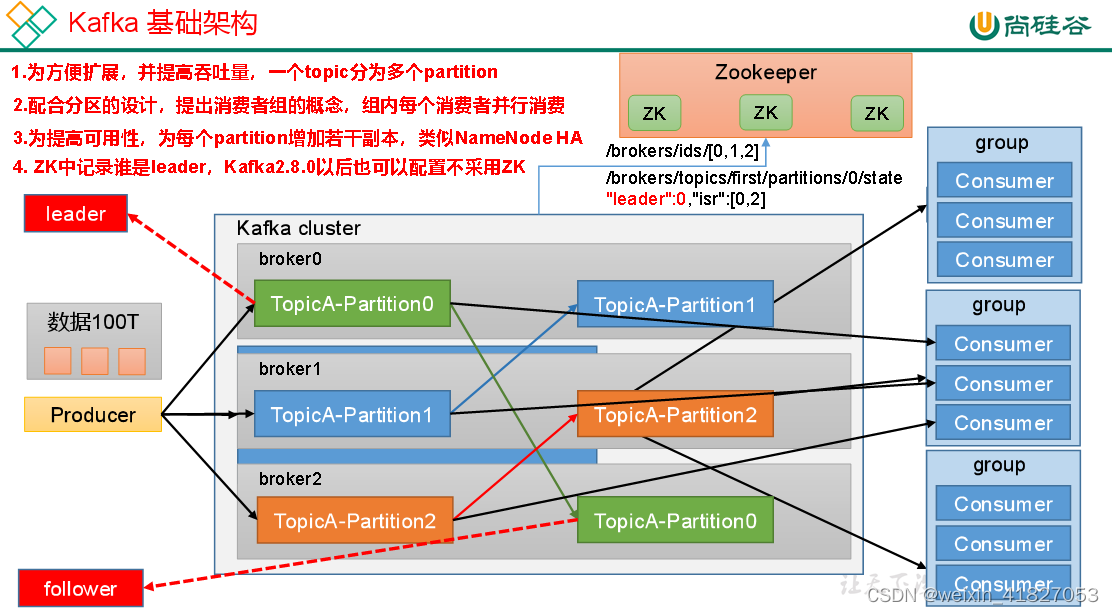

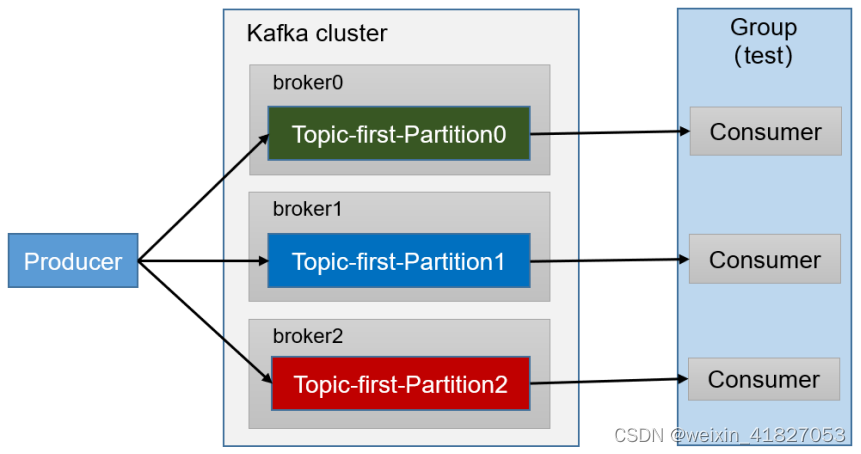

3.Kafka基础架构

(1)Producer:消息生产者,就是向Kafka broker发消息的客户端。

(2)Consumer:消息消费者,向Kafka broker取消息的客户端。

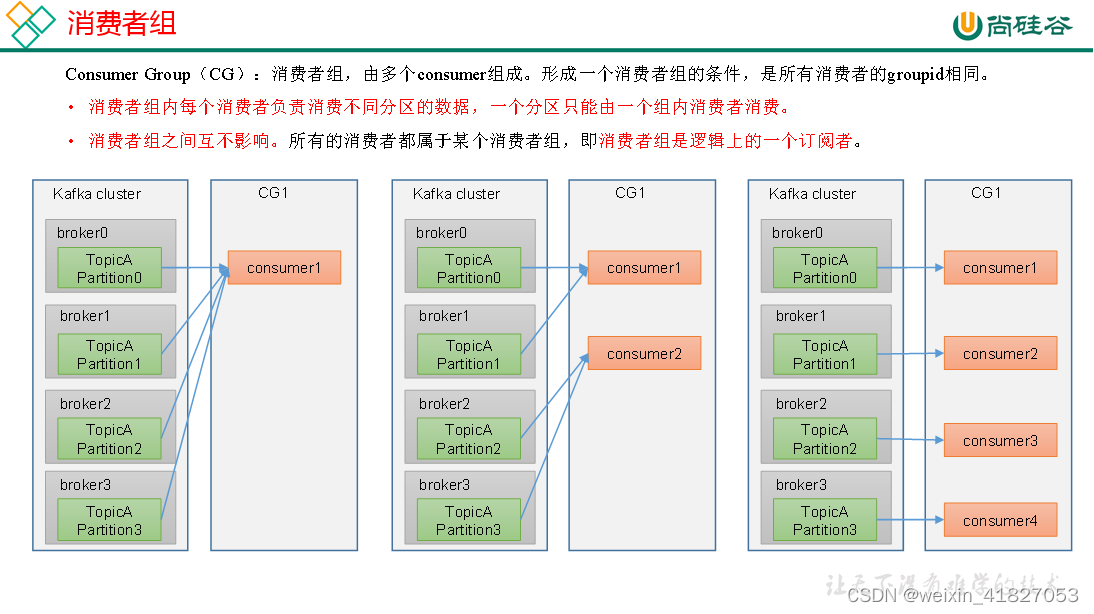

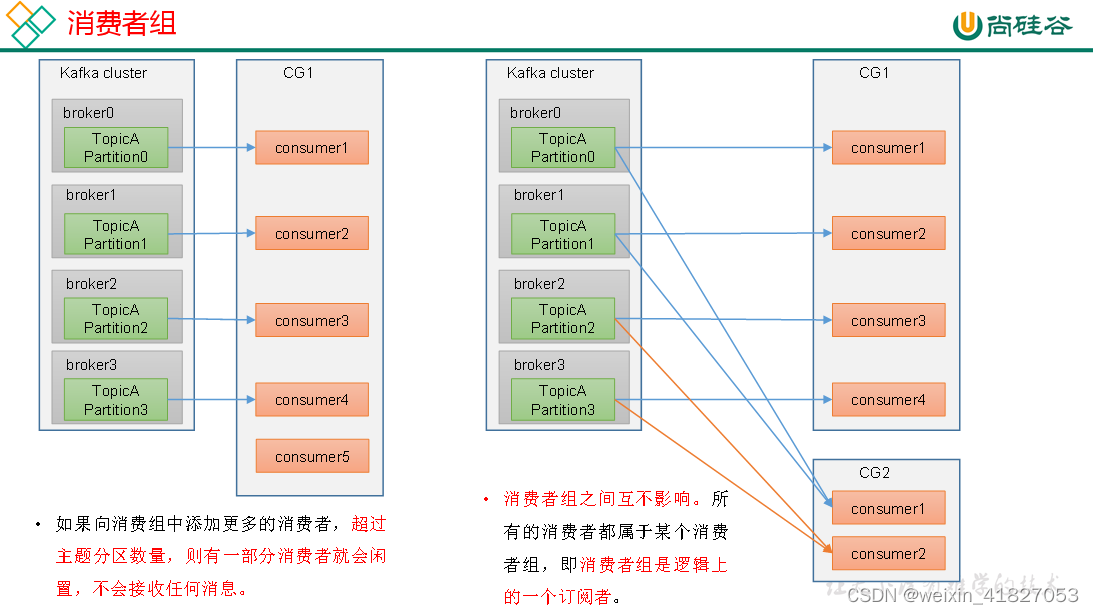

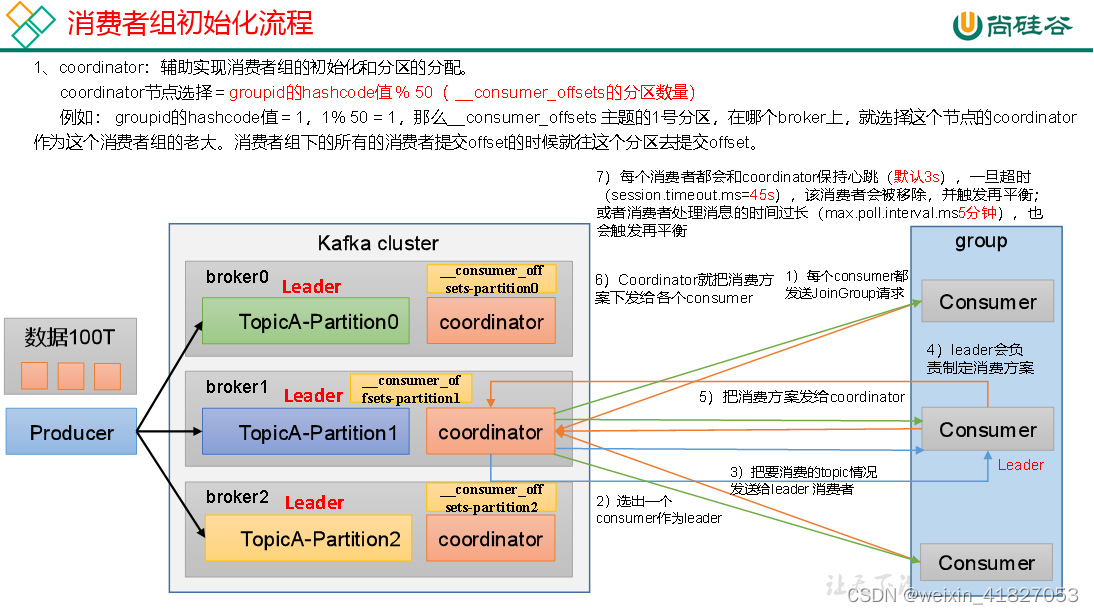

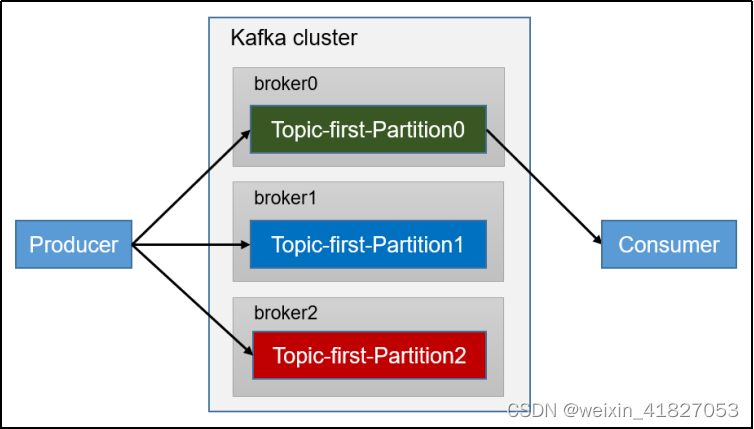

(3)Consumer Group(CG):消费者组,由多个consumer组成。消费者组内每个消费者负责消费不同分区的数据,一个分区只能由一个组内消费者消费;消费者组之间互不影响。所有的消费者都属于某个消费者组,即消费者组是逻辑上的一个订阅者。

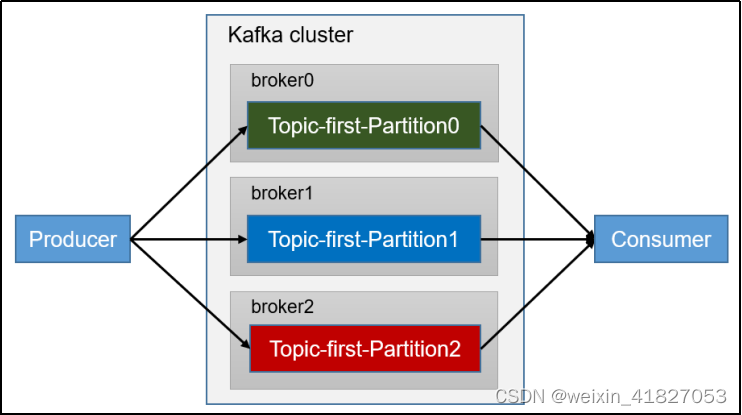

(4)Broker:一台Kafka服务器就是一个broker。一个集群由多个broker组成。一个broker可以容纳多个topic。

(5)Topic:可以理解为一个队列,生产者和消费者面向的都是一个topic。

(6)Partition:为了实现扩展性,一个非常大的topic可以分布到多个broker(即服务器)上,一个topic可以分为多个partition,每个partition是一个有序的队列。

(7)Replica:副本。一个topic的每个分区都有若干个副本,一个Leader和若干个Follower。

(8)Leader:每个分区多个副本的“主”,生产者发送数据的对象,以及消费者消费数据的对象都是Leader。

(9)Follower:每个分区多个副本中的“从”,实时从Leader中同步数据,保持和Leader数据的同步。Leader发生故障时,某个Follower会成为新的Leader。

4.Kafka生产者

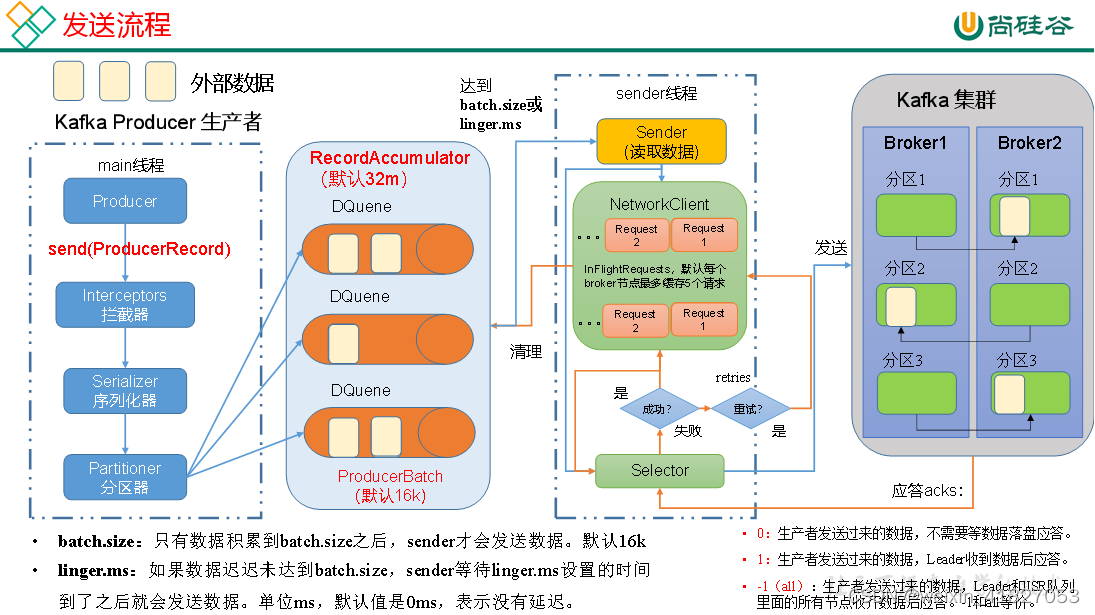

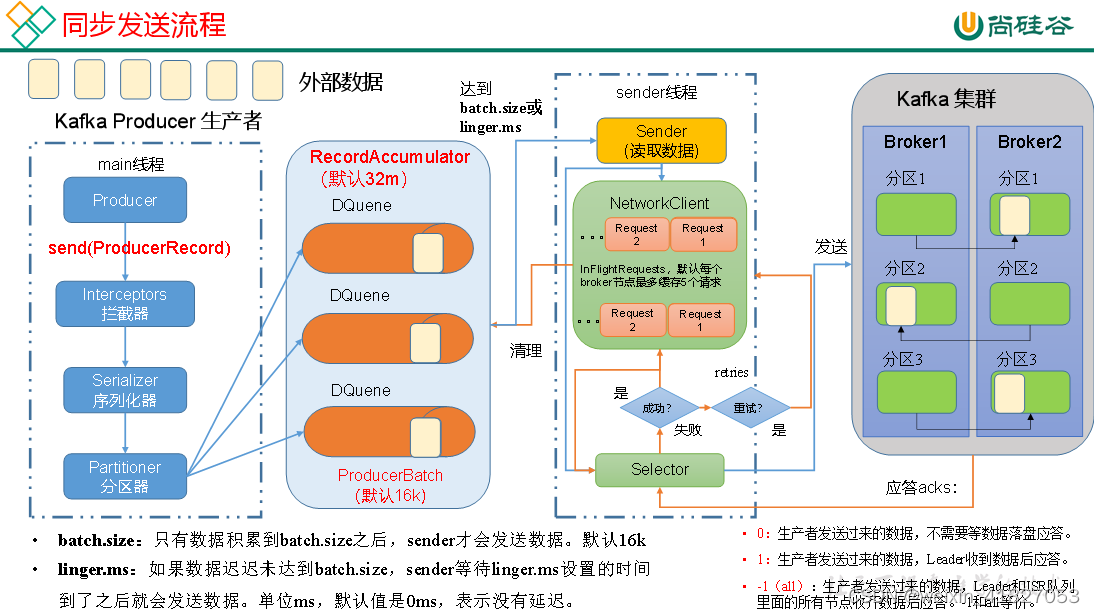

4.1 发送原理

在消息发送的过程中,涉及到了两个线程——main线程和Sender线程。在main线程中创建了一个双端队列RecordAccumulator。main线程将消息发送给RecordAccumulator,Sender线程不断从RecordAccumulator中拉取消息发送到Kafka Broker。

4.2 生产者重要参数列表

| 参数名称 | 描述 |

|---|---|

| bootstrap.servers | 生产者连接集群所需的broker地址清单。例如hadoop102:9092,hadoop103:9092,hadoop104:9092,可以设置1个或者多个,中间用逗号隔开。注意这里并非需要所有的broker地址,因为生产者从给定的broker里查找到其他broker信息。 |

| key.serializer和value.serializer | 指定发送消息的key和value的序列化类型。一定要写全类名。 |

| buffer.memory | RecordAccumulator缓冲区总大小,默认32m。 |

| batch.size | 缓冲区一批数据最大值,默认16k。适当增加该值,可以提高吞吐量,但是如果该值设置太大,会导致数据传输延迟增加。 |

| linger.ms | 如果数据迟迟未达到batch.size,sender等待linger.time之后就会发送数据。单位ms,默认值是0ms,表示没有延迟。生产环境建议该值大小为5-100ms之间。 |

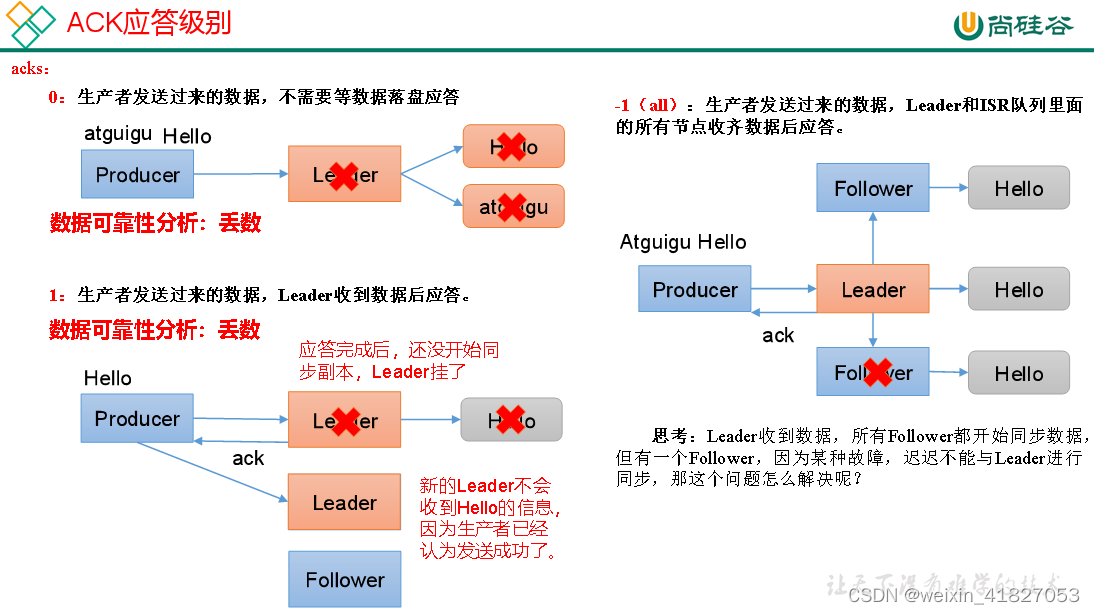

| acks | 0:生产者发送过来的数据,不需要等数据落盘应答。1:生产者发送过来的数据,Leader收到数据后应答。 -1(all):生产者发送过来的数据,Leader+和isr队列里面的所有节点收齐数据后应答。默认值是-1,-1和all是等价的。 |

| max.in.flight.requests.per.connection | 允许最多没有返回ack的次数,默认为5,开启幂等性要保证该值是 1-5的数字。 |

| retries | 当消息发送出现错误的时候,系统会重发消息。retries表示重试次数。默认是int最大值,2147483647。如果设置了重试,还想保证消息的有序性,需要设置MAX_IN_FLIGHT_REQUESTS_PER_CONNECTION=1否则在重试此失败消息的时候,其他的消息可能发送成功了。 |

| retry.backoff.ms | 两次重试之间的时间间隔,默认是100ms。 |

| enable.idempotence 是否开启幂等性,默认true,开启幂等性。 | |

| compression.type | 生产者发送的所有数据的压缩方式。默认是none,也就是不压缩。 支持压缩类型:none、gzip、snappy、lz4和zstd。 |

4.3 同步发送、异步发送

普通异步发送

kafkaProducer.send(new ProducerRecord<>("first","atguigu " + i));

带回调函数的异步发送

回调函数会在producer收到ack时调用,为异步调用,该方法有两个参数,分别是元数据信息(RecordMetadata)和异常信息(Exception),如果Exception为null,说明消息发送成功,如果Exception不为null,说明消息发送失败。

// 添加回调

kafkaProducer.send(new ProducerRecord<>("first", "atguigu " + i), new Callback() {

// 该方法在Producer收到ack时调用,为异步调用

@Override

public void onCompletion(RecordMetadata metadata, Exception exception) {

if (exception == null) {

// 没有异常,输出信息到控制台

System.out.println("主题:" + metadata.topic() + "->" + "分区:" + metadata.partition());

} else {

// 出现异常打印

exception.printStackTrace();

}

}

});

同步发送

只需在异步发送的基础上,再调用一下get()方法即可

// 同步发送

kafkaProducer.send(new ProducerRecord<>("first","kafka" + i)).get();

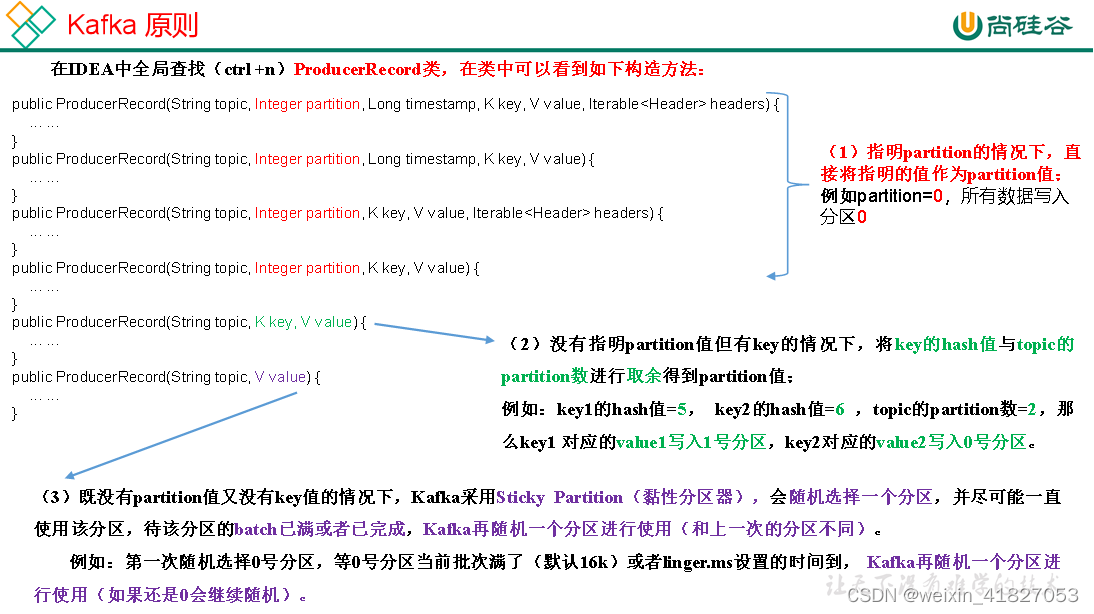

4.4 生产者分区策略

将数据发往指定partition的情况下,例如,将所有数据发往分区1中

// 指定数据发送到1号分区,key为空(IDEA中ctrl + p查看参数)

kafkaProducer.send(new ProducerRecord<>("first", 1,"","atguigu " + i), new Callback() {

@Override

public void onCompletion(RecordMetadata metadata, Exception e) {

if (e == null){

System.out.println("主题:" + metadata.topic() + "->" + "分区:" + metadata.partition()

);

}else {

e.printStackTrace();

}

}

});

没有指明partition值但有key的情况下,将key的hash值与topic的partition数进行取余得到partition值。

// 依次指定key值为a,b,f ,数据key的hash值与3个分区求余,分别发往1、2、0

kafkaProducer.send(new ProducerRecord<>("first", "a","atguigu " + i), new Callback() {

@Override

public void onCompletion(RecordMetadata metadata, Exception e) {

if (e == null){

System.out.println("主题:" + metadata.topic() + "->" + "分区:" + metadata.partition()

);

}else {

e.printStackTrace();

}

}

});

4.5 数据可靠性

思考: Leader收到数据,所有Follower都开始同步数据,但有-个Follower,因为某种故障,迟迟不能与Leader进行同步,那这个问题怎么解决呢?

Leader维护了一个动态的in-sync replica set (ISR),意为和Lcader保持同步的Follower+Lcader集合(leader: 0,isr:0,1,2)。

如果Follower长时间未向Leader发送通信请求或同步数据,则该Follower将被踢出ISR。该时间阈值由replica.lag.time.maxm.ms参数设定,默认30s。例如2超时,(leader:0, isr:0,1)

这样就不用等长期联系不上或者已经故障的节点。

数据可靠性分析

如果分区副本设置为1个,或者ISR里应答的最小副本数量(min.insync.replicas

默认为1)设置为1,和ack=1的效果是样的,仍然有丢数的风险(leader: 0,isr:0)

数据完全可靠条件=ACK级别设置为-1+ 分区副本大于等于2+ ISR里应答的最小副本数量大于等于2

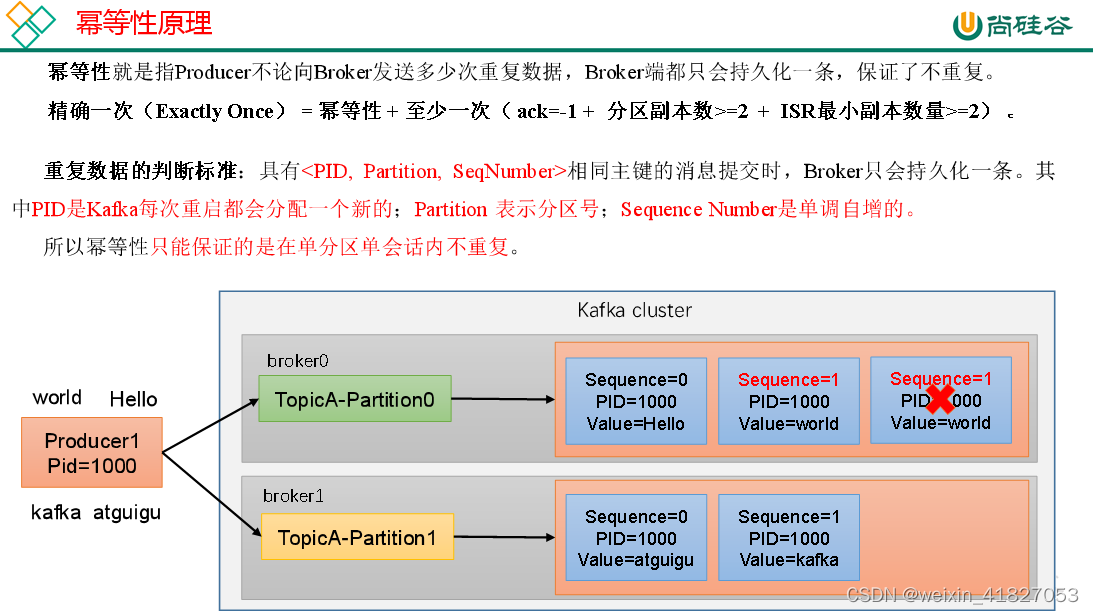

4.6 数据去重

4.6.1 幂等性

如何使用幂等性

如何使用幂等性

开启参数enable.idempotence 默认为true,false关闭。

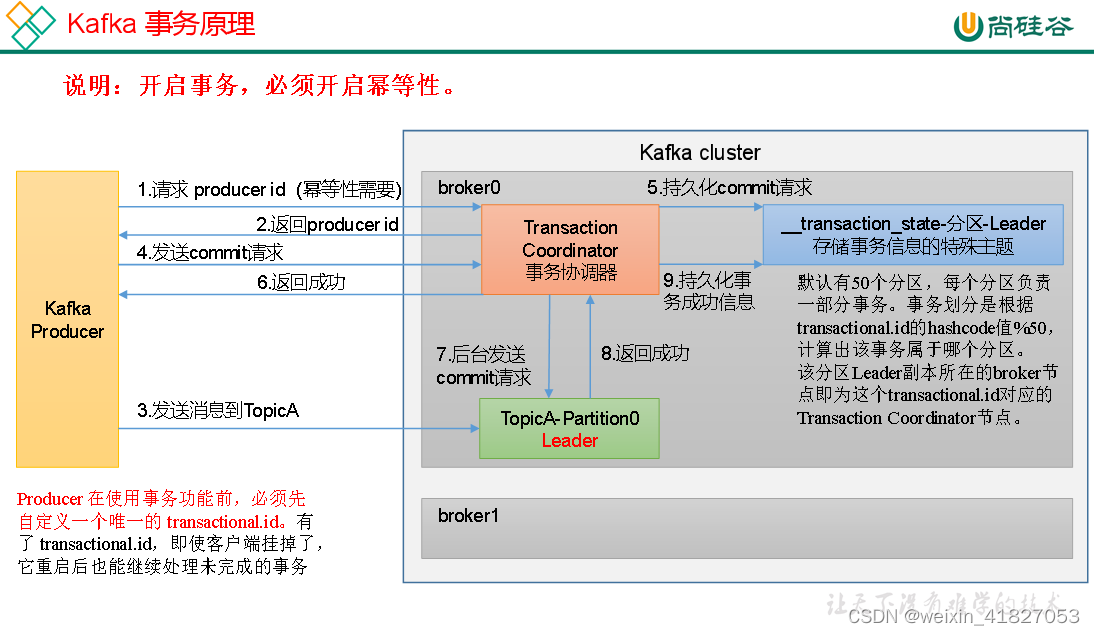

4.6.2 生产者事务

Kafka事务原理

开启事务,必须开启幂等性

Producer在使用事务功能钱,必须先自定义一个唯一的transactionl_id。有了transactionl_id,即使客户端挂掉了,它重启后也能继续处理维完成的事务

Kafka事务API

// 1初始化事务

void initTransactions();

// 2开启事务

void beginTransaction() throws ProducerFencedException;

// 3在事务内提交已经消费的偏移量(主要用于消费者)

void sendOffsetsToTransaction(Map<TopicPartition, OffsetAndMetadata> offsets, String consumerGroupId) throws ProducerFencedException;

// 4提交事务

void commitTransaction() throws ProducerFencedException;

// 5放弃事务(类似于回滚事务的操作)

void abortTransaction() throws ProducerFencedException;

单个Producer,使用事务保证消息的仅一次发送

package com.atguigu.kafka.producer;

import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.ProducerRecord;

import java.util.Properties;

public class CustomProducerTransactions {

public static void main(String[] args) throws InterruptedException {

// 1. 创建kafka生产者的配置对象

Properties properties = new Properties();

// 2. 给kafka配置对象添加配置信息

properties.put(ProducerConfig.BOOTSTRAP_SERVERS_CONFIG, "hadoop102:9092");

// key,value序列化

properties.put(ProducerConfig.KEY_SERIALIZER_CLASS_CONFIG, StringSerializer.class.getName());

properties.put(ProducerConfig.VALUE_SERIALIZER_CLASS_CONFIG, StringSerializer.class.getName());

// 设置事务id(必须),事务id任意起名

properties.put(ProducerConfig.TRANSACTIONAL_ID_CONFIG, "transaction_id_0");

// 3. 创建kafka生产者对象

KafkaProducer<String, String> kafkaProducer = new KafkaProducer<String, String>(properties);

// 初始化事务

kafkaProducer.initTransactions();

// 开启事务

kafkaProducer.beginTransaction();

try {

// 4. 调用send方法,发送消息

for (int i = 0; i < 5; i++) {

// 发送消息

kafkaProducer.send(new ProducerRecord<>("first", "atguigu " + i));

}

// int i = 1 / 0;

// 提交事务

kafkaProducer.commitTransaction();

} catch (Exception e) {

// 终止事务

kafkaProducer.abortTransaction();

} finally {

// 5. 关闭资源

kafkaProducer.close();

}

}

}

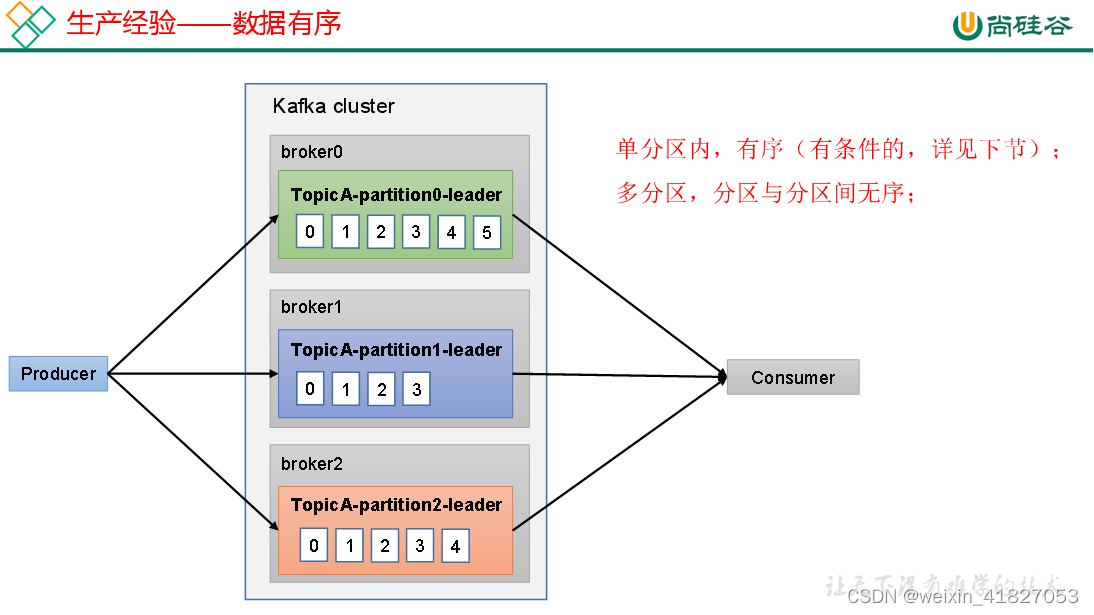

4.7 数据有序

单分区内,有序

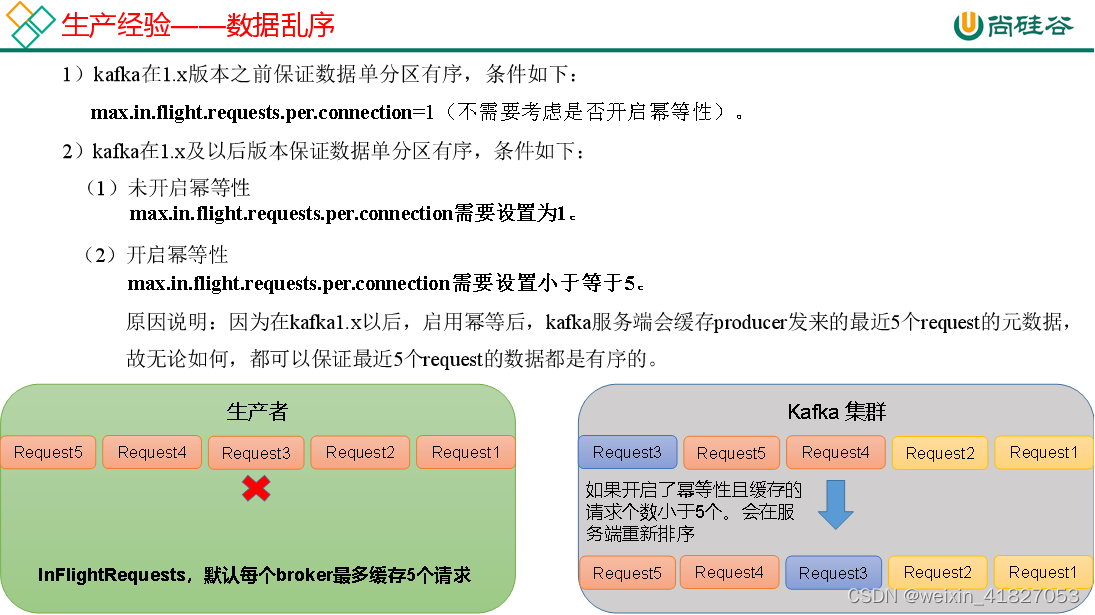

- kafka在1.x版本之前保证数据单分区有序,条件如下:

maxinflightrequestsperconnection=1(不需要考虑是否开启幂等性)。2) kafka在1.x及以后版本保证数据单分区有序,条件如下:(1)未开启幂等性maxin.flightrequests.per.connection需要设置为1

(2)开启幂等性maxinflight.requests.per.connection需要设置小于等于5原因说明:因为在kafkal.x以后,启用幂等后,kaka服务端会缓存producer发来的最近5个request的元数据故无论如何,都可以保证最近5个request的数据都是有序的。

4.8 数据乱序

5. Kafka Broker

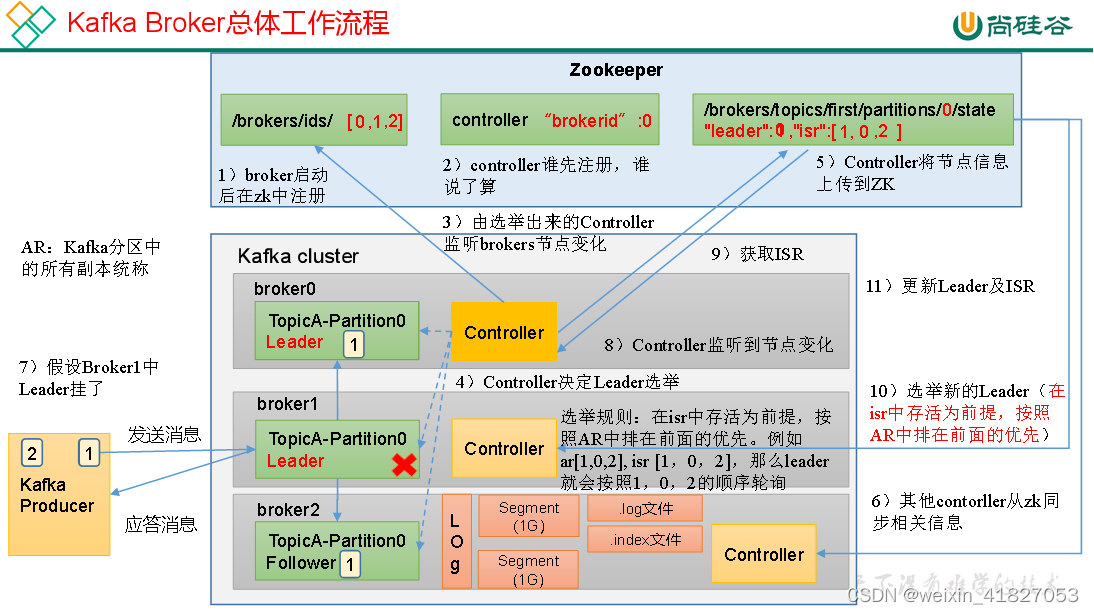

5.1 Kafka Broker 工作流程

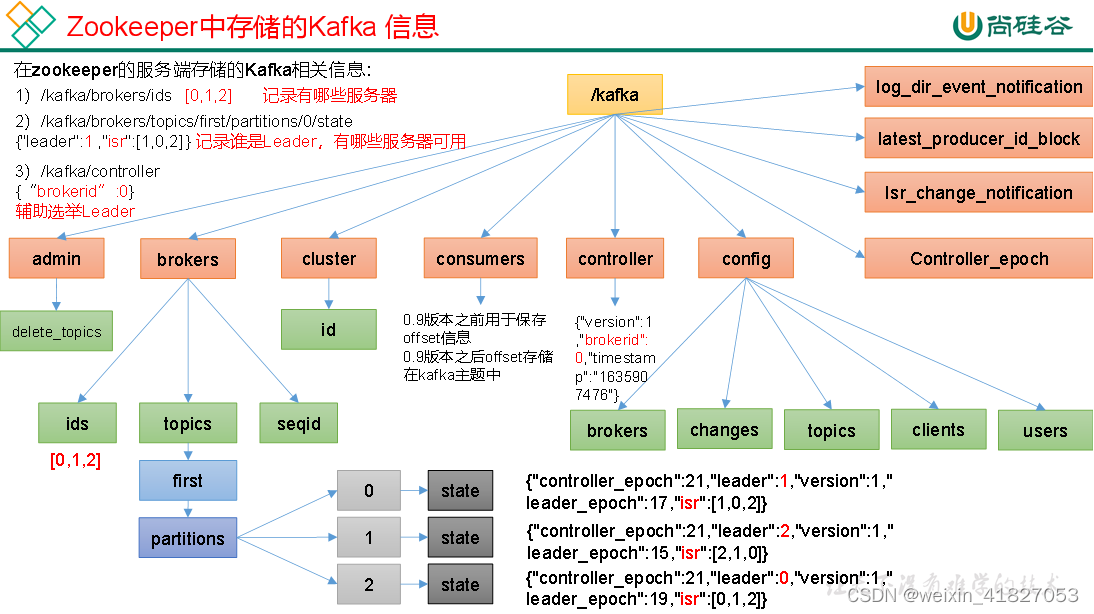

5.1.1 Zookeeper存储的Kafka信息

5.1.2 Kafka Broker 总体工作流程

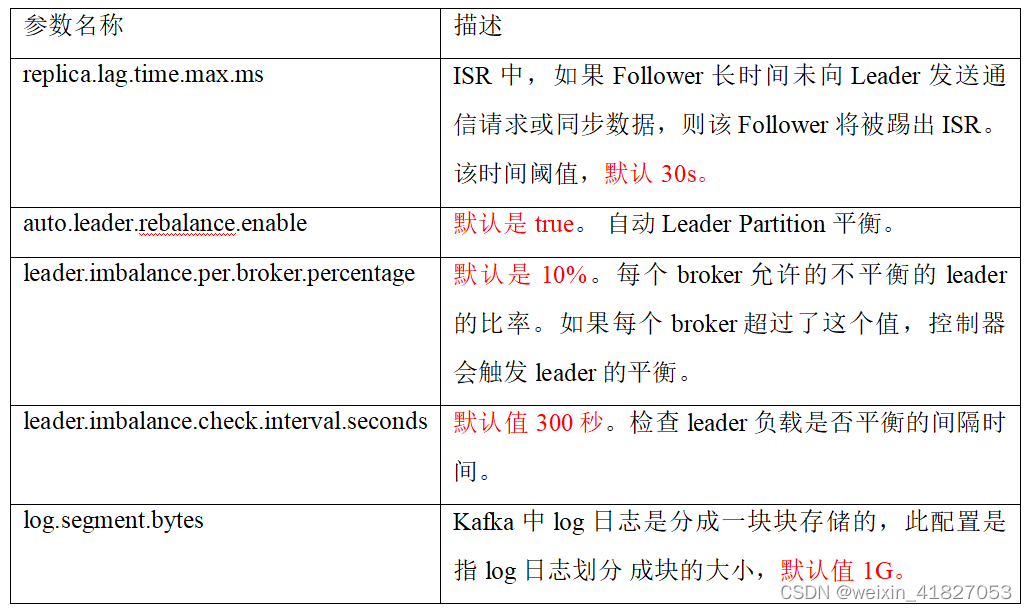

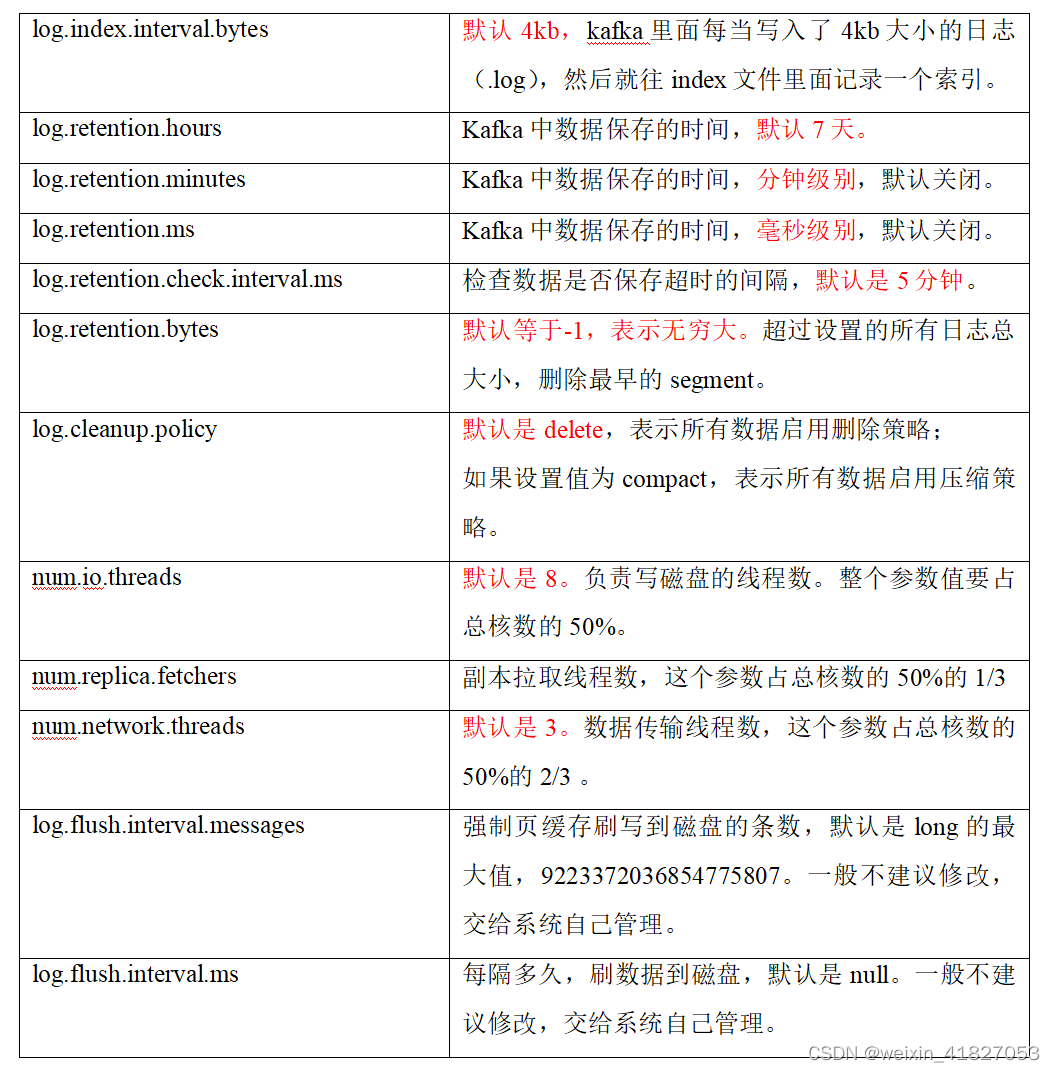

5.1.3 Broker重要参数

5.2 Kafka副本

5.2.1 副本基本信息

(1)Kafka副本作用:提高数据可靠性。

(2)Kafka默认副本1个,生产环境一般配置为2个,保证数据可靠性;太多副本会增加磁盘存储空间,增加网络上数据传输,降低效率。

(3)Kafka中副本分为:Leader和Follower。Kafka生产者只会把数据发往Leader,然后Follower找Leader进行同步数据。

(4)Kafka分区中的所有副本统称为AR(Assigned Repllicas)。

AR = ISR + OSR

ISR,表示和Leader保持同步的Follower集合。如果Follower长时间未向Leader发送通信请求或同步数据,则该Follower将被踢出ISR。该时间阈值由replica.lag.time.max.ms参数设定,默认30s。Leader发生故障之后,就会从ISR中选举新的Leader。

OSR,表示Follower与Leader副本同步时,延迟过多的副本。

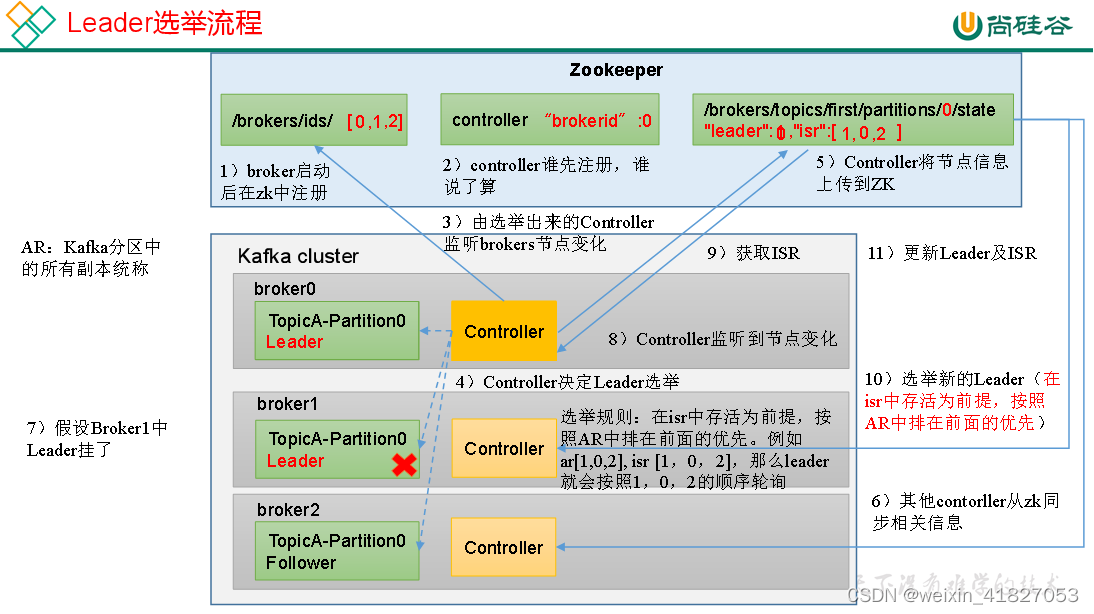

5.2.2 Leader选举流程

Kafka集群中有一个broker的Controller会被选举为Controller Leader,负责管理集群broker的上下线,所有topic的分区副本分配和Leader选举等工作。

Controller的信息同步工作是依赖于Zookeeper的。

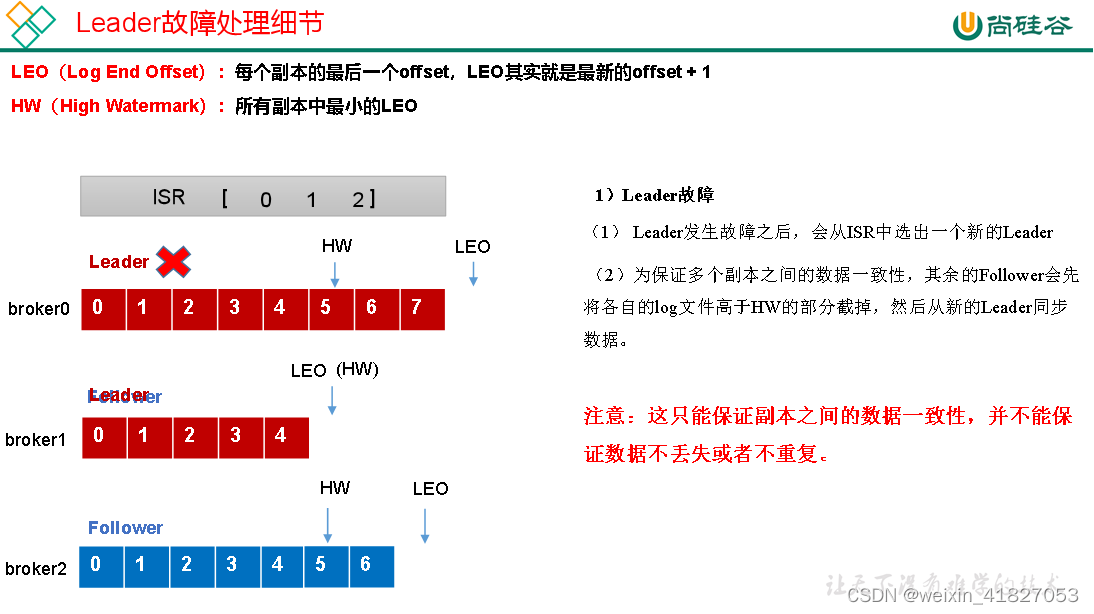

5.2.3 Leader和Follower故障处理细节

5.2.4 分区副本分配

如果kafka服务器只有4个节点,那么设置kafka的分区数大于服务器台数,在kafka底层如何分配存储副本呢?

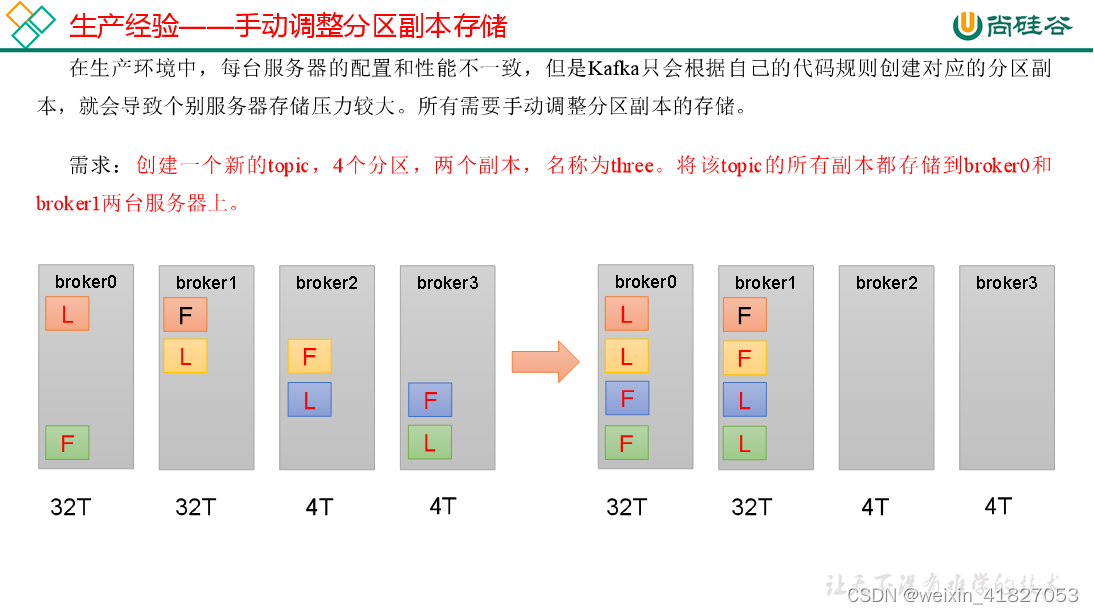

5.2.5 手动调整分区副本存储

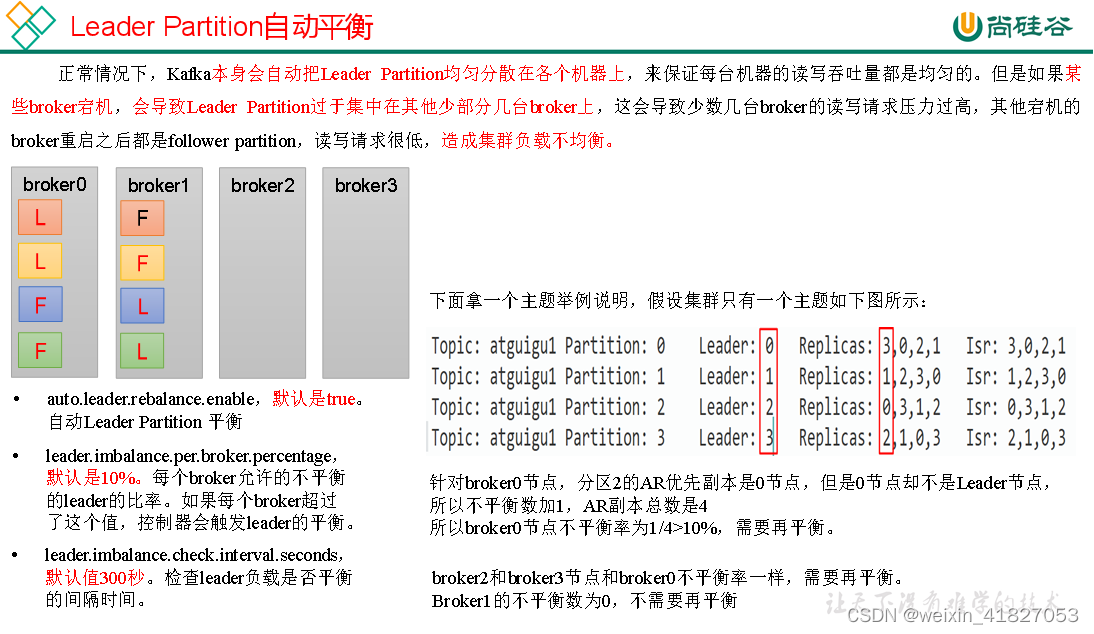

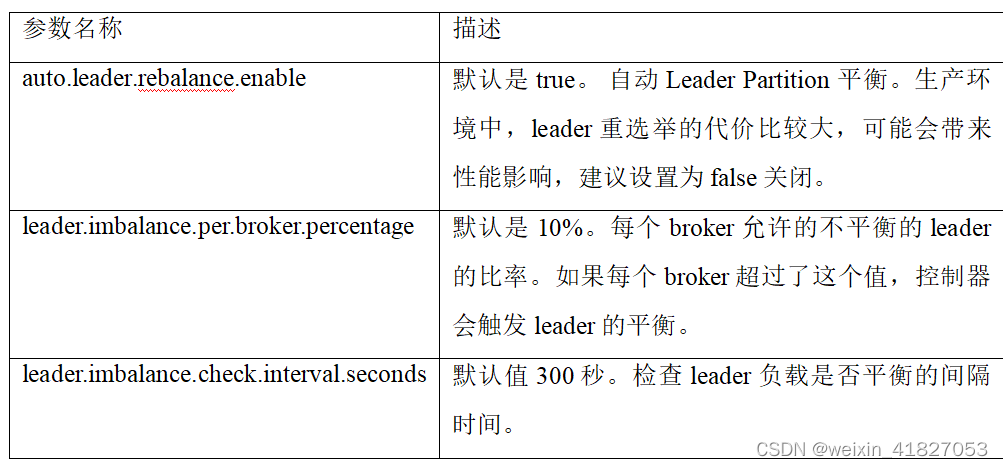

5.2.6 Leader Partition负载平衡

5.3 文件存储

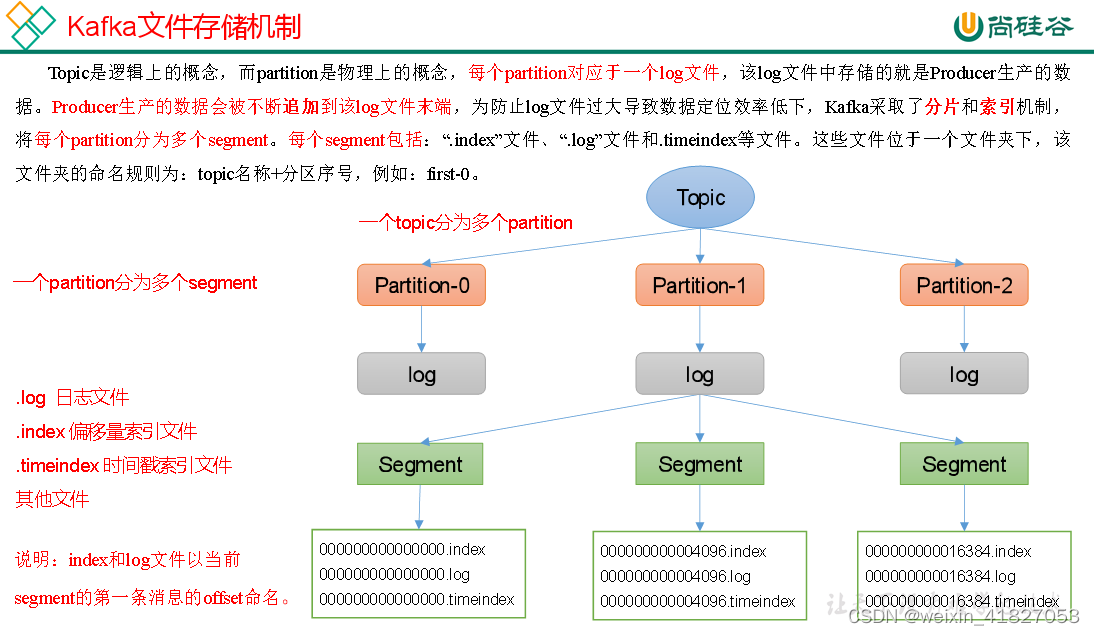

5.3.1 文件存储机制

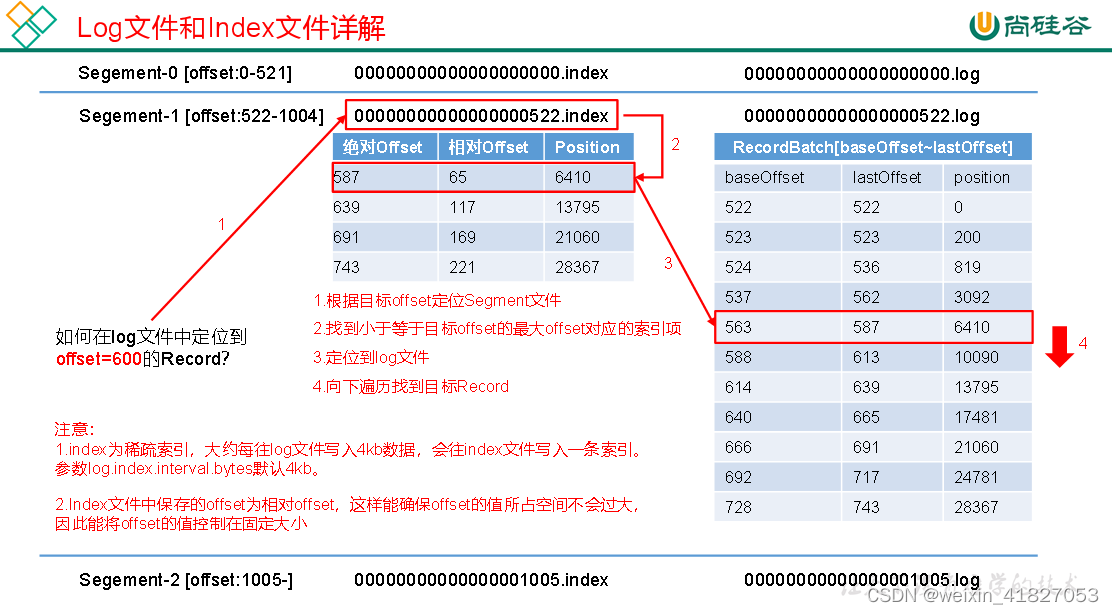

Topic数据的存储机制

| 参数 | 描述 |

| log.segment.bytes | Kafka中log日志是分成一块块存储的,此配置是指log日志划分 成块的大小,默认值1G。 |

| log.index.interval.bytes | 默认4kb,kafka里面每当写入了4kb大小的日志(.log),然后就往index文件里面记录一个索引。 稀疏索引。 |

5.3.2 文件清理策略

Kafka中默认的日志保存时间为7天,可以通过调整如下参数修改保存时间。

log.retention.hours,最低优先级小时,默认7天。

log.retention.minutes,分钟。

log.retention.ms,最高优先级毫秒。

log.retention.check.interval.ms,负责设置检查周期,默认5分钟。

那么日志一旦超过了设置的时间,怎么处理呢?

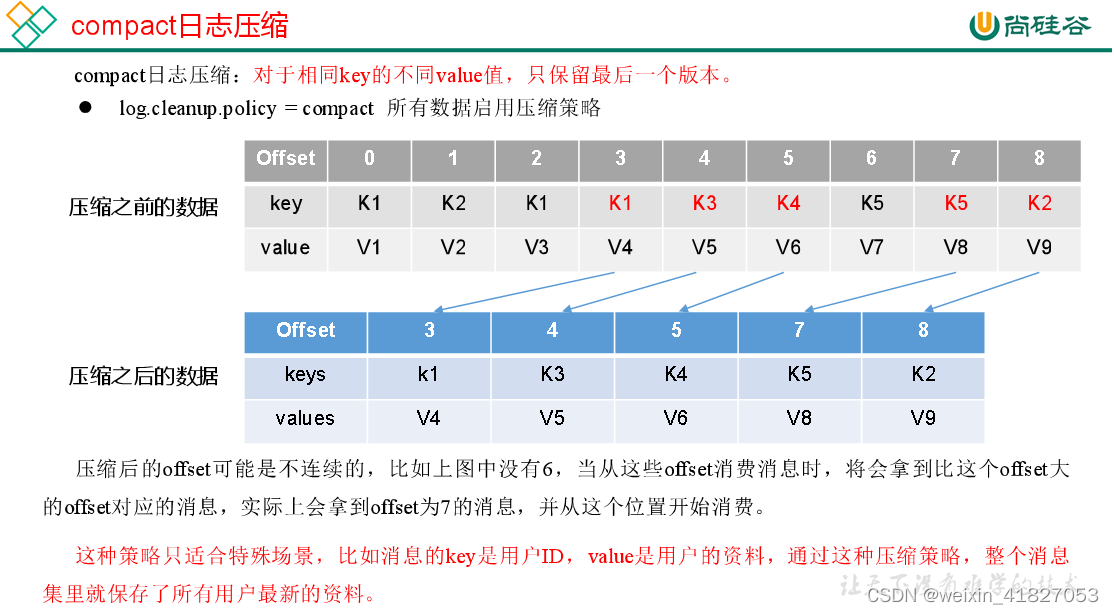

Kafka中提供的日志清理策略有delete和compact两种。

delete日志删除:将过期数据删除

log.cleanup.policy = delete 所有数据启用删除策略

(1)基于时间:默认打开。以segment中所有记录中的最大时间戳作为该文件时间戳。

(2)基于大小:默认关闭。超过设置的所有日志总大小,删除最早的segment。

log.retention.bytes,默认等于-1,表示无穷大。

思考:如果一个segment中有一部分数据过期,一部分没有过期,怎么处理?

compact日志压缩

5.4 高效读写数据

Kafka本身是分布式集群,可以采用分区技术,并行度高

读数据采用稀疏索引,可以快速定位要消费的数据

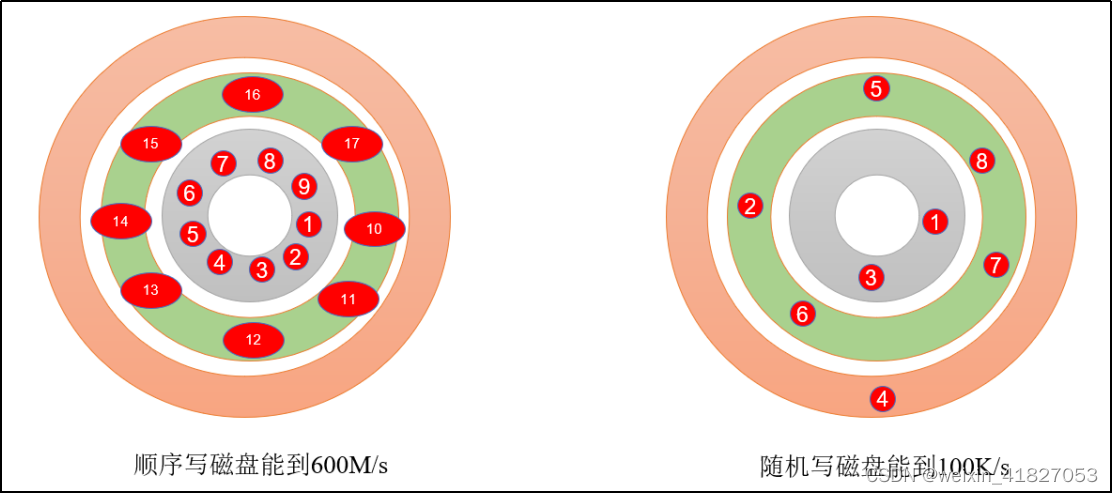

顺序写磁盘

Kafka的producer生产数据,要写入到log文件中,写的过程是一直追加到文件末端,为顺序写。官网有数据表明,同样的磁盘,顺序写能到600M/s,而随机写只有100K/s。这与磁盘的机械机构有关,顺序写之所以快,是因为其省去了大量磁头寻址的时间。

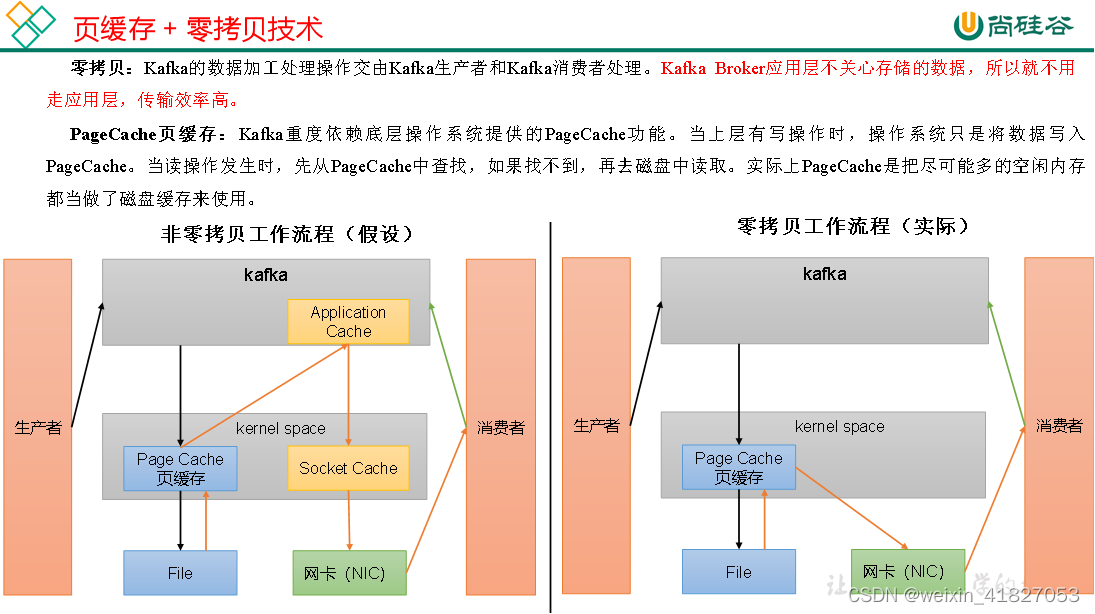

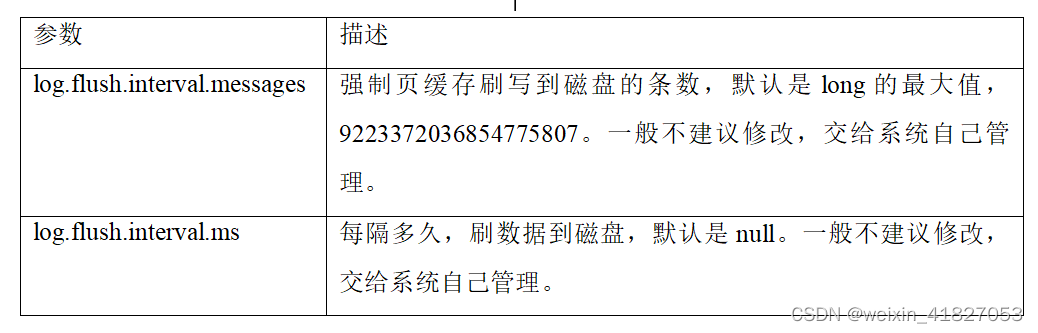

页缓存 + 零拷贝技术

6 Kafka消费者

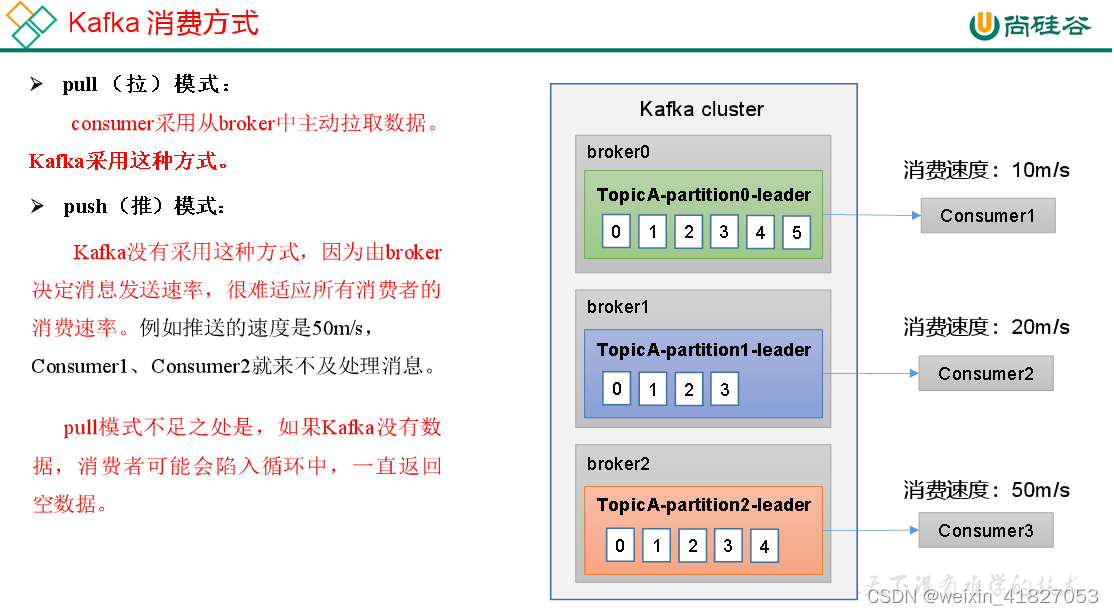

6.1 Kafka消费方式

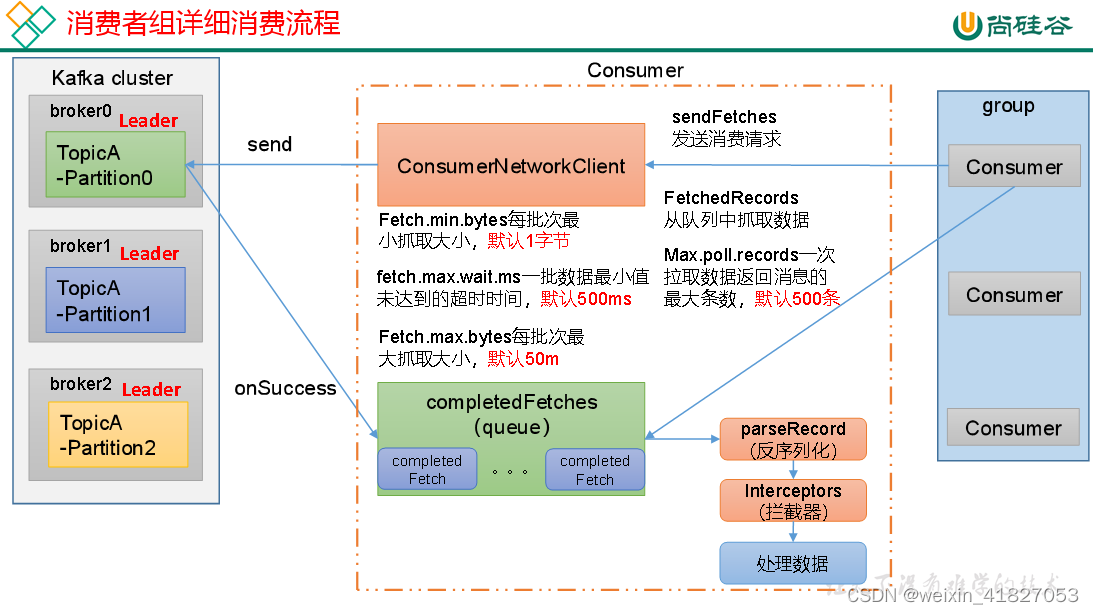

Kafka采用的pull(拉)模式:

consumer从broker中主动拉取数据。

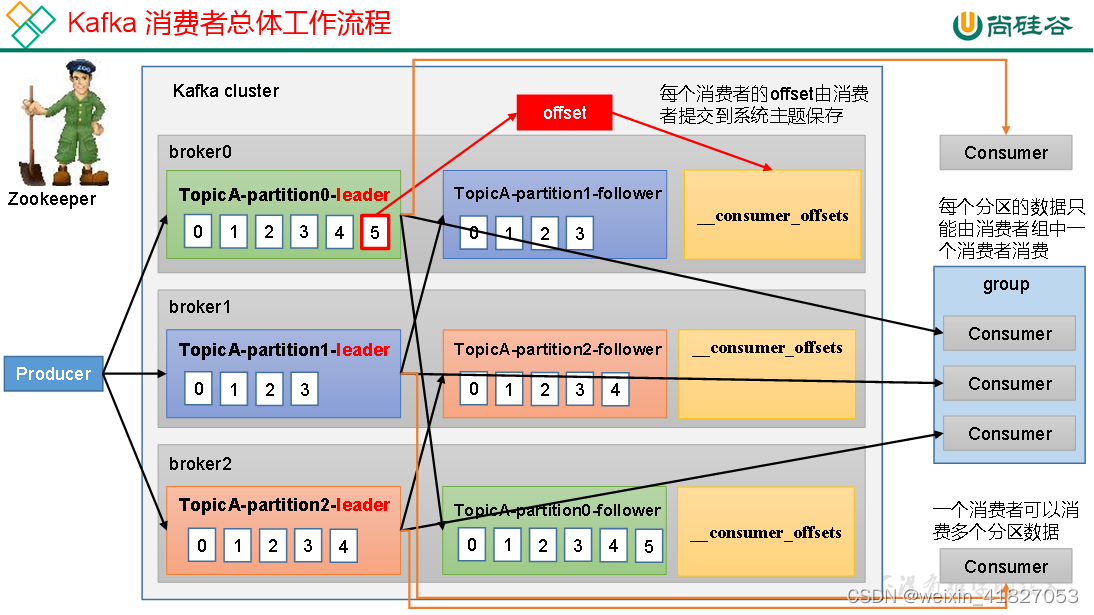

6.2 Kafka消费者工作流程

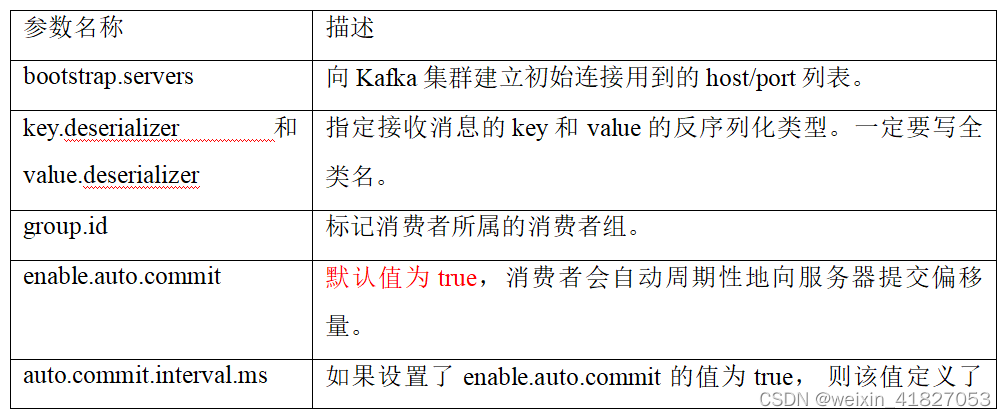

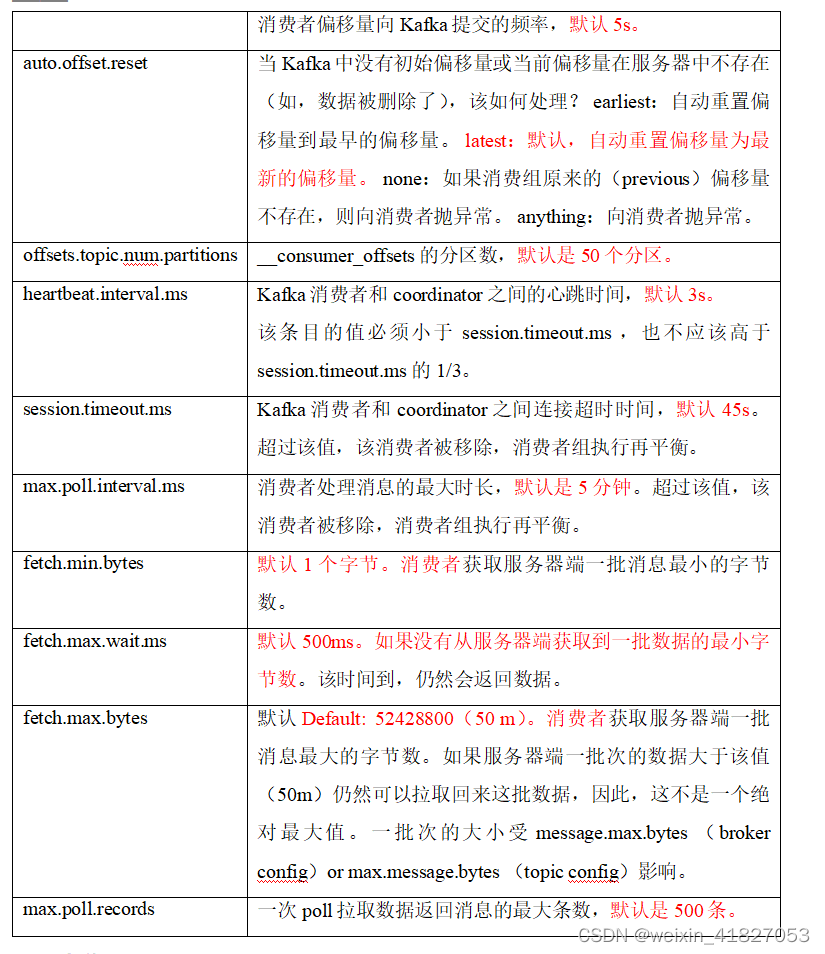

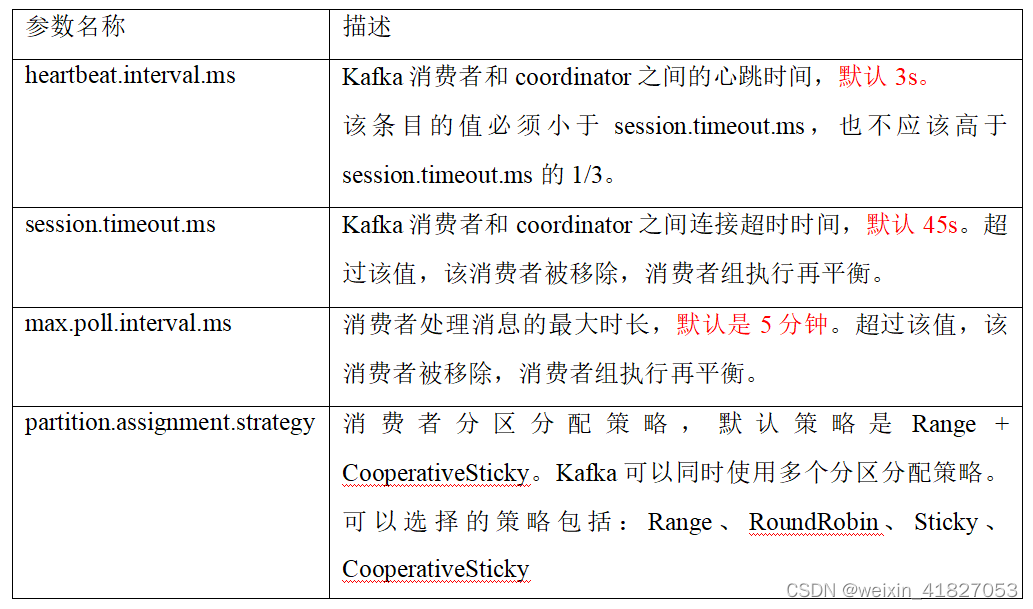

消费者重要参数

6.3 消费者API

6.3.1 独立消费者案例(订阅主题)

注意:在消费者API代码中必须配置消费者组id。命令行启动消费者不填写消费者组id会被自动填写随机的消费者组id。

package com.atguigu.kafka.consumer;

import org.apache.kafka.clients.consumer.ConsumerConfig;

import org.apache.kafka.clients.consumer.ConsumerRecord;

import org.apache.kafka.clients.consumer.ConsumerRecords;

import org.apache.kafka.clients.consumer.KafkaConsumer;

import java.time.Duration;

import java.util.ArrayList;

import java.util.Properties;

public class CustomConsumer {

public static void main(String[] args) {

// 1.创建消费者的配置对象

Properties properties = new Properties();

// 2.给消费者配置对象添加参数

properties.put(ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG, "hadoop102:9092");

// 配置序列化 必须

properties.put(ConsumerConfig.KEY_DESERIALIZER_CLASS_CONFIG, StringDeserializer.class.getName());

properties.put(ConsumerConfig.VALUE_DESERIALIZER_CLASS_CONFIG, StringDeserializer.class.getName());

// 配置消费者组(组名任意起名) 必须

properties.put(ConsumerConfig.GROUP_ID_CONFIG, "test");

// 创建消费者对象

KafkaConsumer<String, String> kafkaConsumer = new KafkaConsumer<String, String>(properties);

// 注册要消费的主题(可以消费多个主题)

ArrayList<String> topics = new ArrayList<>();

topics.add("first");

kafkaConsumer.subscribe(topics);

// 拉取数据打印

while (true) {

// 设置1s中消费一批数据

ConsumerRecords<String, String> consumerRecords = kafkaConsumer.poll(Duration.ofSeconds(1));

// 打印消费到的数据

for (ConsumerRecord<String, String> consumerRecord : consumerRecords) {

System.out.println(consumerRecord);

}

}

}

}

6.3.2 独立消费者案例(订阅分区)

package com.atguigu.kafka.consumer;

import org.apache.kafka.clients.consumer.ConsumerConfig;

import org.apache.kafka.clients.consumer.ConsumerRecord;

import org.apache.kafka.clients.consumer.ConsumerRecords;

import org.apache.kafka.clients.consumer.KafkaConsumer;

import org.apache.kafka.common.TopicPartition;

import java.time.Duration;

import java.util.ArrayList;

import java.util.Arrays;

import java.util.Properties;

public class CustomConsumerPartition {

public static void main(String[] args) {

Properties properties = new Properties();

properties.put(ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG,"hadoop102:9092");

// 配置序列化 必须

properties.put(ConsumerConfig.KEY_DESERIALIZER_CLASS_CONFIG, StringDeserializer.class.getName());

properties.put(ConsumerConfig.VALUE_DESERIALIZER_CLASS_CONFIG, StringDeserializer.class.getName());

// 配置消费者组(必须),名字可以任意起

properties.put(ConsumerConfig.GROUP_ID_CONFIG,"test");

KafkaConsumer<String, String> kafkaConsumer = new KafkaConsumer<>(properties);

// 消费某个主题的某个分区数据

ArrayList<TopicPartition> topicPartitions = new ArrayList<>();

topicPartitions.add(new TopicPartition("first", 0));

kafkaConsumer.assign(topicPartitions);

while (true){

ConsumerRecords<String, String> consumerRecords = kafkaConsumer.poll(Duration.ofSeconds(1));

for (ConsumerRecord<String, String> consumerRecord : consumerRecords) {

System.out.println(consumerRecord);

}

}

}

}

6.3.3 独立消费者案例(订阅分区)

package com.atguigu.kafka.consumer;

import org.apache.kafka.clients.consumer.ConsumerConfig;

import org.apache.kafka.clients.consumer.ConsumerRecord;

import org.apache.kafka.clients.consumer.ConsumerRecords;

import org.apache.kafka.clients.consumer.KafkaConsumer;

import java.time.Duration;

import java.util.ArrayList;

import java.util.Properties;

public class CustomConsumer1 {

public static void main(String[] args) {

// 1.创建消费者的配置对象

Properties properties = new Properties();

// 2.给消费者配置对象添加参数

properties.put(ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG, "hadoop102:9092");

// 配置序列化 必须

properties.put(ConsumerConfig.KEY_DESERIALIZER_CLASS_CONFIG, StringDeserializer.class.getName());

properties.put(ConsumerConfig.VALUE_DESERIALIZER_CLASS_CONFIG, StringDeserializer.class.getName());

// 配置消费者组 必须

properties.put(ConsumerConfig.GROUP_ID_CONFIG, "test");

// 创建消费者对象

KafkaConsumer<String, String> kafkaConsumer = new KafkaConsumer<String, String>(properties);

// 注册主题

ArrayList<String> topics = new ArrayList<>();

topics.add("first");

kafkaConsumer.subscribe(topics);

// 拉取数据打印

while (true) {

// 设置1s中消费一批数据

ConsumerRecords<String, String> consumerRecords = kafkaConsumer.poll(Duration.ofSeconds(1));

// 打印消费到的数据

for (ConsumerRecord<String, String> consumerRecord : consumerRecords) {

System.out.println(consumerRecord);

}

}

}

}

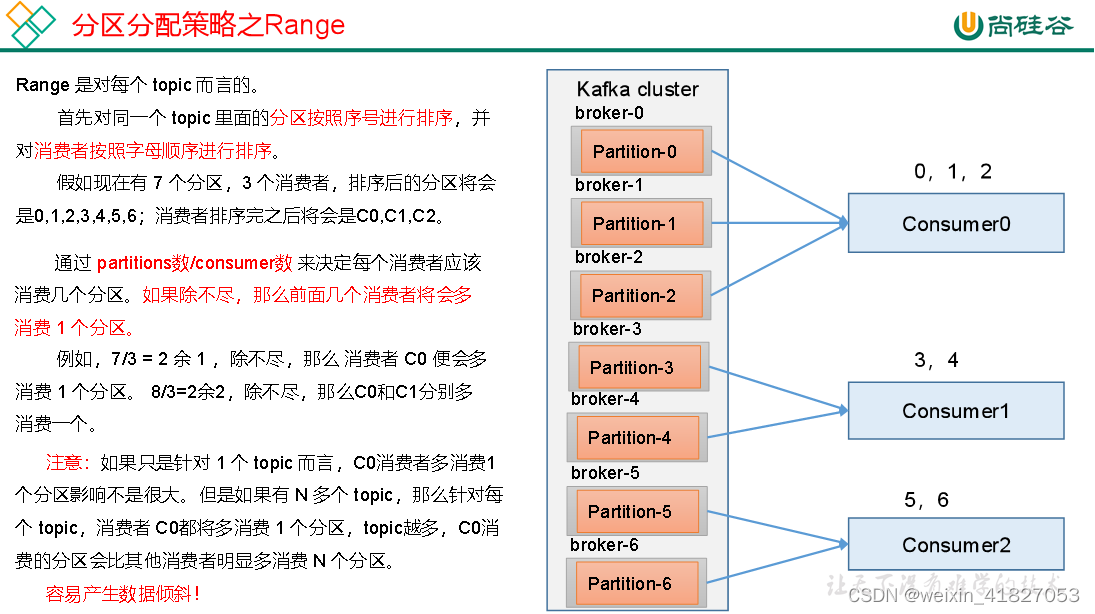

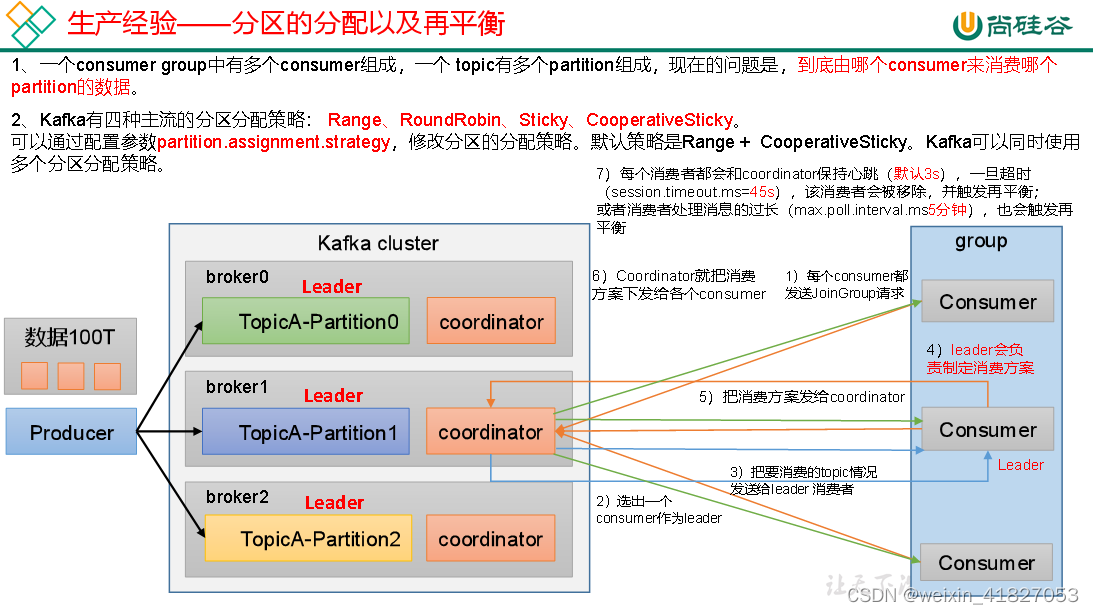

6.4 分区的分配以及再平衡

Kafka默认的分区分配策略就是Range + CooperativeSticky,所以不需要修改策略。

6.4.1 Range以及再平衡

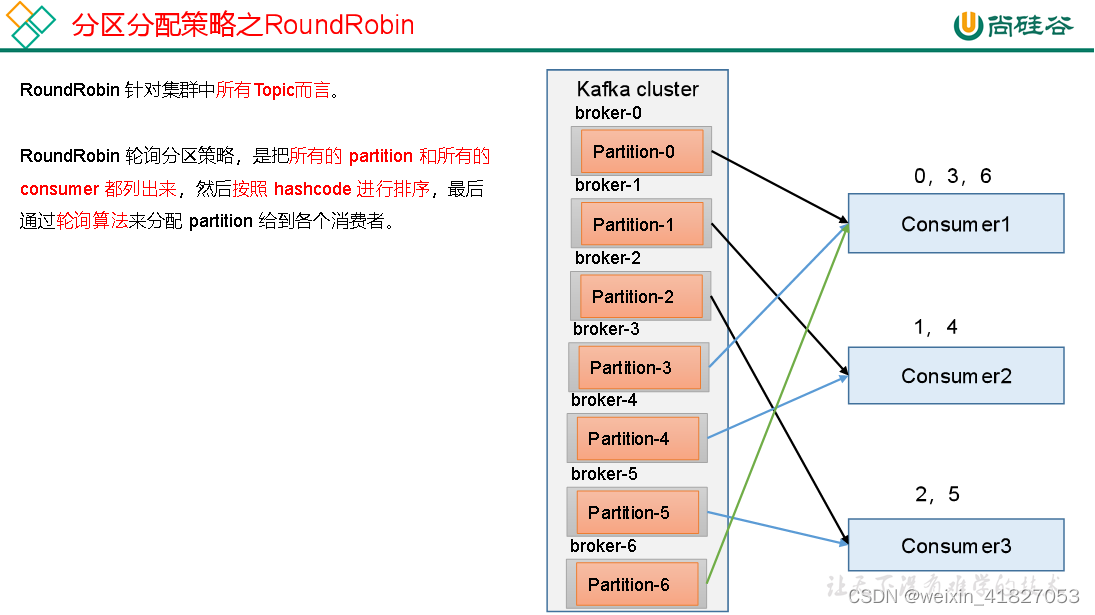

6.4.2 RoundRobin以及再平衡

6.4.3 Sticky以及再平衡

粘性分区定义:可以理解为分配的结果带有“粘性的”。即在执行一次新的分配之前,考虑上一次分配的结果,尽量少的调整分配的变动,可以节省大量的开销。

粘性分区是Kafka从0.11.x版本开始引入这种分配策略,首先会尽量均衡的放置分区到消费者上面,在出现同一消费者组内消费者出现问题的时候,会尽量保持原有分配的分区不变化。

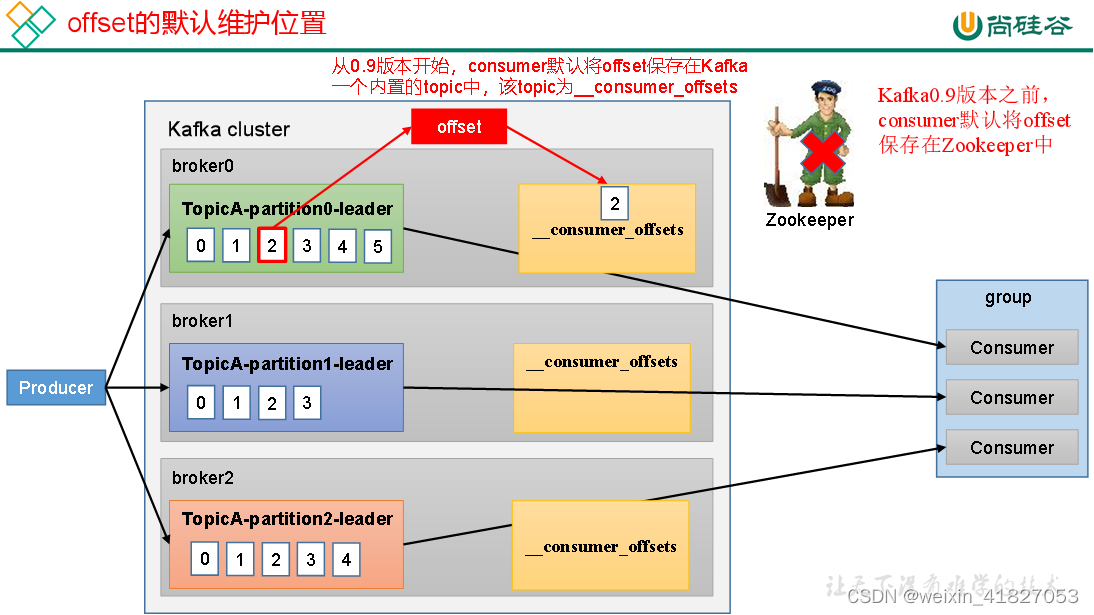

6.5 offset位移

6.5.1 offset的默认维护位置

__consumer_offsets主题里面采用key和value的方式存储数据。key是group.id+topic+分区号,value就是当前offset的值。每隔一段时间,kafka内部会对这个topic进行compact,也就是每个group.id+topic+分区号就保留最新数据。

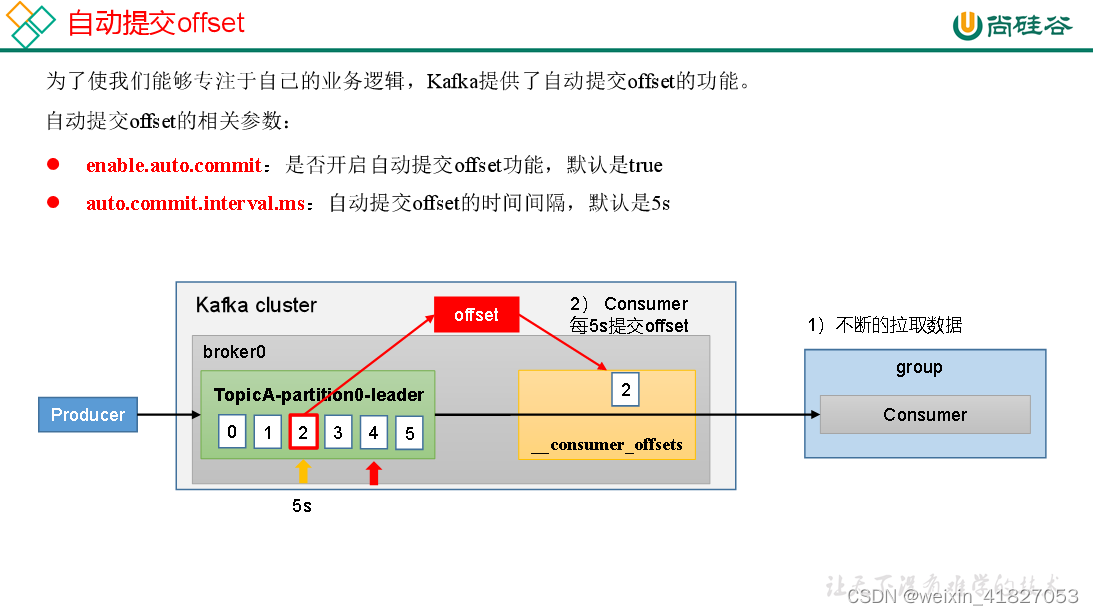

6.5.2 自动提交offset

| 参数名称 | 描述 |

| enable.auto.commit | 默认值为true,消费者会自动周期性地向服务器提交偏移量。 |

| auto.commit.interval.ms | 如果设置了 enable.auto.commit 的值为true, 则该值定义了消费者偏移量向Kafka提交的频率,默认5s。 |

消费者自动提交offset

package com.atguigu.kafka.consumer;

import org.apache.kafka.clients.consumer.ConsumerConfig;

import org.apache.kafka.clients.consumer.ConsumerRecord;

import org.apache.kafka.clients.consumer.ConsumerRecords;

import org.apache.kafka.clients.consumer.KafkaConsumer;

import java.util.Arrays;

import java.util.Properties;

public class CustomConsumerAutoOffset {

public static void main(String[] args) {

// 1. 创建kafka消费者配置类

Properties properties = new Properties();

// 2. 添加配置参数

// 添加连接

properties.put(ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG, "hadoop102:9092");

// 配置序列化 必须

properties.put(ConsumerConfig.KEY_DESERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringDeserializer");

properties.put(ConsumerConfig.VALUE_DESERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringDeserializer");

// 配置消费者组

properties.put(ConsumerConfig.GROUP_ID_CONFIG, "test");

// 是否自动提交offset

properties.put(ConsumerConfig.ENABLE_AUTO_COMMIT_CONFIG, true);

// 提交offset的时间周期1000ms,默认5s

properties.put(ConsumerConfig.AUTO_COMMIT_INTERVAL_MS_CONFIG, 1000);

//3. 创建kafka消费者

KafkaConsumer<String, String> consumer = new KafkaConsumer<>(properties);

//4. 设置消费主题 形参是列表

consumer.subscribe(Arrays.asList("first"));

//5. 消费数据

while (true){

// 读取消息

ConsumerRecords<String, String> consumerRecords = consumer.poll(Duration.ofSeconds(1));

// 输出消息

for (ConsumerRecord<String, String> consumerRecord : consumerRecords) {

System.out.println(consumerRecord.value());

}

}

}

}

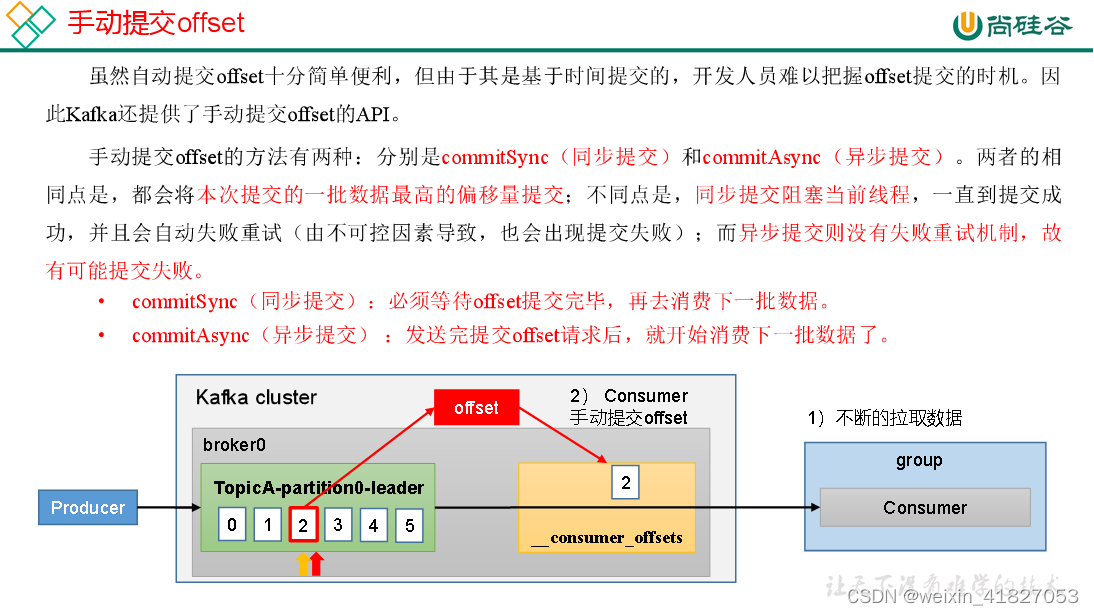

6.5.3 手动提交offset

同步提交offset

由于同步提交offset有失败重试机制,故更加可靠,但是由于一直等待提交结果,提交的效率比较低。以下为同步提交offset的示例。

package com.atguigu.kafka.consumer;

import org.apache.kafka.clients.consumer.ConsumerConfig;

import org.apache.kafka.clients.consumer.ConsumerRecord;

import org.apache.kafka.clients.consumer.ConsumerRecords;

import org.apache.kafka.clients.consumer.KafkaConsumer;

import java.util.Arrays;

import java.util.Properties;

public class CustomConsumerByHandSync {

public static void main(String[] args) {

// 1. 创建kafka消费者配置类

Properties properties = new Properties();

// 2. 添加配置参数

// 添加连接

properties.put(ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG, "hadoop102:9092");

// 配置序列化 必须

properties.put(ConsumerConfig.KEY_DESERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringDeserializer");

properties.put(ConsumerConfig.VALUE_DESERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringDeserializer");

// 配置消费者组

properties.put(ConsumerConfig.GROUP_ID_CONFIG, "test");

// 是否自动提交offset

properties.put(ConsumerConfig.ENABLE_AUTO_COMMIT_CONFIG, false);

//3. 创建kafka消费者

KafkaConsumer<String, String> consumer = new KafkaConsumer<>(properties);

//4. 设置消费主题 形参是列表

consumer.subscribe(Arrays.asList("first"));

//5. 消费数据

while (true){

// 读取消息

ConsumerRecords<String, String> consumerRecords = consumer.poll(Duration.ofSeconds(1));

// 输出消息

for (ConsumerRecord<String, String> consumerRecord : consumerRecords) {

System.out.println(consumerRecord.value());

}

// 同步提交offset

consumer.commitSync();

}

}

}

异步提交offset

虽然同步提交offset更可靠一些,但是由于其会阻塞当前线程,直到提交成功。因此吞吐量会受到很大的影响。因此更多的情况下,会选用异步提交offset的方式。

package com.atguigu.kafka.consumer;

import org.apache.kafka.clients.consumer.*;

import org.apache.kafka.common.TopicPartition;

import java.util.Arrays;

import java.util.Map;

import java.util.Properties;

public class CustomConsumerByHandAsync {

public static void main(String[] args) {

// 1. 创建kafka消费者配置类

Properties properties = new Properties();

// 2. 添加配置参数

// 添加连接

properties.put(ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG, "hadoop102:9092");

// 配置序列化 必须

properties.put(ConsumerConfig.KEY_DESERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringDeserializer");

properties.put(ConsumerConfig.VALUE_DESERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringDeserializer");

// 配置消费者组

properties.put(ConsumerConfig.GROUP_ID_CONFIG, "test");

// 是否自动提交offset

properties.put(ConsumerConfig.ENABLE_AUTO_COMMIT_CONFIG, "false");

//3. 创建Kafka消费者

KafkaConsumer<String, String> consumer = new KafkaConsumer<>(properties);

//4. 设置消费主题 形参是列表

consumer.subscribe(Arrays.asList("first"));

//5. 消费数据

while (true){

// 读取消息

ConsumerRecords<String, String> consumerRecords = consumer.poll(Duration.ofSeconds(1));

// 输出消息

for (ConsumerRecord<String, String> consumerRecord : consumerRecords) {

System.out.println(consumerRecord.value());

}

// 异步提交offset

consumer.commitAsync();

}

}

}

指定Offset消费

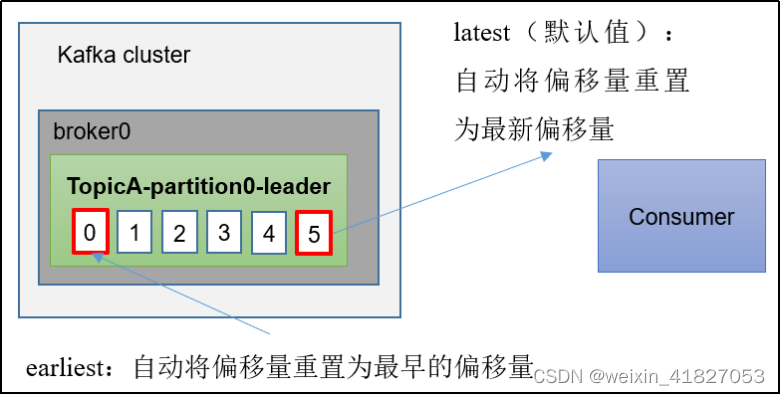

auto.offset.reset = earliest | latest | none 默认是latest。

当Kafka中没有初始偏移量(消费者组第一次消费)或服务器上不再存在当前偏移量时(例如该数据已被删除),该怎么办?

(1)earliest:自动将偏移量重置为最早的偏移量,–from-beginning。

(2)latest(默认值):自动将偏移量重置为最新偏移量。

(3)none:如果未找到消费者组的先前偏移量,则向消费者抛出异常。

(4)任意指定offset位移开始消费

package com.atguigu.kafka.consumer;

import org.apache.kafka.clients.consumer.ConsumerConfig;

import org.apache.kafka.clients.consumer.ConsumerRecord;

import org.apache.kafka.clients.consumer.ConsumerRecords;

import org.apache.kafka.clients.consumer.KafkaConsumer;

import org.apache.kafka.common.TopicPartition;

import org.apache.kafka.common.serialization.StringDeserializer;

import java.time.Duration;

import java.util.ArrayList;

import java.util.HashSet;

import java.util.Properties;

import java.util.Set;

public class CustomConsumerSeek {

public static void main(String[] args) {

// 0 配置信息

Properties properties = new Properties();

// 连接

properties.put(ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG, "hadoop102:9092");

// key value反序列化

properties.put(ConsumerConfig.KEY_DESERIALIZER_CLASS_CONFIG, StringDeserializer.class.getName());

properties.put(ConsumerConfig.VALUE_DESERIALIZER_CLASS_CONFIG, StringDeserializer.class.getName());

properties.put(ConsumerConfig.GROUP_ID_CONFIG, "test2");

// 1 创建一个消费者

KafkaConsumer<String, String> kafkaConsumer = new KafkaConsumer<>(properties);

// 2 订阅一个主题

ArrayList<String> topics = new ArrayList<>();

topics.add("first");

kafkaConsumer.subscribe(topics);

Set<TopicPartition> assignment= new HashSet<>();

while (assignment.size() == 0) {

kafkaConsumer.poll(Duration.ofSeconds(1));

// 获取消费者分区分配信息(有了分区分配信息才能开始消费)

assignment = kafkaConsumer.assignment();

}

// 遍历所有分区,并指定offset从1700的位置开始消费

for (TopicPartition tp: assignment) {

kafkaConsumer.seek(tp, 1700);

}

// 3 消费该主题数据

while (true) {

ConsumerRecords<String, String> consumerRecords = kafkaConsumer.poll(Duration.ofSeconds(1));

for (ConsumerRecord<String, String> consumerRecord : consumerRecords) {

System.out.println(consumerRecord);

}

}

}

}

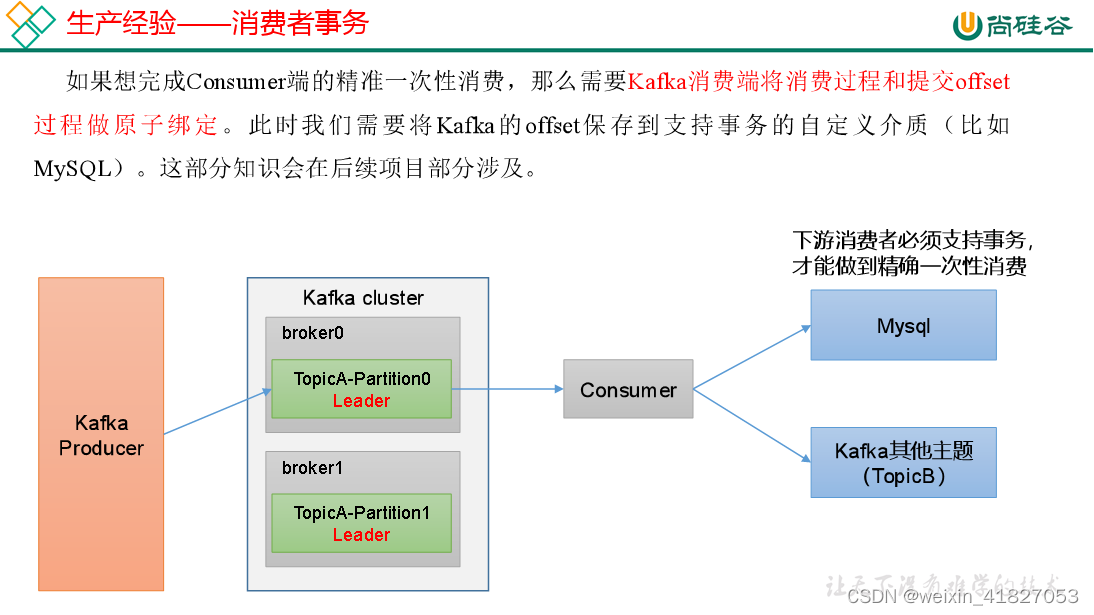

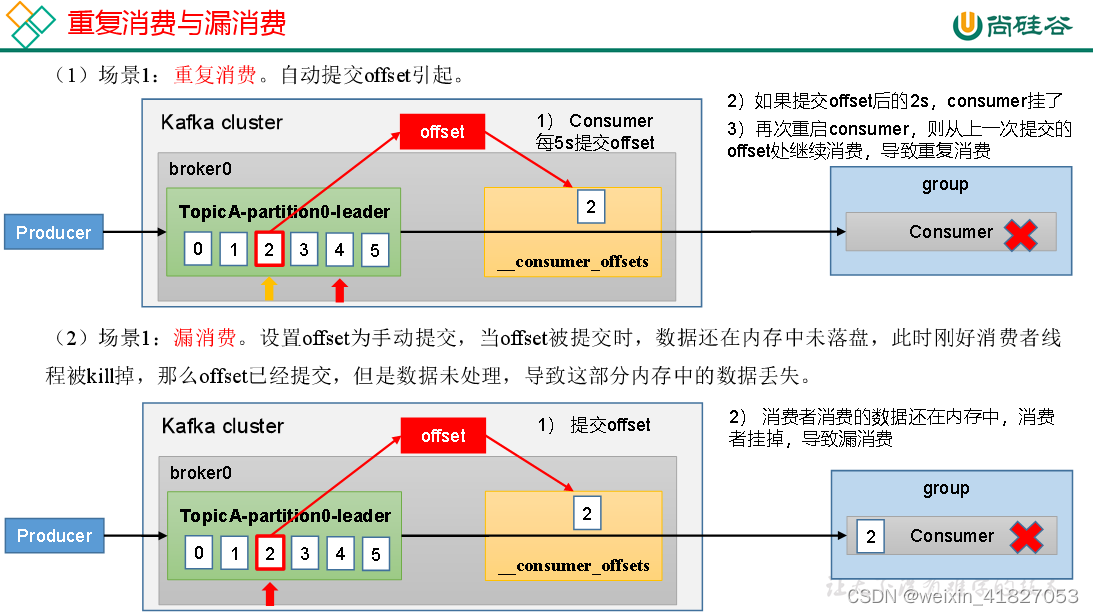

漏消费和重复消费

重复消费:已经消费了数据,但是offset没提交。

漏消费:先提交offset后消费,有可能会造成数据的漏消费。

6.6 消费者事务

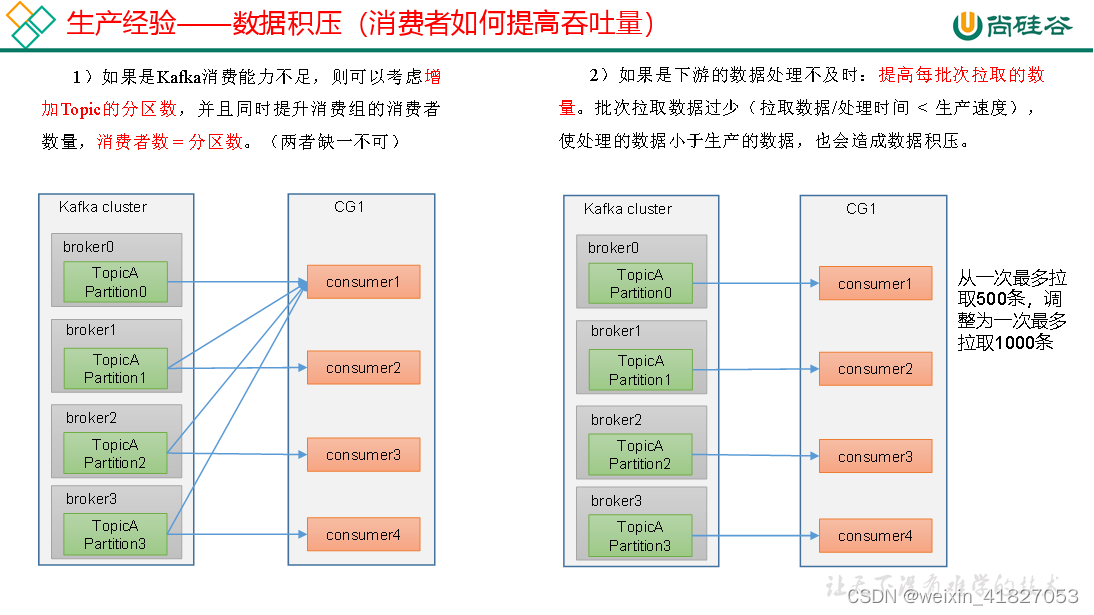

6.7 数据积压(消费者如何提高吞吐量)

| 参数名称 | 描述 |

| fetch.max.bytes | 默认Default: 52428800(50 m)。消费者获取服务器端一批消息最大的字节数。如果服务器端一批次的数据大于该值(50m)仍然可以拉取回来这批数据,因此,这不是一个绝对最大值。一批次的大小受message.max.bytes (broker config)or max.message.bytes (topic config)影响。 |

| max.poll.records | 一次poll拉取数据返回消息的最大条数,默认是500条 |

7 Kafka 调优

7.1 如何提升吞吐量

1)提升生产吞吐量

(1)buffer.memory:发送消息的缓冲区大小,默认值是32m,可以增加到64m。

(2)batch.size:默认是16k。如果batch设置太小,会导致频繁网络请求,吞吐量下降;如果batch太大,会导致一条消息需要等待很久才能被发送出去,增加网络延时。

(3)linger.ms,这个值默认是0,意思就是消息必须立即被发送。一般设置一个5-100毫秒。如果linger.ms设置的太小,会导致频繁网络请求,吞吐量下降;如果linger.ms太长,会导致一条消息需要等待很久才能被发送出去,增加网络延时。

(4)compression.type:默认是none,不压缩,但是也可以使用lz4压缩,效率还是不错的,压缩之后可以减小数据量,提升吞吐量,但是会加大producer端的CPU开销。

2)增加分区

3)消费者提高吞吐量

(1)调整fetch.max.bytes大小,默认是50m。

(2)调整max.poll.records大小,默认是500条。

4)增加下游消费者处理能力

7.2 数据唯一

1)生产者角度

acks设置为-1 (acks=-1)。

幂等性(enable.idempotence = true) + 事务 。

2)broker服务端角度

分区副本大于等于2 (–replication-factor 2)。

ISR里应答的最小副本数量大于等于2 (min.insync.replicas = 2)。

3)消费者

事务 + 手动提交offset (enable.auto.commit = false)。

消费者输出的目的地必须支持事务(MySQL、Kafka)。

1033

1033

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?