⭐️⭐️⭐️⭐️⭐️欢迎来到我的博客⭐️⭐️⭐️⭐️⭐️

🐴作者:秋无之地🐴简介:CSDN爬虫、后端、大数据、人工智能领域创作者。目前从事python全栈、爬虫和人工智能等相关工作,主要擅长领域有:python全栈、爬虫、大数据开发、人工智能等。

🐴欢迎小伙伴们点赞👍🏻、收藏⭐️、留言💬、关注🤝,关注必回关

前言:

最近好几个粉丝私信问我,对于人工智能尤其是现在最火的DeepSeek了不了解?普通人需要怎样才能入门DeepSeek?如何将DeepSeek运用到实际中?

今天通过这篇超万字的博文给大家来一个详细的解答,希望能给大家有个初步的认识和启发!

一、DeepSeek的介绍

1、DeepSeek的由来

DeepSeek,全称杭州深度求索人工智能基础技术研究有限公司,成立于2023年7月17日,是一家创新型科技公司,专注于开发先进的大语言模型(LLM)和相关技术。

2、DeepSeek-R1大数据模型

据DeepSeek介绍,其最新发布的模型DeepSeek-R1在后训练阶段大规模使用了强化学习技术,在仅有极少标注数据的情况下,极大提升了模型推理能力。在数学、代码、自然语言推理等任务上,性能比肩OpenAI o1正式版。而且训练成本和使用费用是OpenAI的1%,从性价比角度看是远远高于后者。另外DeepSeek-R1是完全开源免费使用,这一举措大大打击到OpenAI的使用者。

3、为啥就火了:

DeepSeek出现并爆火的意义是,它让一个普通人使用AI的门槛快速降低。

由于是推理型大模型,DeepSeek不需要背诵提示词模板、学习特定的指令、研究各类参数,只需要像和朋友唠嗑一样说出你的痛点、场景、需求即可。

比如你想让DeepSeek给出一些春节相关的知识和建议:

二、DeepSeek使用方式

刚才介绍完DeepSeek是个啥,接下来就说一下怎么用?

我们可以通过三种方式使用DeepSeek:官方web访问、API使用、本地部署。

1. 通过DeepSeek聊天平台进行网页访问:

DeepSeek聊天平台提供了一个友好的用户界面,允许用户无需任何设置即可与DeepSeek-R1进行互动。

访问的步骤:

- 浏览至DeepSeek聊天平台

- 注册一个账号,或者如果您已有账号,直接登录。

- 登录后,可以选择“深度思考”模式,体验DeepSeek-R1的逐步推理功能。

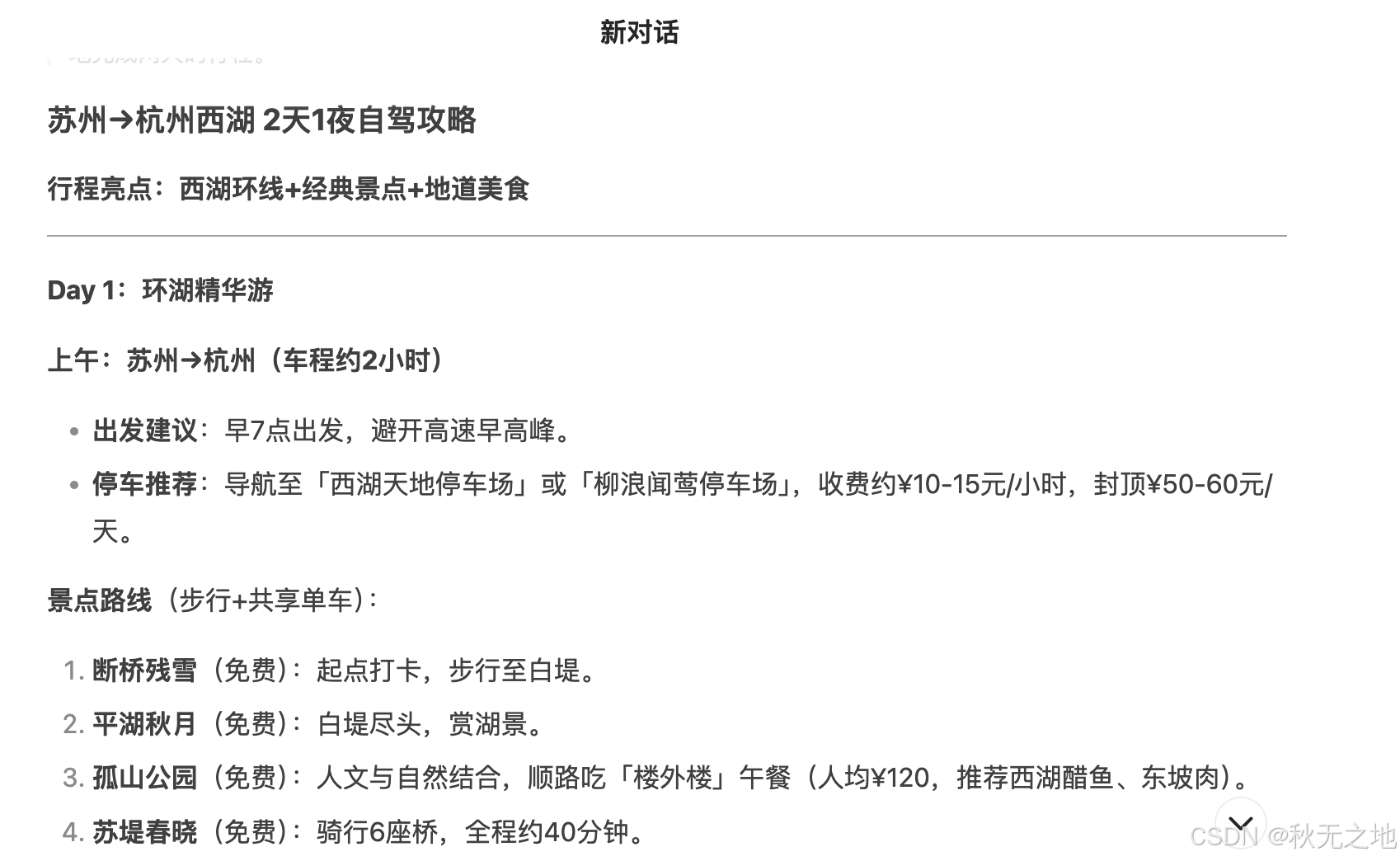

比如你可以说,“我明天打算从苏州出发到杭州西湖的景点游玩2天1夜,选择自驾出行,同行3人,可以帮忙规划游玩的路线,包含美食、住宿、景点门票、停车场位置和停车收费等信息,尽可能用简短易懂的语言描述。”

2. 通过 DeepSeek API 访问:

DeepSeek 提供了一个与 OpenAI 格式兼容的 API,方便开发者将其嵌入各种应用程序中进行程序化访问。

当前注册还可以享有10块钱的赠送额度

使用 API 的步骤:

1)获取 API 密钥:

- 访问DeepSeekAPI平台,注册账号并生成您的专属 API 密钥。

2)配置您的环境:

- 设置

base_url为https://api.deepseek.com/v1。- 使用您的 API 密钥进行认证,通常在 HTTP 头部通过 Bearer Token 进行。

3)发起 API 调用:

- 利用 API 向 DeepSeek-R1 发送指令并接收响应。

- 您可以在DeepSeekAPI文档中找到详细的文档和示例。

代码如下:

# 请先安装 OpenAI SDK:`pip3 install openai`

from openai import OpenAI

client = OpenAI(api_key="<DeepSeek API Key>", base_url="https://api.deepseek.com")

response = client.chat.completions.create(

model="deepseek-chat",

messages=[

{"role": "system", "content": "You are a helpful assistant"},

{"role": "user", "content": "Hello"},

],

stream=False

)

print(response.choices[0].message.content)

3. 在本地部署 DeepSeek-R1:

两种模型(R1 和 R1-Zero):

- 硬件需求:由于模型规模庞大,完整模型需要较强的硬件支持。推荐使用具有大量视频内存(VRAM)的 GPU,例如 Nvidia RTX 3090 或更高级别。如果使用 CPU,你至少需要 48GB 的 RAM 和 250GB 的磁盘空间,但若不使用 GPU 加速,性能会显著下降。

- 蒸馏模型:对于硬件要求不那么高的本地部署,DeepSeek 提供了参数范围从 15 亿到 700 亿的蒸馏版本,适合硬件配置较低的系统。例如,一个 7B 参数的模型可以在至少拥有 6GB VRAM 的 GPU 上运行,或在大约 4GB RAM 的 CPU 上运行 GGML/GGUF 格式。

DeepSeek本地部署步骤:

3.1、Ollama:

您可以使用Ollama来在本地部署和运行模型:(Ollama 是一个工具,允许您在个人计算机上本地运行开源 AI 模型。您可以从这里下载它:ollama.com/download)

根据自身使用的系统选择合适的版本,点击按钮进行下载安装即可。

3.2、验证 Ollama 安装情况

在进一步操作之前,我们需要确保 Ollama 已经正确安装。请打开您的终端或命令提示符,输入以下命令:

ollama--version如果您看到版本号显示出来,说明安装成功了!如果没有显示,那么请仔细检查您是否已按照安装步骤正确执行。

ollama version is 0.5.73.3、Download Deepseek R1

通过 Ollama 下载 DeepSeek R1 非常便捷。您只需在终端中执行以下命令:

ollama run deepseek-r1默认版本是:7B 模型(CPU 大概需要4G内存,1.5B大概需要1.7G内存),DeepSeek R1 的参数范围从 1.5B 到 671B,可以使用ollama run deepseek-r1:1.5b适合自己的模型版本,下载时间可能会根据您的网络速度而异。

3.4、运行 DeepSeek R1

下载完成后,您就可以启动 DeepSeek R1 了。使用以下命令:

ollama run deepseek-r1

就这样,您已经在本地机器上顺利启动了 DeepSeek R1!是不是特别简单!

3.5、本地运行试用Deepseek R1

现在我们已经成功启动了 DeepSeek R1,接下来就是更加有趣的部分——实际使用它!让我们一起探索这款强大的 AI 模型能做些什么神奇的事情。

比如写一个关于机器人产生自我意识想着统治人类的故事:

这是一个既有创意又条理清晰的故事!是不是已经感觉到它的强大之处了!赶紧收藏本文开始学习试用吧!

版权声明

本文章版权归作者所有,未经作者允许禁止任何转载、采集,作者保留一切追究的权利。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?