1 常用优化

官方提供的优化请参考官方文档:https://tensorflow.google.cn/guide/performance/overview?hl=zh-cn,列出的都是些最基本的常用优化方法,效果明显,更细的优化就不具体介绍了,像算子粒度的优化.

1.1 增加并发量提高算子计算图

提高算子和算子间的并发量对提高性能最明显,简单有效,是最常用的优化方法,尤其对CPU计算来说,下面给出三个修改并发量的参数,CPU计算时一定不要忘记这三个参数.

config.proto

// Map from device type name (e.g., "CPU" or "GPU" ) to maximum

// number of devices of that type to use. If a particular device

// type is not found in the map, the system picks an appropriate

// number.

map<string, int32> device_count = 1;

// The execution of an individual op (for some op types) can be

// parallelized on a pool of intra_op_parallelism_threads.

// 0 means the system picks an appropriate number.

int32 intra_op_parallelism_threads = 2;

// Nodes that perform blocking operations are enqueued on a pool of

// inter_op_parallelism_threads available in each process.

//

// 0 means the system picks an appropriate number.

//

// Note that the first Session created in the process sets the

// number of threads for all future sessions unless use_per_session_threads is

// true or session_inter_op_thread_pool is configured.

int32 inter_op_parallelism_threads = 5;

解释:

1)device_count, 告诉tf Session使用CPU数量上限,如果你的CPU数量较多,可以适当加大这个值;2) inter_op_parallelism_threads和intra_op_parallelis

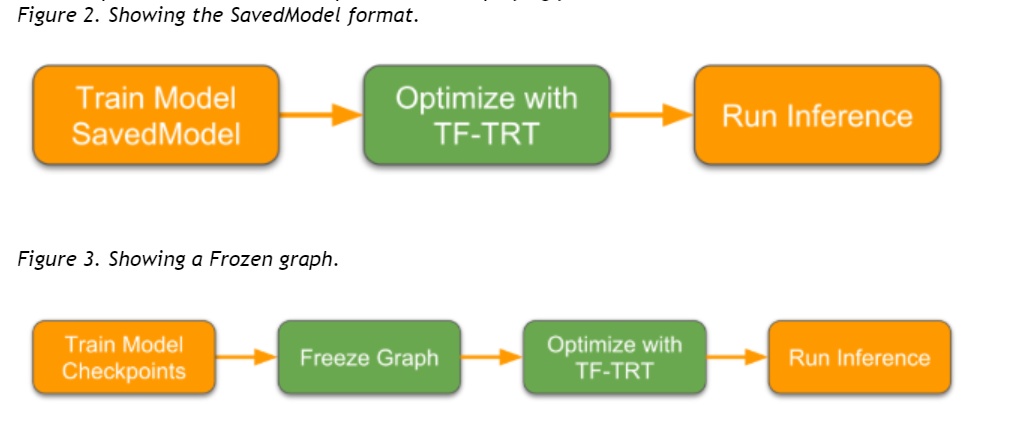

本文探讨了TensorFlow模型的优化方法,包括增加并发量优化算子计算图,利用tf.data提高数据流处理效率,以及GPipe进行大规模模型训练。在部署方面,介绍了Graph Transform Tool (GTT)的常用优化选项,如删除训练特定操作,折叠Batch Normalization,以及TensorRT库带来的性能提升。此外,还提到了模型量化工具和TF-TRT解决不支持算子的问题。

本文探讨了TensorFlow模型的优化方法,包括增加并发量优化算子计算图,利用tf.data提高数据流处理效率,以及GPipe进行大规模模型训练。在部署方面,介绍了Graph Transform Tool (GTT)的常用优化选项,如删除训练特定操作,折叠Batch Normalization,以及TensorRT库带来的性能提升。此外,还提到了模型量化工具和TF-TRT解决不支持算子的问题。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1393

1393

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?