简介:本文介绍了NVIDIA CUDA深度神经网络库(CuDNN)的特定版本v7.6.5.32,适用于CUDA 10.1环境和Windows 10 64位系统。CuDNN是深度学习算法加速库,提供了针对各种深度学习模型的优化算法,能够利用GPU并行计算提升性能。CUDA 10.1版本支持最新GPU架构,改善内存管理和Tensor Core性能。CuDNN的安装包包含了头文件、库文件、示例代码等,是深度学习开发者在Windows环境下进行GPU加速计算的重要工具。

1. CuDNN版本v7.6.5.32介绍

CuDNN是什么

NVIDIA的深度神经网络库CuDNN(CUDA Deep Neural Network library)是一个针对深度神经网络的计算库,它是专门为提升深度学习框架中算法性能而设计的。作为CUDA的配套库,CuDNN可以极大地加速GPU上的神经网络计算。通过提供核心的、高度优化的深度学习组件,CuDNN使得开发者能够专注于构建和训练复杂模型,而不是从头开始编写底层的计算功能。

CuDNN的版本更新历程

自推出以来,CuDNN经历了数次重要的版本更新。每一次的更新都包含了一系列的性能提升、新功能的添加以及对现有功能的改进。例如,v7版本中引入了对NVIDIA Tensor Core的支持,显著提升了计算效率。每个版本的发布,都是为了更好地与现有的CUDA版本协同工作,提供对最新GPU架构的支持,并优化深度学习算法的执行速度和效率。

v7.6.5.32版本的新特性

在v7.6.5.32版本中,CuDNN主要关注在进一步提高性能和优化用户体验。此版本新增了对某些NVIDIA GPU架构的支持,如针对Turing GPU的优化,以及对前向推理和训练功能的改进。此外,它也强化了对某些深度学习网络层的加速,比如改进了对变种卷积层的处理效率。该版本还包括了对API的稳定性更新,以确保与未来软件版本的兼容性。这些更新和改进,使得v7.6.5.32版本的CuDNN成为在深度学习领域中一个极为重要的工具库。

由于Markdown不支持多级标题,以下是作为参照的Markdown内容。在实际Markdown文档中,应当去除这些注释。

## 深度说明

### 关于CuDNN的详细信息

为了更深入了解CuDNN,可以从NVIDIA的官方文档和社区论坛获取一手资料。这些资源能够帮助开发者理解和使用最新的CuDNN库,以及解决在使用过程中可能遇到的问题。

### CuDNN与深度学习框架的结合

以TensorFlow和PyTorch为例,这些流行的深度学习框架都紧密集成了CuDNN,并通过其API无缝地利用了GPU加速能力。开发者在选择深度学习框架时,通常会考虑其对CuDNN的集成程度和优化水平。

请注意,Markdown格式通常不支持传统的二级标题(即"###"),而是直接使用一级标题("#")来表示小节。为了清晰地展示目录结构,我才在示例中添加了二级标题。在实际撰写文章时,应采用合适的Markdown语法,符合标准Markdown的渲染需求。

2. CUDA深度学习框架概述

2.1 CUDA的历史与发展

2.1.1 CUDA的发展背景

CUDA(Compute Unified Device Architecture)是由NVIDIA推出的并行计算平台和编程模型。它允许开发者使用NVIDIA的GPU(Graphics Processing Unit)进行通用计算,而不仅仅是图形渲染。这一理念的提出,源于在图形处理之外寻找GPU处理能力新应用的需求。当图形处理器处理图形任务时,其强大的并行计算能力往往未能得到充分利用。为了解决这一问题,CUDA应运而生,旨在简化并行计算,使得开发者可以利用GPU的并行架构来加速计算密集型任务。

2.1.2 CUDA的主要版本和更新

CUDA自2007年首次发布以来,已经经历了多个版本的迭代更新。CUDA 1.x版本着重于基础架构和简单的并行计算能力。随着时间推移,CUDA不断添加新功能和优化,并引入对新的NVIDIA GPU架构的支持。CUDA 4.x版本引入了对NVIDIA Fermi架构的支持,进一步简化了并行编程。到了CUDA 8和CUDA 9,开发者得到了对新的Volta和Turing架构的支持,并引入了多项性能优化和技术改进。最新版本的CUDA不断地为开发者提供更高级别的抽象,更多的硬件功能支持和更优的性能表现。

2.2 CUDA核心概念与组件

2.2.1 CUDA的核心组成

CUDA架构的核心概念包括线程、线程块、线程网格、流和内存管理等。线程是执行计算的基本单元,线程块是多个线程的集合,它们在同一个流处理器上运行并且共享内存。线程网格是由多个线程块组成,能够利用整个GPU的计算资源。流是执行的序列,允许多个操作并行或顺序执行。在内存管理方面,CUDA区分了全局内存、共享内存、常量内存和纹理内存,以优化不同访问模式下的性能。

2.2.2 CUDA的运行模型和内存管理

CUDA的运行模型让GPU能够执行成千上万的线程,形成一种高度并行的计算环境。每个GPU流处理器可以运行许多线程,而线程块和线程网格的组织方式提供了一种灵活的方式来管理这些线程。CUDA内存管理则提供了一种层次化的内存访问策略。全局内存是最大的内存区域,适用于线程间共享数据,但访问速度较慢。共享内存和常量纹理内存则提供了更快的数据访问速度,但大小有限制。CUDA编程模型设计了这些内存类型和层次,允许程序员更好地控制内存访问和数据传输,以提高程序的执行效率。

2.3 CUDA在深度学习中的应用

2.3.1 深度学习框架对CUDA的依赖

CUDA作为深度学习的一个关键技术,已经被各种主流的深度学习框架所依赖,如TensorFlow、PyTorch、Caffe等。这些框架利用CUDA优化了其后端的计算能力,提高了大规模数据处理的效率。CUDA与这些深度学习框架的集成,使得开发者无需深入了解底层GPU架构和并行计算细节,也能够享受到GPU加速带来的性能提升。

2.3.2 CUDA在不同深度学习框架中的角色

在深度学习框架中,CUDA的角色主要体现在以下几方面:首先,它提供了底层硬件资源的抽象,使得上层框架可以在不同的GPU硬件上无缝运行。其次,CUDA通过其丰富的API,为深度学习模型的执行提供了高效的计算和数据传输机制。最后,CUDA还通过内置的高性能数学库,如cuDNN,为深度学习中的特定操作如卷积和池化等提供了深度优化。这些深度优化使得在GPU上执行这些操作时的速度大大提升,对整个深度学习框架的性能起到了关键作用。

3. CUDA 10.1的新特性与支持

3.1 CUDA 10.1特性概览

3.1.1 新引入的硬件支持和优化

随着半导体技术的发展,新的GPU架构也应运而生,每一版CUDA的更新通常伴随着对最新硬件架构的优化和支持。CUDA 10.1也不例外,它不仅增加了对NVIDIA Turing™架构GPU的支持,还引入了对Volta和Pascal GPU的多项性能改进。这一代GPU架构加强了AI和深度学习计算能力,并对FP16(半精度浮点数)计算进行了优化。

Volta GPU是CUDA 10.1重点优化的对象之一,它带来了全新的Tensor Core,为矩阵乘法和卷积计算提供了加速。Tensor Core对于深度学习工作负载至关重要,它能够将计算效率提高一个数量级。此外,Turing架构GPU的RT核心也首次被支持,这为实时光线追踪计算提供了硬件加速。

从软件层面来看,NVIDIA提供了各类计算库的更新,包括cuDNN、cuBLAS等,这些库为开发者提供了更高效的API接口,能够更好地利用新硬件特性。

3.1.2 性能改进和新工具

CUDA 10.1在性能上的提升主要体现在以下几个方面:

- 计算性能优化 :对核心运行时和编译器后端进行了性能调优,尤其是对于单个线程性能的改进。

- 内存管理提升 :改进了内存池的分配效率,减少了内存碎片问题,特别是在处理大量小内存分配时的性能提升。

- 异构计算增强 :提高了GPU与CPU之间的数据传输速率,并优化了在两种架构间进行协作计算时的通信开销。

此外,CUDA 10.1还引入了多个新工具,例如NVTX(NVIDIA Tools Extension)3.0提供了更丰富的性能分析信息,使得开发者能更好地理解和优化他们的代码。它支持高精度时间戳和资源标记,这对于深度调试和性能分析至关重要。

代码块展示

#include <iostream>

#include <nvtx3/nvToolsExt.h>

int main() {

nvtxRangePushA("Main function");

std::cout << "Hello, CUDA 10.1!" << std::endl;

nvtxRangePop();

return 0;

}

此代码块展示了如何使用NVTX库标记代码段,以进行性能分析。每一行代码都有对应的逻辑分析和参数说明:

-

nvtxRangePushA定义了一个新的活动范围,并将字符串标签传递给它。 - 在

main函数中,使用nvtxRangePushA标记主函数的开始,并用nvtxRangePop结束。 -

std::cout用于输出调试信息。

3.2 CUDA 10.1在深度学习中的新功能

3.2.1 深度学习加速库的更新

深度学习库作为CUDA生态系统中的重要组成部分,其更新在CUDA 10.1中也受到了高度重视。cuDNN库自不必说,它为深度学习开发者提供了大量的优化算法,极大地提升了卷积、池化、归一化等操作的效率。在CUDA 10.1中,cuDNN的版本升级到了v7.4,进一步优化了对Tensor Core的支持,并提供了更快的推理速度。

cuBLAS和cuFFT等库也得到了改进,它们针对新硬件架构进行了优化,例如cuBLAS 10.1版本提供了对FP16数据类型更好的支持,并且在矩阵乘法操作中引入了新的算法,减少了计算过程中的资源占用。cuFFT库则进一步提升了大规模FFT(快速傅里叶变换)的性能。

3.2.2 对主流框架的支持改进

除了底层的库更新,CUDA 10.1还着力于提高与主流深度学习框架的兼容性和性能。在这一版本中,它引入了对TensorFlow 1.12和PyTorch 1.0的原生支持。这种支持意味着深度学习模型能够直接运行在GPU上,无需经过额外的适配层,从而减少了不必要的性能开销。

开发者在使用这些框架进行深度学习实验时,能够利用CUDA 10.1提供的性能优化,使得实验迭代周期大大缩短。同时,NVIDIA还与框架开发者合作,确保了在新版本框架下,能够充分利用CUDA的新特性和优化。

代码块展示

import tensorflow as tf

from tensorflow.keras import layers

model = tf.keras.Sequential([

layers.Conv2D(32, (3, 3), activation='relu', input_shape=(224, 224, 3)),

layers.MaxPooling2D((2, 2)),

# ... (更多层)

])

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

此Python代码段展示了如何在TensorFlow 1.12版本中构建一个简单的卷积神经网络,并利用cuDNN加速其运算。代码中的每一行都有对应的逻辑分析:

- 首先导入TensorFlow框架。

- 使用

Sequential模型创建一个卷积神经网络。 - 添加卷积层和池化层,使用

Conv2D和MaxPooling2D实现。 - 编译模型,设置优化器、损失函数和评估指标。

3.3 迁移指南与兼容性问题

3.3.1 从CUDA 10.0到10.1的迁移步骤

迁移新版本CUDA是许多开发者需要面对的问题。从CUDA 10.0迁移到10.1,一般需要以下步骤:

- 备份旧版本 :在安装新版本CUDA前,备份当前系统中的CUDA 10.0文件,包括安装文件夹以及环境变量配置。

- 卸载旧版本 :在安装新版本之前,卸载CUDA 10.0并确保所有相关的驱动和软件组件也被完全清除。

- 下载并安装新版本 :下载CUDA 10.1的安装程序并运行,遵循安装向导进行安装。

- 更新环境变量 :安装完成后,根据需要更新系统的PATH和LD_LIBRARY_PATH环境变量,以确保能够正确调用新的CUDA库。

- 验证安装 :通过运行CUDA自带的样例程序和工具来验证CUDA 10.1是否安装成功。

3.3.2 常见兼容性问题和解决方案

在迁移过程中,开发者可能会遇到的兼容性问题包括:

- 驱动不兼容 :安装新版本CUDA后,之前安装的NVIDIA驱动可能与新版本不兼容。通常需要一起更新到与CUDA 10.1相匹配的新版本驱动程序。

- 依赖库冲突 :旧版本的深度学习框架可能依赖于旧版本的CUDA库,直接更新可能会导致依赖关系断裂。需要确保所有相关库都得到更新,或者在虚拟环境中隔离库版本。

- 应用程序问题 :更新CUDA可能会导致应用程序报错,特别是当应用程序直接调用CUDA API时。此时,开发者需要检查API调用的变化,并相应地修改代码。

解决这些问题的一个常见做法是逐步更新和测试,确保每一步的改变都能被系统稳定运行。同时,也可以查看NVIDIA提供的官方文档和社区论坛中的经验分享,这些资源经常能提供有效的解决方案。

表格展示

| 兼容性问题 | 解决方案 | |------------|----------| | 驱动不兼容 | 更新至与CUDA 10.1匹配的NVIDIA驱动版本 | | 依赖库冲突 | 在虚拟环境中管理库版本,逐步更新深度学习框架 | | 应用程序报错 | 检查API调用的改变并修改代码,参考官方文档进行调试 |

这个表格总结了迁移CUDA时可能遇到的几个常见问题及其解决方案,帮助开发者有条不紊地处理兼容性问题。

4. Windows 10 64位系统优化

4.1 Windows平台下的CUDA环境搭建

在进行CUDA开发之前,首先需要在Windows 10 64位系统上搭建合适的开发环境。搭建过程中,主要分为CUDA安装和环境配置两个步骤。

4.1.1 Windows平台CUDA安装步骤

安装CUDA之前,需要先检查系统兼容性,确保系统满足CUDA安装的最低要求。CUDA支持的显卡和驱动版本可以在NVIDIA官网找到详细列表。

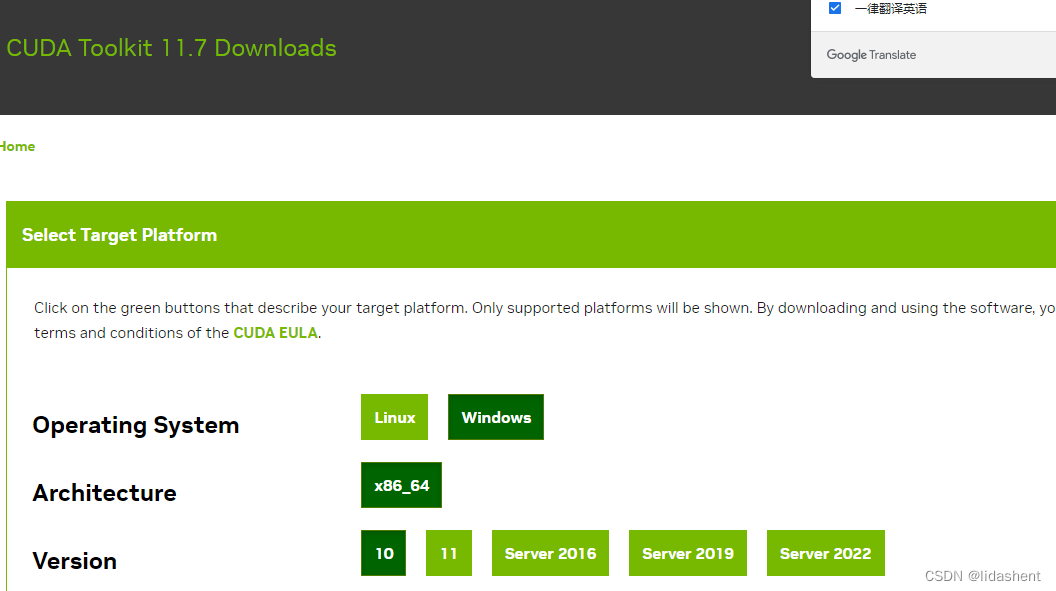

- 下载CUDA Toolkit :

- 访问NVIDIA官方CUDA下载页面,根据系统配置选择合适的CUDA Toolkit版本进行下载。

-

选择Windows平台,并确保下载的版本支持64位系统。

-

运行安装程序 :

- 双击下载的

cuda_10.1.105_418.67_win10.exe文件开始安装。 -

在安装向导中选择“Custom”安装类型,以便自定义安装路径和组件。

-

安装选项 :

- 确保“NVIDIA Accelerated Graphics Driver”选项被选中。

-

“CUDA Toolkit”、“CUDA Samples”和“Documentation”是推荐安装的组件。

-

环境变量配置 :

- 安装结束后,需要设置环境变量以便命令行和开发工具可以识别CUDA。

- 右键点击“此电脑”,选择“属性”,然后点击“高级系统设置”,在“系统属性”对话框中选择“环境变量”。

-

在“系统变量”区域点击“新建”,变量名为

CUDA_PATH,变量值为CUDA安装路径,如C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v10.1。 -

验证安装 :

- 通过运行命令

nvcc --version和nvcc -V来验证CUDA编译器是否正确安装。 - 运行CUDA Samples中的示例程序来确认安装成功。

4.1.2 驱动安装与环境变量配置

显卡驱动安装 :

- 访问NVIDIA驱动下载页面,选择合适的驱动版本进行下载。建议选择与CUDA Toolkit版本匹配的驱动。

- 安装过程中,确保选中“NVIDIA Control Panel”和“NVIDIA PhysX”等可选组件。

环境变量配置 :

- 打开系统属性,点击“环境变量”按钮。

- 在“系统变量”区域,点击“新建”创建

CUDA_PATH变量,指向CUDA安装路径。 -

可选地,将CUDA的

bin目录(如C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v10.1\bin)添加到Path环境变量中,以便在命令行中直接调用CUDA命令。 -

同样,将CUDA Samples的路径(如

C:\ProgramData\NVIDIA Corporation\CUDA Samples\v10.1)添加到Path变量中,方便调用示例程序。

验证驱动安装 :

- 打开NVIDIA控制面板,检查驱动版本和设备状态是否正常。

- 使用设备管理器检查显示适配器是否有任何问题。

4.2 Windows系统下的性能优化

在安装和配置好CUDA环境后,接下来是针对Windows系统的性能优化。

4.2.1 系统级别的优化设置

Windows系统优化主要从磁盘、内存、处理器等方面入手。

- 磁盘优化 :

- 使用NTFS文件系统的磁盘碎片整理功能,提高存储设备的读写速度。

-

禁用或减少虚拟内存(页面文件),减轻磁盘I/O压力。

-

内存管理 :

- 增加系统的页面文件大小,以确保在内存使用高峰时系统性能不会下降。

-

定期运行内存诊断工具检查系统内存健康状况。

-

处理器设置 :

- 在“电源选项”中设置高性能模式,确保处理器运行在最大性能状态。

-

在系统服务中,合理关闭或调整不必要的系统服务,减少处理器负载。

-

系统服务和启动项 :

- 通过任务管理器和服务管理工具,禁用不必要的启动项和服务,提高系统启动速度和运行效率。

4.2.2 CUDA程序性能调优策略

对于CUDA程序,性能调优通常涉及以下几个方面:

- 内存访问优化 :

- 利用CUDA提供的内存访问功能,如共享内存和纹理内存,减少全局内存访问延迟。

-

尽量减少对全局内存的非对齐访问,使用类型转换和内存复制函数来优化数据存取。

-

核函数调用优化 :

- 适当调整网格和块的尺寸,平衡资源占用和核函数执行效率。

-

合理利用CUDA的多线程特性,确保GPU计算资源的最大化利用。

-

异步内存传输 :

- 使用CUDA流来组织内存拷贝和核函数调用,让它们在硬件上并行运行。

-

在不同流中重叠内存传输和核函数执行,提高整体执行效率。

-

编译器优化选项 :

- 使用nvcc编译器的优化选项,如

-O3或-arch=sm_XX(针对特定GPU架构)来编译代码,获取更高的性能。 - 利用编译器的自动向量化功能,简化代码的同时提高性能。

4.3 Windows下常见问题诊断与解决

在CUDA开发过程中,可能会遇到各种问题。以下是一些常见的错误类型和解决方案。

4.3.1 常见错误与警告分析

错误分析 :

- CUDA_ERROR_OUT_OF_MEMORY :

- 常见于内存资源不足的情况,需检查内存使用情况并优化程序。

- CUDA_ERROR_INVALID_DEVICE :

- 指示尝试在一个不存在的设备上执行CUDA操作,检查设备ID和系统配置是否正确。

警告分析 :

- CUDA WARNING_600 :

- 可能出现在使用NVIDIA视觉计算SDK时,建议仔细阅读SDK文档,找到相应的解决方案。

4.3.2 调试工具和故障排除技巧

- Nsight :

- 使用NVIDIA的Nsight工具进行CUDA应用程序的调试和性能分析。

-

通过Nsight可以观察核函数的执行过程、内存使用情况和性能瓶颈。

-

CUDA-GDB :

- 对于需要更深层次调试的应用程序,使用CUDA-GDB可以帮助开发者进行源代码级别的调试。

- CUDA-GDB支持断点设置、变量检查等强大功能。

通过上述分析和调试工具的使用,可以快速定位并解决问题,保证CUDA程序在Windows平台上的稳定运行。在实际工作中,诊断和解决问题的技能是非常重要的,它可以帮助开发者更深入地理解CUDA程序的行为,并优化程序性能。

5. CuDNN在GPU加速计算中的作用

5.1 CuDNN与GPU加速的关系

5.1.1 GPU计算基础与CUDA的角色

在讨论CuDNN之前,我们首先要了解GPU加速计算的基础和CUDA的作用。GPU加速计算指的是利用图形处理器(GPU)强大的并行计算能力,来提高数值和科学计算的效率。这种计算模式尤其适合于那些可以被分解为许多小的并行计算任务的应用,比如深度学习训练和推理。

CUDA(Compute Unified Device Architecture)是由NVIDIA推出的一个并行计算平台和编程模型,它允许开发者使用C、C++以及其他语言直接编写能在GPU上运行的程序。CUDA为GPU加速计算提供了一个易于使用的接口,使得开发者能够更加专注于问题的解决,而不是底层的硬件细节。

5.1.2 CuDNN在GPU加速中的优化贡献

CuDNN是专门为深度神经网络设计的GPU加速库,它是NVIDIA提供的深度学习软件堆栈的重要组成部分。CuDNN对许多常见的深度学习操作进行了高度优化,例如卷积、池化和归一化等。这些优化显著提高了计算性能,加速了深度学习模型的训练和推理过程。

在GPU加速计算中,CuDNN的作用在于:

- 提供高效的实现 :CuDNN提供了大量的深度学习算法的高效实现,这些实现充分利用了GPU的并行架构。

- 减少开发者的工作量 :通过封装底层的优化细节,CuDNN使得开发者可以更加专注于网络结构的设计,而不必担心底层的计算细节。

- 支持广泛的深度学习框架 :CuDNN被多个主流的深度学习框架所支持,如TensorFlow、PyTorch等,这为开发者提供了极大的便利性。

5.2 CuDNN在深度学习中的具体应用

5.2.1 加速卷积神经网络的关键技术

卷积神经网络(CNN)是深度学习中一个重要的领域,广泛应用于图像识别、视频分析和自然语言处理等任务。CuDNN提供的优化主要集中在加速卷积神经网络的关键操作上,包括:

- 高效的卷积算法 :例如Winograd算法、FFT(快速傅里叶变换)等,这些算法能够显著减少计算量。

- 张量格式优化 :为了适应GPU的内存和带宽,CuDNN设计了特定的张量格式,比如cuDNN_TensorFormat_t。

- 内存和计算复用 :通过重用内存和计算,避免不必要的数据传输,以此减少延迟和提高吞吐量。

5.2.2 CuDNN在不同深度学习任务中的应用案例

CuDNN广泛应用于各种深度学习任务,其中一些具体的应用案例包括:

- 图像识别 :在图像识别任务中,如CIFAR-10或ImageNet数据集上的分类,CuDNN加速了网络中卷积层的处理,大幅缩短了训练时间。

- 自然语言处理 :在NLP领域,如BERT模型的训练和推理,CuDNN优化了网络中涉及到的复杂操作,提升了模型的运行效率。

- 强化学习 :在强化学习的多个应用中,如AlphaGo,CuDNN为高效计算策略网络和价值网络提供了支持。

5.3 CuDNN的未来展望和发展趋势

5.3.1 CuDNN的技术演进路线图

随着时间的推移,深度学习模型变得越来越复杂,对计算效率的需求也越来越高。未来的CuDNN将会继续围绕以下几个方向发展:

- 性能优化 :持续优化现有算法,研究新的算法和数据表示形式,以进一步提高计算效率。

- 易用性和可扩展性 :提供更加友好的API接口,使得更多的开发者能够受益于GPU加速。

- 支持新的硬件 :随着新硬件的不断推出,CuDNN也将持续更新以支持NVIDIA的最新GPU架构。

5.3.2 CuDNN与深度学习技术的融合展望

深度学习技术在不断进步,而CuDNN作为一个底层库,将继续与之紧密融合:

- 网络结构创新 :新的深度学习架构需要更高效的计算支持,CuDNN将为这些创新架构提供必要的优化。

- 自动化和智能化 :CuDNN未来的发展可能会融入更多自动化和智能化的元素,例如自动调优网络执行计划,以适应不同的计算场景。

- 跨平台和跨设备 :随着技术的发展,对跨平台和跨设备的优化需求日益增长,CuDNN也可能在这一方向上进行拓展。

CuDNN的作用不仅仅是作为一个库那么简单,它的发展紧密跟随深度学习的步伐,推动着整个领域的进步。

简介:本文介绍了NVIDIA CUDA深度神经网络库(CuDNN)的特定版本v7.6.5.32,适用于CUDA 10.1环境和Windows 10 64位系统。CuDNN是深度学习算法加速库,提供了针对各种深度学习模型的优化算法,能够利用GPU并行计算提升性能。CUDA 10.1版本支持最新GPU架构,改善内存管理和Tensor Core性能。CuDNN的安装包包含了头文件、库文件、示例代码等,是深度学习开发者在Windows环境下进行GPU加速计算的重要工具。

403

403

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?