简介:iOS 11引入了Core ML框架,该框架作为机器学习在苹果设备上的核心工具,支持将多种机器学习模型集成到iOS应用中,实现图像识别、自然语言处理等智能功能。本文详细介绍Core ML的框架概述、模型支持、性能优化、集成流程、示例代码、工具支持、隐私保护、持续更新以及应用实例,旨在帮助开发者深入理解和实践如何利用Core ML提升移动应用的智能化水平。

1. Core ML框架概述与特点

概述

Core ML是苹果公司推出的机器学习框架,旨在让开发者轻松地将机器学习模型集成到iOS、macOS、watchOS和tvOS应用中。它支持广泛的机器学习任务,包括分类、回归、聚类等,并提供了一系列优化工具,以便开发者能高效地进行模型训练和部署。

特点

Core ML具有以下显著特点: - 高性能 :能够在多种Apple设备上实现快速且高效的机器学习。 - 易用性 :简化了模型集成流程,开发者无需深入了解机器学习原理。 - 隐私保护 :所有的数据处理在设备上进行,无需云服务,保障用户隐私。 - 广泛兼容 :支持多种机器学习库和框架的转换,例如TensorFlow、scikit-learn等。

通过这些特点,Core ML为开发者提供了一个简单、高效且安全的方式来引入机器学习功能到其应用中。接下来的章节将深入探讨Core ML支持的模型类型和特点。

2. 支持的机器学习模型类型

2.1 模型类型的基本介绍

2.1.1 了解Core ML支持的模型种类

Core ML(Core Machine Learning)框架自2017年随iOS 11推出以来,已经成为苹果生态系统中进行机器学习模型部署的首选工具。Core ML支持多种机器学习模型,使其可以在iOS设备上本地运行,包括但不限于以下几种:

- 神经网络模型(Neural Networks):支持多种层结构的神经网络,包括卷积层(Convolution)、循环层(Recurrent)、全连接层(Fully Connected)等。

- 决策树(Decision Trees)与随机森林(Random Forests):用于分类和回归任务。

- 支持向量机(Support Vector Machines, SVM):主要用于分类和回归分析。

- 广义线性模型(Generalized Linear Models, GLM):用于线性回归、逻辑回归等。

- 传统机器学习模型:如k-最近邻(k-NN)、梯度提升树(Gradient Boosted Trees)等。

以上这些模型涵盖了从简单的线性模型到复杂的神经网络模型,使得开发者能够针对不同的应用场景选择最合适的模型。

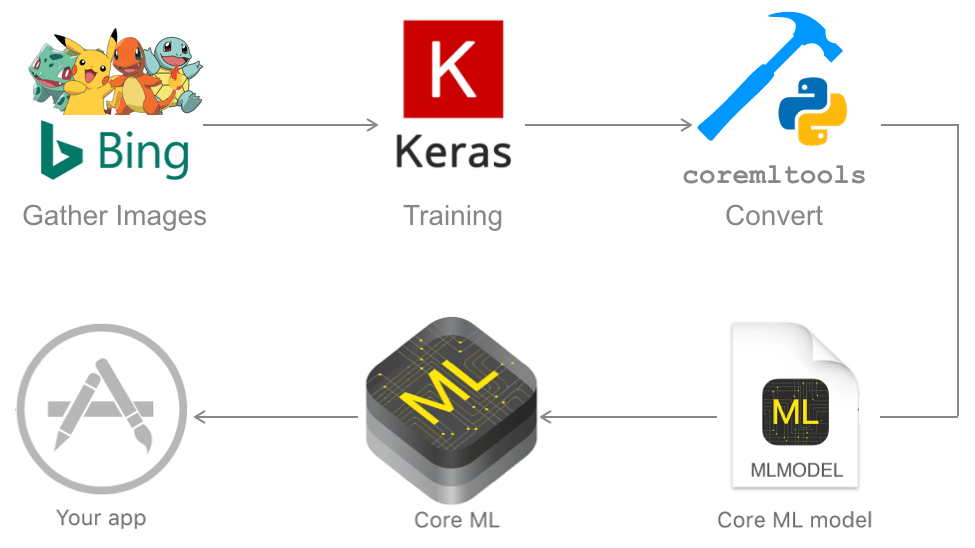

2.1.2 模型的转换方法和工具

为了让模型能够在iOS设备上运行,需要将其转换为Core ML支持的格式。苹果提供了 coremltools 库,它允许数据科学家和开发者将训练好的模型转换为 .mlmodel 文件。 coremltools 支持从流行的机器学习框架如TensorFlow, Keras, scikit-learn, XGBoost等导入模型。

例如,将一个Keras构建的神经网络模型转换为Core ML模型可以通过以下步骤完成:

import coremltools as ct

# 假设已有一个Keras模型 keras_model

# 将Keras模型转换为Core ML模型

model = ct.convert(keras_model, compute_precision='double', minimum_deployment_target=ct.target.iOS13)

# 保存转换后的模型

model.save('MyModel.mlmodel')

在这个例子中, convert 函数负责处理转换工作, minimum_deployment_target 参数定义了模型的最小部署版本。通过这样的转换过程,开发者可以将训练好的模型部署到iOS设备上运行。

2.2 模型的结构和工作原理

2.2.1 深入模型内部架构

一个Core ML模型通常由多个组件组成,包括输入输出规范、模型参数、预测逻辑等。在内部,Core ML使用一种标准化的格式来表示模型,确保不同类型的模型能够被iOS平台正确解析和执行。

以一个简单的神经网络为例,其内部架构通常包括如下几个关键部分:

- 输入层(Input Layer):定义了模型的输入数据维度和格式。

- 输出层(Output Layer):输出模型的预测结果。

- 隐藏层(Hidden Layers):位于输入层和输出层之间,执行特征提取和数据转换的任务。

- 网络权重(Weights):决定着神经元之间连接的强度。

以下是一个简化后的神经网络的Mermaid流程图表示:

graph LR

A[输入层] --> B[隐藏层1]

B --> C[隐藏层2]

C --> D[输出层]

2.2.2 模型参数和权重解析

每个神经网络模型都有自己的权重矩阵和偏置项,这些参数是模型训练过程中学到的。在Core ML模型中,权重矩阵会被序列化并存储在模型文件中。

权重的解析过程通常涉及以下步骤:

- 初始化模型:通过

coremltools库加载模型文件。 - 遍历模型的层级结构:获取各个层的信息。

- 读取权重数据:根据层类型,提取对应的权重和偏置数据。

代码示例:

# 加载ML模型

model = ct.models.MLModel('MyModel.mlmodel')

# 遍历模型层级获取权重

for layer in model.spec.description.layers:

if hasattr(layer, 'weight'):

weight = layer.weight

print(f'Layer name: {layer.name} with weight shape: {weight.shape}')

2.3 模型的选择与优化建议

2.3.1 如何根据需求选择合适的模型

在选择模型时,需要考虑以下几个关键因素:

- 数据量大小:大规模数据集可能需要更复杂的模型结构。

- 性能需求:对于实时性要求较高的应用,需要轻量级的模型以保证快速响应。

- 精度需求:对预测准确性要求高的应用场景需要选择复杂度更高的模型。

- 设备限制:考虑到不同iOS设备的计算能力和内存限制。

举例来说,如果需要在iPhone上实现图像识别功能,卷积神经网络(CNN)是一个不错的选择,因为它擅长处理图像数据,并且可以通过模型压缩和量化技术优化,使其适应移动设备的性能限制。

2.3.2 模型优化的策略和技巧

模型优化可以从以下几个方面着手:

- 模型剪枝:通过移除神经网络中不必要的权重来减小模型体积,降低计算复杂度。

- 权重量化:将浮点数权重转换为低精度的数值(如INT8),减小模型大小,加快推理速度。

- 知识蒸馏:将大型复杂模型的知识迁移到小型模型中,保持性能的同时减少模型的复杂度。

- 使用专门的iOS优化技术:比如使用Core ML的神经网络API进行模型加速。

以量化为例,它可以将一个浮点数权重的模型转换成8位整数权重模型:

import coremltools as ct

model = ct.models.MLModel('MyModel.mlmodel')

# 对模型进行量化

quantized_model = ct.models.neural_network.quantize(model, nbits=8)

quantized_model.save('MyQuantizedModel.mlmodel')

这个过程通过减少权重的精度来加快模型的计算速度,同时在大多数情况下保持了模型的准确度。

通过上述的章节,我们了解了Core ML所支持的模型类型以及它们的内部结构。在下一章节中,我们将深入了解如何将这些模型应用于图像识别技术中,以及图像识别的基本概念与方法。

3. 图像识别技术应用

3.1 图像识别的基本概念与方法

3.1.1 图像识别的常见算法

图像识别是指让计算机通过图像处理算法对图像进行处理和分析,从而识别出图像中的内容和特征的过程。在这一领域,有许多成熟的算法,比如支持向量机(SVM)、深度神经网络(DNN)、卷积神经网络(CNN)等。其中,CNN因其在处理图像方面的卓越能力而备受关注,成为目前图像识别领域最流行的算法之一。

CNN模型特别擅长于提取图像的空间层级特征,它通过卷积层、池化层和全连接层等结构自动学习图像的特征表示。这种层级结构设计能够从底层简单特征到高层复杂特征进行递进式抽象,非常适合于图像识别任务。

3.1.2 核心技术解读

图像识别的核心技术之一是特征提取,它包括手工特征提取和自动特征提取。手工特征提取依赖于图像处理的专业知识,而自动特征提取则依赖于深度学习模型的自学习能力。

自动特征提取是通过训练一个深度学习网络来自动学习从原始像素到高级特征的映射。这个过程不需要人为地设计特征,网络通过多层非线性变换自动提取图像的关键信息。自动特征提取极大地减少了人工干预,提高了识别系统的泛化能力。

3.2 Core ML在图像识别中的应用

3.2.1 利用Core ML进行图像识别

Core ML是苹果公司提供的一个机器学习框架,支持在iOS、macOS等苹果平台上部署机器学习模型。对于图像识别任务,Core ML可以利用已经训练好的CNN模型,实现快速准确的图像分析。

在实际应用中,开发人员可以使用Core ML将训练好的模型文件直接导入Xcode项目中,并通过API与模型交互。Core ML能够自动优化模型,使之适合在移动设备上运行,同时保持较高的准确性。

3.2.2 实际案例分析

为了更具体地了解Core ML在图像识别中的应用,我们可以考虑一个实际的案例:使用Core ML构建一个花卉识别应用。开发者首先需要准备一个预先训练好的花卉识别模型,然后使用Core ML工具进行转换,使其能够集成到iOS应用中。

在应用中,当用户拍摄或选择一张花卉图片后,应用通过Core ML调用模型进行识别,然后将识别结果呈现给用户。这个案例演示了如何快速将复杂的图像识别模型转化为用户友好的功能。

3.3 图像识别的性能优化

3.3.1 优化图像处理流程

在图像识别应用中,性能优化是至关重要的。优化图像处理流程可以通过多种方式进行,例如,预处理图像以减少尺寸和复杂性,只保留对模型识别至关重要的部分。

预处理通常包括调整图像大小、裁剪、归一化、增强对比度等操作。这些操作有助于减少模型输入的维度,加快模型的运算速度,同时对准确率的影响较小。

3.3.2 利用硬件加速提升效率

另一个提升图像识别效率的方法是利用iOS设备的硬件加速特性。例如,使用Metal框架,开发者可以将深度学习模型部署到GPU上运行,从而加快模型的计算速度。

苹果公司提供的神经网络API(Neural Engine)可以进一步加速模型计算。这些优化手段能够大大提升图像识别的速度,使应用响应更迅速,用户体验更流畅。

// 示例代码,展示如何使用Core ML和Metal进行图像识别

import CoreML

import Metal

// 加载模型

let model = try!鸢尾花分类器().model

// 使用Core ML创建一个预测器

let predictor = try! VNCoreMLModel(for: model)

// 在Metal中配置加速器

let device = MTLCreateSystemDefaultDevice()

let commandQueue = device!.makeCommandQueue()

// 加载图像并进行预处理...

// 使用Metal进行图像处理...

// 使用Core ML进行预测...

通过上述方法,我们可以看到,如何将Core ML与iOS设备的硬件加速相结合,提高图像识别的效率和性能。

在下一章节,我们将深入探讨Core ML在iOS应用集成中的实践细节和优化策略。

4. 性能优化与硬件优势利用

随着人工智能的不断演进,性能优化和硬件优势的利用成为了提升机器学习应用效率的关键。Core ML作为苹果公司推出的机器学习框架,在性能优化与硬件协同工作方面提供了丰富的工具和策略。本章节将深入探讨性能优化的方法和硬件优势的利用方式。

4.1 性能优化的策略与实践

性能优化对于任何机器学习应用来说都是至关重要的。我们需要了解性能瓶颈的所在,并据此采取相应的优化措施。

4.1.1 理解和分析性能瓶颈

在使用Core ML进行开发时,开发者可能会遇到性能瓶颈。这些瓶颈可能是由于算法效率不高、模型大小过大的内存占用、或是运行时CPU/GPU的负载不均衡等原因造成的。为了解决这些问题,首先需要通过工具和方法来定位瓶颈的具体位置。

分析步骤

- 监控资源使用情况 :使用Xcode内置的Instruments工具来监控应用的CPU、GPU、内存等资源的使用情况。

- 性能日志分析 :通过Xcode的Console或使用命令行工具

log收集性能相关日志。 - Core ML工具分析 :使用

coremltools包中的命令行工具进行模型的性能分析。 - 代码级优化 :对于在特定代码段中发现的性能问题,可以使用Swift的性能分析工具,例如

timeProfile来进一步分析。

4.1.2 实际操作中的优化步骤

一旦找到性能瓶颈,就可以采取以下步骤进行优化:

- 模型优化 :通过模型剪枝、量化等技术来减小模型大小,提高运行速度。

- 算法优化 :对算法进行重构,使用更高效的算法或数据结构。

- 硬件加速 :利用Core ML的硬件加速功能,例如使用

VNImageRequestHandler来处理图像识别任务。 - 并行计算 :在可能的情况下,采用并行计算来充分利用多核处理器的能力。

- 缓存优化 :合理地利用缓存可以显著提高性能,例如缓存模型预处理的结果。

// 示例:使用VNImageRequestHandler进行图像识别任务

import Vision

let request = VNDetectFaceLandmarksRequest(completionHandler: { (request, error) in

// 处理识别结果

})

let handler = VNImageRequestHandler(cvPixelBuffer: pixelBuffer, options: [:])

do {

try handler.perform([request])

} catch {

print(error)

}

4.2 硬件优势的利用方法

Core ML与iOS设备硬件的协同工作能够带来出色的性能表现。以下是如何深入探讨硬件加速技术,从而利用硬件的优势。

4.2.1 Core ML与iOS设备硬件的协同工作

苹果公司在硬件设计上投入巨大,其设计的芯片在运行机器学习模型时有着出色的表现。为了充分利用这些硬件优势,开发者需要了解如何让Core ML与iOS设备的硬件协同工作。

硬件优化要点

- 使用Neural Engine :利用Neural Engine可以将特定的机器学习任务卸载到专用硬件上执行,从而获得更高的性能。

- CPU/GPU协同 :对于不完全适合Neural Engine处理的任务,合理分配CPU和GPU资源,以平衡负载。

- 编译模型以适应特定硬件 :在使用

coremltools转换模型时,可以指定目标硬件选项,从而优化模型以在特定硬件上运行。

4.2.2 硬件加速技术的深入探讨

为了进一步提升性能,开发者应当熟悉并实践各种硬件加速技术。

加速技术应用

- 使用Core ML的并行计算 :利用Core ML提供的API进行模型的并行执行。

- 使用Metal :Metal是苹果公司推出的一个低开销、高性能的API,用于直接访问GPU进行图形渲染和计算任务。在进行大量并行计算时,Metal可以带来显著的性能提升。

- 利用Vulkan API :对于图形渲染任务,可以使用Vulkan API进行优化,虽然它是标准的跨平台图形和计算API,但在苹果生态系统中同样可以使用,并且和Core ML能够协同工作。

4.3 面向未来的技术展望

随着苹果公司对硬件的持续更新,我们可以预见性能优化会有一个全新的未来。本节将探索苹果公司对硬件的更新计划以及预测其对性能优化的影响。

4.3.1 苹果公司对硬件的更新计划

苹果公司致力于推动其硬件性能的不断提升,这通常包括定期的芯片更新,以及可能的新处理器架构。例如,苹果的M1芯片在集成度和性能上都有显著提升,这使得在将来的设备中我们可以期待更强大的计算能力。

4.3.2 对性能优化影响的预测分析

随着硬件能力的增强,Core ML可以被期望在以下方面得到性能上的提升:

- 更快的执行速度 :更强大的处理器将直接提升执行速度。

- 更大的模型支持 :更多的内存和更快的存储将允许处理更大的模型。

- 更智能的性能调度 :硬件可能包含更智能的性能管理机制,自动优化性能与电池寿命的平衡。

通过本章的探讨,我们已经对性能优化有了一个全面的了解,并且认识到了硬件优化的重要性。随着技术的发展,性能优化将不断被推向新的高度,而Core ML与硬件的结合将使这一切成为可能。

5. Core ML在iOS应用中的集成与实践

5.1 集成步骤的详细解读

5.1.1 集成前的准备工作

在将Core ML模型集成到iOS应用之前,开发者需要确保他们已经有了一个经过训练并转换为 .mlmodel 格式的机器学习模型。转换过程通常可以通过Xcode自带的模型转换工具进行,或者使用命令行工具 coremlconvert 进行转换。确保模型转换成功后,可以使用Xcode中的Core ML编辑器进一步检查模型结构,并进行必要的配置。

5.1.2 集成过程中的关键步骤

集成Core ML模型到iOS应用主要包括以下步骤:

- 添加模型文件 :将

.mlmodel文件拖拽到Xcode项目中。 - 配置项目 :在Xcode中,选择项目设置中的

Build Phases,添加Core ML框架(CoreML.framework)。 - 生成代码接口 :选中

.mlmodel文件,使用Xcode提供的工具生成模型的代码接口。这将允许应用以编程方式调用模型。 - 编写调用模型的代码 :在应用代码中,通过生成的接口类调用模型进行预测或处理数据。

- 配置权限和隐私 :确保应用的

Info.plist中配置了必要的权限和隐私声明,尤其是涉及相机、照片库或位置等敏感数据时。

5.2 示例代码与项目集成实例

5.2.1 通过代码示例学习集成

下面的代码示例展示了如何使用生成的接口类 MyModel 调用一个预训练的Core ML模型:

import CoreML

class ViewController: UIViewController {

var model: MyModel!

override func viewDidLoad() {

super.viewDidLoad()

// 初始化模型

model = MyModel()

// 准备输入数据

let inputData = MyModelInput(image: UIImage(named: "example.jpg")!)

// 调用模型进行预测

model.prediction(inputData: inputData) { (result, error) in

if let error = error {

print(error)

} else {

// 处理预测结果

print(result.classLabel)

}

}

}

}

5.2.2 分析成功集成的项目案例

一个成功的集成项目案例通常展示如何将模型集成到一个完整的应用中,并且如何展示和处理模型的输出。例如,在一个图像识别应用中,应用可能集成了一个Core ML模型用于识别照片中的对象,并将识别结果显示在界面上。开发者可能会采用异步处理来避免阻塞主线程,并使用苹果的 Vision 框架来处理图像数据,准备输入到Core ML模型中。

5.3 集成后的调试与优化

5.3.1 使用Xcode进行调试

在Xcode中,开发者可以利用 Debug 和 Debug Area 来检查代码执行流程和模型调用是否正常。此外, Print 语句也可以在调试过程中输出模型输入输出数据,帮助开发者理解模型的实际工作状态。

5.3.2 性能优化与问题排查技巧

在集成Core ML模型后,性能优化是提高用户体验的关键。开发者可以采取以下措施:

- 预处理图像 :在传递给模型之前,对图像进行裁剪、缩放等预处理操作以减少计算量。

- 内存优化 :确保及时释放不再使用的资源,避免内存泄漏。

- 利用Swift的特性 :使用Swift的

lazy属性或者guard语句来优化代码。 - 硬件加速 :确保使用支持Core ML加速的设备,同时考虑使用

AVFoundation框架来处理多媒体数据。

5.4 用户数据隐私保护措施

5.4.1 了解和遵守隐私保护法律法规

在使用Core ML集成数据处理功能时,开发者应确保遵守相关的法律法规,尤其是关于个人数据和隐私的。例如,对于欧盟地区,需要遵守通用数据保护条例(GDPR),而美国加州则有消费者隐私法案(CCPA)。

5.4.2 在应用中实施数据保护策略

开发者应采取以下措施保护用户数据隐私:

- 最小化数据收集 :仅收集实现应用功能所必需的数据。

- 透明性 :向用户提供清晰的隐私政策,告知他们数据的使用方式。

- 安全措施 :采取加密、安全存储等措施保护用户数据安全。

5.5 Core ML功能的持续更新与扩展

5.5.1 定期更新的重要性

随着技术的不断进步,模型也需要不断更新以保持其准确性和效率。定期更新模型可以帮助保持应用的竞争力,并对用户需求变化做出快速响应。

5.5.2 扩展新功能的实现方式

为了扩展新功能,开发者可以:

- 监控模型性能 :持续监控模型在实际应用中的表现,找出性能瓶颈。

- 收集反馈 :从用户那里收集反馈,了解模型需要改进的方向。

- 集成新模型 :引入新的或改进的机器学习模型,并按照集成流程将其集成到现有应用中。

5.6 不同领域的应用实例

5.6.1 探索Core ML在不同行业中的应用案例

Core ML的应用案例跨越了多个领域,包括但不限于:

- 金融 :使用Core ML进行风险评估和欺诈检测。

- 健康医疗 :提供疾病预测和辅助诊断。

- 零售 :实现个性化推荐和库存管理。

5.6.2 分析行业特有的集成策略与挑战

不同行业的集成策略和挑战各异。例如,在健康医疗领域,集成策略需要着重考虑合规性和隐私保护。而在金融领域,则需要特别注意模型的解释性和决策透明度。因此,开发者需要针对不同行业特有的需求和限制,采取相应的集成策略,并解决相关的技术挑战。

简介:iOS 11引入了Core ML框架,该框架作为机器学习在苹果设备上的核心工具,支持将多种机器学习模型集成到iOS应用中,实现图像识别、自然语言处理等智能功能。本文详细介绍Core ML的框架概述、模型支持、性能优化、集成流程、示例代码、工具支持、隐私保护、持续更新以及应用实例,旨在帮助开发者深入理解和实践如何利用Core ML提升移动应用的智能化水平。

686

686

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?