本篇Hadoop系统基础环境搭建是对接上一次更新,之前的步骤链接如下:https://blog.csdn.net/weixin_42588131/article/details/100629196

正文开始

1.5配置SSH免密

(1)配置SSH免密码登陆

SSH主要通过RSA算法来产生公钥与私钥,在数据传输过程中对数据进行加密来保障数据的安全性和可 靠性,公钥部分是公共部分,网络上任一结点均可以访问,私钥主要用于对数据进行加密,以防他人盗取 数据。总而言之,这是一种非对称算法,想要破解还是非常有难度的。Hadoop集群的各个结点之间需要 进行数据的访问,被访问的结点对于访问用户结点的可靠性必须进行验证,hadoop采用的是ssh的方法通 过密钥验证及数据加解密的方式进行远程安全登录操作,当然,如果hadoop对每个结点的访问均需要进行 验证,其效率将会大大降低,所以才需要配置SSH免密码的方法直接远程连入被访问结点,这样将大大提 高访问效率。

每个结点分别产生公私密钥:

ssh-keygen -t dsa -P ‘’ -f ~/.ssh/id_dsa(三台机器)

秘钥产生目录在用户主目录下的.ssh目录中,进入相应目录查看:cd .ssh/

Id_dsa.pub为公钥,id_dsa为私钥,紧接着将公钥文件复制成authorized_keys文件:(仅master) cat id_dsa.pub >> authorized_keys(注意在.ssh/路径下操作)

(2)在主机上连接自己

ssh master

(3)让主节点master通过SSH免密登陆两个子节点slave (slave 操作)

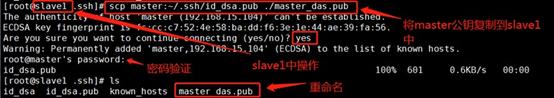

为了实现这个功能,两个slave结点的公钥文件中必须要包含主结点的公钥信息,这样 当master就可以顺利安全地访问这两个slave结点了。 slave1结点通过scp命令远程登录master结点,并复制master的公钥文件到当前的目录下,且重命名为master_das.pub,这一 过程需要密码验证。

scp master:~/.ssh/id_dsa.pub ./master_das.pub

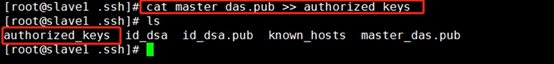

将master结点的公钥文件追加至authorized_keys文件。 cat master_dsa.pub >> authorized_keys

这时,master就可以连接slave1了

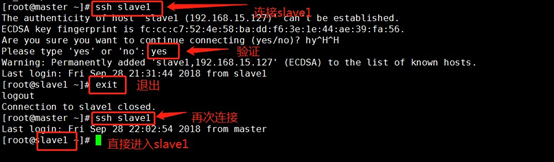

slave1结点首次连接时需要,“yes”确认连接,这意味着master结点连接slave1结点时需要人 工询问,无法自动连接,输入yes后成功接入,紧接着注销退出至master结点。

同理slave2中也是这么操作。

注意:两个结点的ssh免密码登录已经配置成功,还需要对主结点master也要进行上面的同 样工作,因为jobtracker有可能会分布在其它结点上,jobtracker有不存在master结点上的可能性。 在上一步骤中,我们已经进行过此操作,这里仅做提醒。

1.6 JDK 的安装

(1)首先建立工作路径/user/java

mkdir

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

331

331

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?