简介:"azure-data-scraper"是一个基于Python的工具,专为高效抓取和处理Azure平台数据而设计。该工具提供了对多种Azure服务如Blob Storage、Table Storage、SQL Database和Cosmos DB的数据访问和提取支持。它利用Python的各类库简化与Azure的交互,包含身份验证、数据提取、数据库操作、数据转换、批量处理、错误处理、日志记录和可配置参数等功能。适用于数据备份、迁移、分析前的数据准备等场景,提高开发者与Azure数据服务交互的效率。

1. Azure数据抓取与处理

在当今数字化转型浪潮中,企业需要高效地从各种数据源抓取和处理数据,以便洞察业务趋势和做出数据驱动的决策。 Azure数据抓取与处理 章节作为本博客的开篇,旨在为读者展示如何利用微软的云服务平台Azure来实现这一目标。

1.1 Azure数据抓取概述

Azure提供了多元化的数据抓取工具和接口,能够连接多种数据源,包括但不限于社交媒体、网站API、企业内部数据库等。通过Azure的数据抓取功能,用户可以轻松地将数据导入到Azure云中进行存储、处理和分析。

1.2 数据抓取工具的集成与应用

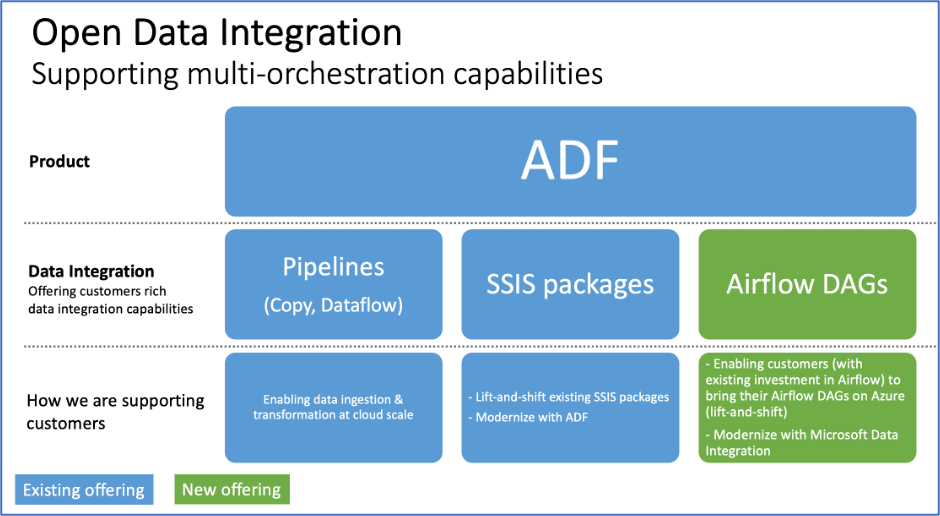

为了更好地支持数据抓取,Azure平台集成了多种工具和服务,例如Azure Functions可以实现基于事件的数据抓取,Azure Logic Apps提供了强大的数据流自动化能力。此外,Azure Data Factory则是针对大规模数据迁移和转换提供的工具。

1.3 数据处理与分析的重要性

抓取的数据必须经过有效的处理和分析才能转化为有价值的洞察。本章节将重点讲解数据预处理的步骤,如数据清洗、转换,以及如何利用Azure的计算服务进行批量数据处理,为后续的数据分析和挖掘打下坚实的基础。

2. Python与Azure交互工具

2.1 Python与Azure的连接技术

2.1.1 Azure SDK for Python介绍

Azure SDK for Python 是一组库,允许开发者使用Python编写代码来创建、测试、部署和管理Azure服务中的应用程序。通过这个SDK,开发者能够控制Azure服务,如虚拟机、存储、数据库、身份验证和许多其他功能。

SDK提供了一种方式,通过一套高级别的APIs,简化了与Azure服务的交互。通过SDK,Python代码可以更容易地进行身份验证、发起请求、处理响应等。Azure SDK for Python 遵循PEP标准,因此对Python社区友好,并具有良好的文档和API设计。

以下是一些主要的特点:

- 易于使用 : Azure SDK for Python提供一致的API设计,使得开发者可以快速上手。

- 自动化的身份验证 : SDK内部处理Azure的OAuth流程,简化了认证过程。

- 完整的功能覆盖 : 从基础资源管理到高级服务操作,几乎所有的Azure服务在SDK中都有对应的模块。

2.1.2 Python客户端库的应用实例

一个常见的应用实例是使用Azure的存储服务。Python客户端库使得开发者可以很轻松地在Azure Blob存储中上传和下载文件。

from azure.storage.blob import BlobServiceClient

# 连接到Azure存储账户

connect_str = 'DefaultEndpointsProtocol=https;AccountName=<your_account_name>;AccountKey=<your_account_key>;EndpointSuffix=***'

blob_service_client = BlobServiceClient.from_connection_string(connect_str)

# 获取容器客户端

container_client = blob_service_client.get_container_client("mycontainer")

# 上传文件

with open('example.txt', 'rb') as data:

container_client.upload_blob(name="example.txt", data=data)

# 下载文件

blob_client = container_client.get_blob_client("example.txt")

downloaded = blob_client.download_blob()

downloaded_content = downloaded.readall()

在这个代码示例中,我们首先创建了一个 BlobServiceClient 实例来管理存储账户。然后,我们获取了一个容器客户端来处理特定的容器。之后,我们可以使用 upload_blob 方法上传一个文件到Blob存储,或者使用 download_blob 方法下载文件。

这个过程是异步的,使用 async 和 await 可以进一步优化性能。

2.2 脚本和自动化流程

2.2.1 使用Python脚本自动化Azure任务

自动化是提高效率和减少错误的关键。使用Python可以自动化几乎所有的Azure任务,包括管理虚拟机、创建数据库、处理数据等。

import os

from azure.mgmt.resource import SubscriptionClient

from azure.mgmt.resource.resources import ResourceManagementClient

# 初始化客户端

subscription_id = os.environ['AZURE_SUBSCRIPTION_ID']

credential = os.environ['AZURE_CREDENTIAL']

subscription_client = SubscriptionClient(credential)

subscription = next(subscription_client.subscriptions.list())

resource_client = ResourceManagementClient(credential, subscription_id)

resource_group_params = {'location': 'eastus2'}

rg_result = resource_client.resource_groups.create_or_update('MyResourceGroup', resource_group_params)

在这个脚本中,我们使用Azure Python SDK来创建或更新资源组。首先,我们获取一个订阅客户端来访问Azure订阅,然后创建一个资源管理客户端。最后,我们调用 create_or_update 方法来创建或更新一个名为"MyResourceGroup"的资源组。

2.2.2 脚本的集成与调度

脚本的集成与调度通常涉及到定时任务或事件触发器。Azure中有多种方式可以实现这一点,例如使用Azure Functions或Azure Logic Apps。

以Azure Functions为例,可以编写一个Python函数,当特定事件发生时(例如文件上传到Blob存储),函数会自动触发并执行预定义的逻辑。

import azure.functions as func

def main(req: func.HttpRequest, context: func.Context) -> func.HttpResponse:

# 自动化任务的代码逻辑

pass

然后通过Azure门户或Azure CLI来配置触发器,例如HTTP请求、时间计划或特定事件。

2.3 交互式数据探索

2.3.1 Jupyter Notebook在Azure中的应用

Jupyter Notebook是一种交互式计算工具,允许你创建和共享包含代码、可视化和解释文本的文档。在Azure中,可以利用Azure Notebooks这一服务,让你在云端运行Jupyter Notebook。

2.3.2 数据探索与可视化工具的结合

结合Jupyter Notebook和Azure存储服务,开发者和数据分析师可以轻松地探索、分析和可视化数据。

例如,使用Pandas库读取Azure Blob存储中的CSV文件,并使用Matplotlib库进行可视化:

import pandas as pd

import matplotlib.pyplot as plt

# 读取CSV文件

df = pd.read_csv('***<your_account_name>.***/mycontainer/myfile.csv')

# 数据可视化

df.plot(kind='scatter', x='columnX', y='columnY')

plt.show()

在实际场景中,数据探索的步骤可能包括数据清洗、数据变换和预测模型的建立等,而Jupyter Notebook提供了灵活的平台来执行这些步骤。

以上就是Python与Azure交互工具的详细介绍,下一章节我们将继续探讨如何在Azure服务中通过Python进行数据访问和操作。

3. Azure服务数据访问支持

3.1 Azure存储服务数据访问

3.1.1 Blob存储的数据操作

Azure Blob存储是一种服务,用于存储大量的非结构化数据,例如文本或二进制数据。通过Azure Blob存储,可以访问从图片到视频文件的各种数据。

操作Blob存储通常涉及到以下几个步骤:

- 初始化存储账户凭证,包括存储账户名和密钥。

- 使用

azure.storage.blob模块中的BlobServiceClient创建一个客户端实例。 - 通过客户端实例获取特定容器的引用。

- 执行具体的数据操作,例如创建容器、上传文件、下载文件、删除文件等。

下面是一个使用Python进行Blob存储基本操作的示例代码:

from azure.storage.blob import BlobServiceClient, BlobClient, ContainerClient

# 初始化连接字符串

connect_str = 'your_connection_string_here'

# 创建BlobServiceClient对象

blob_service_client = BlobServiceClient.from_connection_string(connect_str)

# 获取特定容器的引用

container_client = blob_service_client.get_container_client('your_container_name')

# 上传文件到Blob存储

with open('example.txt', 'rb') as data:

blob_client = blob_service_client.get_blob_client(container='your_container_name', blob='newblob.txt')

blob_client.upload_blob(data)

# 下载Blob存储中的文件

blob_client = blob_service_client.get_blob_client(container='your_container_name', blob='newblob.txt')

downloaded = blob_client.download_blob()

with open('downloaded_example.txt', 'wb') as download_***

***

在上述代码中,我们使用了 BlobServiceClient 来与Azure Blob存储服务进行交互。通过提供连接字符串,我们创建了服务客户端。随后,我们获取了一个容器的引用,并演示了上传和下载操作。

3.1.2 文件和表存储的交互

除了Blob存储,Azure还提供了其他两种存储解决方案:文件存储和表存储。文件存储提供了基于标准的 SMB (服务器消息块) 和 NFS (网络文件系统) 协议的共享文件服务,适用于传统应用,例如在Windows上运行的应用。

表存储是一种NoSQL键/值存储,适用于结构化数据。它非常适合存储非关系型数据,如JSON或XML格式。

在使用这些存储服务时,通常需要执行以下操作:

- 创建文件共享或表。

- 管理访问权限和策略。

- 向存储服务中上传、读取、更新或删除数据。

下面是一个简单的示例,展示如何在Python中使用Azure存储SDK创建和管理文件共享:

from azure.storage.fileshare import ShareServiceClient, ShareClient, ShareDirectoryClient

# 初始化连接字符串

connect_str = 'your_connection_string_here'

# 创建ShareServiceClient对象

share_service_client = ShareServiceClient.from_connection_string(connect_str)

# 创建一个文件共享

share_client = share_service_client.get_share_client('new_share')

try:

share_client.create_share()

except Exception as e:

print(e)

# 获取文件共享的引用

directory_client = share_client.get_directory_client('new_directory')

# 创建一个目录

directory_client.create_directory()

在上述代码中,我们使用 ShareServiceClient 类来管理文件共享。我们创建了一个新的文件共享,并尝试在其下创建一个目录。

3.2 Azure SQL数据库的连接与操作

3.2.1 连接Azure SQL数据库

Azure SQL数据库是一个关系数据库服务,它基于Microsoft SQL Server数据库引擎。开发者可以使用熟悉的工具和语言连接和查询数据,例如使用Transact-SQL (T-SQL)。

要在Python中连接Azure SQL数据库,可以使用 pyodbc 或 pymssql 库。以下是使用 pyodbc 连接到Azure SQL数据库的示例代码:

import pyodbc

# 数据库连接参数

server = 'your_***'

database = 'your_database'

username = 'your_username'

password = 'your_password'

# 创建连接字符串

connection_string = f'DRIVER={{ODBC Driver 17 for SQL Server}};SERVER={server};DATABASE={database};UID={username};PWD={password}'

# 连接数据库

conn = pyodbc.connect(connection_string)

# 创建cursor对象以执行SQL语句

cursor = conn.cursor()

# 执行SQL查询

cursor.execute("SELECT @@VERSION")

# 打印查询结果

row = cursor.fetchone()

while row:

print(row[0])

row = cursor.fetchone()

# 关闭连接

cursor.close()

conn.close()

3.2.2 SQL查询执行与结果处理

查询执行后,获取结果并进行处理是数据操作的关键步骤。Python中的数据库游标对象提供了多种方法来处理查询结果。

以 fetchone() 方法为例,它会从结果集中获取下一行。返回的每一行都是一个元组,列对应于列名。例如:

cursor.execute("SELECT * FROM your_table")

# 获取所有列数据

data = cursor.fetchall()

for row in data:

print(row)

处理大量数据时,使用 cursor.scroll() 可以有效地导航到结果集中的特定行。

3.3 第三方服务集成

3.3.1 Azure Marketplace上的数据服务

Azure Marketplace提供了丰富的数据服务,包括数据集成、数据仓库、数据分析和数据可视化解决方案。

要集成Azure Marketplace中的数据服务,首先需要在Azure门户中搜索并选择所需的服务,然后遵循该服务的部署和配置指南。

3.3.2 第三方库与Azure数据集成案例

在Python项目中集成第三方库,使得与Azure数据的交互更加灵活。例如,使用 requests 库可以轻松调用REST API与Azure数据服务交互。

下面是一个集成第三方库的案例,这里演示如何使用 requests 与Azure Storage进行交互:

import requests

import json

# Azure Storage的API URL

url = '***'

# 请求头部,包括认证信息

headers = {

'x-ms-version': '2019-07-07',

'Authorization': 'Bearer your_access_token_here'

}

# 请求体,可能包含创建容器所需的参数等

body = {

"properties": {

"publicAccess": "Container"

}

}

# 使用POST请求创建容器

response = requests.put(url + 'your_container', data=json.dumps(body), headers=headers)

# 检查响应状态码

if response.status_code == 201:

print('Container created successfully')

else:

print('Failed to create container, Status code:', response.status_code)

在此代码中,我们使用 requests 库向Azure Storage发送一个PUT请求,以创建一个新的容器。请求中包含了认证信息和容器的配置信息。

以上内容仅为第三章的部分内容,详细内容包括每一小节的深入讲解和操作代码会远远超过上述提供的长度。在实际编写中,每个二级章节(如3.1和3.2)将详细讨论相关技术和概念,而每个三级章节(如3.1.1和3.1.2)将通过代码示例和具体分析进行深入探讨。每个四级章节(未在上面内容中单独展示)将提供更具体的实施细节、操作步骤及性能优化建议。

4. 身份验证和安全访问

4.1 Azure身份验证机制

身份验证是保护数据安全的第一道防线。Azure提供了多种身份验证机制,以确保只有授权用户和应用程序能够访问资源。

4.1.1 Azure AD身份认证基础

Azure Active Directory(Azure AD)是Microsoft Azure云服务的身份和访问管理解决方案。Azure AD为组织提供单一登录(SSO)功能,允许用户使用同一套凭证访问多个应用程序和服务。

通过使用Azure AD,可以实现细粒度的访问控制,支持基于角色的访问控制(RBAC)策略,这将允许管理员根据用户的角色分配不同的访问权限。此外,它还提供了自适应多因素身份验证,增加了账户登录过程的安全性。

4.1.2 多因素认证的应用场景

多因素认证(MFA)要求用户在输入用户名和密码之外,还需提供额外的验证因素。这极大地提升了账户的安全性,因为即使密码被盗或被猜测,没有第二个认证因素,攻击者也无法访问账户。

在Azure中,MFA可以应用于多种场景,如管理员账户的日常管理任务、对敏感数据的访问以及第三方应用程序的授权。实施MFA可以有效防止未经授权的访问,尤其适用于对数据敏感性要求极高的企业环境。

graph TD;

A[开始] --> B[用户登录]

B --> C{是否启用MFA?}

C -->|是| D[输入用户名和密码]

D --> E[输入第二个认证因素]

E --> F[成功登录]

C -->|否| G[仅输入用户名和密码]

G --> F

4.2 安全策略与权限管理

4.2.1 角色基础访问控制(RBAC)

RBAC是一种访问控制模式,允许管理员根据用户的角色和职责分配合适的权限。通过定义角色,可以有效地管理多个用户的权限,而无需针对每个用户单独配置。

在Azure中,RBAC能够实现细致的权限控制,例如,可以为开发人员授予对特定资源的读取权限,而为管理员授予完全控制的权限。这种控制方式有助于最小权限原则,降低安全风险。

4.2.2 访问策略与数据保护

制定适当的访问策略是保障数据安全的关键。Azure提供了多种工具来帮助实现访问策略的制定和执行,包括访问控制列表(ACL)、锁以及资源策略等。

例如,可以对存储账户或数据库设置ACL,明确哪些用户或用户组可以访问哪些资源。Azure还支持资源锁,一旦加锁,即使在高级别权限的账户也不能删除或修改该资源,从而保护关键资源不受意外或恶意的删除操作。

4.3 安全网络通信

4.3.1 Azure虚拟网络与数据访问

虚拟网络是实现隔离和保护网络环境的重要组件。Azure虚拟网络(VNet)允许用户创建私有网络,在这个网络上可以部署和管理虚拟机(VM)以及其他Azure资源。

通过配置VNet,可以确保数据传输在私有网络中进行,减少数据在公共网络中传输的风险。同时,VNet还支持虚拟网络服务端点,它允许服务资源只在虚拟网络内部可见,并可以直接从虚拟网络连接到Azure服务,如Azure存储和SQL数据库。

4.3.2 端到端加密通信的实现

在保护数据的传输安全方面,端到端加密(E2EE)是一种常见的安全措施。E2EE保证从一个端点到另一个端点的传输过程中数据加密,即使数据在传输途中被截获,也无法被未授权的第三方解密和读取。

Azure提供多种服务支持E2EE,例如Azure Storage、Azure SQL Database和Azure Key Vault等。通过这些服务的E2EE功能,可以确保在客户端和服务端之间传输的数据在传输过程中保持加密状态,增强了数据的保密性和完整性。

以上内容详细介绍了Azure身份验证和安全访问的相关知识,包括身份认证机制、权限管理和安全网络通信。在下一章节中,我们将深入探讨数据提取与数据库操作的技巧和实践。

5. 数据提取与数据库操作

5.1 数据提取技巧

从API抓取数据的方法

在当今数字化的世界中,应用程序接口(API)已经成为数据交换和获取数据的主要手段之一。为了从API中有效地提取数据,开发者可以利用多种工具和技术。在Python中,常用的库包括 requests 库,它是一个简单易用的HTTP库,可以用来发送各种HTTP请求。

示例代码

以下是一个使用 requests 库从REST API提取数据的基本示例:

import requests

# 定义API的URL

url = '***'

# 发起GET请求

response = requests.get(url)

# 检查请求是否成功

if response.status_code == 200:

# 将响应体解析为JSON格式

data = response.json()

print(data)

else:

print("Failed to retrieve data: ", response.status_code)

在上面的代码中,我们首先导入了 requests 模块,然后定义了要抓取数据的API URL。通过调用 get 方法发起HTTP GET请求,并对返回的状态码进行检查确保请求成功。如果成功,我们使用 json() 方法将响应体解析为Python字典。

数据抓取的优化技巧

在数据抓取过程中,优化请求以提高效率和减少服务器负载是很重要的。这可以通过减少请求频率、使用缓存、合理分页以及利用并发请求等方式实现。

使用缓存

为了避免不必要的重复请求,可以使用缓存技术,如 requests_cache 库。这样,相同的请求在一定时间内可以直接从缓存中获取响应,而不是发送新的网络请求。

import requests

import requests_cache

# 启用缓存,设置缓存时间为24小时

requests_cache.install_cache('my_cache', expire_after=86400)

# 之后的请求将会根据缓存策略减少网络请求

response = requests.get(url)

分页处理

当API支持分页时,合理地处理分页可以提高数据提取的效率。通常需要检查API响应中返回的分页信息,并通过循环或递归的方式遍历所有数据。

# 分页处理

page = 1

all_data = []

while True:

# 构造分页请求

paginated_url = f'{url}?page={page}'

response = requests.get(paginated_url)

if response.status_code != 200:

print("Error: ", response.status_code)

break

data = response.json()

# 处理数据

all_data.extend(data['items'])

# 检查是否还有更多页面

if 'nextPage' in data:

page += 1

else:

break

以上代码片段展示了如何通过循环处理分页请求,直到没有更多页面为止。注意,每次请求应该检查API返回的状态码以及是否还有更多页面。

表格展示

在实际应用中,数据提取结果往往需要表格形式展示,以便进行进一步分析。以下是用Python pandas 库创建数据框(DataFrame)的示例:

import pandas as pd

# 假设从API获取的是JSON格式的列表

data = [{"id": 1, "name": "Alice"}, {"id": 2, "name": "Bob"}]

# 转换为pandas DataFrame

df = pd.DataFrame(data)

# 输出DataFrame内容

print(df)

在上述代码中,我们用 pandas 库的 DataFrame 构造函数,将包含字典的列表转换为数据框,然后打印出来。

流程图展示

为了更直观地理解分页处理的逻辑,这里通过一个mermaid流程图展示分页的处理逻辑:

graph LR

A[开始] --> B{是否存在更多页面}

B -- 是 --> C[提取当前页数据]

B -- 否 --> D[结束提取]

C --> E{是否完成所有数据提取}

E -- 否 --> A

E -- 是 --> D

在上面的流程图中,展示了分页处理的逻辑结构。流程从开始节点开始,接着检查是否还有更多页面。如果有,提取当前页的数据并判断是否完成所有数据提取。如果未完成,流程返回到开始节点。如果没有更多页面,则结束提取。

5.2 数据库操作实践

数据库设计与模型构建

设计一个良好的数据库模型是优化数据操作和提高数据库性能的关键。在关系数据库中,模型通常表现为一系列的表,表之间通过外键等约束建立关系。在非关系型数据库中,模型可能表现为文档、键值对等。

示例模型构建

在Python中,使用 SQLAlchemy 这一ORM(对象关系映射)工具可以帮助我们更方便地构建和操作数据库模型。以下是一个简单的示例:

from sqlalchemy import create_engine, Column, Integer, String, ForeignKey

from sqlalchemy.ext.declarative import declarative_base

from sqlalchemy.orm import relationship

# 创建一个基础类

Base = declarative_base()

# 定义用户模型

class User(Base):

__tablename__ = 'users'

id = Column(Integer, primary_key=True)

name = Column(String)

addresses = relationship("Address", back_populates="user")

# 定义地址模型

class Address(Base):

__tablename__ = 'addresses'

id = Column(Integer, primary_key=True)

street = Column(String)

user_id = Column(Integer, ForeignKey('users.id'))

user = relationship("User", back_populates="addresses")

# 创建数据库引擎

engine = create_engine('sqlite:///mydatabase.db')

# 创建所有表

Base.metadata.create_all(engine)

上面的代码定义了用户和地址两个模型,并通过 relationship 函数建立了它们之间的关系。接着,我们使用 create_engine 创建了一个指向SQLite数据库的引擎,并通过调用 Base.metadata.create_all(engine) 创建了这些表。

批量数据操作与性能调优

在对数据库进行批量操作时,性能调优至关重要。例如,使用 SQLAlchemy 进行批量插入时,可以使用 bulk_insert_mappings 方法以提高性能。

批量插入优化

以下是使用 SQLAlchemy 批量插入数据的示例:

from sqlalchemy import insert

# 创建插入语句

stmt = insert(Address).values([{"street": "123 Main St", "user_id": 1},

{"street": "456 Elm St", "user_id": 2}])

# 执行批量插入,同时传入数据库会话对象

with session.begin():

session.execute(stmt)

在这个代码段中,我们首先构造了一个插入语句 insert ,然后将要插入的数据作为字典列表传递。通过 session.execute 执行批量插入操作,从而提高大量数据插入数据库的性能。

表格与数据展示

展示数据操作结果时,表格是一种非常直观的方式。以下是如何在Python中使用 pandas 库来展示数据库中的数据:

import pandas as pd

# 假设我们从数据库中查询到了数据

query = "SELECT * FROM users"

data = session.execute(query).fetchall()

# 使用pandas创建DataFrame

df = pd.DataFrame(data, columns=[desc[0] for desc in session.execute("PRAGMA table_info(users)").fetchall()])

# 打印DataFrame

print(df)

在这段代码中,我们首先执行了一个SQL查询,然后使用查询结果构造了 pandas 的DataFrame对象。最后打印这个对象,就可以看到查询结果的数据。

优化策略与性能分析

在进行数据库操作时,性能瓶颈分析是不可或缺的。要进行性能分析,可以使用数据库自身的工具,如 EXPLAIN 计划在MySQL或PostgreSQL中,或者使用Python中的 SQLAlchemy 的 profile 功能。

性能分析工具使用示例

下面的代码片段展示了如何使用 SQLAlchemy 来分析查询性能:

from sqlalchemy import create_engine

# 创建一个引擎

engine = create_engine('sqlite:///mydatabase.db')

# 使用profile功能

with engine.connect() as connection:

result = connection.execute("SELECT * FROM users")

for row in result:

print(row)

# 打印性能分析结果

print(connection.engine._profiler)

在这个示例中,我们首先创建了一个连接到SQLite数据库的引擎。然后使用连接对象执行查询,并且遍历结果。最后,我们可以打印出内部的性能分析信息,这对于调优查询性能非常有帮助。

5.3 数据流处理

实时数据流的抓取与处理

实时数据流处理在当今的IT行业非常流行,特别是在需要即时分析和响应大量数据的场景中。实时数据流处理通常涉及到消息队列和流处理框架,例如Apache Kafka和Apache Flink。

实时数据流抓取示例

实时数据流抓取的一个常见场景是在社交媒体平台抓取用户行为数据,下面是一个简单的示例,展示如何使用Python监听Kafka主题中的实时数据流:

from kafka import KafkaConsumer

# 创建Kafka消费者实例

consumer = KafkaConsumer(

'my_topic',

bootstrap_servers=['localhost:9092'],

auto_offset_reset='earliest'

)

# 循环读取实时数据流

for message in consumer:

print(f"Received message: {message.value.decode('utf-8')}")

上面的代码创建了一个Kafka消费者来监听指定的主题,然后进入循环不断读取和打印新到的消息。 auto_offset_reset 参数设置了消费者在没有偏移量时的行为。

数据流处理工具和框架的选择

选择合适的工具和框架对于处理数据流至关重要。一个流行的选择是Apache Kafka,用于构建实时数据管道和流应用程序。另一个选择是Apache Flink,它是一个处理大规模数据流处理的强大框架。

Apache Kafka的介绍

Apache Kafka是一个分布式流处理平台,它具有高性能、可持久化、可扩展和容错的特点。Kafka通常用于构建实时数据管道和流应用程序。它通过发布-订阅模型处理来自生产者的消息,并将消息存储在被称为主题的类别中。

Apache Flink的介绍

Apache Flink是一个开源的流处理框架,用于对无界和有界数据流进行状态化计算。Flink的优势在于其低延迟和高吞吐量处理能力,使得它成为构建实时分析和数据处理应用的理想选择。

框架选择示例

选择数据流处理框架时,需要考虑数据量大小、处理延迟、容错能力等因素。例如,对于需要毫秒级响应的实时分析任务,Flink可能是更好的选择;而对于构建大规模数据管道,则可能优先考虑Kafka。

在实际应用中,通常会结合使用多个框架,如使用Kafka作为数据的入站管道,然后使用Flink进行实时处理。

表格与对比展示

为了更直观地比较不同的数据流处理工具和框架,可以创建一个表格进行对比:

| 特性 | Kafka | Flink | | --- | --- | --- | | 实时性 | 高 | 高 | | 容错性 | 中 | 高 | | 可扩展性 | 高 | 高 | | 应用场景 | 数据管道,消息队列 | 实时分析,复杂事件处理 | | 社区活跃度 | 高 | 中 | | 官方文档 | 充分 | 充分 |

流程图展示

最后,我们可以用一个流程图来表示实时数据流处理的整体架构:

graph LR

A[数据源] -->|发布| B(Kafka生产者)

B --> C[Kafka主题]

C -->|消费| D(Kafka消费者)

D --> E[数据处理]

E -->|输出| F[结果存储/下游应用]

在这个流程图中,数据源首先通过Kafka生产者发布消息到Kafka主题,然后Kafka消费者消费这些消息,并将其传递到数据处理环节,最终将结果输出到存储系统或下游应用。

通过本章节的介绍,我们了解了如何利用Python抓取API数据,设计和操作数据库,以及处理实时数据流。接下来的章节将进一步探讨数据预处理与批量处理的技巧和工具,以及如何监控和维护数据处理流程。

6. 数据预处理与批量处理

数据预处理是数据科学和分析中至关重要的一环,它能够提高数据质量,并为后续的数据分析和机器学习算法提供准备好的输入。批量处理则是处理大量数据时常用的方法,它能够帮助我们高效地完成数据处理任务。

6.1 数据清洗与转换

在数据准备阶段,数据清洗是将原始数据转换为整洁、可靠、一致的数据集的过程。数据转换则通常指对数据进行一些转换或调整,以符合特定的数据格式要求。

6.1.1 缺失值和异常值处理

缺失值是数据集中常见的问题之一,处理缺失值的方法有多种,包括删除含有缺失值的记录、填充缺失值等。异常值可能会对分析结果产生不利影响,因此需要进行识别和处理。

import pandas as pd

# 加载数据集

df = pd.read_csv('data.csv')

# 查看数据集中是否有缺失值

print(df.isnull().sum())

# 删除含有缺失值的记录

df_cleaned = df.dropna()

# 用列的平均值填充缺失值

df_filled = df.fillna(df.mean())

# 识别并处理异常值

# 例如:假设 'age' 列不应超过100岁

df['age'] = df['age'].apply(lambda x: x if x < 100 else None)

6.1.2 数据标准化与归一化

数据标准化和归一化是确保数据特征之间具有可比性的常用方法。标准化使数据具有单位方差和零均值,而归一化则将数据缩放到特定范围,如0到1。

from sklearn.preprocessing import StandardScaler, MinMaxScaler

# 使用标准化(StandardScaler)

scaler = StandardScaler()

df_scaled = pd.DataFrame(scaler.fit_transform(df), columns=df.columns)

# 使用归一化(MinMaxScaler)

min_max_scaler = MinMaxScaler()

df_normalized = pd.DataFrame(min_max_scaler.fit_transform(df), columns=df.columns)

6.2 批量数据处理策略

随着数据量的增长,传统的单机处理方法往往会遇到性能瓶颈。这时,分布式计算框架,如Apache Spark,提供了处理大规模数据集的能力。

6.2.1 分布式计算在批量处理中的应用

在分布式计算环境中,数据被分散存储在不同的节点上,计算任务也在不同的节点上并行执行。Apache Spark是一个广受欢迎的分布式计算平台,它提供了处理大规模数据集的能力。

from pyspark.sql import SparkSession

# 初始化Spark会话

spark = SparkSession.builder \

.appName("BatchProcessing") \

.getOrCreate()

# 读取数据集

df_spark = spark.read.csv('data.csv', header=True, inferSchema=True)

# 在Spark上进行数据清洗操作

df_spark_cleaned = df_spark.dropna()

# 执行分布式数据转换

from pyspark.ml.feature import MinMaxScaler

scaler = MinMaxScaler(inputCol="age", outputCol="age_scaled")

df_spark_normalized = scaler.fit(df_spark_cleaned).transform(df_spark_cleaned)

# 保存处理后的数据集

df_spark_normalized.write.mode("overwrite").csv("normalized_data.csv")

6.2.2 高效数据处理流程设计

为了处理大量数据,需要设计一个高效的处理流程。这包括数据的加载、预处理、分析、输出等步骤。合理的数据流程设计可以显著提高数据处理的效率。

graph LR

A[开始] --> B[数据加载]

B --> C[数据清洗]

C --> D[数据转换]

D --> E[数据分析]

E --> F[数据输出]

F --> G[结束]

6.3 处理流程的监控与维护

监控数据处理流程是保证数据质量的关键。我们可以通过日志、性能指标和警报等手段来跟踪数据处理的状态。

6.3.1 数据处理流程的监控工具

使用监控工具可以实时查看数据处理的状态,识别性能瓶颈,并在出现问题时及时响应。

# 示例:监控Spark作业的执行状态

spark_status = spark.sparkContext.statusTracker

active_stages = spark_status.activeStages()

completed_stages = spark_***pletedStages()

print(f"Active stages: {active_stages}")

print(f"Completed stages: {completed_stages}")

6.3.2 性能瓶颈分析与优化

在处理大量数据时,性能瓶颈分析与优化是至关重要的。我们可以采取多种策略来优化数据处理流程,例如增加资源、优化代码或使用更高效的数据结构。

# 示例:通过增加分区数来优化Spark作业的性能

df_spark.repartition(100)

通过监控工具和性能分析,我们可以对数据处理流程的瓶颈进行诊断和优化,从而确保数据处理任务能够高效率、高稳定性地运行。

简介:"azure-data-scraper"是一个基于Python的工具,专为高效抓取和处理Azure平台数据而设计。该工具提供了对多种Azure服务如Blob Storage、Table Storage、SQL Database和Cosmos DB的数据访问和提取支持。它利用Python的各类库简化与Azure的交互,包含身份验证、数据提取、数据库操作、数据转换、批量处理、错误处理、日志记录和可配置参数等功能。适用于数据备份、迁移、分析前的数据准备等场景,提高开发者与Azure数据服务交互的效率。

211

211

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?