NVIDIA发布企业级硬件 AI 参考架构

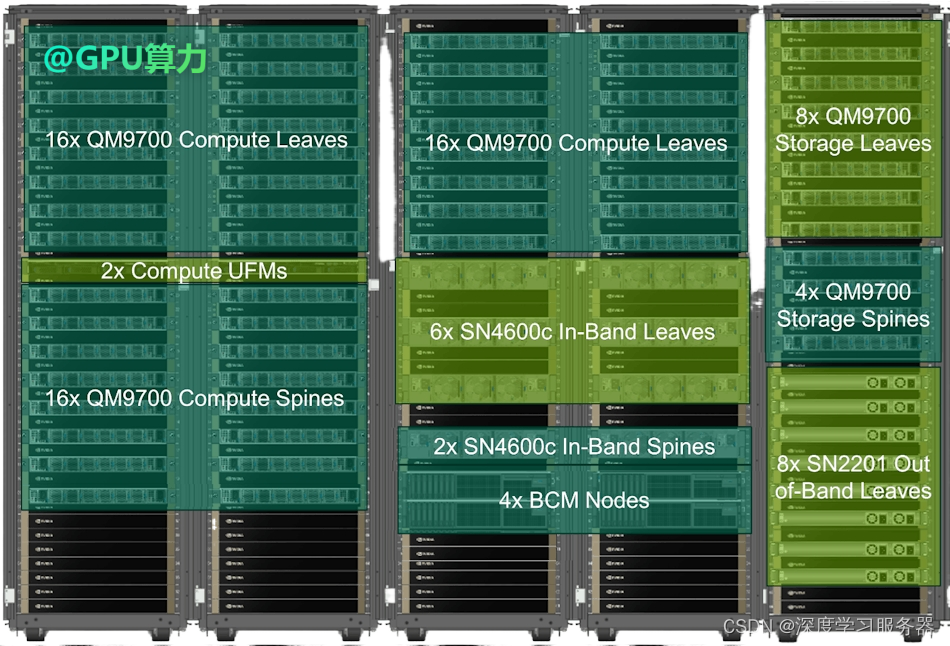

🏵NVIDIA英伟达在 OCP 峰会后发布了许多 AI 参考架构,#GPU服务器#供应商与 Nvidia 合作开发了大规模部署 Nvidia AI 硬件所需的基础设施硬件,近日 Nvidia 宣布企业级客户构建的参考架构。NVIDIA DGX SuperPOD架构,该架构完全使用 Nvidia 服务器和网络技术构建。

🚨从设计到部署进行优化

新发布的参考架构 (RA) 产品适用于部署范围为 32 到 1024 个 GPU 的企业级硬件,源自现有的 Nvidia Cloud Partner (NCP) 设计,该设计专注于 128 个节点到超过 16000 个节点的部署。

🚀虽然 NCP 架构旨在为使用 Nvidia 提供的专业服务的客户提供指南,但 Nvidia 合作伙伴硬件供应商(如 HPE、Dell、液冷服务器和 Supermicro)正在使用新的企业级 RA 来开发使用 NVIDIA Hopper GPU、Blackwell GPU、Grace CPU、Spectrum-X 网络和 BlueFieldDPU 架构的 Nvidia 认证解决方案。

🔮这些技术中的每一项都有一个现有的节点级认证计划,该计划允许合作伙伴供应商提供针对其客户希望开发的服务进行优化的系统。但是,仅仅使用经过认证的组件并不足以让供应商发布经过认证的解决方案。

经过认证的服务器配置需要接受测试计划,其中包括热分析、机械应力测试、功耗评估和信号完整性评估,并通过一系列操作测试要求,包括管理功能、安全性和网络性能,适用于一系列工作负载、应用程序和用例。

选择认证选择后,Nvidia 的 RA 指南还会提供有关构建集群、使用其节点和遵循常见设计模式的指导。正如所宣布的,每个企业参考体系结构都有某些共同因素,包括以下方面的建议:

🥇 使用优化的 Nvidia 服务器配置加速基础设施。

🥈 基于 Spectrum-X 以太网和 Blufield-3 DPU 的 AI 优化网络。

🥉 用于生产 AI 部署的 Nvidia AI 企业软件平台。

☀️横向扩展与纵向扩展

Nvidia RA 了解客户需求的性质,根据客户需求和长期规划,支持纵向扩展和横向扩展部署。

简单来说,纵向扩展部署使用 NVLink 连接来创建高带宽、多节点 GPU 集群,该集群可以被视为单个巨大的 GPU,工作负载分布在多个服务器上。

🌤这些系统可以扩展到 NVLink 连接的最大能力,例如,GB200 NVL72 可以扩展到 72 个 GPU,作为一个单元运行。

在横向扩展模型中,如 RA 概述中所述,该方法使用优化的 PCIe 连接来扩展集群,根据所选的架构设计,集群可以从 4 个节点扩展到 96 个节点。工作负载被分配到具有不同优化和性能级别的服务器。

🏮选择 RA 设计的特点

总体而言,选择使用这些参考架构设计构建的系统意味着可以充分利用 Nvidia 在构建大型系统方面获得的多年工程专业知识和经验。Nvidia 将这些好处分解为适用于 IT 和业务运营的好处。

⛅️对于 IT 来说,利用这些设计可以提高性能、简化支持、降低复杂性和改善 TCO,并简化扩展和管理部署。

对于业务问题,Nvidia 强调了降低成本、提高效率、加快上市时间和显著降低风险。

提供的指南旨在加速数据中心从传统工作模式向 AI 工厂的过渡。

📍使用 RA 的供应商可以从 Nvidia 使用其硬件和软件解决方案的经验中受益,而选择部署认证解决方案的客户则可以确保在快速有效部署的道路上遇到最少的障碍。

#NVIDIA# #英伟达# #液冷服务器#

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?