论文题目:Modeling Intra and Inter-modality Incongruity for Multi-Modal Sarcasm Detection

时间:2020

来源:EMNLP

论文链接:点击跳转

论文代码:点击跳转

又没有代码 太难了

目录

摘要

讽刺是当今社交媒体平台(例如 Twitter 和 Reddit)中普遍存在的现象。这些平台允许用户创建多模式消息,包括文本、图像和视频。现有的多模态讽刺检测方法要么简单地连接多模态的特征,要么以设计的方式融合多模态信息。然而,他们忽略了讽刺话语中的不协调性,这种不协调性往往表现在情态之间或情态之内。受此启发,我们提出了一个基于 BERT 架构的模型,该模型专注于多模态讽刺检测的模态内和模态间不协调。具体来说,我们受到自我注意机制和设计多模态注意以捕获多模态不协调的想法的启发。此外,还应用了共同注意机制来模拟文本内部的矛盾。然后将不一致信息用于预测。实验结果表明,我们的模型在公共多模态讽刺检测数据集上达到了最先进的性能。

介绍

讽刺是一种比喻语言,其中单词的字面含义不成立,而是打算进行相反的解释(Joshi 等,2017)。讽刺在当今的社交媒体平台中很普遍,它可以完全翻转情绪或意见的极性。因此,有效的讽刺检测器有利于情感分析、意见挖掘(Pang 和 Lee,2007)以及其他需要人们真实情感的任务。然而,讽刺的比喻性质使其成为一项具有挑战性的任务(Liu,2010)。学者们注意到讽刺通常与一个称为不协调的概念相关联,该概念用于暗示现实与期望之间的区别。因此,通过捕获文本中的不协调性,提出了许多讽刺检测方法(Riloff 等人,2013 年;Joshi 等人,2015 年;Tay 等人,2018 年;Xiong 等人,2019 年)。

越来越多的应用程序(如 Twitter)允许用户发布多模式消息。因此,仅对文本模态内的不协调进行建模不足以识别模态间矛盾的讽刺。考虑图 1 中的给定示例;人们不能仅仅从文本中识别讽刺,除非他们发现文本和图像之间的矛盾。因此,捕获模态之间的不协调对于多模态讽刺检测非常重要。

然而,现有的多模态讽刺检测模型要么连接多模态的特征(Schifanella et al., 2016),要么以设计的方式融合来自不同模态的信息(Cai et al., 2019)。以前的多模态讽刺检测方法忽略了讽刺的不协调性。我们相信对于捕捉多模态讽刺检测的模态内和模态间的不协调是有意义的。

在这项工作中,我们将图像和文本视为两种模态,并提出了一种新的基于 BERT 架构的模型,用于多模态讽刺检测。 BERT 作为 Devlin 等人提出的预训练语言模型。 (2019),可用于生成出色的文本表示。出于这个原因,我们利用 BERT 来获取文本中的文本和主题标签(使用前面带有“#”的单词来表示推文的主题)的表示。我们注意到主题标签可能包含与文本形成对比的信息。 Maynard 和 Greenwood (2014) 也在主题标签的帮助下研究了情绪和讽刺。因此,我们应用一个共同注意矩阵来将文本和主题标签之间的不一致建模为模态内的不一致。此外,自注意力机制考虑了键和查询之间的交互,模态间的不一致信息也可以被视为文本和图像之间的交互。因此,受自注意力这一关键思想的启发,我们设计了多模态注意力,将文本特征视为查询,将图像特征视为键和值,以捕捉模态间的不一致。然后组合模态内和模态间不一致信息以进行预测。

我们工作的主要贡献可以总结如下:

- 我们提出了一种新的基于 BERT 架构的多模态讽刺检测模型,旨在解决现有的多模态讽刺检测模型没有考虑讽刺的不协调特征的问题

- 我们设计了模态间注意来模拟模态之间的不一致,并应用共同注意机制来模拟文本模态内的不一致以进行多模态讽刺检测

- 我们进行了一系列实验来展示我们模型的有效性,我们的模型在 F1 分数上比最先进的方法提高了 2.74%。此外,我们发现考虑图像上的文本可以带来显着的改进。

2. 方法

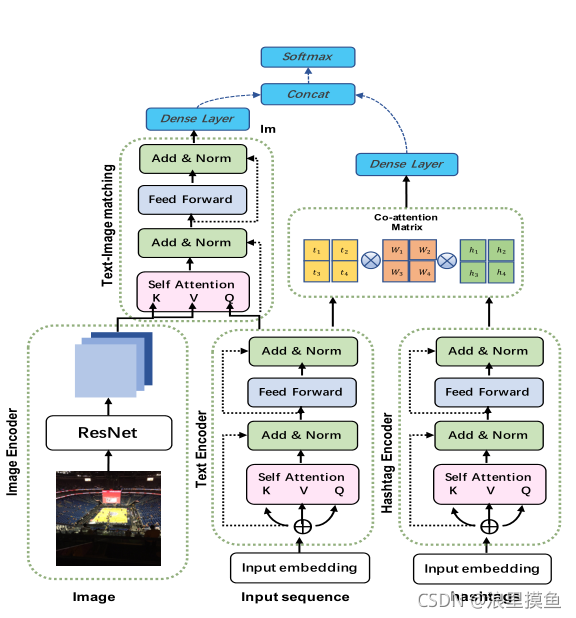

在本节中,我们首先定义多模态讽刺检测任务。然后我们简要介绍 BERT 模型的背景,并详细描述我们提出的模型的架构。图 2 概述了我们的模型。

图2:我们提出的模型概述。预先训练的 bert 模型对文本及其内的标签进行编码。ResNet用于获取图像表示。我们运用情态内注意来模拟文本内部的不一致性,而情态内注意来模拟文本和图像之间的不一致性。然后将不一致性信息进行组合并用于预测。

2.1 任务定义

多模态讽刺检测旨在识别与图像相关的给定文本是否具有讽刺意义。形式上,给定一组多模态样本 D,对于每个样本 d ∈ D,它包含一个句子 T,其中有 n 个词 { t1, t2, t3, … . . , tn} 和相关图像 I。我们模型的目标是学习多模态讽刺检测分类器,以正确预测未见过样本的结果。

2.2 背景

语言模型预训练已被证明可用于许多自然语言处理任务(Peters 等人,2018 年;Howard 和 Ruder,2018 年)。 BERT 是由 Devlin 等人提出的。 (2019),旨在通过对所有层的左右上下文进行联合调节,从大型未标记数据中预训练深度双向表示。预训练过程使 BERT 具有获取文本良好表示的能力。 BERT 模型由多层双向变压器编码器组成(V aswani 等,2017)。德夫林等人。 (2019) 在他们的工作中提出了两个 BERT 模型。具有 12 个转换器块的基本 BERT 模型、具有 768 个隐藏单元和 12 个注意头的前馈网络,以及具有 24 个转换器块的大型 BERT 模型、具有 1024 个隐藏单元和 16 个注意头的前馈网络,在我们的工作中,我们应用预训练的 Base BERT 模型来获取文本表示。

2.3 模型架构

我们的模型可以分为三个部分:图像和文本处理模块、模态间注意模块和模态内注意模块。

图像和文本处理

对于文本处理,给定一个单词序列 X = {x1, x2, . . . , xN},其中 xi∈Rdis 是词、段和位置嵌入的总和,N 是序列的最大长度,d 是嵌入大小。我们在其上采用预训练的 BERT 模型来获取文本表示。编码后的文本可以表示为 H∈Rd∗N,它是 BERT 编码器最后一层的输出,d 是 BERT 的隐藏大小。

对于图像处理,给定图像 I,我们首先将其大小调整为 224*224 像素,然后我们使用 ResNet-152 获得图像的表示。具体来说,我们砍掉最后一个全连接(FC)层,得到最后一个卷积层的输出:

其中每个

r

i

r_i

ri 是一个 2048 维的向量,表示图像上的一个区域。因此,图像 I 可以表示为

R

e

s

N

e

t

(

I

)

∈

R

2048

∗

49

ResNet(I) ∈ R^{2048∗49}

ResNet(I)∈R2048∗49。最后,为了将视觉特征投影到文本特征的相同维度,我们对编码图像表示 ResNet(I) 进行线性变换,如下所示:

其中

W

v

∈

R

d

∗

2048

W_v∈R^{d∗2048}

Wv∈Rd∗2048 是可训练参数,d 是文本特征的维度。

G

∈

R

d

∗

49

G ∈ R^{d∗49}

G∈Rd∗49 是视觉特征的编码表示。

模态间注意力

模态间不一致信息可以表示为多模态特征之间的一种相互作用。对句子和图像区域相矛盾的给予高度关注,因为不协调是讽刺的关键特征。因此,我们借鉴了self-attention 的思想,设计了一个文本图像匹配层来捕获文本和图像之间的不一致信息。我们的文本图像匹配层接受文本特征

H

∈

R

d

∗

N

H ∈ R^{d∗N}

H∈Rd∗N 查询,以及图像特征

G

∈

R

d

∗

49

G ∈ R^{d∗49}

G∈Rd∗49 作为键和值。这样,文本特征可以引导模型更加关注不协调的图像区域。具体来说,对于图文匹配层的第i个head,它有如下形式:

其中

d

k

∈

R

d

/

h

d_k∈ R^{d/h}

dk∈Rd/h,

A

T

T

i

(

H

,

G

)

∈

R

N

∗

d

k

AT Ti(H, G) ∈ R^{N∗d_k}

ATTi(H,G)∈RN∗dk,

W

i

Q

,

W

i

K

,

W

i

V

∈

R

d

k

∗

d

{W^Q_i, W^K_i, W^V_i} ∈ R^{d_k∗d}

WiQ,WiK,WiV∈Rdk∗d,可学习参数。然后将 h 个头的输出连接起来,然后进行线性变换,如下所示:

其中

W

o

∈

R

d

∗

d

W^o∈R^{d∗d}

Wo∈Rd∗d 是一个可学习的参数。之后,对文本特征 H 和自注意力层 MATT(H, G) 的输出进行残差连接:

其中 LN 是 Ba 等人提出的层归一化操作。 (2016)。之后,在 Z 上采用前馈网络(又名 M LP)和另一个残差连接来获得第一个变压器编码器的输出:

其中

T

I

M

l

m

(

H

,

G

)

∈

R

N

∗

d

TIM_lm(H, G)∈ R^{N∗d}

TIMlm(H,G)∈RN∗d是第一个文本图像匹配层的输出。我们堆叠 lm文本-图像匹配层并得到

T

I

M

l

m

(

H

,

G

)

TIM_lm(H, G)

TIMlm(H,G)作为最后一层的输出,其中

T

I

M

l

m

(

H

,

G

)

∈

R

N

∗

d

TIM_lm(H, G)∈ R^{N∗d}

TIMlm(H,G)∈RN∗d 和

l

m

l_m

lm一个预定义的超参数。模态间不一致的最终表示可以描述为

H

G

∈

R

d

H_G∈R^d

HG∈Rd,这是[CLS]标记在

T

I

M

l

m

(

H

,

G

)

TIM_lm(H, G)

TIMlm(H,G)中的编码。

模态内注意力

由于不一致可能仅出现在文本中(例如,与不相关图像相关的讽刺文本),因此有必要考虑模态内的不一致。 Twitter 等社交媒体允许用户添加主题标签来表明主题或他们的真实想法。 Maynard 和 Greenwood (2014) 指出,在分析用户的真实情绪时,主题标签很有用(例如,我很高兴我今天早上 5:15 醒来。# 不是)。因此,我们将原始文本和其中的主题标签之间的矛盾视为模态内不协调(即,对于那些没有主题标签的样本,我们使用特殊标记代替)。直观上,我们可以使用与模态间注意相同的方式来获得模态内不协调信息。然而,我们发现它即使包含更多的参数也没有带来太大的改进。因此,受到 Lu 等人的启发。 (2016) 的工作,我们引入了一个亲和矩阵 C 来模拟文本和主题标签之间的交互。 C 计算公式为:

其中 H ∈ Rd∗Nand T ∈ Rd∗M 分别表示文本特征和标签特征。 N 和 M 是预定义的超参数,分别表示输入序列的最大长度和主题标签。 Wb∈Rd∗dis 是一个包含权重的可学习参数。在计算亲和力矩阵 C ∈ RN∗M 之后,我们最大化文本特征位置上的亲和力矩阵以获得标签注意力。具体来说,我们通过对矩阵 C 应用列式最大池化操作来计算权重向量 a ∈ RM。 (2018) 认为应该突出导致不协调的词(通常伴随着高注意力价值)。因此,在我们的例子中,像最大池化这样的更具辨别力的池化算子是可取的。最后,模态内不一致性计算如下:

其中HT∈Rd包含模态内不协调信息。

3. 实验

本节首先描述数据集、实验设置、基线模型和实验结果。然后,我们进行了一系列烧蚀实验来验证组件在我们的模型。之后,我们分析了文本图像匹配层数对模型性能的影响。最后,我们给出了几个给定的讽刺案例的模型可视化,并对错误预测的样本进行了分析。

3.1 数据集

我们在一个公开可用的多模态讽刺检测数据集上评估我们的模型,该数据集由 Cai 等人收集。 (2019)。数据集中的每个样本都由一系列文本和相关图像组成。包含讽刺、讽刺、讽刺、讽刺或 URL 等词的推文在数据预处理期间被丢弃。蔡等人。 (2019) 将数据划分为训练集、开发集和测试集,比例为80%:10%:10%。他们还手动检查开发集和测试集,以确保标签的准确性。详细的统计数据总结在表 1 中。

3.2 基线模型

我们将基线模型分为三类:视觉模态模型、文本模态模型和文本视觉模态模型。

- 视觉模态模型:Image-Only:图像特征 G 直接用于预测平均池化操作后的结果。

- 文本模态模型:

TextCNN: 由 Kim (2014) 提出,是一种基于 CNN 的深度学习模型,用于解决文本分类任务。

SIARN: SIARN 是由 Tay 等人提出的。 (2018)。它采用内部注意力进行文本讽刺检测,以克服先前序列模型(如 RNN)的弱点,这些模型无法捕获词对之间的交互并妨碍明确建模不协调的能力。

SMSD: 继(Tay et al.,2018)的工作之后,Xiong et al.(2019)提出了一个自匹配网络,通过探索词与词之间的交互来捕获句子不一致信息。

BERT: BERT是Devlin等人(2019)提出的一种预训练模型,它在许多NLP任务中实现了最先进的结果。我们认为这是一个基线调查性能增益来自伯特或我们提出的方法。 - 视觉文本模态模型:

Hierarchical Fusion Model(HFM): 蔡等人。 (2019) 提出了一种用于多模态讽刺检测的分层融合模型。他们的模型将图像特征、图像属性特征和文本特征作为三种模态。三种模态的特征被重建和融合以进行预测。

Res-bert: 我们将 Res-bert 实现为我们的基线模型之一。 Res-bert 简单地将图像特征 G 和文本特征 H 连接起来进行分类。

3.3 实验设置

我们的模型在 PyTorch (Paszke et al., 2019) 中实现,在 NVIDIA TITAN RTX GPU 上运行。预训练的 BERT 模型可从 Hugging Face 发布的转换工具包中获得。2我们采用 Adam (Kingma and Ba, 2015) 作为我们的优化器,并将初始学习率设置为 5e-5,预热率为 0.2。用于训练的批大小固定为 32。文本的最大长度为 75,主题标签的最大长度分别为 10。我们的模型针对 8 个 epoch 进行了微调训练集。我们保存模型,它在验证集上具有最佳性能。完整参数列于表 2 中

3.4 实验结果

我们将我们的模型与基线模型在标准指标上进行比较,包括精度、召回率、F1 分数和准确率。3 结果如表 3 所示。实验结果表明,我们的模型在基线模型中取得了最佳性能。具体来说,与 Cai 等人提出的最先进的分层融合模型 (HFM) 相比,我们的模型在 F1 分数方面获得了 2.74% 的改进。 (2019)。我们的模型也以 2.7% 的改进优于微调的 BERT 模型,这显示了我们模型的有效性和图像的重要作用。

从表 3 中我们可以看出,仅使用图像特征的模型表现不佳,这表明对于多模态讽刺检测任务无法独立处理图像。显然,基于文本模态的方法比基于图像模态的方法获得了更好的性能。因此,对于讽刺检测,文本信息比图像信息更有用。值得注意的是,微调的 BERT 模型的性能远远优于其他基于文本的非预训练模型,这支持了我们的动机,即像 BERT 这样的预训练模型可以改进我们的任务。属于 Visual Text 模态的模型通常比其他模型获得更好的结果,表明图像对于提高性能很有用。

查看文本模态中的模型,SIARN(Tay 等人,2018 年)和 SMSD(Xiong 等人,2019 年)都将不一致信息纳入考虑并优于 TextCNN。因此,不协调信息有利于识别讽刺。我们提出的方法比 Res-bert 取得了更好的结果,证明对模态内和模态间不协调进行建模比用于多模态讽刺检测的简单模态串联更有效。

3.5 消融研究

为了评估模型中各组件的有效性,我们进行了一系列的消融实验。我们首先去掉通道内注意力,得到只使用HG进行预测的模型(w\o Intra)。然后,我们消除了通道间的注意,得到了无通道注意的模型。该模型将H和HT连接到分类器层,实验结果表明,HT在我们的模型中只起到辅助作用。

表4给出了消融实验的结果。实验结果表明,当同时包含通道内和通道间注意模块时,我们提出的模型获得了最好的性能。通道间注意力的缺失导致检测结果的降低,证明了考虑通道之间的矛盾对于多通道讽刺检测具有重要意义。没有通道内注意的模型也会影响性能。因此,通道内和通道间注意在我们的模型中扮演着不可或缺的角色。

误差分析:我们还对错误预测的样本进行定性分析。我们检查了大约50个错误分类的实例,发现我们的模型可能会错误地对包含图像上必要文本信息的样本进行分类(见图5)。因此,考虑图像上的文本可能会改进多模态讽刺检测任务。基于这一观察,我们进一步实现了一个实验,其中考虑了图像上的文本。具体来说,我们使用一个通用的字符识别API来获取图片上的文本,并使用共同注意矩阵来建模原始tweet和文本之间的不一致信息。表5显示,当考虑到图像上的文本时,我们的模型实现了显著的改进。除此之外我们发现我们的模型在需要外部知识的情况下,例如说话人的面部姿势或上下文信息,可能会遇到困难。因此,外部信息对于讽刺检测也是必不可少的。

3.6 模型分析

文本-图像匹配层数lm的影响:我们测量模型性能对F1得分的影响,以及文本-图像匹配层数lm从1到7的范围。在图4中我们可以看到,当lmequals为3时,F1得分一直增加,直到达到峰值。在这一点上,我们的模型取得了最佳的性能。然后,随着lm的继续增长,模型的性能开始下降。我们猜测性能会变差,可能是由于模型参数的增加,这表明添加更多的文本-图像匹配层可能不会增强性能,反而会阻碍性能。

模型可视化:在本节中,我们将可视化文本图像的注意力分布。我们的模型旨在捕获不一致信息。因此,我们的模型更可能关注图像上的不一致区域。我们展示了从数据集中收集的几个讽刺案例:

4. 相关工作

4.1基于文本的讽刺检测

4.2多模态讽刺检测

值得注意的是,也有一些有价值的工作集中在多模态讽刺检测。Schifanella等人(2016)首先考虑讽刺和讽刺的文本和视觉特征,并提出两种可供选择的框架。Mishra等人(2017年)提出了情感和讽刺分类的认知 NLP 系统。他们引入了一个框架来自动从眼动/凝视数据中提取认知特征。他们使用CNN对基于凝视和文本的特征进行编码以进行分类。卡斯特罗等人(2019年)提出了一个新的讽刺数据集,该数据集来自电视节目。他们将文本特征、语音特征和视频特征视为三种模式,并使用支持向量机作为分类器。Cai等人(2019)介绍了一种分层融合模型。它们将图像特征、图像属性特征和文本特征作为三种模式。三种模式的特征被重建并融合用于预测。

5. 结论

在本文中,我们提出了一种新的基于 bert 的模型,以解决现有的多模态讽刺检测方法不考虑不一致性讽刺的问题。具体来说,我们的模型考虑了模态内和模态间的不一致性,并在公共多模态讽刺检测数据集上实现了最先进的性能。此外,我们还进行了一系列实验来验证模型的有效性。最后,我们进行了错误分析,发现图像上的文本对于多模态讽刺检测是必不可少的。

942

942

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?