ELK即ElasticSearch、Logstash和Kibana,是由这三个软件组成的,能够实现日志入库和日志检索,安装也较为简单,下面介绍安装部署方法:

一、下载软件:

三个软件的下载,可访问我的网盘:

链接:https://pan.baidu.com/s/1yqPaX4ElR-AGIy4azS0Yuw

提取码:aabd

复制这段内容后打开百度网盘手机App,操作更方便哦

二、部署说明

环境 centos7

192.168.10.134 部署ElasticSearch

192.168.10.135 部署 logstash

192.168.10.136 部署kibana

1、ElasticSearch

- 功能:作为日志的存储和搜索引擎

- 安装:

rz 上传包jdk-11.0.10_linux-x64_bin.tar.gz和elasticsearch-7.11.1-linux-x86_64.tar.gz

解压

tar xf jdk-11.0.10_linux-x64_bin.tar.gz

tar xf elasticsearch-7.11.1-linux-x86_64.tar.gz

mv jdk-11.0.10 /usr/local/

mv elasticsearch-7.11.1 /usr/local/elasticsearch

创建环境变量,修改/etc/profile 文件,添加内容如下:

export JAVA_HOME=/usr/local/jdk-11.0.10

export PATH=\$JAVA_HOME/bin:\$JAVA_HOME/jre/bin:\$PATH

export CLASS_PATH=\$JAVA_HOME/lib:\$JAVA_HOME/jre/lib:\$CLASS_PATH

创建用户 useradd es,因为ElasticSearch不能用root用户启动

授权:

chown -R es.es /usr/local/elasticsearch/

修改配置文件:

node.name: node-1 #修改node名称

network.host: 0.0.0.0 #修改监听地址

cluster.initial_master_nodes: ["node-1"] #修改集群模式为单点模式

es正常启动还需要修改文件描述符的数量和虚拟内存大小:

vi /etc/security/limits.conf ,在末尾添加:

* soft nofile 65536

* hard nofile 65536

修改虚拟内存:

vi /etc/sysctl.conf

vm.max_map_count=655360

- 启动 : 切换用户并启动es:

su - es

/usr/local/elasticsearch/bin/elasticsearch -d

- 故障解决办法:

若有报错,可参考如下内容:

启动后可能会报错,需要修改如下内核参数设置:

1)SecComp功能不支持;

ERROR: bootstrap checks failed

system call filters failed to install; check the logs and fix your configuration or disable system call filters at your own risk;

因为Centos6不支持SecComp,而ES5.3.0默认bootstrap.system_call_filter为true进行检测,所以导致检测失败,失败后直接导致ES不能启动。

Seccomp(全称securecomputing mode)是Linux Kernel从2.6.23版本开始所支持的一种安全机制。

在Linux系统里,大量的系统调用(systemcall)直接暴露给用户态程序。但是并不是所有的系统调用都被需要,而且不安全的代码滥用系统调用会对系统造成安全威胁。通过Seccomp,我们限制程序使用某些系统调用,这样可以减少系统的暴露面,同时是程序进入一种“安全”的状态。

解决方法:

在elasticsearch.yml中配置bootstrap.system_call_filter为false,注意要在Memory下面:

bootstrap.memory_lock: false

bootstrap.system_call_filter: false

2)内核参数设置问题;

max file descriptors [4096] for elasticsearch process is too low, increase to at least [65536]

max number of threads [1024] for user [hadoop] is too low, increase to at least [2048]

max virtual memory areas vm.max_map_count [65530] is too low, increase to at least [262144]

解决方法:

vim /etc/security/limits.conf

* soft nofile 65536

* hard nofile 65536

vim /etc/security/limits.d/90-nproc.conf

soft nproc 2048

vi /etc/sysctl.conf

vm.max_map_count=655360

Max_map_count文件包含限制一个进程可以拥有的VMA(虚拟内存区域)的数量。虚拟内存区域是一个连续的虚拟地址空间区域。在进程的生命周期中,每当程序尝试在内存中映射文件,链接到共享内存段,或者分配堆空间的时候,这些区域将被创建。

调优这个值将限制进程可拥有VMA的数量。限制一个进程拥有VMA的总数可能导致应用程序出错,因为当进程达到了VMA上线但又只能释放少量的内存给其他的内核进程使用时,操作系统会抛出内存不足的错误。

如果你的操作系统在NORMAL区域仅占用少量的内存,那么调低这个值可以帮助释放内存给内核用。

2、Logstash

-

功能:就是收集客户端的日志,并可以做一些转换或过滤等等,之后将数据发给ElasticSearch

-

安装过程如下:

rz 上传包jdk-11.0.10_linux-x64_bin.tar.gz和logstash-7.11.1-linux-x86_64.tar.gz

解压

tar xf jdk-11.0.10_linux-x64_bin.tar.gz

tar xf logstash-7.11.1-linux-x86_64.tar.gz

mv jdk-11.0.10 /usr/local/

mv logstash-7.11.1-linux-x86_64 /usr/local/logstash

创建环境变量,修改/etc/profile 文件,添加内容如下:

export JAVA_HOME=/usr/local/jdk-11.0.10

export PATH=$JAVA_HOME/bin:$JAVA_HOME/jre/bin:$PATH

export CLASS_PATH=$JAVA_HOME/lib:$JAVA_HOME/jre/lib:$CLASS_PATH -

配置文件

创建目录/usr/local/logstash/config/etc/

编写一个nginx的日志收集入库文件:

[root@node2 etc]# cat logstash.conf

input {

file {

type => "nginx-access"

path => "/var/log/nginx/access.log"

}

}

output {

stdout {

codec => rubydebug {}

}

elasticsearch {

hosts => "192.168.10.134" }

}

或者要进行简单的入库测试的话,也可以编写一个简单的stdin模式的yaml文件,表示日志由用户操作键盘产生:

input {

stdin {}

}

output {

stdout {

codec => rubydebug {}

}

elasticsearch {

hosts => "192.168.10.134" }

}

这里的stdin表示标准输入

- 启动,/usr/local/logstash/bin/logstash -f stdin.yml

[2021-04-10T08:09:13,379][INFO ][logstash.javapipeline ][main] Pipeline started {"pipeline.id"=>"main"}

The stdin plugin is now waiting for input:

[2021-04-10T08:09:13,507][INFO ][logstash.agent ] Pipelines running {:count=>1, :running_pipelines=>[:main], :non_running_pipelines=>[]}

[2021-04-10T08:09:13,748][INFO ][logstash.agent ] Successfully started Logstash API endpoint {:port=>9600}

www.baidu.test

{

"host" => "node2",

"message" => "www.baidu.test",

"@timestamp" => 2021-04-10T10:10:30.783Z,

"@version" => "1"

}

www.baidu.test 就是由用户手动输入生成的日志信息,而其后面的字符串都是通过yml文件定义的规则生成的,并发送给es

3. Kibana

- 功能 Kibana 也是一个开源和免费的工具,可以为 Logstash 和 ElasticSearch 提供的日志分析友好的 Web 界面,可以帮助您汇总、分析和搜索重要数据日志;

- 安装

rz 上传包后,解压 tar xf kibana-7.11.1-linux-x86_64.tar.gz

mv kibana-7.11.1-linux-x86_64 /usr/local/kibana - 修改配置文件

server.host: “0.0.0.0” #修改监听地址

elasticsearch.hosts: [“http://192.168.10.134:9200”] #修改es的地址

i18n.locale: “zh-CN” #修改页面编码为中文 - 启动

bin 目录下的kibana 文件是shell编写的脚本,用后台符启动

cd /usr/local/kibana/bin

nohup sh kibana --allow-root &

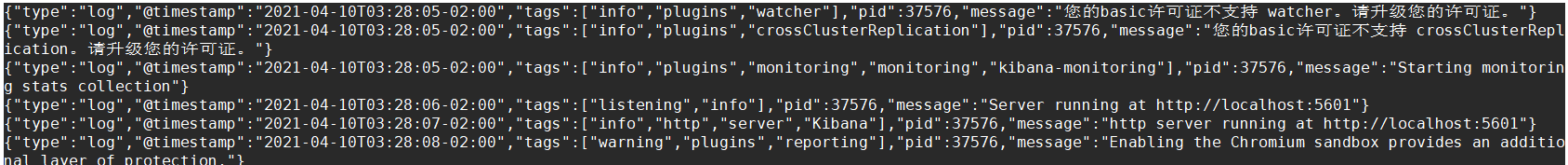

查看kibana的日志:http://192.168.10.136:5601/

到浏览器访问kibana:

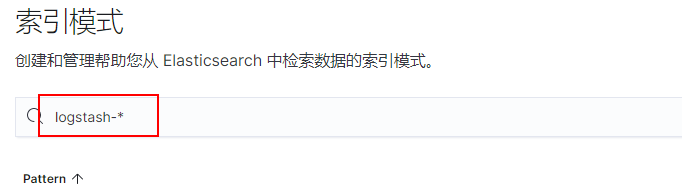

点击左下角的管理权限,点击索引模式:

创建一个logstash-* 的索引:

并按照@timestamp 字段排序

保存后,点击左上角的菜单,点击 发现:

由logstash入库的数据将被展示出来:

9480

9480

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?