浅谈Flume框架

文章目录

定义

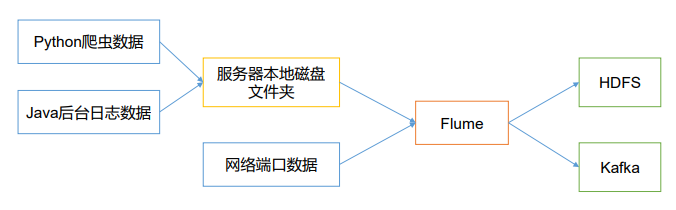

Flume 是 Cloudera 提供的一个高可用的,高可靠的,分布式的海量日志采集、聚合和传

输的系统。Flume 基于流式架构,灵活简单。

Flume最主要的作用就是,实时读取服务器本地磁盘的数据,将数据写入到HDFS

Flume架构

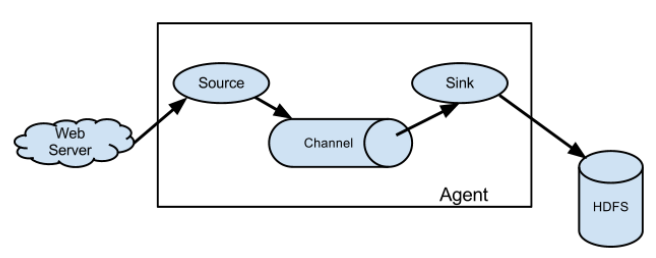

Agent

Agent 是一个 JVM 进程,它以事件的形式将数据从源头送至目的。

Agent 主要有 3 个部分组成,Source、Channel、Sink。

Source

Source 是负责接收数据到 Flume Agent 的组件。Source 组件可以处理各种类型、各种

格式的日志数据,包括 avro、thrift、exec、jms、spooling directory、netcat、taildir、

sequence generator、syslog、http、legacy。

Sink

Sink 不断地轮询 Channel 中的事件且批量地移除它们,并将这些事件批量写入到存储

或索引系统、或者被发送到另一个 Flume Agent。

Sink 组件目的地包括 hdfs、logger、avro、thrift、ipc、file、HBase、solr、自定

义。

Channel

Channel 是位于 Source 和 Sink 之间的缓冲区。因此,Channel 允许 Source 和 Sink 运

作在不同的速率上。Channel 是线程安全的,可以同时处理几个 Source 的写入操作和几个

Sink 的读取操作。

Flume 自带两种 Channel:Memory Channel 和 File Channel。

Memory Channel 是内存中的队列。Memory Channel 在不需要关心数据丢失的情景下适

用。如果需要关心数据丢失,那么 Memory Channel 就不应该使用,因为程序死亡、机器宕

机或者重启都会导致数据丢失。

File Channel 将所有事件写到磁盘。因此在程序关闭或机器宕机的情况下不会丢失数

据。

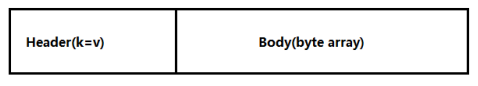

Event

传输单元,Flume 数据传输的基本单元,以 Event 的形式将数据从源头送至目的地。

Event 由 Header 和 Body 两部分组成,Header 用来存放该 event 的一些属性,为 K-V 结构,

Body 用来存放该条数据,形式为字节数组

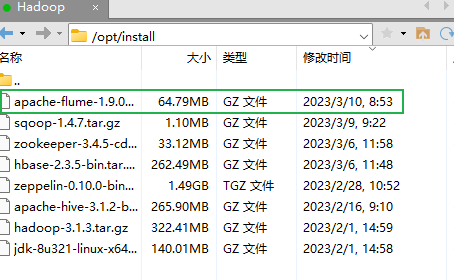

Flume安装步骤

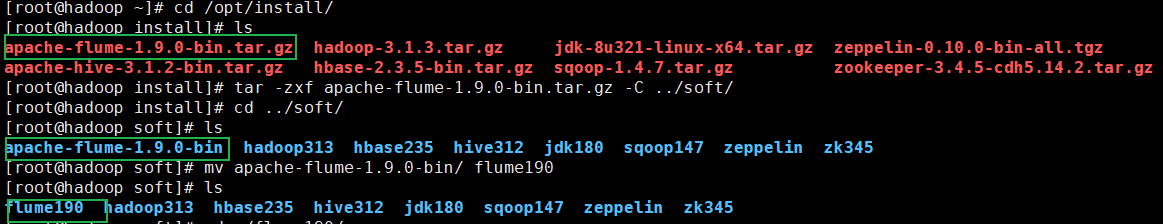

上传压缩包至/opt/install

解压并更名

# 切换目录

[root@hadoop ~]# cd /opt/install/

# 解压

[root@hadoop install]# tar -zxf apache-flume-1.9.0-bin.tar.gz -C ../soft/

# 切换目录

[root@hadoop install]# cd ../soft/

# 更名

[root@hadoop soft]# mv apache-flume-1.9.0-bin/ flume190

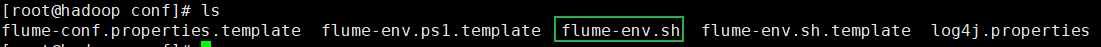

修改配置文件

# 配置文件更名

[root@hadoop conf]# cp flume-env.sh.template flume-env.sh

[root@hadoop conf]# vim ./flume-env.sh

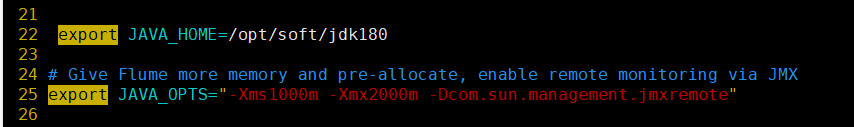

export JAVA_HOME=/opt/soft/jdk180

export JAVA_OPTS="-Xms1000m -Xmx2000m -Dcom.sun.management.jmxremote"

安装工具

[root@hadoop conf]# yum install -y nc

[root@hadoop ~]# yum install telnet-server

[root@hadoop ~]# yum install telnet.*

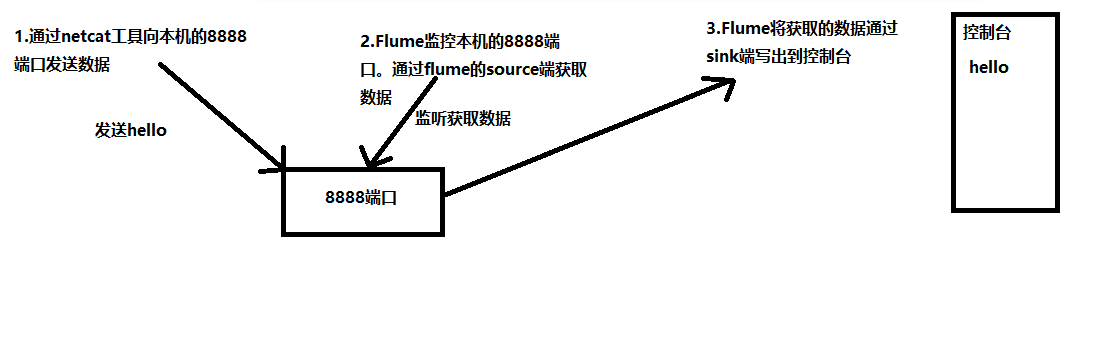

应用案例

编写配置文件 netcat-logger.conf

netcat-logger.conf

# Name the components on this agent a1表示agent的名称

a1.sources=r1 #r1表示a1的source名称

a1.sinks=k1 #k1表示a1的sink名称

a1.channels=c1 #c1表示a1的channel名称

# configure the source

a1.sources.r1.type=netcat #表示a1的输入源类型为netcat端口类型

a1.sources.r1.bind=localhost #表示a1的监听的主机

a1.sources.r1.port=8888 #表示a1的监听的端口号

# Use a channel which buffers events in memory

a1.channels.c1.type=memory # 表示示a1的channel类型是memory内存型

a1.channels.c1.capacity=1000 # 表示a1的channel总容量1000个event

a1.channels.c1.transactionCapacity=100 # 表示a1的channel传输时收集到了100条event以后再去提交事务

# Describe sink

a1.sinks.k1.type=logger

a1.sources.r1.channels=c1 #表示将r1和c1连接起来

a1.sinks.k1.channel=c1 #表示将k1和c1连接起来

启动

[root@hadoop flume190]# ./bin/flume-ng agent --name a1 --conf ./conf/ --conf-file ./conf/netcat-logger.conf -Dflume.root.logger=INFO,console

–conf/-c:表示配置文件存储在 conf/目录

–name/-n:表示给 agent 起名为 a1

–conf-file/-f:flume 本次启动读取的配置文件是在 job 文件夹下的 netcat-logger.conf 文件

-Dflume.root.logger=INFO,console :-D 表示 flume 运行时动态修改 flume.root.logger

参数属性值,并将控制台日志打印级别设置为 INFO 级别。日志级别包括:log、info、warn、error

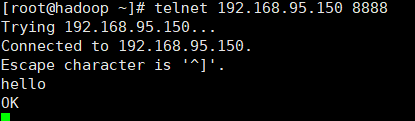

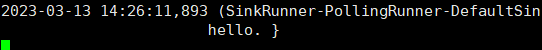

案例分析

# 重新开一个窗口 拨号发送hello

[root@hadoop ~]# telnet 192.168.95.150 8888

333

333

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?