numpy

random.shuffle(x[, random]):用于将一个列表中的元素打乱

np.tile(1,n) np.tile(n,1) np.tile(n,n) 就是将原矩阵横向、纵向地复制、纵横。

np.hstack((a,b))水平组合

np.vstack((a,b))垂直组合

data[‘second’] = data[‘second’].astype(int)某行转化类型

ndarray = np.array(list) # list 转 numpy数组

list = ndarray.tolist() # numpy 转 list

tensor=torch.Tensor(list) # list 转 torch.Tensor

list = tensor.numpy().tolist() # torch.Tensor 转 list 先转numpy,后转list

ndarray = tensor.cpu().numpy() # torch.Tensor 转 numpy *gpu上的tensor不能直接转为numpy

tensor = torch.from_numpy(ndarray) # numpy 转 torch.Tensor

pytorch

unsqueeze_(dim=):dim的维度上加1

squeeze_(dim)把dim(如果dim维度为1)这个维度去掉

.item() 返回可遍历的key和值

detach_ 不进行梯度下降

nn.Conv2d是一个类,而F.conv2d()是一个函数,而nn.Conv2d的forward()函数实现是用F.conv2d()实现的

torch.cat(seq,dim=0,out=None) # 沿着dim连接seq中的tensor, 所有的tensor必须有相同的size或为empty, 其相反的操作为 torch.split() 和torch.chunk()

torch.stack(seq, dim=0, out=None) #在dim上添加一个维度

torch.permute(1,0,2,3)多维度转置

data = tensor:narrow(dim, index, size)#表示从第dim个维度从index取size行的数据出来

torch.ge(input,g) 输出矩阵input大于g的位置为1

torch.lt(imput,l )输出矩阵input小于g的位置为1

torch.full((2, 3), 3.141592)

tensor([[ 3.1416, 3.1416, 3.1416],

[ 3.1416, 3.1416, 3.1416]])

ValueError: Expected more than 1 value per channel when training, got input size [1, 256, 1, 1] 问题

最后一批为1,将DataLoader中drop_last设置为True,丢弃最后不够一批的数据

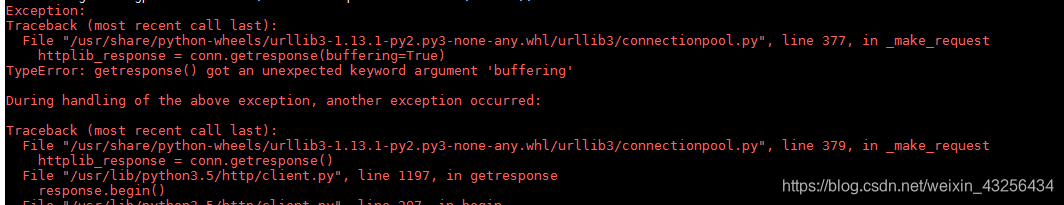

RuntimeError: CUDA error: device-side assert triggered

分类类别问题

python

class Indexer:

def getitem(self, index): #重载索引,对于实例的索引运算,会自动调用__getitem__

return index**2

x=Indexer()

print(x[3]) #9

path.split(’/’)[-2] #返回路径最后第二个/后面的内容

linux

sed -i “s|/home/lin/turi_test|/home/jinyl|g” grep /home/lin/turi_test -rl .(后面半句输出的为文件名)

替换所有文件夹中的/home/lin/turi_test|为/home/jinyl

chmod 777 打开文件夹权限

初始环境变量

export PATH=.:/usr/local/sbin:/usr/local/bin:/sbin:/bin:/usr/sbin:/usr/bin:/root/bin

nvcc not find

export CPATH=/usr/local/cuda-9.0/include

export LD_LIBRARY_PATH=/usr/local/cuda/lib

export PATH=$PATH:/usr/local/cuda/bin

动态 显卡信息watch -n 0.1 nvidia-smi

tar zxvf 文件名.tgz -C ./

xvf

修该默认python版本

cd /usr/bin

sudo rm -rf python

删除后再建立新的链接关系:

sudo ln -s /usr/bin/python3 /usr/bin/python

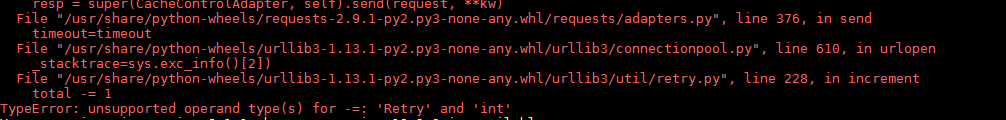

pip install 报错

解决

python -m pip uninstall pip && sudo apt install python-pip --reinstall

驱动failed

cd /usr/src

ls 查看版本

step1:sudo apt-get install dkms

step2: sudo dkms install -m nvidia -v 430.26

conda 复制环境

conda create -n BBB --clone AAA

pthread_mutex_lock:在多线程编程中,引入了对象互斥锁的概念,来保证共享数据操作的完整性。 每个对象都对应于一个可称为" 互斥锁" 的标记,这个标记用来保证在任一时刻, 只能有一个线程访问该对象。

5048

5048

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?