论文一:

数据集:PopQA,Biography,PubHealth,Arc-Challenge

1. 检索阶段(Retrieval Phase)

-

评估指标:检索的相关性和准确性。

-

具体指标:

-

检索文档的相关性:通过检索评估器(Retrieval Evaluator)对检索到的文档进行评分,判断其与输入问题的相关性。评分范围从-1到1,分数越高表示相关性越强。

-

检索文档的质量:通过检索评估器判断检索到的文档是否包含准确的信息来回答问题。评估器会根据文档内容给出“正确”(Correct)、“错误”(Incorrect)或“模糊”(Ambiguous)的判断。

-

2. 知识增强阶段(Knowledge Augmentation Phase)

-

评估指标:知识增强的效果和知识的选择性过滤。

-

具体指标:

-

知识分解与重组:通过分解-重组算法(decompose-then-recompose algorithm)对检索到的文档进行细化,提取关键信息并过滤掉不相关的内容。

-

外部知识补充:当检索结果被判定为“错误”时,系统会通过大规模网络搜索(web search)来补充外部知识,确保生成的内容具有更高的准确性和多样性。

-

3. 生成阶段(Generation Phase)

-

评估指标:生成文本的准确性和事实性。

-

具体指标:

-

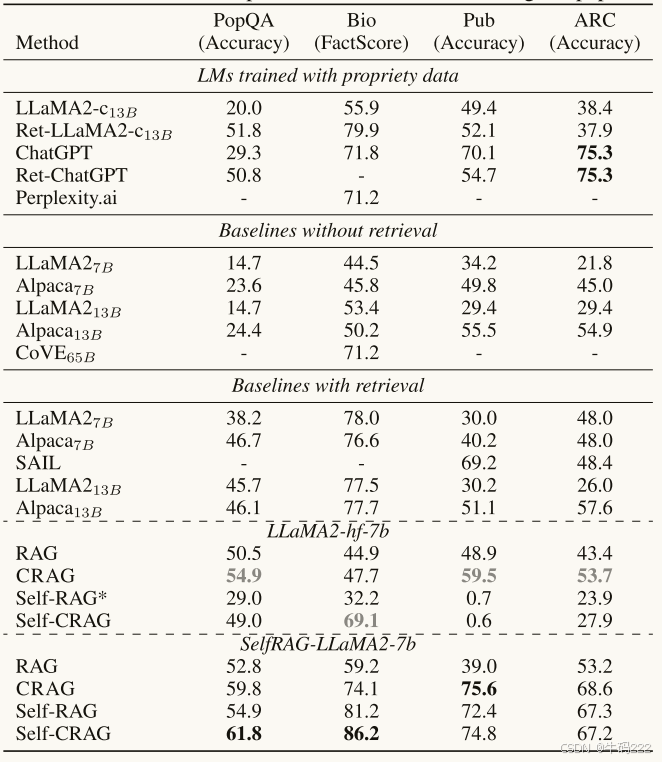

生成文本的准确性:在多个数据集上(如PopQA、Biography、PubHealth、Arc-Challenge)评估生成文本的准确性。具体指标包括:

-

PopQA:准确率(Accuracy)。

-

Biography:FactScore,用于评估生成的长文本的事实准确性。

-

PubHealth:准确率(Accuracy),用于判断健康相关问题的真伪。

-

Arc-Challenge:准确率(Accuracy),用于评估科学常识问题的回答准确性。

-

-

4. 整体系统评估(Overall System Evaluation)

-

评估指标:系统的整体性能和鲁棒性。

-

具体指标:

-

CRAG与RAG的性能对比:通过对比CRAG和标准RAG在不同数据集上的表现,评估CRAG在提升生成鲁棒性方面的效果。

-

消融实验(Ablation Study):通过移除不同的动作(如Correct、Incorrect、Ambiguous)或知识利用操作(如文档细化、搜索查询重写、外部知识选择),评估每个组件对系统性能的贡献。

-

检索评估器的准确性:评估检索评估器在判断检索结果质量时的准确性,对比其与商业LLM(如ChatGPT)的表现。

-

5. 计算开销评估(Computational Overhead Evaluation)

-

评估指标:系统的计算开销和执行时间。

-

具体指标:

-

FLOPs(浮点运算次数):评估每个token生成所需的计算量。

-

执行时间:评估每个实例的平均执行时间,确保CRAG的计算开销在可接受范围内。

-

通过这些评估指标,文章全面评估了CRAG在检索、知识增强、生成等各个阶段的性能,并验证了其在提升生成鲁棒性和准确性方面的有效性。

论文二:

1. 检索阶段(Retrieval Stage)

-

Recall@10:衡量检索到的前10个文档中包含相关文档的比例。该指标反映了检索系统的召回能力,即检索到相关文档的效率。

-

MAP@10(Mean Average Precision at 10):衡量检索到的前10个文档的相关性排序质量。它综合考虑了检索结果的相关性和排序顺序,反映了检索系统的准确性和排序能力。

-

RePASs(Regulatory Passage Answer Stability Score):虽然主要用于生成阶段的评估,但在检索阶段也间接反映了检索结果的质量。它通过评估生成答案的稳定性、准确性和一致性,间接反映了检索到的文档是否为生成高质量答案提供了足够的支持。

2. 生成阶段(Generation Stage)

-

RePASs(Regulatory Passage Answer Stability Score):这是一个综合指标,用于评估生成答案的质量。它包括三个子指标:

-

Entailment Score (Es):衡量生成答案中的每个句子在多大程度上得到了检索到的文档的支持。该指标反映了生成答案的准确性和可靠性。

-

Contradiction Score (Cs):评估生成答案中是否有句子与检索到的文档中的信息相矛盾。该指标反映了生成答案的一致性和逻辑性。

-

Obligation Coverage Score (OCs):检查生成答案是否覆盖了检索到的文档中提到的所有义务。该指标反映了生成答案的全面性和完整性。

-

3. 综合性能(Overall Performance)

-

Recall@10 和 MAP@10 的提升:这些指标用于衡量混合检索系统相对于单独的词汇检索或语义检索方法的性能提升。文章通过比较这些指标,证明了混合方法在检索阶段的优势。

-

RePASs 的提升:用于衡量RAG系统在生成阶段的性能提升。通过比较不同模型(如GPT 3.5 Turbo、GPT-4o Mini和Llama 3.1)的RePASs分数,文章展示了混合检索系统在生成高质量答案方面的有效性。

4. 效率和资源消耗(Efficiency and Resource Consumption)

-

训练时间和内存使用:文章提到了使用Automatic Mixed Precision(AMP)技术来减少训练过程中的内存使用,并提高训练速度。虽然这不是一个直接的评估指标,但它反映了系统在实际应用中的可行性和效率。

5. 鲁棒性(Robustness)

-

对不同模型的适应性:文章通过在不同语言模型(如GPT 3.5 Turbo、GPT-4o Mini和Llama 3.1)上进行实验,展示了混合检索系统在生成阶段的鲁棒性。尽管不同模型的性能有所不同,但混合检索系统都能提供高质量的输入,从而生成准确的答案。

总结

文章通过Recall@10、MAP@10和RePASs等指标,全面评估了混合检索系统在检索和生成阶段的性能。这些指标不仅衡量了检索结果的质量和相关性,还评估了生成答案的准确性、一致性和全面性。通过这些评估指标,文章证明了混合方法在处理复杂监管文本时的有效性和优越性。

论文三:

1. 检索阶段(Retrieval Phase)

-

评估指标:检索的相关性和准确性。

-

具体指标:

-

检索F1分数(Retrieval F1 Score):衡量检索到的文档与真实相关文档之间的匹配度。计算公式为:

F1retrieval=2⋅P⋅RP+RF1retrieval=P+R2⋅P⋅R其中,PP 是检索的精确率(Precision),RR 是召回率(Recall)。

-

检索成本(Retrieval Cost):衡量在检索过程中调用LLM的次数,次数越少,成本越低。

-

2. 知识增强阶段(Knowledge Augmentation Phase)

-

评估指标:知识增强的效果和知识的选择性过滤。

-

具体指标:

-

图结构的构建:通过伪查询(pseudo-queries)构建图结构,顶点是文本块,边是通过LLM生成的逻辑关系。评估图结构的构建效率和逻辑关系的准确性。

-

图遍历的多跳推理:通过多跳推理(multi-hop reasoning)从间接相关的文档中跳转到真正相关的文档。评估多跳推理的效果和效率。

-

3. 生成阶段(Generation Phase)

-

评估指标:生成文本的准确性和一致性。

-

具体指标:

-

精确匹配(Exact Match, EM):生成的答案与标准答案完全匹配的比例。

-

F1分数(F1 Score):生成的答案与标准答案之间的重叠度,计算公式为:

F1=2⋅P⋅RP+RF1=P+R2⋅P⋅R其中,PP 是生成的答案的精确率,RR 是召回率。

-

4. 整体系统评估(Overall System Evaluation)

-

评估指标:系统的整体性能和鲁棒性。

-

具体指标:

-

多跳问答任务的性能:在多个多跳问答数据集(如MuSiQue、2WikiMultiHopQA、HotpotQA)上的表现,评估系统的整体性能。

-

与基线方法的对比:与传统的稀疏检索(BM25)、稠密检索(BGE)以及其他结构化RAG方法(如RAPTOR、SiReRAG、GraphRAG)进行对比,评估HopRAG在检索和生成任务上的优势。

-

5. 计算开销评估(Computational Overhead Evaluation)

-

评估指标:系统的计算开销和执行时间。

-

具体指标:

-

LLM调用次数:在多跳推理过程中调用LLM的次数,衡量系统的计算开销。

-

图遍历的效率:通过控制多跳次数(nhopnhop)和检索文档数量(topktopk),评估系统在不同参数设置下的效率和性能。

-

6. 消融实验(Ablation Study)

-

评估指标:不同组件对系统性能的影响。

-

具体指标:

-

是否使用推理模型:通过对比使用和不使用推理模型的图遍历效果,评估推理模型对系统性能的提升。

-

多跳次数的影响:通过调整多跳次数(nhopnhop),评估多跳推理对检索和生成任务的影响。

-

检索文档数量的影响:通过调整检索文档数量(topktopk),评估不同上下文长度对生成任务的影响。

-

通过这些评估指标,文章全面评估了HopRAG在检索、知识增强、生成等各个阶段的性能,并验证了其在提升生成鲁棒性和准确性方面的有效性。

论文四:

1. 检索阶段(Retrieval Stage)

-

Top-k检索准确率(Top-k Retrieval Accuracy):

-

用于衡量检索到的前k个文档中包含相关文档的比例。文章中使用了Top-5、Top-10和Top-20等指标来评估检索性能。

-

计算方法:计算检索结果中与真实相关文档匹配的比例。

-

示例:

-

在NQ数据集上,Blended RAG的Top-10检索准确率达到88.77%(图2)。

-

在TREC-COVID数据集上,Blended RAG的Top-10检索准确率达到78%(图3)。

-

在HotPotQA数据集上,Blended RAG的Top-10检索准确率达到65.70%(图5)。

-

-

-

NDCG@10(Normalized Discounted Cumulative Gain):

-

用于衡量检索结果的相关性排序质量。NDCG@10考虑了检索结果的相关性和排序顺序,是一个综合指标。

-

计算方法:通过计算检索结果的相关性得分的折算累积增益来评估检索性能。

-

示例:

-

在NQ数据集上,Blended RAG的NDCG@10得分为0.67,比当前基准(0.633)高出5.8%(图6)。

-

在TREC-COVID数据集上,Blended RAG的NDCG@10得分为0.87,比当前基准(0.804)高出8.2%(图7)。

-

-

2. 生成阶段(Generation Stage)

-

精确匹配(Exact Match, EM):

-

用于衡量生成答案与真实答案的完全匹配程度。它计算生成答案与真实答案完全一致的比例。

-

计算方法:计算生成答案与真实答案完全匹配的比例。

-

示例:

-

在SQuAD数据集上,Blended RAG的EM得分为57.63%(表IV)。

-

在NQ数据集上,Blended RAG的EM得分为42.63%(表V)。

-

-

-

F1分数(F1 Score):

-

用于衡量生成答案与真实答案之间的平均重叠程度。它通过计算生成答案与真实答案之间的精确率(Precision)和召回率(Recall)的调和平均值来评估生成质量。

-

计算方法:计算生成答案与真实答案之间的F1分数。

-

示例:

-

在SQuAD数据集上,Blended RAG的F1得分为68.4%(表IV)。

-

在NQ数据集上,Blended RAG的F1得分为53.96%(表V)。

-

-

3. 综合性能(Overall Performance)

-

检索准确率提升(Retrieval Accuracy Improvement):

-

用于衡量Blended RAG相对于传统方法在检索准确率上的提升。

-

计算方法:通过比较Blended RAG与其他基线方法在不同数据集上的检索准确率来衡量。

-

示例:

-

在TREC-COVID数据集上,Blended RAG的检索准确率比当前基准高出8.2%(表II)。

-

-

-

生成质量提升(Generation Quality Improvement):

-

用于衡量Blended RAG相对于传统方法在生成质量上的提升。

-

计算方法:通过比较Blended RAG与其他基线方法在不同数据集上的EM和F1分数来衡量。

-

示例:

-

在SQuAD数据集上,Blended RAG的F1分数比RAG-end2end高出50%(表IV)。

-

在NQ数据集上,Blended RAG的EM分数比GLaM(Oneshot)高出35%(表V)。

-

-

4. 效率和资源消耗(Efficiency and Resource Consumption)

-

索引大小(Index Size):

-

用于衡量不同索引方法的存储需求。文章中提到,稀疏向量索引(Sparse Vector Index)比密集向量索引(Dense Vector Index)更节省存储空间。

-

示例:

-

HotPotQA数据集的稀疏向量索引大小为10.5GB,而密集向量索引大小为50GB(第V节A部分)。

-

-

-

查询性能(Query Performance):

-

用于衡量不同索引方法的查询效率。文章中提到,稀疏向量索引查询速度更快,而密集向量索引查询速度较慢。

-

示例:

-

稀疏向量索引在查询性能上优于密集向量索引(第V节A部分)。

-

-

总结

文章通过Top-k检索准确率、NDCG@10、精确匹配(EM)、F1分数等指标,全面评估了Blended RAG在检索和生成阶段的性能。这些指标不仅衡量了检索结果的质量和相关性,还评估了生成答案的准确性和一致性。通过这些评估指标,文章证明了Blended RAG在处理大规模文档库时的有效性和优越性。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?