[title]导读[/title]

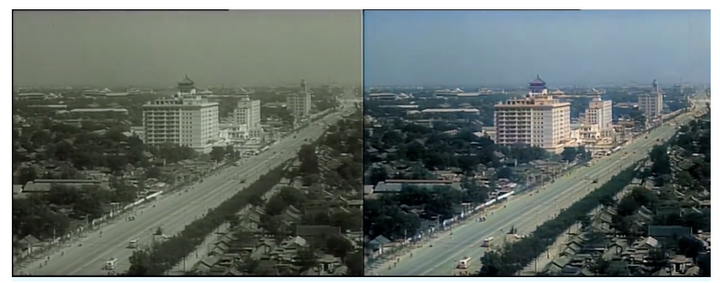

一百年前的北京是什么样子?如何真实还原六十年前首都建设的大场面?之前一位叫大谷Spitzer的微博网友利用AI技术,将人民日报 4 年前发布的 1920 年北京黑白影像资料,做了修复工作;近日,央视新闻又与大谷Spitzer合作,利用AI技术修复了六十多年前首都建设的大场面。

在这些视频中,作者对黑白影像完成了修复帧率、扩大分辨率、上色等步骤。通过插帧技术使视频更加流畅;通过超分辨率提升视频画质,最后对视频进行上色。

此外还有部分视频受限于拍摄设备配置、光线不足等因素,可能存在较多噪点,画面模糊等。所以还需要对视频进行去伪影、去噪操作。这些内容会在下一章节中讲述。虽然这些视频引发了大量的关注,但其背后的算法却已有了多年的发展,如图像超分辨自从 2002 年开始,至今研究了近 20 年。视频插帧技术也有近 10 年的历史。但其终究存在技术门槛,让普通大众难以深入了解并使用这些技术。

那有没有现成的软件可以快速体验上手AI视频修复?

本文将给出三种作者提到的现有方案,实现帧率修复、超分辨率、上色三大功能。所有

软件

或

代码

均可在公众号后台回复

「视频修复」

免费获取。

本系列文章Part1:软件上手快速体验用AI修复老视频part2:技术篇:AI是如何对视频进行修复的

[title]软件&代码[/title]

帧率修复/DAIN

Github:github.com/baowenbo/DAIN

软件地址:grisk.itch.io/dain-app

该项目中,作者提出了DAIN模型,给定两个时刻的输入帧,先估计光流和深度图,然后使用建议的深度感知流投影层生成中间流。然后,模型基于光流和局部插值内核对输入帧、深度图和上下文特征进行扭曲,合成输出帧。

这种模型紧凑、高效且完全可微分。定量和定性的结果表明,DAIN在各种数据集上均优于最新的帧插值方法。下图为该项目的软件版本。

超分辨率/ESRGAN

Github:github.com/xinntao/ESRGAN

软件地址:无ESRGAN 是一个基于增强型超分辨率生成对抗网络的 AI 图像处理工具,能通过 AI 在图像超分辨率期间生成真实纹理,实现图像分辨率的提升,效果如下图所示:

项目论文中提出的 ESRGAN 在 SRGAN 的基础上做出了改进,包括去除 BN 层,基本结构换成 RDDB,改进 GAN 中判别器的判别目标,以及使用激活前的特征构成感知域损失函数,实验证明这些改进对提升输出图像的视觉效果都有作用。

此外,论文作者也使用了一些技巧来提升网络的性能,包括对残差信息的 scaling,以及更小的初始化。最后,作者使用了一种网络插值的方法来平衡输出图像的视觉效果和 PSNR 等指标值。

上色/DeOldify

Github:github.com/jantic/DeOldify

软件地址:无

DeOldify 是用于着色和恢复旧图像及视频的深度学习项目。它采用了 NoGAN 这样一种新型的、高效的图像到图像的 GAN 训练方法。细节处理效果更好,渲染也更逼真。下为效果图。

目前,DeOldify 有三种型号可供选择,每一种都有关键优势和劣势,因此具有不同的用例。三种型号分别为:

Artistic(艺术型)

、

Stable(稳定型)

、

Video(视频专用)

所有软件或代码均可关注公众号「IamZLT」在公众号后台回复「视频修复」即可免费获取。

7258

7258

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?