MapReduce数据流程

1. MapReduce数据流程概览

MapReduce计算框架整体分为四大部分:

- source端就是InputFormat;

- 中间分布式计算就是Mapper和Reducer;

- sink端就是OutputFormat

2. InputFormat

功能

(1)将原始数据处理成KV

InputFormat是mapreduce处理数据的第一步,它接触的是最原始的数据文件,将原始数据处理成KV形式交给Mapper处理;

(2)切片

决定如何对数据文件进行切片,进而决定了一个MapReduce任务有多少个并行的MapTask

概述

InputFormat是一个接口,拥有各种实现类应用于不同的场景中,将在后面一一介绍;

2.1 切片机制 (决定MapTask并行度)

(1)数据块和数据切片的概念

数据块

- Block是HDFS物理上把文件分成一块一块进行存储

- 数据块是HDFS存储数据单位。

数据切片

- 数据切片只是对一个数据文件在逻辑上对输入进行分片,并不会在磁盘上将其切分成片进行存储。

- 数据切片是MapReduce程序计算输入数据的单位,一个切片会对应启动一个MapTask。

(2)切片和maptask的关系

mapper阶段并行度和切片的关系

- 一个切片对应一个 maptask ,并行度越高,处理越快;

切片是针对文件个体

-

这里的意思是: 我们在Driver类中指定MapReduce的输入数据的路径时,可以是目录也可以具体到文件;目录则意味着可能会有多个数据文件,那么在切片的时候,是针对每个文件进行切片的;

-

举例说明: 一个目录总共有500M,分为300M、100M、100M三个文件,那么按照128M切片,产生:128M+128M+44M,100M,100M五个切片;

切片大小的设定

-

切片大小一般和块大小保持一致;而默认就是块大小

-

Yarn优化原则:尽量在数据切片所在的节点启动MapTask来处理切片数据。这是为了避免网络传输。

比如按照100M切片,Node1上128M,产生28M的网络传输,Node2上128M,加上Node1传递来的28M,Node2需要往Node3传递56M的数据,这样整个集群就产生了28+56=84M的流量!

因此块设置的越小,意味着MapTask越多,集群整体的处理时间最短,但是加上IO时间,集群整体的处理性能下降!

2.2 Job提交流程

起点: Job.waitForCompletion(true)提交任务

连接: Connection() 方法判断是本地还是yarn集群,因为需要提交job相关的任务信息,如果是本地环境,就在本地创建一个目录( …/…/staging)来保存任务信息,如果是集群环境,就提交到hdfs的目录下;

生成信息:

- 生成jobid,并创建文件

- 客户端进行逻辑切片,生成切片规划文件job.split

- 将job.split、job.xml、job.jar 提交到连接过程中生成的目录下

2.3 FileInputFormat切片机制

inputformat接口的不同实现类针对不同的数据源场景,因此各自有各自的切片规则,由于最常用的是文件作为数据源,因此这里讲解 FileInputForma类,该类专门用于输入类型是文件的数据源

(1)流程

- 遍历每个文件

- 获取文件大小

- 计算切片大小

- 开始切片,形成切片规划文件

- 提交切片规划文件到yarn的AppMaster,AM根据此文件计算开启MapTask的个数

(2)如何切 【切片机制】

- 按照文件内容长度进行切片

- 切片大小默认等于Block大小

- 切片时不考虑数据集整体,而是针对指定的数据目录下的每一个文件单独切片

- 每次切片时,都要判断切完剩下的部分是否大于block的1.1倍,如果不大于,就不切了,当做一块切片!

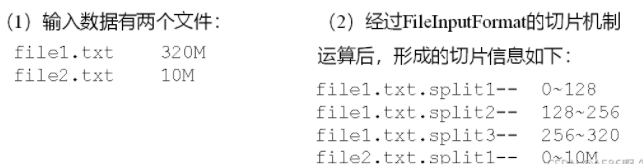

案例分析:

(3)切片大小设置

切片大小: MinSize\blockSize\MaxSize 三者中取中间的

3. 一些InputFormat实现类

3.1 TextInputFormat

(1)切片机制

切片方式和FileInputFormat是一样的

(2)产生的kv

TextInputFormat输出的key-value对是(行偏移量,行内容)

3.2 KeyValueTextInputFormat

(1)切片机制

切片方式和FileInputFormat是一样的

(2)产生的kv

3.3 NLineInputFormat

(1)切片机制

(2)产生的kv

kv和TextInputFormat是一样的

3.4 CombineTextInputFormat(解决小文件问题)

框架默认的TextInputFormat切片机制是对任务按文件规划切片,不管文件多小,都会是一个单独的切片,都会交给一个MapTask,这样如果有大量小文件,就会产生大量的MapTask,处理效率极其低下。

(1)应用场景:

CombineTextInputFormat用于小文件过多的场景,它可以将多个小文件从逻辑上规划到一个切片中,这样,多个小文件就可以交给一个MapTask处理。

(2)虚拟存储切片最大值设置

CombineTextInputFormat.setMaxInputSplitSize(job, 4194304);// 4m

注意:虚拟存储切片最大值设置最好根据实际的小文件大小情况来设置具体的值

(3)切片机制

(1)虚拟存储过程:

将输入目录下所有文件大小,依次和设置的setMaxInputSplitSize值比较。

① 如果不大于设置的最大值,逻辑上划分一个块。

② 如果输入文件大于setMaxInputSplitSize且大于两倍,那么以setMaxInputSplitSize切割一块;

③ 当剩余数据大小超过setMaxInputSplitSize且不大于最大值2倍,此时将文件均分成2个虚拟存储块(防止出现太小切片)。

例如setMaxInputSplitSize值为4M,输入文件大小为8.02M,则先逻辑上分成一个4M。剩余的大小为4.02M,如果按照4M逻辑划分,就会出现0.02M的小的虚拟存储文件,所以将剩余的4.02M文件切分成(2.01M和2.01M)两个文件。

(2)切片过程:

(a)判断虚拟存储的文件大小是否大于setMaxInputSplitSize值,大于等于则单独形成一个切片。

(b)如果不大于则跟下一个虚拟存储文件进行合并,共同形成一个切片,超了setMaxInputSplitSize,就是一个切片,没有超过,就继续和下一个虚拟存储文件合并。

(c)测试举例:有4个小文件大小分别为1.7M、5.1M、3.4M以及6.8M这四个小文件,则虚拟存储之后形成6个文件块,大小分别为:

1.7M,(2.55M、2.55M),3.4M以及(3.4M、3.4M)

最终会形成3个切片,大小分别为:

(1.7+2.55)M,(2.55+3.4)M,(3.4+3.4)M

(4)CombineTextInputFormat实操

用之前的wordcount程序,准备如下数据目录和数据文件:

552

552

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?