Residual dense network for medical magnetic resonance images super-resolution

(医学磁共振图像超分辨率的残差稠密网络)

高分辨率磁共振成像(MRI)有助于专家定位病灶和诊断疾病,但高分辨率MRI难以获得。此外,基于深度学习的图像超分辨率技术可以有效提高图像分辨率。本文提出了一种基于残差稠密网络(MRDN)的医学磁共振(MR)图像超分辨率重建方法。首先将浅层的卷积特征输入到剩余的稠密块中,得到全局和局部特征。其次,将剩余密集块中的每一层直接连接到前一层,实现特征的重用。最后利用亚像素卷积层进行上采样和超分辨率重建,得到清晰的高分辨率图像。在Set5、Set14和Urban100基准数据集上,针对2倍、3倍和4倍放大,MRDN方法显示出了优于现有方法的优越性,大量的基准实验和分析表明,MRDN算法在峰值信噪比(PSNR)和结构相似性指标(SSIM)方面具有优越性。在三个公共数据集上进行了定量实验:Set5、Set14和Urban10,采用常用的评价指标进行评价,实验结果表明本文方法是有效的。此外,我们对公共MR数据集进行了重建,重建的高分辨率MR图像结构清晰,纹理细节丰富。

介绍

磁共振成像(MRI)是一种断层成像技术,利用磁共振(MR)从人体获取电磁信号,重建人体信息。MRI是在静磁场中对人体施加一定频率的射频脉冲,使人体内的氢质子被激发而引起磁共振。脉冲停止后,质子在弛豫过程中产生MR信号。通过诸如MR信号接收、空间编码和图像重建的处理过程来生成MR图像。MRI已用于全身各种系统的成像诊断,包括脑、脊髓、心脏和大血管、关节骨、软组织和骨盆。MR、正电子发射断层扫描(PET)和单光子发射计算机断层扫描(SPECT)之间的区别在于它可以在不注射放射性同位素的情况下成像。同时,MRI可以获得任意方向的断层图像、三维图像、甚至空间谱分布的四维图像。但由于MR成像的特殊性,硬件成像的分辨率已经达到极限,磁场和辐射时间的增加会对人体造成蛋白失活等不可逆的损伤。高分辨率(HR)MR图像有助于专家定位病变和诊断疾病。因此,MR图像超分辨率(SR)的软件方法对于实现MR图像分辨率的提高而不对人体造成伤害具有重要意义。图像SR重建的方法主要包括基于插值的方法、基于重建的方法、基于字典学习的方法、基于深度学习的方法。

近年来,随着基于深度学习超分辨率方法的相关竞赛的增多,越来越多的研究者开始利用学习方法来探索超分辨率及其相关问题。Dong等人在2014年提出了一种结合卷积神经网络的超分辨率算法模型(SRCNN),该模型根据卷积神经网络结构依次提取并充分表示图像块信息,然后完成非线性映射和分辨率增强操作。基于SRCNN方法的重建图像与插值和重建方法相比有明显的改善。Dong等[15]在原有算法的基础上提出了FSRCNN方法,将卷积网络结构扩展到8层。在网络的末端,对低分辨率(LR)图像进行解卷积采样,得到的图像明显优于SRCNN处理后的图像。Kim等人将残差学习引入到图像超分辨率重建中,提出了极深超分辨率(VDSR)模型。残差学习解决了深度学习梯度消失的问题,使网络层次进一步加深,大大提高了网络学习效果。但其模型只是简单的卷积层叠加,不能有效地提取图像信息。随后,Kim等人设计了基于深度递归卷积网络(DRCN)框架的超分辨率算法。该算法通过增加每层卷积核的大小来获取目标像素周围的更多信息。此外,该方法还引入了递归神经网络,使网络更加简化,产生更好的图像质量。

然而,这些方法只使用信息从某些卷积层,而不是全部。对象在一个图像有不同的尺度,视角和纵横比,深卷积神经网络的分层特性在图像重建可以很大的帮助。因此,我们提出一个残余图像SR致密的网络结构。

贡献

1)针对低频信息丢失和网络收敛困难的问题,设计了残差密集网络。

2)为了解决由于网络层数增加而引起的网络性能下降的问题,我们提出了多残差块(MRB)。

3)为了提高图像特征信息获取的准确性,设计了长短跳跃连接的残差结构。

相关工作

深度卷积神经网络在训练过程中容易遇到梯度消失的问题,通过在块归一化时将输入数据从激活函数的收敛区域调整到梯度较大的区域,可以在一定程度上缓解这一问题。然而,当网络层数急剧增加时,反向传播(BP)算法导数的累积效应很容易使梯度缓慢减小直至消失。为了从根本上解决这一问题,He等人提出了深度残差网络,以简化那些非常深度的网络的训练过程,使得该层可以基于其输入而不是原始函数来学习残差函数。

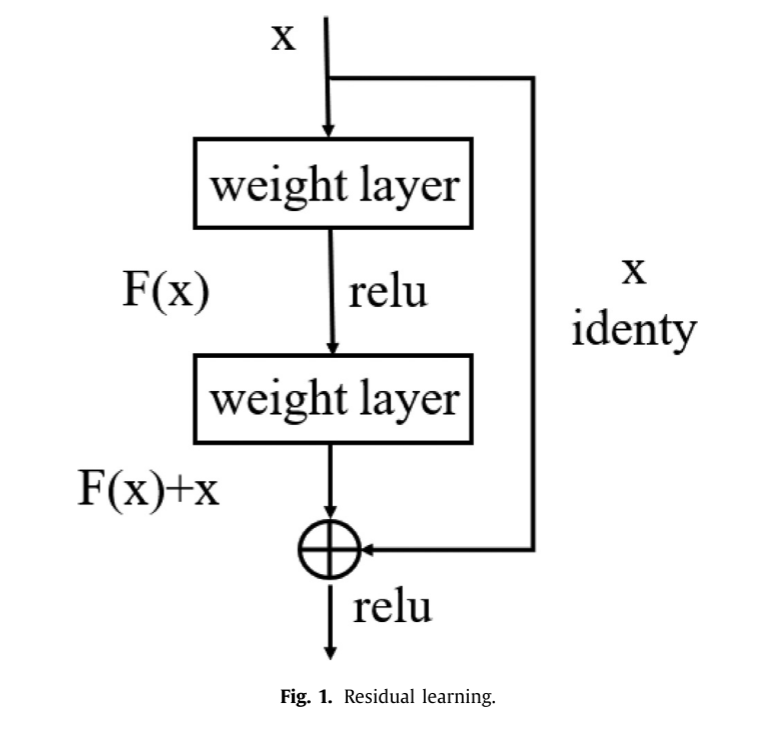

实验表明,这些残差网络的优化过程相对简单,能够使网络结构具有更深的层次,能够获得更高的性能。在ImageNet数据集上使用152层网络结构来评估建议的残差网络。虽然它等价于8倍深度视觉几何组(VGG)网络,但在所提出的框架中仍然具有很低的复杂度。这些残差网络的组合模型在ImageNet数据集上的误差率仅为3.57%。该结果在2015年ImageNet大规模视觉识别挑战(ILSVRC)分类任务中获得第一名,每个残差块如图1所示。

其中:x是输入。假设H(x)是一个映射函数,我们不期望得到H(x)的近似值,而是将其近似为一个残差函数F(x)= H(x)− x。因此,原函数H(x)= F(x)+ x。剩余结构可以简单地写为:

通过递归,可以得到任意深度单元的L个特征的表达式:

其中xl和x~l + 1分别是输入和输出;函数F(x,{Wi~})表示学习的残差映射。对于图1所示的残差块,总共有两层,F = W2σ(W1x),σ是校正线性单位(ReLU)激活函数。

假设优化残差映射比优化期望映射更容易,即更容易优化,则在极端情况下,期望映射将拟合到恒等映射。这类残差网络的主要任务是拟合。普通网络需要拟合的是,前者显然更容易优化。

根据最近的研究结果,如果神经网络的每一层都采用到输入层和输出层的较短连接,则网络结构可以设计得更深更精确,训练也会更有效率。Huang等人基于这一现象提出了一种稠密卷积神经网络(DenseNet),它以前馈的方式将每一层分别连接到其他层。传统的L层卷积网络总共有L个连接,而稠密网的任何一层不仅与相邻层相连,而且与所有后续层直接相连,因此网络有L(L + 1)/ 2个直接连接。Densenet具有以下令人信服的优势:Densenet具有以下令人信服的优势:(1)有效地解决了梯度消失问题;(2)增强了特征传播能力;(3)Densenet将网络中的每一层与上一层直接连接起来,实现了特征的重用;(4)DenseNet将网络的每一层都设计得很窄,即只学习几个特征图。在最极端的情况下,每层仅学习一个特征图可以减少冗余。

方法

Overall process

本文针对医学MR图像SR提出了一种残差稠密网络结构,网络结构如图2所示。网络结构包括三部分:浅层特征提取、剩余密集块和重建模块。

我们使用两个卷积层提取浅层的特性。第一次卷积层提取输入LR图像的特性,表示为:

其中HSF1(·)表示卷积运算,F−1可进一步用于提取浅层特征。因此,F0可通过类推得到:

其中HSF2(·)表示第二特征提取层的卷积运算,特征F0用作具有密集和快速残差的输入。假设我们有D个密集残差块,第d层残差密集块的输入Fd可以表示为:

其中HRDB,d(·)表示第d个剩余稠密块的运算,可以表示为复合函数运算,例如卷积层和ReLU层。最后,所有的特性都可以表示为:

在提取了局部和全局特征之后,我们使用上采样和亚像素卷积层来获得HR图像。

Residual dense module

剩余密集网络结构包括密集连接层和局部特征融合层,如图3所示。

令F−1和Fd分别表示第d个剩余稠密块的输入和输出。然后,第d个残差密集块中的第c个卷积层的输出可以表示为:

其中σ是ReLU激活函数,Wd,c是第c个卷积层的权重。

Multi-residual block

由于卷积神经网络可以提取低、中、高层的不同特征,网络层数越多,提取的特征越丰富。而且,网络越深入,特征越抽象,语义信息越多,但如果简单地增加网络层数,就会造成梯度分散或梯度爆炸。梯度爆炸问题的解决方案是正则化初始化和批量归一化层(BN),这可以使网络深度达到几十层,这种解决方案还会有另一个问题,即退化问题。随着网络层数的增加,训练集的精度会饱和甚至下降,因为虽然深层网络的解空间包含了浅层网络的解空间,但我们在训练网络时通常采用随机梯度下降策略,往往解不是全局最优解,而是局部最优解。显然,深度网络的解空间更加复杂,导致网络的退化。

为了解决这个问题,我们设计了多残差块(MRB),如图4所示,每个MRB包含3个残差块(RB),每个RB包含两个卷积层和ReLU激活层,这种设计是因为深层网络的后面几层都是身份映射,模型退化为浅层网络,而学习身份映射函数就是解决之道。我们不再使用多个堆叠层来直接拟合所需的特征映射,而是使用它们来拟合残差映射。MRB模型不同于普通网络的地方在于跳跃连接的引入,它允许来自前一个残差块的信息无阻碍地流入下一个残差块,因为随着网络的深入,卷积层提取的特征变得更加抽象和精细,图像的全局信息结构丢失,此时可以通过残差学习来补充初始图像特征以改善网络中的图像信息流。它还避免了由于网络太深而导致的梯度消失和性能下降的问题。

本文提出了一种基于残差稠密网络的医学磁共振图像超分辨率重建方法,通过利用残差学习和密集连接来解决梯度消失问题,提高图像特征的传播和重用。实验结果显示,这种方法在多个基准数据集上表现优越,对于2倍、3倍和4倍放大,均能获得清晰的高分辨率图像,具有较高的峰值信噪比和结构相似性指标。

本文提出了一种基于残差稠密网络的医学磁共振图像超分辨率重建方法,通过利用残差学习和密集连接来解决梯度消失问题,提高图像特征的传播和重用。实验结果显示,这种方法在多个基准数据集上表现优越,对于2倍、3倍和4倍放大,均能获得清晰的高分辨率图像,具有较高的峰值信噪比和结构相似性指标。

2446

2446

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?