配置好单机版后,若有需要配置分布式集群可以参考我的这篇博客https://blog.csdn.net/weixin_43729499/article/details/103858637

单机版配置步骤:

1、下载spark安装包

安装包可以到官网上直接下载,不过国外的网下载速度可能会稍微慢,可以考虑换个源来下载

2、对文件进行解压(tar -zxvf XXX),并移动到指定位置

(移动位置命令:mv XXX YYY

XXX就是你的安装包名称,YYY是目的路径)

3、修改配置文件

①、spark-env.sh可以复制一份由spark安装文件自带的配置文件模板spark-env.sh.template并重命名为spark-env.sh;

然后,vim 编辑spark-env.sh,添加以下配置信息:

export SPARK_DIST_CLASSPATH=$(hadoop的路径/hadoop/bin/hadoop classpath)

例如在/home下,则为

export SPARK_DIST_CLASSPATH=$(/home/hadoop/bin/hadoop classpath)

(有了此配置信息,spark才可以把数据存储到Hadoop分布式文件系统HDFS中,并从HDFS读取数据,否则只能读写本地文件系统的数据)

export HADOOP_CONF_DIR=hadoop的路径/hadoop/etc/hadoop

例如在/home下,则为

export HADOOP_CONF_DIR=/home/hadoop/etc/hadoop

export JAVA_HOME=JDK环境变量

例如在/home下,则为

export JAVA_HOME=/home/jdk

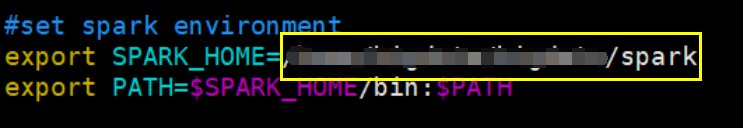

②、编辑 ~/.bashrc或/etc/profile

下面我以~/.bashrc为例,(/etc/profile也是大致相同)

vim 编辑~/.bashrc,添加以下配置信息:

可以在安装包目录下执行

pwd

来查看所在路径

配置好这些信息后,

source ~/.bashrc 使配置文件生效

4、通过运行spark自带的实例SparkPi,验证spark是否安装成功:

进入spark目录下的bin,执行:

./run-example SparkPi

运行程序执行时会输出很多屏幕信息,若要从大量的输出信息中找到我们想要的执行结果,可以使用来:

./run-example SparkPi 2>&1 | grep “Pi is roughly”

1649

1649

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?