1 介绍

年份:2020

期刊: arXiv preprint

引用量:111

本文提出了一种基于残差适配器的架构方法,用于任务型对话系统中的持续学习,通过在预训练的语言模型上添加可训练的适配器参数来实现新任务的学习,同时使用基于困惑度的分类器在测试时选择最合适的适配器。

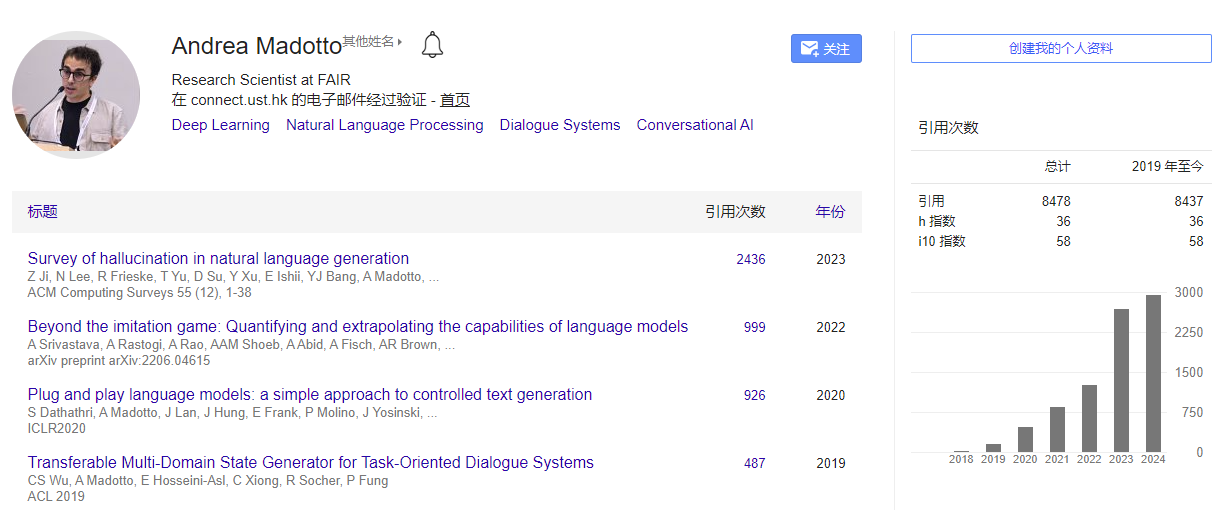

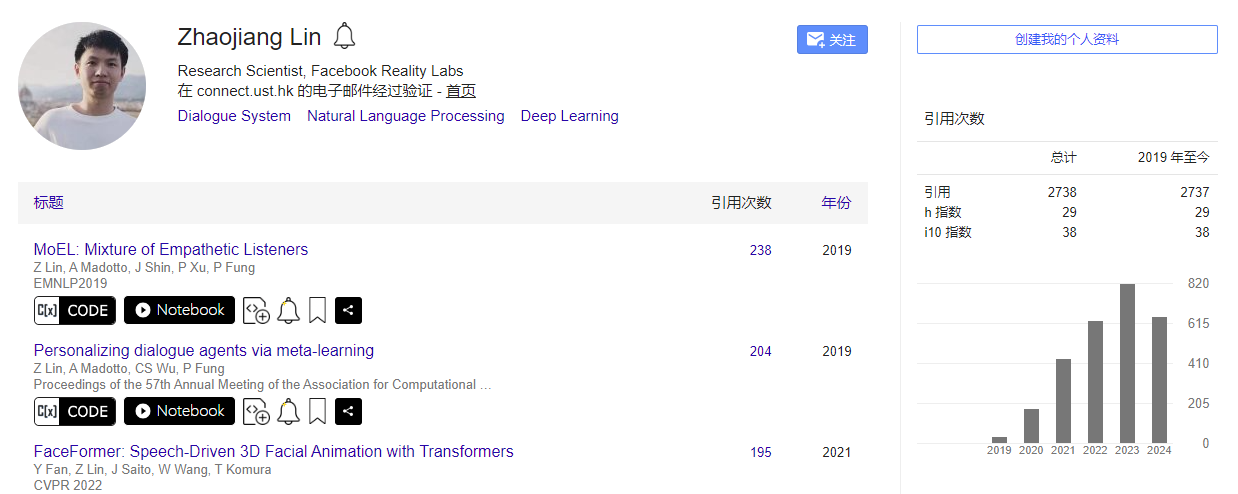

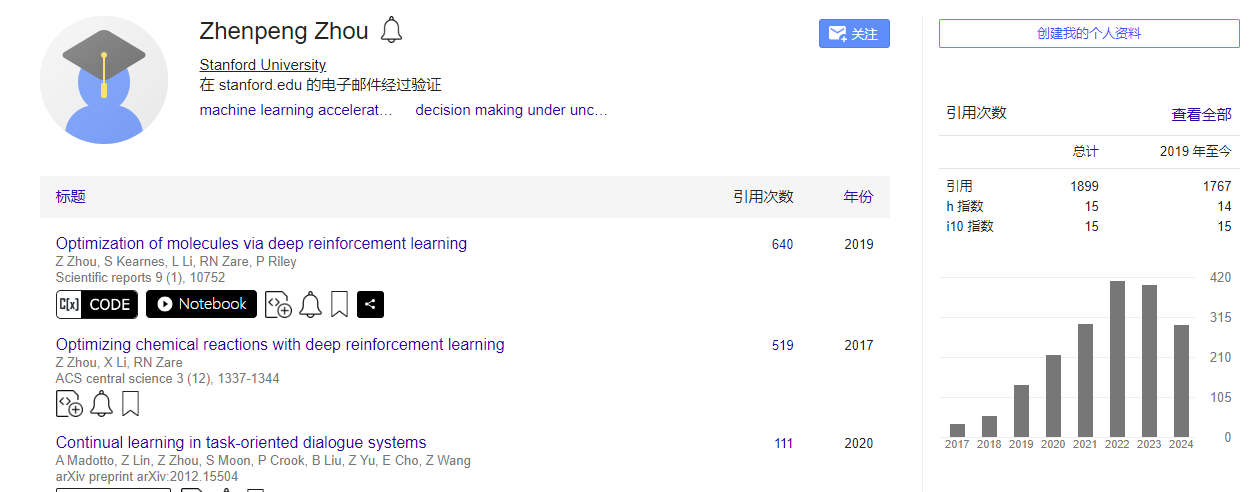

Madotto A, Lin Z, Zhou Z, et al. Continual learning in task-oriented dialogue systems[J]. arXiv preprint arXiv:2012.15504, 2020.

2 创新点

- 首个持续学习基准测试:提出了首个针对任务型对话系统(ToDs)的持续学习基准测试,包含37个不同领域,这些领域在模块化和端到端学习设置中被连续学习。

- 残差适配器架构:提出了一种基于残差适配器的简单而有效的架构方法,该方法可以在测试时不需要任务分类器,即可连续学习新任务。

- 困惑度分类器:提出了一种基于输入序列困惑度的分类器,用于在测试时选择最合适的适配器,以生成输出序列。

- 性能与资源权衡分析:分析了不同持续学习方法在参数使用、内存大小和训练时间方面的权衡,这对于设计任务型对话系统非常重要。

- 与多任务学习性能对比:提出持续学习的性能上限应等同于当所有领域的数据同时可用时的多任务学习性能,并在实验中验证了这一点。

- 高效的新领域学习:实验表明,所提出的架构方法和简单的基于重放的策略在学习新领域时,比其他持续学习技术表现得好很多,且学习速度比多任务学习快20倍。

- 开源基准测试:为了促进这一方向的更多研究,作者发布了所提出的基准测试。

3 相关研究

- 任务型对话系统(ToDs)的持续更新:

- 介绍了任务型对话系统根据用户需求持续更新新功能,例如添加新的槽位(slots)和意图(intents),或完全新的领域。这是通过持续学习(CL)实现的,以减少每次重新训练整个系统所需的高昂成本。

- Sebastian Thrun and Lorien Pratt. 2012. Learning to learn. Springer Science & Business Media.

- 持续学习的方法:

- 提到了三种通常用来克服灾难性遗忘的方法:损失正则化(loss regularization)、重放(rehearsal)和架构方法(architectural methods)。

- 任务型对话系统中的持续学习ÿ

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?