搭建Hadoop单机版

使用的软件或系统

VMware14、CentOS7、Hadoop2.7.3、JDK1.8.0_81

VM与CentOS7可以参考其他的文章搭建起来

温馨提示

创建用户推荐创建你自己的用户并将你加入到sudoers中,避免使用root用户时误操作删除掉一些关键文件,修改配置文件也不需要动profile文件,正常操作的时候也是用普通用户操作。

Hadoop搭建

1、创建用户,创建密码

(1)username是你自己的名字

useradd username

(2)输入密码

passwd username

(3)切换用户,查看是否成功

su username

(4)再切换到root用户

su root

(5)修改/etc/sudoers文件,将用户添加到root用户组

vi /etc/sudoers

找到这一行:root ALL=(ALL) ALL,

在下面添加:username ALL=(ALL) ALL,然后保存退出。

2、配置IP,主要用于用Shell工具连接到系统操作以及传输文件

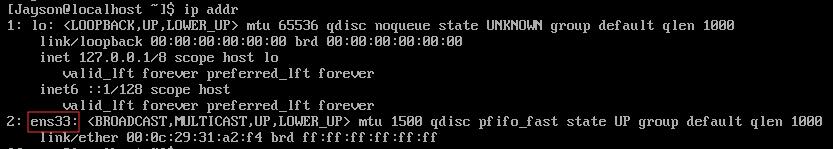

(1)查看IP,发现 ens33 没有 inet 这个属性,那么就没法通过IP地址连接虚拟机

ip addr

(2)给虚拟机配置静态ip,修改配置文件ifcfg-ens33

sudo vi /etc/sysconfig/network-scripts/ifcfg-ens33

修改BOOTPROTO=static #这里将dhcp换成static

修改ONBOOT=yes #将no换成yes

新增:

IPADDR=192.168.1.200 #静态IP,可自定义,不冲突就行

GATEWAY=192.168.1.2 #默认网关

NETMASK=255.255.255.0 #子网掩码

(3)重启网络服务

service network restart

重启之后再用 ip addr 查看

(4)虚拟网络编辑器(修改提供外部访问的IP)

用Windows的cmd工具试一下。

ping 192.168.1.200

(5)关闭防火墙

systemctl stop firewalld.service

关闭开机启动

systemctl disable firewalld.service

3、Shell工具操作系统,推荐使用Xshell与Xftp(家用版)

申请地址:https://www.netsarang.com/zh/free-for-home-school/

申请之后官方会发下载连接到你邮箱,去下载安装就行。

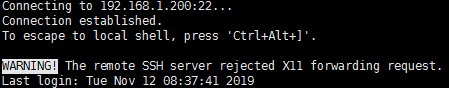

(1)安装了Xshell和Xftp之后打开Xshell,新建会话,输入你的IP,确定之后输入账户密码连接即可。

成功连接!

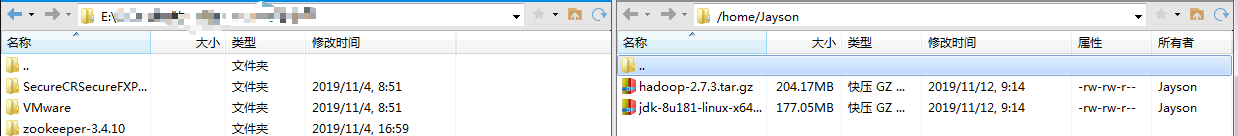

(2)上传JDK和Hadopp,因为我本地下载有,本地传输快,就不在Linux上下载了。

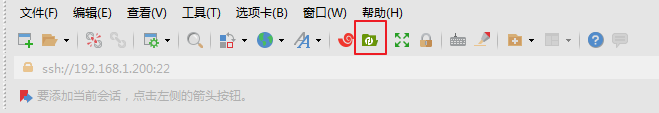

在Xshell上点击Xftp,连接成功后把windows(左侧)的文件拉倒Linux(右侧)即可。

上传成功

我这里也分享一下这两个包吧,避免一些小白们找不到也不会下载

链接:https://pan.baidu.com/s/1rPeArro7UsKSZ2taPeL0rg

提取码:xbnk

4、安装与配置JDK

然后解压JDK到/usr/local,解压之后去/uer/local看看,有jdk文件夹即成功

sudo tar -xzvf jdk-8u181-linux-x64.tar.gz -C /usr/local/

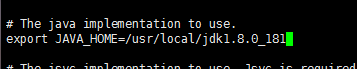

配置JDK,不建议动profile文件,修改用户的.bashrc就好了

vi ~/.bashrc

在末尾添加,并保存

exprot JAVA_HOME=/usr/local/jdk1.8.0_181

export JRE_HOME=${JAVA_HOME}/jre

export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib

export PATH=${JAVA_HOME}/bin:$PATH

刷新一下文件

source ~/.bashrc

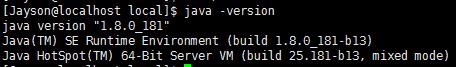

查看JDK版本,成功即可,若未成功,请返回上面仔细核对一下步骤有无错误

java -version

成功

5、安装与配置Hadoop

(1)解压hadoop

sudo tar -xzvf hadoop-2.7.3.tar.gz -C /usr/local/

(2)给修改文件权限,后面步骤需要在该目录建立目录与文件,需要写权限

sudo chmod 757 /usr/local/hadoop-2.7.3/

(3)配置hadoop的java工作环境,修改配置文件hadoop-env.sh。该配置文件在hadoop安装目录的etc/hadoop目录下,找到export JAVA_HOME,并指定java的安装路径

sudo vi /usr/local/hadoop-2.7.3/etc/hadoop/hadoop-env.sh

(4)把hadoop加入到环境变量中

vi ~/.bashrc

export HADOOP_HOME=/usr/local/hadoop-2.7.3

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

更新一下

source ~/.bashrc

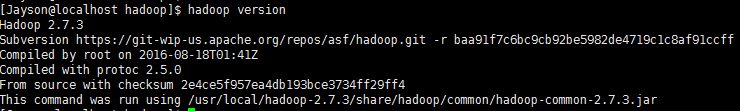

查看版本

hadoop version

5、修改Hadoop配置文件与启动

切换到/usr/local/hadoop-2.7.3/etc/hadoop/目录

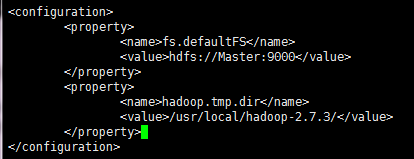

(1)、修改core-site.xml

sudo vi core-site.xml

在 configuration 标签里添加如下内容:

<property>

<name>fs.defaultFS</name>

<value>hdfs://Master:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/hadoop-2.7.3/</value>

</property>

(2)修改mapred-site.xml,先把mapred-site.xml.template复制一份并改名为mapred-site.xml,然后添加内容。

sudo cp mapred-site.xml.template mapred-site.xml

修改mapreduce-site.xml,在 configuration 标签里添加如下内容

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

(3)修改yarn-site.xml,在 configuration 标签里添加如下内容:

<property>

<name>yarn.resourcemanager.hostname</name>

<value>Master</value>

</property>

<property>

<name>yarn.nodemaneger.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

(4)修改hdfs-site.xml,在 configuration 标签里添加如下内容:

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>Master:50090</value>

</property>

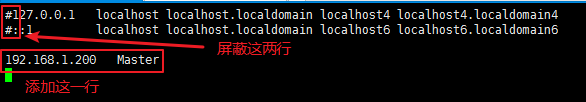

(5)配置IP的静态映射

sudo vi /etc/hosts

(6)配置主机名,因为我们改配置的时候设为了Master,所以改为Master

sudo vi /etc/hostname

删除里面的内容,改为Master

(7)配置免密登录

ssh-keygen -t rsa -P "" -f ~/.ssh/id_rsa

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

chmod 0600 ~/.ssh/authorized_keys

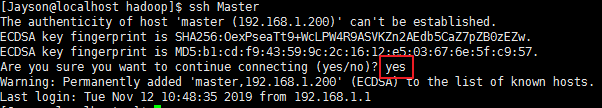

测试一下是否成功

ssh Master

无需密码登录,成功

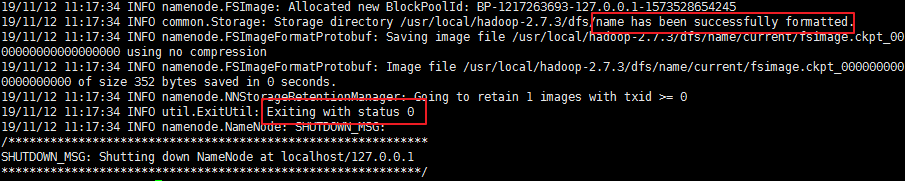

(8)格式化hadoop

hdfs namenode -format

有框内的提示则格式化成功

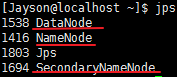

(9)启动HDFS,用 jps命令验证,正确启动会出现NameNode,DataNode,SecondaryNameNode三个进程:

start-dfs.sh

关闭,可以先不关

stop-dfs.sh

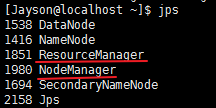

(10)启动yarn,用 jps命令验证,正确启动将出现ResourceManager、NodeManager两个进程:

start-yarn.sh

关闭,可以先不关

stop-yarn.sh

成功!搭建完成!

这样就可以做HDFS的shell命令操作了,具体操作可以参考我的博客:HDFS的Shell操作

注:也可以用 start-all.sh 和 stop-all.sh 启动所有和关闭所有。

1684

1684

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?