面试题汇总

redis知识参考:https://blog.csdn.net/weixin_43994244/category_12071099.html?spm=1001.2014.3001.5482

Redis的使用场景

缓存:穿透,击穿,雪崩,双写一致性,持久化,数据过期,淘汰策略

分布式锁:setnx,redisson

什么是缓存穿透,有什么解决方案?

缓存穿透是指客户端请求的数据在缓存中和数据库中都不存在,这样缓存永远不会生效,这些请求都会打到数据库,不断发起这样的请求,给数据库带来巨大压力。

解决方案有两种:

- 缓存null值

- 优点:实现简单,维护方便

- 缺点:额外的内存消耗(缓存里缓存了很多null,设置TTL),可能造成短期的不一致

- 布隆过滤

- 优点:内存占用较少,没有多余key

- 缺点:实现复杂,存在误判可能

预防方案:

增加id的复杂度,避免被猜测id规律并且做好数据的基础格式校验,

加强用户权限校验

做好热点参数的限流

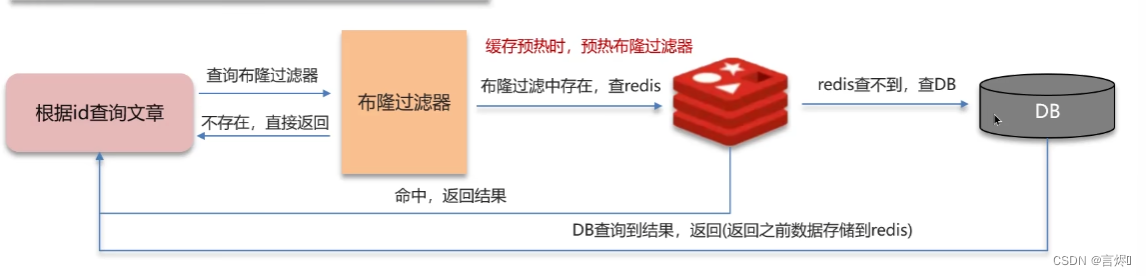

能否介绍一下布隆过滤器布隆过滤器?

布隆过滤器的底层是一个大数组,里面存放二进制0或1,主要是用于检索一个元素是否在一个集合中。我们当时使用的是redisson实现的布隆过滤器。

在一开始都是0,当一个key来了之后经过3次hash计算,模于数组长度找到数据的下标然后把数组中原来的0改为1,这样的话,三个数组的位置就能标明一个key的存在。查找的过程也是一样的。

布隆过滤器有可能会产生一定的误判,一般可以设置这个误判率在5%以内,其实这个误判是必然存在的,5%以内的误判率一般的项目也能接受,不至于高并发下压倒数据库。

什么是缓存击穿 ? 怎么解决 ?

缓存击穿问题也叫热点Key问题,就是一个被高并发访问并且缓存重建业务较复杂的key突然失效了,无数的请求访问会在瞬间给数据库带来巨大的冲击。

解决方案:

第一种使用互斥锁:当线程1发现缓存失效时,先获取一个互斥锁,(如 Redis 的 setnx 去设置一个互斥锁),再查询数据库并重建缓存数据,再释放锁。在其他线程等待线程1 释放锁之后再查询缓存。

第二种方案设置当前key逻辑过期:在写入缓存设置key的时候,同时写入一个字段为过期时间,不给当前key设置过期时间。当查询时,从redis取出数据后判断时间是否过期,如果过期则开通另外一个线程进行数据同步,当前线程正常返回数据,这个数据不是最新的。

如果选择数据的强一致性,建议使用分布式锁的方案,性能上可能没那么高,锁需要等,也有可能产生死锁的问题

如果选择key的逻辑删除,则优先考虑的高可用性,性能比较高,但是数据同步这块做不到强一致,会有额外内存消耗,实现复杂。

什么是缓存雪崩 ? 怎么解决 ?

缓存雪崩是指在同一时段大量的缓存key同时失效或者Redis服务宕机,导致大量请求到达数据库,带来巨大压力。

解决方案:

给不同的Key的TTL添加随机值(同一时段大量的缓存key同时失效)

利用Redis集群提高服务的可用性(Redis服务宕机)

给缓存业务添加降级限流策略(提前做好容错处理,服务降级,快速失败,牺牲部分服务,保护数据库)(降级可作为系统的保底策略,适用于穿透,击穿,雪崩)

给业务添加多级缓存?

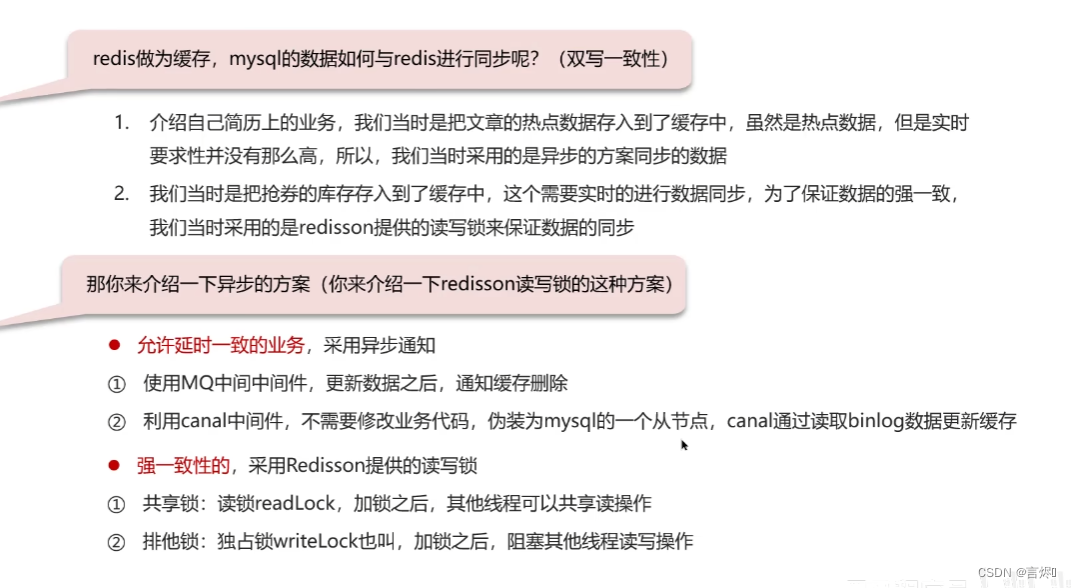

redis做为缓存,mysql的数据如何与redis进行同步呢?(双写一致性)

redis读操作:缓存命中,直接返回,缓存未命中查询数据库,写入缓存,设定超时时间。

redis写操作:延迟双删:删除缓存,修改数据库,延时删除缓存(也有脏数据风险)。

回答1:嗯!就说我最近做的这个项目,里面有xxxx(根据自己的简历上写)的功能,数据同步可以有一定的延时(符合大部分业务)

我们当时采用的阿里的canal组件实现数据同步:不需要更改业务代码,部署一个canal服务。canal服务把自己伪装成mysql的一个从节点,当mysql数据更新以后,canal会读取binlog数据,然后在通过canal的客户端获取到数据,更新缓存即可。

回答2:嗯!就说我最近做的这个项目,里面有xxxx(根据自己的简历上写)的功能,需要让数据库与redis高度保持一致,因为要求时效性比较高,我们当时采用的读写锁保证的强一致性。

我们采用的是redisson实现的读写锁,在读的时候添加共享锁,可以保证读读不互斥,读写互斥。当我们更新数据的时候,添加排他锁,它是读写,读读都互斥,这样就能保证在写数据的同时是不会让其他线程读数据的,避免了脏数据。需要注意的是读方法和写方法上需要使用同一把锁才行。

那排他锁是如何保证读写、读读互斥的呢?

排他锁底层使用也是setnx,保证了同时只能有一个线程操作锁住的方法

你听说过延时双删吗?为什么不用它呢?

延迟双删,如果是写操作,我们先把缓存中的数据删除,然后更新数据库,最后再延时删除缓存中的数据,其中这个延时多久不太好确定,在延时的过程中可能会出现脏数据,并不能保证强一致性,所以没有采用它。

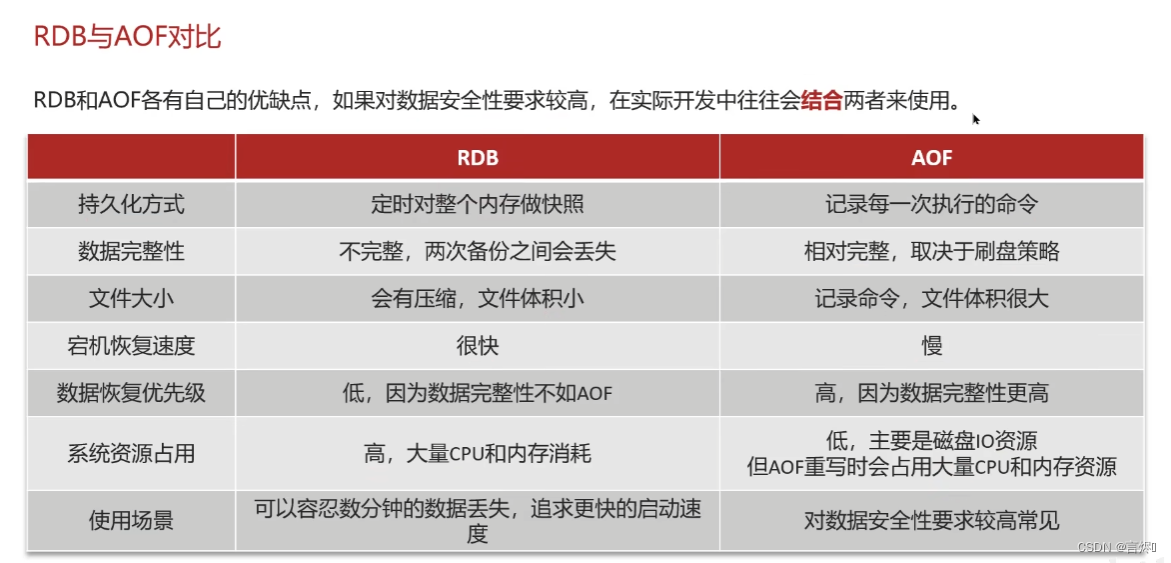

redis做为缓存,数据的持久化是怎么做的?

在Redis中提供了两种数据持久化的方式:1、RDB 2、AOF

- RDB是一个快照文件,它是把redis内存存储的数据写到磁盘上,当redis实例宕机恢复数据的时候,方便从RDB的快照文件中恢复数据。save命令是由redis主进程来执行DB,会阻塞所有命令,bgsave命令会开启子进程来执行RDB,避免主进程收到影响

redis.conf文件中也有内部触发RDB的机制。 - AOF的含义是追加文件,当redis操作写命令的时候,都会存储这个文件中,当redis实例宕机恢复数据的时候,会从这个文件中再次执行一遍命令来恢复数据。

RDB执行原理是什么?

注意:进程无法直接修改物理内存,通过操作虚拟内存,虚拟内存基于页表的隐射关联到物理内存真正的存储数据的位置,实现对物理内存读和写的操作。

答:bgsave开始时会fork(克隆)主进程得到子进程,将主进程的页表数据copy给子进程,因为映射关系相同,子进程在操作自己的虚拟内存时,最终一定会映射到相同的物理内存,这样阻塞时间尽可能的缩短了(不用复制虚拟内存),子进程将读到的数据写入新的RDB文件替换旧的RDB文件。

为了避免脏数据,fork采用的是copy-on-write技术:

首先在fork时会将共享的数据标记为read-only,只可以读。当主进程执行写操作时,先拷贝一份数据,再执行写读的操作,页表映射也会映射到拷贝后的数据上。

这两种方式,哪种恢复的比较快呢?

RDB因为是二进制文件,在保存的时候体积也是比较小的,它恢复的比较快,但是它有可能会丢数据,我们通常在项目中也会使用AOF来恢复数据,虽然AOF恢复的速度慢一些,但是它丢数据的风险要小很多,在AOF文件中可以设置刷盘策略,我们当时设置的就是每秒批量写入一次命令。

Redis的数据过期策略有哪些 ?

- 惰性删除,在设置该key过期时间后,我们不去管它,当访问该key时,我们再检查其是否过期,如果过期,我们就删掉它,反之返回该key。

- 优点:对CPU友好,只会在使用该key时才会进行过期检查,对于很多用不到的key不用浪费时间进行过期检查。

- 缺点:对内存不友好,如果一个key已经过期,但是一直没有使用,那该key就会一直存在内存中,不会释放。

- 定期删除,就是说每隔一段时间,就对一些key进行检查,删除里面过期的key(从一定数量里的数据库中取出一定数量的随机key进行检查,并删除其中的过期key)

- 优点:可以通过限制删除操作执行的时长和频率来减少删除操作对CPU的影响。另外定期删除,也能有效释放过期键占用的内存

- 缺点:难以确定删除操作执行的时长和频率

定期删除的两种模式:

- SLOW模式是定时任务,执行频率默认为10hz,每次不超过25ms(尽量少的影响主进程),以通过修改配置文件redis.conf 的 hz 选项来调整这个次数

- FAST模式执行频率不固定,每次事件循环会尝试执行,但两次间隔不低于2ms,每次耗时不超过1ms

Redis的过期删除策略:惰性删除 + 定期删除两种策略进行配合使用。

Redis的数据淘汰策略有哪些 ?

在Redis中的内存不够用时,读命令还可以正常返回,再添加新的key时,redis会按照某一种规则将内存数据删除掉,这种规则就是内存的淘汰策略。

- 默认是noeviction,不删除任何数据,不允许写入新的数据,内部不足直接报错

- volatile-ttl,对设置TTL的key,比较key的剩余TTL值,数值小的先淘汰

- allkeys-random:对全体key,随机淘汰

- volatile-random:对设置TTL的key,进行随机淘汰

- allkeys-lru:对全体key,基于LRU算法进行淘汰

- volatile-lru:对设置了TTL嗯对key,进行LRU算法进行淘汰

- allkeys-lfu:对全体key,基于LFU算法进行淘汰

- volatile-lfu:对设置了TTL的ey,进行LFU算法进行淘汰

LRU: 根据数据最近被访问的时间进行淘汰,即淘汰最久未被访问的数据。

LFU: 根据数据的访问频率进行淘汰,即淘汰访问频率低的数据。

使用建议:

如果业务有明显的冷热数据区分,优先设置allkeys-lru,挑选最近最少使用的数据淘汰,把一些经常访问的key留在redis中。

如果业务中数据访问频率差别不大,没有明显冷热数据区分,建议使用allkeys-random,随机淘汰。

如果业务中有置顶的需求,可以使用volatile-lru策略,同事置顶数据不设置过期时间,这些数据就一直不被删除,会淘汰其他设置过期时间的数据。

如果业务中有短时高频访问的数据,可以使用allkeys-lfu或volatile-lfu策略

数据库有1000万数据 ,Redis只能缓存20w数据, 如何保证Redis中的数据都是热点数据 ?

可以使用 allkeys-lru (挑选最近最少使用的数据淘汰)淘汰策略,那留下来的都是经常访问的热点数据

Redis的内存用完了会发生什么?

需要看redis的数据淘汰策略是什么,如果是默认的配置,redis内存用完以后则直接报错。我们当时设置的 allkeys-lru 策略。把最近最常访问的数据留在缓存中。

Redis分布式锁

分布式锁使用场景:集群情况下的定时任务,抢单,幂等性场景

Redis分布式锁如何实现 ?

在抢优惠券的业务中使用redisson实现的分布式锁,底层是setnx(由于redis的单线程的,用了setnx之后,只能有一个客户端对某一个key设置值,在没有过期或删除key的时候是其他客户端是不能设置这个key的)和lua脚本(保证原子性)来实现的。

那如何控制Redis实现分布式锁有效时长呢?

在redisson中需要手动加锁,并且可以控制锁的失效时间和等待时间,当锁住的一个业务还没有执行完成的时候,在redisson中引入了一个看门狗机制,就是说每10s就检查当前业务是否还持有锁,如果持有就增加加锁的持有时间,当业务执行完成之后需要使用释放锁就可以了

还有一个好处就是,在高并发下,一个业务有可能会执行很快,先客户1持有锁的时候,客户2来了以后并不会马上拒绝,它会自旋不断尝试获取锁,如果客户1释放之后,客户2就可以马上持有锁,性能也得到了提升。

redisson实现的分布式锁是可重入的吗?

是可以重入的,这样做是为了避免死锁的产生。这个重入其实在内部就是判断是否是当前线程持有的锁,如果是当前线程持有的锁就会计数,如果释放锁就会在计算上减一。在存储数据的时候采用的hash结构,大key是锁名称,其中小key是当前线程的唯一标识,value是当前线程重入的次数

redisson实现的分布式锁能解决主从一致性的问题吗

候选人:这个是不能的,比如,当线程1加锁成功后,master节点数据会异步复制到slave节点,此时当前持有Redis锁的master节点宕机,slave节点被提升为新的master节点,假如现在来了一个线程2,再次加锁,会在新的master节点上加锁成功,这个时候就会出现两个节点同时持有一把锁的问题。

可以利用redisson提供的红锁来解决这个问题,它的主要作用是,不能只在一个redis实例上创建锁,应该是在多个redis实例上创建锁,并且要求在大多数redis节点上都成功创建锁,红锁中要求是redis的节点数量要过半。这样就能避免线程1加锁成功后master节点宕机导致线程2成功加锁到新的master节点上的问题了。

但是,如果使用了红锁,因为需要同时在多个节点上都添加锁,性能就变的很低了,并且运维维护成本也非常高,所以,我们一般在项目中也不会直接使用红锁,并且官方也暂时废弃了这个红锁,如果业务非要保证数据的强一致性,建议使用zookeeper实现的分布式锁,它是可以保证强一致性的。

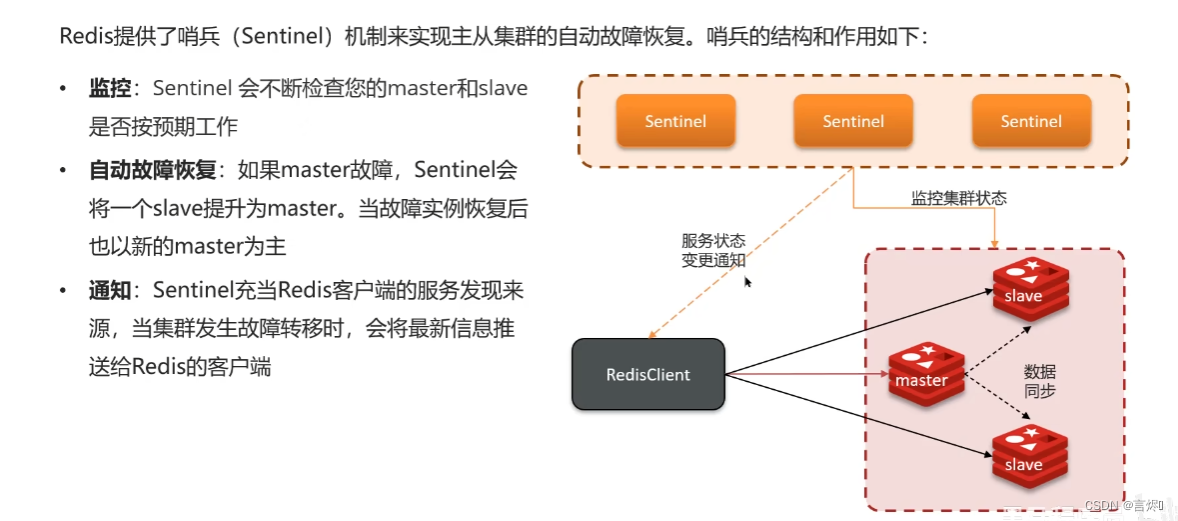

Redis集群有哪些方案?

Redis中提供的集群方案总共有三种:主从复制、哨兵模式、Redis分片集群

介绍一下主从同步

单节点Redis的并发能力是有上限的,要进一步提高Redis的并发能力,可以搭建主从集群,实现读写分离。一般都是一主多从,主节点负责写数据,从节点负责读数据,主节点写入数据之后,需要把数据同步到从节点中。

主从同步数据的流程

主从同步分为了两个阶段,一个是全量同步,一个是增量同步

全量同步是指从节点第一次与主节点建立连接的时候使用全量同步,流程是这样的:

第一:从节点请求主节点同步数据,其中从节点会携带自己的replication id和offset偏移量。

第二:主节点判断是否是第一次请求,主要判断的依据就是,主节点与从节点是否是同一个replication id,如果不是,就说明是第一次同步,那主节点就会把自己的replication id和offset发送给从节点,让从节点与主节点的信息保持一致。

第三:在同时主节点会执行bgsave,生成rdb文件后,发送给从节点去执行,从节点先把自己的数据清空,然后执行主节点发送过来的rdb文件,这样就保持了一致

当然,如果在rdb生成执行期间,依然有请求到了主节点,而主节点会以命令的方式记录到缓冲区,缓冲区是一个日志文件repl_backlog,最后把这个日志文件发送给从节点,这样就能保证主节点与从节点完全一致了,后期再同步数据的时候,都是依赖于这个日志文件,这个就是全量同步

replication id是数据集的标记,id一致则说明是同一数据集,每个master都有唯一的replication id,slave则会继承master节点的replication id

offset是偏移量,随着记录在repl_backlog中的数据增多而主键增大。slave完成同步时也会记录当前同步的offset。如果slave的offset小于master的offset,说明slave的数据落后与master,需要更新。

增量同步当从节点服务重启之后或后期数据变化之后,数据就不一致了,所以这个时候,从节点会请求主节点同步数据,主节点还是判断不是第一次请求,不是第一次就获取从节点的offset值,然后主节点从命令日志中获取offset值之后的数据,发送给从节点进行数据同步。

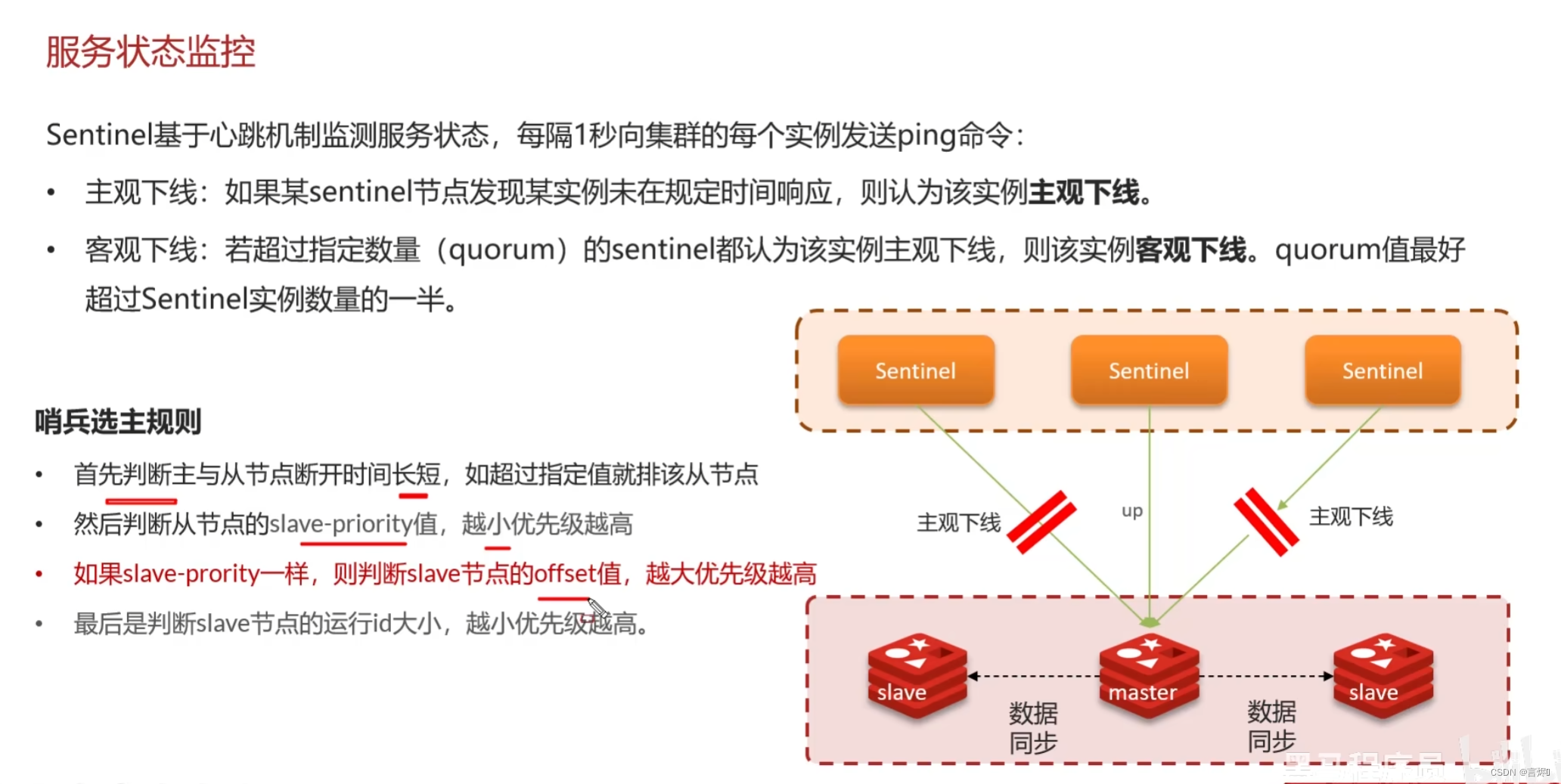

怎么保证Redis的高并发高可用?

首先可以搭建主从集群,再加上使用redis中的哨兵模式,哨兵模式可以实现主从集群的自动故障恢复,里面就包含了对主从服务的监控、自动故障恢复、通知;如果master故障,Sentinel会将一个slave提升为master。当故障实例恢复后也以新的master为主;同时Sentinel也充当Redis客户端的服务发现来源,当集群发生故障转移时,会将最新信息推送给Redis的客户端,所以一般项目都会采用哨兵的模式来保证redis的高并发高可用。

你们使用redis是单点还是集群,哪种集群?

我们当时使用的是主从(1主1从)加哨兵。一般单节点不超过10G内存,如果Redis内存不足则可以给不同服务分配独立的Redis主从节点。尽量不做分片集群。因为集群维护起来比较麻烦,并且集群之间的心跳检测和数据通信会消耗大量的网络带宽,也没有办法使用lua脚本和事务。

redis集群脑裂,该怎么解决呢?

这个在项目很少见,不过脑裂的问题是这样的,我们现在用的是redis的哨兵模式集群,有的时候由于网络等原因可能会出现脑裂的情况,就是说,由于redis master节点和redis salve节点和sentinel处于不同的网络分区,使得sentinel没有能够心跳感知到master,所以通过选举的方式提升了一个salve为master,这样就存在了两个master,就像大脑分裂了一样,这样会导致客户端还在old master那里写入数据,新节点无法同步数据,当网络恢复后,sentinel会将old master降为salve,这时再从新master同步数据,这会导致old master中的大量数据丢失。

关于解决的话,我记得在redis的配置中可以设置:第一可以设置最少的salve节点个数,比如设置至少要有一个从节点才能同步数据,第二个可以设置主从数据复制和同步的延迟时间,如果达不到要求就拒绝客户端请求,就可以避免大量的数据丢失。

redis的分片集群有什么作用

主从和哨兵解决高可用,高并发的问题,分片集群解决海量数据存储和高并发写的问题。

候选人:分片集群主要解决的是,海量数据存储的问题,集群中有多个master,每个master保存不同数据(解决海量存储和高并发写的问题),并且还可以给每个master设置多个slave节点(解决高并发读),就可以继续增大集群的高并发能力。同时每个master之间通过ping监测彼此健康状态,就类似于哨兵模式了。当客户端请求可以访问集群任意节点,最终都会被转发到正确节点。

Redis分片集群中数据是怎么存储和读取的?

Redis 集群引入了哈希槽的概念,有 16384 个哈希槽,集群中每个主节点绑定了一定范围的哈希槽范围, 读写数据时,根据key的有效部分(如果key前有大括号,大括号的内容就是有小部分,如果没有,key本身作为有效部分)计算哈希值后对 16384 取模来决定放置哪个槽,通过槽找到对应的节点进行存储。取值的逻辑是一样的。

Redis是单线程的,但是为什么还那么快?

1、redis是纯内存操作,执行速度非常快

2、采用单线程,避免不必要的上下文切换,多线程还要考虑线程安全问题

3、使用多路I/O复用模型,非阻塞IO

例如:bgsave 和 bgrewriteaof 都是在后台执行操作,不影响主线程的正常使用,不会产生阻塞

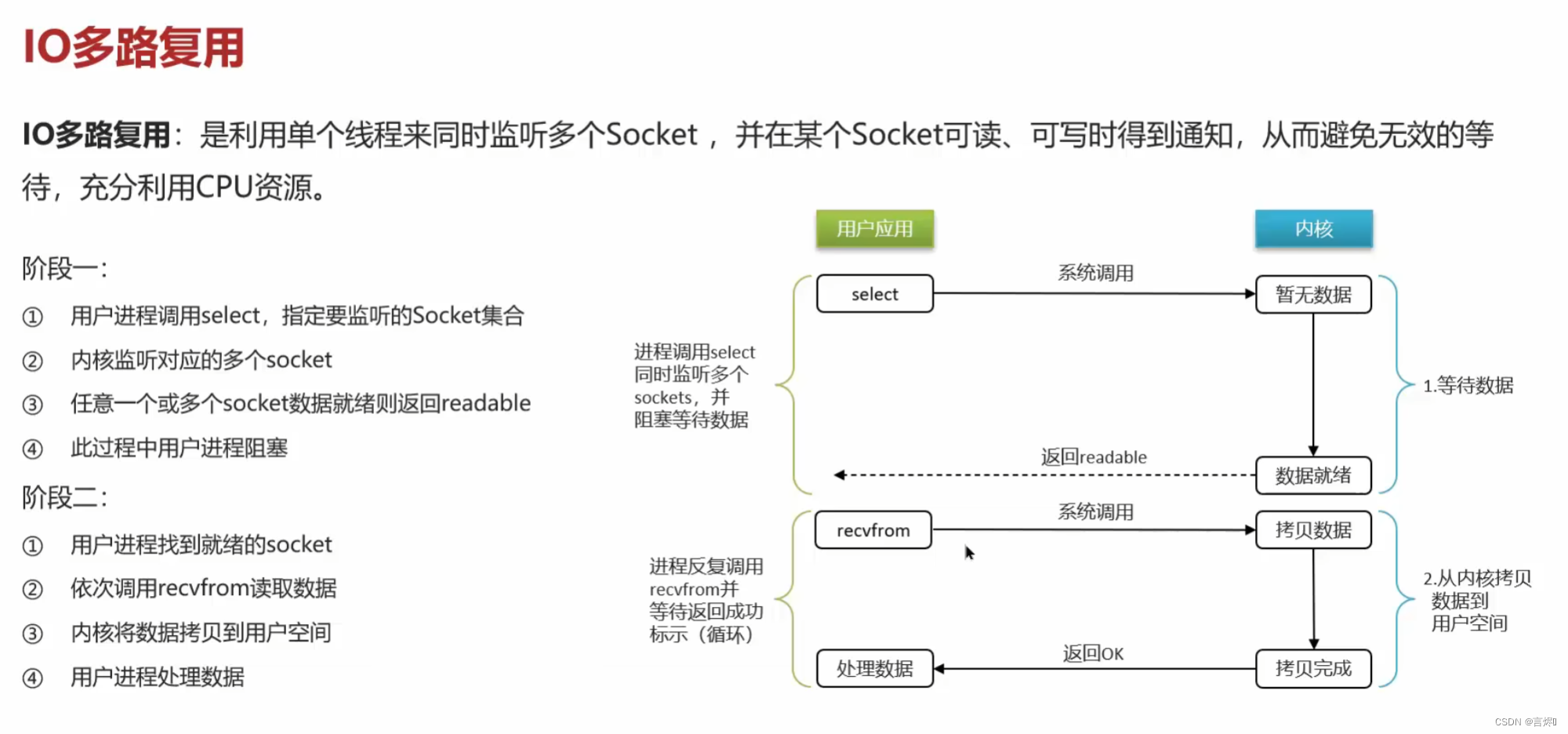

能解释一下I/O多路复用模型?

Redis是纯内存操作,执行速度非常快,它的性能瓶颈是网络延迟而不是执行速度,I/O多路复用模型主要是实现了高效的网络请求。

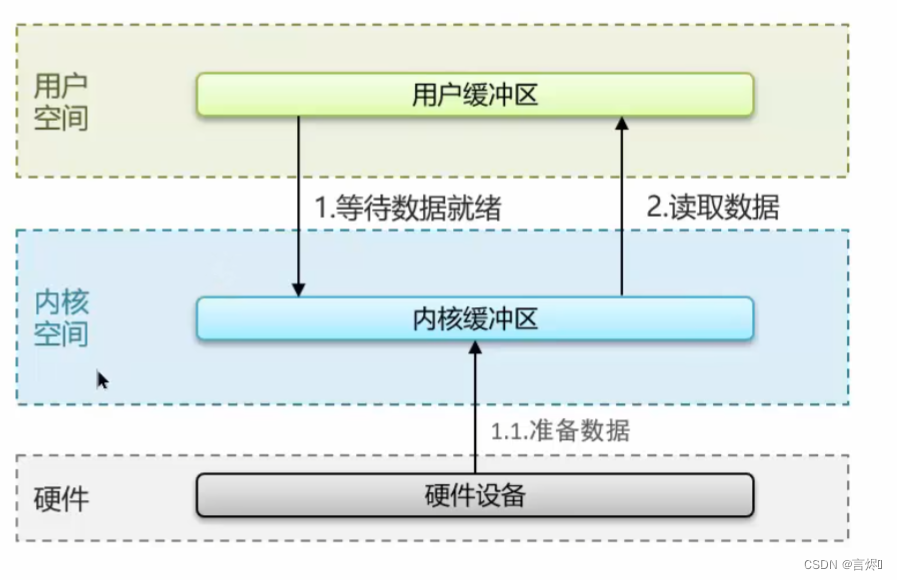

linux系统中一个进程使用的内存情况分为:用户空间和内核空间

用户空间:权限较小,不能直接调用系统资源,必须通过内核提供的接口来访问

内核空间:可以执行特权命令,调用一切系统资源

Linux为了提供IO效率,会在用户空间和内核空间都加入缓冲区:

写数据时,要把用户缓冲区数据拷贝到内核缓冲区,然后写入设备

读数据时,要从设备读取数据到内核缓冲区,然后拷贝到用户缓冲区

常见的IO模型:

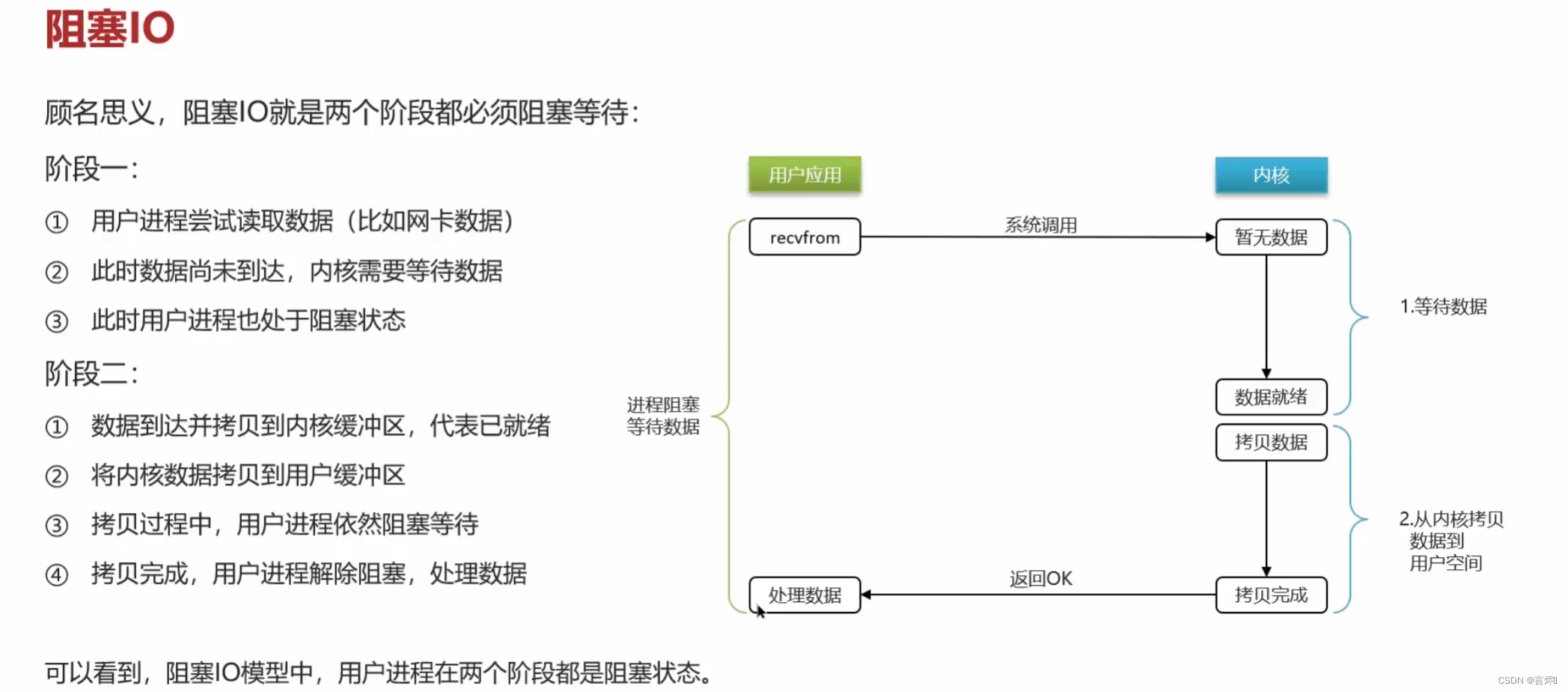

阻塞IO:

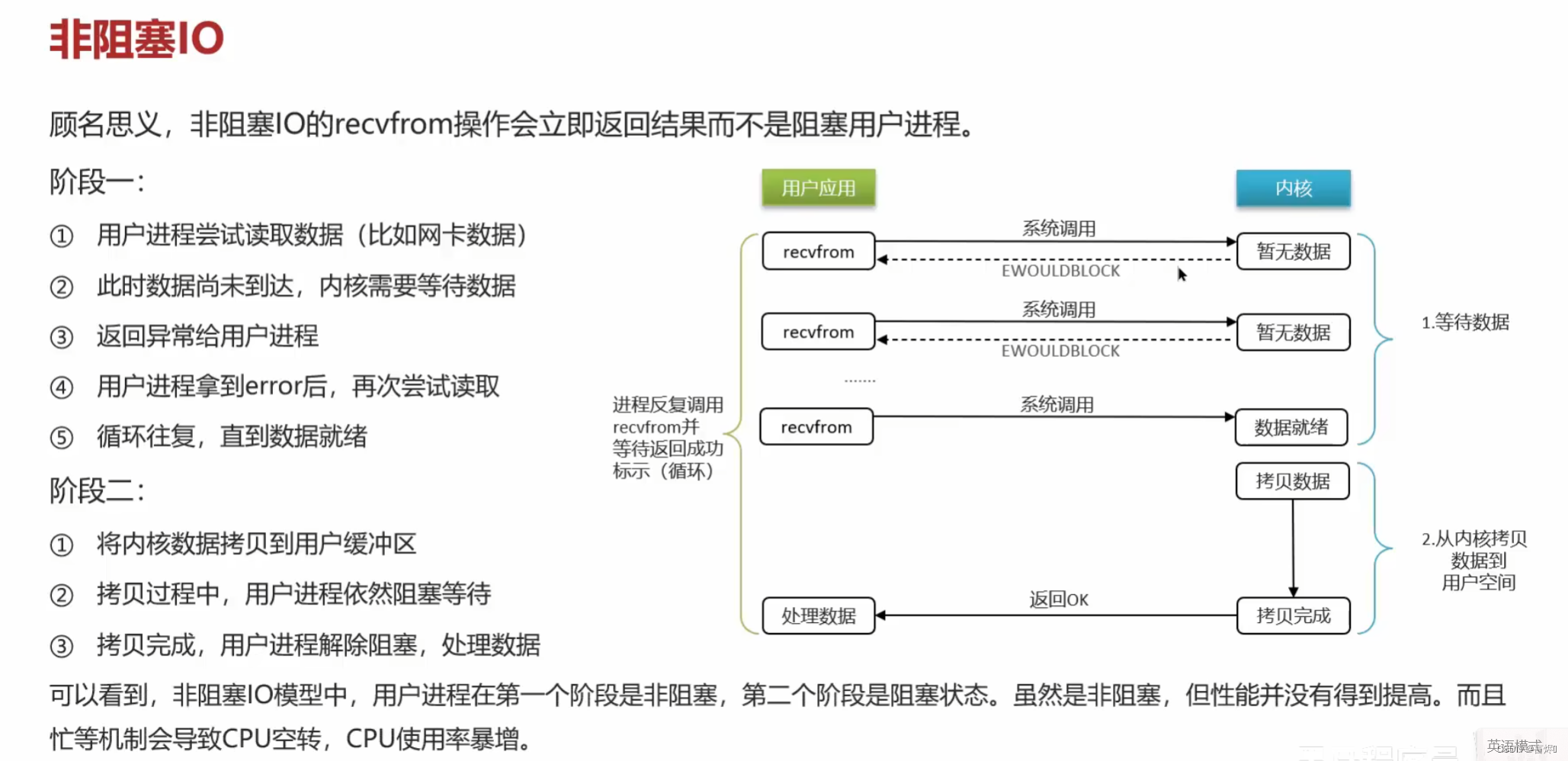

非阻塞IO

IO多路复用

答:I/O多路复用是指利用单个线程来同时监听多个Socket ,并在某个Socket可读、可写时得到通知,从而避免无效的等待,充分利用CPU资源。目前的I/O多路复用都是采用的epoll模式实现,它会在通知用户进程Socket就绪的同时,把已就绪的Socket写入用户空间,不需要挨个遍历Socket来判断是否就绪,提升了性能。

其中Redis的网络模型就是使用I/O多路复用结合事件的处理器来应对多个Socket请求,比如,提供了连接应答处理器、命令回复处理器,命令请求处理器;

在Redis6.0之后,为了提升更好的性能,在命令回复处理器使用了多线程来处理回复事件,在命令请求处理器中,将命令的转换使用了多线程,增加命令转换速度,在命令执行的时候,依然是单线程

20万+

20万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?