1. 修改huggingface默认的模型下载路径

也可以不修改,不修改默认下载在c盘/用户/xxx/.cache,但模型都很大。

新增用户环境变量变量 HF _HOME 和 HUGGINGFACE_HUB_CACHE,自己选择cache存储地

如果修改成功,下载的时候给出的一堆英文里,是会有你自己写的这个地址的。

2.配置升级

之前 cuda=11.1 pytorch=1.8.0 python=3.7 => cuda=11.8 pytorch2.0 python=3.9

关于cuda的升级:先卸载之前的,再nvidia-smi查询自己电脑GPU能安装的最大版本cuda version(右上角这个),再去官网下载对应版本,pytorch2应该是要求cuda11.7或者11.8

然后在pytorch官网找到安装命令:pip和conda哪个能用就用哪个

conda创建环境py39环境,激活环境,在里面下载pytorch2。(pytorch1.x似乎不行,有一个函数好像没有会报错),而pytorch2似乎又要求高版本python,之前的3.7不行。

conda create -n 名字 python=3.9

conda activate 名字

conda install pytorch torchvision torchaudio pytorch-cuda=11.8 -c pytorch -c nvidiapip和conda都有可能报错,有可能网络不行,需要更换源,或者翻出去。我是出去用conda下的。

也有可能版本和环境等不匹配(但按照上面这个步骤新建py39环境,使用对应版本的cuda和pytorch应该是不会有不匹配问题)

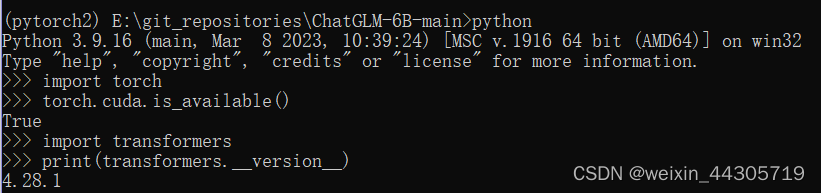

验证是否成功:

3.下载运行

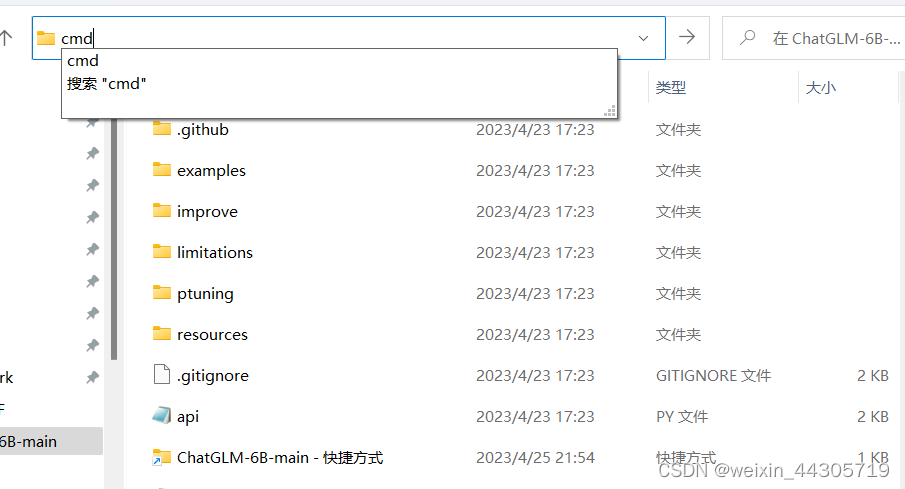

git上下载下包,在对应文件夹下运行cmd,进入之后运行web_demo.py

报错的时候,缺啥下载啥,完了电脑可以的话,应该就能去web界面了。

4.在colab部署GHATGLM

但之后捏,因为我电脑不行,按照官方的要求:

所以,,,之后我就搬到了云端,用了google colab,其中有免费GPU可以用,能跑起来int4。其他要求高的应该需要colab会员才能带动。

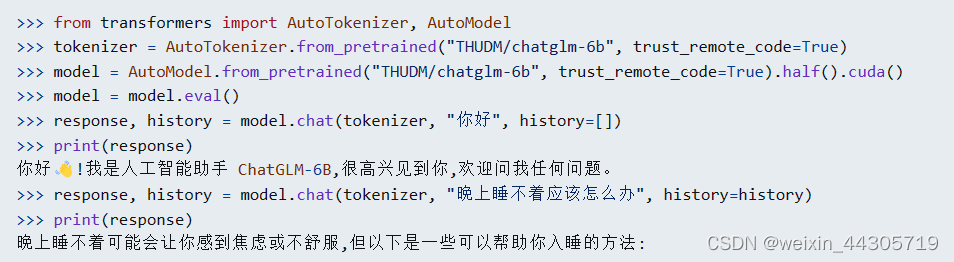

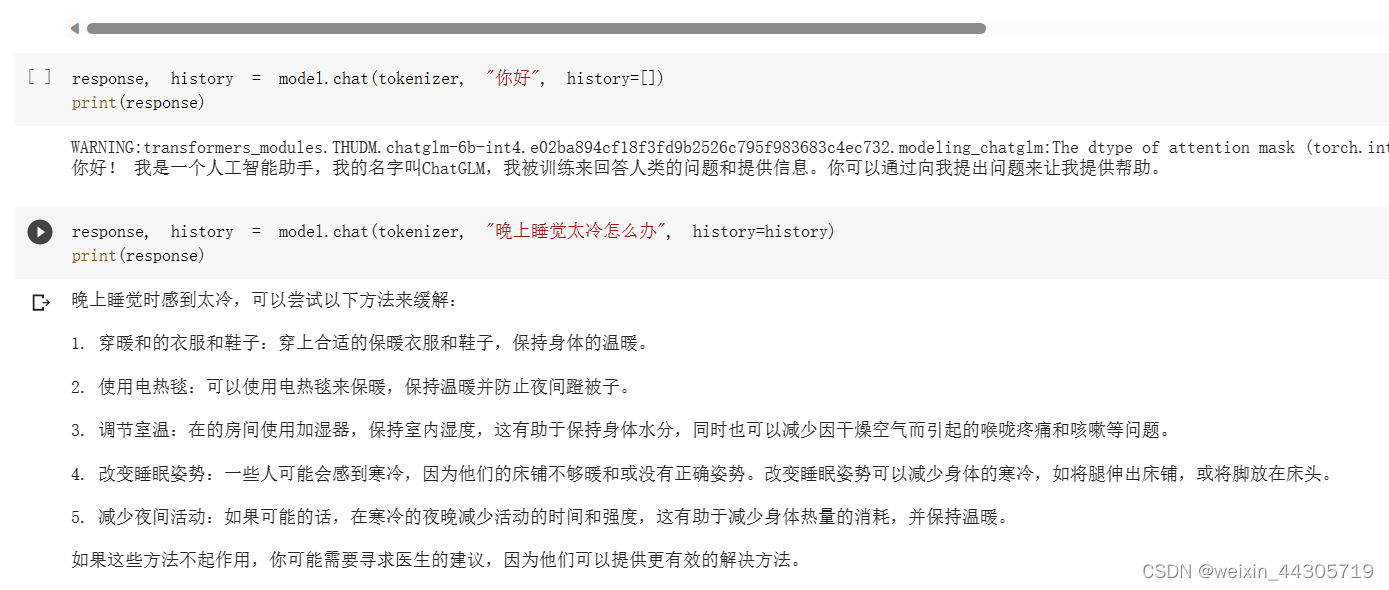

按照官网指示运行这些命令,在ipython界面交互了。

这里修改了huggingface的模型下载路径,加一个cache_dir,下在谷歌drive里。之后可以从这个路径读取模型。

有一个坑是需要自己打开GPU运行模式,否则cuda不可用,模型起不来。

验证一下,满足了在下载:

结果如下:

773

773

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?