目录

1、Hadoop 运行模式

Hadoop 官方网站:http://hadoop.apache.org/

Hadoop

运行模式包括:

本地模式

、

伪分布式模式

以及

完全分布式模式

。

➢

本地模式

:单机运行,只是用来演示一下官方案例。

生产环境不用。

➢

伪分布式模式:

也是单机运行,但是具备

Hadoop

集群的所有功能,一台服务器模

拟一个分布式的环境。

个别缺钱的公司用来测试,生产环境不用。

➢

完全分布式模式:

多台服务器组成分布式环境。

生产环境使用。

2、完全分布式运行模式(开发重点)

分析:

1

)准备

3

台客户机(

关闭防火墙、静态

IP

、主机名称

)

2

)安装

JDK

3

)配置环境变量

4

)安装

Hadoop

5

)配置环境变量

6

)配置集群

7

)单点启动

8

)配置

ssh

9

)群起并测试集群

3、编写集群分发脚本xsync

3.1 scp(secure copy)安全拷贝

(1)

scp

定义

scp 可以实现服务器与服务器之间的数据拷贝。(from server1 to server2)

(2)基本语法

scp -r $pdir/$fname $user@$host:$pdir/$fname

命令

递归

要拷贝的文件路径/名称

目的地用户@

主机

:

目的地路径

/

名称

(3) 案例实操

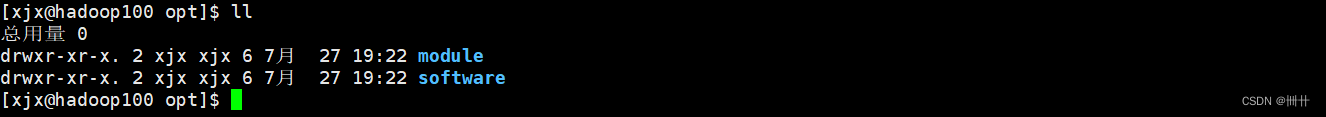

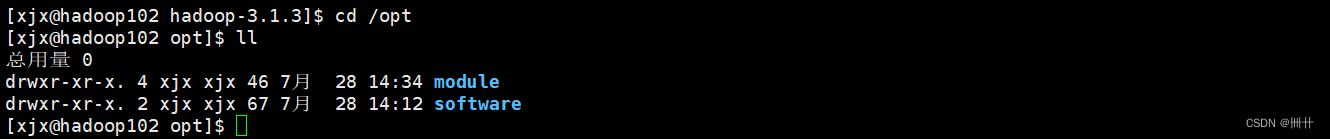

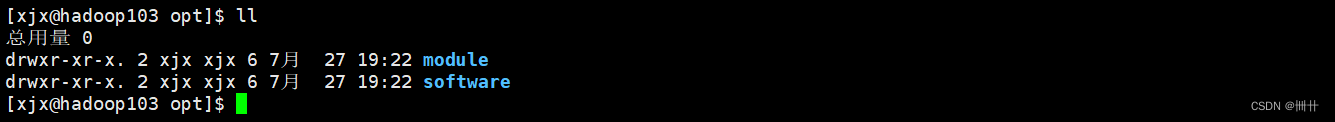

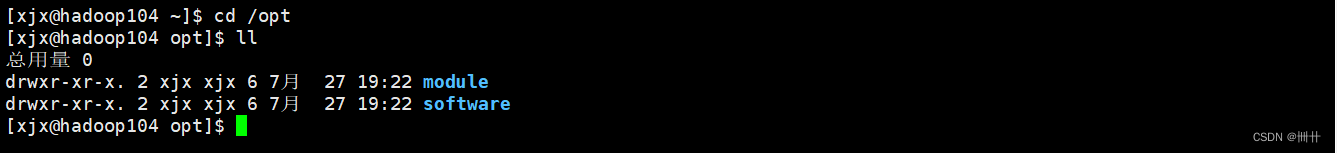

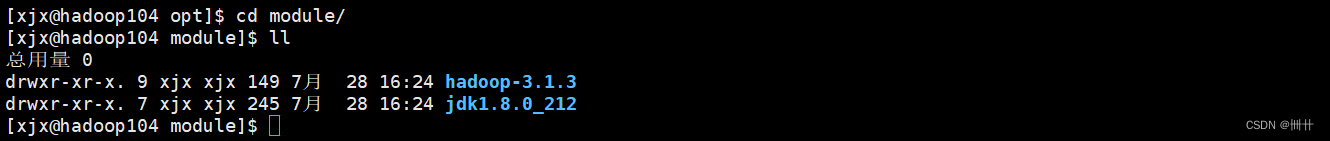

前提:在 hadoop102 、 hadoop103 、 hadoop104 都已经创建好的 /opt/module 、/opt/software 两个目录,并且已经把这两个目录修改为 xjx:xjxsudo chown xjx:xjx-R /opt/module

hadoop100

hadoop102

hadoop102

hadoop103

hadoop104

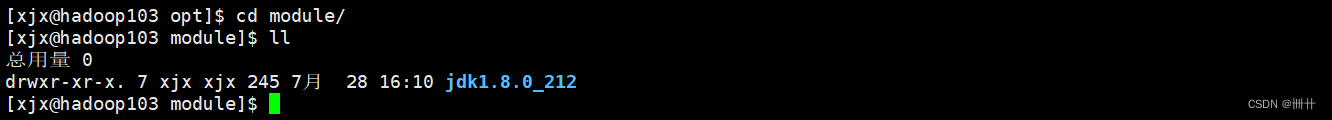

(a)在

hadoop102

上,将

hadoop102

中

/opt/module/jdk1.8.0_212

目录拷贝到

hadoop103

上。

scp -r /opt/module/jdk1.8.0_212 xjx@hadoop103:/opt/module

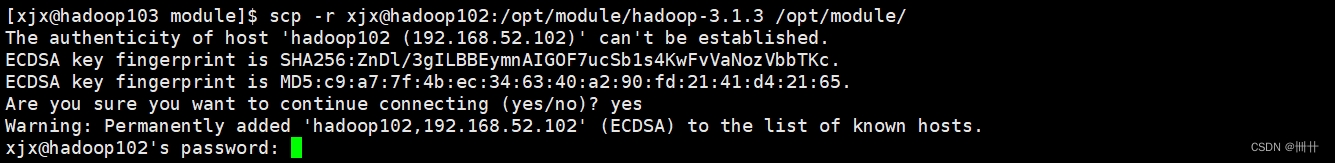

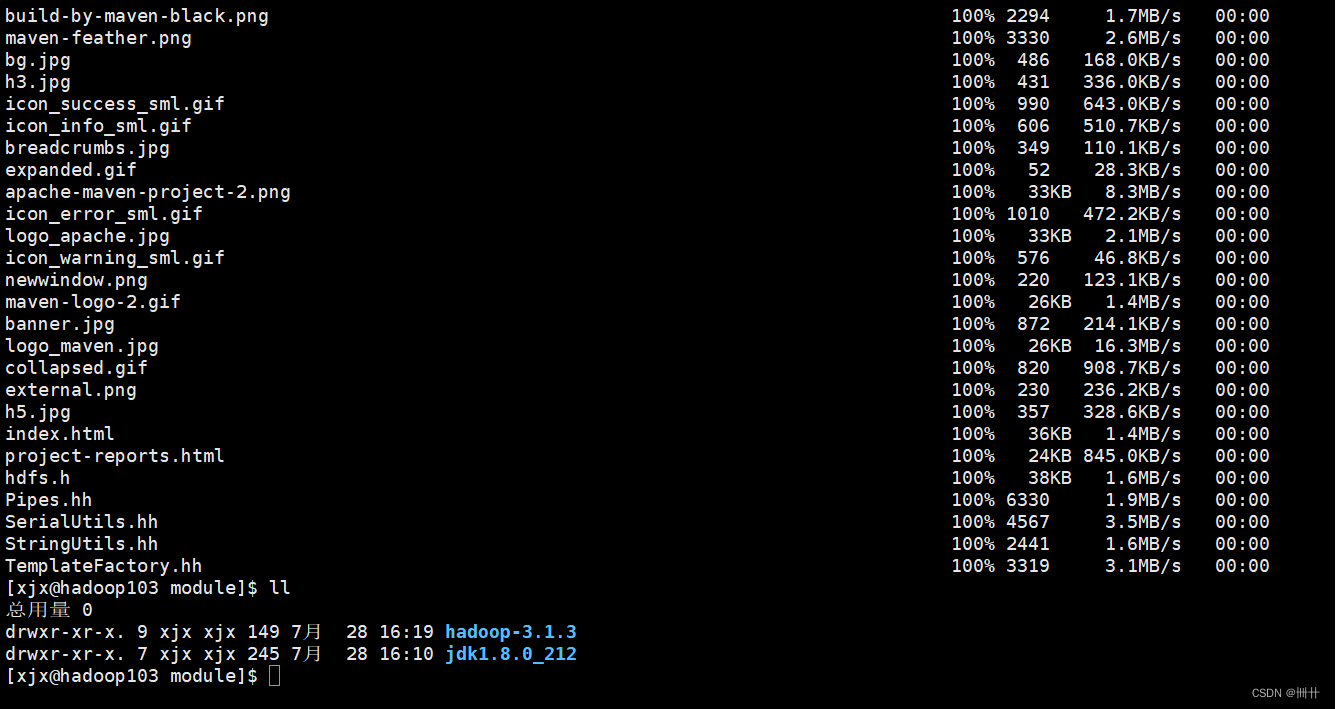

(b)在 hadoop103 上,将 hadoop102 中/opt/module/hadoop-3.1.3 目录拷贝到

hadoop103

上。

scp -r xjx@hadoop102:/opt/module/hadoop-3.1.3 /opt/module/

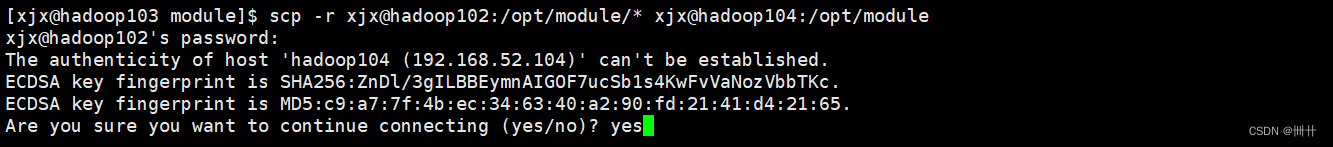

(c)在 hadoop103 上操作,将 hadoop102 中/opt/module 目录下所有目录拷贝到

hadoop104

上。

scp -r xjx@hadoop102:/opt/module/* xjx@hadoop104:/opt/module

3.2 rsync 远程同步工具

rsync 主要用于备份和镜像。具有速度快、避免复制相同内容和支持符号链接的优点。

rsync 和 scp 区别:用 rsync 做文件的复制要比 scp 的速度快,rsync 只对差异文件做更

新。scp 是把所有文件都复制过去。

(

1

)基本语法

rsync -av $pdir/$fname $user@$host:$pdir/$fname

命令

选项参数

要拷贝的文件路径/名称

目的地用户@

主机

:

目的地路径

/

名称

选项参数说明

选项 功能

`-a 归档拷贝

-v 显示复制过程

安装rsync

yum -y install rsync

(2)案例实操

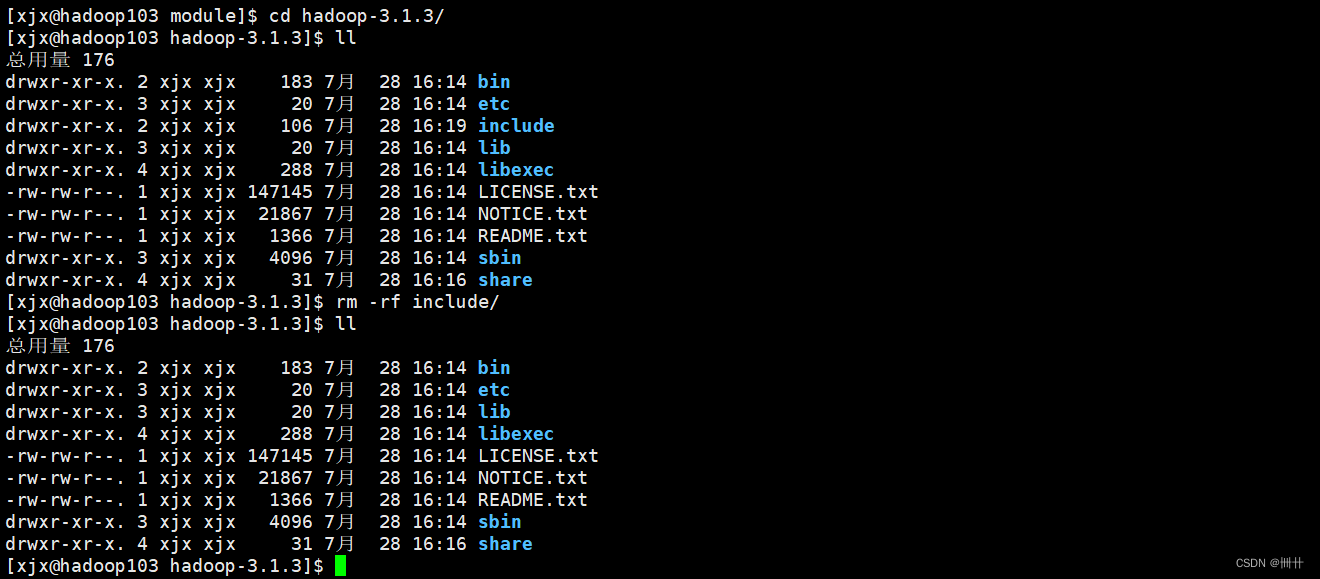

(a)删除

hadoop103

中

/opt/module/hadoop-3.1.3/wcinput

rm -rf wcinput/

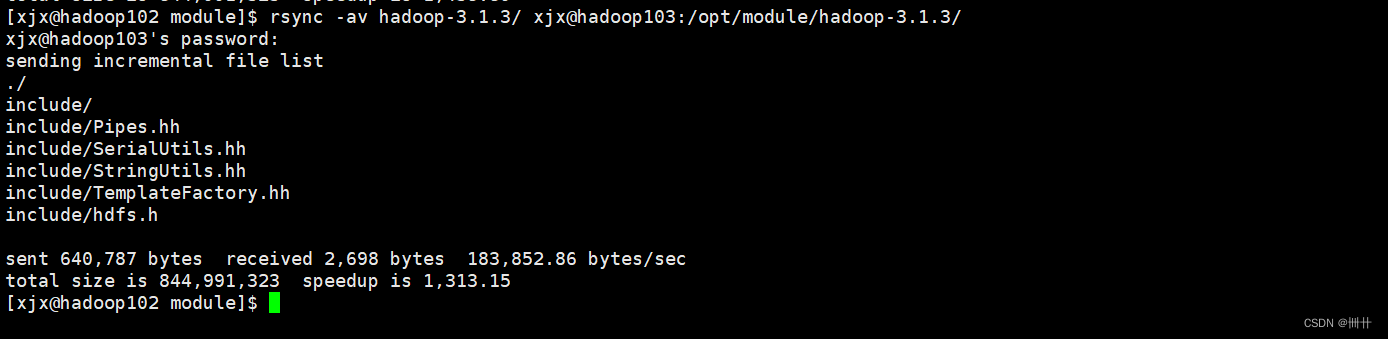

(b)同步

hadoop102

中的

/opt/module/hadoop-3.1.3

到

hadoop103

rsync -av hadoop-3.1.3/ xjx@hadoop103:/opt/module/hadoop-3.1.3/

3.3 xsync 集群分发脚本

(1)需求:循环复制文件到所有节点的相同目录下

(2)需求分析:

(a)rsync 命令原始拷贝:

rsync -av /opt/module xjx@hadoop103:/opt/

(b)期望脚本:

xsync 要同步的文件名称

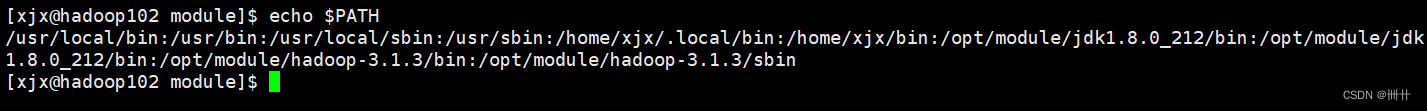

(c)期望脚本在任何路径都能使用(脚本放在声明了全局环境变量的路径)

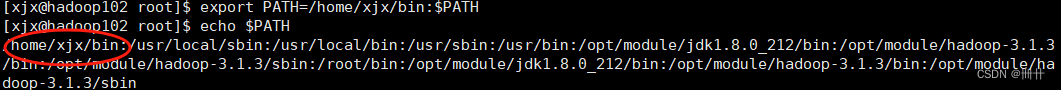

# 查看 全局环境变量的路径

echo $PATH

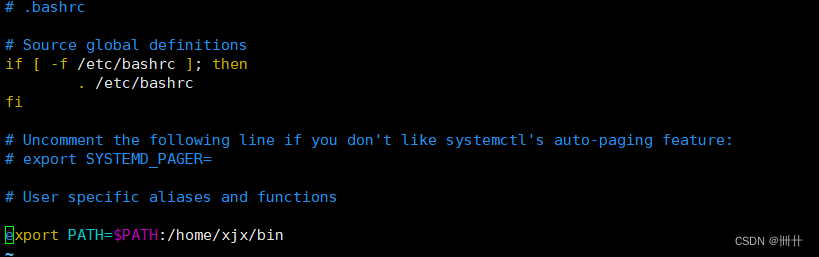

注:没有/home/xjx/bin路径

添加路径代码

vim /home/xjx/.bashrc

export PATH=/home/xjx/bin:$PATH

(3)脚本实现

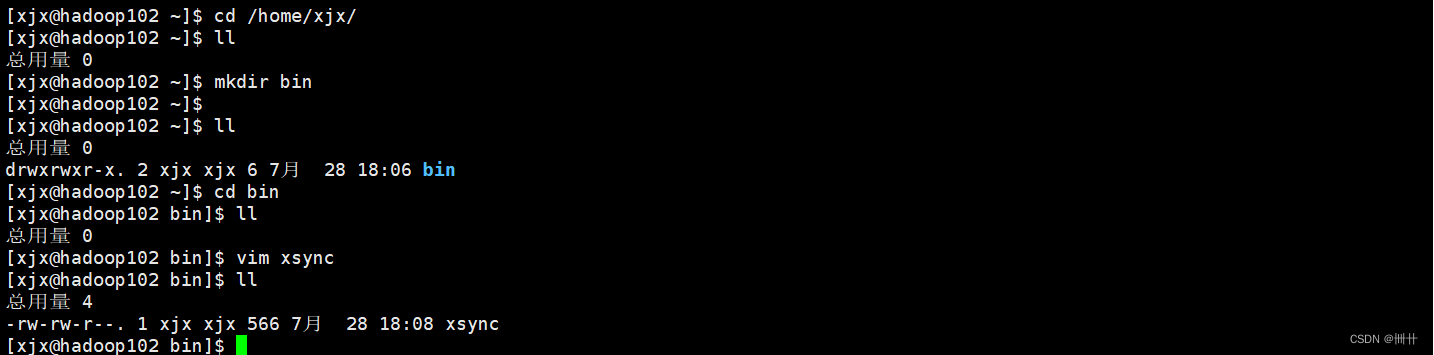

(a)在

/home/xjx/bin

目录下创建

xsync

文件

cd /home/xjx

mkdir bin

vim xsync

在该文件中编写如下代码

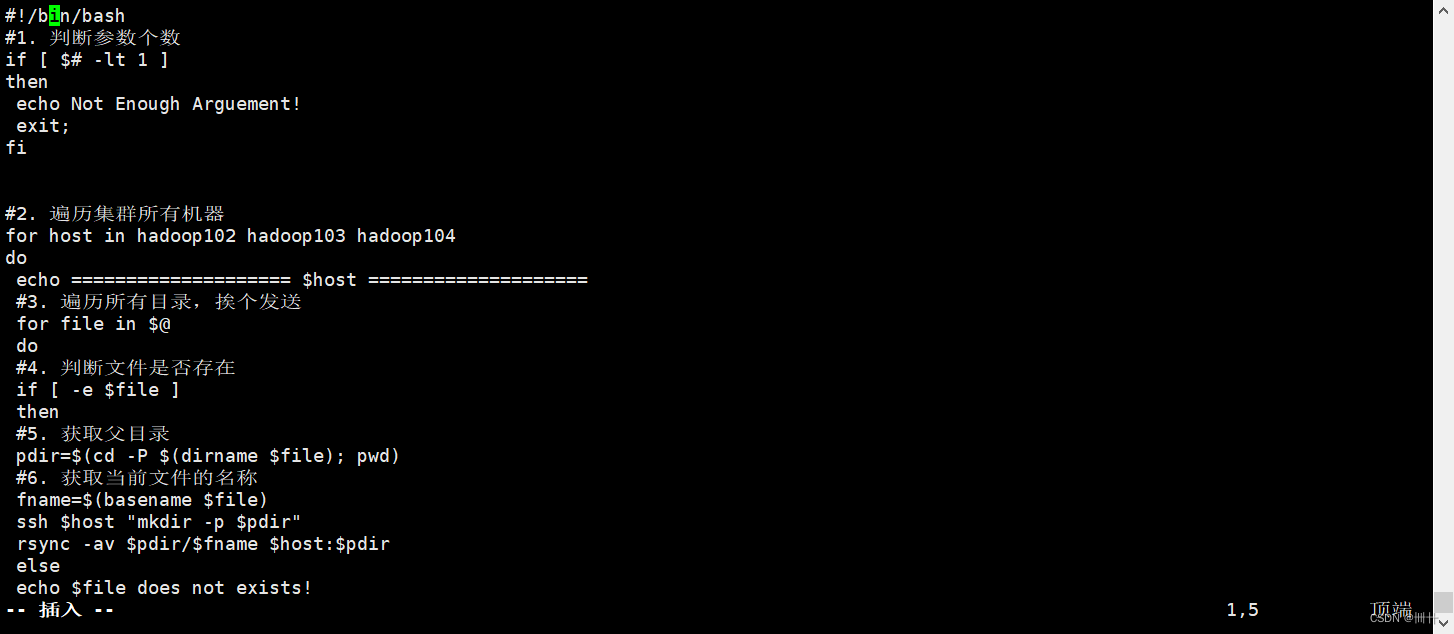

#!/bin/bash

#1. 判断参数个数

if [ $# -lt 1 ]

then

echo Not Enough Arguement!

exit;

fi

#2. 遍历集群所有机器

for host in hadoop102 hadoop103 hadoop104

do

echo ==================== $host ====================

#3. 遍历所有目录,挨个发送

for file in $@

do

#4. 判断文件是否存在

if [ -e $file ]

then

#5. 获取父目录

pdir=$(cd -P $(dirname $file); pwd)

#6. 获取当前文件的名称

fname=$(basename $file)

ssh $host "mkdir -p $pdir"

rsync -av $pdir/$fname $host:$pdir

else

echo $file does not exists!

fi

done

done

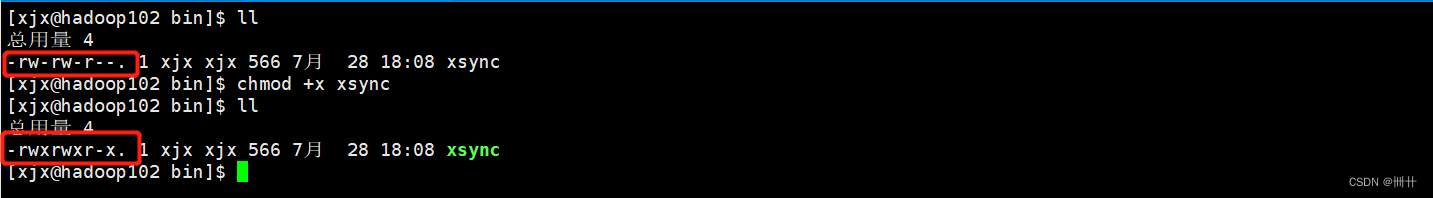

(b)修改脚本

xsync

具有执行权限

chmod +x xsync

(c)测试脚本

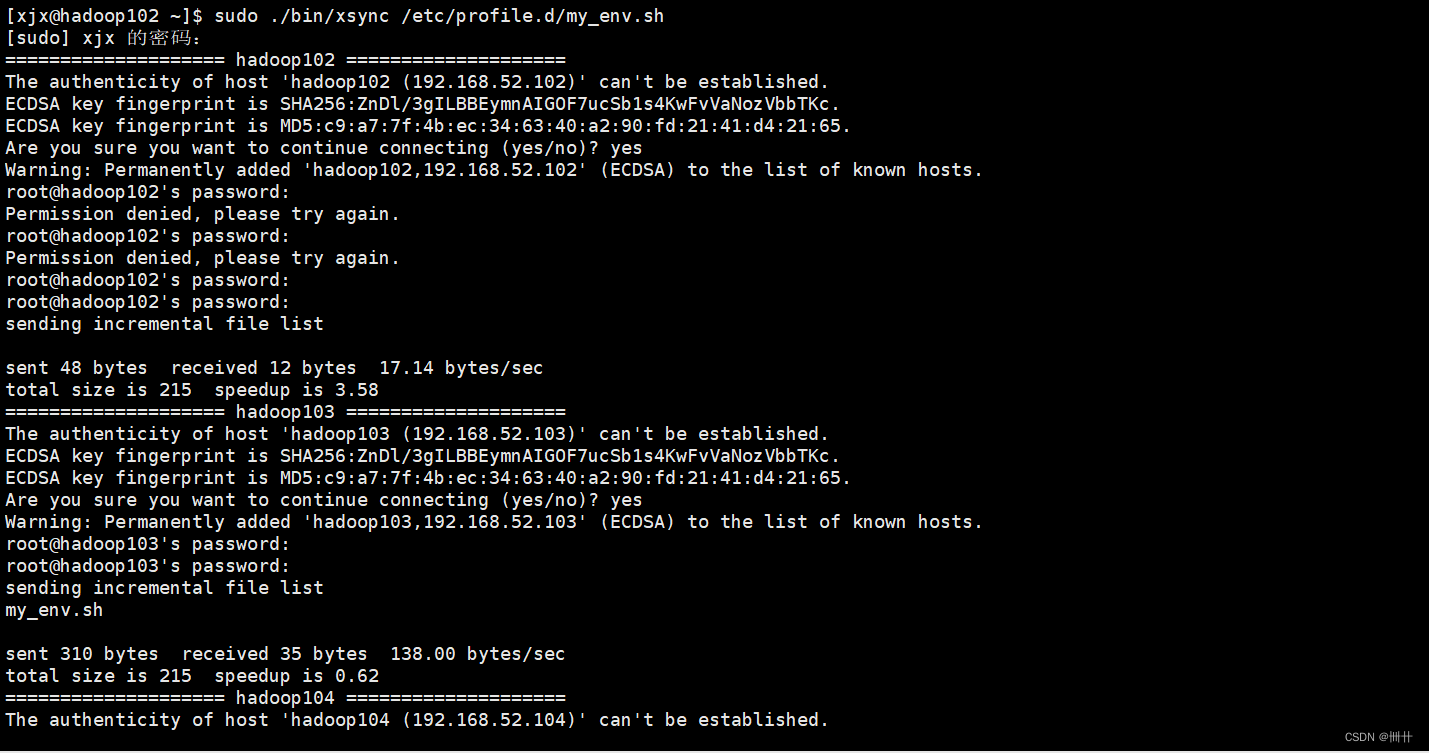

xsync /home/xjx/bin(d)同步环境变量配置(root 所有者)

sudo ./bin/xsync /etc/profile.d/my_env.sh 注意:如果用了 sudo,那么 xsync 一定要给它的路径补全。

注意:如果用了 sudo,那么 xsync 一定要给它的路径补全。

让环境变量生效(hadoop103,hadoop104)

source /etc/profile4、SSH无密登录配置

4.1配置ssh

(

1

)基本语法

ssh 另一台电脑的 IP

地址

(2)

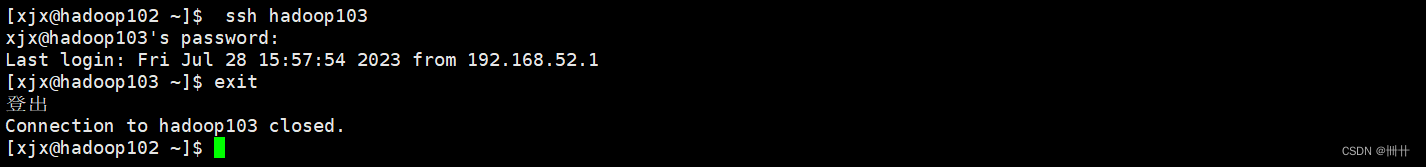

ssh

连接时出现

Host key verification failed

的解决方法

ssh hadoop103

# 退出

exit

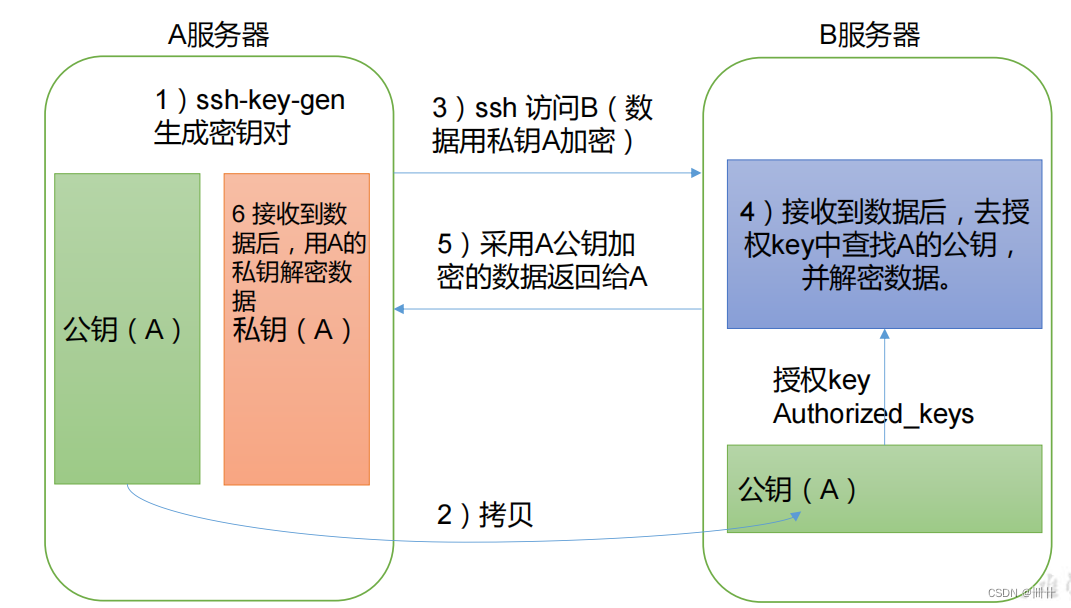

4.2无密钥配置

(

1

)免密登录原理

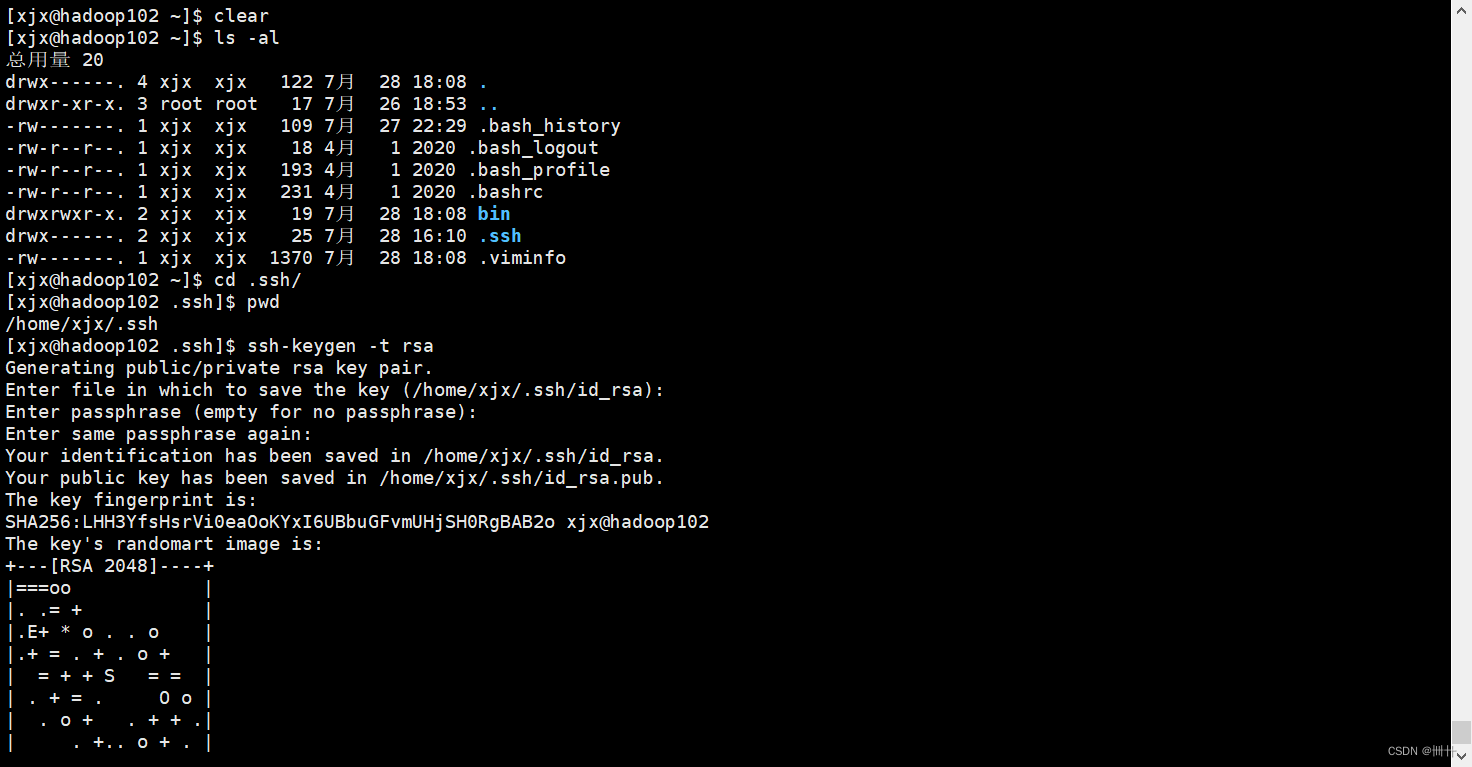

(2)生成公钥和私钥

# 查看所有隐藏文件

ls -al

pwd

ssh-keygen -t rsa

然后敲(三个回车),就会生成两个文件

id_rsa

(私钥)、

id_rsa.pub

(公钥)

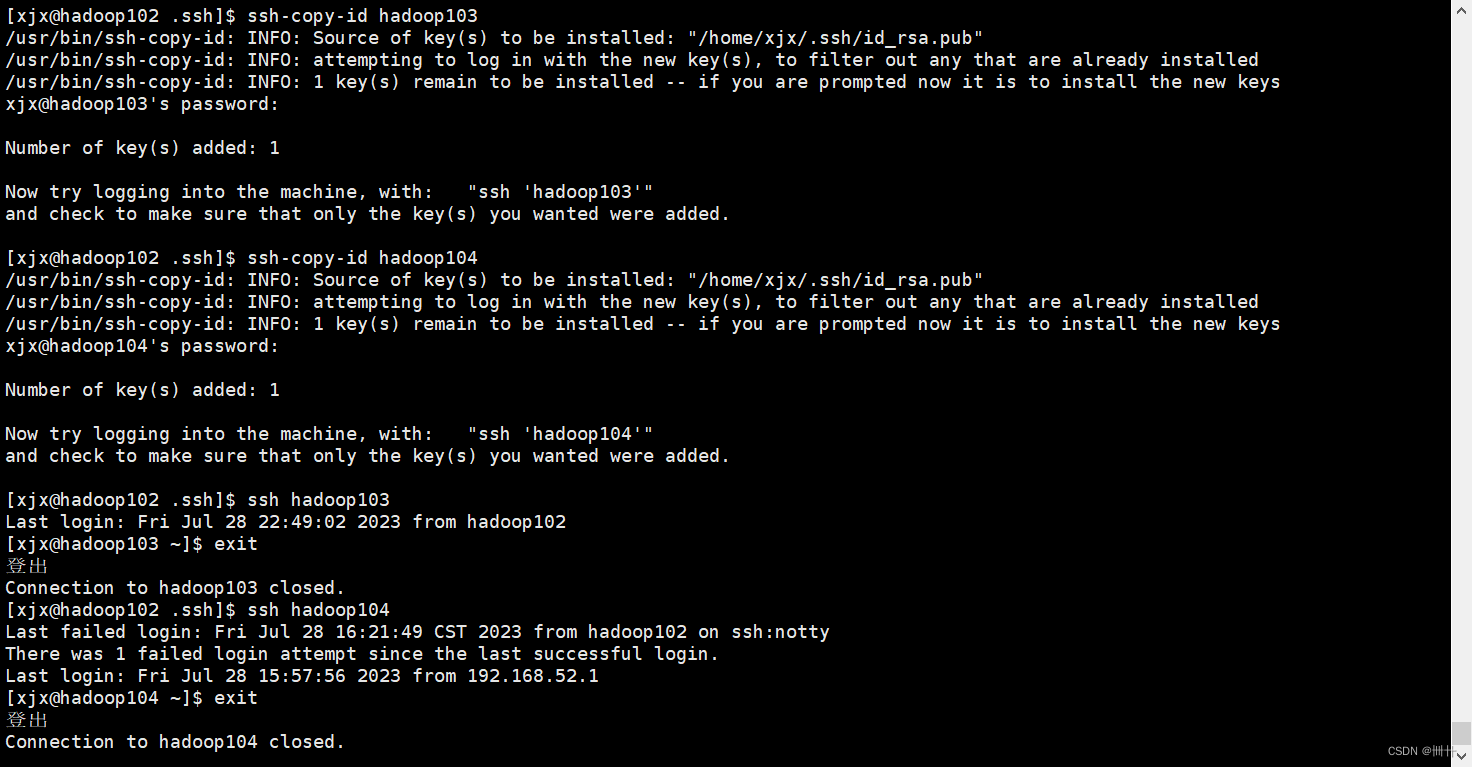

(3)将公钥拷贝到要免密登录的目标机器上

ssh-copy-id hadoop102

ssh-copy-id hadoop103

ssh-copy-id hadoop104

注意:

还需要在 hadoop103 上采用 xjx账号配置一下无密登录到 hadoop102、hadoop103、

hadoop104 服务器上。

还需要在 hadoop104 上采用 xjx账号配置一下无密登录到 hadoop102、hadoop103、

hadoop104 服务器上。

还需要在 hadoop102 上采用 root 账号,配置一下无密登录到 hadoop102、hadoop103、

hadoop104;

3

)

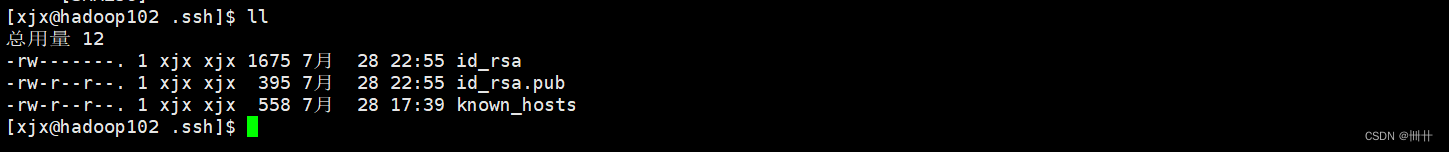

.ssh

文件夹下(

~/.ssh

)的文件功能解释

known_hosts 记录 ssh 访问过计算机的公钥(public key)

id_rsa 生成的私钥

id_rsa.pub 生成的公钥

authorized_keys 存放授权过的无密登录服务器公钥

614

614

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?