起始及经过

爬取某个网站的过程中,发现直接从浏览器按F12的控制台复制的xpath地址什么都获取不到,输出一个空列表,重新检查了xpath路径发现并没有什么问题.

示例网站:https://so.gushiwen.cn/shiwenv_4ef2774ed20a.aspx

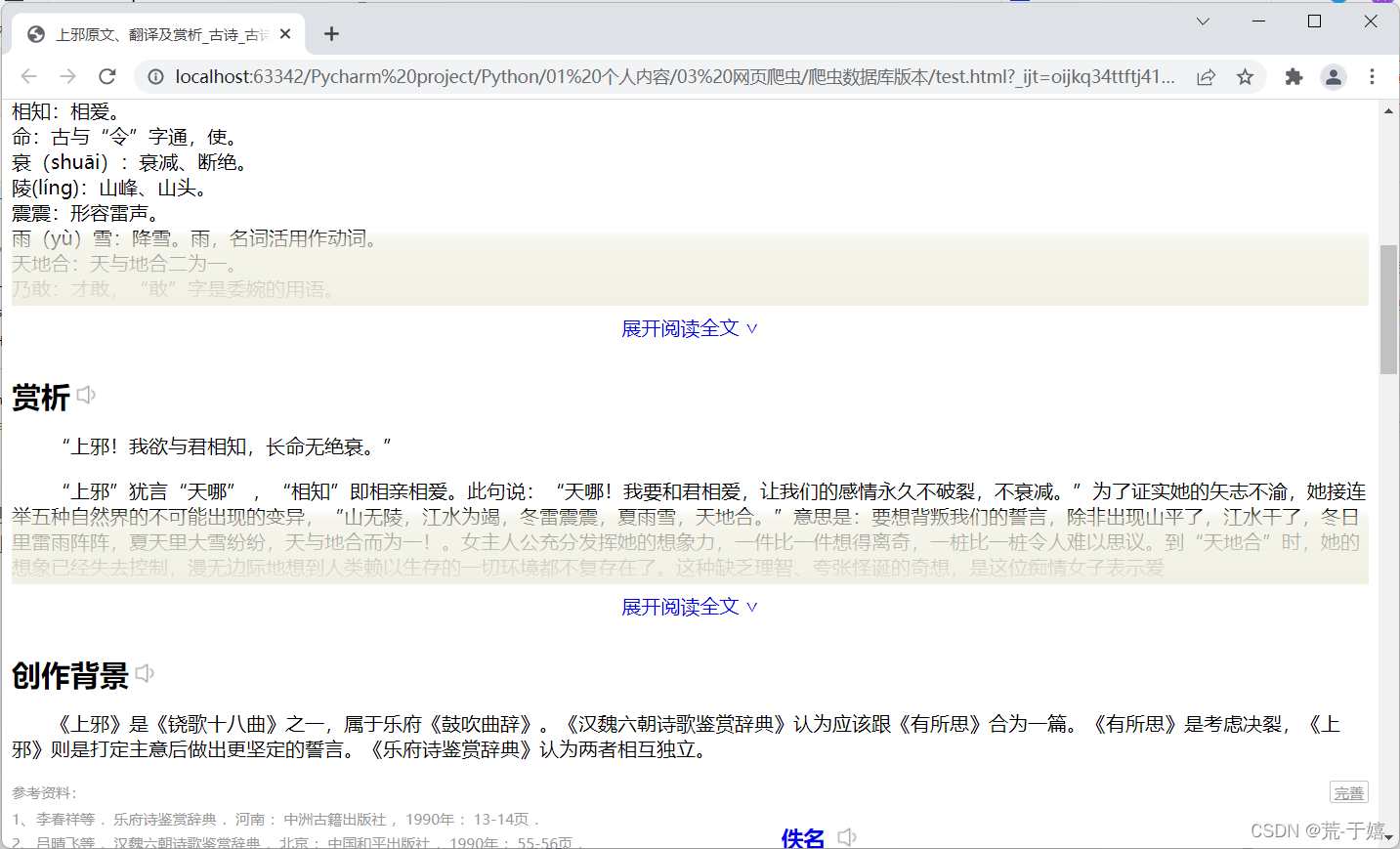

演示爬取内容(获取此处的赏析文本):

初始代码:

from lxml import etree

from requests import Session

url = 'https://so.gushiwen.cn/shiwenv_4ef2774ed20a.aspx'

session = Session()

pageContent = session.get(url).content.decode("utf-8")

xpath = etree.HTML(pageContent)

# 完整xpath: /html/body/div[2]/div[1]/div[6]/div[1]/p[2]/text()

content = xpath.xpath('//*[@id="shangxiquan1274"]/div[1]/p[2]/text()')

print("浏览器复制xpath获取内容:",content)

代码运行后发现输出空列表没有任何内容.

然后我把获取到的页面内容写入到了一个文件中,用浏览器重新打开这个文件.

页面显示虽然有问题,但是"赏析"这一段的文本内容还是在的,说明页面是存在这个数据的.并且不是通过接口获取的.

然后我重新在这里复制了xpath地址,粘贴到了代码中,发现和之前在原网站复制到的xpath地址居然不同

重新运行代码,成功获取到了内容

from lxml import etree

from requests import Session

url = 'https://so.gushiwen.cn/shiwenv_4ef2774ed20a.aspx'

session = Session()

# 从原网站F12控制台复制的xpath地址片段

pageContent = session.get(url).content.decode("utf-8")

xpath = etree.HTML(pageContent)

# 完整xpath: /html/body/div[2]/div[1]/div[6]/div[1]/p[2]/text()

content = xpath.xpath('//*[@id="shangxiquan1274"]/div[1]/p[2]/text()')

print("浏览器复制xpath获取内容:",content)

# 写入文件

with open("test.html",mode="w",encoding="utf-8") as w:

w.write(pageContent)

# 从本地文件打开的页面复制的xpath地址代片段

xpath = etree.HTML(pageContent)

# 完整xpath: /html/body/div[2]/div[1]/div[5]/div/p[2]/text()

content = xpath.xpath('//*[@id="shangxi1274"]/div/p[2]/text()')

print("修正后的xpath获取内容:",content)

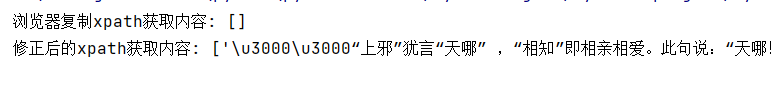

运行结果

两次xpath地址对比:

# 存在问题的

完整路径:/html/body/div[2]/div[1]/div[6]/div[1]/p[2]/text()

# 本地复制的可用的xpath地址

完整路径:/html/body/div[2]/div[1]/div[5]/div/p[2]/text()

# 相对路径

# 存在问题的

//*[@id="shangxiquan1274"]/div[1]/p[2]/text()

# 本地复制的可用的xpath地址

//*[@id="shangxi1274"]/div/p[2]/text()

解决方案

虽然不知道原因,但是如果发现获取不到内容大部分原因都是xpath地址问题了,如果检查没有问题可以先把抓取到的页面保存到本地,然后用浏览器打开本地文件重新复制xpath地址.

869

869

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?