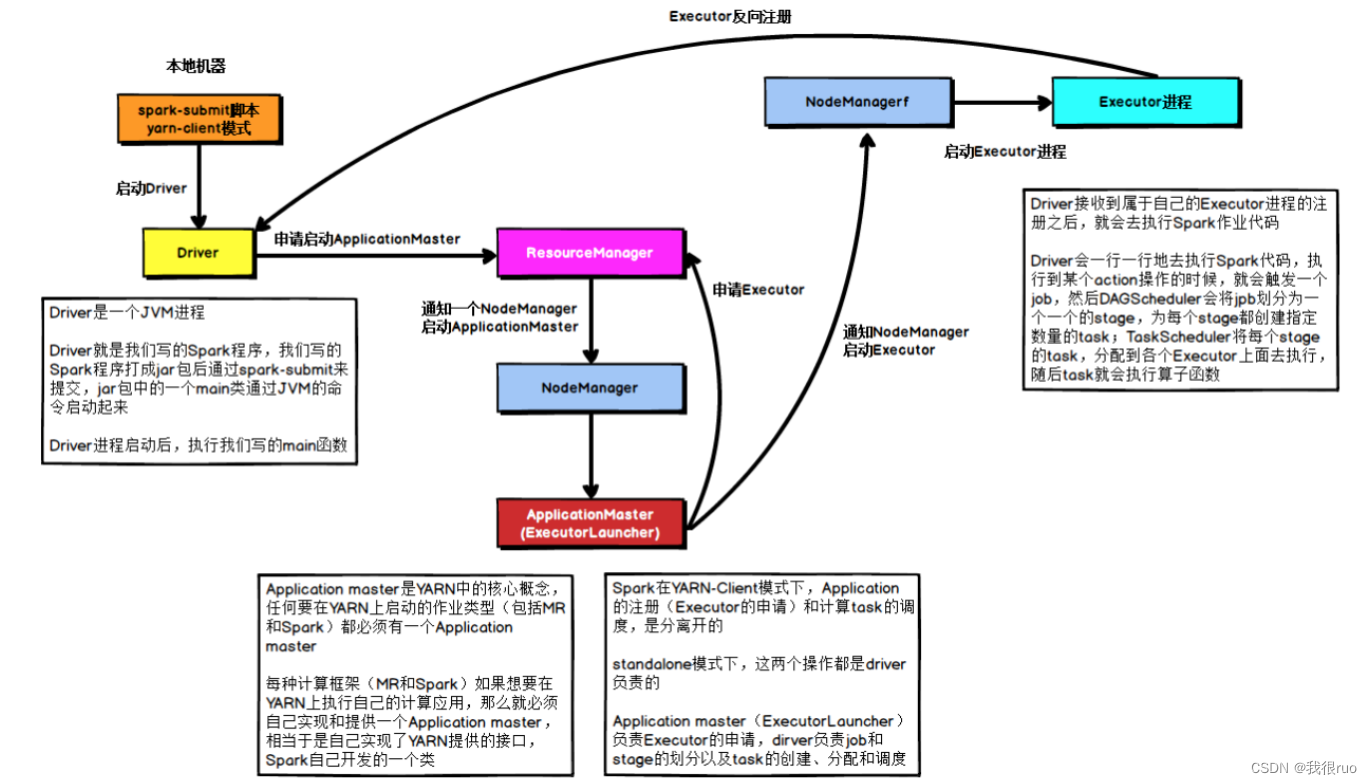

spark 核心流程

yarn-client

yarn-cluster

spark 任务调度

spark stage 级别调度

spark task 级别调度

失败重试和白名单

对于运行失败的 Task,TaskSetManager 会记录它失败的次数,如果失败次数还没有超过最大重试次数,那么就把它放回待调度的 Task 池子中等待重新执行,当重试次数过允许的最大次数,整个 Application失败。在记录 Task 失败次数过程中,TaskSetManager 还会记录它上一次失败所在的 ExecutorId 和 Host,这样下次再调度这个 Task 时,会使用黑名单机制,避免它被调度到上一次失败的节点上,起到一定的容错作用。

spark 的任务提交源码剖析

spark 中 DAG 引擎的设计

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2631

2631

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?