说明:刚开始接触nlp,可能很多不正确的地方,进行学习总结。学习的书是《自然语言处理(基于预训练模型的方法)》(车万翔郭江)。

1.1 自然语言处理的概念

自然语言通常指的是人类语言(本书特指文本符号,而非语音信号)。**自然语言处理(Natural Language Processing,NLP)**主要研究用计算机理解和生成自然语言的各种理论和方法,属于人工智能领域的一个重要甚至核心分支,是计算机科学与语言学的交叉学科,又常被称为计算语言学(Computational Linguistics,CL)。

人们普遍认为人工智能的发展经历了从运算智能到感知智能,再到认知智能三个发展阶段。运算智能关注的是机器的基础运算和存储能力,在这方面,机器已经完胜人类。感知智能则强调机器的模式识别能力。

1.2 自然语言处理的难点

1.2.1 抽象性

语言是由抽象符号构成的,每个符号背后都对应着现实世界或人们头脑中的复杂概念,如“车”表示各种交通工具——汽车、火车、自行车等,它们都具有共同的属性,有轮子、能载人或物等。

1.2.2 组合性

有限的符号却可以组合成无限的语义,即使是相同的词汇,由于顺序不同,组合的语义也是不相同的。

1.2.3 歧义性

歧义性主要是由于语言的形式和语义之间存在多对多的对应关系导致的,如:“苹果”一词,既可以指水果,也可以指一家公司或手机、电脑等电子设备,这就是典型的一词多义现象。另外,对于两个句子,如“曹雪芹写了红楼梦”和“红楼梦的作者是曹雪芹”,虽然它们的形式不同,但是语义是相同的。

1.2.4 进化性

随着时代发展,新词越来越多,用法层出不穷。

1.2.5 非规范性

错字、近音等,“为什么”→“为森么”,“怎么了”→“肿么了”

1.2.6 主观性

和感知智能问题不同,属于认知智能的自然语言处理问题往往具有一定的主观性。如在分词这一

最基本的中文自然语言处理任务中,关于什么是“词”的定义都尚不明确,比如“打篮球”是一个词还是两个词呢?此外,由于不同的分词系统往往标准都不尽相同,所以通过准确率等客观指标对比不同的分词系统本身就是不客观的。

1.2.7 知识性

理解语言通常需要背景知识以及基于这些知识的推理能力。例如,针对句子“张三打了李四,然后 倒了”,问其中的“他”指代的是“张三”还是“李四”?只有具备了“被打的人更容易倒”这一知识,才能推出“他”很可能指代的是“李四”。而如果将“倒”替换为“笑”,则“他”很可能指代的是“张三”,因为“被打的人不太容易笑”。但是,如何表示、获取并利用这些知识呢?目前的自然语言处理技术并没有提供很好的答案。

1.2.8 难移植性

由于自然语言处理涉及的任务和领域众多,并且它们之间的差异较大,造成了难移植性的问题。另外,由于不同领域的用词以及表达方式不尽相同,因此在一个领域上学习的模型也很难应用于其他领域,这也给提高自然语言处理系统的可移植性带来了极大的困难。

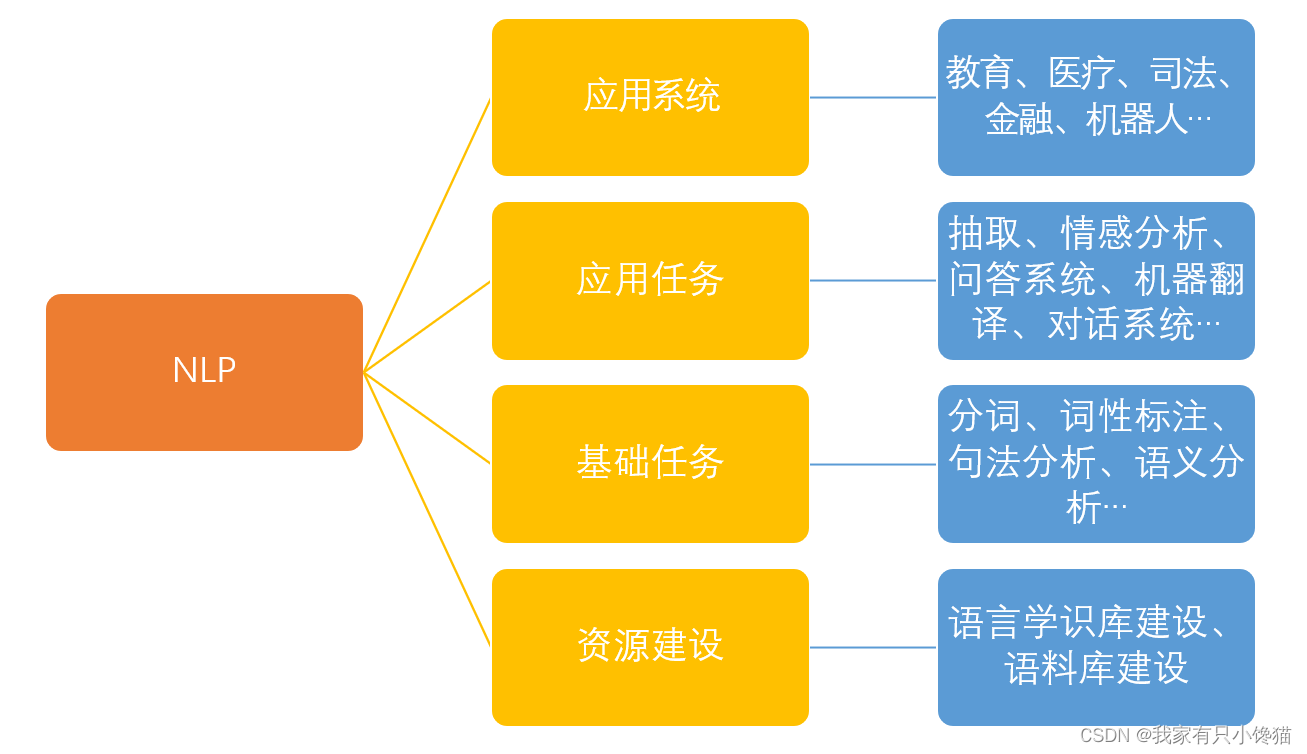

1.3 自然语言处理任务体系

1.3.1 任务层级

按照从低层到高层的方式,可以划分为资源建设、基础任务、应用任务和应用系统四大类。

语言学知识库一般包括词典、规则库等。词典(Dictionary)也称辞典(Thesaurus),除了可以为词语提供音韵、句法或者语义解释以及示例等信息,还可以提供词语之间的关系信息,如上下位、同义反义关系等。

语料库资源指的是面向某一自然语言处理任务所标注的数据。无论是语言学资源,还是语料库资源的建设,都是上层各种自然语言处理技术的基础,需要花费大量的人力和物力构建。

基础任务除了语言学上的研究价值,它们主要为上层应用任务提供所需的特征。

应用系统特指自然语言处理技术在某一领域的综合应用,又被称为NLP+,即自然语言

处理技术加上特定的应用领域。

1.3.2 任务类别

1.回归问题

即将输入文本映射为一个连续的数值,如对作文的打分,对案件刑期或罚款金额的预测等。

2.分类问题

又称为文本分类,即判断一个输入的文本所属的类别,如:在垃圾邮件识别任务中,可以将一封邮件分为正常和垃圾两类;在情感分析中,可以将用户的情感分为褒义、贬义或中性三类。

3.匹配问题

判断两个输入文本之间的关系,如:它们之间是复述或非复述两类关系;或者蕴含、矛盾和无关三类关系。另外,识别两个输入文本之间的相似性(0到1的数值)也属于匹配问题。

4.解析问题

特指对文本中的词语进行标注或识别词语之间的关系,典型的解析问题包括词性标注、句法分析等,另外还有很多问题,如分词、命名实体识别等也可以转化为解析问题。

5.生成问题

特指根据输入(可以是文本,也可以是图片、表格等其他类型数据)生成一段自然语言,如机器翻译、文本摘要、图像描述生成等都是典型的文本生成类任务。

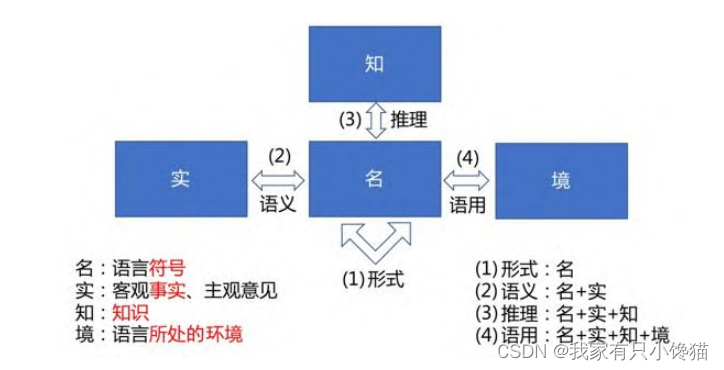

1.3.3 研究对象与层次

以通过对研究对象的区分将自然语言处理研究分成多个层次的任务。自然语言处理主要涉及**“名”“实”“知”“境”**之间的关系。

“名”指的是语言符号;

“实”表示客观世界中存在的事实或人的主观世界中的概念;

“知”是指知识,包括常识知识、世界知识和领域知识等;

“境”则是指语言所处的环境。

随着涉及的研究对象越来越多,自然语言处理的研究由浅入深,可以分为形式、语义、推理和语用四个层次。

1.形式主要研究语言符号层面的处理,研究的是“名”与“名”之间的关系,如通过编辑距离等计算文本之间的相似度。

2. 语义主要研究语言符号和其背后所要表达的含义之间的关系,即“名”和“实”之间的关系,如“手机余额不足”和“电话欠费了”两个句子的表达方式完全不同,但是背后阐述的事实是相同的。语义问题也是自然语言处理领域目前主要关注的问题。

3. 推理是在语义研究的基础之上,进一步引入知识的运用,因此涉及“名”“实”和“知”之间关系,这一点正体现了自然语言的知识性。

4. 语用则最为复杂,由于引入了语言所处的环境因素,通常表达的是“言外之意”和“弦外之音”,同时涉及了“名”“实”“知”“境”四个方面。例如,同样的一句话“你真讨厌”,从字面意义上明显是贬义,而如果是情侣之间的对话,则含义可能就不一样了。另外,语气、语调以及说话人的表情和动作也会影响其要表达的含义。

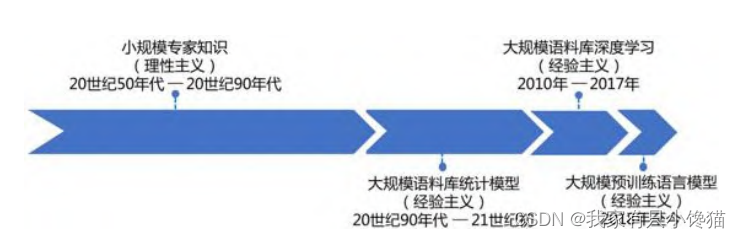

1.4 自然语言处理技术发展历史

深度学习可以有效地避免统计学习方法中的人工特征提取操作,自动地发现对于目标任务有效的表示。在语音识别、计算机视觉等领域,取得了好的效果,在自然语言处理领域,深度学习同样引发了一系列的变革,自然语言生成也取得了长足进步。

但是基于深度学习的算法有一个致命的缺点,过度依赖于大规模有标注数据。对于语音识别、图像处理等感知类任务,标注数据相对容易获得。由于自然语言处理这一认知类任务所具有的“主观性”特点,以及其所面对的任务和领域众多,使得标注大规模语料库的时间过长,人力成本过于高昂。

早期的静态词向量预训练模型,以及后来的动态词向量预训练模型,特别是2018年以来,以BERT、GPT为代表的超大规模预训练语言模型恰好弥补了自然语言处理标注数据不足的缺点。

模型预训练(Pre-train),即首先在一个原任务上预先训练一个模型预训练,然后在下游任务(也称目标任务)上继续对该模型进行精调(Fine-tune),从而达到提高下游任务准确率的目的。在本质上,这也是迁移学习(Transfer Learning)思想的一种应用。然而,由于同样需要人工标注,导致原任务标注数据的规模往往也非常有限。那么,如何获得更大规模的标注数据呢?

文本自身的顺序性就是一种天然的标注数据,通过若干连续出现的词语预测下一个词语(又称语言模型)就可以构成一项原任务。由于图书、网页等文本数据规模近乎无限,所以,可以非常容易地获得超大规模的预训练数据。有人将这种不需要人工标注数据的预训练学习方法称为无监督学习(Unsupervised Learning),其实这并不准确,因为学习的过程仍然是有监督的(Supervised),更准确的叫法应该是自监督学习(Self-supervised Learning)。

为了能够刻画大规模数据中复杂的语言现象,还要求所使用的深度学习模型容量足够大。基于自注意力的Transformer模型显著地提升了对于自然语言的建模能力,是近年来具有里程碑意义的进展之一。要想在可容忍的时间内,在如此大规模的数据上训练一个超大规模的Transformer模型,也离不开以GPU、TPU为代表的现代并行计算硬件。可以说,超大规模预训练语言模型完全依赖“蛮力”,在大数据、大模型和大算力的加持下,使自然语言处理取得了长足的进步。如OpenAI推出的GPT-3,是一个具有1,750亿个参数的巨大规模,无须接受任何特定任务的训练,便可以通过小样本学习完成十余种文本生成任务,如问答、风格迁移、网页生成和自动编曲等。目前,预训练模型已经成为自然语言处理的新范式。

725

725

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?