论文: https://arxiv.org/abs/1812.04948

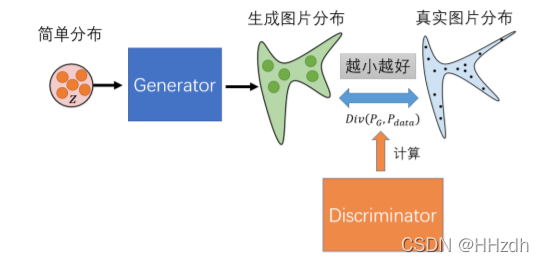

首先回顾GAN在做的事:

一般来说实验上做的图片大小都是28、128、256等小尺寸的图片,现在我们要做是让 GANs 能生成高质量的大图像(1024*1024)。 这是一件有挑战性的事情因为在一个彩色的 1024*1024 大小的图片空间中, 总共存在的图片样本点为个(图片深度为 3,像素值为 0-255),而现在我们要让 GANs 学会在这样一个庞大的图片空间中找出真实图片的分布区域,并且建立一个从简单分布到这一复杂分布的转换,任务量无疑是巨大的。

一个比较自然的想法是由小至大,逐级生成。也就是,先使用非常低分辨率的图像(如:4×4)开始训练生成器和判别器,并且逐次增加一个更高分辨率的网络层,直到最后能产生一个具有丰富细节的高清图片。基于这一想法,ProGAN(渐进式生成对抗网络)诞生了。ProGAN是styleGAN的前身。

《Progressively Growing of GANs》论文解读_HHzdh的博客-CSDN博客

特别值得注意的是,上图 Generator 中的网络结构不是指的从 4*4 网络连接到 8*8 网络,再连接到 16*16 网络依次输出,而是指的从 4*4 网络变化到 8*8 网络,再变化到 16*16 网络。也就是说,Generator 内部的网络只有一个,但是在训练过程中网络的结构是在动态变化的。事实上,前面那种依次连接的网络模型叫做 StackGAN,但是 StackGAN 不适合用来做超清图片生成,因为会特别慢。

由于 ProGAN 是逐级直接生成图片,我们没有对其增添控制,我们也就无法获知它在每一级上学到的特征是什么,这就导致了它控制所生成图像的特定特征的能力非常有限。换句话说,这 些特性是互相关联的,因此尝试调整一下输入,即使是一点儿,通常也会同时影响多个特性。 我们希望有一种更好的模型,能让我们控制住输出的图片是长什么样的,也就是在生成图片过程中每一级的特征,要能够特定决定生成图片某些方面的表象,并且相互间的影响尽可能小。于是,在 ProGAN 的基础上,StyleGAN 作出了进一步的改进与提升。

1 摘要

-

StyleGAN受风格迁移style transfer启发而设计了一种新的生成器网络结构。新的网络结构可以通过无监督式的自动学习对图像的高层语义属性做一定解耦分离,例如人脸图像的姿势和身份、所生成图像的随机变化如雀斑和头发等。也可以做到一定程度上的控制合成。

-

为了量化插值质量和解纠缠度,还提出了两种计算方法。最后,还介绍一个新的、高度多样化和高质量的人脸数据集。

2 介绍

-

GAN所生成的图像在分辨率和质量上都得到了飞速发展,但在此之前很多研究工作仍然把生成器当作黑箱子,也就是缺乏对生成器进行图像生成过程的理解,例如图像多样性中的随机特征是如何控制的,潜在空间的性质也是知之甚少。

-

受风格迁移启发,StyleGAN重新设计了生成器网络结构,并试图来控制图像生成过程:生成器从学习到的常量输入开始,基于潜码调整每个卷积层的图像“风格”,从而直接控制图像特征;另外,结合直接注入网络的噪声,可以更改所生成图像中的随机属性(例如雀斑、头发)。StyleGAN可以一定程度上实现无监督式地属性分离,进行一些风格混合或插值的操作。

-

提出了一个新的人脸数据集(Flickr-Faces-HQ, FFHQ),它比现有的高分辨率数据集提供了更高的质量,覆盖了更广泛的变化。

3 基于风格驱动的生成器

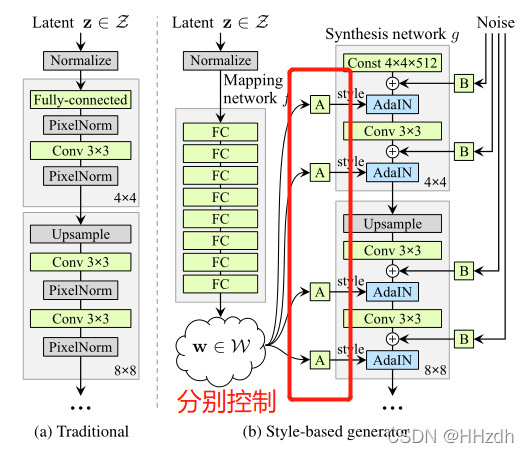

(1)StyleGAN的第一点改进是,给Generator的输入加上了由8个全连接层组成的Mapping Network,并且 Mapping Network 的输出𝑊′与输入层(512×1)的大小相同。

添加 Mapping Network 的目标是将输入向量编码为中间向量,并且中间向量后续会传给生成网络得到 18 个控制向量,使得该控制向量的不同元素能够控制不同的视觉特征。( 我们希望有一种更好的模型,能让我们控制住输出的图片是长什么样的,也就是在生成图片过程中每一级的特征,要能够特定决定生成图片某些方面的表象,并且相互间的影响尽可能小)

为何要加 Mapping Network 呢?因为如果不加这个 Mapping Network 的话,后续得到的 18 个控制向量之间会存在特征纠缠的现象——比如说我们想调节 8*8 分辨率上的控制向量(假设它能控制人脸生成的角度),但是我们会发现 32*32 分辨率上的控制内容(譬如肤色)也被改变了,这个就叫做特征纠缠。所以 Mapping Network 的作用就是为输入向量的特征解缠提供一条学习的通路。 为何 Mapping Network 能够学习到特征解缠呢?简单来说,如果仅使用输入向量来控制视觉特征,能力是非常有限的,因此它必须遵循训练数据的概率密度。例如,如果黑头发的人的图像在数据集中更常见,那么更多的输入值将会被映射到该特征上。因此,该模型无法将部分输入(向量中的元素)映射到特征上,这就会造成特征纠缠。然而,通过使用另一个神经网络,该模型可以生成一个不必遵循训练数据分布的向量,并且可以减少特征之间的相关性。 映射网络由 8 个全连接层组成,它的输出𝑊′与输入层(512×1)的大小相同。

(2)样式模块(AdaIN)

StyleGAN 的第二点改进是,将特征解缠后的中间向量𝑊′变换为样式控制向量,从而参与影响生成器的生成过程。

非线性映射也就是学习到的仿射变换将w定制化为风格,它们在接下来的生成网络g中每个卷积层之后被用于控制自适应实例归一化(AdaIN)。AdaIN运算定义为如下式所示。其中,每个特征图

分别归一化,然后使用y中对应的标量。因此,y的维数是该层特征图的两倍。与风格迁移不同,StyleGAN是从向量w而不是风格图像计算而来。

生成器由于从 4*4,变换到 8*8,并最终变换到 1024*1024,所以它由 9 个生成阶段组成,而每个阶段都会受两个控制向量(A)对其施加影响,其中一个控制向量在 Upsample 之后对其影响一次,另外一个控制向量在 Convolution 之后对其影响一次,影响的方式都采用 AdaIN(自适应实例归一化)。因此,中间向量𝑊′总共被变换成 18 个控制向量(A)传给生成器。

(3)由于 StyleGAN 生成图像的特征是由𝑊′和 AdaIN 控制的,那么生成器的初始输入可以被忽略,并用常量值替代。

最后,通过对生成器引入噪声输入(加入随机变化),提供了一种生成随机(多样性)细节的方法。噪声输入是由不相关的高斯噪声组成的单通道数据,它们被馈送到生成网络的每一层。

4 网络结构

加入了一系列附加模块后得到的 StyleGAN 最终网络模型结构图如下:总的来说就是实现在每一级的训练上施加精确控制,能让我们控制住输出的图片是长什么样的,也就是在生成图片过程中每一级的特征,要能够特定决定生成图片某些方面的表象,并且相互间的影响尽可能小。

相关源码:

GitHub - tomguluson92/StyleGAN_PyTorch: The implementation of StyleGAN on PyTorch 1.0.1

GitHub - NVlabs/stylegan2: StyleGAN2 - Official TensorFlow Implementation

StyleGAN是一种改进的生成对抗网络,受到风格迁移的启发,其设计目标是实现对生成图像的高层语义属性的解耦控制。通过引入Mapping Network和AdaIN(自适应实例归一化)技术,StyleGAN能够逐步生成高质量图像,并在生成过程中对特征进行解缠,从而更好地控制图像的特定方面。此外,StyleGAN还引入噪声输入以增加生成的多样性。该模型在1024*1024的大尺寸图像生成中表现出色,尤其适用于人脸图像,能实现对姿态和身份等属性的独立控制。

StyleGAN是一种改进的生成对抗网络,受到风格迁移的启发,其设计目标是实现对生成图像的高层语义属性的解耦控制。通过引入Mapping Network和AdaIN(自适应实例归一化)技术,StyleGAN能够逐步生成高质量图像,并在生成过程中对特征进行解缠,从而更好地控制图像的特定方面。此外,StyleGAN还引入噪声输入以增加生成的多样性。该模型在1024*1024的大尺寸图像生成中表现出色,尤其适用于人脸图像,能实现对姿态和身份等属性的独立控制。

293

293

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?