视频:XTuner 微调 LLM:1.8B、多模态、Agent_哔哩哔哩_bilibili

文档:Tutorial/xtuner/readme.md at camp2 · InternLM/Tutorial · GitHub

笔记

两种Finetune范式

LLM 的下游应用中,增量预训练和指令跟随是经常会用到两种的微调模式

增量预训练微调

使用场景:让基座模型学习到一些新知识,如某个垂类领域的常识训练数据:文章、书籍、代码等

指令跟随微调

使用场景:让模型学会对话模板,根据人类指令进行对话训练数据:高质量的对话、问答数据

XTurn

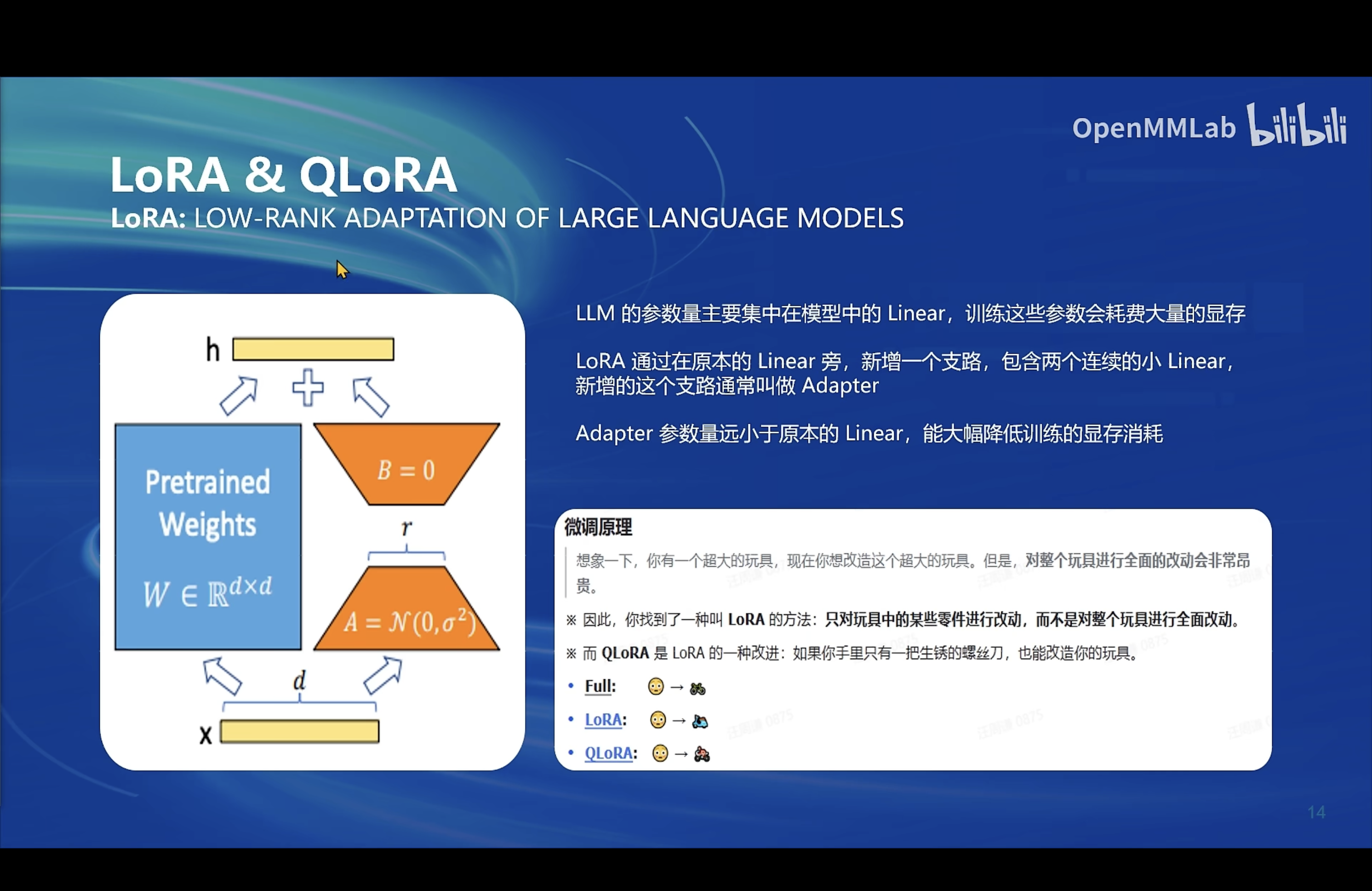

LoRA & QLoRA

LoRA: Low-Rank Adaptation of Large Language Models

- LLM 的参数量主要集中在模型中的 Linear, 训练这些参数会耗费大量的显存

- LoRA 通过在原本的 Linear 旁,新增一个支路,包含两个连续的小 linear,新增的这个支路通常叫做 Adapter

- Adapter 参数量远小于原本的 Linear,能大幅降低训练的显存消耗

QLoRA: Quantized LLMs with Low-Rank Adapters

- 4位NormalFloat量化:这是一种改进量化的方法,确保每个量化仓中有相同数量的值,这避免了计算问题和异常值的错误。

- 双量化:对量化常量再次量化以节省额外内存的过程。

- 统一内存分页:它依赖于NVIDIA统一内存管理,自动处理CPU和GPU之间的页到页传输,它可以保证GPU处理无错,特别是在GPU可能耗尽内存的情况下。

XTuner 一个大语言模型&多模态模型微调工具箱。由 MMRazor 和 MMDeploy 联合开发。

- 🤓 傻瓜化: 以 配置文件 的形式封装了大部分微调场景,0基础的非专业人员也能一键开始微调。

- 🍃 轻量级: 对于 7B 参数量的LLM,微调所需的最小显存仅为 8GB : 消费级显卡✅,colab✅

MS-Agent 数据集

这个数据集比较有意思,能够赋予大模型调用api的agent能力,原理:

- 模型的回复中会包括插件调用代码和执行代码

- 调用代码是 LLM 生成的

- 执行代码是需要调用服务来生成结果的,这里我们需要给

xtuner chat增加-lagent参数来实现

本文介绍了XTuner,一个用于大语言模型和多模态模型微调的工具,支持增量预训练和指令跟随两种模式。LoRA和QLoRA技术被提及,前者通过低秩适应减少显存消耗,后者利用量化技术优化内存。XTuner简化了微调过程,即使是初级用户也能轻松上手,且对硬件要求较低。

本文介绍了XTuner,一个用于大语言模型和多模态模型微调的工具,支持增量预训练和指令跟随两种模式。LoRA和QLoRA技术被提及,前者通过低秩适应减少显存消耗,后者利用量化技术优化内存。XTuner简化了微调过程,即使是初级用户也能轻松上手,且对硬件要求较低。

1188

1188

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?