往期文章一览

【7W字长文】使用LVS+Keepalived实现Nginx高可用,一文搞懂Nginx

主从复制高可用Redis集群

分布式架构介绍

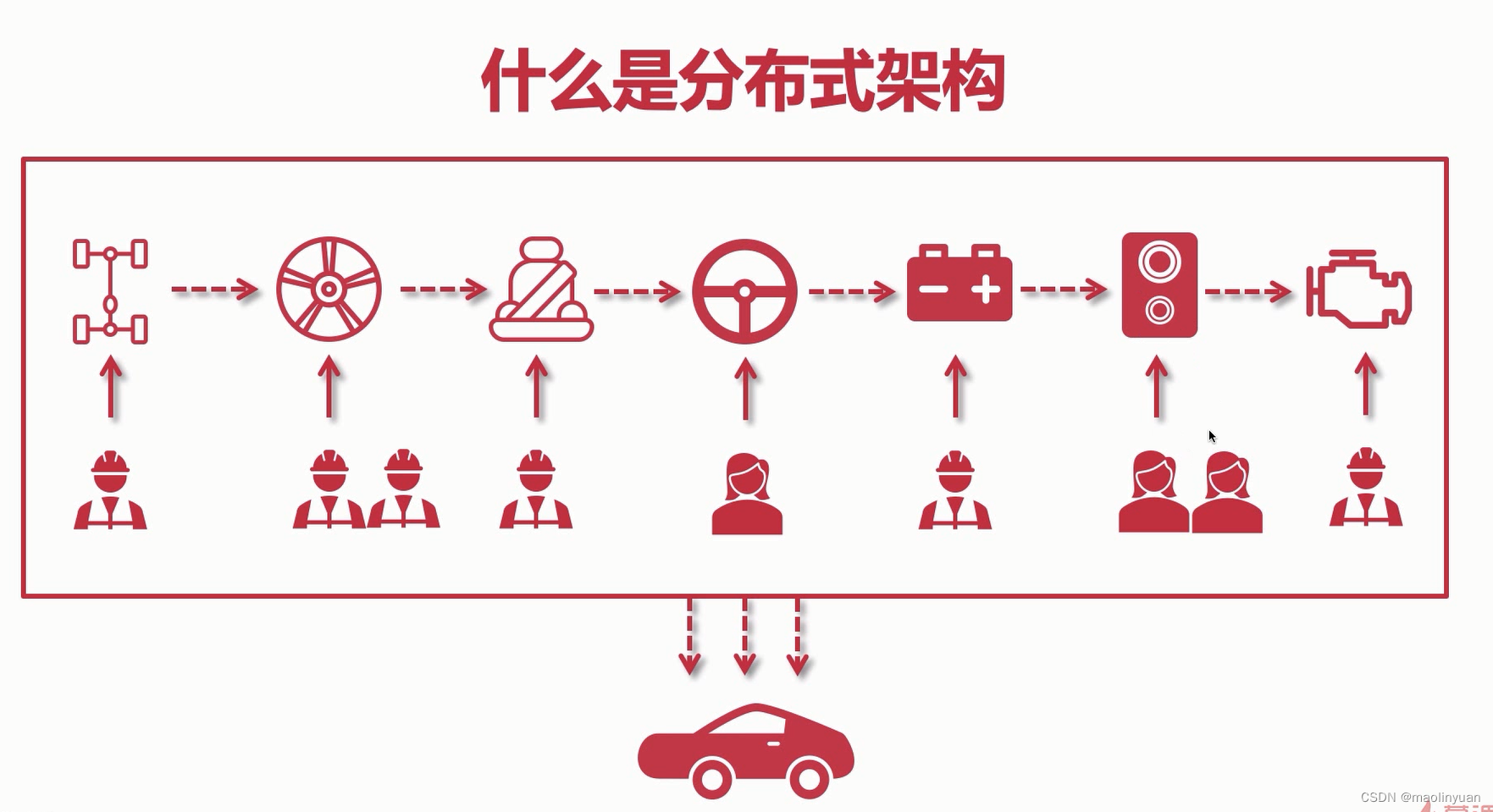

什么是分布式架构

随着越来越多的人参与到互联网的浪潮来,曾经的单体应用架构越来越无法满足需求,所以,分布式集群架构出现,也因此,分布式搭建开发成为了Web开发者必掌握的技能之一。那什么是分布式呢?怎么实现分布式以及怎么处理分布式带来的问题呢?本系列文章就来源于对分布式各组件系统的学习总结,包含但不限于Zookeeper、Dubbo、消息队列(ActiveMQ、Kafka、RabbitMQ)、NoSql(Redis、MongoDB)、Nginx、分库分表MyCat、Netty等内容。

简单的说,“分工协作,专人做专事”就是分布式的概念。不同的功能模块分散部署在不同的服务器,每个子系统负责一个或多个不同的业务模块,服务之间可以相互交互和通信。

分布式系统设计对用户是透明的,用户只关心请求是否能返回相应的结果而已,和集群对用户透明的概念类似。同时,分布式架构中每个服务也可以做集群,可以发展为集群分布式系统架构,而且一个服务的集群对于其他服务来说也是透明的。微服务架构是属于分布式架构的一种,微服务架构是分布式架构的一个子集。

- 集群:你们公司业务增长的非常快,老板发现你一个后端忙不过来了,就又招了几个后端开发来协助你,这就是后端集群;再往后,发现前端也忙不过来了,又配备几个前端,就是前端集群。所以也不难看出,将应用拆分后,你可以有针对性地扩展单个服务,做成集群,这就是分布式的好处之一。

- 节点:这个也非常好理解,一个服务就是一个节点,比如你就是后端集群中的一个节点,而集群本身也可以看成是整个应用的一个集群节点。

- 副本:副本就是为服务和数据提供的冗余,保证高可用。

- 中间件:为开发者提供便利,屏蔽复杂的底层的一类框架组件。如服务管理通信、序列化、负载均衡等组件。

单体架构和分布式架构举例描述

举例来说,一个工人造汽车时,从左到右每个环节都是他来处理,最后得到一台整车。这时,服务的性能顶点就很低,因为一个人的能力是有限的。

当然我们也可以多请几个工人,多线进行,形成一个相当于服务集群的效果,当然这个是把整个服务的所有功能都进行了集群。但是又出现一个问题,比如说装底盘比较简单,几分钟就完成了,而装轮子比较难,几天都完成不了。那么影响汽车建造完成的瓶颈就在轮子上,我把整个流程复制一份,再请一个工人来做,成本提高了,但是效率却并没有提升这么大。因为装底盘本来就简单,我一个人就可以跟上生产的速度,我没必要两个人都要去装底盘。

为了解决这个问题,首先我们把人员分来,每个人只做自己擅长的事情,就像是流水线。这样学习时间会缩短,熟练之后效率也提高的快,这就形成了一个基本的分布式架构。

装轮子比较困难,一个人装需要几天时间,我可以多分配几个人一起装,这样可以提高这个步骤的安装时间,而其他步骤比较简单的,就保持一个人就行了。定向优化某一个服务,提高它的性能瓶颈,这样可以尽量缩短每个服务处理的时间差,成本也可以大大减少,这就形成了分布式集群架构。

分布式架构的优点

- 业务解耦:解耦之后方便性能优化。

- 系统模块化,可重用化:发布时也不用全部模块一起发布,只需要发布更新的模块就行了。

- 提升系统并发量:单体架构的并发量是有限的,而分布式架构可以集群某一个可承载并发量比较低的模块从而提升整体架构的并发量上限。

- 优化运维部署效率:迭代发布时,只需要根据模块发布,包比较轻巧,单体架构打包往往比较庞大。

分布式架构的缺点

- 架构比较复杂:功能多了,模块多,服务器也会更多,架构就更加复杂了

- 部署多个子系统复杂:当同时修改多个模块时,部署则需要同时更新多个服务器上面的应用

- 系统之间通信耗时:服务之间调用会有时间的损耗,这是不可避免的。

- 新人融入团队缓慢:架构复杂时,新人上手难度会变高

- 调试复杂:调用链路比较长的话,debug时往往需要同时启多个服务,打印日志也需要在多个服务中查看。

基本设计原则

- 异步解构:模块拆分之后,模块与模块之间的通信会有异步和同步之分。能使用异步尽量使用异步,不到万不得已不要使用同步,因为异步的效率往往要比同步高很多,异步解耦需要涉及到消息队列。

- 幂等一致性:用户的请求可能需要经过多个子系统,不管是查询或者增删改,多次操作或者重复操作数据的一致性是需要保证的。主要针对于增加和修改操作,因为查询多查几次结果都是一致的,删除删掉一次数据就没有了,多删几次也不会删掉别的数据,而增加假如没有处理好会增加很多条重复数据,会使应用出现问题。

- 拆分原则:可以根据业务来拆,比如说可以拆分成订单系统、文件系统、门户系统等;也可以根据系统功能来拆分比如把文件系统可以拆分成上传文件子系统、下载文件子系统等。

- 融合分布式中间件:比如Redis可以作为缓存,Zookeeper可以作为协调,MQ可以作为消息队列等,这些我们都可以把它融入到我们的系统中去。

- 容错高可用:每个服务单独部署都会容易产生单点故障,这是我们可以使用集群的方案来应对单点故障,集群和分布式技术是相辅相成的。

分布式架构需要使用到的技术

- 分布式缓存中间件Redis

- 分布式会话以及单点登录

- 分布式搜索引擎Elasticsearch

- 分布式文件系统

- 分布式消息队列

- 分布式锁

- 数据库读写分离以及分库分表

- 数据库表全局唯一主键id设计

- 分布式事务以及数据一致性

- 接口幂等设计以及分布式限流

分布式缓存和技术选型

什么是Redis

Redis(Remote Dictionary Server ),即远程字典服务,是一个开源的使用ANSI C语言编写、支持网络、可基于内存亦可持久化的日志型、Key-Value数据库,并提供多种语言的API。从2010年3月15日起,Redis的开发工作由VMware主持。从2013年5月开始,Redis的开发由Pivotal赞助。

Redis的出现,很大程度补偿了Memcached这类key/value存储的不足,在部分场合可以对关系数据库起到很好的补充作用。

它提供了Java,C/C++,C#,PHP,JavaScript,Perl,Object-C,Python,Ruby,Erlang等客户端,使用很方便。

和Memcached类似,它支持存储的value类型相对更多,包括string(字符串)、list(链表)、set(集合)、zset(sorted set --有序集合)和hash(哈希类型)。这些数据类型都支持push/pop、add/remove及取交集并集和差集及更丰富的操作,而且这些操作都是原子性的。在此基础上,Redis支持各种不同方式的排序。与Memcached一样,为了保证效率,数据都是缓存在内存中。

区别的是Redis会周期性的把更新的数据写入磁盘或者把修改操作写入追加的记录文件,并且在此基础上实现了master-slave(主从)同步。

数据可以从主服务器向任意数量的从服务器上同步,从服务器可以是关联其他从服务器的主服务器。这使得Redis可执行单层树复制。存盘可以有意无意的对数据进行写操作。由于完全实现了发布/订阅机制,使得从数据库在任何地方同步树时,可订阅一个频道并接收主服务器完整的消息发布记录。同步对读取操作的可扩展性和数据冗余很有帮助。

Redis的官网地址,非常好记,是redis.io。(域名后缀io属于国家域名,是british Indian Ocean territory,即英属印度洋领地)

特性和特点

Redis是现在最受欢迎的NoSQL数据库之一,Redis是一个使用ANSI C编写的开源、包含多种数据结构、支持网络、基于内存、可选持久性的键值对存储数据库,其具备如下特性:

- 基于内存运行,性能高效

- 支持分布式,理论上可以无限扩展

- key-value存储系统

- 开源的使用ANSI C语言编写、遵守BSD协议、支持网络、可基于内存亦可持久化的日志型、Key-Value数据库,并提供多种语言的API

相比于其他数据库类型,Redis具备的特点是:

- C/S通讯模型

- 单进程单线程模型

- 丰富的数据类型

- 操作具有原子性

- 持久化

- 高并发读写

- 支持lua脚本

参考链接:

为什么要引入Redis

在Web应用发展的初期,那时关系型数据库受到了较为广泛的关注和应用,原因是因为那时候Web站点基本上访问和并发不高、交互也较少。而在后来,随着访问量的提升,使用关系型数据库的Web站点多多少少都开始在性能上出现了一些瓶颈,而瓶颈的源头一般是在磁盘的I/O上。而随着互联网技术的进一步发展,各种类型的应用层出不穷,这导致在当今云计算、大数据盛行的时代,对性能有了更多的需求,主要体现在以下四个方面:

- 低延迟的读写速度:应用快速地反应能极大地提升用户的满意度

- 支撑海量的数据和流量:对于搜索这样大型应用而言,需要利用PB级别的数据和能应对百万级的流量

- 大规模集群的管理:系统管理员希望分布式应用能更简单的部署和管理

- 庞大运营成本的考量:IT部门希望在硬件成本、软件成本和人力成本能够有大幅度地降低

为了克服这一问题,NoSQL应运而生,它同时具备了高性能、可扩展性强、高可用等优点,受到广泛开发人员和仓库管理人员的青睐。

现有架构分析

- 浏览器访问时,请求先到LVS,使用Keepalived让两台LVS达成一个主备关系或者双主热备关系

- LVS的之后是Nginx集群,LVS是四层负载均衡,使用DR模式使请求通过LVS,而响应直接由应用响应到浏览器

- 每个Nginx集群的每一个节点都使用了upstream模块,配置了tomcat集群

- 因为每个应用服务是完全相同的,所以他们的都会连接到同一个数据库,现在应用的性能瓶颈就在应用到数据库之间

- 在应用的时,对于数据库来说当中有一个二八原则,请求中百分之八十都是读请求,写请求远远少于读请求

举个例子,假如系统中有2千万用户信息,用户信息基本固定,一旦录入很少变动,那么你每次加载所有用户信息时,如果都要请求数据库,数据库编译并执行你的查询语句,这样效率就会低下很多,针对这种信息不经常变动并且数据量较大的情况,通常做法,就是把他加入缓存,每次取数前先去判断,如果缓存不为空,那么就从缓存取值,如果为空,再去请求数据库,并将数据加入缓存,这样大大提高系统访问效率。

其次,假如有一个明星的负面新闻被曝光在微博上了,这时会有几千万上亿的请求会访问到它。对于这种高流量的热点新闻,我们也可以加入缓存,减缓数据库压力,是数据库不会被上亿的流量冲垮。

所以,我们可以使用Redis缓存把应用服务和数据库分隔开,把一些热点数据和不经常变动的数据放到缓存中,让上亿的请求访问到Redis,而不会直接接触数据库,从而达到保护数据库的效果。相当于提高了数据库的读取这类型数据的性能,也就是提高了应用服务的性能和吞吐量,也可以承载更多的并发。

Redis的作用

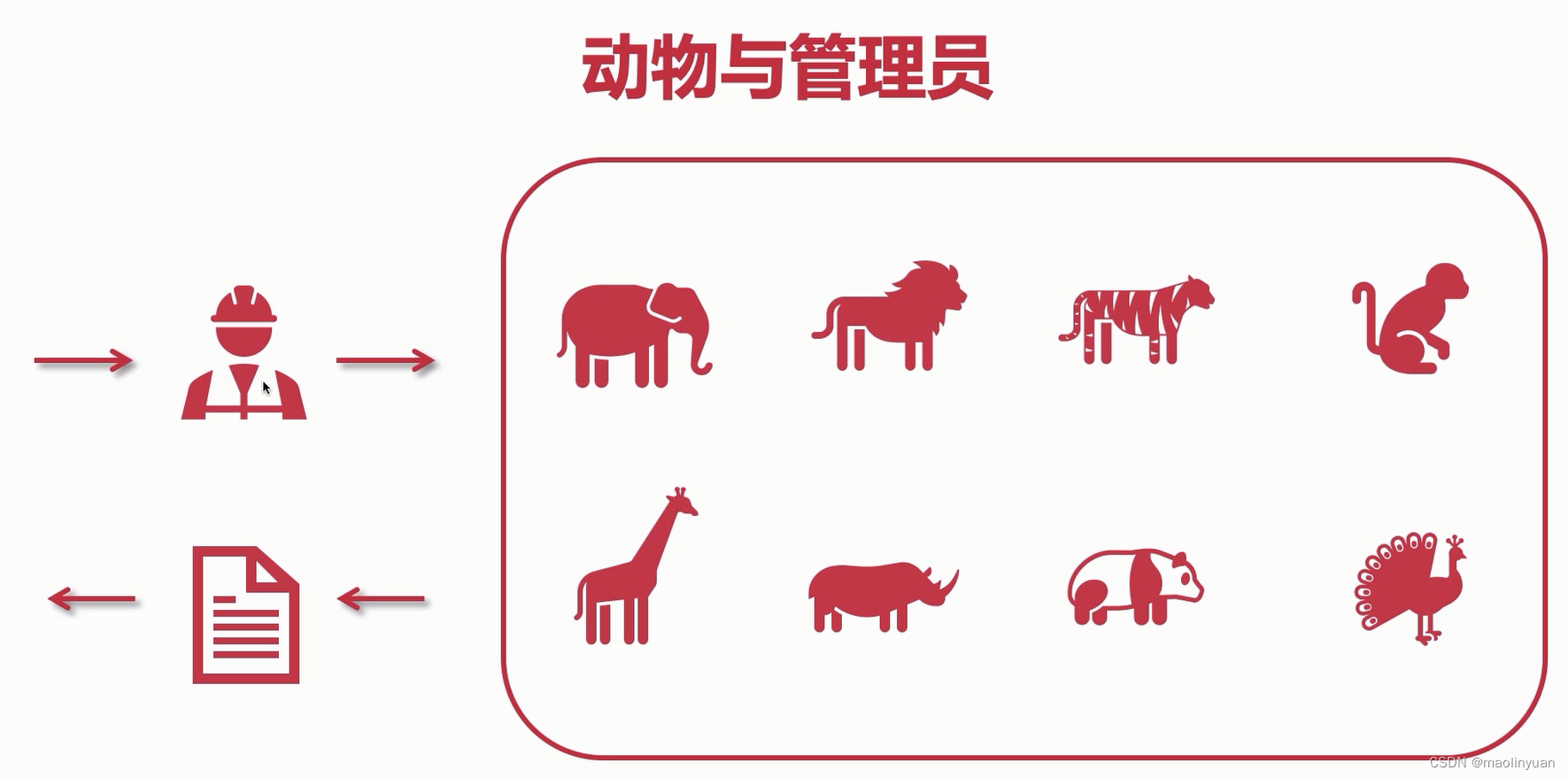

动物园中有各种动物,当游客来到动物园中,她想要知道大熊猫有多少只。她去询问管理员时,管理员进去动物园中数了数大熊猫的数量,返回到原来的地方告诉游客她想要知道的信息。这时若客流量突然变大时,管理员对于每一个人的问题都要去动物园中寻找,他就会非常累。

管理员灵机一动想到了一个方法,他每次去动物园中寻找时,把问题和问题对应的结果写到一个账本上。久而久之,账本上记录的问题和数据越来越多。

当他遇到有人问到之前记录过的一个问题时,他就会直接把账本上的问题答案回答给游客,就不用再一次进去动物园中了。这时,他能接待的客流量就增多了。

这时又会出现一个问题,当动物园中动物的数据发生变化之后,账本和真实数据就对应不上了。这就要靠动物园中的维护人员来保证数据的一致性了,当动物园中动物数据发生变化之后,维护人员要及时修改账本的数据,使其数据和真实数据保持一致。

而账本就相当于我们架构中的Redis,管理员和动物园相当于数据库,这样我们应用的并发量和吞吐量也就提高了,当原有数据发生变化时(新增或修改),要及时更新Redis中缓存的数据,保证数据一致性。

什么是NoSql

NoSQL(NoSQL = Not Only SQL ),意即"不仅仅是SQL"。

- 平时我们使用的最多的数据库MySql、postgreSql等等都是关系型数据库,NoSql则是非关系型数据库

- 对于关系型数据库来说,是需要把数据存储到库、表、行、字段里,查询的时候根据条件一行一行地去匹配,当量非常大的时候就很耗费时间和资源,尤其是数据是需要从磁盘里去检索

- NoSQL数据库存储原理非常简单(典型的数据类型为k-v),不存在繁杂的关系链,比如mysql查询的时候,需要找到对应的库、表(通常是多个表)以及字段

- NoSQL数据可以存储在内存里,查询速度非常快

- NoSQL在性能表现上虽然能优于关系型数据库,但是它并不能完全替代关系型数据库

- NoSQL因为没有复杂的数据结构,扩展非常容易,支持分布式

传统项目都是使用关系型数据库,访问量也不是很大,任何请求过来直接查询数据库也不会造成什么影响。当今互联网中数据量越来越大,请求数和并发要求越来越高,而传统的纯数据库架构设计慢慢的不能满足我们的需求。普通的关系型数据库不再适合把超大量的数据提供出去做并发型的查询(用户信息,地理信息,购物信息等)。数据库单表的性能是有限的,数据库做的好优化的好的话单表数据量能到达400w-600w的样子,而一般一点的最多只能到300w-400w,就会对应用的性能造成很大的影响。

一旦数据量达到300w时,数据库管理员(DBA)就要及时准备数据库的优化方案,从而的对数据库进行优化。数据库的数据量庞大之后,关系型数据库也不适合对数据进行深挖(数据挖掘、大数据分析等)。这时使用NoSql就是顺势而为,NoSql水平(横向)扩展非常方便高效。Redis的数据结构是key-value的这种结构,存储形式是非常简单的,所以扩展起来就非常容易,而且由于是键值对这种形式,增加或者删除缓存中的数据会非常高效。数据库中数据量到达上百万的话,数据库中增加和删除数据性能会非常差,若是针对字段的新增或者删除其对性能的影响更是灾难性的,对于整体的数据会有非常大的影响。

对于Redis来说,它的读取性能是非常高的,每秒能达到十万次,远远大于传统关系型数据库。还能搭建集群,而且非常容易。可以存储数据,也可以对于缓存的数据进行持久化(不同的NoSql,对于持久化的支持情况不同)。

NoSql的分类

键值对数据库

相关产品:Redis、Riak、SimpleDB、Chordless、Scalaris、Memcached

应用:内容缓存

优点:扩展性好、灵活性好、大量写操作时性能高

缺点:无法存储结构化信息、条件查询效率较低

使用者:百度云(Redis)、GitHub(Riak)、BestBuy(Riak)、Twitter(Ridis和Memcached)

列存储数据库

相关产品:BigTable、HBase、Cassandra、HadoopDB、GreenPlum、PNUTS

应用:分布式数据存储与管理

优点:查找速度快、可扩展性强、容易进行分布式扩展、复杂性低

使用者:Ebay(Cassandra)、Instagram(Cassandra)、NASA(Cassandra)、Facebook(HBase)

文档型数据库

相关产品:MongoDB、CouchDB、ThruDB、CloudKit、Perservere、Jackrabbit

应用:存储、索引并管理面向文档的数据或者类似的半结构化数据

优点:性能好、灵活性高、复杂性低、数据结构灵活

缺点:缺乏统一的查询语言

使用者:百度云数据库(MongoDB)、SAP(MongoDB)

图形数据库

相关产品:Neo4J、OrientDB、InfoGrid、GraphDB

应用:大量复杂、互连接、低结构化的图结构场合,如社交网络、推荐系统等

优点:灵活性高、支持复杂的图形算法、可用于构建复杂的关系图谱

缺点:复杂性高、只能支持一定的数据规模

使用者:Adobe(Neo4J)、Cisco(Neo4J)、T-Mobile(Neo4J)

参考链接:

总结:Redis、Memcached、MongoDB是国内使用的最多的数据库,假如一个项目没有使用到任何一个NoSql则可以断定这是一个非常传统的项目

什么是分布式缓存

在高并发的分布式的系统中,缓存是必不可少的一部分。没有缓存对系统的加速和阻挡大量的请求直接落到系统的底层,系统是很难撑住高并发的冲击,所以分布式系统中缓存的设计是很重要的一环。

在高并发的场景下,通过分布式缓存可以提高数据的读取数据,相应的应用的性能和吞吐量就提高了。这里只针对读操作,读取数据时尽量在缓存中读取,可以降低数据库对服务器性能的开支,降低服务器的压力,而写操作时才把数据直接写到数据库,这里遵循二八原则(百分之八十都是读操作)。Redis是基于内存的,读写性能远远高于磁盘存储的数据库。一般情况下,尽量让大部分查询请求去命中缓存,少量的请求根据需要直接操作数据库。在分布式系统中,分布式缓存中的数据可以被所有服务访问到,可以很轻松的实现服务之间数据的共享。

使用缓存我们得到以下收益:

-

加速读写。因为缓存通常是全内存的,比如Redis、Memcache。对内存的直接读写会比传统的存储层如MySQL,性能好很多。举个例子:同等配置单机Redis QPS可轻松上万,MySQL则只有几千。加速读写之后,响应时间加快,相比之下系统的用户体验能得到更好的提升。

-

降低后端的负载。缓存一些复杂计算或者耗时得出的结果可以降低后端系统对CPU、IO、线程这些资源的需求,让系统运行在一个相对资源健康的环境。

但随之以来也有一些成本:

- 数据不一致性:缓存层与存储层的数据存在着一定时间窗口一致,时间窗口与缓存的过期时间更新策略有关。

- 代码维护成本:加入缓存后,需要同时处理缓存层和存储层的逻辑,增加了开发者维护代码的成本。

- 运维成本:引入缓存层,比如Redis。为保证高可用,需要做主从,高并发需要做集群。

综合起来,只要收益大于成本,我们就可以采用缓存。

参考链接:

缓存方案的对比

Ehcache

Ehcache 是一个纯Java的进程内缓存框架,具有快速、精干等特点,是Hibernate中默认CacheProvider。Ehcache是一种广泛使用的开源Java分布式缓存。主要面向通用缓存,Java EE和轻量级容器。它具有内存和磁盘存储、缓存加载器、缓存扩展、缓存异常处理程序、一个gzip缓存servlet过滤器、支持REST和SOAP API等特点。

Spring 提供了对缓存功能的抽象:即允许绑定不同的缓存解决方案(如Ehcache),但本身不直接提供缓存功能的实现。它支持注解方式使用缓存,非常方便。

特性

- 快速、简单

- 多种缓存策略

- 缓存数据有两级:内存和磁盘,因此无需担心容量问题

- 缓存数据会在虚拟机

重启的过程中写入磁盘 - 可以通过RMI、可插入API等方式进行分布式缓存

- 具有缓存和缓存管理器的侦听接口

- 支持

多缓存管理器实例,以及一个实例的多个缓存区域 - 提供Hibernate的缓存实现

优点

- 基于Java开发:对于Java项目的整合,其代码的健壮性比较好

- 基于JVM缓存:在JVM中使用的话,速度比较快,性能也会更高

- 简单、轻巧、方便:整合起来非常容易,很多框架都整合了Ehchache,例如:hibernate

缺点

- 集群不支持:不支持缓存共享,对于集群的实现非常复杂,维护起来也非常不方便

- 分布式不支持:Ehchache更加适合于单应用以及快速开发

集成

可以单独使用,一般在第三方库中被用到的比较多(如mybatis、shiro等)Ehcache 对分布式支持不够好,多个节点不能同步,通常和redis一块使用

灵活性

Ehcache具备对象api接口和可序列化api接口

不能序列化的对象可以使用出磁盘存储外Ehcache的所有功能

支持基于Cache和基于Element的过期策略,每个Cache的存活时间都是可以设置和控制的。

提供了LRU、LFU和FIFO缓存淘汰算法,Ehcache 1.2引入了最少使用和先进先出缓存淘汰算法,构成了完整的缓存淘汰算法。

提供内存和磁盘存储,Ehcache和大多数缓存解决方案一样,提供高性能的内存和磁盘存储。

动态、运行时缓存配置,存活时间、空闲时间、内存和磁盘存放缓存的最大数目都是可以在运行时修改的。

应用持久化

在jvm重启后,持久化到磁盘的存储可以复原数据

Ehache是第一个引入缓存数据持久化存储的开源java缓存框架,缓存的数据可以在机器重启后从磁盘上重新获得

根据需要将缓存刷到磁盘。将缓存条目刷到磁盘的操作可以通过cache.fiush方法执行,这大大方便了Ehcache的使用

Ehcache和Redis 比较

- Ehcache直接在jvm虚拟机中缓存,速度快,效率高;但是缓存共享麻烦,集群分布式应用不方便。

- Redis是通过socket访问到缓存服务,效率比Ecache低,比数据库要快很多,处理集群和分布式缓存方便,有成熟的方案。如果是单个应用或者对缓存访问要求很高的应用,用Ehcache。如果是大型系统,存在缓存共享、分布式部署、缓存内容很大的,建议用Redis。

参考链接:

Memcache

Memcache是一个自由、源码开放、高性能、分布式的分布式内存对象缓存系统,用于动态Web应用以减轻数据库的负载。它通过在内存中缓存数据和对象来减少读取数据库的次数,从而提高了网站访问的速度。Memcache是一个存储键值对的HashMap,在内存中对任意的数据(比如字符串、对象等)所使用的key-value存储,数据可以来自数据库调用、API调用,或者页面渲染的结果。Memcache设计理念就是小而强大,它简单的设计促进了快速部署、易于开发并解决面对大规模的数据缓存的许多难题,而所开放的API使得Memcache能用于Java、C/C++/C#、Perl、Python、PHP、Ruby等大部分流行的程序语言。

Memcache通过在内存里维护一个统一的巨大的hash表,它能够用来存储各种格式的数据,包括图像、视频、文件以及数据库检索的结果等。简单的说就是将数据调用到内存中,然后从内存中读取,从而大大提高读取速度。Memcached是以守护程序(监听)方式运行于一个或多个服务器中,随时会接收客户端的连接和操作。

另外,说一下Memcache和Memcached的区别:

-

Memcache是项目的名称

-

Memcached是Memcache服务器端可以执行文件的名称

特性和限制

- 在 Memcached中可以保存的item数据量是没有限制的,只要内存足够 。

- Memcached单进程在32位系统中最大使用内存为2G,若在64位系统则没有限制,这是由于32位系统限制单进程最多可使用2G内存,要使用更多内存,可以分多个端口开启多个Memcached进程 。

- 最大30天的数据过期时间,设置为永久的也会在这个时间过期,常量REALTIME_MAXDELTA 60 * 60 * 24 * 30控制

- 最大键长为250字节,大于该长度无法存储,常量KEY_MAX_LENGTH 250控制

- 单个item最大数据是1MB,超过1MB数据不予存储,常量POWER_BLOCK 1048576进行控制,它是默认的slab大小

- Memcache服务端是不安全的,比如已知某个Memcache节点,可以直接telnet过去,并通过flush_all让已经存在的键值对立即失效

- Memcache的高性能源自于两阶段哈希结构:第一阶段在客户端,通过Hash算法根据Key值算出一个节点;第二阶段在服务端,通过一个内部的Hash算法,查找真正的item并返回给客户端。从实现的角度看,Memcache是一个非阻塞的、基于事件的服务器程序

- 最大同时连接数是200,通过 conn_init()中的freetotal进行控制,最大软连接数是1024,通过 settings.maxconns=1024 进行控制

- 跟空间占用相关的参数:settings.factor=1.25, settings.chunk_size=48, 影响slab的数据占用和步进方式

- memcached是一种无阻塞的socket通信方式服务,基于libevent库,由于无阻塞通信,对内存读写速度非常之快。

- memcached分服务器端和客户端,可以配置多个服务器端和客户端,应用于分布式的服务非常广泛。

- memcached作为小规模的数据分布式平台是十分有效果的。

- memcached是键值一一对应,key默认最大不能超过128个字 节,value默认大小是1M,也就是一个slabs,如果要存2M的值(连续的),不能用两个slabs,因为两个slabs不是连续的,无法在内存中 存储,故需要修改slabs的大小,多个key和value进行存储时,即使这个slabs没有利用完,那么也不会存放别的数据。

- memcached已经可以支持C/C++、Perl、PHP、Python、Ruby、Java、C#、Postgres、Chicken Scheme、Lua、MySQL和Protocol等语言客户端

参考链接:

优点

- 部分容灾:假设只用一台Memcache,如果这台Memcache服务器挂掉了,那么请求将不断的冲击数据库,这样有可能搞死数据库,从而引发”雪崩“。如果使用多台Memcache服务器,由于Memcache使用一致性哈希算法,万一其中一台挂掉了,部分请求还是可以在Memcache中命中,为修复系统赢得一些时间。

- 横向扩展简单:一台Memcache服务器的容量毕竟有限,可以使用多台Memcache服务器,增加缓存容量。

- 均衡请求:使用多台Memcache服务器,可以均衡请求,避免所有请求都冲进一台Memcache服务器,导致服务器挂掉。

- 多核运行:Memcache 可以利用多核优势,单实例吞吐量极高,可以达到几十万 QPS(取决于 key、value 的字节大小以及服务器硬件性能,日常环境中 QPS 高峰大约在 4-6w 左右)。适用于最大程度扛量。

- 支持直接配置为 session handle。

缺点

-

只支持简单的 key/value 数据结构,不像 Redis 可以支持丰富的数据类型。

-

无法进行持久化,数据不能备份,只能用于缓存使用,且重启后数据全部丢失。

-

无法进行数据同步,不能将Memcache中的数据迁移到其他Memcache实例中。

-

Memcached 内存分配采用 Slab Allocation 机制管理内存,value 大小分布差异较大时会造成内存利用率降低,并引发低利用率时依然出现踢出等问题。需要用户注重 value 设计。

Memcache和Redis比较

- 持久化能力:Redis支持持久化,Memcache也支持但一般不做持久化(重启丢失数据)

- 数据类型支持:Redis类型较多(5种数据类型,string、list、hash、set、sorted set),Memcache只能是字符串

- 线程模型:Redis是单线程+多路IO复用,虽然没有锁冲突,但很难利用多核特性提升整体吞吐量。Memcache是多线程+锁的方式,主线程监听,work子线程接收请求,执行读写,有锁冲突。;

- 数据库特征:Redis不是所有的数据都存储在内存,在很多方面具备数据库的特征,Memcache只是简单的kv缓存;相当于Memcache更像是redis在功能上的一个子集。

- 高可用支持:高可用(redis原生支持高可用功能,可以实现主从复制,哨兵模式,redis集群模式,而Memcache要实现高可用,需要进行二次开发,例如客户端的双读双写,或者服务端的集群同步)(延伸:虽然数据类型单一,但是Memcache的内存管理机制导致无碎片,这让Memcache工作更加稳定,而redis本身也考虑到自己功能复杂,会产生碎片,并且容易崩溃,所以支持高可用)

- 内容大小比较:Redis存储的内容比较大(Memcache的value存储最大是1M,如果存储value很大,只能选择redis)

- 内存分配:memchache使用预分配内存池的方式管理内存,能够省区内存分配的时间,这个节省的时间在数据量很大的时候还是很可观的。而redis则是临时申请空间,可能导致碎片。Redis和Memcache在写入性能上面差别不大的,读取性能上面尤其是批量读取性能上面Memcache更强的。

参考链接:

Redis

简单来说 Redis 就是一个用C语言写的数据库,不过与传统数据库不同的是 Redis 的数据是存在内存中的,所以读写速度非常快,因此 Redis 被广泛应用于缓存方向。另外,Redis 也经常用来做分布式锁。Redis 提供了多种数据类型来支持不同的业务场景。除此之外,Redis 支持事务 、持久化、LUA脚本、LRU驱动事件、多种集群方案。

Redis是一个开源的,先进的key-value持久化产品。它通常被称为数据结构服务器,它的值可以是字符串(String)、哈希(Map)、列表(List)、集合(Sets)和有序集合(Sorted sets)等类型。可以在这些类型上面做一些原子操作,如:字符串追加、增加Hash里面的值、添加元素到列表、计算集合的交集,并集和差集;或者区有序集合中排名最高的成员。为了取得好的性能,Redis是一个内存型数据库。不限于此,Redis也可以把数据持久化到磁盘中,或者把数据操作指令追加了一个日志文件,把它用于持久化。也可以用Redis容易的搭建master-slave架构用于数据复制。其它让它像缓存的特性包括,简单的check-and-set机制,pub/sub和配置设置。Redis可以用大部分程序语言来操作:C、C++、C#、Java、Node.js、php、ruby等等。

特性

-

速度快

正常情况下,Redis执行命令的速度非常快,官方给出的数字是读写性能可以达到10万/秒,当然这也取决于机器的性能,但这里先不讨论机器性能上的差异,只分析一下是什么造就了Redis除此之快的速度,可以大致归纳为以下三点:

- Redis的所有数据都是存放在内存中的,所以把数据放在内存中是Redis速度快的最主要原因。

- Redis是用C语言实现的,一般来说C语言实现的程序“距离”操作系统更近,执行速度相对会更快。

- Redis使用了单线程架构,预防了多线程可能产生的竞争问题。

-

基于键值对的数据结构服务器

几乎所有的编程语言都提供了类似字典的功能,例如Java里的map、Python里的dict,类似于这种组织数据的方式叫作基于键值的方式,与很多键值对数据库不同的是,Redis中的值不仅可以是字符串,而且还可以是具体的数据结构,这样不仅能便于在许多应用场景的开发,同时也能够提高开发效率。Redis的全称是REmote Dictionary Server,它主要提供了5种数据结构:字符串、哈希、列表、集合、有序集合。

-

丰富的功能

除了5种数据结构,Redis还提供了许多额外的功能:

- 提供了键过期功能,可以用来实现缓存。

- 提供了发布订阅功能,可以用来实现消息系统。

- 支持Lua脚本功能,可以利用Lua创造出新的Redis命令。

- 提供了简单的事务功能,能在一定程度上保证事务特性。

- 提供了流水线(Pipeline)功能,这样客户端能将一批命令一次性传到Redis,减少了网络的开销。

-

简单稳定

Redis的简单主要表现在三个方面。

- Redis的源码很少。

- Redis使用单线程模型,这样不仅使得Redis服务端处理模型变得简单,而且也使得客户端开发变得简单。

- Redis不需要依赖于操作系统中的类库(例如Memcache需要依赖libevent这样的系统类库),Redis自己实现了事件处理的相关功能。

- Redis虽然很简单,但是不代表它不稳定。维护的上千个Redis为例,没有出现过因为Redis自身bug而宕掉的情况。

-

客户端语言多

Redis提供了简单的TCP通信协议,很多编程语言可以很方便地接入到Redis,并且由于Redis受到社区和各大公司的广泛认可,所以支持Redis的客户端语言也非常多,几乎涵盖了主流的编程语言,例如Java、PHP、Python、C、C++、Nodejs等。

-

持久化

通常看,将数据放在内存中是不安全的,一旦发生断电或者机器故障,重要的数据可能就会丢失,因此Redis提供了两种持久化方式:RDB和AOF,即可以用两种策略将内存的数据保存到硬盘中(如图所示)这样就保证了数据的可持久性。

-

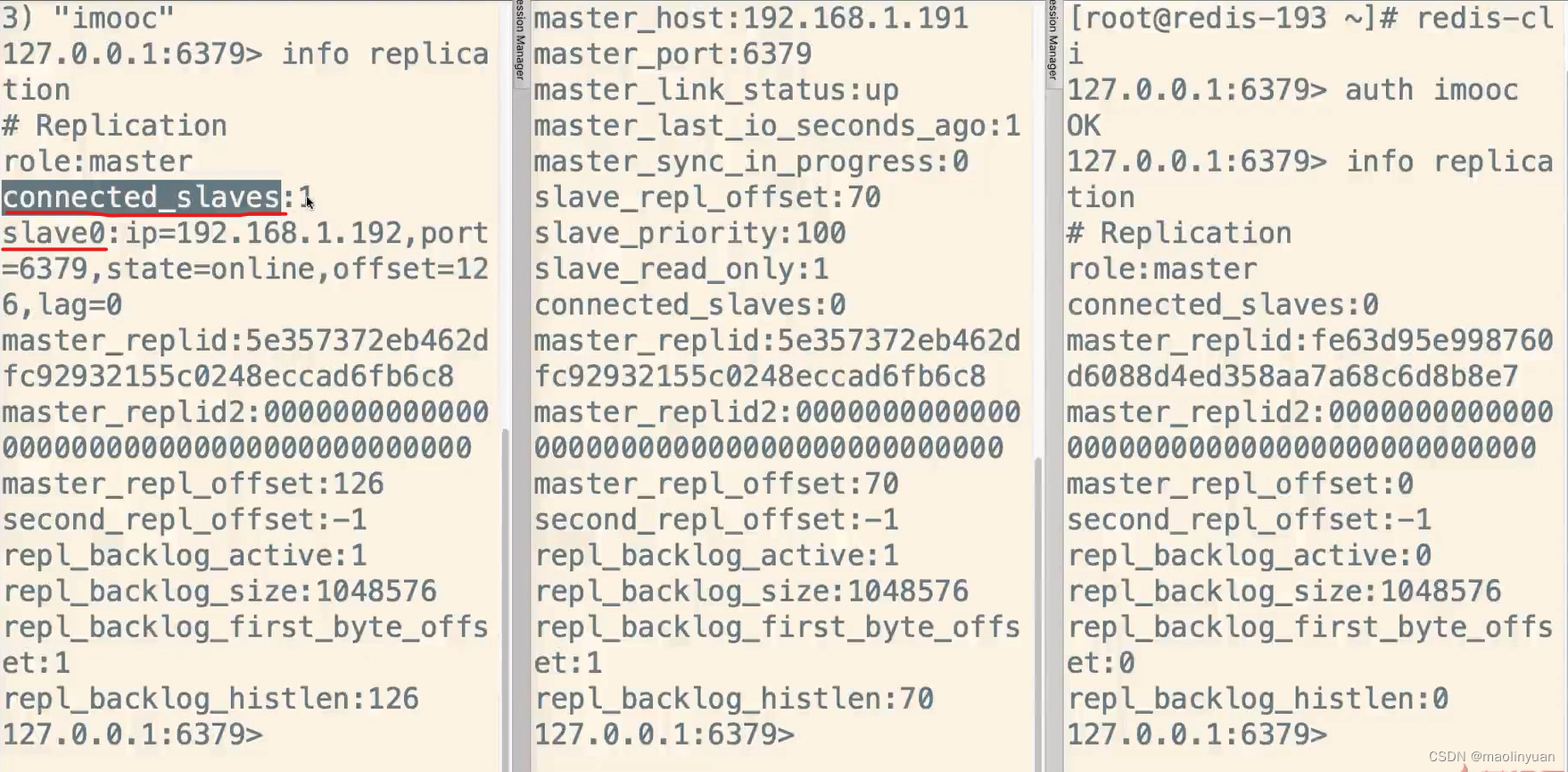

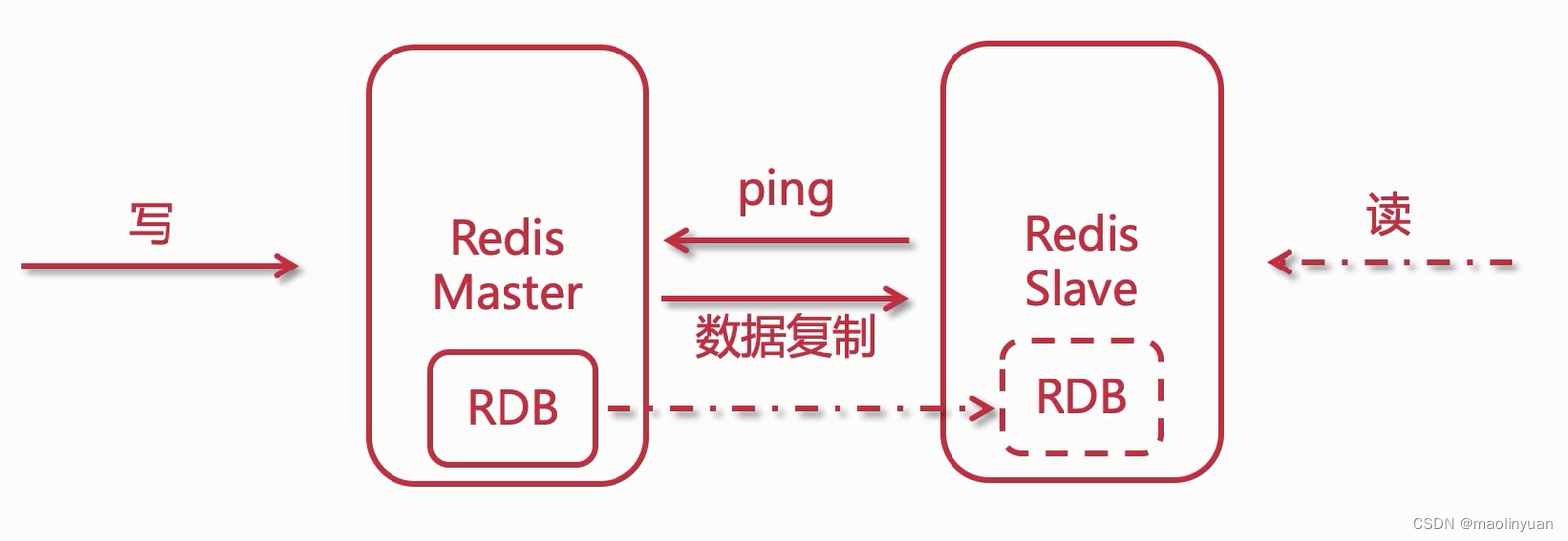

主从复制

Redis提供了复制功能,实现了多个相同数据的Redis副本(如图所示),复制功能是分布式Redis的基础。

-

高可用和分布式

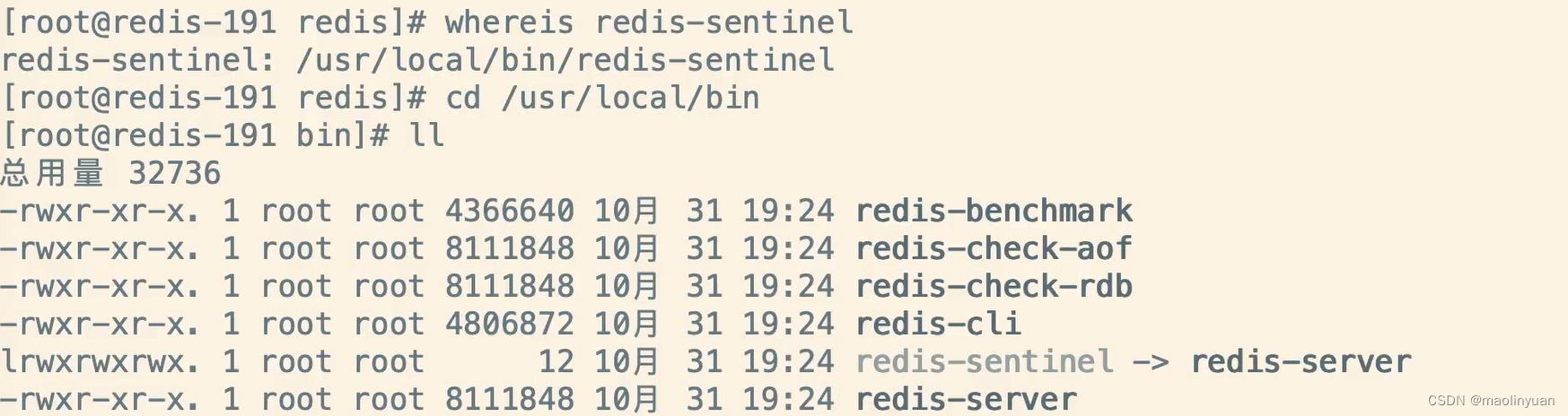

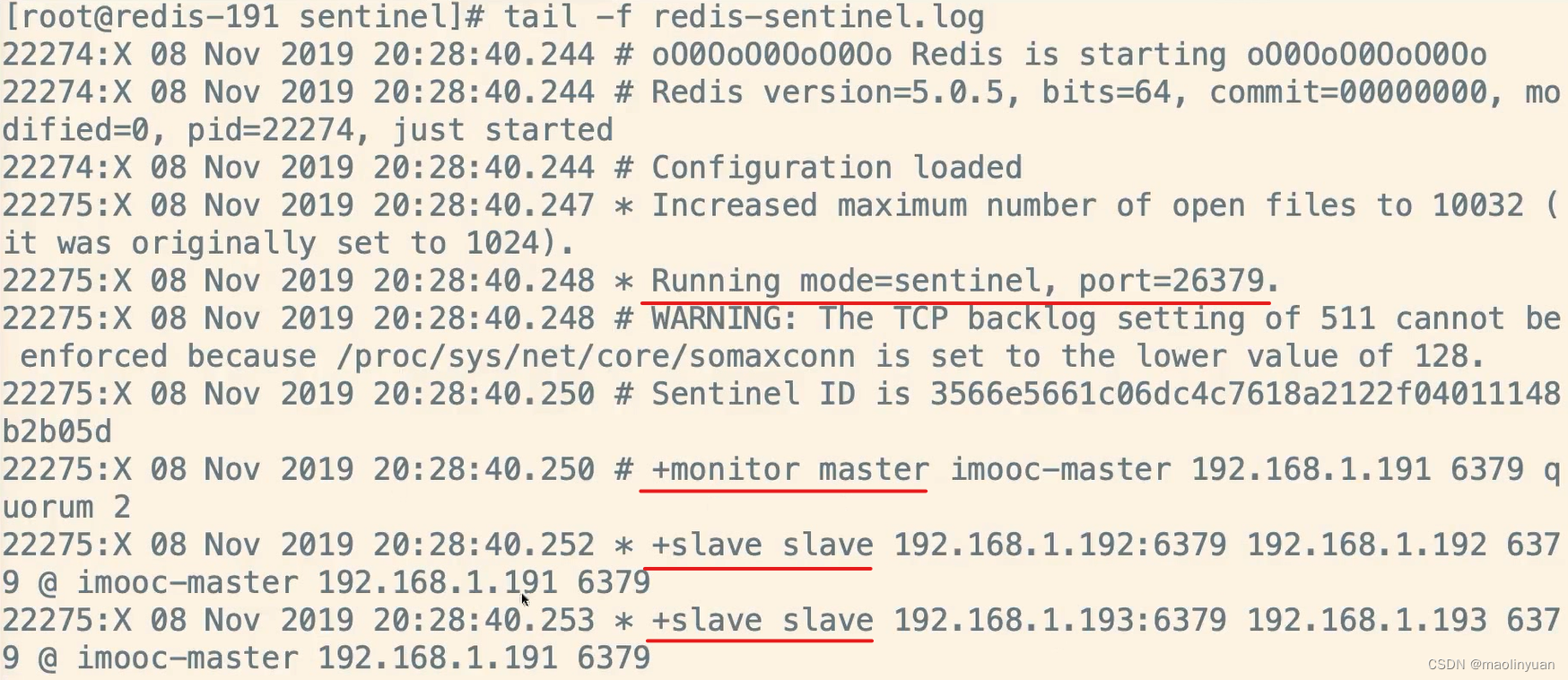

Redis从2.8版本正式提供了高可用实现Redis Sentinel,它能够保证Redis节点的故障发现和故障自动转移。Redis从3.0版本正式提供了分布式实现Redis Cluster,它是Redis真正的分布式实现,提供了高可用、读写和容量的扩展性。

参考链接:

优点

- 支持多种数据类型:包括set,zset,list,hash,string这五种数据类型,操作非常方便。比如,如果你在做好友系统,查看自己的好友关系,如果采用其他的key-value系统,则必须把对应的好友拼接成字符串,然后在提取好友时,再把value进行解析,而Redis则相对简单,直接支持list的存储(采用双向链表或者压缩链表的存储方式)。

- 持久化存储:作为一个内存数据库,最担心的,就是万一机器死机,数据会消失掉。redi使用rdb和aof做数据的持久化存储。主从数据同时,生成rdb文件,并利用缓冲区添加新的数据更新操作做对应的同步。

- 丰富的特性:pub/sub,key过期策略,事务,支持多个DB等。

- 性能很好:由于是全内存操作,所以读写性能很好,可以达到10w/s的频率。公司有项目使用Redis,目前的访问频率是80w/s,通过适当的部署,线上运行一切ok。

缺点

- 由于是内存数据库,所以,单台机器,存储的数据量,跟机器本身的内存大小。虽然Redis本身有key过期策略,但是还是需要提前预估和节约内存。如果内存增长过快,需要定期删除数据。

- 如果进行完整重同步,由于需要生成rdb文件,并进行传输,会占用主机的CPU,并会消耗现网的带宽。不过Redis2.8版本,已经有部分重同步的功能,但是还是有可能有完整重同步的。比如,新上线的备机。

- 修改配置文件,进行重启,将硬盘中的数据加载进内存,时间比较久。在这个过程中,Redis不能提供服务。

相关问题

-

数据库和缓存双写一致性问题:一致性问题是分布式常见问题,还可以再分为最终一致性和强一致性。数据库和缓存双写,就必然会存在不一致的问题。就是如果对数据有强一致性要求,不能放缓存。我们所做的一切,只能保证最终一致性。另外,我们所做的方案其实从根本上来说,只能说降低不一致发生的概率,无法完全避免。因此,有强一致性要求的数据,不能放缓存。

-

缓存穿透:即黑客故意去请求缓存中不存在的数据,导致所有的请求都怼到数据库上,从而数据库连接异常。解决方案:

- 利用互斥锁,缓存失效的时候,先去获得锁,得到锁了,再去请求数据库。没得到锁,则休眠一段时间重试

- 采用异步更新策略,无论key是否取到值,都直接返回。value值中维护一个缓存失效时间,缓存如果过期,异步起一个线程去读数据库,更新缓存。需要做缓存预热(项目启动前,先加载缓存)操作。

- 提供一个能迅速判断请求是否有效的拦截机制,比如,利用布隆过滤器,内部维护一系列合法有效的key。迅速判断出,请求所携带的Key是否合法有效。如果不合法,则直接返回。

-

缓存雪崩:即缓存同一时间大面积的失效,这个时候又来了一波请求,结果请求都怼到数据库上,从而导致数据库连接异常。解决方案:

- 给缓存的失效时间,加上一个随机值,避免集体失效。

- 使用互斥锁,但是该方案吞吐量明显下降了。

- 双缓存。我们有两个缓存,缓存A和缓存B。缓存A的失效时间为20分钟,缓存B不设失效时间。自己做缓存预热操作。然后细分以下几个小点

- 从缓存A读数据库,有则直接返回

- A没有数据,直接从B读数据,直接返回,并且异步启动一个更新线程。

- 更新线程同时更新缓存A和缓存B。

-

缓存的并发竞争:同时有多个子系统去set一个key。

-

如果对这个key操作,不要求顺序:这种情况下,准备一个分布式锁,大家去抢锁,抢到锁就做set操作即可,比较简单。

-

如果对这个key操作,要求顺序:(假设有一个key1,系统A需要将key1设置为valueA,系统B需要将key1设置为valueB,系统C需要将key1设置为valueC)期望按照key1的value值按照 valueA–>valueB–>valueC的顺序变化。这种时候我们在数据写入数据库的时候,需要保存一个时间戳。假设时间戳如下:

- 系统A key 1 {valueA 3:00}

- 系统B key 1 {valueB 3:05}

- 系统C key 1 {valueC 3:10}

那么,假设这会系统B先抢到锁,将key1设置为{valueB 3:05}。接下来系统A抢到锁,发现自己的valueA的时间戳早于缓存中的时间戳,那就不做set操作了。以此类推。

其他方法,比如利用队列,将set方法变成串行访问也可以。总之,灵活变通。

-

-

Redis的过期策略以及内存淘汰机制:Redis采用的是定期删除+惰性删除策略。

-

为什么不用定时删除策略?

定时删除,用一个定时器来负责监视key,过期则自动删除。虽然内存及时释放,但是十分消耗CPU资源。在大并发请求下,CPU要将时间应用在处理请求,而不是删除key,因此没有采用这一策略。

-

定期删除+惰性删除是如何工作的呢?

定期删除,Redis默认每个100ms检查,是否有过期的key,有过期key则删除。需要说明的是,Redis不是每个100ms将所有的key检查一次,而是随机抽取进行检查(如果每隔100ms,全部key进行检查,Redis岂不是卡死)。因此,如果只采用定期删除策略,会导致很多key到时间没有删除。于是,惰性删除派上用场。也就是说在你获取某个key的时候,Redis会检查一下,这个key如果设置了过期时间那么是否过期了?如果过期了此时就会删除。

-

采用定期删除+惰性删除就没其他问题了么?

不是的,如果定期删除没删除key。然后你也没即时去请求key,也就是说惰性删除也没生效。这样,Redis的内存会越来越高。那么就应该采用内存淘汰机制。

在redis.conf中有一行配置:

# maxmemory-policy volatile-lru

该配置就是配内存淘汰策略的

- noeviction:当内存不足以容纳新写入数据时,新写入操作会报错。应该没人用吧。

- allkeys-lru:当内存不足以容纳新写入数据时,在键空间中,移除最近最少使用的key。推荐使用,目前项目在用这种。

- allkeys-random:当内存不足以容纳新写入数据时,在键空间中,随机移除某个key。应该也没人用吧,你不删最少使用Key,去随机删。

- volatile-lru:当内存不足以容纳新写入数据时,在设置了过期时间的键空间中,移除最近最少使用的key。这种情况一般是把Redis既当缓存,又做持久化存储的时候才用。不推荐

- volatile-random:当内存不足以容纳新写入数据时,在设置了过期时间的键空间中,随机移除某个key。依然不推荐

- volatile-ttl:当内存不足以容纳新写入数据时,在设置了过期时间的键空间中,有更早过期时间的key优先移除。不推荐

- ps:如果没有设置 expire 的key, 不满足先决条件(prerequisites); 那么 volatile-lru, volatile-random 和 volatile-ttl 策略的行为, 和 noeviction(不删除) 基本上一致。

-

参考链接:

Redis的使用

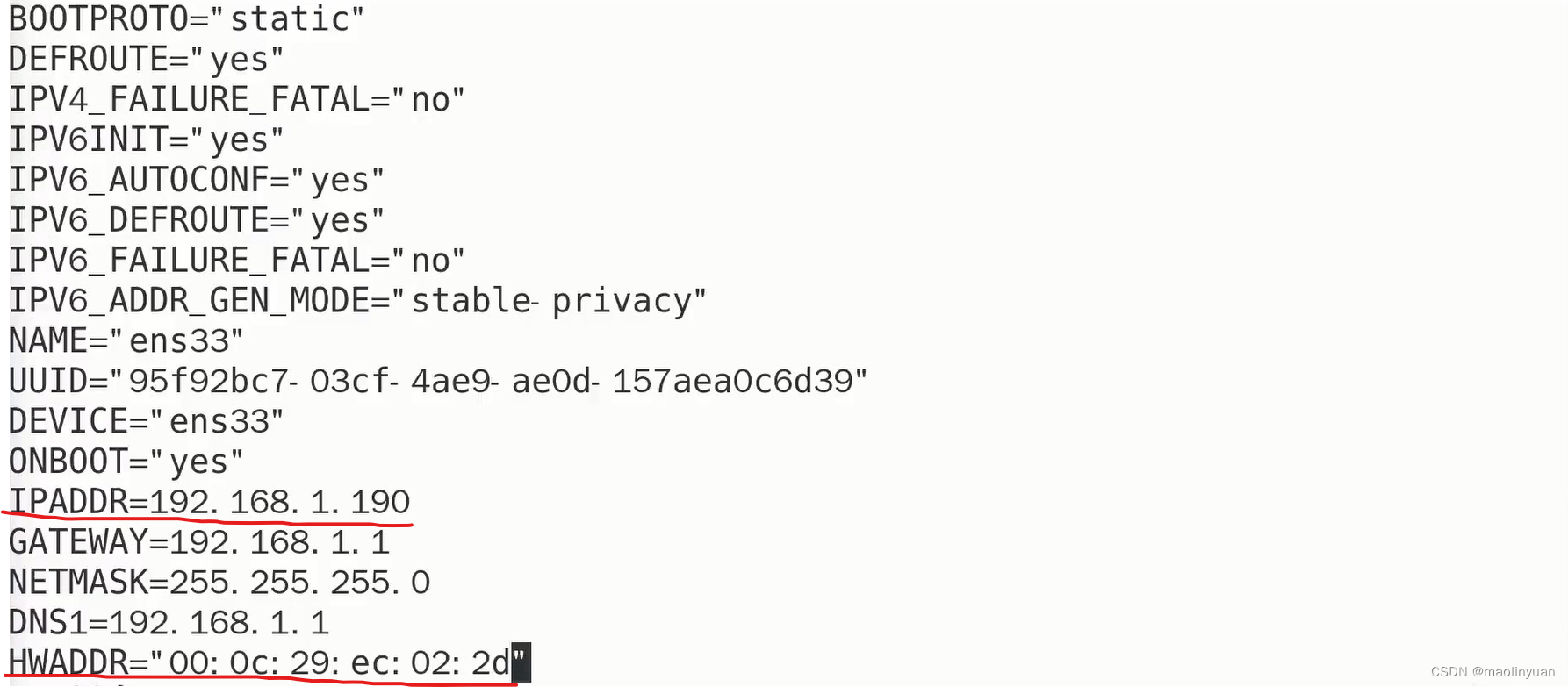

Redis的安装和配置

-

打开官网:https://redis.io (中文官网:http://www.redis.cn)点击下载最新版本的Redis

-

上传到Linux服务器

-

解压安装包

tar -zxvf redis.xxxx.tar.gz

-

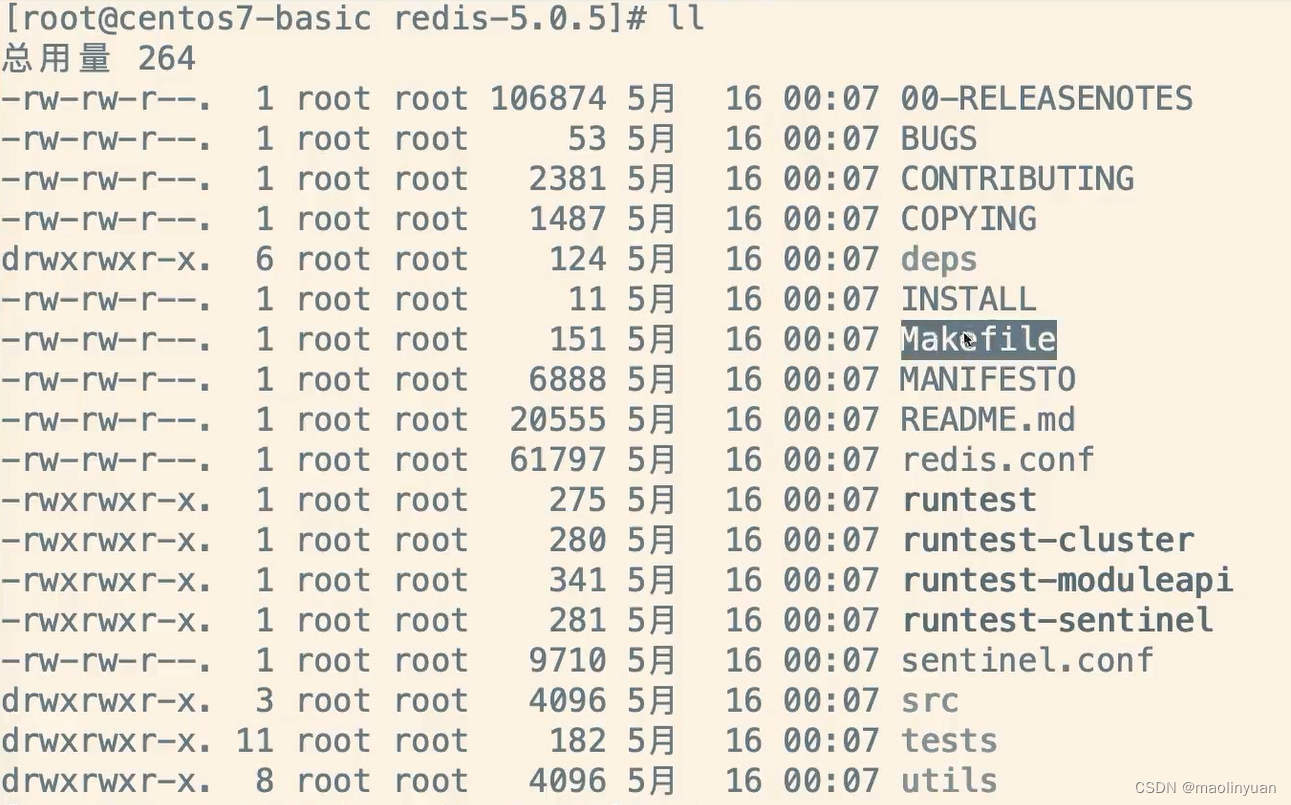

进入解压缩之后的文件夹,可以发现其中有一个Makefile文件,因此安装方式和Nginx类似

-

因为是C语言编写的,所以安装gcc的编译环境

yum install gcc-c++

-

编译

make

当最后看到:Hint: It’s a good idea to run ‘make test’ 😉

说明编译成功了

-

安装

make install

-

拷贝Redis解压目录中的utils文件夹下的启动脚本到系统目录中,以备后用

cp ./utils/redis_init_script /etc/init.d/

-

创建配置文件所在的文件夹以及Redis的工作空间

mkdir /usr/local/redis -p

mkdir /usr/local/redis/db -p

-

拷贝redis.conf文件夹到创建的目录中

cp ./redis.conf /usr/local/redis/redis.conf

-

修改配置文件

vim /usr/local/redis/redis.conf

修改以下配置项

- 设置后台启动:daemonize yes

- 设置工作空间:dir /usr/local/redis/db

- 设置允许访问Redis服务的ip:bind 0.0.0.0

- 修改访问密码(此项配置默认是关闭的):requirepass imooc

- 关闭保护模式:protected-mode no

部分配置项:

daemonize yes #是否以后台进程运行 pidfile /var/run/redis/redis-server.pid #pid文件位置 port 6379#监听端口 bind 127.0.0.1 #绑定地址,如外网需要连接,设置0.0.0.0 timeout 300 #连接超时时间,单位秒 loglevel notice #日志级别,分别有: # debug :适用于开发和测试 # verbose :更详细信息 # notice :适用于生产环境 # warning :只记录警告或错误信息 logfile /var/log/redis/redis-server.log #日志文件位置 syslog-enabled no #是否将日志输出到系统日志 databases 16#设置数据库数量,默认数据库为0 ############### 快照方式 ############### save 900 1 #在900s(15m)之后,至少有1个key发生变化,则快照 save 300 10 #在300s(5m)之后,至少有10个key发生变化,则快照 save 60 10000 #在60s(1m)之后,至少有1000个key发生变化,则快照 rdbcompression yes #dump时是否压缩数据 dir /var/lib/redis #数据库(dump.rdb)文件存放目录 ############### 主从复制 ############### slaveof <masterip> <masterport> #主从复制使用,用于本机redis作为slave去连接主redis masterauth <master-password> #当master设置密码认证,slave用此选项指定master认证密码 slave-serve-stale-data yes #当slave与master之间的连接断开或slave正在与master进行数据同步时,如果有slave请求,当设置为yes时,slave仍然响应请求,此时可能有问题,如果设置no时,slave会返回"SYNC with master in progress"错误信息。但INFO和SLAVEOF命令除外。 ############### 安全 ############### requirepass foobared #配置redis连接认证密码 ############### 限制 ############### maxclients 128#设置最大连接数,0为不限制 maxmemory <bytes>#内存清理策略,如果达到此值,将采取以下动作: maxmemory-policy volatile-lru#如果达到maxmemory值,采用此策略 # volatile-lru :默认策略,只对设置过期时间的key进行LRU算法删除 # allkeys-lru :删除不经常使用的key # volatile-random :随机删除即将过期的key # allkeys-random :随机删除一个key # volatile-ttl :删除即将过期的key # noeviction :不过期,写操作返回报错 maxmemory-samples 3 #默认随机选择3个key,从中淘汰最不经常用的 ############### 附加模式 ############### appendonly no #AOF持久化,是否记录更新操作日志,默认redis是异步(快照)把数据写入本地磁盘 appendfilename appendonly.aof #指定更新日志文件名 # AOF持久化三种同步策略: # appendfsync always #每次有数据发生变化时都会写入appendonly.aof # appendfsync everysec #默认方式,每秒同步一次到appendonly.aof # appendfsync no #不同步,数据不会持久化 no-appendfsync-on-rewrite no #当AOF日志文件即将增长到指定百分比时,redis通过调用BGREWRITEAOF是否自动重写AOF日志文件。 ############### 虚拟内存 ############### vm-enabled no #是否启用虚拟内存机制,虚拟内存机将数据分页存放,把很少访问的页放到swap上,内存占用多,最好关闭虚拟内存 vm-swap-file /var/lib/redis/redis.swap #虚拟内存文件位置 vm-max-memory 0 #redis使用的最大内存上限,保护redis不会因过多使用物理内存影响性能 vm-page-size 32 #每个页面的大小为32字节 vm-pages 134217728 #设置swap文件中页面数量 vm-max-threads 4 #访问swap文件的线程数 ############### 高级配置 ############### hash-max-zipmap-entries 512 #哈希表中元素(条目)总个数不超过设定数量时,采用线性紧凑格式存储来节省空间 hash-max-zipmap-value 64 #哈希表中每个value的长度不超过多少字节时,采用线性紧凑格式存储来节省空间 list-max-ziplist-entries 512 #list数据类型多少节点以下会采用去指针的紧凑存储格式 list-max-ziplist-value 64 #list数据类型节点值大小小于多少字节会采用紧凑存储格式 set-max-intset-entries 512 #set数据类型内部数据如果全部是数值型,且包含多少节点以下会采用紧凑格式存储 activerehashing yes #是否激活重置哈希参考链接:

-

修改Redis启动脚本

vim /etc/init.d/redis_init_script

修改脚本的配置文件地址为:

CONF=“/usr/local/redis/redis.conf”

-

给脚本新增执行权限

chmod 777 /etc/init.d/redis_init_script

-

使用脚本启动Redis Server

/etc/init.d/redis_init_script start

-

查看Redis进程是否启动成功

ps -ef | grep redis

-

在脚本中配置启动级别和描述

在脚本文件中新增以下内容:

# chkconfig: 22345 10 90

# description: Start and Stop redis

-

将脚本注册到启动项中

chkconfig redis_init_script on

参考链接:

例子:

# 1.将(脚本)启动文件移动到 /etc/init.d/或者/etc/rc.d/init.d/目录下。(前者是后者的软连接) mv /www/wwwroot/test.sh /etc/rc.d/init.d # 2.启动文件前面务必添加如下三行代码,否侧会提示chkconfig不支持。 #!/bin/sh 告诉系统使用的shell,所以的shell脚本都是这样 #chkconfig: 35 20 80 分别代表运行级别,启动优先权,关闭优先权,此行代码必须 #description: http server 自己随便发挥!!!,此行代码必须 /bin/echo $(/bin/date +%F_%T) >> /tmp/test.log # 3.增加脚本的可执行权限 chmod +x /etc/rc.d/init.d/test.sh # 4.添加脚本到开机自动启动项目中。添加到chkconfig,开机自启动。 [root@localhost ~]# cd /etc/rc.d/init.d [root@localhost ~]# chkconfig --add test.sh [root@localhost ~]# chkconfig test.sh on # 5.关闭开机启动 [root@localhost ~]# chkconfig test.sh off # 6.从chkconfig管理中删除test.sh [root@localhost ~]# chkconfig --del test.sh # 7.查看chkconfig管理 [root@localhost ~]# chkconfig --list test.sh

使用redis-cli工具操作Redis

-

打开Redis自启动脚本文件,查看redis-cli工具的安装位置

vim /etc/init.d/redis_init_script

-

使用此工具连接Redis

可以直接输入redis-cli或者输入绝对路径进入使用状态

新开一个连接可以查看工具的此工具的进程,输入

ps -ef | grep redis

-

当我们使用时发现Redis报错,提示没有授权

是我们连接Redis时没有输入密码的原因

-

使用时设置密码,使用set命令和get命令操作key-value

使用auth命令后面跟密码进行认证

使用set命令设置key-value键值对

使用get命令获取key对应的value值

使用del命令删除一个键值对

使用ctrl+c直接退出redis-cli客户端工具

参考链接:

-

在客户端工具之外操作Redis

检测Redis是否存活

redis-cli -p imooc ping

-

想要停止Redis除了直接kill掉此进程之外,还可以使用脚本文件停止

/etc/init.d/redis_init_script stop

因为设置了密码,它会提示没有权限

打开此脚本

vim /etc/init.d/redis_init_script

在stop部分找到以下位置加上设置的密码

重新执行脚本停止服务

查询是否还有Redis进程

ps -ef | grep redis

redis-cli常用命令

string类型

KEYS pattern

查找所有符合给定模式pattern(正则表达式)的 key 。

时间复杂度为O(N),N为数据库里面key的数量。

例如,Redis在一个有1百万个key的数据库里面执行一次查询需要的时间是40毫秒 。

警告: KEYS的速度非常快,但在一个大的数据库中使用它仍然可能造成性能问题,如果你需要从一个数据集中查找特定的 KEYS, 你最好还是用 Redis 的集合结构 SETS 来代替。

支持的正则表达模式:

h?llo匹配hello,hallo和hxlloh*llo匹配hllo和heeeelloh[ae]llo匹配hello和hallo,但是不匹配hilloh[^e]llo匹配hallo,hbllo, … 但是不匹配helloh[a-b]llo匹配hallo和hbllo

如果你想取消字符的特殊匹配(正则表达式,可以在它的前面加\。

返回值

array-reply: 所有符合条件的key

例子

redis> MSET one 1 two 2 three 3 four 4

OK

redis> KEYS *o*

1) "four"

2) "one"

3) "two"

redis> KEYS t??

1) "two"

redis> KEYS *

1) "four"

2) "three"

3) "one"

4) "two"

redis>

SET key value [EX seconds] [PX milliseconds] [NX|XX]

将键key设定为指定的“字符串”值。

如果 key 已经保存了一个值,那么这个操作会直接覆盖原来的值,并且忽略原始类型。

当set命令执行成功之后,之前设置的过期时间都将失效

选项

从2.6.12版本开始,redis为SET命令增加了一系列选项:

EXseconds – Set the specified expire time, in seconds.PXmilliseconds – Set the specified expire time, in milliseconds.NX– Only set the key if it does not already exist.XX– Only set the key if it already exist.EXseconds – 设置键key的过期时间,单位时秒PXmilliseconds – 设置键key的过期时间,单位时毫秒NX– 只有键key不存在的时候才会设置key的值XX– 只有键key存在的时候才会设置key的值

注意: 由于SET命令加上选项已经可以完全取代SETNX, SETEX, PSETEX的功能,所以在将来的版本中,redis可能会不推荐使用并且最终抛弃这几个命令。

返回值

simple-string-reply:如果SET命令正常执行那么回返回OK,否则如果加了NX 或者 XX选项,但是没有设置条件。那么会返回nil。

例子

redis> SET mykey "Hello"

OK

redis> GET mykey

"Hello"

redis>

设计模式

注意: 下面这种设计模式并不推荐用来实现redis分布式锁。应该参考the Redlock algorithm的实现,因为这个方法只是复杂一点,但是却能保证更好的使用效果。

命令 SET resource-name anystring NX EX max-lock-time 是一种用 Redis 来实现锁机制的简单方法。

如果上述命令返回OK,那么客户端就可以获得锁(如果上述命令返回Nil,那么客户端可以在一段时间之后重新尝试),并且可以通过DEL命令来释放锁。

客户端加锁之后,如果没有主动释放,会在过期时间之后自动释放。

可以通过如下优化使得上面的锁系统变得更加鲁棒:

- 不要设置固定的字符串,而是设置为随机的大字符串,可以称为token。

- 通过脚步删除指定锁的key,而不是DEL命令。

上述优化方法会避免下述场景:a客户端获得的锁(键key)已经由于过期时间到了被redis服务器删除,但是这个时候a客户端还去执行DEL命令。而b客户端已经在a设置的过期时间之后重新获取了这个同样key的锁,那么a执行DEL就会释放了b客户端加好的锁。

解锁脚本的一个例子将类似于以下:

if redis.call("get",KEYS[1]) == ARGV[1]

then

return redis.call("del",KEYS[1])

else

return 0

end

这个脚本执行方式如下:

EVAL …script… 1 resource-name token-value

GET key

返回key的value。如果key不存在,返回特殊值nil。如果key的value不是string,就返回错误,因为GET只处理string类型的values。

返回值

simple-string-reply:key对应的value,或者nil(key不存在时)

例子

redis> GET nonexisting

(nil)

redis> SET mykey "Hello"

OK

redis> GET mykey

"Hello"

redis>

DEL key [key …]

删除指定的一批keys,如果删除中的某些key不存在,则直接忽略。

返回值

integer-reply: 被删除的keys的数量

例子

redis> SET key1 "Hello"

OK

redis> SET key2 "World"

OK

redis> DEL key1 key2 key3

(integer) 2

redis>

TYPE key

起始版本:1.0.0

时间复杂度:O(1)

返回key所存储的value的数据结构类型,它可以返回string, list, set, zset 和 hash等不同的类型。

返回值

simple-string-reply: 返回当前key的数据类型,如果key不存在时返回none。

例子

redis> SET key1 "value"

OK

redis> LPUSH key2 "value"

(integer) 1

redis> SADD key3 "value"

(integer) 1

redis> TYPE key1

string

redis> TYPE key2

list

redis> TYPE key3

set

redis>

SETNX key value

起始版本:1.0.0

时间复杂度:O(1)

可能会被弃用,因为SET命令可以设置参数来代替此功能

将key设置值为value,如果key不存在,这种情况下等同SET命令。 当key存在时,什么也不做。SETNX是”SET if Not eXists”的简写。

返回值

Integer reply, 特定值:

1如果key被设置了0如果key没有被设置

例子

redis> SETNX mykey "Hello"

(integer) 1

redis> SETNX mykey "World"

(integer) 0

redis> GET mykey

"Hello"

redis>

设计模式:使用!SETNX加锁

请注意:

- 不鼓励以下模式来实现the Redlock algorithm ,该算法实现起来有一些复杂,但是提供了更好的保证并且具有容错性。

- 无论如何,我们保留旧的模式,因为肯定存在一些已实现的方法链接到该页面作为引用。而且,这是一个有趣的例子说明Redis命令能够被用来作为编程原语的。

- 无论如何,即使假设一个单例的加锁原语,但是从 2.6.12 开始,可以创建一个更加简单的加锁原语,相当于使用

SET命令来获取锁,并且用一个简单的 Lua 脚本来释放锁。该模式被记录在SET命令的页面中。

也就是说,SETNX能够被使用并且以前也在被使用去作为一个加锁原语。例如,获取键为foo的锁,客户端可以尝试一下操作:

SETNX lock.foo <current Unix time + lock timeout + 1>

如果客户端获得锁,SETNX返回1,那么将lock.foo键的Unix时间设置为不在被认为有效的时间。客户端随后会使用DEL lock.foo去释放该锁。

如果SETNX返回0,那么该键已经被其他的客户端锁定。如果这是一个非阻塞的锁,才能立刻返回给调用者,或者尝试重新获取该锁,直到成功或者过期超时。

处理死锁

以上加锁算法存在一个问题:如果客户端出现故障,崩溃或者其他情况无法释放该锁会发生什么情况?这是能够检测到这种情况,因为该锁包含一个Unix时间戳,如果这样一个时间戳等于当前的Unix时间,该锁将不再有效。

当以下这种情况发生时,我们不能调用DEL来删除该锁,并且尝试执行一个SETNX,因为这里存在一个竞态条件,当多个客户端察觉到一个过期的锁并且都尝试去释放它。

- C1 和 C2 读

lock.foo检查时间戳,因为他们执行完SETNX后都被返回了0,因为锁仍然被 C3 所持有,并且 C3 已经崩溃。 - C1 发送

DEL lock.foo - C1 发送

SETNX lock.foo命令并且成功返回 - C2 发送

DEL lock.foo - C2 发送

SETNX lock.foo命令并且成功返回 - 错误:由于竞态条件导致 C1 和 C2 都获取到了锁

幸运的是,可以使用以下的算法来避免这种情况,请看 C4 客户端所使用的好的算法:

-

C4 发送

SETNX lock.foo为了获得该锁 -

已经崩溃的客户端 C3 仍然持有该锁,所以Redis将会返回

0给 C4 -

C4 发送

GET lock.foo检查该锁是否已经过期。如果没有过期,C4 客户端将会睡眠一会,并且从一开始进行重试操作 -

另一种情况,如果因为

lock.foo键的Unix时间小于当前的Unix时间而导致该锁已经过期,C4 会尝试执行以下的操作:GETSET lock.foo <current Unix timestamp + lock timeout + 1> -

由于

GETSET的语意,C4会检查已经过期的旧值是否仍然存储在lock.foo中。如果是的话,C4 会获得锁 -

如果另一个客户端,假如为 C5 ,比 C4 更快的通过

GETSET操作获取到锁,那么 C4 执行GETSET操作会被返回一个不过期的时间戳。C4 将会从第一个步骤重新开始。请注意:即使 C4 在将来几秒设置该键,这也不是问题。

为了使这种加锁算法更加的健壮,持有锁的客户端应该总是要检查是否超时,保证使用DEL释放锁之前不会过期,因为客户端故障的情况可能是复杂的,不止是崩溃,还会阻塞一段时间,阻止一些操作的执行,并且在阻塞恢复后尝试执行DEL(此时,该LOCK已经被其他客户端所持有

TTL key

起始版本:1.0.0

时间复杂度:O(1)

返回key剩余的过期时间。 这种反射能力允许Redis客户端检查指定key在数据集里面剩余的有效期。

在Redis 2.6和之前版本,如果key不存在或者已过期时返回-1。

从Redis2.8开始,错误返回值的结果有如下改变:

- 如果key不存在或者已过期,返回

-2 - 如果key存在并且没有设置过期时间(永久有效),返回

-1。

另见PTTL命令返回相同的信息,只不过他的时间单位是毫秒(仅适用于Redis 2.6及更高版本)。

返回值

Integer reply: key有效的秒数(TTL in seconds),或者一个负值的错误 (参考上文)。

例子

redis> SET mykey "Hello"

OK

redis> EXPIRE mykey 10 # 设置mykey 10秒后过期

(integer) 1

redis> TTL mykey # 查看mykey剩余的过期时间

(integer) 10

redis>

EXPIRE key seconds

起始版本:1.0.0

时间复杂度:O(1)

设置key的过期时间,超过时间后,将会自动删除该key。在Redis的术语中一个key的相关超时是不确定的。

超时后只有对key执行DEL命令或者SET命令或者GETSET时才会清除。 这意味着,从概念上讲所有改变key的值的操作都会使他清除。 例如,INCR递增key的值,执行LPUSH操作,或者用HSET改变hash的field所有这些操作都会触发删除动作。

使用PERSIST命令可以清除超时,使其变成一个永久的key。

如果key被RENAME命令修改,相关的超时时间会转移到新key上面。

如果key被RENAME命令修改,比如原来就存在Key_A,然后调用RENAME Key_B Key_A命令,这时不管原来Key_A是永久的还是设置为超时的,都会由Key_B的有效期状态覆盖。

刷新过期时间

对已经有过期时间的key执行EXPIRE操作,将会更新它的过期时间。有很多应用有这种业务场景,例如记录会话的session。

返回值

integer-reply, 具体的:

1如果成功设置过期时间。0如果key不存在或者不能设置过期时间。

例子

redis> SET mykey "Hello"

OK

redis> EXPIRE mykey 10

(integer) 1

redis> TTL mykey

(integer) 10

redis> SET mykey "Hello World"

OK

redis> TTL mykey

(integer) -1

redis>

案例: Navigation session

想象一下,你有一个网络服务器,你对用户最近访问的N个网页感兴趣,每一个相邻的页面设置超时时间为60秒。在概念上你为这些网页添加Navigation session,如果你的用户,可能包含有趣的信息,他或她正在寻找什么样的产品,你可以推荐相关产品。

你可以使用下面的策略模型,使用这种模式:每次用户浏览网页调用下面的命令:

MULTI

RPUSH pagewviews.user:<userid> http://.....

EXPIRE pagewviews.user:<userid> 60

EXEC

如果用户60秒没有操作,这个key将会被删除,不到60秒的话,后续网页将会被继续记录。

附录: Redis 过期时间

-

Keys的过期时间

通常Redis keys创建时没有设置相关过期时间。他们会一直存在,除非使用显示的命令移除,例如,使用DEL命令。

EXPIRE一类命令能关联到一个有额外内存开销的key。当key执行过期操作时,Redis会确保按照规定时间删除他们。key的过期时间和永久有效性可以通过

EXPIRE和PERSIST命令(或者其他相关命令)来进行更新或者删除过期时间。 -

过期精度

在 Redis 2.4 及以前版本,过期期时间可能不是十分准确,有0-1秒的误差。

从 Redis 2.6 起,过期时间误差缩小到0-1毫秒。

-

过期和持久

Keys的过期时间使用Unix时间戳存储(从Redis 2.6开始以毫秒为单位)。这意味着即使Redis实例不可用,时间也是一直在流逝的。

要想过期的工作处理好,计算机必须采用稳定的时间。 如果你将RDB文件在两台时钟不同步的电脑间同步,有趣的事会发生(所有的 keys装载时就会过期)。

即使正在运行的实例也会检查计算机的时钟,例如如果你设置了一个key的有效期是1000秒,然后设置你的计算机时间为未来2000秒,这时key会立即失效,而不是等1000秒之后。

-

Redis如何淘汰过期的keys

Redis keys过期有两种方式:被动和主动方式。

当一些客户端尝试访问它时,key会被发现并主动的过期。

当然,这样是不够的,因为有些过期的keys,永远不会访问他们。 无论如何,这些keys应该过期,所以定时随机测试设置keys的过期时间。所有这些过期的keys将会从密钥空间删除。

具体就是Redis每秒10次做的事情:

- 测试随机的20个keys进行相关过期检测。

- 删除所有已经过期的keys。

- 如果有多于25%的keys过期,重复步奏1.

这是一个平凡的概率算法,基本上的假设是,我们的样本是这个密钥控件,并且我们不断重复过期检测,直到过期的keys的百分百低于25%,这意味着,在任何给定的时刻,最多会清除1/4的过期keys。

-

在复制AOF文件时如何处理过期

为了获得正确的行为而不牺牲一致性,当一个key过期,

DEL将会随着AOF文字一起合成到所有附加的slaves。在master实例中,这种方法是集中的,并且不存在一致性错误的机会。然而,当slaves连接到master时,不会独立过期keys(会等到master执行DEL命令),他们任然会在数据集里面存在,所以当slave当选为master时淘汰keys会独立执行,然后成为master。

APPEND key value

起始版本:2.0.0

时间复杂度:O(1)。均摊时间复杂度是O(1), 因为redis用的动态字符串的库在每次分配空间的时候会增加一倍的可用空闲空间,所以在添加的value较小而且已经存在的 value是任意大小的情况下,均摊时间复杂度是O(1) 。

如果 key 已经存在,并且值为字符串,那么这个命令会把 value 追加到原来值(value)的结尾。 如果 key 不存在,那么它将首先创建一个空字符串的key,再执行追加操作,这种情况 APPEND 将类似于 SET 操作。

返回值

Integer reply:返回append后字符串值(value)的长度。

例子

redis> EXISTS mykey

(integer) 0

redis> APPEND mykey "Hello"

(integer) 5

redis> APPEND mykey " World"

(integer) 11

redis> GET mykey

"Hello World"

redis>

模式:节拍序列(Time series)

APPEND 命令可以用来连接一系列固定长度的样例,与使用列表相比这样更加紧凑. 通常会用来记录节拍序列. 每收到一个新的节拍样例就可以这样记录:

APPEND timeseries "fixed-size sample"

在节拍序列里, 可以很容易地访问序列中的每个元素:

- STRLEN 可以用来计算样例个数.

- GETRANGE 允许随机访问序列中的各个元素. 如果序列中有明确的节拍信息, 在Redis 2.6中就可以使用GETRANGE配合Lua脚本来实现一个二分查找算法.

- SETRANGE 可以用来覆写已有的节拍序列.

该模式的局限在于只能做追加操作. Redis目前缺少剪裁字符串的命令, 所以无法方便地把序列剪裁成指定的尺寸. 但是, 节拍序列在空间占用上效率极好.

小贴士: 在键值中组合Unix时间戳, 可以在构建一系列相关键值时缩短键值长度,更优雅地分配Redis实例.

使用定长字符串进行温度采样的例子(在实际使用时,采用二进制格式会更好).

redis> APPEND ts "0043"

(integer) 4

redis> APPEND ts "0035"

(integer) 8

redis> GETRANGE ts 0 3

"0043"

redis> GETRANGE ts 4 7

"0035"

redis>

STRLEN key

起始版本:2.2.0

时间复杂度:O(1)

返回key的string类型value的长度。如果key对应的非string类型,就返回错误。

返回值

integer-reply:key对应的字符串value的长度,或者0(key不存在)

例子

redis> SET mykey "Hello world"

OK

redis> STRLEN mykey

(integer) 11

redis> STRLEN nonexisting

(integer) 0

redis>

INCR key

起始版本:1.0.0

时间复杂度:O(1)

对存储在指定key的数值执行原子的加1操作。

如果指定的key不存在,那么在执行incr操作之前,会先将它的值设定为0。

如果指定的key中存储的值不是字符串类型(fix:)或者存储的字符串类型不能表示为一个整数,

那么执行这个命令时服务器会返回一个错误(eq:(error) ERR value is not an integer or out of range)。

这个操作仅限于64位的有符号整型数据。

注意: 由于redis并没有一个明确的类型来表示整型数据,所以这个操作是一个字符串操作。

执行这个操作的时候,key对应存储的字符串被解析为10进制的64位有符号整型数据。

事实上,Redis 内部采用整数形式(Integer representation)来存储对应的整数值,所以对该类字符串值实际上是用整数保存,也就不存在存储整数的字符串表示(String representation)所带来的额外消耗。

返回值

integer-reply:执行递增操作后key对应的值。

例子

redis> SET mykey "10"

OK

redis> INCR mykey

(integer) 11

redis> GET mykey

"11"

redis>

实例:计数器

Redis的原子递增操作最常用的使用场景是计数器。

使用思路是:每次有相关操作的时候,就向Redis服务器发送一个incr命令。

例如这样一个场景:我们有一个web应用,我们想记录每个用户每天访问这个网站的次数。

web应用只需要通过拼接用户id和代表当前时间的字符串作为key,每次用户访问这个页面的时候对这个key执行一下incr命令。

这个场景可以有很多种扩展方法:

- 通过结合使用

INCR和EXPIRE命令,可以实现一个只记录用户在指定间隔时间内的访问次数的计数器 - 客户端可以通过GETSET命令获取当前计数器的值并且重置为0

- 通过类似于DECR或者INCRBY等原子递增/递减的命令,可以根据用户的操作来增加或者减少某些值 比如在线游戏,需要对用户的游戏分数进行实时控制,分数可能增加也可能减少。

实例: 限速器

限速器是一种可以限制某些操作执行速率的特殊场景。

传统的例子就是限制某个公共api的请求数目。

假设我们要解决如下问题:限制某个api每秒每个ip的请求次数不超过10次。

我们可以通过incr命令来实现两种方法解决这个问题。

实例: 限速器 1

更加简单和直接的实现如下:

FUNCTION LIMIT_API_CALL(ip)

ts = CURRENT_UNIX_TIME()

keyname = ip+":"+ts

current = GET(keyname)

IF current != NULL AND current > 10 THEN

ERROR "too many requests per second"

ELSE

MULTI

INCR(keyname,1)

EXPIRE(keyname,10)

EXEC

PERFORM_API_CALL()

END

这种方法的基本点是每个ip每秒生成一个可以记录请求数的计数器。

但是这些计数器每次递增的时候都设置了10秒的过期时间,这样在进入下一秒之后,redis会自动删除前一秒的计数器。

注意上面伪代码中我们用到了MULTI和EXEC命令,将递增操作和设置过期时间的操作放在了一个事务中, 从而保证了两个操作的原子性。

实例: 限速器 2

另外一个实现是对每个ip只用一个单独的计数器(不是每秒生成一个),但是需要注意避免竟态条件。 我们会对多种不同的变量进行测试。

FUNCTION LIMIT_API_CALL(ip):

current = GET(ip)

IF current != NULL AND current > 10 THEN

ERROR "too many requests per second"

ELSE

value = INCR(ip)

IF value == 1 THEN

EXPIRE(value,1)

END

PERFORM_API_CALL()

END

上述方法的思路是,从第一个请求开始设置过期时间为1秒。如果1秒内请求数超过了10个,那么会抛异常。

否则,计数器会清零。

上述代码中,可能会进入竞态条件,比如客户端在执行INCR之后,没有成功设置EXPIRE时间。这个ip的key 会造成内存泄漏,直到下次有同一个ip发送相同的请求过来。

把上述INCR和EXPIRE命令写在lua脚本并执行EVAL命令可以避免上述问题(只有redis版本>=2.6才可以使用)

local current

current = redis.call("incr",KEYS[1])

if tonumber(current) == 1 then

redis.call("expire",KEYS[1],1)

end

还可以通过使用redis的list来解决上述问题避免进入竞态条件。

实现代码更加复杂并且利用了一些redis的新的feature,可以记录当前请求的客户端ip地址。这个有没有好处 取决于应用程序本身。

FUNCTION LIMIT_API_CALL(ip)

current = LLEN(ip)

IF current > 10 THEN

ERROR "too many requests per second"

ELSE

IF EXISTS(ip) == FALSE

MULTI

RPUSH(ip,ip)

EXPIRE(ip,1)

EXEC

ELSE

RPUSHX(ip,ip)

END

PERFORM_API_CALL()

END

The RPUSHX command only pushes the element if the key already exists.

RPUSHX命令会往list中插入一个元素,如果key存在的话

上述实现也可能会出现竞态,比如我们在执行EXISTS指令之后返回了false,但是另外一个客户端创建了这个key。

后果就是我们会少记录一个请求。但是这种情况很少出现,所以我们的请求限速器还是能够运行良好的。

DECR key

起始版本:1.0.0

时间复杂度:O(1)

对key对应的数字做减1操作。如果key不存在,那么在操作之前,这个key对应的值会被置为0。如果key有一个错误类型的value或者是一个不能表示成数字的字符串,就返回错误。这个操作最大支持在64位有符号的整型数字。

查看命令INCR了解关于增减操作的额外信息。

返回值

数字:减小之后的value

例子

redis> SET mykey "10"

OK

redis> DECR mykey

(integer) 9

redis> SET mykey "234293482390480948029348230948"

OK

redis> DECR mykey

ERR value is not an integer or out of range

redis>

INCRBY key increment

起始版本:1.0.0

时间复杂度:O(1)

将key对应的数字加decrement。如果key不存在,操作之前,key就会被置为0。如果key的value类型错误或者是个不能表示成数字的字符串,就返回错误。这个操作最多支持64位有符号的正型数字。

查看命令INCR了解关于增减操作的额外信息。

返回值

integer-reply: 增加之后的value值。

例子

redis> SET mykey "10"

OK

redis> INCRBY mykey 5

(integer) 15

redis>

DECRBY key decrement

起始版本:1.0.0

时间复杂度:O(1)

将key对应的数字减decrement。如果key不存在,操作之前,key就会被置为0。如果key的value类型错误或者是个不能表示成数字的字符串,就返回错误。这个操作最多支持64位有符号的正型数字。

查看命令INCR了解关于增减操作的额外信息。似。

返回值

返回一个数字:减少之后的value值。

例子

redis> SET mykey "10"

OK

redis> DECRBY mykey 5

(integer) 5

redis>

GETRANGE key start end

起始版本:2.4.0

时间复杂度:O(N) N是字符串长度,复杂度由最终返回长度决定,但由于通过一个字符串创建子字符串是很容易的,它可以被认为是O(1)。

警告:这个命令是被改成GETRANGE的,在小于2.0的Redis版本中叫SUBSTR。 返回key对应的字符串value的子串,这个子串是由start和end位移决定的(两者都在string内)。可以用负的位移来表示从string尾部开始数的下标。所以-1就是最后一个字符,-2就是倒数第二个,以此类推。

这个函数处理超出范围的请求时,都把结果限制在string内。

返回值

例子

redis> SET mykey "This is a string"

OK

redis> GETRANGE mykey 0 3

"This"

redis> GETRANGE mykey -3 -1

"ing"

redis> GETRANGE mykey 0 -1

"This is a string"

redis> GETRANGE mykey 10 100

"string"

redis>

SETRANGE key offset value

起始版本:2.2.0

时间复杂度:O(1),不计算将新字符串复制到位所需的时间。通常,该字符串非常小,因此时间复杂度为O(1),否则,时间复杂度为O(M),M是开始值参数的长度

这个命令的作用是覆盖key对应的string的一部分,从指定的offset处开始,覆盖value的长度。如果offset比当前key对应string还要长,那这个string后面就补0以达到offset。不存在的keys被认为是空字符串,所以这个命令可以确保key有一个足够大的字符串,能在offset处设置value。

注意,offset最大可以是229-1(536870911),因为redis字符串限制在512M大小。如果你需要超过这个大小,你可以用多个keys。

警告:当set最后一个字节并且key还没有一个字符串value或者其value是个比较小的字符串时,Redis需要立即分配所有内存,这有可能会导致服务阻塞一会。在一台2010MacBook Pro上,set536870911字节(分配512MB)需要~300ms,set134217728字节(分配128MB)需要~80ms,set33554432比特位(分配32MB)需要~30ms,set8388608比特(分配8MB)需要8ms。注意,一旦第一次内存分配完,后面对同一个key调用SETRANGE就不会预先得到内存分配。

模式

正因为有了SETRANGE和类似功能的GETRANGE命令,你可以把Redis的字符串当成线性数组,随机访问只要O(1)复杂度。这在很多真实场景应用里非常快和高效。

返回值

integer-reply:该命令修改后的字符串长度

例子

基本使用方法:

redis> SET key1 "Hello World"

OK

redis> SETRANGE key1 6 "Redis"

(integer) 11

redis> GET key1

"Hello Redis"

redis>

补充的例子:

redis> SETRANGE key2 6 "Redis"

(integer) 11

redis> GET key2

"\x00\x00\x00\x00\x00\x00Redis"

redis>

MSET key value [key value …]

起始版本:1.0.1

时间复杂度:O(N),其中N是要设置的key的数量。

对应给定的keys到他们相应的values上。MSET会用新的value替换已经存在的value,就像普通的SET命令一样。如果你不想覆盖已经存在的values,请参看命令MSETNX。

MSET是原子的,所以所有给定的keys是一次性set的。客户端不可能看到这种一部分keys被更新而另外的没有改变的情况。

返回值

simple-string-reply:总是OK,因为MSET不会失败。

例子

redis> MSET key1 "Hello" key2 "World"

OK

redis> GET key1

"Hello"

redis> GET key2

"World"

redis>

MGET key [key …]

起始版本:1.0.0

时间复杂度:O(N),其中N是要检索的key数量。

返回所有指定的key的value。对于每个不对应string或者不存在的key,都返回特殊值nil。正因为此,这个操作从来不会失败。

返回值

array-reply: 指定的key对应的values的list

例子

redis> SET key1 "Hello"

OK

redis> SET key2 "World"

OK

redis> MGET key1 key2 nonexisting

1) "Hello"

2) "World"

3) (nil)

redis>

MSETNX key value [key value …]

起始版本:1.0.1

时间复杂度:O(N),其中N是要设置的key的数量。

对应给定的keys到他们相应的values上。只要有一个key已经存在,MSETNX一个操作都不会执行。 由于这种特性,MSETNX可以实现要么所有的操作都成功,要么一个都不执行,这样可以用来设置不同的key,来表示一个唯一的对象的不同字段。

MSETNX是原子的,所以所有给定的keys是一次性set的。客户端不可能看到这种一部分keys被更新而另外的没有改变的情况。

返回值

integer-reply,只有以下两种值:

- 1 如果所有的key被set

- 0 如果没有key被set(至少其中有一个key是存在的)

例子

redis> MSETNX key1 "Hello" key2 "there"

(integer) 1

redis> MSETNX key2 "there" key3 "world"

(integer) 0

redis> MGET key1 key2 key3

1) "Hello"

2) "there"

3) (nil)

redis>

SELECT index

起始版本:1.0.0

选择一个数据库,下标值从0开始,一个新连接默认连接的数据库是DB0。

返回值

FLUSHDB

起始版本:1.0.0

删除当前数据库里面的所有数据。

这个命令永远不会出现失败。

这个操作的时间复杂度是O(N),N是当前数据库的keys数量。

返回

FLUSHALL

起始版本:1.0.0

删除所有数据库里面的所有数据,注意不是当前数据库,而是所有数据库。

这个命令永远不会出现失败。

这个操作的时间复杂度是O(N),N是数据库的数量。

返回

hash类型

HSET key field value

起始版本:2.0.0

时间复杂度:O(1)

设置 key 指定的哈希集中指定字段的值。

如果 key 指定的哈希集不存在,会创建一个新的哈希集并与 key 关联。

如果字段在哈希集中存在,它将被重写。

返回值

integer-reply:含义如下

- 1如果field是一个新的字段

- 0如果field原来在map里面已经存在

例子

redis> HSET myhash field1 "Hello"

(integer) 1

redis> HGET myhash field1

"Hello"

redis>

HGET key field

起始版本:2.0.0

时间复杂度**:**O(1)

返回 key 指定的哈希集中该字段所关联的值

返回值

bulk-string-reply:该字段所关联的值。当字段不存在或者 key 不存在时返回nil。

例子

redis> HSET myhash field1 "foo"

(integer) 1

redis> HGET myhash field1

"foo"

redis> HGET myhash field2

(nil)

redis>

HMSET key field value [field value …]

起始版本:2.0.0

时间复杂度:O(N),这里的N是需要设置的字段数

设置 key 指定的哈希集中指定字段的值。该命令将重写所有在哈希集中存在的字段。如果 key 指定的哈希集不存在,会创建一个新的哈希集并与 key 关联

返回值

例子

redis> HMSET myhash field1 "Hello" field2 "World"

OK

redis> HGET myhash field1

"Hello"

redis> HGET myhash field2

"World"

redis>

HMGET key field [field …]

起始版本:2.0.0

时间复杂度:O(N),这里的N是需要设置的字段数

返回 key 指定的哈希集中指定字段的值。

对于哈希集中不存在的每个字段,返回 nil 值。因为不存在的keys被认为是一个空的哈希集,对一个不存在的 key 执行 HMGET 将返回一个只含有 nil 值的列表

返回值

array-reply:含有给定字段及其值的列表,并保持与请求相同的顺序。

例子

redis> HSET myhash field1 "Hello"

(integer) 1

redis> HSET myhash field2 "World"

(integer) 1

redis> HMGET myhash field1 field2 nofield

1) "Hello"

2) "World"

3) (nil)

redis>

HGETALL key

起始版本:2.0.0

时间复杂度**:**O(N),这里的N是这个hash的size

返回 key 指定的哈希集中所有的字段和值。返回值中,每个字段名的下一个是它的值,所以返回值的长度是哈希集大小的两倍

返回值

array-reply:哈希集中字段和值的列表。当 key 指定的哈希集不存在时返回空列表。

例子

redis> HSET myhash field1 "Hello"

(integer) 1

redis> HSET myhash field2 "World"

(integer) 1

redis> HGETALL myhash

1) "field1"

2) "Hello"

3) "field2"

4) "World"

redis>

HLEN key

起始版本:2.0.0

时间复杂度:O(1)

返回 key 指定的哈希集包含的字段的数量。

返回值

integer-reply: 哈希集中字段的数量,当 key 指定的哈希集不存在时返回 0

例子

redis> HSET myhash field1 "Hello"

(integer) 1

redis> HSET myhash field2 "World"

(integer) 1

redis> HLEN myhash

(integer) 2

redis>

HKEYS key

起始版本:2.0.0

时间复杂度:O(N),这里的N是此hash的size

返回 key 指定的哈希集中所有字段的名字。

返回值

array-reply:哈希集中的字段列表,当 key 指定的哈希集不存在时返回空列表。

例子

redis> HSET myhash field1 "Hello"

(integer) 1

redis> HSET myhash field2 "World"

(integer) 1

redis> HKEYS myhash

1) "field1"

2) "field2"

redis>

HVALS key

起始版本:2.0.0

时间复杂度:O(N),这里的N是此hash的size

返回 key 指定的哈希集中所有字段的值。

返回值

array-reply:哈希集中的值的列表,当 key 指定的哈希集不存在时返回空列表。

例子

redis> HSET myhash field1 "Hello"

(integer) 1

redis> HSET myhash field2 "World"

(integer) 1

redis> HVALS myhash

1) "Hello"

2) "World"

redis>

HINCRBY key field increment

起始版本:2.0.0

时间复杂度:O(1)

增加 key 指定的哈希集中指定字段的数值。如果 key 不存在,会创建一个新的哈希集并与 key 关联。如果字段不存在,则字段的值在该操作执行前被设置为 0

HINCRBY 支持的值的范围限定在 64位 有符号整数

返回值

integer-reply:增值操作执行后的该字段的值。

例子

redis> HSET myhash field 5

(integer) 1

redis> HINCRBY myhash field 1

(integer) 6

redis> HINCRBY myhash field -1

(integer) 5

redis> HINCRBY myhash field -10

(integer) -5

redis>

HINCRBYFLOAT key field increment

起始版本:2.6.0

时间复杂度:O(1)

为指定key的hash的field字段值执行float类型的increment加。如果field不存在,则在执行该操作前设置为0.如果出现下列情况之一,则返回错误:

field的值包含的类型错误(不是字符串)。- 当前

field或者increment不能解析为一个float类型。

此命令的确切行为与INCRBYFLOAT命令相同,请参阅INCRBYFLOAT命令获取更多信息。

返回值

bulk-string-reply: field执行increment加后的值

例子

redis> HSET mykey field 10.50

(integer) 1

redis> HINCRBYFLOAT mykey field 0.1

"10.6"

redis> HSET mykey field 5.0e3

(integer) 0

redis> HINCRBYFLOAT mykey field 2.0e2

"5200"

redis>

实现细节

该命令始终是在复制和模仿HSET,因此,在底层的浮点数运算不会出现数据不一致性问题。

HEXISTS key field

起始版本:2.0.0

时间复杂度:O(1)

返回hash里面field是否存在

返回值

integer-reply, 含义如下:

- 1 hash里面包含该field。

- 0 hash里面不包含该field或者key不存在。

例子

redis> HSET myhash field1 "foo"

(integer) 1

redis> HEXISTS myhash field1

(integer) 1

redis> HEXISTS myhash field2

(integer) 0

redis>

HDEL key field [field …]

起始版本:2.0.0

时间复杂度:O(N) N是被删除的字段数量。

从 key 指定的哈希集中移除指定的域。在哈希集中不存在的域将被忽略。

如果 key 指定的哈希集不存在,它将被认为是一个空的哈希集,该命令将返回0。

返回值

integer-reply: 返回从哈希集中成功移除的域的数量,不包括指出但不存在的那些域

历史

例子

redis> HSET myhash field1 "foo"

(integer) 1

redis> HDEL myhash field1

(integer) 1

redis> HDEL myhash field2

(integer) 0

redis>

list类型

LPUSH key value [value …]

起始版本:1.0.0

时间复杂度:O(1)

将所有指定的值插入到存于 key 的列表的头部。如果 key 不存在,那么在进行 push 操作前会创建一个空列表。 如果 key 对应的值不是一个 list 的话,那么会返回一个错误。

可以使用一个命令把多个元素 push 进入列表,只需在命令末尾加上多个指定的参数。元素是从最左端的到最右端的、一个接一个被插入到 list 的头部。 所以对于这个命令例子 LPUSH mylist a b c,返回的列表是 c 为第一个元素, b 为第二个元素, a 为第三个元素。

返回值

integer-reply: 在 push 操作后的 list 长度。

历史

- 2.4: 接受多个 value 参数。版本老于 2.4 的 Redis 只能每条命令 push 一个值。

例子

redis> LPUSH mylist "world"

(integer) 1

redis> LPUSH mylist "hello"

(integer) 2

redis> LRANGE mylist 0 -1

1) "hello"

2) "world"

redis>

LRANGE key start stop

起始版本:1.0.0

时间复杂度:O(S+N),其中S是小列表的起始偏移距头部的距离,大列表的起始偏移距最近端(头部或尾部)的距离;N是指定范围内的元素数。

返回存储在 key 的列表里指定范围内的元素。 start 和 end 偏移量都是基于0的下标,即list的第一个元素下标是0(list的表头),第二个元素下标是1,以此类推。

偏移量也可以是负数,表示偏移量是从list尾部开始计数。 例如, -1 表示列表的最后一个元素,-2 是倒数第二个,以此类推。

在不同编程语言里,关于求范围函数的一致性

需要注意的是,如果你有一个list,里面的元素是从0到100,那么 LRANGE list 0 10 这个命令会返回11个元素,即最右边的那个元素也会被包含在内。 在你所使用的编程语言里,这一点可能是也可能不是跟那些求范围有关的函数都是一致的。(像Ruby的 Range.new,Array#slice 或者Python的 range() 函数。)

超过范围的下标

当下标超过list范围的时候不会产生error。 如果start比list的尾部下标大的时候,会返回一个空列表。 如果stop比list的实际尾部大的时候,Redis会当它是最后一个元素的下标。

返回值

array-reply: 指定范围里的列表元素。

例子

redis> RPUSH mylist "one"

(integer) 1

redis> RPUSH mylist "two"

(integer) 2

redis> RPUSH mylist "three"

(integer) 3

redis> LRANGE mylist 0 0

1) "one"

redis> LRANGE mylist -3 2

1) "one"

2) "two"

3) "three"

redis> LRANGE mylist -100 100

1) "one"

2) "two"

3) "three"

redis> LRANGE mylist 5 10

(empty list or set)

redis>

RPUSH key value [value …]

起始版本:1.0.0

时间复杂度:O(1)

向存于 key 的列表的尾部插入所有指定的值。如果 key 不存在,那么会创建一个空的列表然后再进行 push 操作。 当 key 保存的不是一个列表,那么会返回一个错误。

可以使用一个命令把多个元素打入队列,只需要在命令后面指定多个参数。元素是从左到右一个接一个从列表尾部插入。 比如命令 RPUSH mylist a b c 会返回一个列表,其第一个元素是 a ,第二个元素是 b ,第三个元素是 c。

返回值

integer-reply: 在 push 操作后的列表长度。

历史

- 2.4: 接受多个 value 参数。 在老于 2.4 的 Redis 版本中,一条命令只能 push 单一个值。

例子

redis> RPUSH mylist "hello"

(integer) 1

redis> RPUSH mylist "world"

(integer) 2

redis> LRANGE mylist 0 -1

1) "hello"

2) "world"

redis>

LPOP key

起始版本:1.0.0

时间复杂度:O(1)

移除并且返回 key 对应的 list 的第一个元素。

返回值

bulk-string-reply: 返回第一个元素的值,或者当 key 不存在时返回 nil。

例子

redis> RPUSH mylist "one"

(integer) 1

redis> RPUSH mylist "two"

(integer) 2

redis> RPUSH mylist "three"

(integer) 3

redis> LPOP mylist

"one"

redis> LRANGE mylist 0 -1

1) "two"

2) "three"

redis>

RPOP key

起始版本:1.0.0

时间复杂度:O(1)

移除并返回存于 key 的 list 的最后一个元素。

返回值

bulk-string-reply: 最后一个元素的值,或者当 key 不存在的时候返回 nil。

例子

redis> RPUSH mylist "one"

(integer) 1

redis> RPUSH mylist "two"

(integer) 2

redis> RPUSH mylist "three"

(integer) 3

redis> RPOP mylist

"three"

redis> LRANGE mylist 0 -1

1) "one"

2) "two"

redis>

LLEN key

起始版本:1.0.0

时间复杂度:O(1)

返回存储在 key 里的list的长度。 如果 key 不存在,那么就被看作是空list,并且返回长度为 0。 当存储在 key 里的值不是一个list的话,会返回error。

返回值

integer-reply: key对应的list的长度。

例子

redis> LPUSH mylist "World"

(integer) 1

redis> LPUSH mylist "Hello"

(integer) 2

redis> LLEN mylist

(integer) 2

redis>

LINDEX key index

起始版本:1.0.0

时间复杂度:O(N),其中N是要遍历的元素数,以到达索引处的元素。这使得请求列表的第一个或最后一个元素成为O(1)。

返回列表里的元素的索引 index 存储在 key 里面。 下标是从0开始索引的,所以 0 是表示第一个元素, 1 表示第二个元素,并以此类推。 负数索引用于指定从列表尾部开始索引的元素。在这种方法下,-1 表示最后一个元素,-2 表示倒数第二个元素,并以此往前推。

当 key 位置的值不是一个列表的时候,会返回一个error。

返回值

bulk-reply:请求的对应元素,或者当 index 超过范围的时候返回 nil。

例子

redis> LPUSH mylist "World"

(integer) 1

redis> LPUSH mylist "Hello"

(integer) 2

redis> LINDEX mylist 0

"Hello"

redis> LINDEX mylist -1

"World"

redis> LINDEX mylist 3

(nil)

redis>

LSET key index value

起始版本:1.0.0

**时间复杂度:**O(N),其中N是列表的长度。将列表的第一个或最后一个元素设置为O(1)。

设置 index 位置的list元素的值为 value。 更多关于 index 参数的信息,详见 LINDEX。

当index超出范围时会返回一个error。

返回值

例子

redis> RPUSH mylist "one"

(integer) 1

redis> RPUSH mylist "two"

(integer) 2

redis> RPUSH mylist "three"

(integer) 3

redis> LSET mylist 0 "four"

OK

redis> LSET mylist -2 "five"

OK

redis> LRANGE mylist 0 -1

1) "four"

2) "five"

3) "three"

redis>

LINSERT key BEFORE|AFTER pivot value

起始版本:2.2.0

时间复杂度:O(N),其中N是在看到值轴之前要遍历的元素数。这意味着在列表的左端(头部)的某个地方插入可以被认为是O(1),而在右端(尾部)的某个地方插入可以被认为是O(N)。

把 value 插入存于 key 的列表中在基准值 pivot 的前面或后面。

当 key 不存在时,这个list会被看作是空list,任何操作都不会发生。

当 key 存在,但保存的不是一个list的时候,会返回error。

返回值

integer-reply: 经过插入操作后的list长度,或者当 pivot 值找不到的时候返回 -1。

例子

redis> RPUSH mylist "Hello"

(integer) 1

redis> RPUSH mylist "World"

(integer) 2

redis> LINSERT mylist BEFORE "World" "There"

(integer) 3

redis> LRANGE mylist 0 -1

1) "Hello"

2) "There"

3) "World"

redis>

LREM key count value

起始版本:1.0.0

时间复杂度:O(N),N是list的长度

从存于 key 的列表里移除前 count 次出现的值为 value 的元素。 这个 count 参数通过下面几种方式影响这个操作:

- count > 0: 从头往尾移除值为 value 的元素。

- count < 0: 从尾往头移除值为 value 的元素。

- count = 0: 移除所有值为 value 的元素。

比如, LREM list -2 “hello” 会从存于 list 的列表里移除最后两个出现的 “hello”。

需要注意的是,如果list里没有存在key就会被当作空list处理,所以当 key 不存在的时候,这个命令会返回 0。

返回值

integer-reply: 被移除的元素个数。

例子

redis> RPUSH mylist "hello"

(integer) 1

redis> RPUSH mylist "hello"

(integer) 2

redis> RPUSH mylist "foo"

(integer) 3

redis> RPUSH mylist "hello"

(integer) 4

redis> LREM mylist -2 "hello"

(integer) 2

redis> LRANGE mylist 0 -1

1) "hello"

2) "foo"

redis>

LTRIM key start stop

起始版本:1.0.0

时间复杂度:O(N),其中N是操作要移除的元素数。

修剪(trim)一个已存在的 list,这样 list 就会只包含指定范围的指定元素。start 和 stop 都是由0开始计数的, 这里的 0 是列表里的第一个元素(表头),1 是第二个元素,以此类推。

例如: LTRIM foobar 0 2 将会对存储在 foobar 的列表进行修剪,只保留列表里的前3个元素。

start 和 end 也可以用负数来表示与表尾的偏移量,比如 -1 表示列表里的最后一个元素, -2 表示倒数第二个,等等。

超过范围的下标并不会产生错误:如果 start 超过列表尾部,或者 start > end,结果会是列表变成空表(即该 key 会被移除)。 如果 end 超过列表尾部,Redis 会将其当作列表的最后一个元素。

LTRIM 的一个常见用法是和 LPUSH / RPUSH 一起使用。 例如:

- LPUSH mylist someelement

- LTRIM mylist 0 99

这一对命令会将一个新的元素 push 进列表里,并保证该列表不会增长到超过100个元素。这个是很有用的,比如当用 Redis 来存储日志。 需要特别注意的是,当用这种方式来使用 LTRIM 的时候,操作的复杂度是 O(1) , 因为平均情况下,每次只有一个元素会被移除。

返回值

例子

redis> RPUSH mylist "one"

(integer) 1

redis> RPUSH mylist "two"

(integer) 2

redis> RPUSH mylist "three"

(integer) 3

redis> LTRIM mylist 1 -1

OK

redis> LRANGE mylist 0 -1

1) "two"

2) "three"

redis>

set类型

SADD key member [member …]

起始版本:1.0.0

时间复杂度:O(N),其中N是要添加的成员数。

添加一个或多个指定的member元素到集合的 key中.指定的一个或者多个元素member 如果已经在集合key中存在则忽略.如果集合key 不存在,则新建集合key,并添加member元素到集合key中.

如果key 的类型不是集合则返回错误.

返回值

integer-reply:返回新成功添加到集合里元素的数量,不包括已经存在于集合中的元素.

历史

- 2.4: 接受多个member 参数. Redis 2.4 以前的版本每次只能添加一个member元素.

例子

redis> SADD myset "Hello"

(integer) 1

redis> SADD myset "World"

(integer) 1

redis> SADD myset "World"

(integer) 0

redis> SMEMBERS myset

1) "World"

2) "Hello"

redis>

SMEMBERS key

起始版本:1.0.0

时间复杂度:O(N),其中N是集合基数。

返回key集合所有的元素.

该命令的作用与使用一个参数的SINTER 命令作用相同.

返回值

array-reply:集合中的所有元素.

举例

redis> SADD myset "Hello"

(integer) 1

redis> SADD myset "World"

(integer) 1

redis> SMEMBERS myset

1) "World"

2) "Hello"

redis>

SCARD key

起始版本:1.0.0

时间复杂度:O(1)

返回集合存储的key的基数 (集合元素的数量).

返回值

integer-reply: 集合的基数(元素的数量),如果key不存在,则返回 0.

举例

redis> SADD myset "Hello"

(integer) 1

redis> SADD myset "World"

(integer) 1

redis> SCARD myset

(integer) 2

redis>

SISMEMBER key member

起始版本:1.0.0

时间复杂度:O(1)

返回成员 member 是否是存储的集合 key的成员.

返回值

integer-reply,详细说明:

- 如果member元素是集合key的成员,则返回1

- 如果member元素不是key的成员,或者集合key不存在,则返回0

举例

redis> SADD myset "one"

(integer) 1

redis> SISMEMBER myset "one"

(integer) 1

redis> SISMEMBER myset "two"

(integer) 0

redis>

SREM key member [member …]

起始版本:1.0.0

时间复杂度:O(N),N是需要移除的元素数量

在key集合中移除指定的元素. 如果指定的元素不是key集合中的元素则忽略 如果key集合不存在则被视为一个空的集合,该命令返回0.

如果key的类型不是一个集合,则返回错误.

返回值

integer-reply:从集合中移除元素的个数,不包括不存在的成员.

历史

- 2.4: 接受多个 member 元素参数. Redis 2.4 之前的版本每次只能移除一个元素.

举例

redis> SADD myset "one"

(integer) 1

redis> SADD myset "two"

(integer) 1

redis> SADD myset "three"

(integer) 1

redis> SREM myset "one"

(integer) 1

redis> SREM myset "four"

(integer) 0

redis> SMEMBERS myset

1) "three"

2) "two"

redis>

SPOP key [count]

起始版本:1.0.0

时间复杂度:O(1)

从存储在key的集合中移除并返回一个或多个随机元素。

此操作与SRANDMEMBER类似,它从一个集合中返回一个或多个随机元素,但不删除元素。

count参数将在更高版本中提供,但是在2.6、2.8、3.0中不可用。

返回值

bulk-string-reply:被删除的元素,或者当key不存在时返回nil。

例子

redis> SMEMBERS db

1) "MySQL"

2) "MongoDB"

3) "Redis"

redis> SPOP db

"Redis"

redis> SMEMBERS db

1) "MySQL"

2) "MongoDB"

redis> SPOP db

"MySQL"

redis> SMEMBERS db

1) "MongoDB"

传递count时的行为规范

如果count大于集合内部的元素数量,此命令将会返回整个集合,不会有额外的元素。

返回元素的分布

请注意,当你需要保证均匀分布返回的元素时,此命令不适用。更多有关SPOP使用的算法的信息,请查阅Knuth采样和Floyd采样算法。

count参数扩展

Redis 3.2是第一个可以给SPOP传递可选参数count的版本,以便在一次调用中取回多个元素。此实现已经在unstable分支中可用。

SRANDMEMBER key [count]

起始版本:1.0.0

时间复杂度:不带count参数O(1),否则为O(N),其中N是传递的计数的绝对值。

仅提供key参数,那么随机返回key集合中的一个元素.

Redis 2.6开始,可以接受 count 参数,如果count是整数且小于元素的个数,返回含有 count 个不同的元素的数组,如果count是个整数且大于集合中元素的个数时,仅返回整个集合的所有元素,当count是负数,则会返回一个包含count的绝对值的个数元素的数组,如果count的绝对值大于元素的个数,则返回的结果集里会出现一个元素出现多次的情况.

仅提供key参数时,该命令作用类似于SPOP命令,不同的是SPOP命令会将被选择的随机元素从集合中移除,而SRANDMEMBER仅仅是返回该随记元素,而不做任何操作.

返回值

bulk-string-reply: 不使用count 参数的情况下该命令返回随机的元素,如果key不存在则返回nil。

array-reply: 使用count参数,则返回一个随机的元素数组,如果key不存在则返回一个空的数组。

举例

redis> SADD myset one two three

(integer) 3

redis> SRANDMEMBER myset

"one"

redis> SRANDMEMBER myset 2

1) "three"

2) "one"

redis> SRANDMEMBER myset -5

1) "one"

2) "one"

3) "one"

4) "one"

5) "one"

redis>

传递count参数时的行为规范

当传递了一个值为正数的count参数,返回的元素就好像从集合中移除了每个选中的元素一样(就像在宾果游戏中提取数字一样)。但是元素不会从集合中移除。所以基本上:

- 不会返回重复的元素。

- 如果count参数的值大于集合内的元素数量,此命令将会仅返回整个集合,没有额外的元素。

相反,当count参数的值为负数时,此命令的行为将发生改变,并且提取操作就像在每次提取后,重新将取出的元素放回包里一样,因此,可能返回重复的元素,以及总是会返回我们请求的数量的元素,因为我们可以一次又一次地重复相同的元素,除了当集合为空(或者不存在key)的时候,将总是会返回一个空数组。

返回元素的分布

当集合中的元素数量很少时,返回元素分布远不够完美,这是因为我们使用了一个近似随机元素函数,它并不能保证良好的分布。

所使用的算法(在dict.c中实现)对哈希表桶进行采样以找到非空桶。一旦找到非空桶,由于我们在哈希表的实现中使用了链接法,因此会检查桶中的元素数量,并且选出一个随机元素。

这意味着,如果你在整个哈希表中有两个非空桶,其中一个有三个元素,另一个只有一个元素,那么其桶中单独存在的元素将以更高的概率返回。

SMOVE source destination member

起始版本:1.0.0

时间复杂度:O(1)

将member从source集合移动到destination集合中. 对于其他的客户端,在特定的时间元素将会作为source或者destination集合的成员出现.

如果source 集合不存在或者不包含指定的元素,这smove命令不执行任何操作并且返回0.否则对象将会从source集合中移除,并添加到destination集合中去,如果destination集合已经存在该元素,则smove命令仅将该元素充source集合中移除. 如果source 和destination不是集合类型,则返回错误.

返回值

- 如果该元素成功移除,返回1

- 如果该元素不是 source集合成员,无任何操作,则返回0.

举例

redis> SADD myset "one"

(integer) 1

redis> SADD myset "two"

(integer) 1

redis> SADD myotherset "three"

(integer) 1

redis> SMOVE myset myotherset "two"

(integer) 1

redis> SMEMBERS myset

1) "one"

redis> SMEMBERS myotherset

1) "three"

2) "two"

redis>

SDIFF key [key …]

起始版本:1.0.0

时间复杂度:O(N),其中N是所有给定集合中的元素总数。

返回一个集合与给定集合的差集的元素.

举例:

key1 = {a,b,c,d}

key2 = {c}

key3 = {a,c,e}

SDIFF key1 key2 key3 = {b,d}

不存在的key认为是空集.

返回值

array-reply:结果集的元素.

举例

redis> SADD key1 "a"

(integer) 1

redis> SADD key1 "b"

(integer) 1

redis> SADD key1 "c"

(integer) 1

redis> SADD key2 "c"

(integer) 1

redis> SADD key2 "d"

(integer) 1

redis> SADD key2 "e"

(integer) 1

redis> SDIFF key1 key2

1) "a"

2) "b"

redis>

SINTER key [key …]

起始版本:1.0.0

时间复杂度:O(N*M),最坏情况,其中N是最小集合的基数,M是集合数。

返回指定所有的集合的成员的交集.

例如:

key1 = {a,b,c,d}

key2 = {c}

key3 = {a,c,e}

SINTER key1 key2 key3 = {c}

如果key不存在则被认为是一个空的集合,当给定的集合为空的时候,结果也为空.(一个集合为空,结果一直为空).

返回值

array-reply: 结果集成员的列表.

例子

redis> SADD key1 "a"

(integer) 1

redis> SADD key1 "b"

(integer) 1

redis> SADD key1 "c"

(integer) 1

redis> SADD key2 "c"

(integer) 1

redis> SADD key2 "d"

(integer) 1

redis> SADD key2 "e"

(integer) 1

redis> SINTER key1 key2

1) "c"

redis>

SUNION key [key …]

起始版本:1.0.0

时间复杂度:O(N),其中N是所有给定集合中的元素总数。

返回给定的多个集合的并集中的所有成员.

例如:

key1 = {a,b,c,d}

key2 = {c}

key3 = {a,c,e}

SUNION key1 key2 key3 = {a,b,c,d,e}

不存在的key可以认为是空的集合.

返回值

array-reply:并集的成员列表

举例

redis> SADD key1 "a"

(integer) 1

redis> SADD key1 "b"

(integer) 1

redis> SADD key1 "c"

(integer) 1

redis> SADD key2 "c"

(integer) 1

redis> SADD key2 "d"

(integer) 1

redis> SADD key2 "e"

(integer) 1

redis> SUNION key1 key2

1) "a"

2) "b"

3) "c"

4) "d"

5) "e"

redis>

zset类型

ZADD key [NX|XX] [CH] [INCR] score member [score member …]

起始版本:1.2.0

时间复杂度:O(log(N)),对于添加的每个元素,其中N是排序集中的元素数。

将所有指定成员添加到键为key有序集合(sorted set)里面。 添加时可以指定多个分数/成员(score/member)对。 如果指定添加的成员已经是有序集合里面的成员,则会更新改成员的分数(scrore)并更新到正确的排序位置。

如果key不存在,将会创建一个新的有序集合(sorted set)并将分数/成员(score/member)对添加到有序集合,就像原来存在一个空的有序集合一样。如果key存在,但是类型不是有序集合,将会返回一个错误应答。

分数值是一个双精度的浮点型数字字符串。+inf和-inf都是有效值。

ZADD 参数(options) (>= Redis 3.0.2)

ZADD 命令在key后面分数/成员(score/member)对前面支持一些参数,他们是:

- XX: 仅仅更新存在的成员,不添加新成员。

- NX: 不更新存在的成员。只添加新成员。

- CH: 修改返回值为发生变化的成员总数,原始是返回新添加成员的总数 (CH 是 changed 的意思)。更改的元素是新添加的成员,已经存在的成员更新分数。 所以在命令中指定的成员有相同的分数将不被计算在内。注:在通常情况下,

ZADD返回值只计算新添加成员的数量。 - INCR: 当

ZADD指定这个选项时,成员的操作就等同ZINCRBY命令,对成员的分数进行递增操作。

分数可以精确的表示的整数的范围

Redis 有序集合的分数使用双精度64位浮点数。我们支持所有的架构,这表示为一个IEEE 754 floating point number,它能包括的整数范围是-(2^53) 到 +(2^53)。或者说是-9007199254740992 到 9007199254740992。更大的整数在内部用指数形式表示,所以,如果为分数设置一个非常大的整数,你得到的是一个近似的十进制数。

Sorted sets 101

有序集合按照分数以递增的方式进行排序。相同的成员(member)只存在一次,有序集合不允许存在重复的成员。 分数可以通过ZADD命令进行更新或者也可以通过ZINCRBY命令递增来修改之前的值,相应的他们的排序位置也会随着分数变化而改变。

获取一个成员当前的分数可以使用ZSCORE命令,也可以用它来验证成员是否存在。

更多关于有序集合的信息请参考数据类型-有序集合。

相同分数的成员

有序集合里面的成员是不能重复的都是唯一的,但是,不同成员间有可能有相同的分数。当多个成员有相同的分数时,他们将是有序的字典(ordered lexicographically)(仍由分数作为第一排序条件,然后,相同分数的成员按照字典规则相对排序)。

字典顺序排序用的是二进制,它比较的是字符串的字节数组。

如果用户将所有元素设置相同分数(例如0),有序集合里面的所有元素将按照字典顺序进行排序,范围查询元素可以使用ZRANGEBYLEX命令(注:范围查询分数可以使用ZRANGEBYSCORE命令)。

返回值

Integer reply, 包括:

- 添加到有序集合的成员数量,不包括已经存在更新分数的成员。

如果指定INCR参数, 返回将会变成bulk-string-reply :

- 成员的新分数(双精度的浮点型数字)字符串。

历史

>= 2.4: 接受多个成员。 在Redis 2.4以前,命令只能添加或者更新一个成员。

例子

redis> ZADD myzset 1 "one"

(integer) 1

redis> ZADD myzset 1 "uno"

(integer) 1

redis> ZADD myzset 2 "two" 3 "three"

(integer) 2

redis> ZRANGE myzset 0 -1 WITHSCORES

1) "one"

2) "1"

3) "uno"

4) "1"

5) "two"

6) "2"

7) "three"

8) "3"

redis>

ZRANGE key start stop [WITHSCORES]

起始版本:1.2.0

时间复杂度:O(log(N)+M),N是排序集中的元素数,M是返回的元素数。

返回存储在有序集合key中的指定范围的元素。 返回的元素可以认为是按得分从最低到最高排列。 如果得分相同,将按字典排序。

当你需要元素从最高分到最低分排列时,请参阅ZREVRANGE(相同的得分将使用字典倒序排序)。

参数start和stop都是基于零的索引,即0是第一个元素,1是第二个元素,以此类推。 它们也可以是负数,表示从有序集合的末尾的偏移量,其中-1是有序集合的最后一个元素,-2是倒数第二个元素,等等。

start和stop都是全包含的区间,因此例如ZRANGE myzset 0 1将会返回有序集合的第一个和第二个元素。

超出范围的索引不会产生错误。 如果start参数的值大于有序集合中的最大索引,或者start > stop,将会返回一个空列表。 如果stop的值大于有序集合的末尾,Redis会将其视为有序集合的最后一个元素。

可以传递WITHSCORES选项,以便将元素的分数与元素一起返回。这样,返回的列表将包含value1,score1,...,valueN,scoreN,而不是value1,...,valueN。 客户端类库可以自由地返回更合适的数据类型(建议:具有值和得分的数组或记录)。

返回值

array-reply:给定范围内的元素列表(如果指定了WITHSCORES选项,将同时返回它们的得分)。

例子

redis > ZRANGE salary 0 -1 WITHSCORES # 显示整个有序集成员

1) "jack"

2) "3500"

3) "tom"

4) "5000"

5) "boss"

6) "10086"

redis > ZRANGE salary 1 2 WITHSCORES # 显示有序集下标区间 1 至 2 的成员

1) "tom"

2) "5000"

3) "boss"

4) "10086"

redis > ZRANGE salary 0 200000 WITHSCORES # 测试 end 下标超出最大下标时的情况

1) "jack"

2) "3500"

3) "tom"

4) "5000"

5) "boss"

6) "10086"

redis > ZRANGE salary 200000 3000000 WITHSCORES # 测试当给定区间不存在于有序集时的情况

(empty list or set)

可以通过使用 WITHSCORES 选项,来让成员和它的 score 值一并返回,返回列表以 value1,score1, ..., valueN,scoreN 的格式表示。 客户端库可能会返回一些更复杂的数据类型,比如数组、元组等。

ZRANK key member

起始版本:2.0.0

时间复杂度:O(log(N))

返回有序集key中成员member的排名。其中有序集成员按score值递增(从小到大)顺序排列。排名以0为底,也就是说,score值最小的成员排名为0。

使用ZREVRANK命令可以获得成员按score值递减(从大到小)排列的排名。

返回值

- 如果member是有序集key的成员,返回integer-reply:member的排名。

- 如果member不是有序集key的成员,返回bulk-string-reply:

nil。

例子

redis> ZADD myzset 1 "one"

(integer) 1

redis> ZADD myzset 2 "two"

(integer) 1

redis> ZADD myzset 3 "three"

(integer) 1

redis> ZRANK myzset "three"

(integer) 2

redis> ZRANK myzset "four"

(nil)

redis>

ZSCORE key member

起始版本:1.2.0

时间复杂度:O(1)

返回有序集key中,成员member的score值。

如果member元素不是有序集key的成员,或key不存在,返回nil。

返回值

bulk-string-reply: member成员的score值(double型浮点数),以字符串形式表示。

例子

redis> ZADD myzset 1 "one"

(integer) 1

redis> ZSCORE myzset "one"

"1"

redis>

ZCARD key

起始版本:1.2.0

时间复杂度:O(1)

返回key的有序集元素个数。

返回值

integer-reply: key存在的时候,返回有序集的元素个数,否则返回0。

例子

redis> ZADD myzset 1 "one"

(integer) 1

redis> ZADD myzset 2 "two"

(integer) 1

redis> ZCARD myzset

(integer) 2

redis>

ZCOUNT key min max

起始版本:2.0.0

时间复杂度: O(log(N)),

N为有序集的基数。

返回有序集 key 中, score 值在 min 和 max 之间(默认包括 score 值等于 min 或 max )的成员的数量。

关于参数 min 和 max 的详细使用方法,请参考 [ZRANGEBYSCORE key min max WITHSCORES] [LIMIT offset count] 命令。

返回值

score 值在 min 和 max 之间的成员的数量。

代码示例

redis> ZRANGE salary 0 -1 WITHSCORES # 测试数据

1) "jack"

2) "2000"

3) "peter"

4) "3500"

5) "tom"

6) "5000"

redis> ZCOUNT salary 2000 5000 # 计算薪水在 2000-5000 之间的人数

(integer) 3

redis> ZCOUNT salary 3000 5000 # 计算薪水在 3000-5000 之间的人数

(integer) 2

ZRANGEBYSCORE key min max [WITHSCORES] [LIMIT offset count]

起始版本:1.0.5

时间复杂度:O(log(N)+M),N是排序集中的元素数,M是返回的元素数。如果M是常数(例如总是要求前10个元素具有限制),你可以考虑它O(log(n))。

如果M是常量(比如,用limit总是请求前10个元素),你可以认为是O(log(N))。

返回key的有序集合中的分数在min和max之间的所有元素(包括分数等于max或者min的元素)。元素被认为是从低分到高分排序的。

具有相同分数的元素按字典序排列(这个根据redis对有序集合实现的情况而定,并不需要进一步计算)。

可选的LIMIT参数指定返回结果的数量及区间(类似SQL中SELECT LIMIT offset, count)。注意,如果offset太大,定位offset就可能遍历整个有序集合,这会增加O(N)的复杂度。

可选参数WITHSCORES会返回元素和其分数,而不只是元素。这个选项在redis2.0之后的版本都可用。

##区间及无限

min和max可以是-inf和+inf,这样一来,你就可以在不知道有序集的最低和最高score值的情况下,使用ZRANGEBYSCORE这类命令。

默认情况下,区间的取值使用闭区间(小于等于或大于等于),你也可以通过给参数前增加(符号来使用可选的开区间(小于或大于)。

举个例子:

ZRANGEBYSCORE zset (1 5

返回所有符合条件1 < score <= 5的成员;

ZRANGEBYSCORE zset (5 (10

返回所有符合条件5 < score < 10 的成员。

返回值

array-reply: 指定分数范围的元素列表(也可以返回他们的分数)。

例子

redis> ZADD myzset 1 "one"

(integer) 1

redis> ZADD myzset 2 "two"

(integer) 1

redis> ZADD myzset 3 "three"

(integer) 1

redis> ZRANGEBYSCORE myzset -inf +inf

1) "one"

2) "two"

3) "three"

redis> ZRANGEBYSCORE myzset 1 2

1) "one"

2) "two"

redis> ZRANGEBYSCORE myzset (1 2

1) "two"

redis> ZRANGEBYSCORE myzset (1 (2

(empty list or set)

redis>

ZREM key member [member …]

起始版本:1.2.0

时间复杂度:O(M*log(N)),N是排序集中的元素数,M是要删除的元素数。

移除有序集 key 中的一个或多个成员,不存在的成员将被忽略。

当 key 存在但不是有序集类型时,返回一个错误。

返回值

integer-reply, 如下的整数:

返回的是从有序集合中删除的成员个数,不包括不存在的成员。

历史

- 2.4: 接受多个元素。在2.4之前的版本中,每次只能删除一个成员。

例子

redis> ZADD myzset 1 "one"

(integer) 1

redis> ZADD myzset 2 "two"

(integer) 1

redis> ZADD myzset 3 "three"

(integer) 1

redis> ZREM myzset "two"

(integer) 1

redis> ZRANGE myzset 0 -1 WITHSCORES

1) "one"

2) "1"

3) "three"

4) "3"

redis>

IO模型简单介绍

一、什么是同步?什么是异步?

同步和异步的概念出来已经很久了,网上有关同步和异步的说法也有很多。以下是我个人的理解:

-

同步就是:如果有多个任务或者事件要发生,这些任务或者事件必须逐个地进行,一个事件或者任务的执行会导致整个流程的暂时等待,这些事件没有办法并发地执行;

-

异步就是:如果有多个任务或者事件发生,这些事件可以并发地执行,一个事件或者任务的执行不会导致整个流程的暂时等待。

这就是同步和异步。举个简单的例子,假如有一个任务包括两个子任务A和B,对于同步来说,当A在执行的过程中,B只有等待,直至A执行完毕,B才能执行;而对于异步就是A和B可以并发地执行,B不必等待A执行完毕之后再执行,这样就不会由于A的执行导致整个任务的暂时等待。

如果还不理解,可以先看下面这2段代码:

void fun1() {

}

void fun2() {

}

void function(){

fun1();

fun2();

.....

.....

}

这段代码就是典型的同步,在方法function中,fun1在执行的过程中会导致后续的fun2无法执行,fun2必须等待fun1执行完毕才可以执行。

接着看下面这段代码:

void fun1() {

}

void fun2() {

}

void function(){

new Thread(){

public void run() {

fun1();

}

}.start();

new Thread(){

public void run() {

fun2();

}

}.start();

.....

.....

}

这段代码是一种典型的异步,fun1的执行不会影响到fun2的执行,并且fun1和fun2的执行不会导致其后续的执行过程处于暂时的等待。

事实上,同步和异步是一个非常广的概念,它们的重点在于多个任务和事件发生时,一个事件的发生或执行是否会导致整个流程的暂时等待。我觉得可以将同步和异步与Java中的synchronized关键字联系起来进行类比。当多个线程同时访问一个变量时,每个线程访问该变量就是一个事件,对于同步来说,就是这些线程必须逐个地来访问该变量,一个线程在访问该变量的过程中,其他线程必须等待;而对于异步来说,就是多个线程不必逐个地访问该变量,可以同时进行访问。

因此,个人觉得同步和异步可以表现在很多方面,但是记住其关键在于多个任务和事件发生时,一个事件的发生或执行是否会导致整个流程的暂时等待。一般来说,可以通过多线程的方式来实现异步,但是千万记住不要将多线程和异步画上等号,异步只是宏观上的一个模式,采用多线程来实现异步只是一种手段,并且通过多进程的方式也可以实现异步。

二、什么是阻塞?什么是非阻塞?

在前面介绍了同步和异步的区别,这一节来看一下阻塞和非阻塞的区别。

-

阻塞就是:当某个事件或者任务在执行过程中,它发出一个请求操作,但是由于该请求操作需要的条件不满足,那么就会一直在那等待,直至条件满足;

-

非阻塞就是:当某个事件或者任务在执行过程中,它发出一个请求操作,如果该请求操作需要的条件不满足,会立即返回一个标志信息告知条件不满足,不会一直在那等待。

这就是阻塞和非阻塞的区别。也就是说阻塞和非阻塞的区别关键在于当发出请求一个操作时,如果条件不满足,是会一直等待还是返回一个标志信息。

举个简单的例子:

假如我要读取一个文件中的内容,如果此时文件中没有内容可读,对于阻塞来说就是会一直在那等待,直至文件中有内容可读;而对于非阻塞来说,就会直接返回一个标志信息告知文件中暂时无内容可读。

在网上有一些朋友将同步和异步分别与阻塞和非阻塞画上等号,事实上,它们是两组完全不同的概念。注意,理解这两组概念的区别对于后面IO模型的理解非常重要。

同步和异步着重点在于多个任务的执行过程中,一个任务的执行是否会导致整个流程的暂时等待;

而阻塞和非阻塞着重点在于发出一个请求操作时,如果进行操作的条件不满足是否会返会一个标志信息告知条件不满足。

理解阻塞和非阻塞可以同线程阻塞类比地理解,当一个线程进行一个请求操作时,如果条件不满足,则会被阻塞,即在那等待条件满足。

三、什么是阻塞IO? 什么是非阻塞IO?

在了解阻塞IO和非阻塞IO之前,先看下一个具体的IO操作过程是怎么进行的。

通常来说,IO操作包括:对硬盘的读写、对socket的读写以及外设的读写。

当用户线程发起一个IO请求操作(本文以读请求操作为例),内核会去查看要读取的数据是否就绪,对于阻塞IO来说,如果数据没有就绪,则会一直在那等待,直到数据就绪;对于非阻塞IO来说,如果数据没有就绪,则会返回一个标志信息告知用户线程当前要读的数据没有就绪。当数据就绪之后,便将数据拷贝到用户线程,这样才完成了一个完整的IO读请求操作,也就是说一个完整的IO读请求操作包括两个阶段:

-

查看数据是否就绪;

-

进行数据拷贝(内核将数据拷贝到用户线程)。

那么阻塞(blocking IO)和非阻塞(non-blocking IO)的区别就在于第一个阶段,如果数据没有就绪,在查看数据是否就绪的过程中是一直等待,还是直接返回一个标志信息。

Java中传统的IO都是阻塞IO,比如通过socket来读数据,调用read()方法之后,如果数据没有就绪,当前线程就会一直阻塞在read方法调用那里,直到有数据才返回;而如果是非阻塞IO的话,当数据没有就绪,read()方法应该返回一个标志信息,告知当前线程数据没有就绪,而不是一直在那里等待。

四、什么是同步IO? 什么是异步IO?

我们先来看一下同步IO和异步IO的定义,在《Unix网络编程》一书中对同步IO和异步IO的定义是这样的:

A synchronous I/O operation causes the requesting process to be blocked until that I/O operation completes.

An asynchronous I/O operation does not cause the requesting process to be blocked.

从字面的意思可以看出:同步IO即 如果一个线程请求进行IO操作,在IO操作完成之前,该线程会被阻塞;

而异步IO为 如果一个线程请求进行IO操作,IO操作不会导致请求线程被阻塞。

事实上,同步IO和异步IO模型是针对用户线程和内核的交互来说的:

对于同步IO:当用户发出IO请求操作之后,如果数据没有就绪,需要通过用户线程或者内核不断地去轮询数据是否就绪,当数据就绪时,再将数据从内核拷贝到用户线程;

而异步IO:只有IO请求操作的发出是由用户线程来进行的,IO操作的两个阶段都是由内核自动完成,然后发送通知告知用户线程IO操作已经完成。也就是说在异步IO中,不会对用户线程产生任何阻塞。

这是同步IO和异步IO关键区别所在,同步IO和异步IO的关键区别反映在数据拷贝阶段是由用户线程完成还是内核完成。所以说异步IO必须要有操作系统的底层支持。

注意同步IO和异步IO与阻塞IO和非阻塞IO是不同的两组概念。

阻塞IO和非阻塞IO是反映在当用户请求IO操作时,如果数据没有就绪,是用户线程一直等待数据就绪,还是会收到一个标志信息这一点上面的。也就是说,阻塞IO和非阻塞IO是反映在IO操作的第一个阶段,在查看数据是否就绪时是如何处理的。

五、五种IO模型

在《Unix网络编程》一书中提到了五种IO模型,分别是:阻塞IO、非阻塞IO、多路复用IO、信号驱动IO以及异步IO。下面就分别来介绍一下这5种IO模型的异同。

阻塞IO模型

最传统的一种IO模型,即在读写数据过程中会发生阻塞现象。

当用户线程发出IO请求之后,内核会去查看数据是否就绪,如果没有就绪就会等待数据就绪,而用户线程就会处于阻塞状态,用户线程交出CPU。当数据就绪之后,内核会将数据拷贝到用户线程,并返回结果给用户线程,用户线程才解除block状态。

典型的阻塞IO模型的例子为:

data = socket.read();

如果数据没有就绪,就会一直阻塞在read方法。

非阻塞IO模型

当用户线程发起一个read操作后,并不需要等待,而是马上就得到了一个结果。如果结果是一个error时,它就知道数据还没有准备好,于是它可以再次发送read操作。一旦内核中的数据准备好了,并且又再次收到了用户线程的请求,那么它马上就将数据拷贝到了用户线程,然后返回。

所以事实上,在非阻塞IO模型中,用户线程需要不断地询问内核数据是否就绪,也就说非阻塞IO不会交出CPU,而会一直占用CPU。

典型的非阻塞IO模型一般如下:

while(true){

data = socket.read();

if(data!= error){

处理数据

break;

}

}

但是对于非阻塞IO就有一个非常严重的问题,在while循环中需要不断地去询问内核数据是否就绪,这样会导致CPU占用率非常高,因此一般情况下很少使用while循环这种方式来读取数据。

多路复用IO模型

多路复用IO模型是目前使用得比较多的模型。Java NIO实际上就是多路复用IO。

在多路复用IO模型中,会有一个线程不断去轮询多个socket的状态,只有当socket真正有读写事件时,才真正调用实际的IO读写操作。因为在多路复用IO模型中,只需要使用一个线程就可以管理多个socket,系统不需要建立新的进程或者线程,也不必维护这些线程和进程,并且只有在真正有socket读写事件进行时,才会使用IO资源,所以它大大减少了资源占用。

在Java NIO中,是通过selector.select()去查询每个通道是否有到达事件,如果没有事件,则一直阻塞在那里,因此这种方式会导致用户线程的阻塞。

也许有朋友会说,我可以采用 多线程+ 阻塞IO 达到类似的效果,但是由于在多线程 + 阻塞IO 中,每个socket对应一个线程,这样会造成很大的资源占用,并且尤其是对于长连接来说,线程的资源一直不会释放,如果后面陆续有很多连接的话,就会造成性能上的瓶颈。

而多路复用IO模式,通过一个线程就可以管理多个socket,只有当socket真正有读写事件发生才会占用资源来进行实际的读写操作。因此,多路复用IO比较适合连接数比较多的情况。

另外多路复用IO为何比非阻塞IO模型的效率高是因为在非阻塞IO中,不断地询问socket状态是通过用户线程去进行的,而在多路复用IO中,轮询每个socket状态是内核在进行的,这个效率要比用户线程要高的多。

不过要注意的是,多路复用IO模型是通过轮询的方式来检测是否有事件到达,并且对到达的事件逐一进行响应。因此对于多路复用IO模型来说,一旦事件响应体很大,那么就会导致后续的事件迟迟得不到处理,并且会影响新的事件轮询。

信号驱动IO模型

在信号驱动IO模型中,当用户线程发起一个IO请求操作,会给对应的socket注册一个信号函数,然后用户线程会继续执行,当内核数据就绪时会发送一个信号给用户线程,用户线程接收到信号之后,便在信号函数中调用IO读写操作来进行实际的IO请求操作。

异步IO模型

异步IO模型才是最理想的IO模型,在异步IO模型中,当用户线程发起read操作之后,立刻就可以开始去做其它的事。而另一方面,从内核的角度,当它收到一个asynchronous read之后,它会立刻返回,说明read请求已经成功发起了,因此不会对用户线程产生任何block。然后,内核会等待数据准备完成,然后将数据拷贝到用户线程,当这一切都完成之后,内核会给用户线程发送一个信号,告诉它read操作完成了。也就说用户线程完全不需要知道实际的整个IO操作是如何进行的,只需要先发起一个请求,当接收内核返回的成功信号时表示IO操作已经完成,可以直接去使用数据了。

也就说在异步IO模型中,**IO操作的两个阶段都不会阻塞用户线程,这两个阶段都是由内核自动完成,然后发送一个信号告知用户线程操作已完成。**用户线程中不需要再次调用IO函数进行具体的读写。这点是和信号驱动模型有所不同的,在信号驱动模型中,当用户线程接收到信号表示数据已经就绪,然后需要用户线程调用IO函数进行实际的读写操作;而在异步IO模型中,收到信号表示IO操作已经完成,不需要再在用户线程中调用iO函数进行实际的读写操作。

注意,异步IO是需要操作系统的底层支持,在Java 7中,提供了Asynchronous IO。

前面四种IO模型实际上都属于同步IO,只有最后一种是真正的异步IO,因为无论是多路复用IO还是信号驱动模型,IO操作的第2个阶段都会引起用户线程阻塞,也就是内核进行数据拷贝的过程都会让用户线程阻塞。

六、两种高性能IO设计模式

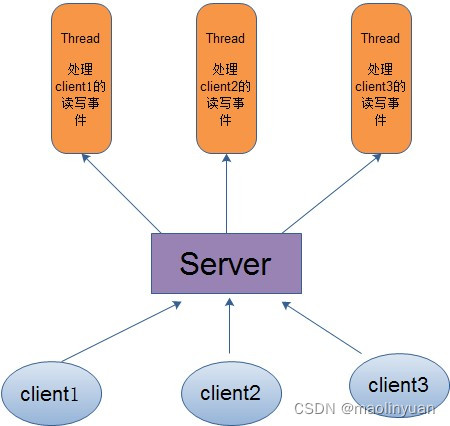

在传统的网络服务设计模式中,有两种比较经典的模式:一种是 多线程,一种是线程池。对于多线程模式,也就说来了client,服务器就会新建一个线程来处理该client的读写事件,如下图所示:

这种模式虽然处理起来简单方便,但是由于服务器为每个client的连接都采用一个线程去处理,使得资源占用非常大。因此,当连接数量达到上限时,再有用户请求连接,直接会导致资源瓶颈,严重的可能会直接导致服务器崩溃。

因此,为了解决这种一个线程对应一个客户端模式带来的问题,提出了采用线程池的方式,也就说创建一个固定大小的线程池,来一个客户端,就从线程池取一个空闲线程来处理,当客户端处理完读写操作之后,就交出对线程的占用。因此这样就避免为每一个客户端都要创建线程带来的资源浪费,使得线程可以重用。

但是线程池也有它的弊端,如果连接大多是长连接,因此可能会导致在一段时间内,线程池中的线程都被占用,那么当再有用户请求连接时,由于没有可用的空闲线程来处理,就会导致客户端连接失败,从而影响用户体验。因此,线程池比较适合大量的短连接应用。

因此便出现了下面的两种高性能IO设计模式:Reactor和Proactor。

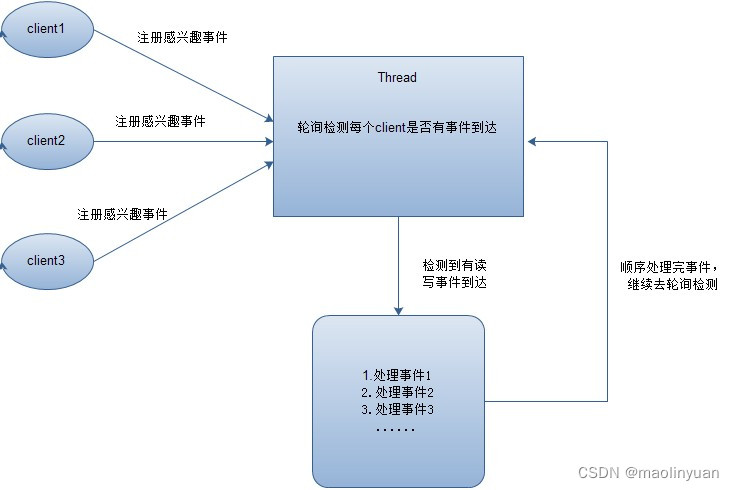

在Reactor模式中,会先对每个client注册感兴趣的事件,然后有一个线程专门去轮询每个client是否有事件发生,当有事件发生时,便顺序处理每个事件,当所有事件处理完之后,便再转去继续轮询,如下图所示:

从这里可以看出,上面的五种IO模型中的多路复用IO就是采用Reactor模式。注意,上面的图中展示的 是顺序处理每个事件,当然为了提高事件处理速度,可以通过多线程或者线程池的方式来处理事件。

在Proactor模式中,当检测到有事件发生时,会新起一个异步操作,然后交由内核线程去处理,当内核线程完成IO操作之后,发送一个通知告知操作已完成,可以得知,异步IO模型采用的就是Proactor模式。

参考链接:

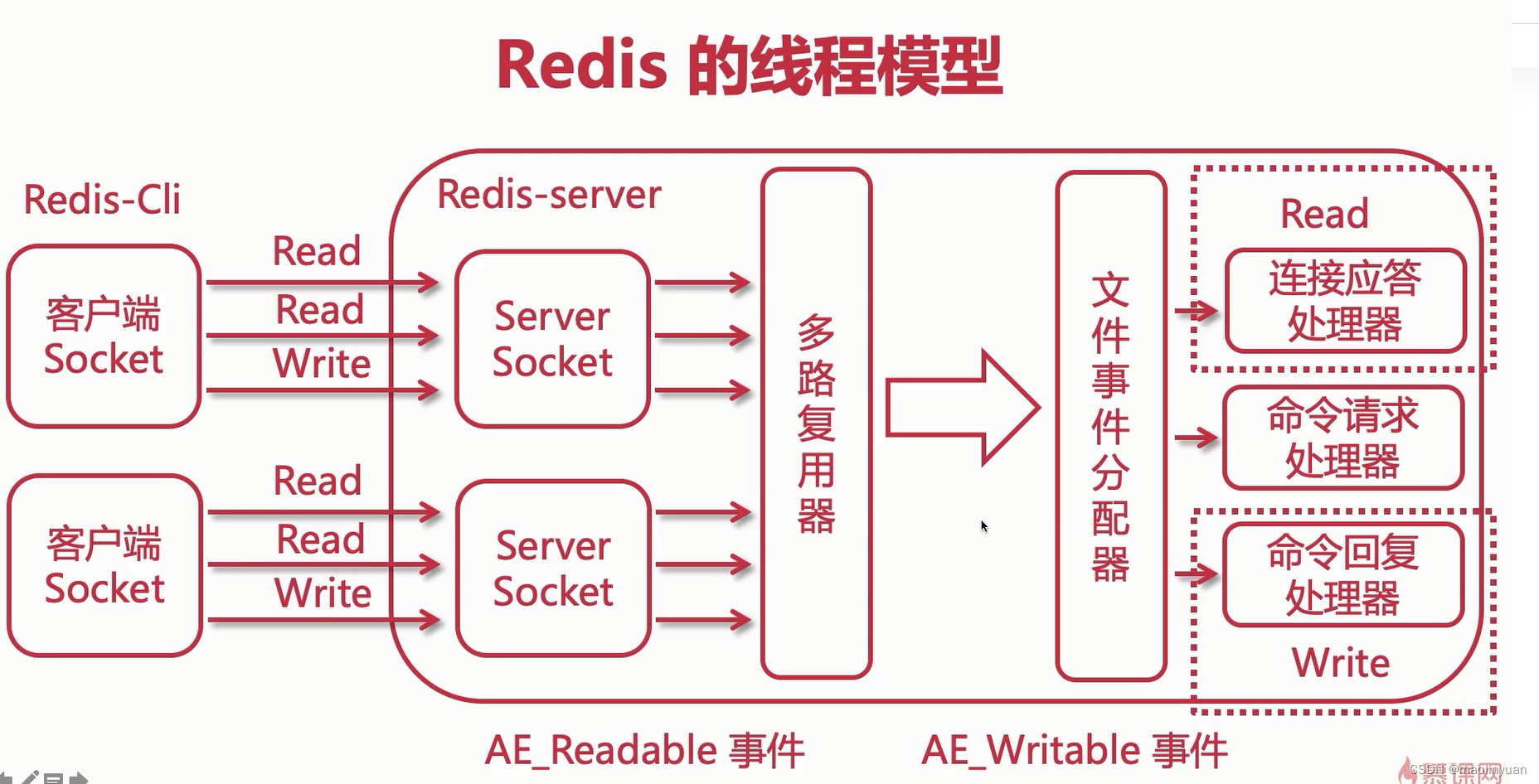

Redis的线程模型

执行事件的流程

Redis 基于 Reactor 模式开发了自己的网络事件处理器 - 文件事件处理器(file event handler,后文简称为 FEH),而该处理器又是单线程的,所以redis设计为单线程模型。

- 采用I/O多路复用同时监听多个socket,根据socket当前执行的事件来为 socket 选择对应的事件处理器。

- 当被监听的socket准备好执行

accept、read、write、close等操作时,和操作对应的文件事件就会产生,这时FEH就会调用socket之前关联好的事件处理器来处理对应事件。

所以虽然FEH是单线程运行,但通过I/O多路复用监听多个socket,不仅实现高性能的网络通信模型,又能和 Redis 服务器中其它同样单线程运行的模块交互,保证了Redis内部单线程模型的简洁设计。

文件事件就是对socket操作的抽象, 每当一个 socket 准备好执行连接accept、read、write、close等操作时, 就会产生一个文件事件。 一个服务器通常会连接多个socket, 多个socket可能并发产生不同操作,每个操作对应不同文件事件。I/O 多路复用程序会负责监听多个socket。

尽管文件事件可能并发出现, 但 I/O 多路复用程序会将所有产生事件的socket放入队列, 通过该队列以有序、同步且每次一个socket的方式向文件事件分派器传送socket。当上一个socket产生的事件被对应事件处理器执行完后, I/O 多路复用程序才会向文件事件分派器传送下个socket。

文件事件分派器接收 I/O 多路复用程序传来的socket, 并根据socket产生的事件类型, 调用相应的事件处理器。服务器会为执行不同任务的套接字关联不同的事件处理器, 这些处理器是一个个函数, 它们定义了某个事件发生时, 服务器应该执行的动作。

Redis 为各种文件事件需求编写了多个处理器,若客户端:

- 连接Redis,对连接服务器的各个客户端进行应答,就需要将socket映射到连接应答处理器

- 写数据到Redis,接收客户端传来的命令请求,就需要映射到命令请求处理器

- 从Redis读数据,向客户端返回命令的执行结果,就需要映射到命令回复处理器

当主服务器和从服务器进行复制操作时, 主从服务器都需要映射到特别为复制功能编写的复制处理器。

值得注意的是,在执行命令阶段,由于Redis是单线程来处理命令的,所有每一条到达服务端的命令不会立刻执行,所有的命令都会进入一个队列中,然后逐个被执行。并且多个客户端发送的命令的执行顺序是不确定的。但是可以确定的是,不会有两条命令被同时执行,不会产生并行问题。

I/O 多路复用程序可以监听多个socket的 ae.h/AE_READABLE 事件和 ae.h/AE_WRITABLE 事件, 这两类事件和套接字操作之间的对应关系如下:

- 当socket可读(比如客户端对Redis执行

write/close操作),或有新的可应答的socket出现时(即客户端对Redis执行connect操作),socket就会产生一个AE_READABLE事件 - 当socket可写时(比如客户端对Redis执行read操作),socket会产生一个AE_WRITABLE事件。

I/O多路复用程序可以同时监听AE_REABLE和AE_WRITABLE两种事件,要是一个socket同时产生这两种事件,那么文件事件分派器优先处理AE_REABLE事件。即一个socket又可读又可写时, Redis服务器先读后写socket。

客户端和Redis服务器通信的整个过程:

-

Redis启动初始化时,将连接应答处理器跟AE_READABLE事件关联。

-

若一个客户端发起连接,会产生一个

AE_READABLE事件,然后由连接应答处理器负责和客户端建立连接,创建客户端对应的socket,同时将这个socket的AE_READABLE事件和命令请求处理器关联,使得客户端可以向主服务器发送命令请求。 -

当客户端向Redis发请求时(不管读还是写请求),客户端socket都会产生一个

AE_READABLE事件,触发命令请求处理器。处理器读取客户端的命令内容, 然后传给相关程序执行。 -

当Redis服务器准备好给客户端的响应数据后,会将socket的

AE_WRITABLE事件和命令回复处理器关联,当客户端准备好读取响应数据时,会在socket产生一个AE_WRITABLE事件,由对应命令回复处理器处理,即将准备好的响应数据写入socket,供客户端读取。 -

命令回复处理器全部写完到 socket 后,就会删除该socket的

AE_WRITABLE事件和命令回复处理器的映射。

参考链接:

Redis客户端和服务端通信示例

多个 socket 可能会并发产生不同的操作,每个操作对应不同的文件事件,但是 IO 多路复用程序会监听多个 socket,会将 socket 产生的事件放入队列中排队,事件分派器每次从队列中取出一个事件,把该事件交给对应的事件处理器进行处理。

-

客户端socket01请求redis的server scoket建立连接,此时server socket生成AE_READABLE事件**,**IO多路复用程序监听到server socket产生的事件,并将该事件压入队列。

-

文件事件分派器从队列中拉取事件交给连接应答处理器,处理器同时生成一个与客户端通信的socket01,并将该scoket01的AE_READABLE事件与命令请求处理器关联

-

此时客户端scoket01发送一个set key value的请求,redis的scoket01接收到AE_READABLE事件,IO多路复用程序监听到事件,将事件压入队列,文件分派器取到事件,由于scoket01已经和命令请求处理器关联,所以命令请求处理器开始set key value,完毕后会将redis的scoket01的AE_WAITABLE事件关联到命令回复处理器

-

如果此时客户端准备好接收返回结果了,向redis中的socket01发起询问请求,那么 redis 中的 socket01 会产生一个

AE_WRITABLE事件,同样压入队列中,事件分派器找到相关联的命令回复处理器,由命令回复处理器对 socket01 输入本次操作的一个结果,比如ok,之后解除 socket01 的AE_WRITABLE事件与命令回复处理器的关联。

这样便完成了redis的一次通信。

参考链接:

Redis的事务机制

MULTI 、 EXEC 、 DISCARD 和 WATCH 是 Redis 事务相关的命令。事务可以一次执行多个命令, 并且带有以下两个重要的保证:

- 事务是一个单独的隔离操作:事务中的所有命令都会序列化、按顺序地执行。事务在执行的过程中,不会被其他客户端发送来的命令请求所打断。

- 事务是一个原子操作:事务中的命令要么全部被执行,要么全部都不执行。

EXEC 命令负责触发并执行事务中的所有命令:

- 如果客户端在使用 MULTI 开启了一个事务之后,却因为断线而没有成功执行 EXEC ,那么事务中的所有命令都不会被执行。

- 另一方面,如果客户端成功在开启事务之后执行 EXEC ,那么事务中的所有命令都会被执行。

由于Redis单线程的特性,所有的命令都是进入一个队列中,依次执行。因此不会有两条命令被同时执行,不会产生并行问题。这点和传统关系型数据库不一样,没有并行问题,也就没有像表锁、行锁这类锁竞争的问题了。