Spark安装——3.安装Hadoop环境

提示:所写文章仅供自己记录安装过程,无任何其他目的。所借鉴的文章,侵权请告知。

前言

进行Spark的安装所需要的一系列操作。安装Linux系统、Java环境和Hadoop环境。

提示:以下是本篇文章正文内容,下面案例可供参考

一、创建hadoop用户

如果你安装 Ubuntu 的时候不是用的 “hadoop” 用户,那么需要增加一个名为 hadoop 的用户。

首先按 ctrl+alt+t 打开终端窗口,输入如下命令

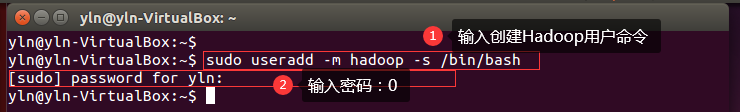

1.创建新用户 :

sudo useradd -m hadoop -s /bin/bash

这条命令创建了可以登陆的 hadoop 用户,并使用 /bin/bash 作为 shell

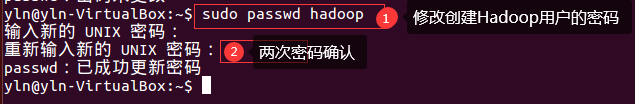

2.接着使用如下命令设置密码,可简单设置为 hadoop,按提示输入两次密码:

sudo passwd hadoop

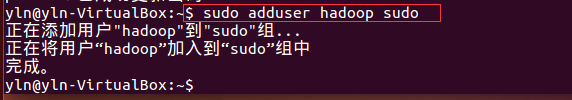

3.可为 hadoop 用户增加管理员权限,方便部署,避免一些对新手来说比较棘手的权限问题:

sudo adduser hadoop sudo

最后注销当前用户(点击屏幕右上角的齿轮,选择注销),返回登陆界面。在登陆界面中选择刚创建的 hadoop 用户进行登陆。

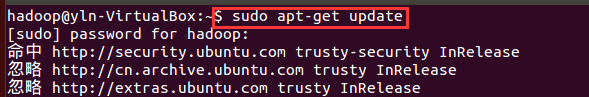

二、更新apt

1.用 hadoop 用户登录后,我们先更新一下 apt,后续我们使用 apt 安装软件,如果没更新可能有一些软件安装不了。按 ctrl+alt+t 打开终端窗口,执行如下命令:

sudo apt-get update

2.后续需要更改一些配置文件,我比较喜欢用的是 vim(vi增强版,基本用法相同),建议安装一下

sudo apt-get install vim

3.安装软件时若需要确认,在提示处输入 y 即可。

3.安装软件时若需要确认,在提示处输入 y 即可。

三、安装SSH、配置SSH无密码登陆

1.集群、单节点模式都需要用到 SSH 登陆(类似于远程登陆,你可以登录某台 Linux 主机,并且在上面运行命令),Ubuntu 默认已安装了 SSH client,此外还需要安装 SSH server:

sudo apt-get install openssh-server

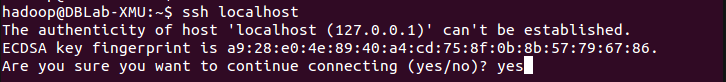

2.安装后,可以使用如下命令登陆本机:

ssh localhost

但这样登陆是需要每次输入密码的,我们需要配置成SSH无密码登陆比较方便。

3.首先退出刚才的 ssh,就回到了我们原先的终端窗口,然后利用 ssh-keygen 生成密钥,并将密钥加入到授权中:

exit # 退出刚才的 ssh localhost

cd ~/.ssh/ # 若没有该目录,请先执行一次ssh localhost

ssh-keygen -t rsa # 会有提示,都按回车就可以

cat ./id_rsa.pub >> ./authorized_keys # 加入授权

4.此时再用 ssh localhost 命令,无需输入密码就可以直接登陆了,如下图所示。

总结

以上是我的安装过程,我所参考的是林子雨实验室的相关步骤。

链接: link.http://dblab.xmu.edu.cn/blog/install-hadoop/

729

729

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?