文章目录

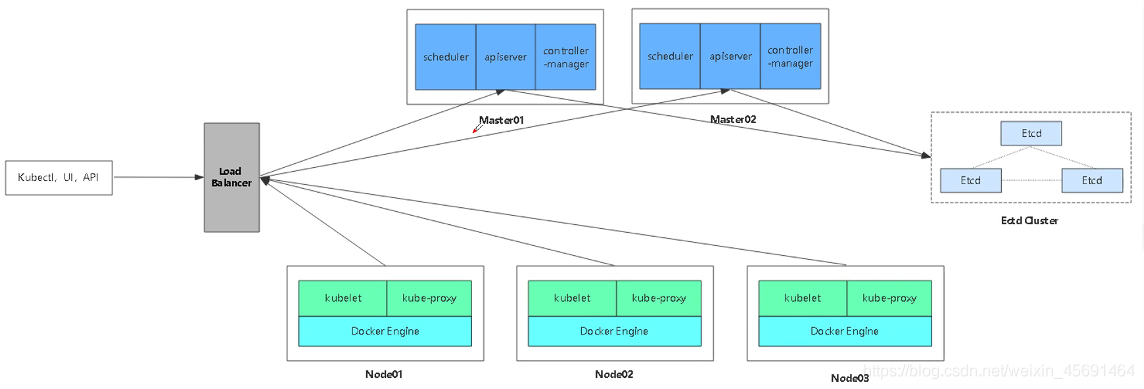

根据上篇 K8S 单master节点群集部署 的基础上,再加一台master2节点,以及两台负载均衡nginx,并做keepalived双击热备高可用

添加master2节点

加一台master2 --192.168.195.131:

1:基本环境配置

固定IP

# vim /etc/sysconfig/network-scripts/ifcfg-ens33

修改并添加:

BOOTPROTO=static

IPADDR=192.168.195.131

NETMASK=255.255.255.0

GATEWAY=192.168.195.2

DNS1=192.168.195.2

# service network restart

# ping www.baidu.com 可ping通

# ifconfig

# systemctl stop NetworkManager

# systemctl disable NetworkManager

# iptables -F 清空防火墙规则

# setenforce 0

2:复制所需文件到master2

master2节点不需要像master1一样重新配置,只需要把master1上的配置文件 启动脚本 证书 复制过来,进行修改就可以

复制/kubernetes/目录到master2

# scp -r /opt/kubernetes/ root@192.168.195.131:/opt

复制3个启动脚本到master2

# scp /usr/lib/systemd/system/{kube-apiserver,kube-controller-manager,kube-scheduler}.service root@192.168.195.131:/usr/lib/systemd/system

特别注意: master02 一定要有etcd证书

需要拷贝master01上已有的etcd证书给master02使用

# scp -r /opt/etcd root@192.168.195.131:/opt

3:修改master2上的配置文件

# cd /opt/kubernetes/cfg

# vim kube-apiserver

IP改为master2的IP

--bind-address=192.168.195.131

--advertise-address=192.168.195.131

4:启动master2 中的3个组件服务

# systemctl start kube-apiserver.service

# systemctl status kube-apiserver.service

# systemctl enable kube-apiserver.service

# systemctl start kube-controller-manager.service

# systemctl status kube-controller-manager.service

# systemctl enable kube-controller-manager.service

# systemctl start kube-scheduler.service

# systemctl status kube-scheduler.service

# systemctl enable kube-scheduler.service

5:设置环境变量

增加环境变量

# vim /etc/profile

末行插入

export PATH=$PATH:/opt/kubernetes/bin

# source /etc/profile

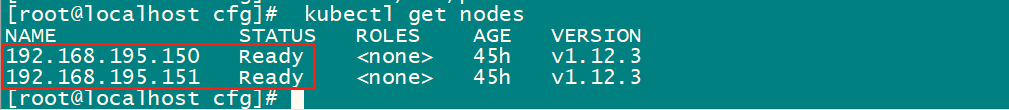

查看节点信息

# kubectl get nodes

可看到node节点是Ready状态,说明master2节点已经部署完成

搭建nginx负载均衡 Lb1 、Lb2

Lb1:192.168.195.133

Lb2:192.168.195.136

1:基本环境配置

(Lb1 Lb2 同步操作,除了IP不同,其他步骤都一样)

固定IP

# vim /etc/sysconfig/network-scripts/ifcfg-ens33

修改并添加:

BOOTPROTO=static

IPADDR=192.168.195.133 // lb2: 136

NETMASK=255.255.255.0

GATEWAY=192.168.195.2

DNS1=192.168.195.2

# service network restart

# ping www.baidu.com

# ifconfig

# systemctl stop NetworkManager

# systemctl disable NetworkManager

# iptables -F

# setenforce 0

2:安装nginx服务

Lb1 、Lb2 同步操作

# rpm -Uvh http://nginx.org/packages/centos/7/noarch/RPMS/nginx-release-centos-7-0.el7.ngx.noarch.rpm

# yum -y install nginx

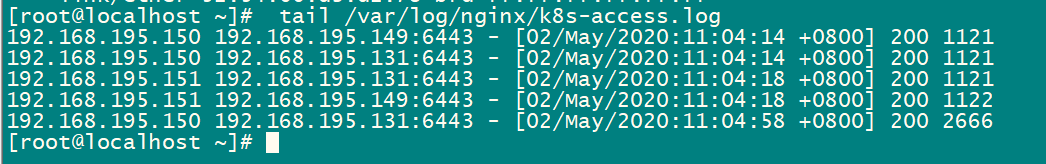

# vim /etc/nginx/nginx.conf

在event段和http段中间添加一段:

stream {

log_format main '$remote_addr $upstream_addr - [$time_local] $status $upstream_bytes_sent';

access_log /var/log/nginx/k8s-access.log main;

upstream k8s-apiserver {

server 192.168.195.149:6443;

server 192.168.195.131:6443;

}

server {

listen 6443;

proxy_pass k8s-apiserver;

}

}

# nginx -t

# systemctl start nginx

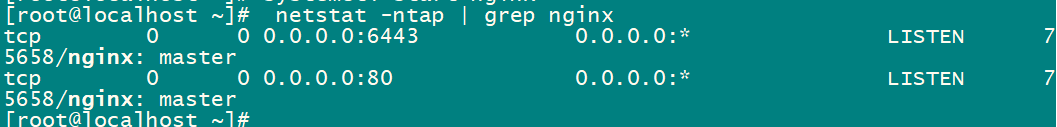

# netstat -ntap | grep nginx

3:部署keepalived

# yum -y install keepalived

把nginx.sh和keepalived.conf脚本拷贝到家目录

# cd ~

# rz -E

把写好的keepalived的配置文件 keepalived.conf 拉过来

# cp keepalived.conf /etc/keepalived/keepalived.conf

把写好的keepalived的配置文件直接覆盖原有的配置文件

提前写好的配置文件keepalived.conf内容

! Configuration File for keepalived

global_defs {

# 接收邮件地址

notification_email {

acassen@firewall.loc

failover@firewall.loc

sysadmin@firewall.loc

}

# 邮件发送地址

notification_email_from Alexandre.Cassen@firewall.loc

smtp_server 127.0.0.1

smtp_connect_timeout 30

router_id NGINX_MASTER

}

vrrp_script check_nginx {

script "/etc/nginx/check_nginx.sh"

}

vrrp_instance VI_1 {

state MASTER

interface eth0

virtual_router_id 51 # VRRP 路由 ID实例,每个实例是唯一的

priority 100 # 优先级,备服务器设置 90

advert_int 1 # 指定VRRP 心跳包通告间隔时间,默认1秒

authentication {

auth_type PASS

auth_pass 1111

}

virtual_ipaddress {

10.0.0.188/24

}

track_script {

check_nginx

}

}

Lb1:修改keepalived的配置文件

修改之处:

# vim /etc/keepalived/keepalived.conf

修改为:

interface ens33

virtual_ipaddress {

192.168.195.100/24

Lb2:修改keepalived的配置文件

修改之处:

# vim /etc/keepalived/keepalived.conf

修改为:

state BACKUP

interface ens33

priority 90

virtual_ipaddress {

192.168.195.100/24

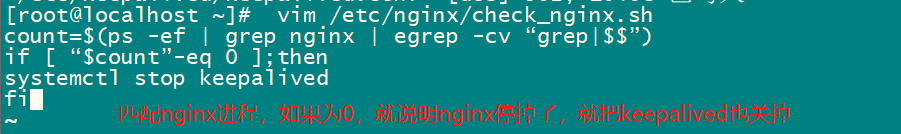

编写配置文件中定义的函数,中的check_nginx.sh脚本

Lb1 Lb2同步操作:

# vim /etc/nginx/check_nginx.sh

count=$(ps -ef | grep nginx | egrep -cv "egrep|$$")

if [ "$count" -eq 0 ];then

systemctl stop keepalived

fi

# chmod +x /etc/nginx/check_nginx.sh

启动keepalived

# systemctl start keepalived.service

# ip a

Lb1上可看到漂移地址VIP : 192.168.195.100;

Lb2上没有,这是因为配置时 Lb1的优先级比Lb2的高

验证地址漂移

Lb1 把nginx关掉 ,会匹配配置文件,就会把keepalived关掉,这时漂移地址VIP已在Lb2上

# pkill nginx

# ip a

如果恢复,需要先启动nginx服务之后,再启动keepalived服务

# systemctl start nginx

# systemctl start keepalived

# systemctl status nginx

# systemctl status keepalived

# ip a

可以看到,VIP地址现在又回到Lb1上。

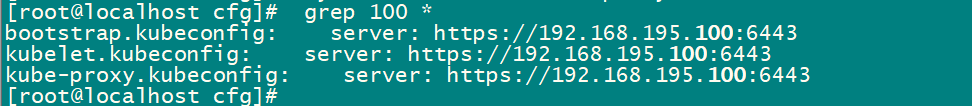

4:修改node节点配置文件统一VIP

node1、 node2节点同步操作:

node节点需指向VIP,充当APIserver访问入口

# cd /opt/kubernetes/cfg/

# vim bootstrap.kubeconfig

server: https://192.168.195.100:6443

# vim kubelet.kubeconfig

server: https://192.168.195.100:6443

# vim kube-proxy.kubeconfig

server: https://192.168.195.100:6443

重启kubelet、kube-proxy服务

# systemctl restart kubelet.service

# systemctl restart kube-proxy.service

# grep 100 *

测试创建pod

Master1节点上操作:

创建pod--nginx

# kubectl run nginx --image=nginx

查看pod状态

# kubectl get pods

创建状态和运行状态

查看在哪个node节点创建的,还可看到pod的IP地址

# kubectl get pods -o wide

在对应网段的node节点上操作可以直接访问到首页

访问本node节点的容器IP

#curl 172.17.46.3

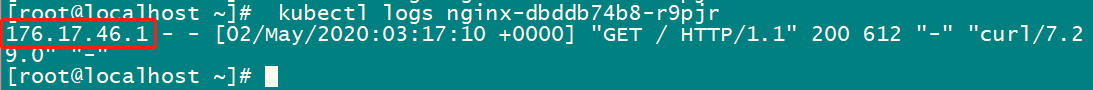

无论master1还是master2都可以查看访问日志

需要先进行提权

需要提权才能看容器日志

# kubectl create clusterrolebinding cluster-system-anonymous --clusterrole=cluster-admin --user=system:anonymous

查看日志

# kubectl logs nginx-dbddb74b8-r9pjr

可看到是本node节点的网关来访问的

2604

2604

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?