基于hadoop搭建Spark环境

需要准备的东西

1. 准备一个配置好的hadoop,master虚拟机

2. 下载下面的三个文件

3. jdk-8u181-linux-x64.tar.gz

4. scala-2.11.1.tgz

5. spark-3.1.2-bin-hadoop3.2.tgz

步骤:

导入虚拟机后打开这个

查看网卡文件

ifconfig -a

修改网络配置

重启网络

重启虚拟机

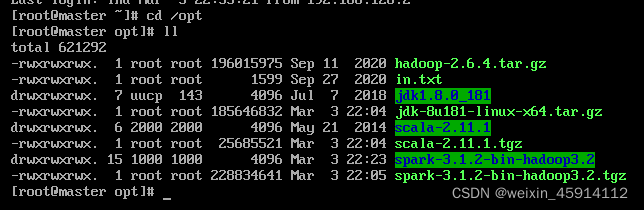

- 上传3个压缩包到虚拟机上,笔者全部放在/opt文件夹下

解压到当前文件夹

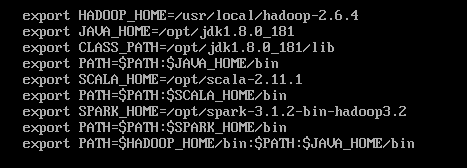

- 修改/etc/profile文件

命令:

vi /etc/profile

保存:

1,Esc

2, :wq

重启或使用下面命令使得修改生效

source /etc/profile

进入spark-3.1.2-bin-hadoop3.2/conf 修改Spark配置文件

- 复制模板文件

cd /opt/spark-3.1.2-bin-hadoop3.2/conf

cp spark-env.sh.template spark-env.sh

cp log4j.properties.template log4j.properties

cp slaves.template slaves

/*如果没有slaves.template 用cp workers.template workers*/

- 修改spark-env设置主节点,和从节点的配置

- 修改slaves设置从节点地址

添加节点主机名称,默认为localhost

注意:这里配置的spark环境只有一个基于Hadoop环境的虚拟机,配置集群的可以配置好之后分发到其他节点

899

899

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?