目录

第四章 决策树总结

这一章主要包括基本流程、划分选择、剪枝处理、连续与缺失值等。

1. 基本流程

什么是决策树?

决策树是基于树的结构来处理决策的,决策树的生成是一个递归的过程,如下图例子。

2.划分选择

不同的决策树划分的方法不同:

-

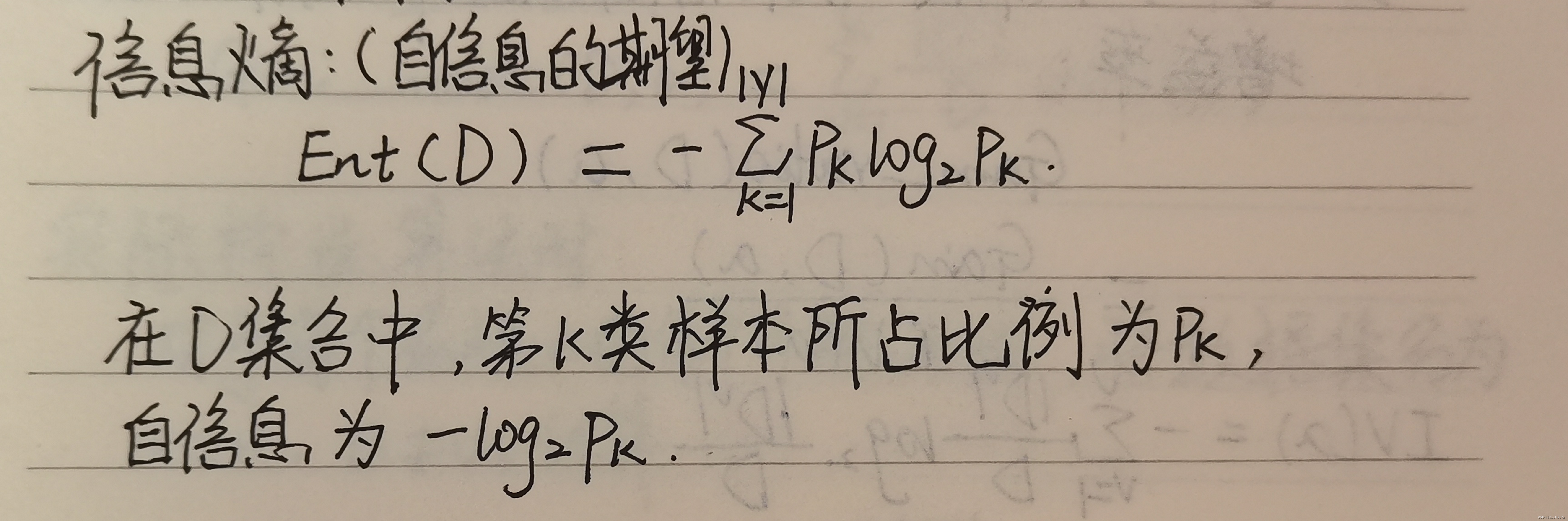

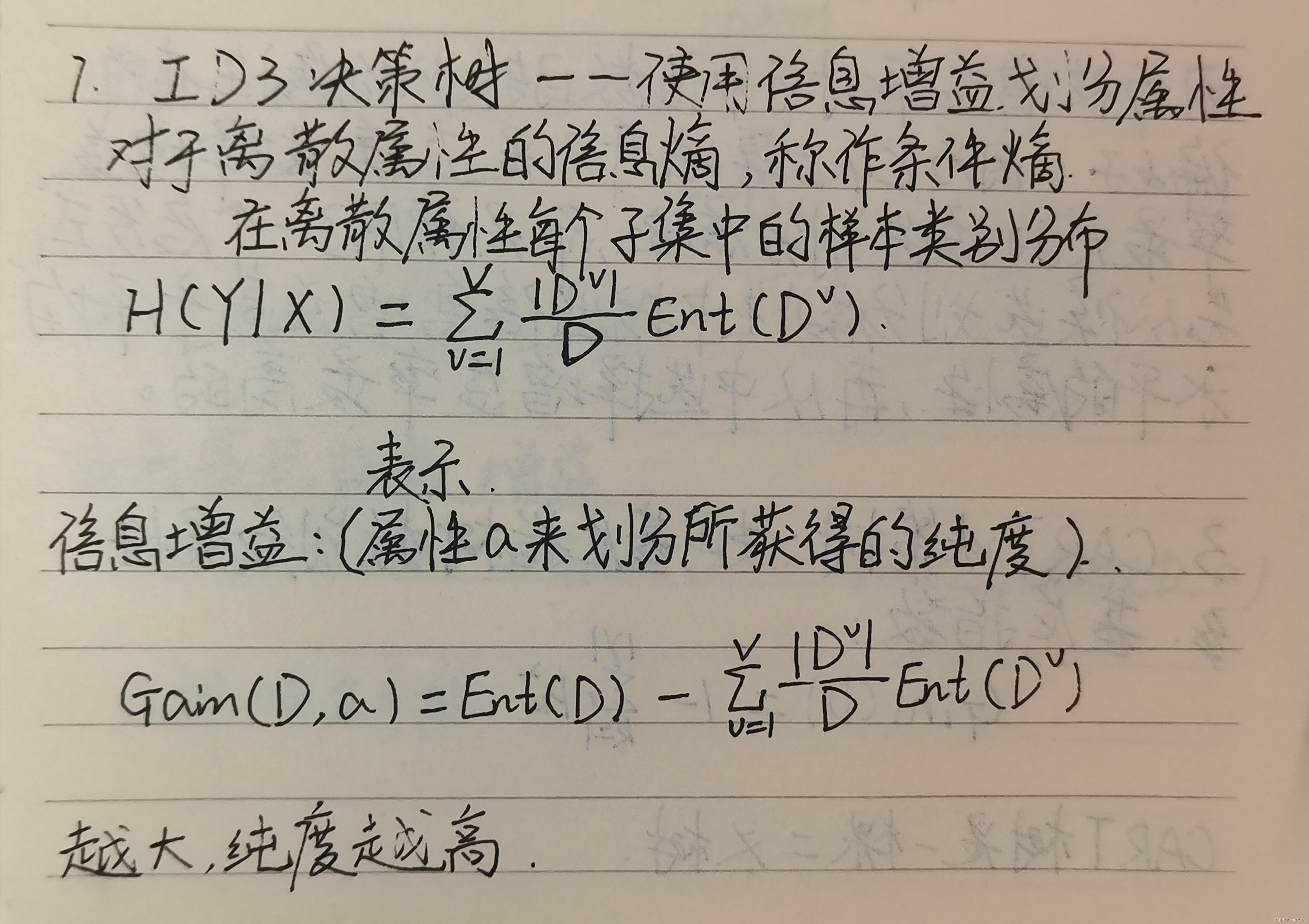

ID3决策树:使用信息增益来划分属性

缺点:倾向于选择属性类别多的,但对于属性中值分类较多的,不具有代表性。

-

C4.5决策树:使用信息增益率划分属性

注意:因为增益率对可取值数目较少的属性有所偏好,因为C4.5算法并不足直接选择增益率最大的候选划分属性,而是使用了一个启发式先从候选划分属性中找出信息增益高于平均水平的属性,再从中选择增益率最高的。

-

CART决策树:使用基尼指数划分属性

3.剪枝处理

预剪枝:

自顶而下,比较划分前和划分后的验证集精度,来判断是否划分当前节点。如果划分后,精度未提升,不进一步划分。

优点:使得决策树部分分支没有展开,降低了过拟合的风险,节省了训练时间。

缺点:有可能出现欠拟合。

后剪枝:

自下而上,先训练整棵树,然后从叶子节点向上剪枝,根据验证集精度判断是否决定剪枝(即是否将当前节点换为叶子节点)。

优点:欠拟合风险很小,泛化性能也很高。

缺点:训练时间比预剪枝时间长。

4.连续与缺失值

连续值处理:

采用二分法对连续属性进行处理,分别计算二分点划分区域的信息增益。

缺失值处理:

1.计算有缺失属性的信息增益时,先计算无缺失部分样本的信息增益,然后乘权重(无缺失在总体中的比例);

2.当缺失该属性的样本进入分支时,以不同的权重分别进入不同的分支(权重为该分支样本占总样本的比例)。

315

315

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?