一、环境准备

1.硬件要求

最低配置:

CPU: 8核+

内存: 16GB+

*供参考:

- 1.5B:中央处理器最低4核,内存8GB+,硬盘图标3GB+存储空间,显卡图标若图形处理器加速可选4 GB+显存,适合低资源设备部署等场景。非必需,

- 7B:中央处理器8核以上,内存16GB+,硬盘8GB+,显卡推荐8 GB+显存,可用于本地开发测试等场景。

- 8B:硬件需求与7B相近略高,适合需更高精度的轻量级任务。

- 14B:CPU 12核以上,内存32GB+,硬盘15GB+,显卡16GB+显存,可用于企业级复杂任务等场景。

- 32B:中央处理器16核以上,内存64GB+,硬盘30 GB+,显卡24 GB+显存,适合高精度专业领域任务等场景。

-

70B:中央处理器32核以上,内存128GB+,硬盘70GB+,显卡需多卡并行,适合科研机构等进行高复杂度生成任务等场景。

2.软件要求

操作系统:Linux。

二、安装deepseek

1.下载ollama

打开ollama官网选择linux

在服务器上使用以下命令安装:

| 1. curl -fsSL https://ollama.com/install.sh | sh |

安装完成后,验证安装:

| 2. ollama --version |

如果输出版本号,则说明安装成功

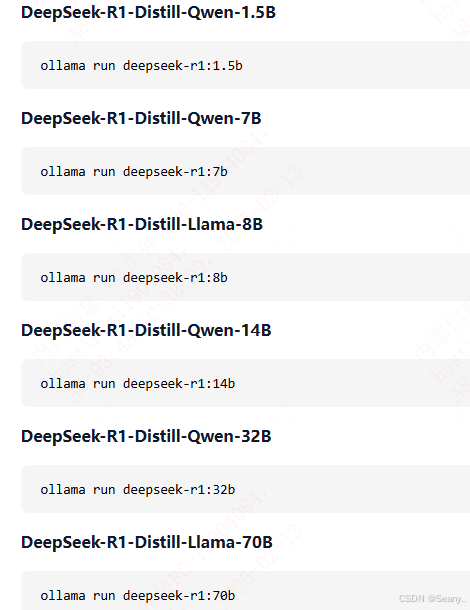

2.下载deep seek

使用如下命令来下载:(以7b版本为例,其他版本同理)

| 1. ollama run deepseek-r1:7b |

一般速度会有点慢,可以考虑加个镜像站(例如:https://pypi.tuna.tsinghua.edu.cn/simple/),

出现“success”表明下载成功。

3.测试与验证

下载好后,再次运行刚刚的命令,即可与其进行对话(如图):

三、交互UI:open web ui

使用命令行与deepseek交互相对不够直观,可以安装open web ui进行交互

首先可以创建一个新的conda环境,并指定Python版本:

- conda create -n open-webui-env python=3.11

- conda activate open-webui-env

- pip install open-webui

随后,启动open-webui服务

- open-webui serve

启动成功后,在浏览器

http://00.00.0.000(替换为你的服务器地址):8080/(例如:http://10.13.6.180:8080/)

左上角可以随意切换解释器模型进行体验。

四、modelscope(魔搭社区)

1.下载

modelscope下载的模型一般都是有微调过,有需要的可以参考。

首先自行编写一个下载模型的.py文件;这里以download_model.py为例。

下载命令:

nohup python download_model.py > download_model.log 2>&1 &

2.导入并启动

先进入指定目录(例如.cd /data/my_materials/LLM_models/)

1、创建Modelfile(可用vim, 名字可自定义), 内容如下

- vim model_file(自定义)

- FROM <model_file.gguf>

例如:

- Vim DeepSeek-R1-Distill-Qwen-14B-Q4_K_M

- From ./DeepSeek-R1-Distill-Qwen-14B-Q4_K_M.gguf

(i为插入,esc切换,:wq退出)

2、导入模型

- ollama create <model_name> -f Modelfile

- ollama create <model_name:7b> -f Modelfile #默认版本是latest, 加冒号可指定版本号

- eg.ollama create "DeepSeek-R1-Distill-Qwen-14B-Q4_K_M" -f "DeepSeek-R1-Distill-Qwen-14B-Q4_K_M"(需要添加引号)

见到success表明导入成功

3、启动模型

ollama run <model_name>

即可。

ps:一些ollama的命令

- ollama serve 开始ollama

- ollama create 创建一个模型

- ollama run 运行模型

- ollama list 模型列表

- ollama ps 正在运行的模型列表

- ollama rm 移除模型

5万+

5万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?