慢慢来,会更好!

大家好,我是一个想研究又不会研究的研究生

陪伴大家一起学习成长!

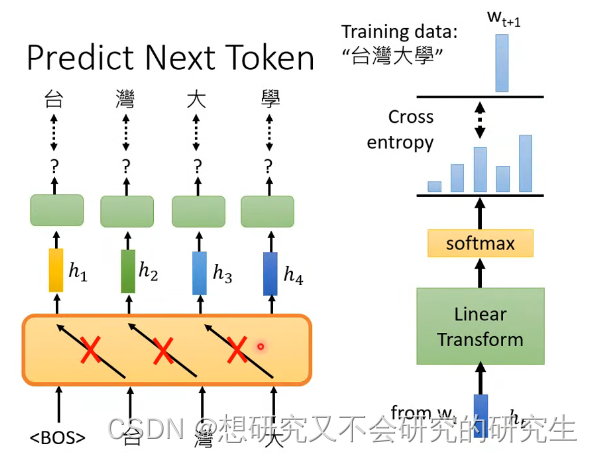

我们前面说Bert做的事情是填空题

而GPT做的任务就是预测接下来会出现的token是什么

例如有笔训练资料是台湾大学,那么输入BOS后训练输出是台,再将台作为输入训练输出是湾

(预测台的时候不会看到湾,预测湾不会看到大等),以此类推即可

模型输出embedding h,h再经过linear transform(线性变换)和softmax后,

计算输出分布与正确答案之间的cross entropy,

希望越小越好(其实和一般的分类问题是一样的)

我们可以不断训练,从而利用GPT来预测下一篇的文章

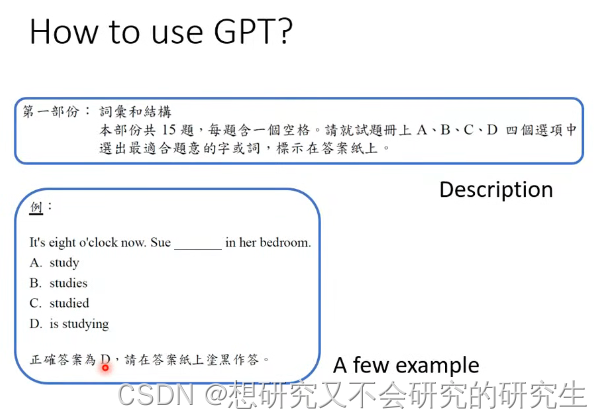

那如何去使用GPT呢?

它有一个更狂的使用方法(所以我们一定要敢狂,才能出奇迹)

描述模型问题和解答范例,模型就能自己开始做题了。这个应用叫few-shot learning(少案例学习),

它不是一般的learining,都没用到gradient descent(梯度下降),所以被叫做In-context Learning

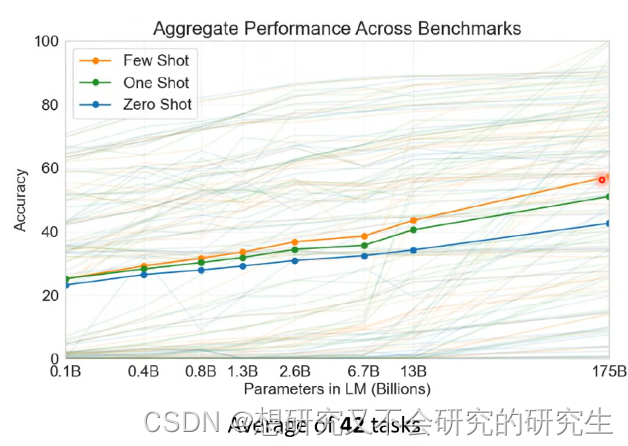

那么,GPT系列有没有完成这些目标呢?

有,但是它的准确率不是太高

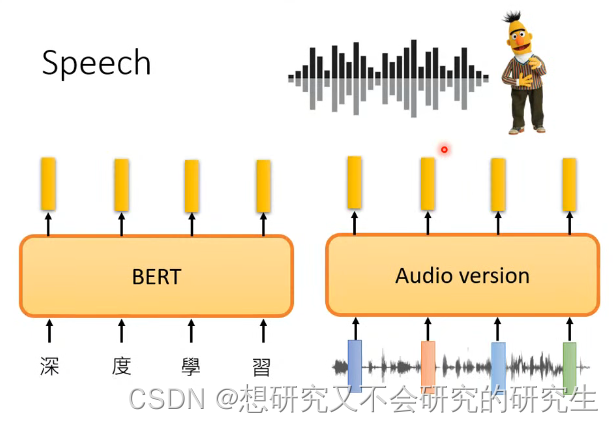

那在语音方面,也完全可以作Bert和GPT

5013

5013

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?