💙💙💙深度学习期末复习题:复习题链接

目录

📌Gradient descent with Momentum(动量梯度下降)

🔮PCA白化

白化是一种重要的数据预处理过程,其目的就是降低输入数据的冗余性,使得经过白化处理的输入数据具有如下性质:

- 特征之间相关性较低;

- 所有特征具有相同的方差。

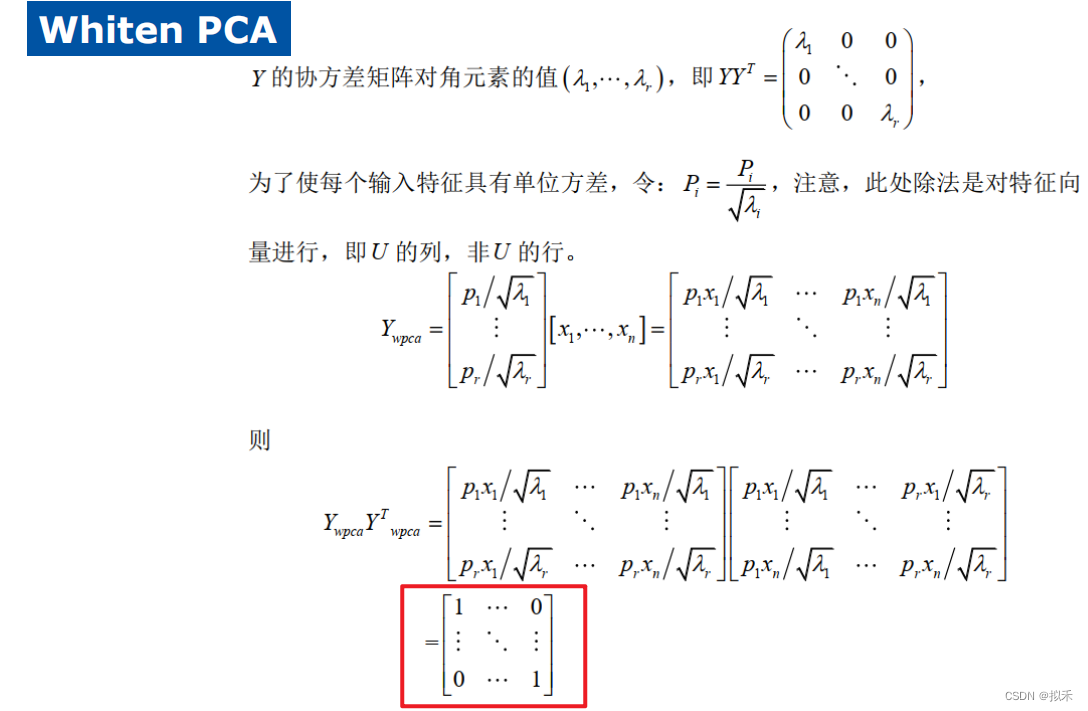

- PCA白化保证数据各维度的方差为1,可以用于降维也可以去相关性。

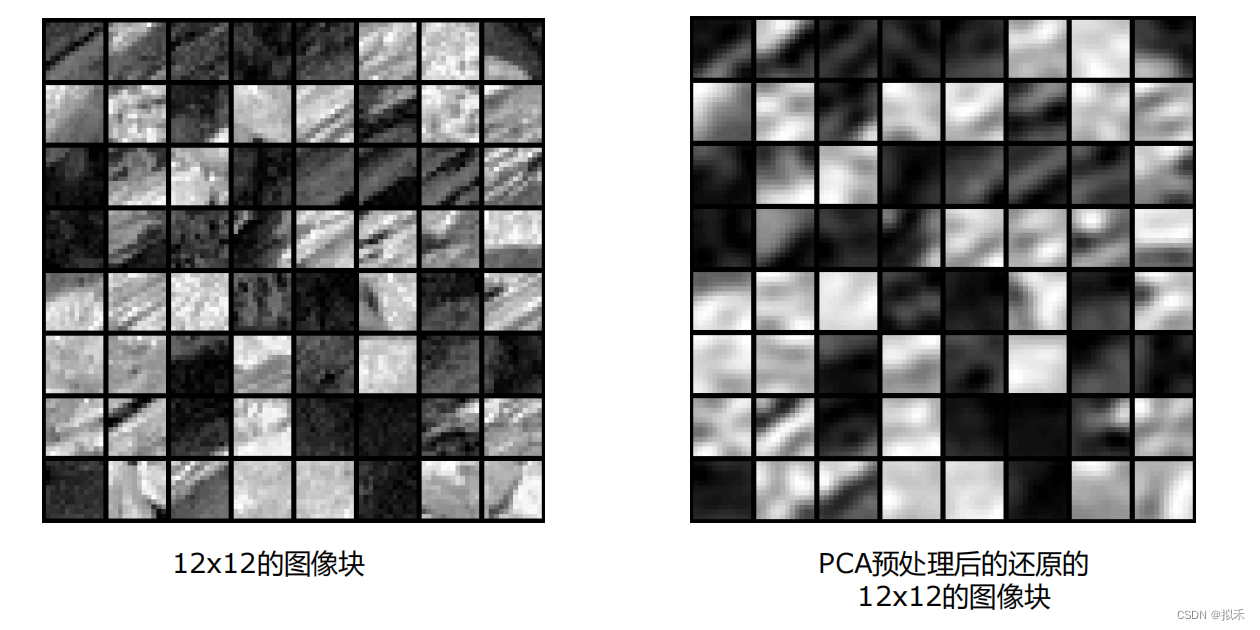

上面两幅图:右边是PCA降维后的数据,左边是原始数据,视觉上可以看出,除了亮度有点区别,其他地方差别很小。

- 0均值处理,确保数据均值为0或者接近0

- 执行PCA,将原始数据映射到不同的特征向量方向上去

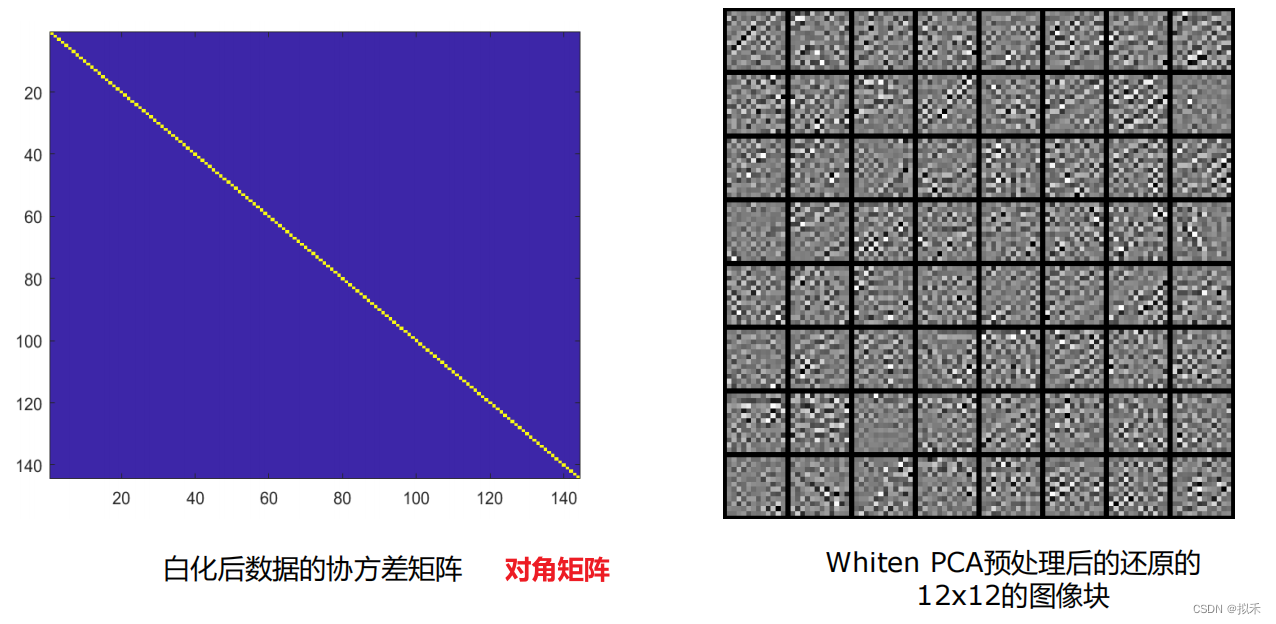

- 验证上面PCA计算出来结果是否正确,若正确的话,映射后的数据的协方差就是一个对角矩阵,将这个对角矩阵可视化以后,可以看到矩形图中一条有颜色不同于背景色的对角线

- 找出到底取前多少个主元合适,这里使用指标是需要保留至少99%方差值

- 降维,根据上一步确定的需要保留的主元数目,对数据降维

- 加入正则化项,对数据进行PCA和白化处理后的数据的协方差矩阵的对角元素都等于1,但是加入正则化参数后,所有对角元素都小于1

🎉迁移学习思想

迁移学习(transfer learning)将从源数据集学到的知识迁移到目标数据集,或者定义为将某个领域或任务上学习到的知识或模式应用到不同但相关的领域或问题中。

主要思想:从相关领域中迁移标注数据或者知识结构、完成或改进目标领域或任务的学习效果。

🎅微调(fine-tuning)

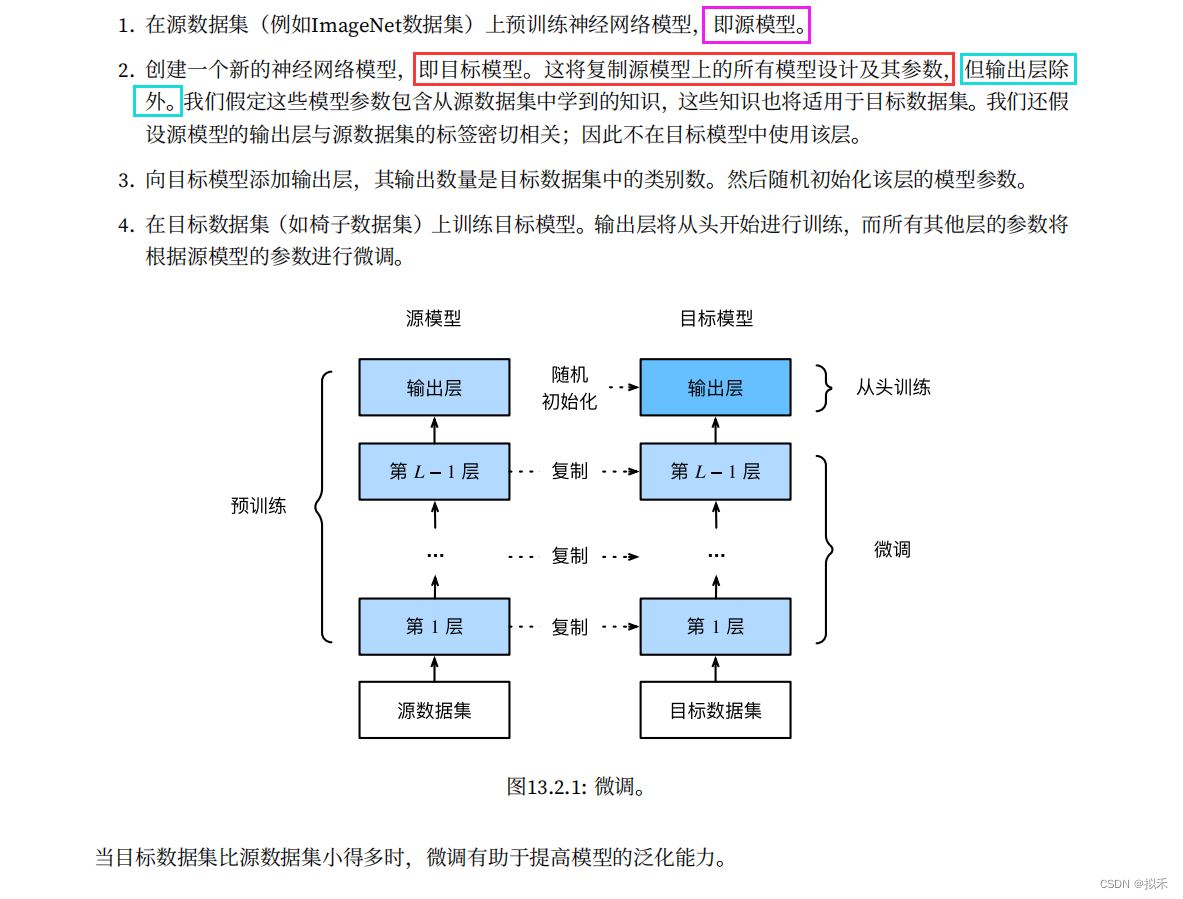

- 迁移学习将从源数据集中学到的知识“迁移”到目标数据集,微调是迁移学习的常见技巧。

- 除输出层外,目标模型从源模型中复制所有模型设计及其参数,并根据目标数据集对这些参数进行微调。但是,目标模型的输出层需要从头开始训练。

- 通常,微调参数使用较小的学习率,而从头开始训练输出层可以使用更大的学习率。

🎁正则化

- 深度学习中可能存在过拟合问题——高方差。

- 这种情况有两个解决方法,一个是正则化,另一个是准备更多的数据

- 考虑到获取更多数据的成本较高,且某些情况下无法获取更多数据,因此正则化通常有助于避免过拟合或减少网络误差。

- 正则化的目的是为了防止过拟合,进而增强泛化能力

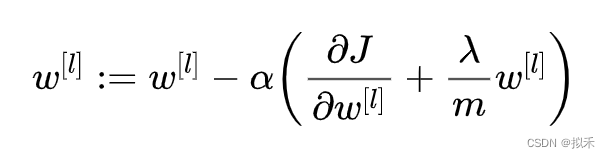

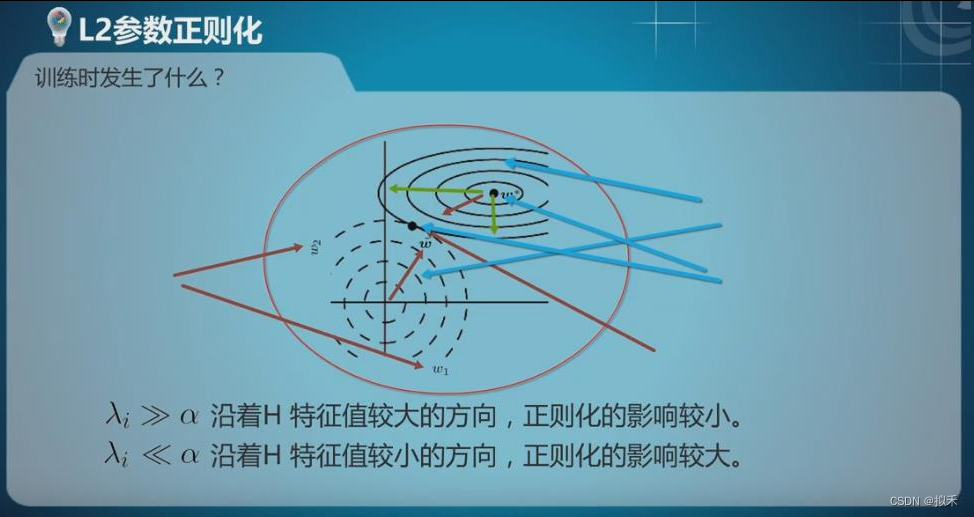

🎋权重衰减(L2正则化项)

- 由于正则化项的存在,我们在使用梯队下降法,求损失函数对w的偏导数时,就会发现偏导数相比于没有正则化项,有所增加一项。

- 因此最终选择时,参数w会变得更小。参数更小,对于模型来说,就意味着更加简单,越简单的模型越不容易产生过拟合现象。

- 直观上理解就是,正则化项 λ 设置的足够大,权重矩阵w会随之变小,即更多的神经元权重降低,甚至于彻底消除部分神经元的影响。

- 此时原本复杂的神经网络就会被简化成一个神经元数量较少,但深度不变的网络,网络会从过度拟合(高方差)状态向高偏差、低方差方向发展。

🎃如何提高神经网络的泛化能力

- L1和L2正则化

- Early Stop

- 权重衰减

- SGD

- Dropout

- 数据增强

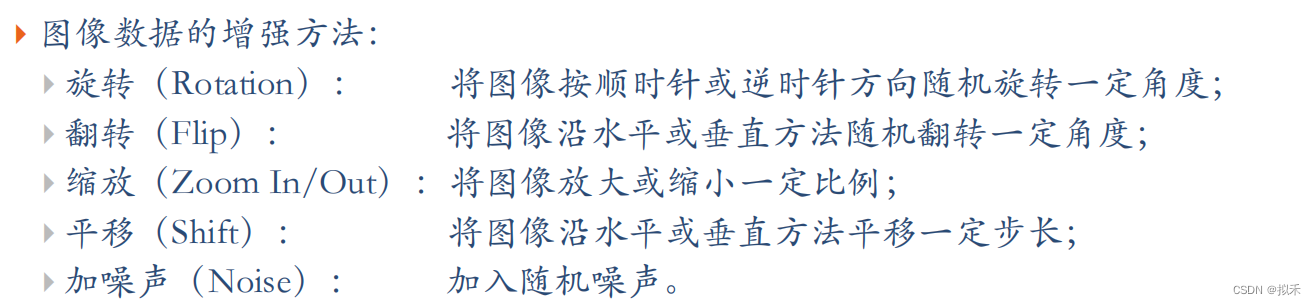

🎇数据增强

图像数据的增强主要是通过算法对图像进行转变,引入噪声等方法来增加数据的多样性。

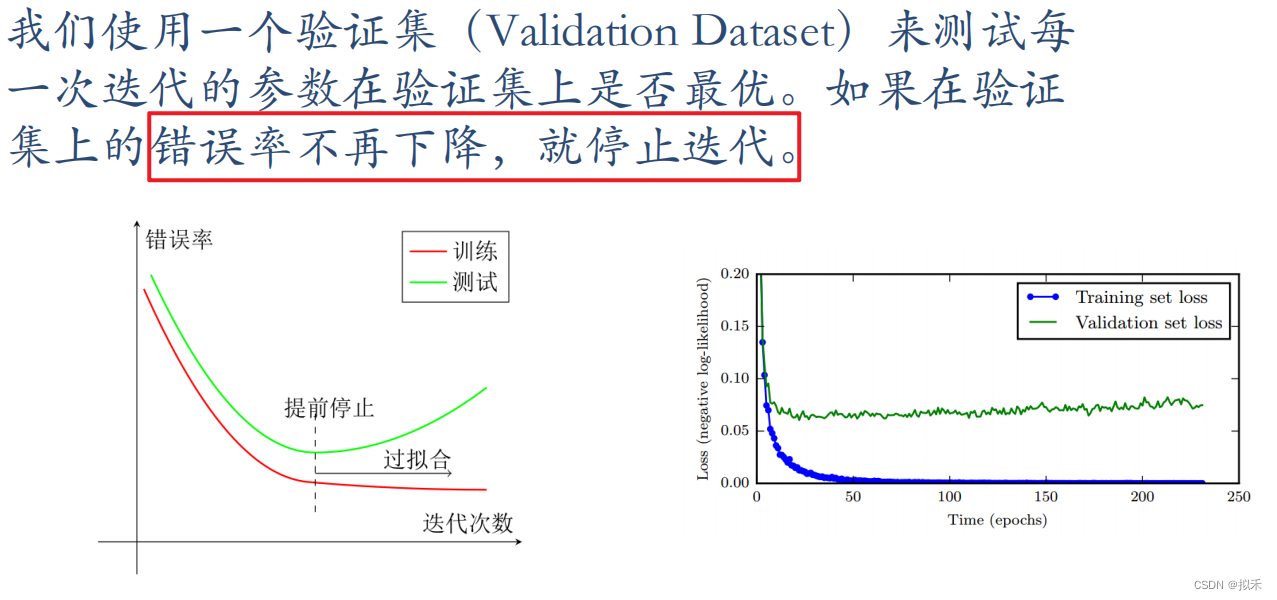

📀提前终止

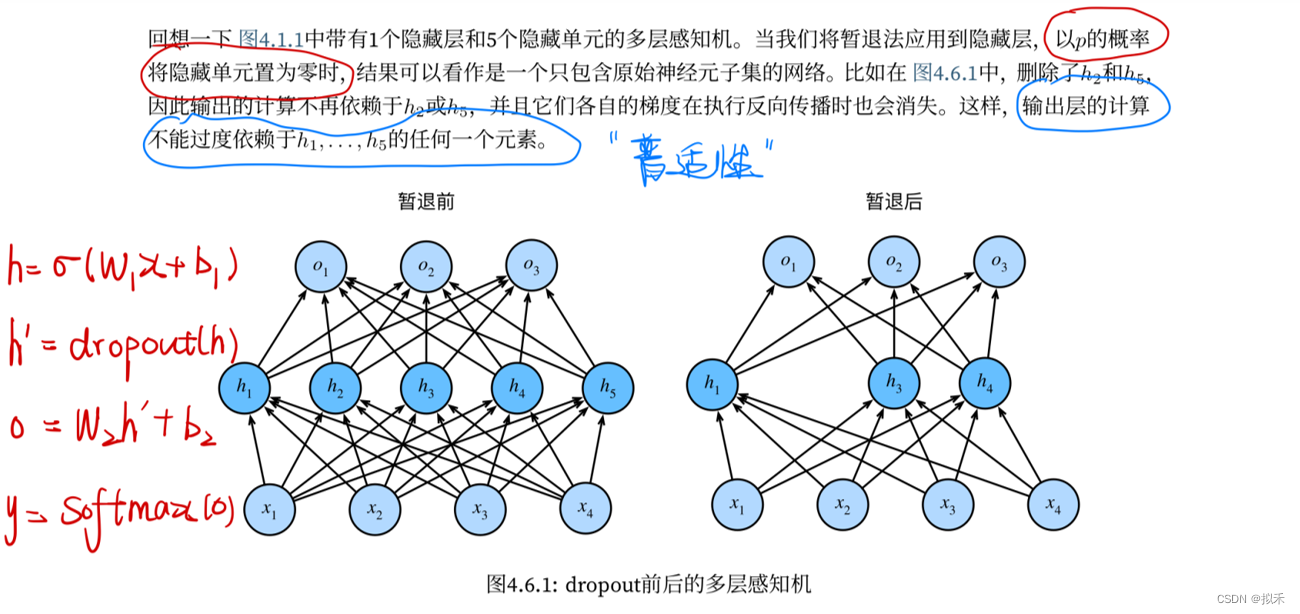

👻Dropout

- 暂退法在前向传播过程中,计算每一内部层的同时丢弃一些神经元。

- 暂退法可以避免过拟合,它通常与控制权重向量的维数和大小结合使用的。·

- 暂退法将活性值h替换为具有期望值h的随机变量。

- 暂退法仅在训练期间使用。

- 在bagging中,所有的分类器都是独立的,而在dropout中,所有的模型都是共享参数的。

- 在baging中,所有的分类器都是在特定的数据集下训练至收敛,而在dropout中没有明确的模型训练过程。网络都是在一步中训练一次

- 对于训练集来说,每一个子网络的训练数据是通过原始数据的替代采样得到的子集。

🎓稀疏表示

- 高维数据的稀疏表示是近些年是机器学习和计算机视觉研究领域的热点之一,其基本假设是:自然图像本身为稀疏信号,用一组过完备基将输入信号线性表达出来,展开系数可以在满足一定的稀疏度条件下,获取对原始信号的良好近似。

- 研究人员发现,尽管稀疏表示的优化模型是从信号重建的角度建立的,但其表示结果在模式识别中都有很好的表现,许多当前最好的分类系统往往都会选用稀疏表示作为其关键模块。

- 即提取重要特征,这些重要特征在全局看来是稀疏的

💣优化算法

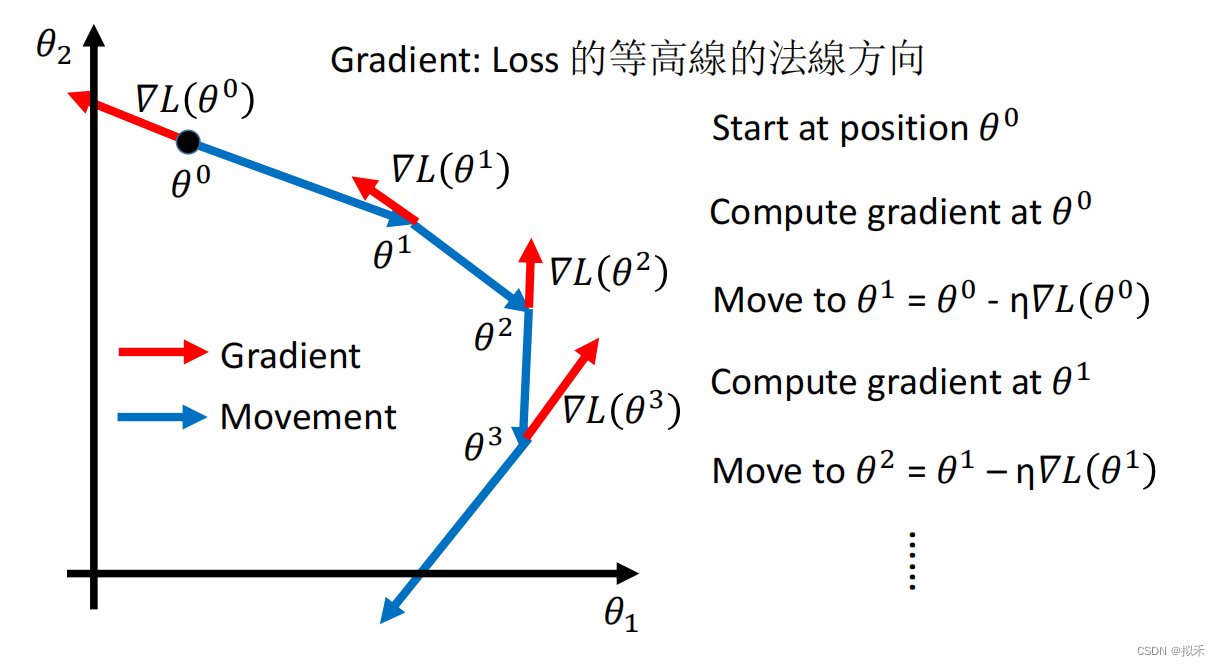

🔪Gradient Descent

💉SGD

- SGD用很小的一个(从大数据里面)随机挑选的子集的数据做训练,因此计算量是恒定的,短期效果可能波动大一些,但长期效果不差。

- 而且随机梯度下降算法,可以避免普通梯度下降算法,掉到一个局部极值里出不来的陷阱

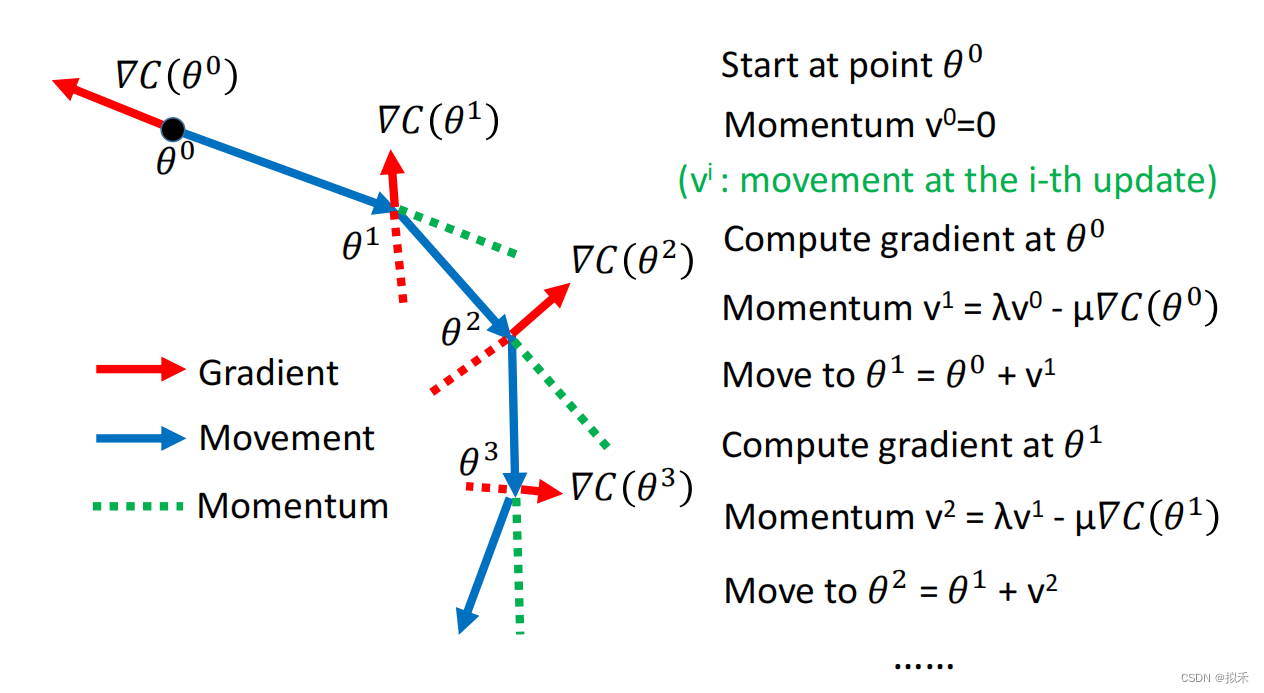

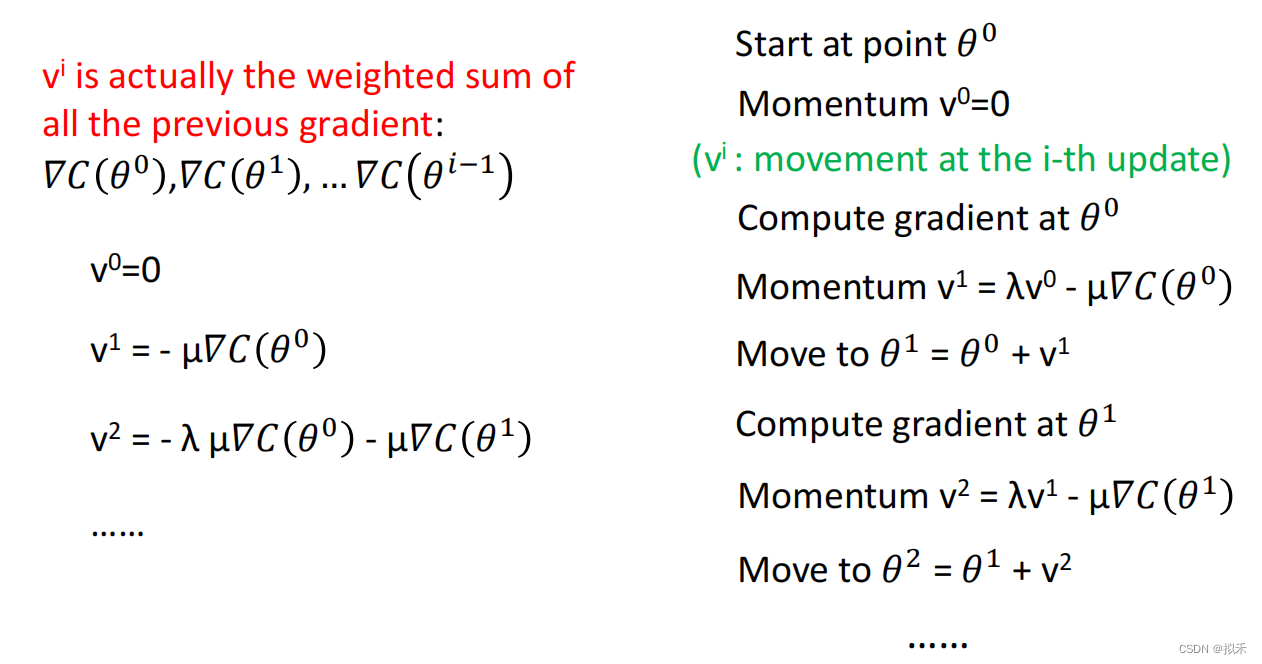

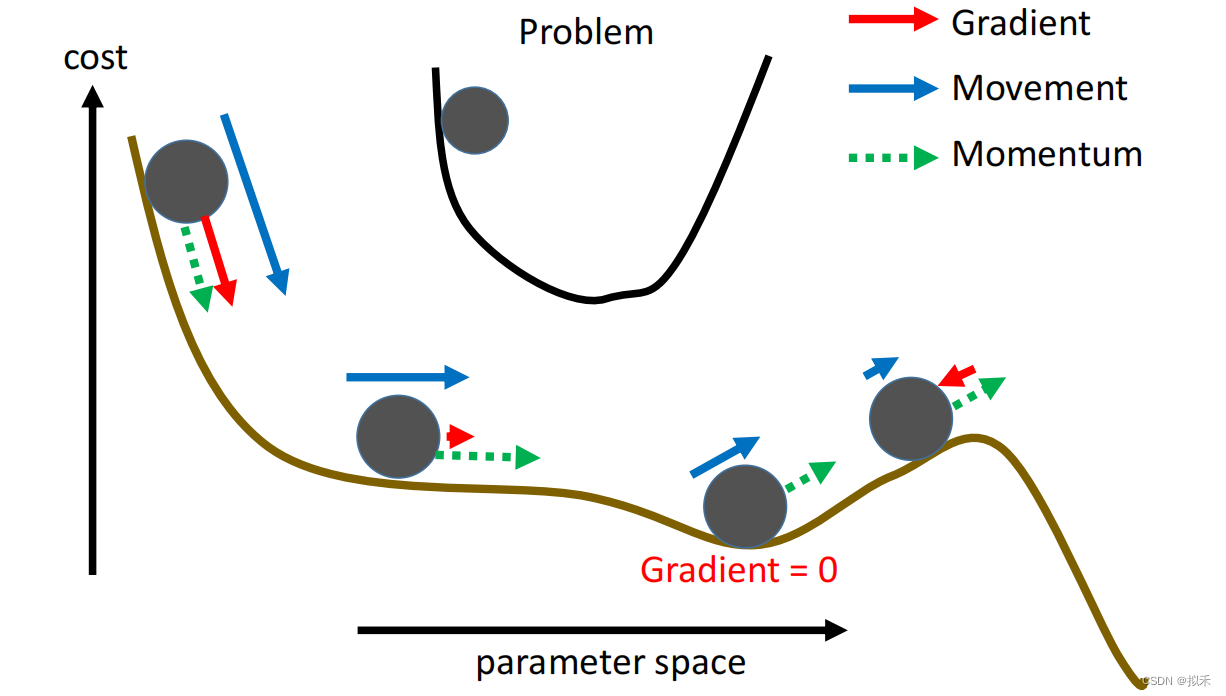

📌Gradient descent with Momentum(动量梯度下降)

动量的主要目的是解决两个问题:

- Hessian矩阵的病态条件

- 随机梯度的方差

✏️参数初始化方案

Xavier初始化的一个目的就是使前向传播和反向传播过程中每一层的输入和输出都具有相似的分布,即输入和输出的方差相同。

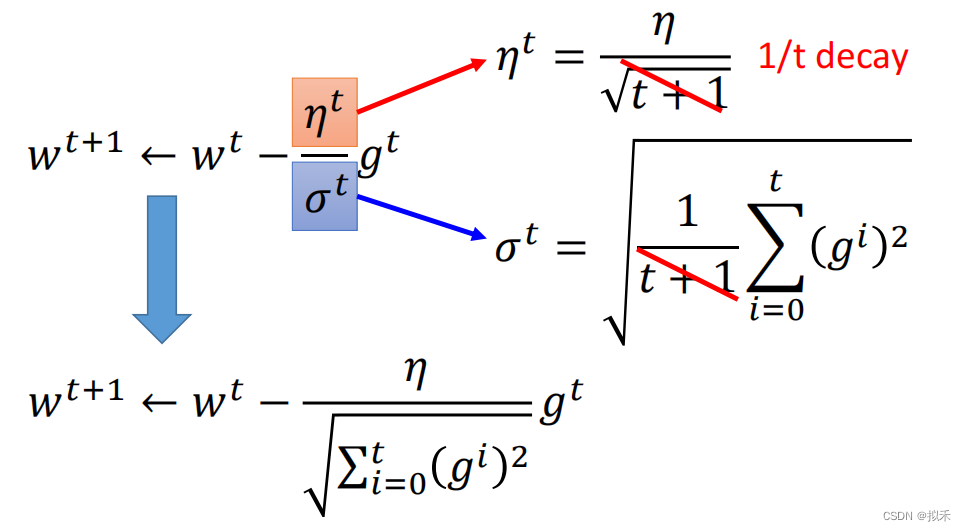

📁Adagrad

Adagrad优化算法被称为自适应学习率优化算法,之前我们讲的随机梯度下降对所有的参数都使用的固定的学习率进行参数更新,但是不同的参数梯度可能不一样,所以需要不同的学习率才能比较好的进行训练,但是这个事情又不能很好地被人为操作,所以Adagrad便能够帮助我们做这件事。

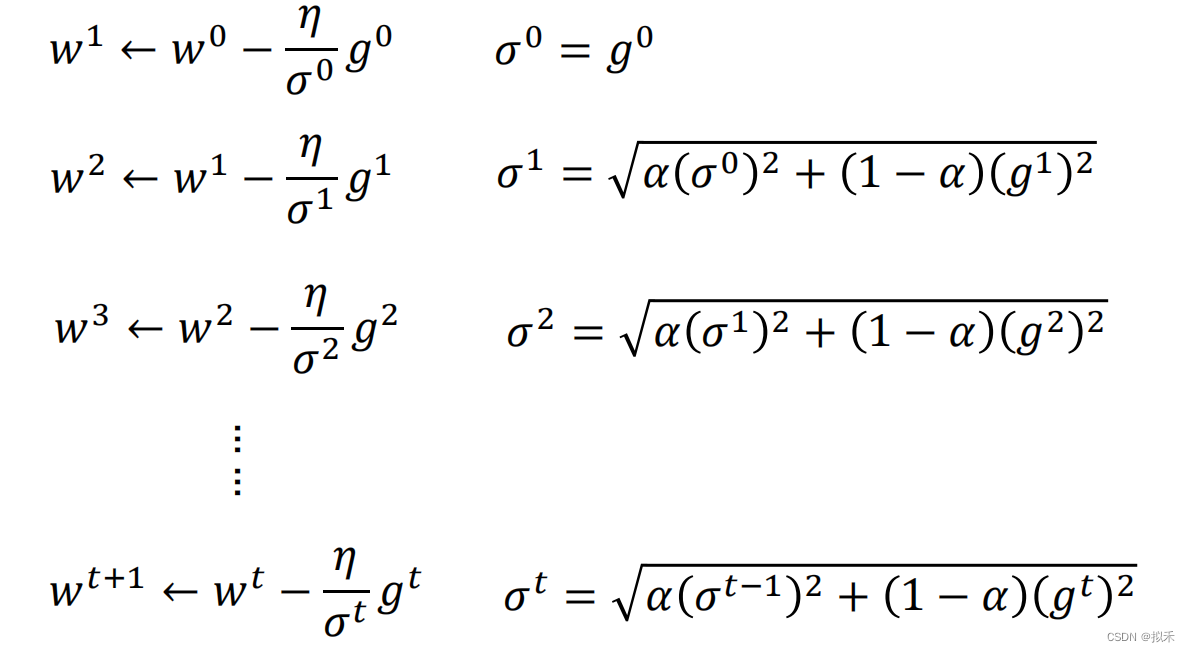

📎RMSProp

Adagrad优化算法的改进:

- 在 AdaGrad 算法中,由于梯度分量的直接累加,步长随着迭代的进行而单调递减, 这可能导致后期步长过小。

- PMSProp 则在此基础上引入权重参数 ρ,其对应的分量累计变为加权和

📗Adam

Adam吸收了Adagrad (自适应学习率的梯度下降算法)和动量梯度下降算法的优点,

既能适应稀疏梯度(即自然语言和计算机视觉问题),又能缓解梯度震荡的问题

🏀Batch Normalization(批量标准化)

PCA白化对图像的像素值分布变换为以0为均值,单位方差的正态分布数值时(这种操作被称为whiten),可以加速网络收敛。

随着网络的深度增加,每层特征值分布会逐渐的向激活函数的输出区间的上下两端(激活函数饱和区间)靠近,这样继续下去就会导致梯度消失。BN就是通过方法将该层特征值分布重新拉回标准正态分布,特征值将落在激活函数对于输入较为敏感的区间,输入的小变化可导致损失函数较大的变化,使得梯度变大,避免梯度消失,同时也可加快收敛。

Batch Normalization可以用来缓解深度神经网络的 Internal Covariate Shift 问题

- ICS问题就是说,如果训练数据在经过网络的每一层后其分布都发生了变化,此时就不能保证整个网络的优化过程是高效的,甚至说会极大地降低网络的优化效率。

BN优缺点:

- 减少梯度消失,加快了收敛过程。

- 起到类似dropout—样的正则化能力,一定程度上防止过拟合。

- 放宽了一定的调参要求。

- 可以替代LRN。

- 但是需要计算均值与方差,不适合动态网络或者RNN。计算均值方差依赖每批次,因此数据最好足够打乱。

💙💙💙深度学习期末复习题:复习题链接

6885

6885

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?