使用本地和边缘数据构建生成式AI应用

关键字: [Amazon Web Services re:Invent 2024, 亚马逊云科技, 生成式AI, LLaMa CPP, Generative Ai Applications, On-Premises Data, Edge Data, Data Residency, Edge Infrastructure]

导读

受监管行业的客户希望利用生成式人工智能处理敏感数据,但由于数据驻留要求,这些数据必须保留在本地。此外,一些在边缘生成数据的客户需要在本地运行小型语言模型(SLMs)以进行实时处理。本次会议探讨如何使用亚马逊云科技混合和边缘服务为本地和边缘用例选择、微调和部署SLMs。了解如何使用本地数据运行检索增强生成(RAG)以改善提示结果。理解模型在准确性、性能和成本效率方面的权衡,并发现安全性、可扩展性和高可用性的架构最佳实践。

演讲精华

以下是小编为您整理的本次演讲的精华。

本次会议由Scott Rose主持,他热情欢迎与会者出席2024年亚马逊云科技 re:Invent大会,并介绍了“在本地和边缘构建生成式AI应用程序”的主题。他的同事Chris McGively和Fernando Gelvez的主要工作是协助客户在亚马逊云科技公有云区域之外的边缘设计和架构解决方案。

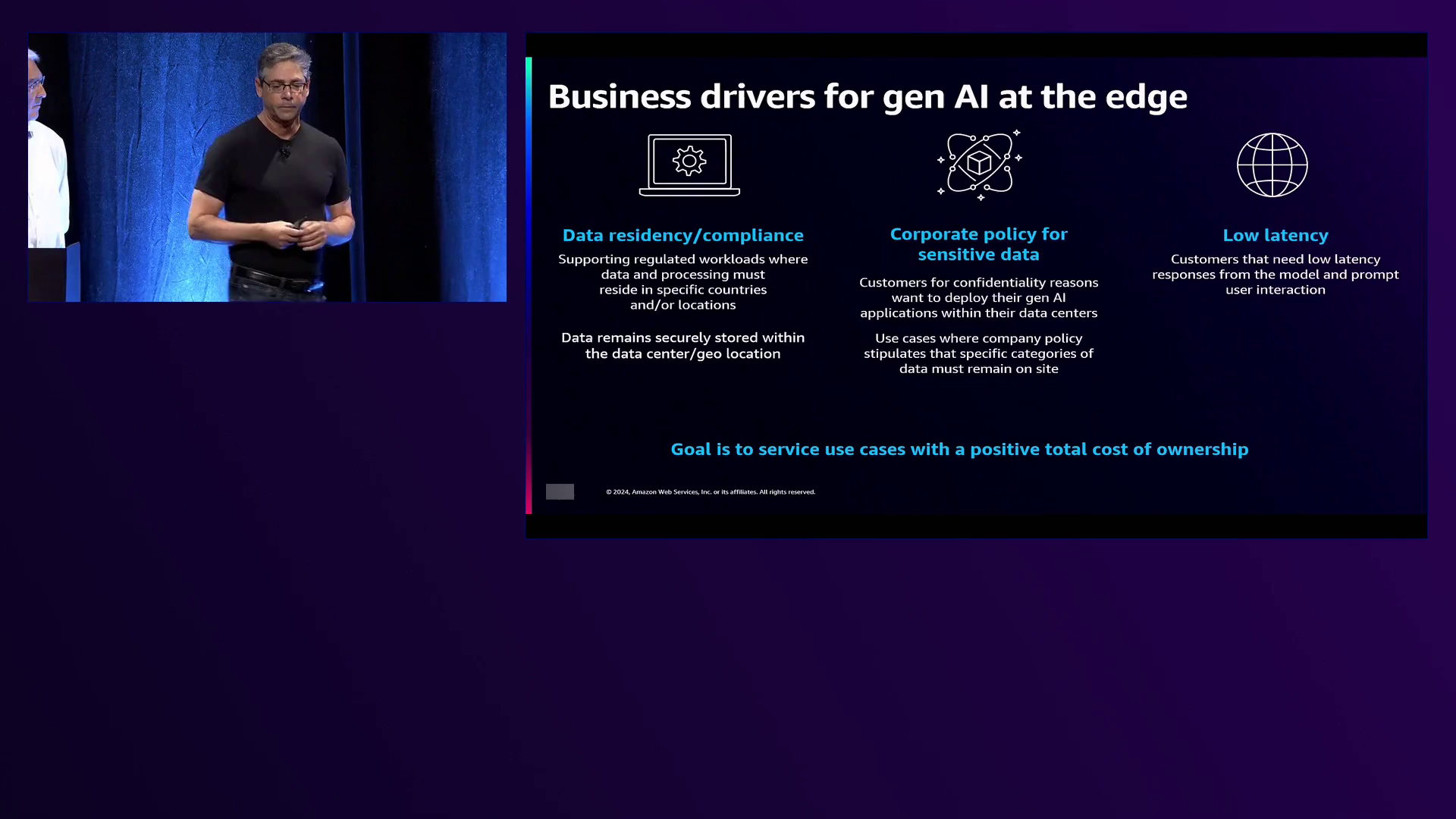

Scott解释说,虽然亚马逊云科技在其公有云区域内正在大力推进生成式AI的发展,但由于数据驻留、延迟等因素或法律要求,许多客户无法在这些环境中部署数据和工作负载。本次会议的主要目标是探讨如何在公有云区域之外的边缘部署生成式AI解决方案。

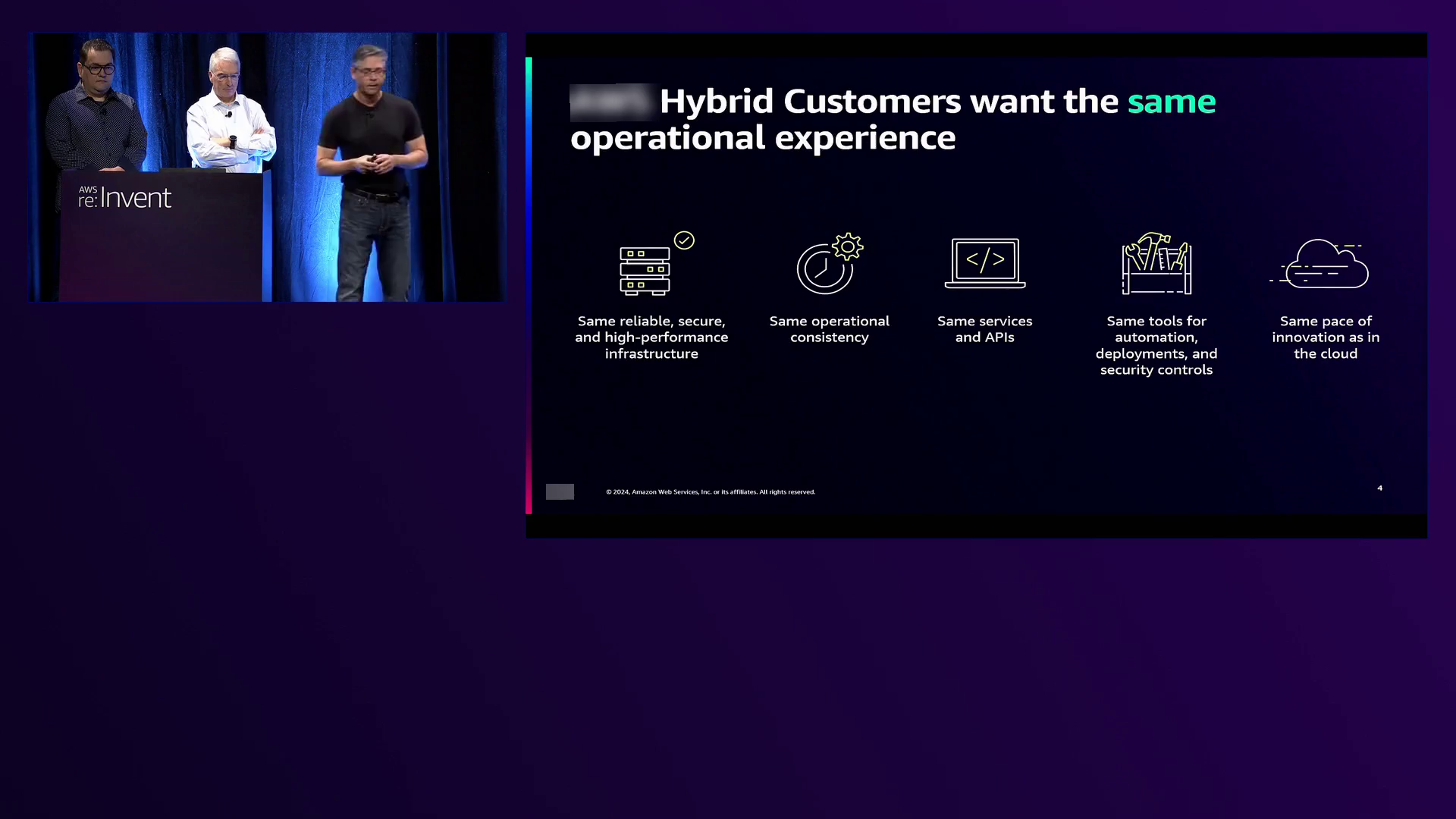

Scott强调亚马逊云科技致力于提供选择性,努力为客户提供最佳选择,以便根据特定用例将数据与最合适的模型相结合进行部署。他还强调亚马逊云科技在公有云区域和边缘部署中保持一致的方法,确保相同的可编程性和API,从而为开发人员提供无缝体验。

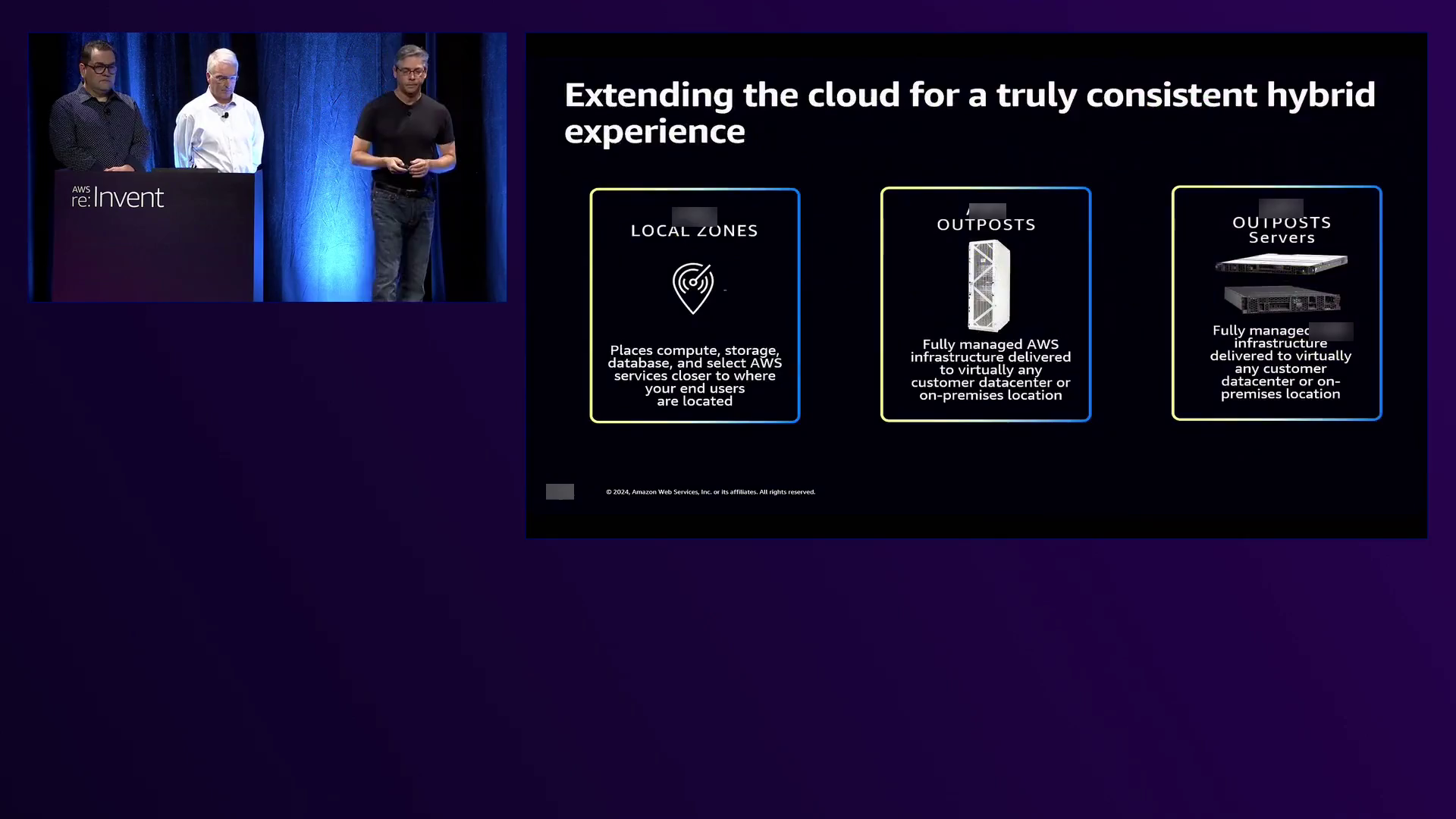

为满足不同客户的需求,亚马逊云科技提供了多种混合云形式,包括Amazon Outposts本地基础设施解决方案(提供完整机架和1U/2U服务器形式)、以及在大都市设施中战略部署的多个Outpost机架组成的Local Zones,支持跨边缘基础设施的多租户体验。

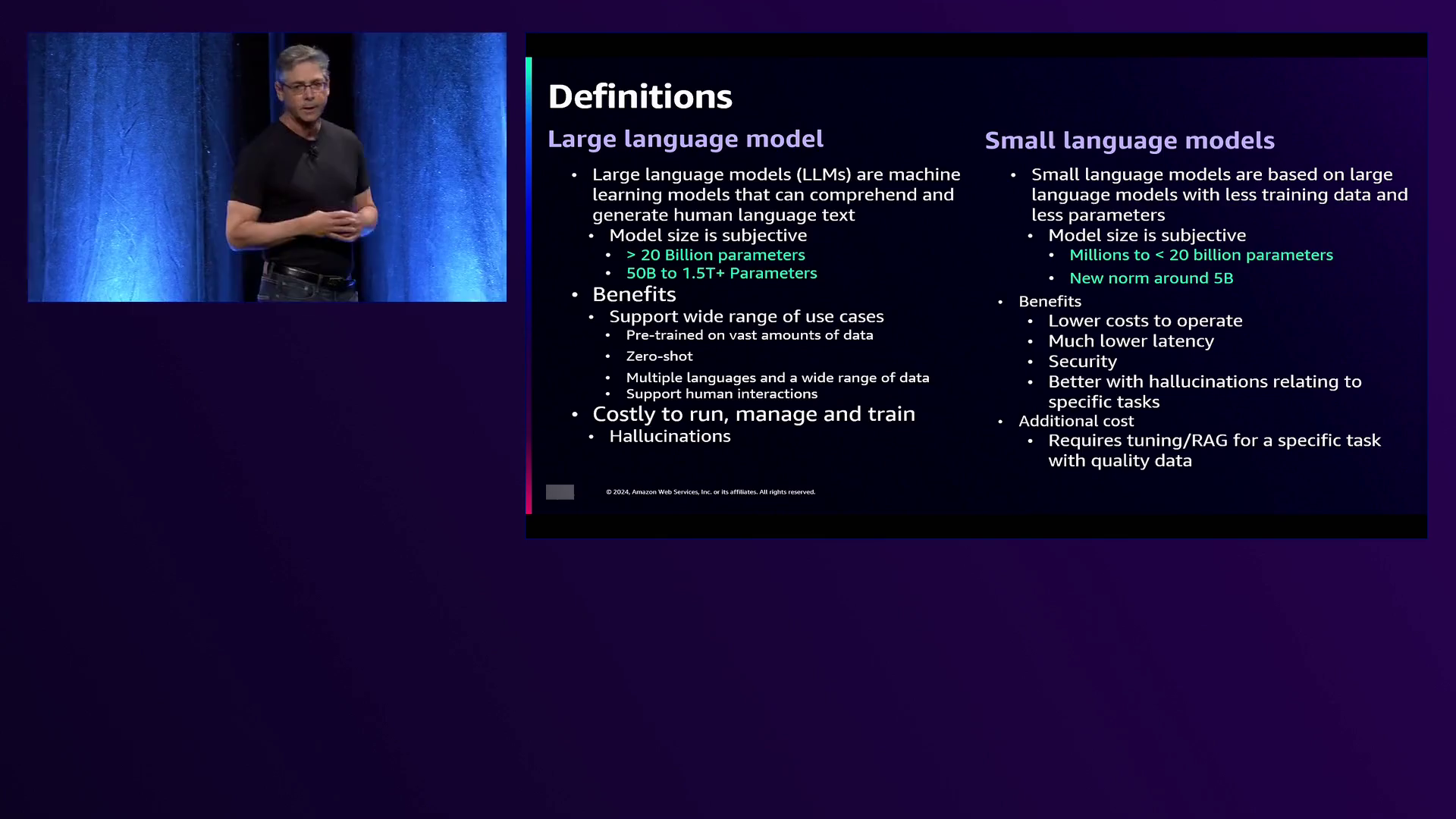

在讨论语言模型时,Scott区分了大型语言模型(LLM,参数超过200亿)和小型语言模型(SLM,参数不超过200亿)。他解释说,SLM针对特定用例进行了微调,擅长处理一组有限的问题和回答,而LLM则能够处理更广泛的查询和人机交互。

推动在边缘部署生成式AI的主要业务驱动因素包括数据驻留要求、数据合规性和低延迟需求。使用案例包括计算机视觉应用、传感器、监视器和模型之间的高速交互以实现准确响应和后续操作,以及聊天机器人、个性化、语音转文本、内容创作、摘要、代码生成、文档处理和流程优化等。

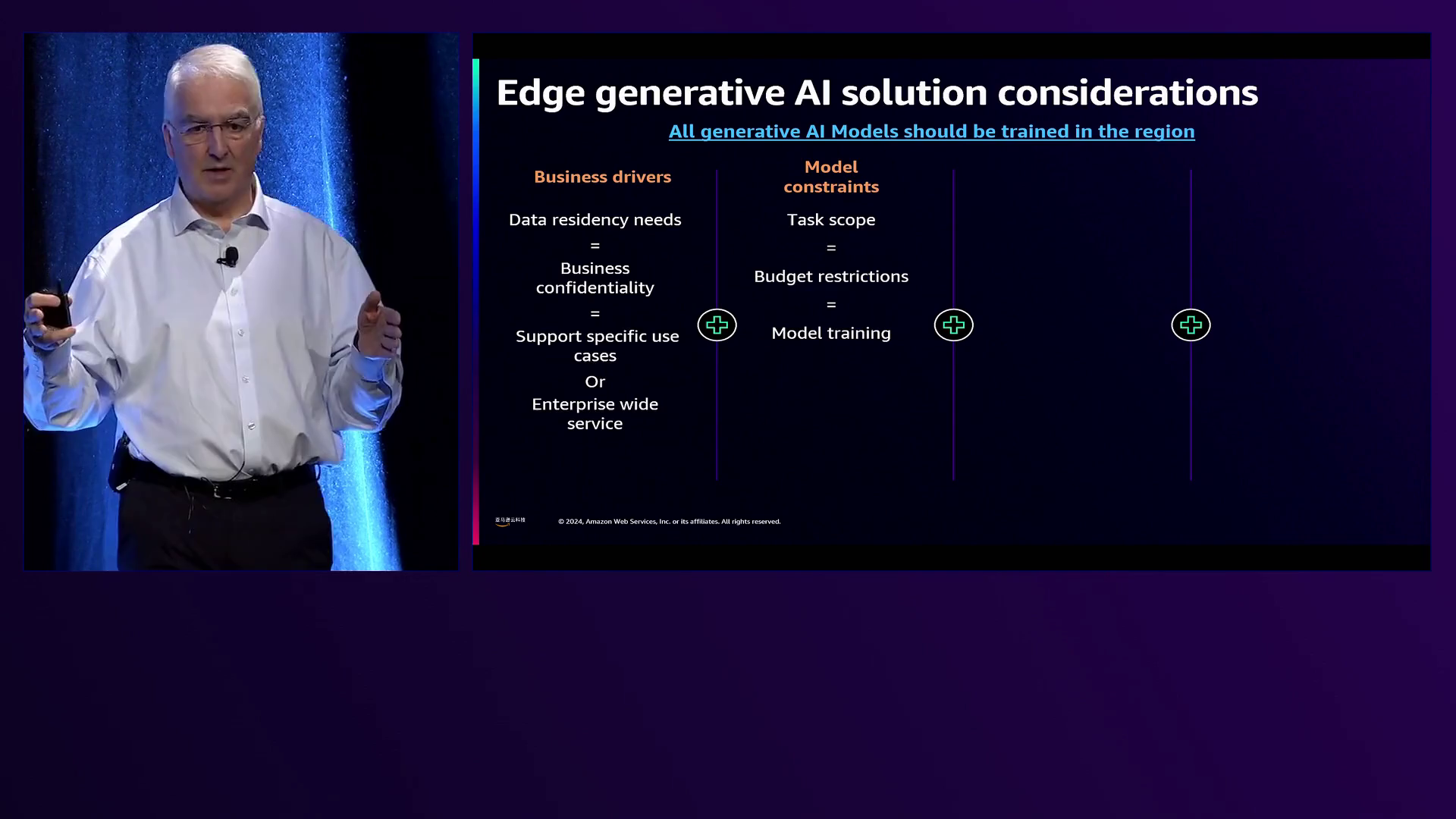

Chris McGively随后探讨了在SLM和LLM之间进行选择的架构考虑因素,包括任务范围、预算限制、训练策略、性能标准(如每秒令牌数、延迟和准确性)以及客户对多个特定任务模型或单一企业级模型的偏好。

Chris介绍了亚马逊云科技采用的开源框架LLaMa CPP,该框架有助于在边缘高效部署和优化模型。他阐述了他们的架构,利用亚马逊云科技 VPC、负载均衡器和GPU实例来运行托管模型的LLaMa CPP服务器。

Fernando Gelvez随后演示了在洛杉矶Amazon Local Zones上运行的生成式AI应用程序的实时部署,展示了SLM和LLM之间的性能差异,以及使用检索增强生成(RAG)通过整合外部数据源来提高准确性的影响。

Chris和Fernando的演示强调,对于特定用例、受监管市场或需要保密数据的场景,SLM表现出色。他们强调优化模型的上下文大小、温度和每秒令牌数等参数以获得最佳性能的重要性。

此外,他们解释了微调和RAG架构如何显著提高SLM的准确性,同时保持数据与模型的分离。RAG架构支持动态数据集成、减少幻觉、提高响应可追踪性,从而增强透明度和合规性。

虽然承认LLM的准确性更高,但Chris和Fernando演示了结合RAG和微调技术的SLM可以以较低的成本和更好的性能指标实现可比的准确性。具体而言,Chris提到,对于相同数量的令牌,SLM的成本约为LLM的2-5%。

为了证实这一点,Chris和Fernando举例说明,一家银行之前每月花费约5万美元为客户生成详细报告,这个过程需要几天时间。但通过利用生成式AI模型,银行将成本降低到每月1万美元,报告生成过程缩短至几小时,可供最终审批。

另一个引人注目的用例是与一家卫生当局的合作。最初,该当局将资源集中在16岁及以上的用户身上,因为他们认为这个年龄段是某项服务的主要用户。但在部署生成式AI模型后,他们发现主要用户实际上是40至45岁之间的人群。通过满足这个人群的需求,卫生当局将救护车费用降低了80%。

Chris进一步阐述了架构考虑因素,强调根据具体任务选择合适的模型的重要性。他举例说明,一位客户最初打算使用大型语言模型生成复杂报告,但最终由于成本考虑而选择了SLM,因为SLM的每个令牌成本仅为LLM的2-5%。

在讨论训练策略时,Chris建议在亚马逊云科技区域进行所有模型训练,并举例说明一位客户最初在边缘基础设施上使用GPU进行训练,耗时约30天。但将训练过程迁移到亚马逊云科技区域后,时间缩短至2天,同时降低了成本并减少了环境影响。

Chris和Fernando强调微调SLM以提高准确性并使其与客户的特定领域和术语相一致的重要性。他们举例说明,对于“什么是X?”这样的通用查询,未经训练的SLM会给出通用回答。但在使用精心策划的数据集对模型进行微调后,相同的查询会得到与客户应用程序和特定领域语言相关的回答,大大提高了模型的实用性和相关性。

会议还探讨了RAG架构的细节,Chris和Fernando赞扬它能够提高模型准确性并防止幻觉。他们解释说,RAG架构允许将数据存储在SLM或LLM之外的外部数据库中,从而增强数据安全性并减小部署的攻击面。在一个客户用例中,使用了RAG架构来整合实时数据源(如股票价格),为模型提供最新信息。

在现场演示中,Fernando展示了将RAG架构与SLM集成的情况,说明如何通过整合外部数据源(如PDF文档或数据库)来显著提高模型回答有关特定事件或原始训练数据中不存在的信息的查询的准确性。例如,当被问及2024年亚马逊云科技 re:Invent会议的详情时,没有RAG的SLM无法提供准确信息,因为其训练数据截止日期早于该活动。但使用了会议详情PDF的RAG增强SLM则能准确回答有关会议开始时间和其他细节的查询。

在讨论性能考虑因素时,Chris全面分析了SLM和LLM在速度、延迟、成本和准确性方面的权衡。他指出,对于每个呼叫中心代理需要每秒6个令牌的客户要求,他们的测试显示,单个GPU可以同时支持长度为16、32、48和64个令牌的高达32个并发提示,并在大多数模型上保持线性性能增长。但超过32个提示后,吞吐量开始下降,需要使用额外的GPU来满足客户需求。

此外,Chris指出,虽然人类可能无法分辨150毫秒以下的延迟,但他们的测试显示,大多数模型都可以在此延迟阈值内处理长度不超过32个令牌的提示,而较小的模型在处理长度为48和64个令牌的提示时表现更好。

值得注意的是,Chris强调,选择模型时不仅要考虑最大令牌/秒和延迟,还要考虑特定用例所需的准确性。他表示,虽然LLM通常表现出更高的准确性,但结合RAG架构和微调的SLM在通用测试中可以实现接近LLM正负1%的准确度,但成本只是LLM的一小部分。

在总结陈词时,Scott、Chris和Fernando重申了亚马逊云科技致力于为客户提供选择权和跨公有区域与边缘部署的一致体验。他们鼓励与会者利用遍布美国、欧洲和其他国际地区的亚马逊云科技外围测试实验室,在亚马逊云科技混合团队的协助下,免费测试和评估其在边缘基础设施上的工作负载。

本次会议强调了亚马逊云科技在边缘生成式人工智能领域不断发展的能力,这与其在公有云区域的产品形成了互补。Scott、Chris和Fernando向与会者发出开放邀请,与亚马逊云科技的团队互动,利用他们在构建和部署生成式人工智能解决方案方面的专业知识,满足特定的使用案例、数据驻留需求和成本限制。

下面是一些演讲现场的精彩瞬间:

亚马逊云科技推出了在边缘部署自然语言AI (NLAi)的突破性进展,使客户能够利用超越公有云区域的尖端技术。

亚马逊云科技在其公有区域和本地边缘基础设施上提供了一致的体验,允许开发人员无需重新架构或重新设计解决方案即可无缝部署应用程序。

亚马逊云科技为Outposts和Local Zones推出了令人兴奋的更新,支持跨各种形式因素的混合云解决方案,用于工作负载分布和灾难恢复。

演讲者强调了大型和小型语言模型之间的差异,强调两者都有利弊,选择取决于诸如成本、基础设施和预期用例等因素。

亚马逊云科技强调了数据驻留、合规性和低延迟作为在边缘部署自然语言AI (NLAi)的关键业务驱动力。

了解如何将训练工作负载迁移到亚马逊云科技区域可以显著缩短训练时间和降低成本,同时改善环境影响。

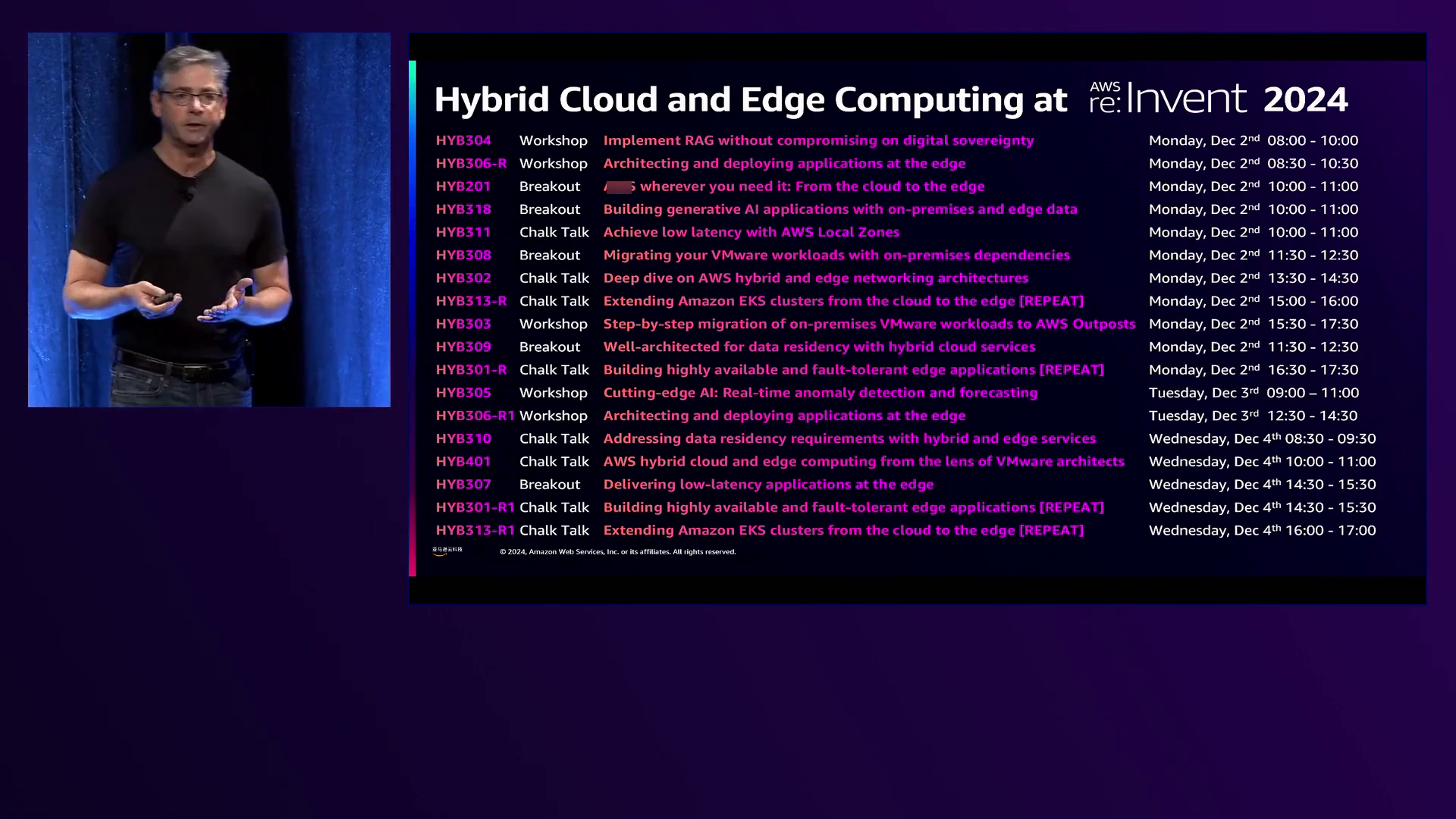

演讲者强调,在re:Invent期间,将提供多个混合边缘和混合云会议、研讨会以及了解Outposts和Local Zones基础设施的机会。

总结

在这个富有洞见的演讲中,亚马逊云科技专家深入探讨了利用本地和边缘数据构建生成式人工智能应用程序的领域。他们探索了在边缘部署大型语言模型(LLM)和小型语言模型(SLM)的细微差别,并解决了数据驻留、合规性和低延迟要求等关键考虑因素。

演讲者强调了选择权的重要性,为客户提供灵活选择最佳部署方式的能力,满足他们的使用场景需求。他们强调亚马逊云科技在公有区域和边缘基础设施上提供了一致的体验,确保无缝的可移植性和可编程性。

通过现场演示,演讲者展示了LLM和SLM在性能上的差异,演示了准确性、成本和速度之间的权衡。他们介绍了LLaMa CPP框架,该框架可实现高效的模型优化和边缘部署。

演讲深入探讨了SLM部署的架构考虑因素,包括使用检索增强生成(RAG)和微调技术。RAG允许数据存在于模型之外,增强安全性并防止幻觉,而微调则使模型适应特定领域和任务。

最后,演讲者倡导采用量身定制的方法,考虑任务范围、预算限制、性能标准和准确性要求等因素。他们强调评估SLM用于特定用例的重要性,并利用LLM进行企业范围内的通用部署。

演讲最后鼓励客户探索亚马逊云科技的Outpost测试实验室,并与混合团队合作,架构和测试他们的边缘生成式人工智能解决方案,利用亚马逊云科技提供的专业知识和资源。

亚马逊云科技(Amazon Web Services)是全球云计算的开创者和引领者。提供200多类广泛而深入的云服务,服务全球245个国家和地区的数百万客户。做为全球生成式AI前行者,亚马逊云科技正在携手广泛的客户和合作伙伴,缔造可见的商业价值 – 汇集全球40余款大模型,亚马逊云科技为10万家全球企业提供AI及机器学习服务,守护3/4中国企业出海。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?