1.DCGAN的主要动机

- 大家都知道GAN在2014年被提出后,随后的DCGAN是第一个使用了卷积进行图像生成的GAN变体。但往往也因此而忽略了原论文最开始的动机——作者们并不是以生成图像为最主要动机,而要解决的是:表征学习问题。

我们可以再看原论文摘要:

注:如果各位看官不习惯英语,可直接跳过看下面的翻译:)

In recent years, supervised learning with convolutional networks (CNNs) has seen huge adoption in computer vision applications. Comparatively, unsupervised learning with CNNs has received less attention. In this work we hope to help bridge the gap between the success of CNNs for supervised learning and unsupervised learning. We introduce a class of CNNs called deep convolutional generative adversarial networks (DCGANs), that have certain architectural constraints, and demonstrate that they are a strong candidate for unsupervised learning. Training on various image datasets, we show convincing evidence that our deep convolutional adversarial pair learns a hierarchy of representations from object parts to scenes in both the generator and discriminator. Additionally, we use the learned features for novel tasks - demonstrating their applicability as general image representations.

- 好了,允许我做一番拙劣翻译如下:

近年来,通过卷积网络(CNN)进行监督学习的方法已在计算机视觉应用中得到了广泛采用。相比之下,CNN的无监督学习受到的关注较少。在这项工作中,我们希望帮助缩小CNN在监督学习与无监督学习之间的差距。我们介绍一种遵循着一些网络结构设计约束的深度卷积生成对抗网络(DCGAN),并证明它是无监督学习的强大候选者。在各种图像数据集上的训练结果令人信服,即深度卷积生成器和判别器都学习到了从对象局部到场景的特征层次结构。此外,我们将学习到的特征用于新颖的任务——这更进一步展示了其作为通用图像特征表示的适用性。

- 实际上,DCGAN的论文标题就是:“UNSUPERVISED REPRESENTATION LEARNING WITH DEEP CONVOLUTIONAL GENERATIVE ADVERSARIAL NETWORKS”

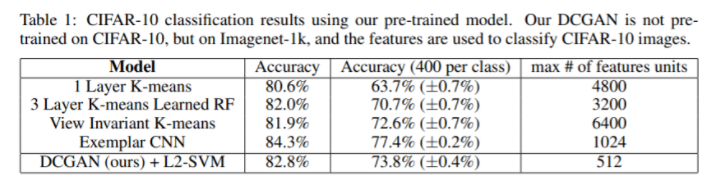

- 评估无监督表示学习算法优劣的一种常用手段是:将其作为特征提取器应用在有标签的监督数据集上以评估性能。为了评估DCGAN提取的特征在监督任务上的效果,论文在Imagenet-1k上进行训练,然后使用判别器的所有卷积层特征、通过最大池化来生成4×4空间特征;然后将它们铺平、拼接得到28672维向量。以正则线性L2-SVM分类器进行训练,在cifar10上可达到82.8%的准确率。

2.DCGAN生成多大的图像?

作为几乎是初学者入门GAN的第一个上手实操的GAN变体,我经常会遇到他们这么一个问题:“GAN也太辣鸡了吧,生成的图像都啥玩意儿呢”

- 事实上,它们很多时候直接那这个最基础简单的DCGAN去去生成256 X 256分辨率以上的图像!而且,它们仅仅使用数百或几千幅图像(当然,这也需要看图像的内容场景复杂与否

- 不要忘了,DCGAN只适合生成32X32和64X64的图像。大分辨率图像请参照StyleGAN、PGGAN之类!

猜喜欢:

附下载 |《TensorFlow 2.0 深度学习算法实战》

本文首发公众号【机器学习与生成对抗网络】

- GAN整整6年了!是时候要来捋捋了!

- 数百篇GAN论文已下载好!搭配一份生成对抗网络最新综述!

- 新手指南综述 | GAN模型太多,不知道选哪儿个?

- 人脸图像GAN,今如何?(附多篇论文下载)

- 人脸生成新SOTA?

- 语义金字塔式-图像生成:一种使用分类模型特征的方法

- 拆解组新的GAN:解耦表征MixNMatch

- CVPR 2020 | StarGAN第2版:多域多样性图像生成

- CVPR 2020 | GAN中的反射/反光、阴影

- CVPR 2020 | 几篇GAN语义生成论文

- CVPR 2020 | 10篇改进GAN的论文(网络、训练、正则等)

- CVPR 2020 | 11篇GAN图像转换img2img 的论文

- CVPR2020之MSG-GAN:简单有效的SOTA?

- CVPR2020之姿势变换GAN

- CVPR2020之多码先验GAN:预训练好的模型怎么使用?

- 两幅图像!这样能训练好 GAN 做图像转换吗?

- ECCV 2020 的对抗相关论文(对抗生成、对抗攻击)

- 2020年9月70篇GAN/对抗论文汇总

- 2020年8月60篇GAN/对抗论文汇总

- 2020年7月90篇GAN/对抗论文汇总

- 2020年6月100篇GAN/对抗论文汇总

- 2020年5月60篇GAN论文汇总

- 最新下载!2020年4月份70多篇GAN论文!

- 最新下载!一览2020年3月至今90多篇GAN论文!

- 最新下载!一览2020年2月50多篇GAN论文!

- 一览!2020年1月份的GANs论文!

- 2019年12月份的GANs论文一览

- 这么多!11月份来的这些GAN论文都在解决什么方向的问题?

部分应用介绍:

- 脸部转正!GAN能否让侧颜杀手、小猪佩奇真容无处遁形?

- 【无中生有的AI】关于deepfake的入门级梳理

- 容颜渐失!GAN来预测?

- 异常检测,GAN如何gan?

- 虚拟换衣!这几篇最新论文不来GAN GAN?

- 脸部妆容迁移!速览几篇用GAN来做的论文

- 有点夸张、有点扭曲!速览GAN如何夸张漫画化人脸!

- 见微知细之超分辨率GAN!附70多篇论文下载!

- 天降斯雨,于我却无!GAN用于去雨如何?

- 结合GAN的零次学习(zero-shot learning)

- 强数据所难!SSL(半监督学习)结合GAN如何?

- 弱水三千,只取你标!AL(主动学习)结合GAN如何?

- 【1】GAN在医学图像上的生成,今如何?

- 英伟达few-shot图像转换

- 【图像上色小综述】生成对抗网络的GAN法

- 文字生成图像!GAN生成对抗网络相关论文大汇总

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?