一、BERT-wwm

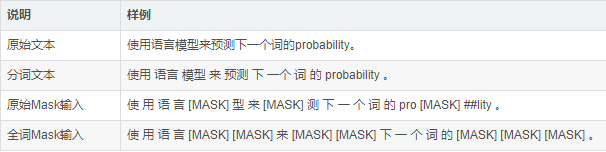

wwm(Whole Word Masking),全词Mask就是对整个词都通过Mask进行掩码,包含更多信息的是词,相比于Bert的改进是用Mask标签替换一个完整的词而不是子词,中文和英文不同,英文中最小的Token就是一个单词,而中文中最小的Token却是字,词是由一个或多个字组成,且每个词之间没有明显的分隔,

论文下载链接:https://arxiv.org/pdf/1906.08101.pdf

二、BERT-wwm-ext

它是BERT-wwm的一个升级版,相比于BERT-wwm的改进是增加了训练数据集同时也增加了训练步数

已训练好中文模型下载:https://github.com/brightmart/albert_zh

BERT-wwm-ext主要是有两点改进:

1)预训练数据集做了增加,次数达到5.4B;

2)训练步数增大,训练第一阶段1M步,训练第二阶段400K步。

中文模型下载

由于目前只包含base模型,故我们不在模型简称中标注base字样。

BERT-base模型:12-layer, 768-hidden, 12-heads, 110M parameters

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

255

255

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?