WARN TaskSchedulerImpl: Initial job has not accepted any resources; check your cluster UI to ensure that workers are registered and have sufficient resources,意思是:初始作业未接受任何资源;请检查群集UI以确保工作进程已注册并且有足够的资源。

出错可能有两种原因。

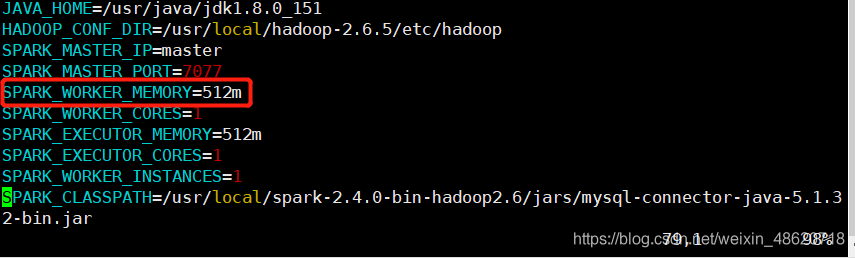

第一种:是spark节点的内存满了,内存可以在spark的配置文件—>spark-env.sh中可以看到。

这个配置文件路径在:/usr/local/spark-2.4.0-bin-hadoop2.6/conf/spark-env.sh路径下。

内存不知道满不满可以去独立集群Web界面查看应用的运行情况,打开浏览器,访问master:8080,

WARN TaskSchedulerImpl: Initial job has not accepted any resources; check your cluster UI to ensure that workers are registered and have sufficient resources,意思是:初始作业未接受任何资源;请检查群集UI以确保工作进程已注册并且有足够的资源。出错可能有两种原因。第一种:是spark节点的内存满了,内存可以在spark的配置文件—>spark-

WARN TaskSchedulerImpl: Initial job has not accepted any resources; check your cluster UI to ensure that workers are registered and have sufficient resources,意思是:初始作业未接受任何资源;请检查群集UI以确保工作进程已注册并且有足够的资源。出错可能有两种原因。第一种:是spark节点的内存满了,内存可以在spark的配置文件—>spark-

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1451

1451

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?