您的公司是否屏蔽了 ChatGPT 或 GitHub Copilot?您是否担心将代码发送给第三方 AI 服务会带来安全或信任问题?您可能不知道这一点,但您可以在计算机上本地运行大型语言模型 (LLM),甚至可以将其与 Visual Studio Code 集成。

使用Ollama工具,您可以在本地下载并运行模型。在这篇文章中,我将指导您完成使用 Ollama 运行 Code Llama 模型并将其集成到 Visual Studio Code 中的步骤。

Code Llama是 Meta 推出的法学硕士课程,专注于生成和讨论代码。它基于他们的 Llama 2 模型,支持多种不同的语言。

安装 Ollama 和 Code Llama 模型

第一步是安装 Ollama。前往https://ollama.com下载并安装。Ollama 启动并运行后,您应该有一个新的终端命令。ollama要查看它是否安装正确,请打开终端并运行:

ollama -v

这应该会打印 Ollama 版本。如果你看到这个,那么你就可以开始了!接下来,通过运行以下命令下载 Code Llama 模型:

ollama pull codellama

这可能需要一段时间,具体取决于您的互联网连接。Code Llama 的 7b 版本为 3.8 GB。在 Ollama 下载此模型时,您可以去喝杯咖啡、茶或您最喜欢的饮料。

设置 CodeGPT

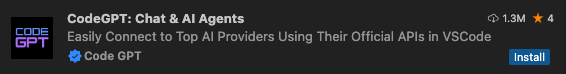

CodeGPT有一个 Visual Studio Code 扩展,您可以在其中直接在编辑器中与模型交互。在 VS Code 中,转到扩展选项卡并搜索“codegpt”。您将看到几个结果,请确保获取带有蓝色复选标记的结果:

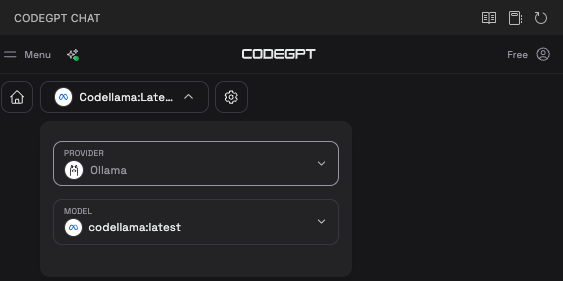

安装 CodeGPT 后,您应该会在编辑器的侧边栏中看到一个新的 CodeGPT 图标。单击此图标后,您将进入 CodeGPT 界面。单击此面板顶部的下拉菜单,选择 Ollama 作为提供程序,并选择codellama作为模型:

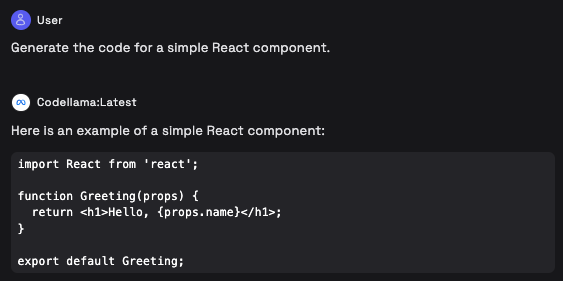

启动并运行后,您将在此面板底部看到一个文本区域,用于开始聊天。尝试输入提示,例如“生成简单 React 组件的代码”。

Code Llama 将开始处理您的请求。请记住,在本地运行模型并不像 Meta AI 或 ChatGPT 等在线服务那样强大或快速。几秒钟后,您应该会在聊天窗口中看到结果。

设置完成 www.cqzlsb.com

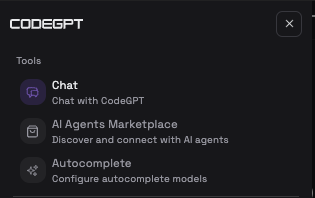

您还可以使用 CodeGPT 来建议代码完成,就像 GitHub Copilot 和类似工具一样。要进行设置,请在 CodeGPT 聊天窗口中,点击屏幕左上角的菜单按钮。菜单将滑出,其中包含多个选项。

选择“自动完成”来设置代码完成。

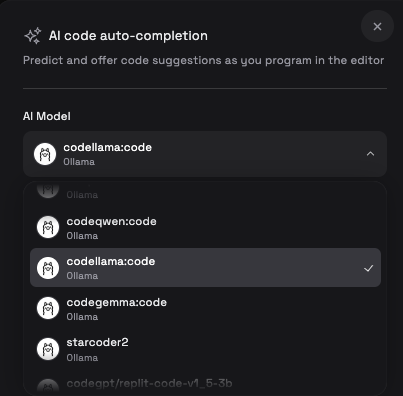

Code Llama 有一个code变体,可用于代码完成。它是一个单独的模型,因此您必须进行另一次大量下载。codellama:code从“AI 模型”下拉菜单中选择模型:

接下来,确保单击切换开关以启用完成:

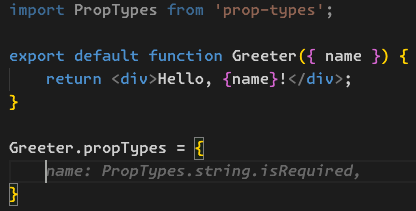

现在,当你在编辑器中输入内容时,Code Llama 会为你提供建议。例如,这里它正在填写PropTypes组件Greeter:

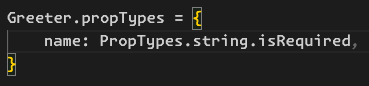

如果您喜欢某个建议,您可以按 Tab 键接受它:

玩得开心!

这就是全部了。现在,Visual Studio Code 中已集成了 AI 聊天和代码完成功能!

5346

5346

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?