前言

爬虫想必很多人都听过,这里简单介绍下爬虫,爬虫是一段可以在网页上自动抓取信息的程序,可以帮助我们获取一些有用的信息。能够完成上述功能的都可以称为爬虫,目前主流的Python爬虫框架主要分为调度器、URL管理器、网页下载器、网页解析器、应用程序(爬取的有价值数据)。调度器主要来调度管理器、下载器和解析器;URL管理器主要用来管理URL,防止重复抓取或者循环抓取等;网页下载器用于下载网页,并转换成字符串;网页解析器用于解析下载下来的字符串,目前主要以DOM树来解析,也可以根据XML,HTML进行解析。爬虫框架已经帮我们完成了80%的工作,我们只需要关注三个步骤:

1、如何能请求得到目标网站的数据,

2、如何从解析器中截取我们想要数据,

3、得到数据后如何做分析。

【----帮助相关技术学习,以下所有学习资料文末免费领!----】

下面就以斗鱼网站上最火的直播主题,哪些主播的人气最高的目标为例,演示整个实现流程:

python环境搭建

python环境的搭建可以参考以下地址:http://www.runoob.com/python/python-install.html

爬虫框架还需要安装几个模块,requests和beautifulSoup4,分别运行命令,

pip install requests

pip install beautifulSoup4

开发工具选用PyCharm,运行完上面命令后,在PyCharm里安装上面两个组件模块,安装成功后,可以在开发工具里引入相关包

#!/usr/bin/python import requests from bs4 import BeautifulSoup as bs

如果引入成功,则安装完成。环境搭建完后,就开始码代码了。

获取目标网站信息

我们先打开斗鱼直播的网站,https://www.douyu.com/directory/all,F12可以看到网页的信息,

通过requests请求网站数据

response = requests.get(“https://www.douyu.com/directory/all”) print response.text

我们就得到了网页的字符串信息,这里就完成了我们关注的第一步。

解析网页信息

下面介绍如何在大量的文本中筛选出需要的数据,BeautifulSoup功能非常强大,通过DOM树的方式帮助我们解析出网页的结构,可以以Python自带的html.parser进行解析,也可以使用lxml进行解析。

html = response.text html_tree = bs(html, “html.parser”) print html_tree 可以看到之前的字符串信息已经被格式化,得到很清晰的html文本。后面就可以很容易的获取DOM树中各个节点数据。我们可以观察到html文本中有用的数据都在

- 标签的

- 中,房间名是

标签的内容,房间类型在标签下,房间人数在中,主播名在中。

在刚才解析出的html文本中,查找出id="live-list-contentbox"的

在刚才解析出的html文本中,查找出id="live-list-contentbox"的- 标签,并且获取所有的

- 标签内容

# 查询ul标签 host_infos = html_tree.find(“ul”, {“id”: “live-list-contentbox”}) # print host_infos # 查询所有li标签 host_list = host_infos.find_all(“li”) print host_list # 遍历获取直播信息 for host in host_list: #获取房间名 home_name = host.find(“h3”, {“class”: “ellipsis”}).string.strip() home_name = home_name.replace(“,”, “”) #获取主播名 p_str = host.find(“p”) host_name = p_str.find(“span”, {“class”: “dy-name ellipsis fl”}).string.strip() #获取房间类型 home_type = host.find(“span”, {“class”: “tag ellipsis”}).string #获取房间人数 home_num = host.find(“span”, {“class”: “dy-num fr”}).string print “\033[31m房间名:\033[0m%s,\033[31m房间类型:\033[0m%s,\033[31m主播名称:\033[0m%s,\033[31m房间人数:\033[0m%s” \ % (home_name, home_type, host_name, home_num)

# 查询ul标签 host_infos = html_tree.find(“ul”, {“id”: “live-list-contentbox”}) # print host_infos # 查询所有li标签 host_list = host_infos.find_all(“li”) print host_list # 遍历获取 host_list 中主机的直播信息: #获取房间名 home_name = host.find(“h3”, {“class”: “ellipsis”}).string.strip() home_name = home_name.replace(“,”, “”) #获取主播名 p_str = host.find(“p”) host_name = p_str.find(“span”, {“class”: “dy-name ellipsis fl”}).string.strip() #获取房间类型 home_type = host.find(“span”, {“类”: “标记省略号”})。string #获取房间人数 home_num = host.find(“span”, {“class”: “dy-num fr”}).string print “\033[31m房间名:\033[0m%s,\033[31m房间类型:\033[0m%s,\033[31m主播名称:\033[0m%s,\033[31m房间人数:\033[0m%s” \ % (home_name, home_type, host_name, home_num)

此时,我们就爬取到了数据分析需要的第1页数据,后面我们继续爬取2页,3页,。。。对于一般的网页来说,爬取数据的基本流程就这样。当然,不同网站爬取的难度不同,用到的技巧也会不一样,需要观察和思考怎样才能获取到有用数据。比如某些网站需要登录后才能获取数据,我们就需要模拟登录流程,保存cookie或者token用于请求数据。

就拿斗鱼网站来说,在我们点击翻页的时候,可以通过F12查看network请求,可以发现一个有意思的规律,

当我们点击第3页时,请求的链接是https://www.douyu.com/gapi/rkc/directory/0_0/3

点击第4页时,请求的链接是https://www.douyu.com/gapi/rkc/directory/0_0/4

请求链接末尾数字正好是请求的页码,因此,我们可以一次性获取几百页的数据,直接上代码,运行后就拿到了200页的直播信息数据。

#!/usr/bin/python # coding=UTF-8 import requests import json import sys # reload()之前必须要引入模块 reload(sys) sys.setdefaultencoding(‘utf-8’) #解决中文乱码

count = 1 base_url = “https://www.douyu.com/gapi/rkc/directory/0_0/”

#存放数据路径 host_file_data = open(“D:\tmp_data\file_data.csv”, “w”) host_file_data.write(“房间名称,房间类别,主播名称,房间人数\n”) #请求200页数据 while count < 200: request_url = base_url + str(count) response = requests.get(request_url) # load json data json_data = json.loads(response.text) for host_info in json_data[“data”][“rl”]: # 解析json里面的房间名,房间类型,主播名称,房间人数 home_name = host_info[“rn”].replace(" “, “”).replace(”,", “”) home_type = host_info[“c2name”] host_name = host_info[“nn”] home_user_num = host_info[“ol”] # print “\033[31m房间名:\033[0m%s,\033[31m房间类型:\033[0m%s,\033[31m主播名称:\033[0m%s,\033[31m房间人数:\033[0m%s”\ # % (home_name, home_type, host_name, home_user_num) #写入文件中 host_file_data.write(home_name + “,” + home_type + “,” + host_name + “,” + str(home_user_num) + “\n”) count += 1

数据的统计分析

我们的目标是统计目前最火的主题排名和最具人气的主播名称。python中的matplotlib库可以帮助我们快速的绘制2D图形,pandas库可以解决数据分析任务,这里用来完成导入和读取数据的任务。

可以通过pip install pandas和pip install matplotlib安装库,如果运行报SimHei not found,中文显示方框的问题:

首先将windwos中fonts目录下的simhei.ttf拷贝到Python根目录中的/python2.7/site-packages/matplotlib/mpl-data/fonts/ttf目录中,

然后删除~/.cache/matplotlib的缓冲目录,重新运行。1.统计直播数最多的主题(房间类别)

import pandas as pd import matplotlib.pyplot as plt

df=pd.read_csv(“/root/.jupyter/study_python/file_data.csv”)#读取数据 #统计直播数最多的主题(房间类别) names=df[“房间类别”].value_counts() plt.rcParams[‘figure.figsize’]=(20.0,4.0)#设置图的尺寸 plt.rcParams[‘figure.dpi’]=200 #设置分辨率 #设置图的字体 font={ ‘family’:‘SimHei’, ‘weight’:‘bold’, ‘size’:‘15’ } plt.rc(‘font’,**font) plt.bar(names.index[0:15],names.values[0:15],fc=‘b’) plt.show()

2.各个主题的直播观看人数排名

2.各个主题的直播观看人数排名

3.各个主播的观看人数排名

从数据爬取到数据分析,整个基本的流程就是这样,希望读者可以通过这个简单的示例能够对大数据和爬虫产生兴趣。后续将继续呈现上数据分析的进阶分享,谢谢。

一、Python入门

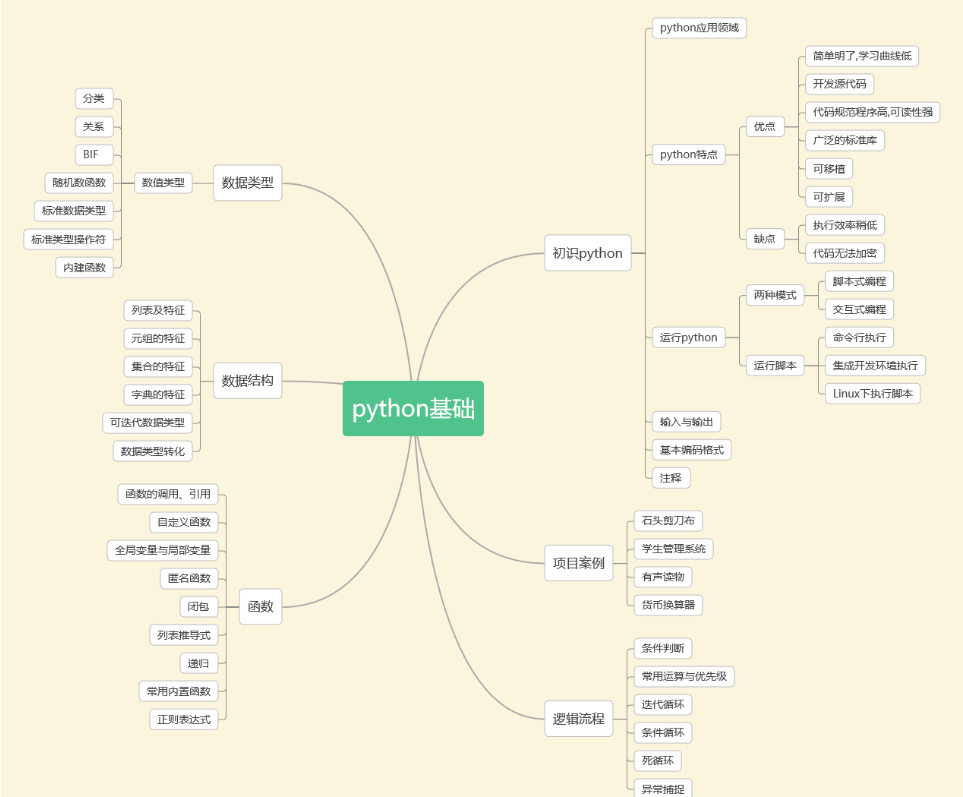

下面这些内容是Python各个应用方向都必备的基础知识,想做爬虫、数据分析或者人工智能,都得先学会他们。任何高大上的东西,都是建立在原始的基础之上。打好基础,未来的路会走得更稳重。所有资料文末免费领取!!!

包含:

计算机基础

python基础

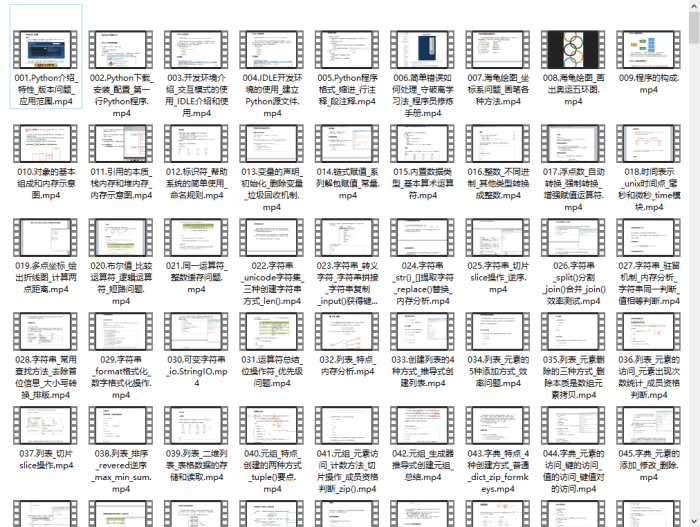

Python入门视频600集:

观看零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

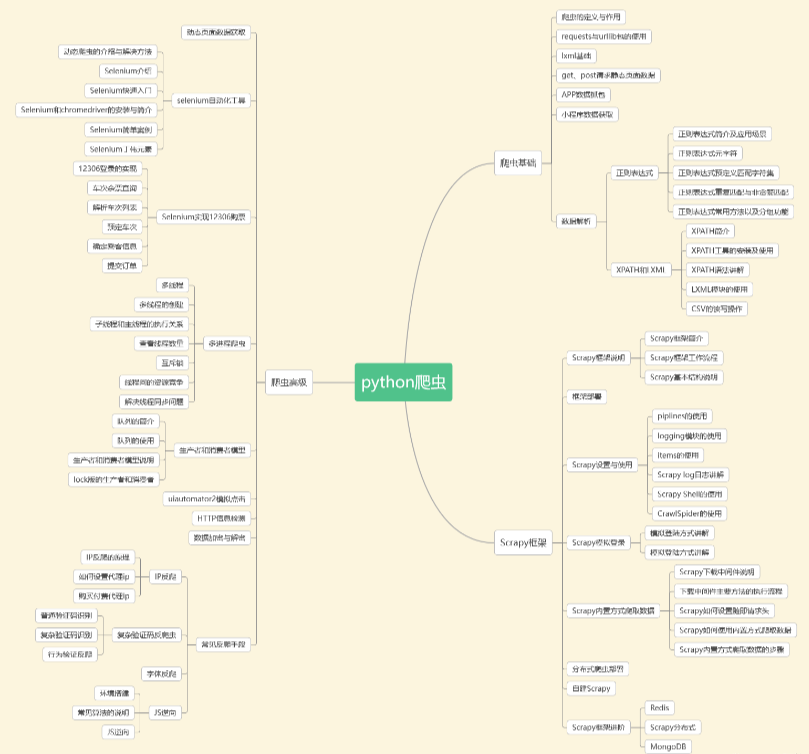

二、Python爬虫

爬虫作为一个热门的方向,不管是在自己兼职还是当成辅助技能提高工作效率,都是很不错的选择。

通过爬虫技术可以将相关的内容收集起来,分析删选后得到我们真正需要的信息。

这个信息收集分析整合的工作,可应用的范畴非常的广泛,无论是生活服务、出行旅行、金融投资、各类制造业的产品市场需求等等,都能够借助爬虫技术获取更精准有效的信息加以利用。

Python爬虫视频资料

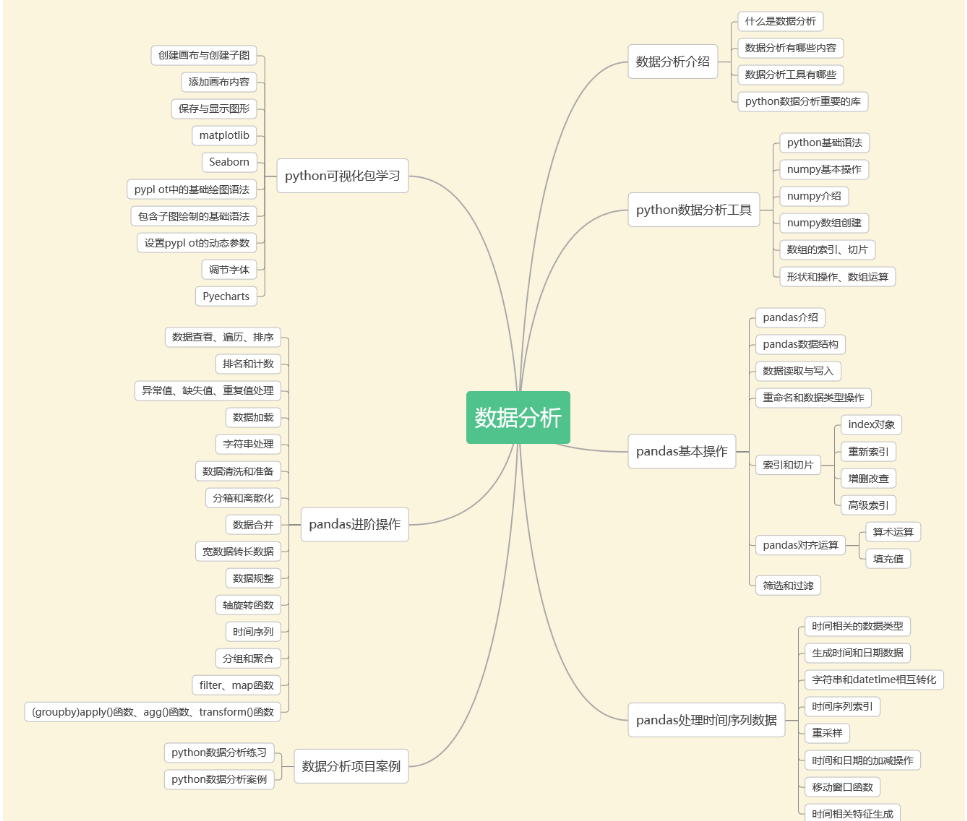

三、数据分析

清华大学经管学院发布的《中国经济的数字化转型:人才与就业》报告显示,2025年,数据分析人才缺口预计将达230万。

这么大的人才缺口,数据分析俨然是一片广阔的蓝海!起薪10K真的是家常便饭。

四、数据库与ETL数仓

企业需要定期将冷数据从业务数据库中转移出来存储到一个专门存放历史数据的仓库里面,各部门可以根据自身业务特性对外提供统一的数据服务,这个仓库就是数据仓库。

传统的数据仓库集成处理架构是ETL,利用ETL平台的能力,E=从源数据库抽取数据,L=将数据清洗(不符合规则的数据)、转化(对表按照业务需求进行不同维度、不同颗粒度、不同业务规则计算进行统计),T=将加工好的表以增量、全量、不同时间加载到数据仓库。

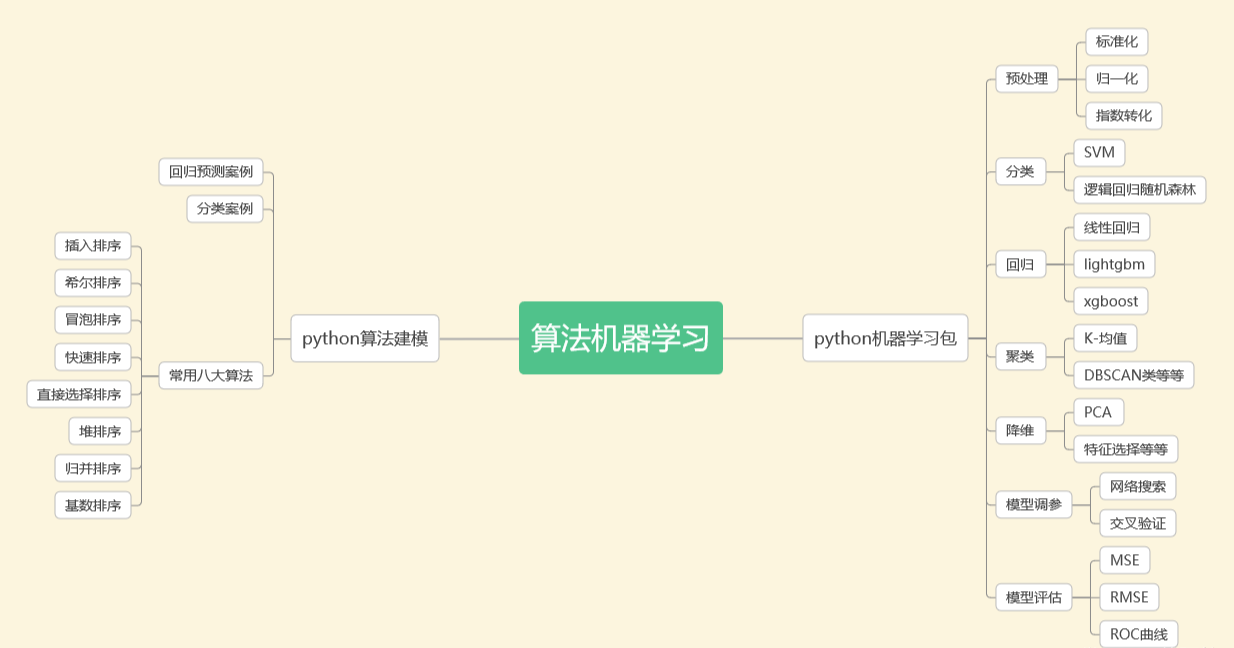

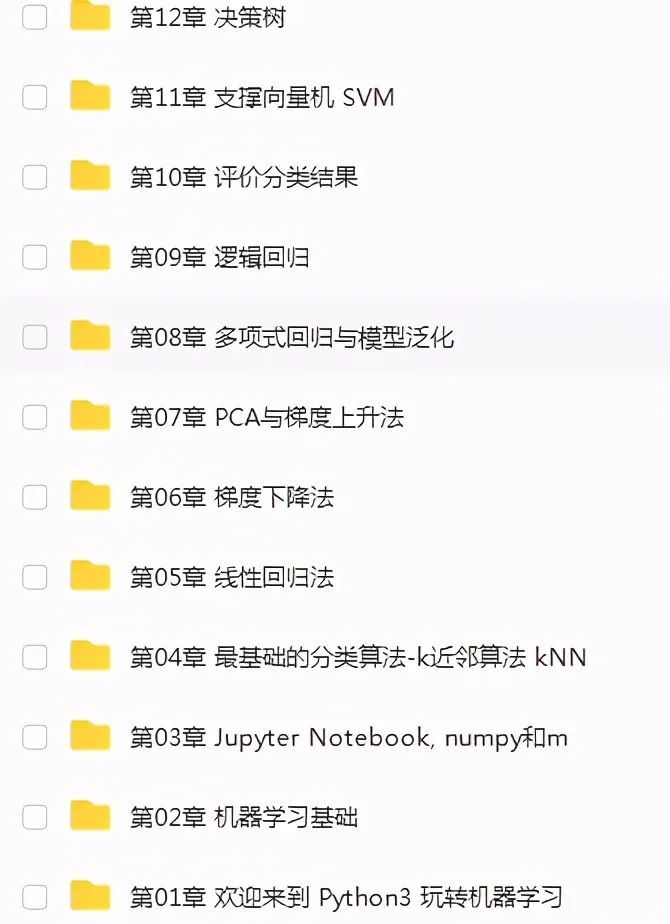

五、机器学习

机器学习就是对计算机一部分数据进行学习,然后对另外一些数据进行预测与判断。

机器学习的核心是“使用算法解析数据,从中学习,然后对新数据做出决定或预测”。也就是说计算机利用以获取的数据得出某一模型,然后利用此模型进行预测的一种方法,这个过程跟人的学习过程有些类似,比如人获取一定的经验,可以对新问题进行预测。

机器学习资料:

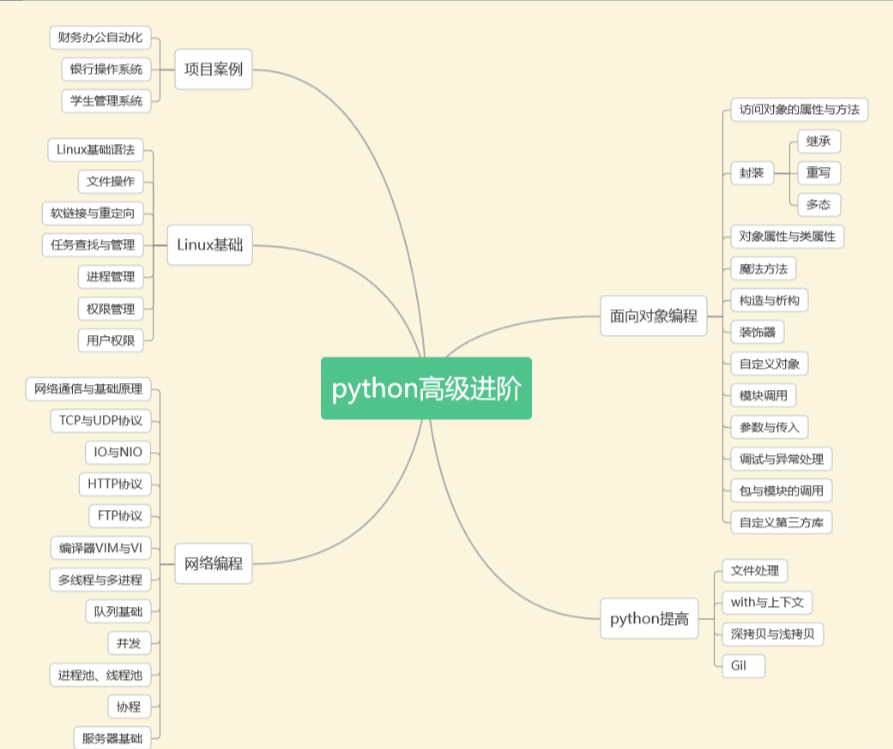

六、Python高级进阶

从基础的语法内容,到非常多深入的进阶知识点,了解编程语言设计,学完这里基本就了解了python入门到进阶的所有的知识点。

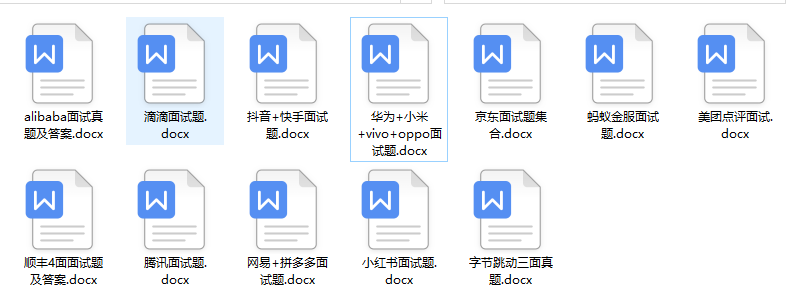

到这就基本就可以达到企业的用人要求了,如果大家还不知道去去哪找面试资料和简历模板,我这里也为大家整理了一份,真的可以说是保姆及的系统学习路线了。

但学习编程并不是一蹴而就,而是需要长期的坚持和训练。整理这份学习路线,是希望和大家共同进步,我自己也能去回顾一些技术点。不管是编程新手,还是需要进阶的有一定经验的程序员,我相信都可以从中有所收获。一蹴而就,而是需要长期的坚持和训练。整理这份学习路线,是希望和大家共同进步,我自己也能去回顾一些技术点。不管是编程新手,还是需要进阶的有一定经验的程序员,我相信都可以从中有所收获。

资料领取

这份完整版的Python全套学习资料已经上传网盘,朋友们如果需要可以点击下方微信卡片免费领取 ↓↓↓【保证100%免费】

或者

【点此链接】领取

好文推荐

了解python的前景:https://blog.csdn.net/SpringJavaMyBatis/article/details/127194835

了解python的兼职副业:https://blog.csdn.net/SpringJavaMyBatis/article/details/127196603

1552

1552

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?