目录

前言

Keepalived是企业应用中,单台服务器承担应用存在单点故障的危险,单点故障一旦发生,企业服务器将会发生终端,造成极大的危害和损失

一、Keepslived概述

1、Keepalived工具介绍

keepalived 软件起初是专为 LVS 负载均衡软件设计的,用来管理并监控 LVS 集群中各个服务节点的状态,后来又加入了可以实现高可用的 VRRP 功能。因此,keepalived 除了能够管理 LVS 集群外,还可以为其他服务(例如:Nginx、Haproxy、MySQL等)实现高可用。

keepalived 软件主要是通过 VRRP 协议实现高可用功能的。VRRP 是 Virtual Router Redundancy Protocol(虚拟路由器冗余协议的缩写,VRRP 出现的目的就是为了解决静态路由单点故障的问题,它能够保证当个别节点宕机时,整个网络可以不间断地运行。

所以,keepalived 一方面具有配置管理 LVS 的功能,同时还具有对 LVS 下面节点进行健康检查的功能,另一方面也可实现系统网络服务的高可用。

2、Keepalived服务重要功能

- 管理LVS负载均衡软件

- 支持故障自动切换(Failover)

- 实现LVS集群中节点的健康检查(Health Checking)

- 实现LVS负载调度节点服务器的高可用性(HA)

一般企业集群需要满足三个特点:负载均衡、健康检查和故障切换可以通过LVS+Keepalived完全可以满足需求

对于节点服务器:健康检查如果发现有故障的节点就会将其隔离或者剔除集群,待其回复后再重新加入的集群当中去

负载均衡器:健康检查会定时去检查主机的状态(包括主机和服务的状态),如果出现故障就会自动切换到备主机上待主机恢复,在重新让主承载业务请求

3、Keepalived实现原理

VRRP虚拟冗余协议

VRRP会把多个路由组成一个虚拟路由组VRID,VRRP会生成一个虚拟路由(包含虚拟IP、虚拟MAC,局域网内,用户不需要关心谁是主路由/谁是备路由,他们只用虚拟路由器的虚拟IP作为他们的网关),实际上虚拟IP就是承载在Master路由上,也就是说实际的数据是通过Master进行转发的,Backup是通过优先级来决定哪一个是Master路由,优先级最大的那台就是Master,Backup只是用来监听Master定时发送的VRRP报文,如果超时未收到Master发来的VRRP报文,则Backup就会抢占Master,虚拟IP也会一起漂移到Backup上。当Master恢复后,虚拟IP会漂移回到Master上(非健康检查模式)

keepalived时一款高可用软件,可以工作在三层(网络层)、四层(传输层)和五层(应用层)上,进行健康检测功能。

我们可以手动配置,选择主用设备和备用设备,选择抢占和非抢占。当开启抢占模式时,原有的主用设备恢复后会抢占原有的备用设备,恢复对VIP的响应,而原有的备用设备则会恢复到备用设备的状态。一般情况下,我们都会把一个硬件性能好的设备作为主用设备,因此我们通常会开启抢占功能。

keepalived可以工作在类似三层、四层和五层的模式上,当keepalived工作在三层模式时,以IP的形式去进行健康检测,当keepalived工作在四层模式时,以IP+端口的形式去进行健康检测,当keepalived工作在五层模式时,以自定义脚本的方式去进行健康检测。

4、Keepalived体系主要模块

| 模块 | 作用 |

| core模块 | 为Keepalived的核心,负责主进程的启动、维护及全局配置文件的加载和解析 |

| vrrp模块 | 是来实现VRRP协议的 |

| check模块 | 负责健康检查,常见的方式又端口及URL检查 |

5、使用Keepalived实现双机热备

- 基于VRRP协议的热备方式Keepalived可以用作故障切换,每个热备组可以有多台服务器,当然最常用的还是双机热备

- 在双机热备方案中,故障切换主要针对虚拟IP地址的漂移来实现,因此可以适用于各种应用服务器(如:Web、FTP、Mail、SSH、DNS...)

- 其中主、备服务器都需要安装Keepalived

二、LVS+DR+Keepalived高可用集群构建

1、集群概述

- keepalived 的设计目标是构建高可用的 LVS 负载均衡集群,可以调用 ipvsadm 工具来创建虚拟服务器、管理服务器池,而不仅仅用作双机热备

- 使用 keepalived 构建 LVS 集群更加简便易用,主要优势在于:对 LVS 负载调度器实现热备切换,提高可用性;对服务器池中的节点进行健康检查,自动移除失效节点,恢复后再重新加入

- 案列将以 DR 模式的 LVS 集群为基础,增加一台从负载调度器,使用 keepalived 实现主、从调度器的热备,搭建兼有负载均衡、高可用性两种能力的 LVS 集群架构

- 使用 keepalived 构建 LVS 集群时,也需要用到 ipvsadm 管理工具,但大部分工作会由 keepalived 自动完成,不需要手动执行 ipvsadm (除了查看和监控集群以外)

2、架构示例图

三、脑裂现象问题

脑裂(split-brain):指在一个高可用(HA)系统中,当联系着的两个节点断开联系时,本来为一个整体的系统,分裂为两个独立节点,这时两个节点开始争抢共享资源,结果会导致系统混乱,数据损坏。

当两台高可用服务器在指定的时间内,无法互相检测到对方心跳而各自启动故障转移功能,取得了资源以及服务的所有权,而此时的两台高可用服务器对都还活着并作正常运行,这样就会导致同一个服务在两端同时启动而发生冲突的严重问题,最严重的就是两台主机同时占用一个VIP的地址(类似双端导入概念),当用户写入数据的时候可能会分别写入到两端,这样可能会导致服务器两端的数据不一致或造成数据的丢失,这种情况就称为裂脑,也有的人称之为分区集群或者大脑垂直分隔。

发生脑裂,导致互相竞争同一个IP资源,就如同我们局域网内常见的IP地址冲突一样,两个机器就会有一个或者两个不正常,影响用户正常访问服务器。如果是应用在数据库或者是存储服务这种极重要的高可用上,那就导致用户发布的数据间断的写在两台服务器上的恶果,最终数据恢复及困难或者是难已恢复。

产生的原因

优先考虑心跳线路上的问题,在可能是心跳服务,软件层面的问题

- 高可用服务器对之间心跳线路故障,导致无法正常的通信,原因比如:

- 心跳线本身就坏了(包括断了,老化);

- 网卡以及相关驱动坏了,IP配置及冲突问题;

- 心跳线间连接的设备故障(交换机的故障或者是网卡的故障);

- 仲裁的服务器出现问题。

- 高可用服务器对上开启了防火墙阻挡了心跳消息的传输;

- 高可用服务器对上的心跳网卡地址等信息配置的不正确,导致发送心跳失败;

- 其他服务配置不当等原因,如心跳的方式不同,心跳广播冲突,软件出现了BUG等;

- Keepalived配置里同一 VRRP实例如果virtual_router_id两端参数配置不一致也会导致裂脑问题发生。

解决方案

- 同时使用串行电缆和以太网电缆连接,同时用两条心跳线路,这样一条线路坏了,另一个还是好的,依然能传送心跳消息。

- 当检测到裂脑时强行关闭一个心跳节点(这个功能需特殊设备支持,如Stonith、feyce)。相当于备节点接收不到心跳消患,通过单独的线路发送关机命令关闭主节点的电源。

- 做好对裂脑的监控报警(如邮件及手机短信等或值班).在问题发生时人为第一时间介入仲裁,降低损失。例如,百度的监控报警短倍就有上行和下行的区别。报警消息发送到管理员手机上,管理员可以通过手机回复对应数字或简单的字符串操作返回给服务器.让服务器根据指令自动处理相应故障,这样解决故障的时间更短.

- 当然,在实施高可用方案时,要根据业务实际需求确定是否能容忍这样的损失。对于一般的网站常规业务.这个损失是可容忍的。

- 多节点集群中,可以通过增加仲裁的机制,确定谁该获得资源,这里面有几个参考的思路:

- 增加一个仲裁机制。例如设置参考的IP,当心跳完全断开的时候,2个节点各自都ping一下参考的IP,不同则表明断点就出现在本段,这样就主动放弃竞争,让能够ping通参考IP的一端去接管服务

- 通过第三方软件仲裁谁该获得资源,这个在阿里有类似的软件应用

- 启用磁盘锁。正在服务一方锁住共享磁盘,脑裂发生的时候,让对方完全抢不走共享的磁盘资源。但使用锁磁盘也会有一个不小的问题,如果占用共享盘的乙方不主动解锁,另一方就永远得不到共享磁盘。现实中介入服务节点突然死机或者崩溃,另一方就永远不可能执行解锁命令。后备节点也就截关不了共享的资源和应用服务。于是有人在HA中涉及了“智能”锁,正在服务的一方只在发现心跳线全部断开时才启用磁盘锁,平时就不上锁了

- 报警报在服务器接管之前,给人员处理留足够的时间就是1分钟内报警了,但是服务器不接管,而是5分钟之后接管,接管的时间较长。数据不会丢失,但就是会导致用户无法写数据。报警后,不直接自动服务器接管,而是由人员接管。

检测思路:正常情况下keepalived的VIP地址是在主节点上的,如果在从节点发现了VIP,就设置报警信息。脚本(在从节点上)如下:

vim split-brainc_check.sh

#!/bin/bash

# 检查脑裂的脚本,在备节点上进行部署

LB01_VIP=192.168.223.10

LB01_IP=192.168.223.33

while true

do

ping -c 2 -W 3 $LB01_VIP &>/dev/null

if [ $? -eq 0 -a `ip add|grep "$LB01_VIP"|wc -l` -eq 1 ];then

echo "ha is brain."

else

echo "ha is ok"

fi

sleep 5

done

预防脑裂

(1)可以采用第三方仲裁的方法。由于keepalived体系中主备两台机器所处的状态与对方有关。如果主备机器之间的通信出了网题,就会发生脑裂,此时keepalived体系中会出现双主的情况,产生资源竞争。

(2)一般可以引入仲裁来解决这个问题,即每个节点必须判断自身的状态。最简单的一种操作方法是,在主备的keepalived的配置文件中增加check配置,服务器周期性地ping一下网关,如果ping不通则认为自身有问题 。

(3)最容易的是借助keepalived提供的vrrp_script及track_script实现。如下所示:

#vim /etc/keepalived/keepalived.conf

......

vrrp_script check_local {

script "/root/check_gateway.sh"

interval 5

}

......

track_script {

check_local

}

脚本内容:

# cat /root/check_gateway.sh

#!/bin/sh

VIP=$1

GATEWAY=192.168.1.1

/sbin/arping -I em1 -c 5 -s $VIP $GATEWAY &>/dev/null

check_gateway.sh 就是我们的仲裁逻辑,发现ping不通网关,则关闭keepalived。

四、实例部署

| 服务器 | IP地址 |

| Master DR Server | 192.168.223.10 |

| Backup DR Server | 192.168.223.33 |

| Web Server1 | 192.168.223.13 |

| Web Server2 | 192.168.223.17 |

| VIP | 192.168.223.100 |

| Client | 192.168.223.200 |

1、配置负载调度器(主:192.168.223.10)

############################ 配置Keepalived master服务器 #################################

1. #关闭防火墙

systemctl stop firewalld.service

setenforce 0

2. #安装服务

yum -y install ipvsadm keepalived

3. #修改配置文件keeplived.conf

cd /etc/keepalived/

cp keepalived.conf keepalived.conf.bak

vim keepalived.conf

......

global_defs { #定义全局参数

--10行--修改,邮件服务指向本地

smtp_server 127.0.0.1

--12行--修改,指定服务器(路由器)的名称,主备服务器名称须不同,主为LVS_01,备为LVS_02

router_id LVS_01

}

vrrp_instance VI_1 { #定义VRRP热备实例参数

--20行--修改,指定热备状态,主为MASTER,备为BACKUP

state MASTER

--21行--修改,指定承载vip地址的物理接口

interface ens33

--22行--修改,指定虚拟路由器的ID号,每个热备组保持一致

virtual_router_id 10

--23行--修改,指定优先级,数值越大优先级越高,主为100,备为99

priority 100

advert_int 1 #通告间隔秒数(心跳频率)

authentication { #定义认证信息,每个热备组保持一致

auth_type PASS #认证类型

--27行--修改,指定验证密码,主备服务器保持一致

auth_pass 123456

}

virtual_ipaddress { #指定群集vip地址

192.168.59.188

}

}

--36行--修改,指定虚拟服务器地址(VIP)、端口,定义虚拟服务器和Web服务器池参数

virtual_server 192.168.233.100 80 {

delay_loop 6 #健康检查的间隔时间(秒)

lb_algo rr #指定调度算法,轮询(rr)

--39行--修改,指定群集工作模式,直接路由(DR)

lb_kind DR

persistence_timeout 50 #连接保持时间(秒)

protocol TCP #应用服务采用的是 TCP协议

--43行--修改,指定第一个Web节点的地址、端口

real_server 192.168.223.13 80 {

weight 1 #节点的权重

--45行--删除,添加以下健康检查方式

TCP_CHECK {

connect_port 80 #添加检查的目标端口

connect_timeout 3 #添加连接超时(秒)

nb_get_retry 3 #添加重试次数

delay_before_retry 3 #添加重试间隔

}

}

real_server 192.168.223.17 80 { #添加第二个 Web节点的地址、端口

weight 1

TCP_CHECK {

connect_port 80

connect_timeout 3

nb_get_retry 3

delay_before_retry 3

}

}

}

##删除后面多余的配置##

4. #启动服务、查看虚拟网卡vip

systemctl start keepalived

ip addr show dev ens33

5. #调整proce响应参数,关闭Linux内核的重定向参数响应

vim /etc/sysctl.conf

net.ipv4.ip_forward = 1

net.ipv4.conf.all.send_redirects = 0

net.ipv4.conf.default.send_redirects = 0

net.ipv4.conf.ens33.send_redirects = 0

6. #刷新一下

sysctl -p

############################# 配置ipvsadm #################################

7. #配置负载分配策略,并启动服务

ipvsadm-save >/etc/sysconfig/ipvsadm

systemctl start ipvsadm.service

8.

#清空ipvsadm,并做策略

ipvsadm -C

ipvsadm -A -t 192.168.223.100 80 -s rr

ipvsadm -A -t 192.168.223.100:80 -s rr

ipvsadm -a -t 192.168.223.100:80 -r 192.168.223.13:80 -g

ipvsadm -a -t 192.168.223.100:80 -r 192.168.223.17:80 -g

9. #保存设置

ipvsadm

ipvsadm -ln

ipvsadm-save >/etc/sysconfig/ipvsadm关闭防火墙和增强机制

下载安装包

下载安装包

备份配置文件

编辑配置文件

重启Keepalived服务并查看虚拟网卡信息

调整/proc响应参数,关闭内核的重定向参数响应

刷新一下

清空并配置ipvsadm策略

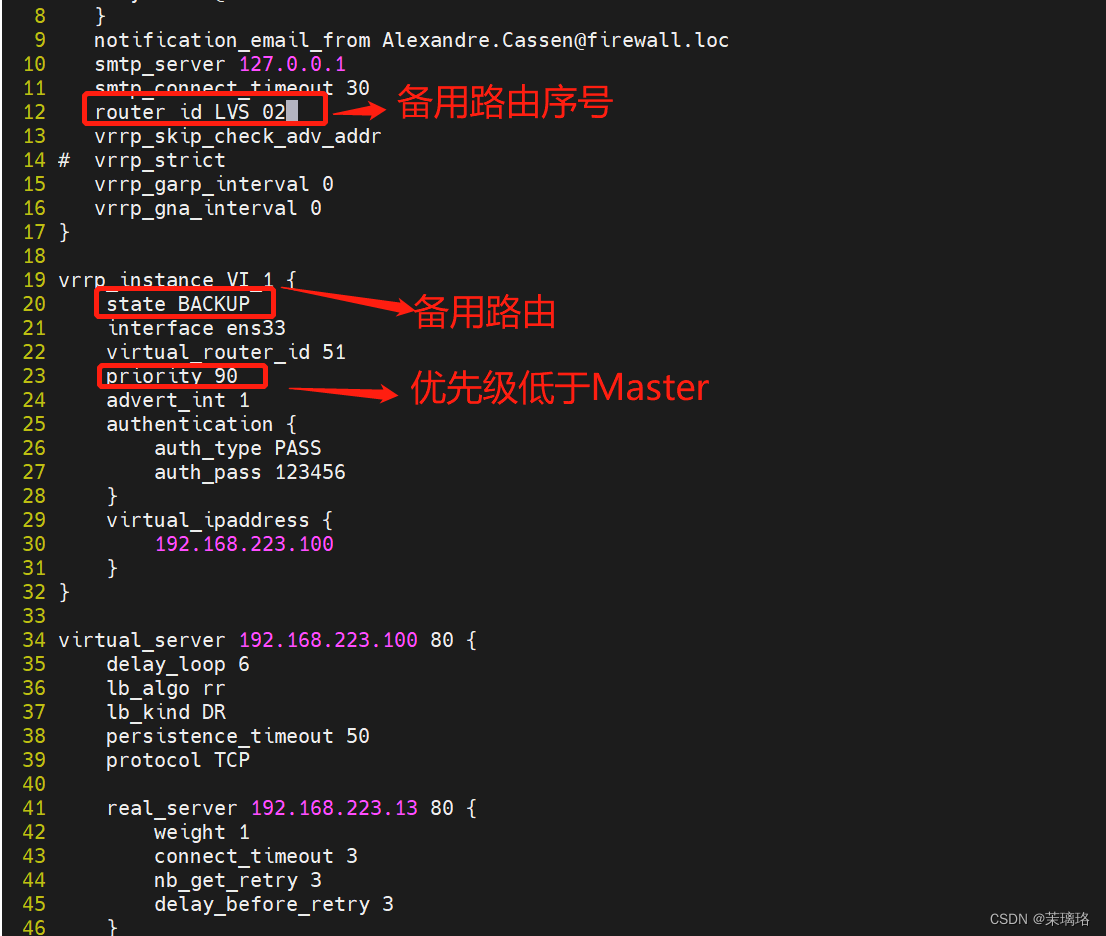

2、配置负载调度器(备:192.168.223.33)

############################ 配置Keepalived backup服务器 #################################

1. #关闭防火墙

systemctl stop firewalld.service

setenforce 0

2. #安装服务

yum -y install ipvsadm keepalived

3. #修改配置文件keeplived.conf

cd /etc/keepalived/

cp keepalived.conf keepalived.conf.bak

vim keepalived.conf

......

global_defs { #定义全局参数

--10行--修改,邮件服务指向本地

smtp_server 127.0.0.1

--12行--修改,指定服务器(路由器)的名称,主备服务器名称须不同,主为LVS_01,备为LVS_02

router_id LVS_01

}

vrrp_instance VI_1 { #定义VRRP热备实例参数

--20行--修改,指定热备状态,主为MASTER,备为BACKUP

state BACKUP

--21行--修改,指定承载vip地址的物理接口

interface ens33

--22行--修改,指定虚拟路由器的ID号,每个热备组保持一致

virtual_router_id 10

--23行--修改,指定优先级,数值越大优先级越高,主为100,备为99

priority 99

advert_int 1 #通告间隔秒数(心跳频率)

authentication { #定义认证信息,每个热备组保持一致

auth_type PASS #认证类型

--27行--修改,指定验证密码,主备服务器保持一致

auth_pass 123456

}

virtual_ipaddress { #指定群集vip地址

192.168.59.188

}

}

--36行--修改,指定虚拟服务器地址(VIP)、端口,定义虚拟服务器和Web服务器池参数

virtual_server 192.168.223.100 80 {

delay_loop 6 #健康检查的间隔时间(秒)

lb_algo rr #指定调度算法,轮询(rr)

--39行--修改,指定群集工作模式,直接路由(DR)

lb_kind DR

persistence_timeout 50 #连接保持时间(秒)

protocol TCP #应用服务采用的是 TCP协议

--43行--修改,指定第一个Web节点的地址、端口

real_server 192.168.223.13 80 {

weight 1 #节点的权重

--45行--删除,添加以下健康检查方式

TCP_CHECK {

connect_port 80 #添加检查的目标端口

connect_timeout 3 #添加连接超时(秒)

nb_get_retry 3 #添加重试次数

delay_before_retry 3 #添加重试间隔

}

}

real_server 192.168.223.17 80 { #添加第二个 Web节点的地址、端口

weight 1

TCP_CHECK {

connect_port 80

connect_timeout 3

nb_get_retry 3

delay_before_retry 3

}

}

}

##删除后面多余的配置##

4. #启动服务、查看虚拟网卡vip

systemctl start keepalived

ip addr show dev ens33

5. #调整proce响应参数,关闭Linux内核的重定向参数响应

vim /etc/sysctl.conf

net.ipv4.ip_forward = 1

net.ipv4.conf.all.send_redirects = 0

net.ipv4.conf.default.send_redirects = 0

net.ipv4.conf.ens33.send_redirects = 0

6. #刷新一下

sysctl -p

############################# 配置ipvsadm #################################

7. #配置负载分配策略,并启动服务

ipvsadm-save >/etc/sysconfig/ipvsadm

systemctl start ipvsadm.service

8.

#清空ipvsadm,并做策略

ipvsadm -C

ipvsadm -A -t 192.168.223.100:80 -s rr

ipvsadm -a -t 192.168.223.100:80 -r 192.168.223.13:80 -g

ipvsadm -a -t 192.168.223.100:80 -r 192.168.223.17:80 -g

9. #保存设置

ipvsadm

ipvsadm -ln

ipvsadm-save >/etc/sysconfig/ipvsadm关闭防火墙和增强机制 修改备用路由的配置文件

修改备用路由的配置文件

配置/proc参数响应

清空ipvsadm策略并添加新策略

3、配置Web 服务器1(192.168.223.13)

1. #关闭防火墙

systemctl stop firewalld

setenforce 0

2. #安装并开启httpd服务

yum -y install httpd

systemctl start httpd

3. #配置站点文件

vim /var/www/html/index.html

this is yxp web!

4. #配置虚拟vip

vim /etc/sysconfig/network-scripts/ifcfg-lo:0

DEVICE=lo:0

ONBOOT=yes

IPADDR=192.168.59.188

NETMASK=255.255.255.255

5. #重启网络服务,开启虚拟网卡

systemctl restart network

ifup lo:0

ifconfig lo:0

6. #设置路由

route add -host 192.168.223.100 dev lo:0

route -n

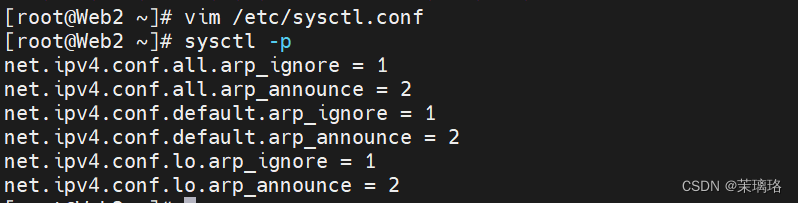

7. #调整 proc 响应参数

#添加系统只响应目的IP为本地IP的ARP请求

#系统不使用原地址来设置ARP请求的源地址,而是物理mac地址上的IP

vim /etc/sysctl.conf

net.ipv4.conf.all.arp_ignore = 1

net.ipv4.conf.all.arp_announce = 2

net.ipv4.conf.default.arp_ignore = 1

net.ipv4.conf.default.arp_announce = 2

net.ipv4.conf.lo.arp_ignore = 1

net.ipv4.conf.lo.arp_announce = 2

8. #刷新proc参数

sysctl -p关闭防火墙和增强机制

配置lo:0虚拟网卡

重启网络后启动lo:0网卡

添加路由并查验

调整ARP内核配置

调整ARP内核配置

向Web服务器的网页中写入内容

4、配置Web 服务器2(192.168.223.17)

1. #关闭防火墙

systemctl stop firewalld

setenforce 0

2. #安装并开启httpd服务

yum -y install httpd

systemctl start httpd

3. #配置站点文件

vim /var/www/html/index.html

this is dhc web!

4. #配置虚拟vip

vim /etc/sysconfig/network-scripts/ifcfg-lo:0

DEVICE=lo:0

ONBOOT=yes

IPADDR=192.168.59.188

NETMASK=255.255.255.255

5. #重启网络服务,开启虚拟网卡

systemctl restart network

ifup lo:0

ifconfig lo:0

6. #设置路由

route add -host 192.168.223.100 dev lo:0

route -n

7. #调整 proc 响应参数

#添加系统只响应目的IP为本地IP的ARP请求

#系统不使用原地址来设置ARP请求的源地址,而是物理mac地址上的IP

vim /etc/sysctl.conf

net.ipv4.conf.all.arp_ignore = 1

net.ipv4.conf.all.arp_announce = 2

net.ipv4.conf.default.arp_ignore = 1

net.ipv4.conf.default.arp_announce = 2

net.ipv4.conf.lo.arp_ignore = 1

net.ipv4.conf.lo.arp_announce = 2

8. #刷新proc参数

sysctl -p关闭防火墙和增强机制

配置lo:0虚拟网卡

启动lo:0网卡

添加路由并查验

调整ARP内核配置并查验

向Web服务器的网页中写入内容

向Web服务器的网页中写入内容

测试

此时VIP处于Master路由的位置,而Backup处于监听状态

网页测试

补充

通过systemctl stop keepalived命令关闭Master的服务后去查看Backup是否顶上VIP

再次启动Master的keepalived服务后查看VIP又回来了

4486

4486

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?