摘要

强化学习(RL)增强的大型语言模型(LLM),特别是以DeepSeek-R1为代表,表现出了卓越的性能。尽管在提升LLM能力方面效果显著,但其实现仍然高度复杂,涉及复杂的算法、奖励建模策略和优化技术。这种复杂性对研究人员和从业者在系统理解RL增强LLM方面构成了挑战。此外,缺乏一份全面的调查总结现有研究的文献,限制了这一领域的进展,妨碍了进一步的发展。

在本研究中,我们将系统性地回顾关于RL增强LLM的最新知识,试图整合和分析该领域快速增长的研究,帮助研究人员理解当前的挑战和进展。具体而言,我们将(1)详细介绍RL的基础;(2)介绍流行的RL增强LLM;(3)回顾两种广泛使用的基于奖励模型的RL技术的研究:人类反馈中的强化学习(RLHF)和人工智能反馈中的强化学习(RLAIF);(4)探讨直接偏好优化(DPO),这是一组通过绕过奖励模型直接使用人类偏好数据来对齐LLM输出与人类期望的方法。我们还将指出当前方法的挑战和不足,并提出进一步改进的建议。该研究的项目页面可以在我们最新的代码库中找到。

1 引言

近期,以DeepSeek-R1(DeepSeek-AI等,2025)为代表的强化学习(RL)增强大型语言模型(LLM)(OpenAI,2023,2024a;Team等,2024b;GLM等,2024;Adler等,2024;Yang等,2024a;AI等,2024;Team等,2025)展示了卓越的性能(Wang等,2023b;Wan等,2023;Sun等,2023c,b;Giray,2023;Zhang,2023;Long,2023;Sun,2023;Gao等,2023;Paranjape等,2023;Sun等,2023a;Diao等,2023;Wang等,2023a;Zhang等,2023b;Sun等,2023d;Liu等,2024d;Yao等,2024;Liu等,2024c;Lee等,2024;Kambhampati,2024;Wang等,2024c),吸引了研究界的广泛关注。促成这一成功的关键因素是强化学习技术的整合,这已被证明是增强LLM能力的有效方法。

使用RL训练LLM的过程可以分为三个主要步骤:(1) 奖励模型训练:在微调之前,训练一个奖励模型(或奖励函数),以近似人类偏好并评估不同的LLM输出;(2) 基于偏好的微调:在每次微调迭代中,LLM为给定指令生成多个响应,每个响应使用训练好的奖励模型进行评分;(3) 策略优化:利用RL优化技术,根据偏好分数更新模型的权重,从而改善响应生成。

将强化学习融入LLM使模型能够根据不同的偏好分数动态调整,而不是局限于单一的预定答案。这使它们能够生成结构良好、上下文适宜的响应。此外,RL还允许直接在人工偏好上进行训练,从而增强LLM生成创造性、高质量输出的能力,更加贴近人类期望。

尽管强化学习(RL)在增强LLM能力方面非常有效,但其实现依然高度复杂,要求使用复杂的算法、奖励建模策略和优化技术。这种复杂性给研究人员和从业者在系统理解RL增强LLM方面带来了挑战。此外,缺乏一份全面的调查总结现有关于RL增强LLM的研究,限制了该领域的进展,妨碍了进一步的发展,也使得整合知识和推动创新变得困难。

为了解决这一问题,本文提供了对强化学习增强的大型语言模型(LLMs)中面临的挑战和机遇的系统回顾。具体而言,我们旨在识别应用强化学习于LLMs的关键障碍,并对近期克服这些障碍的努力进行全面分析:

-

奖励模型训练层面:我们分析了奖励模型的演变,包括人类反馈中的强化学习(RLHF)和人工智能反馈中的强化学习(RLAIF)。讨论内容涵盖了它们的有效性、局限性、评估方法及相关挑战,如人类注释中的偏差、生成分布外内容,以及与人类可解释性相关的问题。

-

偏好微调层面:我们探索了将LLMs与人类偏好对齐的方法,包括直接偏好优化(DPO)及其变体。此外,我们还考察了偏好数据收集的影响、不同优化函数,以及旨在维护对齐过程中的安全性的策略。

通过提供对RL增强LLMs的全面概述,本调查旨在弥补该领域的知识空白,努力整合和分析该领域快速增长的研究,帮助研究人员理解当前的格局、挑战和进展。该调查的其余部分组织如下:

- 第2节:介绍强化学习(RL)的基本概念及关键术语,并概述RL管道如何适应LLMs。

- 第3节:介绍流行且强大的强化学习增强LLMs。

- 第4节:概述人类反馈中的强化学习(RLHF)过程,这是一种将强化学习与人类反馈结合以使LLMs与人类价值观、偏好和期望对齐的训练方法。

- 第5节:回顾关于人工智能反馈中的强化学习(RLAIF)的研究,这为RLHF提供了一种有前景的替代或补充,通过利用AI系统对正在训练的LLM的输出提供反馈,具有可扩展性、一致性和成本效益等优势。

- 第6节:分析与RLHF和RLAIF相关的挑战。

- 第7节:讨论直接偏好优化(DPO)的研究,这是一系列绕过奖励模型的方法,直接利用人类偏好数据来使LLM输出与人类期望对齐。

- 第8节:总结当前挑战并讨论进一步改进的机会。

2 基础知识:大型语言模型的强化学习

在本节中,我们首先详细介绍强化学习(RL)的基本知识及关键术语,然后概述RL管道如何适应大型语言模型(LLMs)。

2.1 强化学习基础

强化学习(RL)是机器学习中的一个关键方法,专注于代理如何与环境交互以最大化累积奖励。与依赖标记数据的监督学习和发现未标记数据模式的无监督学习不同,RL强调通过直接反馈进行试错学习。以下是对RL基本定义和一般管道的逐步描述。

2.1.1 基本定义

在此,我们使用图1中的训练示例来说明RL的完整过程。在这个例子中,我们的目标是训练一个机器人从方形的左下角移动到右上角。此外,每个网格单元都有一个奖励分数,我们的目标是最大化机器人的总分。在深入训练过程之前,我们首先介绍一些相关术语:

-

代理(Agent):代理是我们训练的实体,以做出正确的决策。在这个例子中,我们的目标是训练机器人做出移动决策,因此机器人就是代理。

-

环境(Environment):环境是代理与之交互的外部系统。在我们的例子中,当训练好的机器人(代理)在网格中移动时,网格就是环境。

-

状态(State):状态表示代理在每个时间点 t t t 的位置。例如,在开始时,时间 t 0 t_0 t0 时,机器人(代理)从左下角开始,因此在 t 0 t_0 t0的状态是左下角,用坐标 (0, 0) 表示。

-

动作(Action(s)):动作表示代理在每个时间点 t t t 在环境中可以选择的可用选项。例如,在开始时,时间 t 0 t_0 t0,机器人(代理)可以选择向右或向上移动,使这两个动作在 t 0 t_0 t0 时可用。

-

奖励(Reward(s)):奖励是环境根据代理在每个时间点 t t t 采取的动作所提供的信号或反馈。例如,在时间 t 0 t_0 t0时,机器人(代理)向右移动将获得 +5 分的奖励,或者向上移动将受到 -1 分的惩罚。

-

策略(Policy):策略是一组决策策略,帮助代理在每个时间点 t t t 选择动作。在实践中,在时间 t 0 t_0 t0时,策略表示一个概率分布,指导机器人(代理)选择向右或向上移动,以最大化其累积奖励。

2.1.2 强化学习的一般管道

我们已经定义了RL中使用的关键术语,在本节中,我们将继续详细介绍强化学习的一般管道。

如图1所示,一般的强化学习(RL)管道可以表示为马尔可夫决策过程(MDP)。正式来说,代理从初始状态 s 0 s_0 s0开始,在每个时间步 t t t 中,根据其当前状态 s t s_t st 选择一个动作 a t a_t at。作为响应,环境转移到一个新状态 s t + 1 s_{t+1} st+1,代理获得一个奖励 r t r_t rt。这个循环持续进行,代理的目标是最大化其随着时间累积的总奖励。

在图1中的具体示例中,在初始时间 t 0 t_0 t0,机器人从左下角开始,位置(状态)为 s 0 s_0 s0。随着时间的推移,在每个时间步 t t t 中,机器人选择一个动作 a t a_t at(要么向上移动,要么向右移动)。该动作使机器人从当前的位置 s t s_t st转移到一个新位置 s t + 1 s_{t+1} st+1,同时获得奖励 r t r_t rt。这一移动和奖励收集的循环持续进行,直到机器人到达右上角的目标位置(状态),实现最大化累积奖励的目标。

2.2 LLMs 的强化学习

我们已经概述了强化学习的一般框架;现在将深入探讨使用RL微调大型语言模型(LLMs)的过程。该方法旨在使LLMs与期望行为对齐,增强其性能,并确保输出既有效又可靠。

在强化学习(RL)中,有六个关键组件:代理、环境、状态、动作、奖励和策略。为了将RL应用于LLMs的微调,第一步是将这些组件映射到LLM框架中。

LLMs在下一个标记预测方面表现出色,它们将一系列标记作为输入,并根据给定上下文预测下一个标记。从RL的角度来看,我们可以将LLM本身视为策略。当前的文本序列代表状态,基于该状态,LLM生成一个动作——下一个标记。该动作更新状态,创建一个新状态,包含新添加的标记。在生成完整的文本序列后,通过使用预训练奖励模型评估LLM输出的质量来确定奖励。

图2展示了Ouyang等(2022)提出的LLMs的具体RL框架。Ouyang等(2022)从一个通过监督学习训练的指令调优模型开始,使其能够针对人类指令生成结构化响应。然后,Ouyang等(2022)应用以下两个步骤:

步骤1:收集比较数据并训练奖励模型。Ouyang等(2022)收集了一个数据集,其中包含指令调优模型输出之间的比较,标注者指明他们对给定输入更喜欢哪个输出。然后,收集的数据集用于训练奖励模型(RM),以预测人类偏好的输出。

步骤2:使用PPO优化策略。Ouyang等(2022)利用RM的输出作为标量奖励,并使用PPO算法(Schulman等,2017)微调指令调优模型,以优化该奖励。

3 通过强化学习增强的流行大型语言模型

近期,几乎所有具有强大能力的流行大型语言模型(LLMs)都利用强化学习(RL)在后期训练过程中进一步提升其性能。这些模型采用的RL方法通常可以分为两个主要方向:

-

传统RL方法:如人类反馈中的强化学习(RLHF)和人工智能反馈中的强化学习(RLAIF)。这些方法需要训练一个奖励模型,并涉及复杂且通常不稳定的过程,使用如近端策略优化(PPO)算法(Schulman等,2017)来优化策略模型。像InstructGPT(Ouyang等,2022)、GPT-4(OpenAI,2023)和Claude 3(Anthropic,2024)等模型遵循这一方法。

-

简化方法:如直接偏好优化(DPO)(Rafailov等,2024)和奖励感知偏好优化(RPO)(Adler等,2024)。这些方法省略了奖励模型,提供了一种稳定、高效且计算效率高的解决方案。像Llama 3(Dubey等,2024)、Qwen 2(Yang等,2024a)和Nemotron-4 340B(Adler等,2024)等模型遵循这一方法。

在本节中,我们将详细描述每个模型,首先简要概述这些RL增强的LLMs,然后解释在其后期训练过程中如何应用RL。关于这些RL增强LLMs的概述见表1。

3.1 DeepSeek-R1

DeepSeek-R1(DeepSeek-AI等,2025)是由DeepSeek开发的最先进推理模型,其性能可与OpenAI的o1系列模型(OpenAI,2024b)相媲美。这项工作开创性地将纯强化学习(RL)应用于增强语言模型的推理能力,强调自我演变,而非单纯依赖监督训练数据。

在训练阶段,DeepSeek-R1经历了一种交替训练过程,结合了监督微调(SFT)(Zhang等,2023a)和强化学习(RL),分为四个关键阶段:

-

初始冷启动SFT:首先收集数千个高质量、关注可读性的长链推理(long-CoT)数据集,以微调DeepSeek-V3-Base,为后续的RL训练奠定坚实的基础。

-

第一次推理导向RL阶段:采用名为大规模推理导向RL的方法,进一步微调模型,生成的检查点用于生成额外的SFT数据,以用于下一训练阶段。

-

第二个SFT阶段:通过结合推理数据和非推理数据进一步优化模型。推理数据通过从前一个阶段的RL检查点进行拒绝采样生成;非推理数据则使用DeepSeek-V3管道整合写作、事实问答、自我认知和翻译等数据,包括部分DeepSeek-V3 SFT数据集。

-

第二个RL阶段(所有场景):利用最终的RL阶段进一步使模型与人类偏好对齐,提高其有用性、安全性和推理能力。

DeepSeek-R1是一个开源模型,公开向研究社区提供,以支持该领域的进一步进展。发布过程中首先推出了DeepSeek-R1-Zero,这是一个源自DeepSeek-V3-Base的模型,使用大规模RL训练而不进行监督微调(SFT)。该初始模型展示了显著的推理改进,其在AIME 2024上的pass@1得分从15.6%提高至71.0%。通过多数投票,得分进一步上升至86.7%,与OpenAI-o1-0912相匹配。为了解决可读性差和语言混合等问题,并进一步提升推理能力,作者推出了DeepSeek-R1。这个增强模型集成了一小部分冷启动数据,并遵循多阶段训练管道,达到了与OpenAI-o1-1217相当的性能。

3.2 Kimi-k1.5

Kimi-k1.5(Team等,2025)是由Moonshot AI开发的多模态大型语言模型(LLM),标志着在强化学习(RL)扩展方面的重大突破。该模型引入了一种新方法,强调长上下文扩展,将RL上下文窗口扩大到128k,并优化政策优化技术。

在训练过程中,Kimi-k1.5经历了四个阶段的训练流程:

- 预训练

- 普通监督微调(SFT)

- 长链推理(Long-CoT)监督微调

- 强化学习(RL)

关键创新在于强化学习(RL)阶段,作者开发了一组高质量的RL提示集,以引导模型朝向稳健的推理,同时减少潜在风险,如奖励黑客和对表面模式的过拟合。这组提示设计具有三个基本特性:

- 多样化覆盖:确保接触广泛的推理挑战。

- 平衡难度:提供简单、中等和复杂推理任务的混合。

- 准确可评估性:允许精确测量推理性能。

虽然长链推理(Long-CoT)模型表现出强大的推理能力,但在测试时通常消耗的标记比标准短链推理(short-CoT)LLMs更多。为了解决这一长短转化挑战,作者提出了四个关键方法,将长链推理能力转移到短链模型:

- 模型合并:通过平均权重将长链模型与短模型结合。

- 最短拒绝采样:使用长链模型生成多个响应,并选择最短的正确响应进行SFT训练。

- 直接偏好优化(DPO):构建成对偏好数据,将较短的正确解决方案视为正样本,较长的解决方案视为负样本,通过DPO训练优化模型。

- 长短RL:实施两阶段RL训练方法,模型首先接受标准RL训练,然后施加长度惩罚,减少最大响应长度,鼓励更简洁的推理,同时保持性能。

Kimi-k1.5在各种基准和模态上提供了最先进的推理性能,媲美OpenAI的o1(OpenAI,2024b)。此外,长短转化技术的引入显著增强了短链推理模型,取得了比现有模型如GPT-4o(Hurst等,2024)和Claude 3.5高达550%的提升。

3.3 InstructGPT

InstructGPT(Ouyang等,2022)是一系列大型语言模型,基于GPT-3(Brown等,2020)进行微调,由OpenAI开发,旨在通过人类反馈更好地与人类意图对齐。该系列包括三个规模的模型:1.3B、6B和175B参数。模型首先使用来自OpenAI API或由标注者编写的提示进行监督学习微调,然后进一步通过人类反馈的强化学习(RLHF)进行优化。人类评估表明,InstructGPT的输出优于GPT-3。值得注意的是,尽管1.3B参数的InstructGPT模型的参数量比175B的GPT-3少100倍,但仍更受欢迎。此外,InstructGPT在真实度和减少有害输出方面表现出色,同时在公共NLP数据集上几乎没有性能折衷。

在应用强化学习(RL)之前,作者训练了一个6B的奖励模型(RM),该模型从监督微调(SFT)模型中初始化,并移除了最终的反嵌入层。该RM使用标注者排序的比较数据进行训练。在RL阶段,他们微调SFT模型,以优化来自RM的标量奖励输出,并使用近端策略优化(PPO)算法(Schulman等,2017)。为了解决公共NLP数据集上的性能回归问题,他们尝试将预训练梯度与PPO梯度混合,得到的模型称为PPO-ptx。

3.4 GPT-4

GPT-4(OpenAI,2023)是由OpenAI开发的大型多模态模型,能够处理图像和文本输入并生成文本输出。它在理解和生成自然语言方面表现出色,尤其在复杂和细微的场景中。评估显示,GPT-4在一系列人类设计的考试中表现卓越,通常超过大多数人类考生。此外,它还优于早期的大型语言模型和大多数最先进的系统,这些系统往往依赖于特定基准的训练或手工工程解决方案。

GPT-4在后期训练对齐阶段采用了RLHF方法,如我们在第3.3节中描述的InstructGPT(Ouyang等,2022)。为了更有效地引导模型在更细微的层面上进行适当的拒绝,作者进一步使用零-shot GPT-4分类器作为基于规则的奖励模型(RBRM)。该RBRM在对一部分训练提示进行PPO微调时,为GPT-4策略模型提供额外的奖励信号。

RBRM的输入包括一个提示(可选)、策略模型的输出和人类编写的评分标准(例如,多项选择题风格的一组规则),然后根据评分标准对输出进行分类。通过这种方法,GPT-4在拒绝有害内容和适当地响应已知安全提示时获得奖励。

3.5 Gemini

Gemini(Team等,2023)代表了谷歌开发的一系列先进多模态模型,以其出色的能力而著称。初始版本Gemini 1.0提供三种规模——Ultra、Pro和Nano,性能从大到小各有不同。每种规模都旨在满足特定的计算约束和应用需求。值得注意的是,Gemini Ultra作为最强大的变体,在32个基准中的30个上取得了最先进的结果,并且是第一个在MMLU(Hendrycks等,2020)上达到人类专家水平性能的模型,同时在所有20个多模态基准上设定了新记录。

Gemini采用优化的反馈循环来驱动关键性能领域的持续改进。在后期训练的RLHF阶段,采用迭代方法,强化学习(RL)逐步增强奖励模型(RM)。与此同时,RM通过系统评估和数据收集进行持续优化。这种动态互动促进了RL和RM的持续进步,导致性能随着时间的推移不断提升。

3.8 Zephyr 141B-A39B

Zephyr 141B-A39B(HuggingFaceH4,2024)是Zephyr(Tunstall等,2023)系列语言模型的最新成员,由Argilla、KAIST和Hugging Face合作开发。该模型采用专家混合(Mixture of Experts,MoE)架构,具有总共1410亿参数,其中390亿参数为活跃参数,经过从Mixtral-8x22B-v0.1(Mistral AI,2024)微调而来。

Zephyr 141B-A39B采用了一种新型对齐算法,称为赔率比偏好优化(Odds Ratio Preference Optimization,ORPO)(Hong等,2024)。ORPO是一种简单而统一的对齐方法,旨在防止模型在监督微调过程中采用不希望的生成风格。值得注意的是,ORPO不需要SFT预热阶段、奖励模型或参考模型,从而使其资源效率极高。该方法通过在标准SFT负对数似然损失中添加基于赔率比的惩罚,使模型能够区分优选和非优选的响应风格。

3.9 DeepSeek-V2

DeepSeek-V2(Liu等,2024a)是由DeepSeek-AI开发的一种强大的专家混合(Mixture-of-Experts,MoE)语言模型,旨在实现经济高效的训练和推理。该模型拥有2360亿总参数,其中每个token激活21亿参数,支持高达128K tokens的上下文长度。它在一个高质量、多源的语料库上进行预训练,该语料库包含81万亿tokens。评估结果表明,DeepSeek-V2及其聊天版本在开源模型中保持顶尖性能,尽管激活参数仅为21亿。

在强化学习(RL)阶段,DeepSeek-V2采用了一种名为组相对策略优化(Group Relative Policy Optimization,GRPO)(Shao等,2024)的优化方法,以降低训练成本。与使用与策略模型相似大小的评论者模型的传统RL方法不同,GRPO省略了评论者模型,而是根据一组针对相同问题的输出计算得分来估计基线。此外,采用了两阶段的RL训练策略:第一阶段专注于推理对齐,第二阶段则关注人类偏好对齐,作者发现这两个阶段表现出不同的特征。

3.10 ChatGLM

ChatGLM(GLM等,2024)是由Zhipu AI开发的一系列不断发展的大型语言模型。该系列的最新版本是GLM-4,包括GLM-4、GLM-4-Air和GLM-4-9B等变体。这些模型在超过10万亿tokens的数据集上进行预训练,主要涵盖中文和英文,随后通过监督微调(SFT)和强化学习人类反馈(RLHF)的结合进行后期训练,以实现先进的对齐质量。评估结果表明,GLM-4在如MMLU等通用基准上与GPT-4(OpenAI,2023)相媲美,甚至超越,并在AlignBench(Liu等,2023b)中显示出在中文特定对齐方面的优越性能。

强化学习阶段涉及ChatGLM-RLHF(Hou等,2024)流程,旨在增强与人类偏好的对齐。该流程包括三个主要组成部分:收集人类偏好数据、训练奖励模型和优化策略模型。为了支持大规模训练,ChatGLM-RLHF采用了减少奖励方差的方法以实现稳定训练,利用模型并行性结合融合梯度下降,并应用正则化约束以防止大型语言模型的灾难性遗忘。实验结果确认,ChatGLM-RLHF在对齐相关任务上相较于ChatGLM的监督微调版本取得了显著改善。

3.11 Nemotron-4 340B

Nemotron-4 340B(Adler等,2024)是NVIDIA发布的一系列模型,包括Nemotron-4-340B-Base、Nemotron-4-340B-Instruct和Nemotron-4-340B-Reward。Nemotron-4-340B-Base模型在一个高质量数据集上训练,使用了9万亿tokens。在开发Nemotron-4-340B-Instruct的对齐过程中,使用了超过98%合成生成的数据。评估结果表明,这些模型在广泛的评估基准中表现出色,与开源模型竞争力强。

在偏好微调阶段,模型采用了DPO(Rafailov等,2024)和一种新型对齐算法,即奖励感知偏好优化(Reward-aware Preference Optimization,RPO),通过多次迭代来提升模型性能。RPO解决了DPO的一个限制,即未考虑所选响应与被拒绝响应之间的质量差异,这可能导致过拟合并遗忘有价值的响应。RPO利用策略网络的隐式奖励来近似这一差距,从而使模型更好地学习和保留优质反馈。

3.12 Llama 3

Llama 3(Dubey等,2024)由Meta开发,是一系列开源基础语言模型,提供8亿、700亿和4050亿参数的不同规模。该模型在一个显著更大的语料库上进行训练,包含约15万亿多语言tokens,相较于Llama 2(Touvron等,2023)的1.8万亿tokens有了显著增加。广泛的实证评估显示,Llama 3在多种任务上与领先模型(如GPT-4,OpenAI,2023)表现相当。

Llama 3的后期训练过程包括六轮迭代优化。每轮包括监督微调(SFT),随后进行DPO,最终模型是所有轮次输出的平均值。每轮都训练一个奖励模型(RM),基于新收集的偏好标注数据,针对广泛的能力进行优化。在SFT之后,DPO进一步优化SFT模型,使用从前几轮表现最佳模型获得的最新偏好数据批次。为增强DPO训练的稳定性,实施了两个关键调整:在DPO损失中屏蔽格式化tokens,并通过负对数似然(NLL)损失引入正则化。

3.13 Qwen2

Qwen2(Yang等,2024a)由阿里巴巴开发,是一系列参数范围从5亿到720亿的语言模型,此外还有一个专家混合变体,具有570亿参数,其中每个token激活14亿参数。该模型在一个包含超过7万亿tokens的高质量大规模数据集上进行预训练,覆盖广泛的领域和语言。广泛的评估显示,Qwen2超越了大多数之前的开源模型,包括其前身Qwen1.5,并在语言理解、生成、多语言能力、编程、数学和推理等多个基准上提供了竞争力的结果。

Qwen2的偏好微调过程分为离线学习和在线学习两个主要阶段。在离线阶段,Qwen2使用DPO进行优化,旨在最大化同一提示两个响应之间的似然差异,基于预编译的偏好数据集。在在线阶段,模型通过利用奖励模型从当前策略模型生成的多个响应中选择的偏好对,实时持续改进。此外,还采用在线合并优化器(Lu等,2024)以最小化对齐成本。

3.14 Gemma 2

Gemma 2(Team等,2024b)是谷歌最新推出的Gemma系列轻量级、先进的开源模型,参数范围从20亿到270亿。该模型结合了多个成熟的Transformer架构修改,包括交错的局部-全局注意力(Beltagy等,2020)和组查询注意力(Ainslie等,2023)。实验表明,这些模型在其规模上表现最佳,甚至提供了对2-3倍更大模型的竞争性替代方案。

类似于Gemma 1.1(Team等,2024a),在后期训练的RLHF阶段,作者使用一个高容量模型作为自动评分者来调整超参数并减轻奖励黑客(Amodei等,2016;Skalse等,2022)的影响。然而,与Gemma 1.1不同,他们使用的奖励模型比策略模型大一个数量级,专门设计用于关注对话能力,特别强调多轮交互。

3.15 Starling-7B

Starling-7B(Zhu et al., 2024)是由加州大学伯克利分校开发的强大7亿参数聊天模型,专注于与人类偏好的对齐,以提高有用性和无害性。该模型基于Openchat-3.5(Wang et al., 2024a)进行微调,采用强化学习人类反馈(RLAIF),使用了一个名为Nectar的高质量偏好数据集,该数据集包含380万个通过提示GPT-4生成的成对比较。结果显示,模型在MT-Bench上的分数从7.81提升至8.09,在AlpacaEval上的分数从88.51%提高到91.99%,而在Chatbot Arena(Chiang et al., 2024)的人工评估ELO从1072上升至1087。

在RLAIF过程中,作者对PPO算法进行了多项改进,以增强训练的稳定性和鲁棒性。首先,他们引入了一个恒定的正奖励用于长度控制,以防止过度冗长。这一调整有助于解决早期阶段奖励模型的高度负奖励可能导致策略模型在仅进行几次梯度更新后变得过于冗长的问题。其次,他们对评论者模型进行了预训练,以减少由于随机初始化评论者导致的早期性能下降。最后,他们对演员和评论者模型进行了全面的参数调优,而不是仅调整前四层,以最大化强化学习阶段的性能提升。

3.16 o1

OpenAI的o1(OpenAI, 2024b)是一种新开发的大型语言模型,优化了复杂推理,利用强化学习进行训练。在生成响应之前,o1进行广泛的内部思考过程,使其在各种推理任务中表现出色。该模型在许多挑战性任务中显著超越了GPT-4o(OpenAI, 2024a):在Codeforces上排名89百分位,在AIME数学竞赛中位列前500名,并在GPQA等科学基准测试中超过博士级别的准确性。

o1的训练涉及一种大规模的强化学习算法,强调通过详细的思维链(CoT)(Wei et al., 2023)进行富有成效的思考,并实现高数据效率。为了保持模型的无过滤推理能力,未对其内部思考过程应用策略合规或用户偏好训练,这也提供了理解模型原始思维过程的独特机会。这一方法使o1能够在训练中细化其策略、纠正错误并分解复杂问题。值得注意的是,模型的性能随着训练计算资源的增加和测试时计算的扩展而提升。

3.17 Others

Reka Core, Flash, and Edge: Team et al.(2024c)是由Reka从头开发的强大多模态语言模型。Reka Edge和Reka Flash分别是具有70亿和210亿参数的密集模型,超越了许多更大模型,并在其计算类别中提供了卓越的性能。旗舰模型Reka Core在自动化和盲人评估中与GPT-4v、Gemini和Claude 3等领先模型竞争。在后期训练中,Reka模型在监督微调后经历多轮使用PPO的RLHF,以进一步增强对齐。

Phi-3: Abdin et al.(2024)是微软推出的一系列语言模型,包括phi-3-mini、phi-3-small和phi-3-medium。值得注意的是,最小的模型phi-3-mini在3.3万亿tokens上进行训练,但仅包含3.8亿参数,使其足够紧凑以在移动设备上部署。尽管其相对较小的规模,phi-3-mini在MMLU上表现出与更大模型如Mixtral 8x7B和GPT-3.5相媲美的性能,达到了69%和在内部测试中的MT-bench得分为8.38。在后期训练中,作者使用DPO将phi-3引导远离不希望的行为,将那些输出视为“被拒绝”的响应。

Athene-70B: Nexusflow(2024)是一种强大的聊天模型,从Llama-3-70B(Dubey et al., 2024)进行微调,取得了77.8%的Arena-Hard-Auto分数,接近GPT-4o(79.2%)和Claude-3.5-Sonnet(79.3%)等领先专有模型。这标志着其前身Llama-3-70B-Instruct的显著飞跃,该模型得分为46.6%。这一进展归因于Nexusflow的有针对性的后期训练方法,提升了模型的性能。具体而言,Nexusflow根据内部基准评估的高质量偏好数据进行策划,涵盖指令遵循、编码、创意写作和多语言任务。这些数据随后用于有针对性的RLHF,从而实现了相对于Llama-3-70B-Instruct的显著性能提升。

Hermes 3: Teknium et al.(2024)是一系列中立对齐的通用指令和工具使用模型,具备先进的推理和创意能力,由Nous Research开发。它从Llama 3.1(Dubey et al., 2024)微调,提供8B、70B和405B的变体,其中最大模型Hermes 3 405B在多个公共基准上设定了开放权重模型的最新性能。Hermes在多样化的合成推理任务和创意应用(如角色扮演和写作)上进行训练,旨在准确且中立地遵循系统和指令提示,而不同于许多商业模型可能因道德原因拒绝指令。为了进一步对齐Hermes,作者利用DPO并训练LoRA(Hu et al., 2021)适配器,而不是微调整个模型,从而显著减少了参考模型和训练模型的GPU内存使用。

4 RLHF: Reinforcement Learning from Human Feedback

Reinforcement Learning from Human Feedback (RLHF) 是一种训练方法,结合了强化学习(RL)和人类反馈,以使大型语言模型(LLMs)与人类的价值观、偏好和期望对齐。RLHF 主要由两个组成部分构成:

-

收集人类反馈以训练奖励模型:在这个过程中,人类评估者通过对LLM的输出进行评分或排名,提供关于输出质量和相关性的反馈。这些反馈用于训练奖励模型,预测输出的质量,并在RL过程中作为奖励函数。

-

利用人类反馈进行偏好优化:训练好的奖励模型指导LLM的输出优化,以最大化预测的奖励,从而将LLM的行为与人类偏好对齐。

下面将通过近期的研究实例来说明这两个组成部分。

4.1 Collecting Human Feedback to Train Reward Model

Skywork-Reward (Liu et al., 2024b)

Skywork-Reward 是一个经过精心设计的数据集,包含80,000个高质量的偏好对,通过有效的数据选择和过滤策略进行策划。原始数据集包含378,000个偏好对,但经过严格的清理、一致性检查、基于模型的评分过滤低质量样本以及人工审核,最终精炼成一个紧凑的高质量数据集。尽管规模显著小于现有数据集,Skywork-Reward 通过严格的处理实现了优异的质量。

该数据集涵盖了多种任务,如指令遵循、代码生成和多语言处理,为像Skywork-Reward-Gemma-27B这样的模型奠定了基础,这些模型在基准测试中表现出色。通过使语言模型更好地理解人类偏好,Skywork-Reward 帮助LLMs在实际应用中变得更加准确和有用。

TÜLU-V2-mix (Ivison et al., 2023)

TÜLU-V2-mix旨在增强大型语言模型的指令遵循能力,提供一个多样化的数据集,以提高模型在多领域任务中的泛化和执行能力。该数据集涵盖广泛的任务,包括问答、代码生成、翻译和多轮对话,特别强调多语言适应性和处理复杂现实场景的能力。

与Skywork-Reward不同,TÜLU-V2-mix专注于模型的泛化能力,帮助模型在广泛任务中表现出色,而Skywork-Reward则专注于使用偏好对将模型与人类偏好对齐,帮助模型学习生成用户偏好的响应,如流畅且连贯的文本。这两个数据集共同解决了推动语言模型能力的互补目标。

4.2 Preference Optimization Using Human Feedback

一旦奖励模型训练完成,它将用于通过强化学习指导原始大型语言模型(LLM)的微调。主要目标是基于预测的奖励改善LLM的行为,使其更有可能生成与人类偏好一致的输出。近期研究(Ouyang et al., 2022; Yuan et al., 2023; Dong et al., 2024; Ahmadian et al., 2024)表明,该过程可以分为两个关键步骤:

-

奖励:在这一步中,LLM针对给定的指令生成多个输出。每个输出将通过训练好的奖励模型,该模型分配一个标量评分,近似人类的偏好。

-

策略优化:在这一步中,通过调整LLM的参数以最大化预测奖励来进行微调,通常使用近端策略优化(Proximal Policy Optimization,PPO)(Schulman et al., 2017)或信任区域策略优化(Trust Region Policy Optimization,TRPO)(Schulman, 2015)算法。

这两个步骤——奖励和策略优化——可以迭代进行。这意味着生成输出、使用训练好的奖励模型进行奖励以及微调LLM以最大化奖励的过程可以重复多次。每次迭代,LLM的表现都会改善,因为它在不断调整行为以更好地符合人类偏好。这种迭代循环使LLM能够持续适应和优化其响应,最终导致更有效且更对齐的输出。

5 RLAIF: Reinforcement Learning from AI Feedback

Reinforcement Learning from AI Feedback (RLAIF) 是一种有前景的替代或补充RLHF的方法,利用更强大或专业的AI系统(例如GPT-4 (OpenAI, 2024a))对正在训练的LLM的输出提供反馈。这种方法具有可扩展性、一致性和成本效率等优点,同时减少了对人类评估者的依赖。以下,我们探讨几种用AI反馈替代人类反馈的方法:

- 提炼AI反馈以训练奖励模型

- 将LLMs提示作为奖励函数

- 自我奖励

5.1 Distilling AI Feedback to Train Reward Model

除了手动收集的数据外,从预训练LLM提炼数据集提供了一种高效的替代方案。通过利用强大的LLM(如GPT-4)的输出,研究人员可以在手动策划和自主评估之间建立桥梁。

UltraFeedback (Cui et al., 2023)

UltraFeedback是一个大规模AI反馈数据集,旨在提高大型语言模型(LLMs)的性能和对齐。它包含超过100万个高质量的GPT-4反馈注释,涵盖250,000个用户-助手交互,重点关注指令遵循、准确性、诚实性和有用性等关键维度。该数据集通过收集60,000个多样化的指令,使用17种不同模型生成响应,并利用GPT-4进行详细的批评和评分,其中运用了思维链推理以减少偏见。

Magpie

Xu et al.(2024b)介绍了一种自我合成方法,利用对齐LLM的自回归特性。通过使用预定义模板作为提示,模型自主生成用户查询和相应的响应,消除了手动干预或初始种子问题的需求。具体而言,如图4所示,使用对齐的LLM(例如Llama-3-Instruct模型)合成了400万个指令-响应对,随后对数据集进行过滤,以保留300,000个高质量对。这些对被用于微调Llama-3-8B-Base模型。值得注意的是,微调后的模型在性能上与经过10百万示例的监督微调和人类反馈强化学习训练的正式Llama-3-8B-Instruct模型相媲美。此外,使用Magpie微调的模型在AlpacaEval等对齐基准上表现优异,超越了在其他开放数据集和偏好优化方法上训练的模型。

HelpSteer2 (Wang et al., 2024d)

HelpSteer2 是一个高效的开源偏好数据集,包含大约10,000个比较样本,旨在训练高性能的奖励模型。该数据集使用多种模型(包括GPT-3.5、Claude等)生成的响应,并具有多维度的注释,如流畅性、相关性、创造力和安全性。偏好对是基于人类或自动评估制作的,使奖励模型能够实现细致的对齐。

通过严格的数据清理和优化,HelpSteer2 提供了高质量的注释,格式紧凑。该数据集以CC-BY-4.0许可证发布,促进了可访问性和社区的使用。

OffsetBias (Park et al., 2024)

OffsetBias 是一个精心设计的数据集,旨在减轻奖励模型中的偏见,该数据集使用多种模型生成的响应,包括GPT-3.5、GPT-4、Claude及开源模型如Llama 2。OffsetBias 系统性地解决了六种已识别的偏见类型:内容、风格、信息性、安全性、创造力和长度。

如图5所示,通过属性控制提示和多模型输出生成比较样本。这些样本经过多维评分和偏好标签的注释,以突出或中和偏见,从而实现细致的对齐。OffsetBias 不仅提高了奖励模型的可靠性,还结合了后查询模板,数据对研究和开发开放获取。

5.2 Prompting LLMs As a Reward Function

随着奖励模型训练的日益复杂,采用LLM作为强化学习循环中的评估者是一种自然的发展。

Exploring with LLMs (ELLM) Rewards (Du et al., 2023)

ELLM是一种将LLM与强化学习(RL)相结合的方法,旨在增强预训练阶段的探索能力。整体流程如图6所示:代理的当前状态被转换为自然语言描述,并输入到LLM中。LLM随后根据该描述生成探索目标,例如特定动作或目标位置。RL代理尝试实现这些目标,并在目标完成后由环境提供奖励。

这种方法通过引导代理朝向可能有价值的状态空间区域,从而提高了探索效率,而无需预先设计的奖励。ELLM在稀疏奖励环境中特别有用。与传统方法相比,ELLM显著提高了探索效率,涵盖了更多的常识行为,并为下游任务提供了更好的初始化。

Reward Design with Language Models (RDLM)

Kwon et al. (2023) 利用像GPT-3这样的LLM简化了强化学习中的奖励函数设计,允许用户通过自然语言描述定义期望的行为。具体而言,用户提供任务描述或几个示例,LLM通过评估代理的行为与这些标准的对比,生成奖励信号。

与产生奖励代码不同,RDLM直接输出奖励值,供代理用于策略优化。这种方法特别适用于用户目标明确但手动设计奖励函数较复杂的任务。

虽然ELLM专注于通过生成有意义的目标来指导预训练阶段的探索,RDLM则强调任务特定的奖励生成,以简化复杂的奖励设计并实现代理与人类意图的更好对齐。

Eureka (MMa et al., 2023)

Eureka 是一种算法,利用LLM自动生成和优化强化学习任务的奖励函数代码。在图7中,首先使用像GPT-4这样的编码LLM根据任务描述生成初始奖励函数代码。然后,通过进化策略对该代码进行迭代精炼,其中候选奖励函数根据它们在多大程度上指导RL代理实现任务成功进行评估。这个过程旨在演化奖励函数,以提高其质量和有效性。

Eureka 在需要复杂或高度特定奖励定义的任务中尤其有效,例如高级机器人技能。它对奖励代码优化的关注使其适用于对奖励塑造要求严格的场景。通过利用LLM生成和精炼代码的能力,Eureka 演变出有效指导RL代理的奖励函数。

实验表明,Eureka 在83%的测试任务中超过了人类设计的奖励,平均性能提高了52%,展示了其在挑战性场景中进行高级技能学习(如机器人任务)的潜力。

Text2Reward (Xie et al., 2023)

Text2Reward 是一个框架,利用大型语言模型自动生成密集且可解释的奖励函数代码,从自然语言任务描述中实现高效的奖励塑造,适用于多种强化学习任务。如图8所示,该过程开始于用户提供自然语言的任务描述,这些描述被输入到LLM中以生成可执行的奖励代码。生成的代码通常包含特定于任务的逻辑,并可能集成外部库以实现复杂功能。生成的奖励函数随后用于指导RL代理的行为。

此外,Text2Reward 还支持通过人类反馈对奖励代码进行迭代精炼,从而实现进一步优化。这种方法在提供灵活、可解释的奖励方面表现出色,特别是在机器人和操作任务中。

与Eureka不同,Text2Reward侧重于创建人类可读的奖励代码,集成外部库并通过人类反馈支持迭代精炼。尽管这两种方法都旨在自动化奖励设计,Eureka在优化复杂奖励逻辑以适应高级技能方面表现突出,而Text2Reward则优先考虑灵活性、可解释性和适应性,适用于更广泛的任务。

RLAIE (Lee et al., 2023)

RLAIE 通过利用LLM替代人类反馈,自动生成强化学习中的反馈。该过程首先为给定任务(如文本摘要或对话生成)生成候选输出。这些输出被配对并输入到LLM中,LLM对它们进行评估,提供偏好(例如,选择更好的输出)或基于任务特定标准分配分数。这些反馈随后用于训练奖励模型,以预测输出质量并指导RL代理。

在其简化变体 d-RLAIF(见图10)中,LLM直接提供分数作为奖励信号,从而绕过了奖励模型的需要。RL策略使用这些奖励进行优化,通常采用近端策略优化(PPO)等算法。该方法实现了自动化、可扩展和高质量的反馈生成,有效地使RL代理行为与任务目标对齐,同时减少对人类注释的依赖。

GenRM (Zhang et al., 2024a)

GenRM重新定义了验证,将其视为文本生成任务,利用大型语言模型生成验证输出和推理链,例如“是”或“否”的回答及其解释。如图9所示,该方法将验证整合到LLM的生成能力中,使其能够以透明和可解释的方式评估和解释候选答案。通过将验证框架化为下一个标记预测,GenRM消除了对传统判别模型的依赖,增强了推理的准确性。

实验结果表明,GenRM在逻辑推理、可解释性和可扩展性能等任务中优于传统方法,展示了其在这些领域的潜力。

5.3 Self-Rewarding

自我奖励机制使LLM能够自主评估和优化其自身表现,从而解决现有强化学习方法在成本、可扩展性和适应性方面的局限性。

Self-Refined LM (Song et al., 2023)

Song等人利用LLM自动生成深度强化学习(DRL)任务的奖励函数,并引入自优化机制以迭代地精炼这些函数。该过程首先由LLM根据自然语言任务描述生成初始奖励函数。然后,将该奖励函数应用于RL训练,并评估代理的表现。来自此评估的反馈被反馈回LLM,使其能够以闭环方式动态调整和改进奖励函数。与Eureka和Text2Reward相比,这种方法消除了对外部优化算法或手动干预的需求。

Self-Rewarding Language Models (SRLM) (Yuan et al., 2024)

SRLM介绍了一种新颖的方法,其中LLM既充当生成器又充当评估者,创建一个自我包含的学习系统。如图11所示,模型首先生成新的提示(指令)和多个候选响应,这些响应源自现有数据,从而创建多样化和全面的训练样本。随后,模型使用结构化评分机制评估这些候选响应,以确定其质量。评估框架涵盖多个维度,包括相关性、覆盖率、有用性、清晰度和专业性,并根据这些标准为每个响应分配分数。

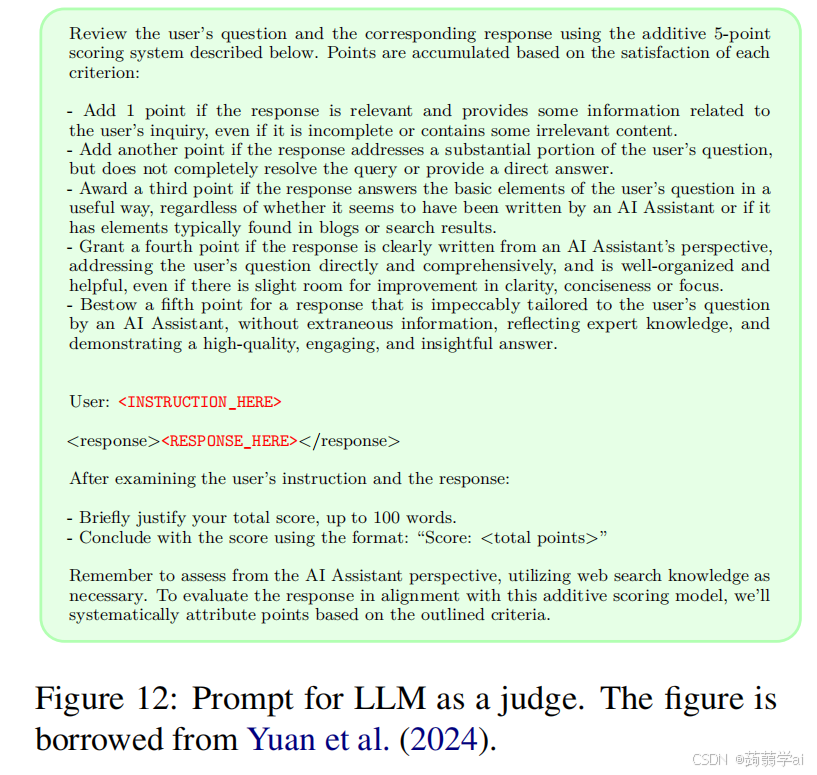

利用这些分数,构建偏好对,包括一个优选响应和一个不优选响应。这些偏好对用于直接偏好优化(DPO),从而提升生成高质量响应的能力。通过迭代精炼,模型逐步增强其表现。图12详细说明了模型用于评估候选响应的提示。实验结果表明,在三次迭代中使用SRLM对Llama 2 70B进行微调,相较于GPT-4和Claude 2等多个最先进模型,在AlpacaEval 2.0等基准测试中表现更佳,展示了其在提升指令遵循和一般任务表现方面的有效性。

Generative Judge via Self-generated Contrastive Judgments (Con-J) (Ye et al., 2024)

Ye等人提出了一种自我奖励机制,利用自生成的对比判断,使LLM能够通过提供详细的自然语言推理来评估和优化其输出。如图13所示,与传统的标量奖励模型输出单一数值分数不同,Generative Judge比较候选输出,生成正面和负面的评估,并附上自然语言解释。这使得模型能够评估为何一个输出优于另一个,从而提供可解释性并使其决策与细致的人类偏好对齐。

该框架还利用人类标注的偏好数据,通过直接偏好优化(DPO)进行训练,LLM被提示为配对输出生成对比推理。这些自生成的评估既作为奖励信号,又作为迭代精炼的基础,使模型能够自主改善其与任务目标的对齐。

在实验中,Generative Judge在与人类偏好的对齐方面达到了与标量奖励模型相当的性能,但在可解释性和对数据集偏见的鲁棒性方面表现更佳。通过利用对比判断,模型在需要多方面推理的任务中展示了增强的适应能力,并提升了其透明决策的能力。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?