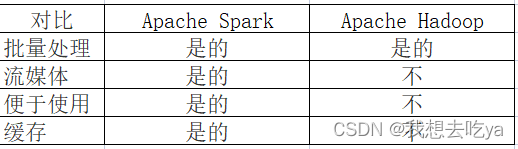

ApacheSpark与 Apache Hadoop数据科学工具有哪些区别?Apache Spark被设计为大规模处理的接口,而 Apache Hadoop 为大数据的分布式存储和处理提供了更广泛的软件框架。两者既可以一起使用也可以作为独立服务使用。Apache Spark 和 Apache Hadoop 都是 Apache 软件基金会提供的流行的开源数据科学工具,由社区开发和支持受欢迎程度和功能不断增长。

1、Apache Spark是什么?

Apache Spark 是一个为高效、大规模数据分析而构建的开源数据处理引擎。Apache Spark 是一个强大的统一分析引擎,数据科学家经常使用它来支持机器学习算法和复杂的数据分析。Apache Spark 可以独立运行,也可以作为 Apache Hadoop 之上的软件包运行。

2、Apache Hadoop是什么?

Apache Hadoop 是一组开源模块和实用程序,旨在简化存储、管理和分析大数据的过程。Apache Hadoop 的模块包括 Hadoop YARN、HadoopMapReduce 和 Hadoop Ozone,但它支持许多可选的数据科学软件包。Apache Hadoop 可以互换使用来指代 Apache Spark 和其他数据科学工具。

3、Apache Spark 与 Apache Hadoop有哪些区别

4、设计和架构区别

Apache Spark 是一个离散的开源数据处理实用程序。通过 Spark,开发人员可以访问用于数据处理集群编程的轻量级接口,具有内置的容错和数据并行性。Apache Spark 是用 Scala 编写的,主要用于机器学习应用程序。

Apache Hadoop 是一个更大的框架,其中包括 Apache Spark、Apache Pig、ApacheHive和 Apache Phoenix 等实用程序。作为一种更通用的解决方案,Apache Hadoop 为数据科学家提供了一个完整且强大的软件平台,然后他们可以根据个人需求进行扩展和定制。

5、使用范围

Apache Spark 的范围仅限于它自己的工具,包括 Spark Core、Spark SQL 和 Spark Streaming。Spark Core 提供了 Apache Spark 的大部分数据处理。Spark SQL支持额外的数据抽象层,开发人员可以通过它构建结构化和半结构化数据。Spark Streaming 利用 Spark Core 的调度服务来执行流分析。

Apache Hadoop 的范围要广泛得多。除了 Apache Spark,Apache Hadoop 的开源实用程序还包括pache Phoenix。一个大规模并行的关系数据库引擎。

(1)Apache Zookeeper.。用于云应用程序的协调分布式服务器。

(2)pache Hive。用于数据查询和分析的数据仓库。

(3)Apache Flume。分布式日志数据的仓储解决方案。

但是出于数据科学的目的,并非所有应用程序都如此广泛。速度、延迟和强大的处理能力在大数据处理和分析领域中至关重要——独立安装的 Apache Spark 可能更容易提供这些。

6、速度

对于大多数实现,Apache Spark 将比 Apache Hadoop 快得多。Apache Spark 专为速度而打造,其速度可能比 Apache Hadoop 快近 100 倍。然而,这是因为 Apache Spark 更简单、更轻量级。

默认情况下,Apache Hadoop 不会像 Apache Spark 一样快。但是,其性能可能会因安装的软件包以及所涉及的数据存储、维护和分析工作而异。

7、学习曲线

由于其关注点相对狭窄,Apache Spark 更容易学习。Apache Spark 有一些核心模块,并为数据的操作和分析提供了一个干净、简单的界面。由于 Apache Spark 是一个相当简单的产品,因此学习曲线很短。

Apache Hadoop 要复杂得多。参与的难度将取决于开发人员如何安装和配置 Apache Hadoop 以及开发人员选择包含哪些软件包。无论如何,即使开箱即用,Apache Hadoop 的学习曲线也更为显著。

8、安全性和容错性

当作为独立产品安装时,Apache Spark 的开箱即用安全性和容错功能少于 Apache Hadoop。但是,Apache Spark 可以访问许多与 Apache Hadoop 相同的安全实用程序,例如 Kerberos 身份验证——它们只需要安装和配置即可。

Apache Hadoop 具有更广泛的本机安全模型,并且在设计上具有广泛的容错性。与 Apache Spark 一样,它的安全性可以通过其他 Apache 实用程序进一步提高。

9、编程语言

Apache Spark 支持 Scala、Java、SQL、Python、R、C# 和 F#。它最初是在 Scala 中开发的。Apache Spark 支持数据科学家使用的几乎所有流行语言。

Apache Hadoop 是用 Java 编写的,部分是用 C 编写的。Apache Hadoop 实用程序支持其他语言,使其适合所有技能的数据科学家。

10、在 Apache Spark 与 Hadoop 之间进行选择

如果您是主要从事机器学习算法和大规模数据处理的数据科学家,请选择 Apache Spark。

Apache Spark:

(1)在没有 Apache Hadoop 的情况下作为独立实用程序运行。

(2)提供分布式任务调度、I/O功能和调度。

(3)支持多种语言,包括 Java、Python 和 Scala。

(4)提供隐式数据并行性和容错性。

如果您是需要大量数据科学实用程序来存储和处理大数据的数据科学家,请选择 Apache Hadoop。

Apache Hadoop:

(1)为大数据的存储和处理提供广泛的框架。

(2)提供了一系列令人难以置信的软件包,包括 Apache Spark。

(3)建立在分布式、可扩展和可移植的文件系统之上。

(4)利用其他应用程序进行数据仓库、机器学习和并行处理。

猎聘大数据研究院发布了《2022未来人才就业趋势报告》

从排名来看,2022年1-4月各行业中高端人才平均年薪来看,人工智能行业中高端人才平均年薪最高,为31.04万元;金融行业中高端人才以27.69万元的平均年薪位居第二;通信、大数据行业中高端人才平均年薪分别为27.51万元、25.23万元,位列第三、第四;IT/互联网行业中高端人才平均年薪23.02万元,位列第七。

图表来源:《2022未来人才就业趋势报告》

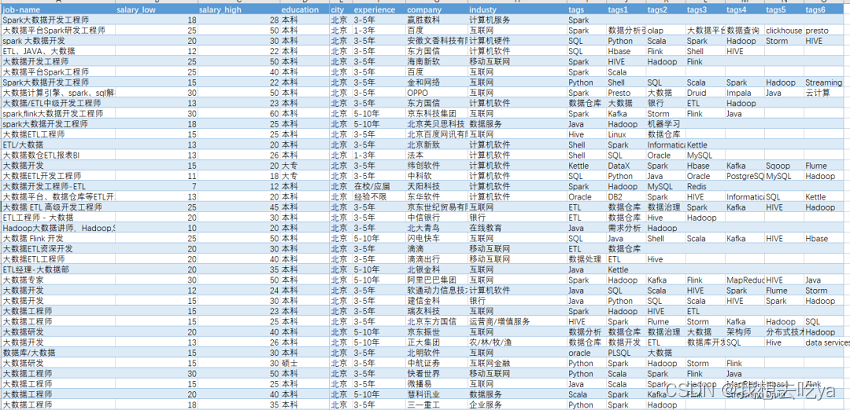

如果你觉得很高,被平均了这样?那么打开Boss直聘,搜大数据工程师:

我们来做下数据分析:

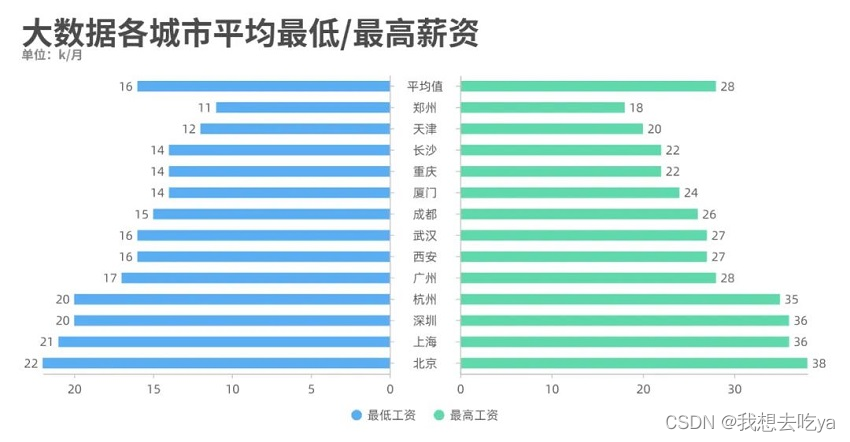

薪资那一列都有一个最低薪资和最高薪资,我们通过不同城市来对比分析一下,发现北京的工资水平最高,最低为22k,最高为38k。

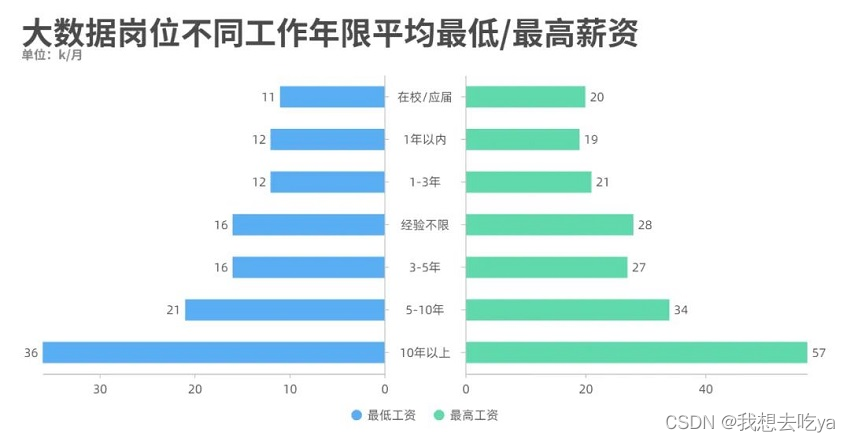

工作年限也是一个制约工资水平的很大因素,从图中可以看出,即使是刚毕业,也能达到一个11-20k的薪资范围。

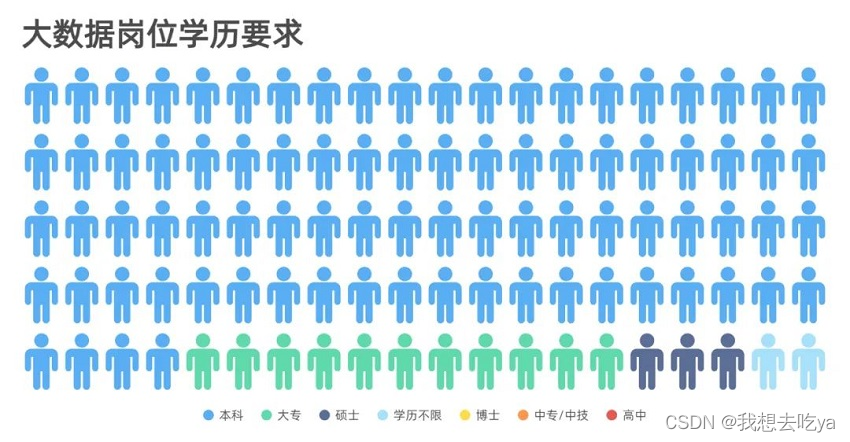

而学历要求来说,大部分为本科,其次为大专和硕士,其他比较少,以至于在图中并没有显示出来。

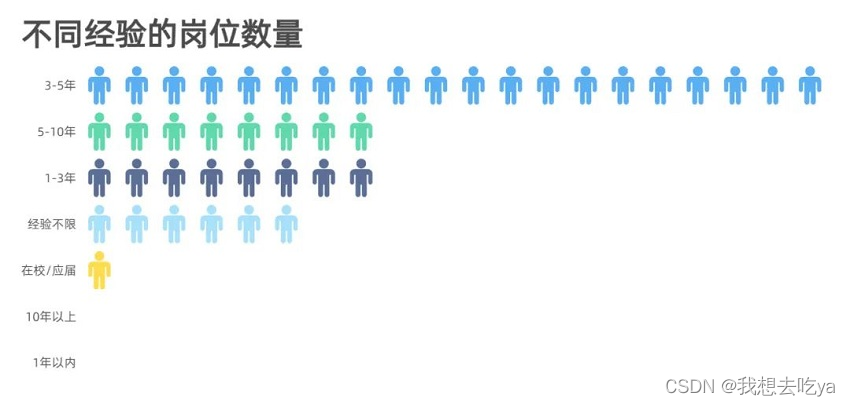

企业对不同岗位的要求以3-5年的居多,企业当然是需要有一定工作经验的员工,但是在实际招聘中,如果你有项目经验,且理论知识没问题,企业也会放宽条件。

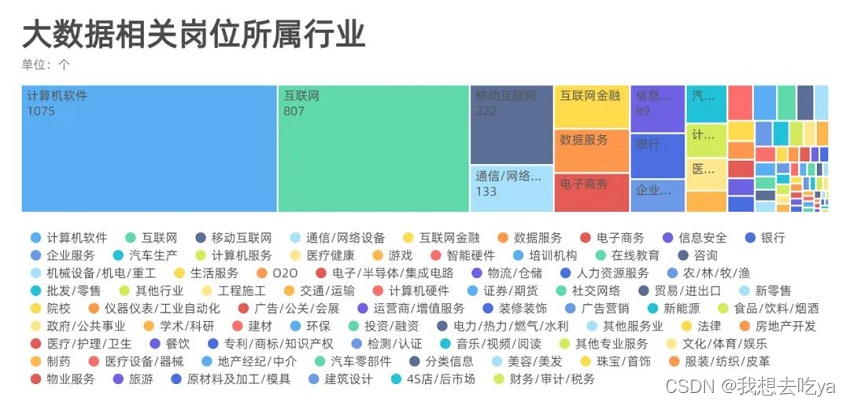

分析不同行业, 我们发现,大数据岗位需求分布在各行各业,主要还是在计算机软件和互联网最多,也有可能是这个招聘软件决定的,毕竟Boss直聘还是以互联网行业为主。

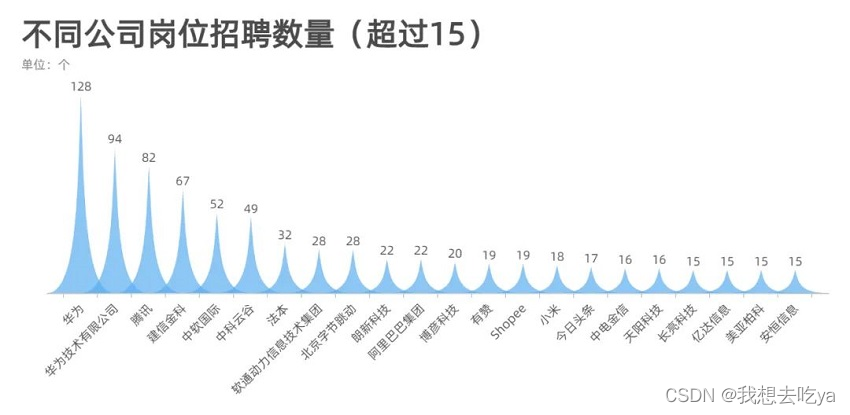

来看看哪些公司在招聘大数据相关岗位,从这个超过15的数量来看,华为,腾讯,阿里,字节,这些大厂对这个岗位的需求量还是很大的。

那么这些岗位都需要什么技能呢?Spark,Hadoop,数据仓库,Python,SQL,Mapreduce,Hbase等等

根据国内的发展形势,大数据未来的发展前景会非常好。自 2018 年企业纷纷开始数字化转型,一二线城市对大数据领域的人才需求非常强烈,未来几年,三四线城市的人才需求也会大增。

在大数据领域,国内发展的比较晚,从 2016 年开始,仅有 200 多所大学开设了大数据相关的专业,也就是说 2020 年第一批毕业生才刚刚步入社会,我国市场环境处于急需大数据人才但人才不足的阶段,所以未来大数据领域会有很多的就业机遇。

薪资高、缺口大,自然成为职场人的“薪”选择!

任何学习过程都需要一个科学合理的学习路线,才能够有条不紊的完成我们的学习目标。Python+大数据所需学习的内容纷繁复杂,难度较大,为大家整理了一个全面的Python+大数据学习路线图,帮大家理清思路,攻破难关!

Python+大数据学习路线图详细介绍

第一阶段 大数据开发入门

学前导读:从传统关系型数据库入手,掌握数据迁移工具、BI数据可视化工具、SQL,对后续学习打下坚实基础。

1.大数据数据开发基础MySQL8.0从入门到精通

MySQL是整个IT基础课程,SQL贯穿整个IT人生,俗话说,SQL写的好,工作随便找。本课程从零到高阶全面讲解MySQL8.0,学习本课程之后可以具备基本开发所需的SQL水平。

2022最新MySQL知识精讲+mysql实战案例_零基础mysql数据库入门到高级全套教程

第二阶段 大数据核心基础

学前导读:学习Linux、Hadoop、Hive,掌握大数据基础技术。

2022版大数据Hadoop入门教程

Hadoop离线是大数据生态圈的核心与基石,是整个大数据开发的入门,是为后期的Spark、Flink打下坚实基础的课程。掌握课程三部分内容:Linux、Hadoop、Hive,就可以独立的基于数据仓库实现离线数据分析的可视化报表开发。

2022最新大数据Hadoop入门视频教程,最适合零基础自学的大数据Hadoop教程

第三阶段 千亿级数仓技术

学前导读:本阶段课程以真实项目为驱动,学习离线数仓技术。

数据离线数据仓库,企业级在线教育项目实战(Hive数仓项目完整流程)

本课程会、建立集团数据仓库,统一集团数据中心,把分散的业务数据集中存储和处理 ;目从需求调研、设计、版本控制、研发、测试到落地上线,涵盖了项目的完整工序 ;掘分析海量用户行为数据,定制多维数据集合,形成数据集市,供各个场景主题使用。

大数据项目实战教程_大数据企业级离线数据仓库,在线教育项目实战(Hive数仓项目完整流程)

第四阶段 PB内存计算

学前导读:Spark官方已经在自己首页中将Python作为第一语言,在3.2版本的更新中,高亮提示内置捆绑Pandas;课程完全顺应技术社区和招聘岗位需求的趋势,全网首家加入Python on Spark的内容。

1.python入门到精通(19天全)

python基础学习课程,从搭建环境。判断语句,再到基础的数据类型,之后对函数进行学习掌握,熟悉文件操作,初步构建面向对象的编程思想,最后以一个案例带领同学进入python的编程殿堂。

全套Python教程_Python基础入门视频教程,零基础小白自学Python必备教程

2.python编程进阶从零到搭建网站

学完本课程会掌握Python高级语法、多任务编程以及网络编程。

Python高级语法进阶教程_python多任务及网络编程,从零搭建网站全套教程

3.spark3.2从基础到精通

Spark是大数据体系的明星产品,是一款高性能的分布式内存迭代计算框架,可以处理海量规模的数据。本课程基于Python语言学习Spark3.2开发,课程的讲解注重理论联系实际,高效快捷,深入浅出,让初学者也能快速掌握。让有经验的工程师也能有所收获。

Spark全套视频教程,大数据spark3.2从基础到精通,全网首套基于Python语言的spark教程

4.大数据Hive+Spark离线数仓工业项目实战

通过大数据技术架构,解决工业物联网制造行业的数据存储和分析、可视化、个性化推荐问题。一站制造项目主要基于Hive数仓分层来存储各个业务指标数据,基于sparkSQL做数据分析。核心业务涉及运营商、呼叫中心、工单、油站、仓储物料。

572

572

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?