1、xgboost的超参数是对所有树起作用吗

在XGBoost中,超参数主要分为两类:一类是用于控制整个模型的全局超参数,另一类是用于控制单棵树的局部超参数。全局超参数对所有树起作用,而局部超参数则只影响单棵树的构建。

全局超参数

以下是一些全局超参数的例子,它们对所有树都起作用:

- n_estimators (树的数量):设置要构建的树的总数。

- learning_rate (学习率):设置每棵树对最终预测的贡献,相当于梯度下降中的步长。

- max_depth (树的最大深度):设置每棵树的最大深度,控制树的复杂度。

- min_child_weight (最小子节点权重):设置子节点分裂时的最小权重和,用于控制树的生长。

- gamma (最小分割增益):设置分裂所需的最小损失函数减少量,用于控制树的生长。

- subsample:设置用于训练每棵树的样本比例。

- colsample_bytree 和 colsample_bylevel:分别设置每棵树和每层树的特征比例。

局部超参数

局部超参数主要控制单棵树的构建过程,例如:

- max_delta_step:设置在最大梯度方向上可以采取的最大步骤。

- lambda (正则化参数):L2正则化项,用于控制叶子节点输出的平方和。

- alpha (正则化参数):L1正则化项,用于控制叶子节点输出的绝对值和。

2、最小损失函数减少量指什么

在XGBoost算法中,最小损失函数减少量(通常由超参数 gamma 控制)是一个用于正则化决策树的参数,它指定了在树的节点分裂时,损失函数必须减少的最小值。这个参数的作用是防止模型在不重要的分裂上过度拟合,从而提高模型的泛化能力。

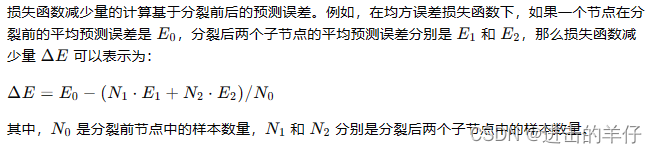

损失函数减少量的计算

在XGBoost中,损失函数通常用于衡量模型预测值与真实值之间的差异。对于回归问题,常用的损失函数是均方误差(MSE);对于分类问题,则可能是对数损失(log loss)或自定义的损失函数。

gamma 参数的作用

gamma 参数(最小分割增益)要求每个分裂后的损失函数减少量必须大于或等于这个设定的值。如果一个潜在的分裂不能达到这个减少量,那么这个分裂就不会执行,节点将保持不变。

这个参数的设置对模型的性能有很大影响:

- 较低的

gamma值允许更多的分裂,可能导致模型更复杂,容易过拟合。 - 较高的

gamma值限制了分裂的数量,使模型更简单,减少过拟合的风险,但可能使模型欠拟合,特别是当数据特征复杂时。

3、XGBoost模型特征重要性指标

-

Feature Weight (权重):

- 描述:这个指标表示特征在所有决策树中作为分裂节点的总次数。

- 意义:如果一个特征的权重高,说明它在构建模型时被频繁使用,可能是一个对模型预测能力有重要影响的特征。

-

Feature Gain (增益):

- 描述:这个指标衡量的是特征在分裂时带来的信息增益,即通过该特征进行节点分裂所减少的损失函数值。

- 意义:增益高的属性在分割数据时对模型性能的提升贡献大,因此是重要的特征。

-

Feature Coverage (覆盖):

- 描述:表示在所有树中,该特征作为分裂点时影响的样本权重之和。

- 意义:覆盖高的属性意味着它影响的数据样本多,即使每次分裂带来的增益可能不是最大的。

-

Total Gain (总增益):

- 描述:一个特征在所有树中作为分裂点时所带来的增益总和。

- 意义:反映了该特征在整个模型中对提升模型性能的累积贡献。

-

Average Gain (平均增益):

- 描述:是总增益除以该特征作为分裂点的次数,得到的特征每次分裂的平均增益。

- 意义:提供了特征每次使用时的平均贡献,有助于平滑由于分裂次数不同而引起的增益差异。

XGBoost通过内置的函数可以方便地获取这些特征重要性指标:

import xgboost as xgb

import matplotlib.pyplot as plt

# 假设 model 是已经训练好的 XGBoost 模型

xgb.plot_importance(model, importance_type='weight', title='Feature Importance (Weight)', grid=False, show_values=True)

plt.show()

# 同样的方法可以用于其他类型的指标,如 gain、coverage 等4、Gain、Total Gain、Average Gain之间的关系

Average Gain 可以通过 Total Gain 除以特征作为分裂点的总次数(即Gain的频次)来计算:

其中,Number of Splits 是特征作为分裂点的总次数,也就是Gain的权重(Weight)

5、如果某个特征的weight较大,但gain较小,反映出什么问题

-

普遍但不关键:该特征可能在许多决策树中作为分裂点出现,但它每次分裂带来的增益不高。这可能意味着这个特征有助于模型在一定程度上区分数据,但不是决定性的区分特征。

-

噪声特征:尽管特征在树中被频繁使用,但如果增益较小,可能表明该特征在数据中引入了噪声,或者其对模型性能的提升作用有限。

-

数据不平衡:在某些情况下,如果数据集存在类别不平衡问题,即使特征的增益不高,它也可能因为与少数类别相关而被频繁使用。

-

模型复杂度:如果模型的树构建得过于复杂,可能会导致一些不重要的特征也被频繁地作为分裂点,但每次分裂带来的增益较低。

-

正则化的影响:XGBoost的正则化参数可能会影响增益的计算,特别是如果正则化参数设置得较高,可能会导致增益降低。

-

特征间的相关性:该特征可能与其他重要特征相关,因此即使它单独的增益不高,也可能在组合中起到了一定的作用。

-

数据的分布特性:特征的分布特性可能使得它在树的多个节点中被用作分裂点,但由于其分布的离散性不高或信息量不大,导致增益较小。

-

模型的早停策略:如果使用了早停策略,可能导致一些树没有完全生长,使得本应获得更高增益的特征未能充分展现其价值。

-

超参数设置:XGBoost的超参数(如最大深度、最小分割增益等)设置可能限制了树的生长,从而影响了增益的计算。

6、当一个特征的weight(权重)较大但gain(增益)较小时,可以间接反映出该特征值及其在数据中表现情况

-

数据分布:如果特征的权重大,可能意味着该特征在数据集中分布广泛,即使每次分裂带来的增益不高,它也可能因为适用于多种不同的数据情境而被频繁使用。

-

多态性:该特征可能在数据中具有多种不同的表现形式或状态,这使得它在多个决策树的多个节点中作为分裂点,但由于其对模型性能提升的平均贡献较小,所以增益不高。

-

相关性:特征可能与其他特征存在一定的相关性,它可能在某些情况下作为其他特征的代理而被使用,尤其是在其他特征不可用时。

-

噪声数据:如果一个特征在数据中引入了噪声,它可能会在树的构建中被频繁使用,但由于它引入的噪声,每次分裂带来的增益可能并不显著。

-

异常值:该特征可能包含异常值或离群点,这些在树的构建中可能会被考虑进去,但由于它们并不代表数据的一般趋势,因此不会带来很高的增益。

-

非线性关系:特征可能与目标变量之间存在复杂的非线性关系,这种关系可能难以通过决策树模型的简单分裂来捕捉,因此增益较小。

-

数据量:如果特征对应的数据量很大,即使它对模型性能的提升不大,也可能因为频繁出现在大量样本中而被模型多次使用。

-

类别特征:对于类别特征,即使某些类别的样本数量不多,但如果这个特征在数据中以多种类别出现,它也可能会有较高的权重。

7、如果某个特征的gain较大,但weight较小,能反映出什么问题

-

关键分裂点:该特征可能在模型的决策树中不是特别频繁地作为分裂点,但当它被使用时,每次分裂带来的增益都很高。这表明它在模型的某些关键节点上对性能的提升有显著影响。

-

重要但不普遍:该特征可能对模型的预测能力有重要影响,但它可能只在特定情况下或对特定数据子集有效,因此它在整个模型中作为分裂点的次数较少。

-

数据稀疏:可能存在数据稀疏的问题,即该特征的有效信息只出现在数据集的一小部分中,导致它不能在更多的树或节点中被使用。

-

过拟合风险:如果一个特征带来的增益很高,但只在一个或少数几个决策树中被使用,这可能表明该特征对模型有较大的影响,但也可能带来过拟合的风险,特别是如果它与噪声或异常值相关联。

-

特征选择:XGBoost在构建每棵树时,会选择一部分特征进行分裂点的搜索。如果一个特征的增益较大但权重较小,可能是因为它没有在足够多的树中被选中。

-

正则化效果:XGBoost中的正则化参数可能会限制模型对特定特征的依赖,即使这些特征能带来较高的增益。

-

特征间的相互作用:该特征可能与其他特征有复杂的交互作用,它的效果可能只在结合其他特征时才能显现,因此在单独的树中使用次数不多。

-

数据编码或预处理:数据预处理或特征编码的方式可能影响了特征在模型中的表现,如类别特征的错误编码可能导致其增益计算不准确。

-

模型的早停策略:如果模型使用了早停策略,可能导致一些树没有完全生长到最大深度,这可能会影响增益和权重的评估。

-

超参数设置:XGBoost的超参数设置,如最大深度、最小分割增益等,可能限制了该特征在树中的使用次数,即使它在某些分裂中能带来较高的增益。

8、信息增益(gain)、信息增益率、基尼指数、xgboost分裂增益都是什么?

答:

熵(Entropy):是衡量数据集不确定性的指标,其计算公式为:

信息增益(gain):

信息增益率:

基尼指数(gini):

xgboost分裂增益:

一个节点被分裂成左子树和右子树,我们可以计算分裂前后的目标函数变化,分裂增益(Gain)计算公式如下:

持续更新中···

254

254

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?