目录

1、线性回归(Linear Regression)简介

线性:两个变量之间的关系是一次函数关系的——图象是直线,叫做线性。

线性是指广义的线性,也就是数据与数据之间的关系。

机器学习最常见的场景是监督学习:给定一些数据,使用计算机学习到一种模式,然后用它来预测新的数据。一个简单的监督学习任务可以表示为,给定N个两两数据对 ,使用某种机器学习模型对其进行建模,得到一个模型(model),其中给定的数据对为样本(sample),x为特征 (feature),y为真实值 (label)。

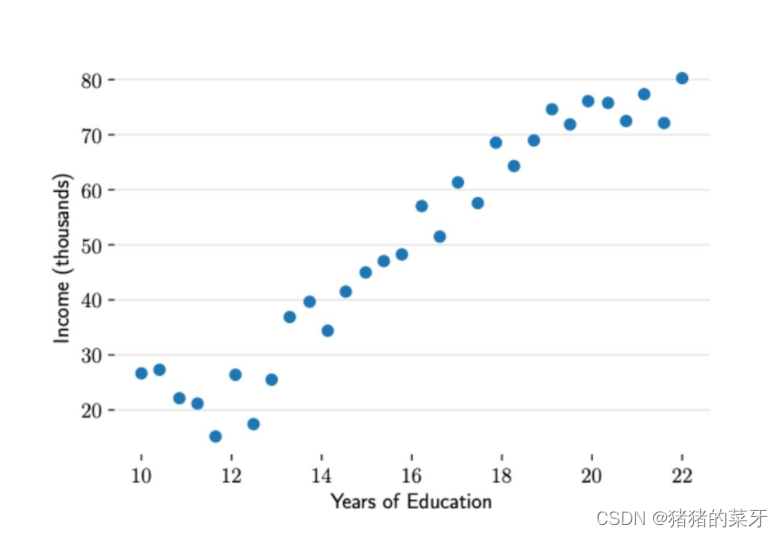

上图展示了收入数据集展示了受教育程度与年度收入之间的数据。根据我们的社会经验和图中的数据分布,我们觉得能使用一个直线来描述“收入会随着受教育时间的增多而增多”的现象。所以针对这个数据集,可以使用一个简单的机器学习模型———一元线性回归。

一元线性回归模型:

在对数据集进行建模时,我们可以对参数m 和 b 取不同值来构建不同的直线,这样就形成了一个参数家族。给定N个数据对(x,y) ,寻找最佳参数 m 和 b ,使模型可以更好的拟合这些数据。机器学习用损失函数(loss function)来衡量参数取值的 “好坏”,损失函数又称为代价函数(cost function),它计算了模型预测值 和真实值 y 之间的差异程度,损失函数越大,模型越差,越不能拟合数据。用

表示损失函数。

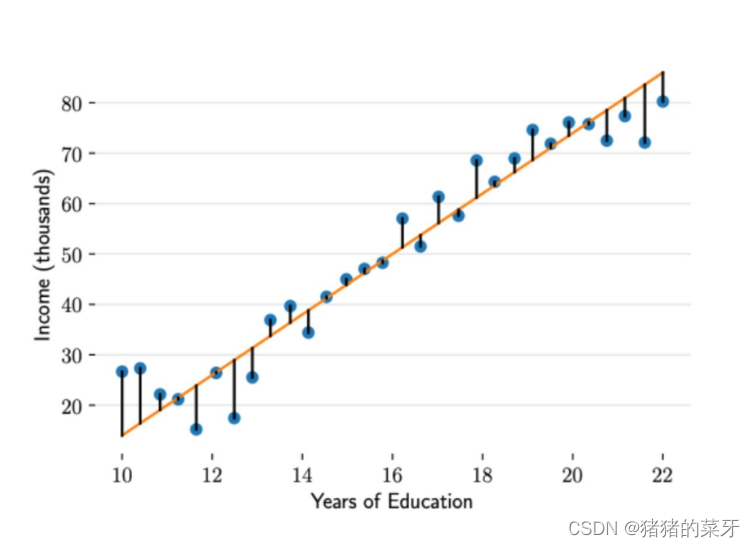

上图展示了收入数据集上预测值与真实值的误差。

数据集上的所有误差求平方和取平均得损失:

即

(1)不能直接用真实值与预测值作差再求和的方法计算损失。因为预测值可能大于真实值,也可能小于真实值(即上图中蓝灰色的预测点可能在橙色线的上方,也可能在橙色线的下方),所以直接作差再求和可导致正负值抵消,呈现出总体损失很小的假象。

(2)在(1)的基础上加绝对值也不是一个全面的解决方法,因为加上绝对值可能存在函数某些点不可导的情况。

2、线性回归从零开始

从零开始实现整个方法,包括数据流水线、模型、损失函数和小批量随机梯度下降优化器

%matplotlib inline #将图表嵌入到Notebook中

import random

import torch

from d2l import torch as d2l根据带有噪声的线性模型构造一个人造数据集。使用线性模型参数 、b = 4.2 和噪声项

生成数据集及其标签:

y = Xw + b +

"""训练样本"""

def synthetic_data(w, b, num_examples): #synthetic人造的 num_examples样本数

"""生成 y = xw + b + 噪声"""

x = torch.normal(0, 1, (num_examples, len(w)))

"""表示生成均值为0、方差为1的随机数 行数是样本 列度是w"""

y = torch.matmul(x, w) + b

"""matmul表示矩阵相乘 """

y += torch.normal(0, 0.01, y.shape) #随机噪音

"""表示生成均值为0、方差为0.01的随机数 列度是w 行数是样本 形状与y的形状一样"""

return x, y.reshape((-1, 1))

"""reshape -1表示自动计算 转换成1列 行数需计算"""

true_w = torch.tensor([2, -3.4]) #真实的w

true_b = 4.2 #真实的b

features, labels = synthetic_data(true_w, true_b, 1000)

"""生成特征以及标注"""

"""对训练样本进行展示"""

print('features:', features[0], '\nlabel:', labels[0])

d2l.set_figsize()

"""set_figsize()定义在 d2l 包里,作图前只需要调用d2l.set_figsize()

即可打印矢量图并设置图的尺寸"""

d2l.plt.scatter(features[:,1].detach().numpy(), labels.detach().numpy(), 1);

"""scatter()绘制散点图"""

定义一个data_iter函数,该函数接受批量大小、特征矩阵和标签向量作为输入,生成大小为batch_size的小批量

def data_iter(batch_size, features, labels):

num_examples = len(features)

indices = list(range(num_examples))

random.shuffle(indices) #shuffle()将序列中的所有元素随机排序

"""打乱下标,以便后面随即访问样本"""

for i in range(0,num_examples,batch_size):

"""从0到num_examples每隔batch_size选取一个"""

batch_indices = torch.tensor(indices[i:min(i+batch_size,num_examples)])

yield features[batch_indices], labels[batch_indices]

"""yield就是return返回一个值,并记住返回值的位置,下次迭代从此位置后开始。

return返回函数会终止,yield不会"""

batch_size = 10

for x,y in data_iter(batch_size,features,labels):

print(x,'\n',y)

break"""定义初始化参数模型"""

w = torch.normal(0,0.01,size=(2,1),requires_grad=True)

"""requires_grad=True 需要梯度计算"""

b = torch.zeros(1,requires_grad=True)

"""偏差"""

"""定义模型"""

def linreg(x,w,b):

"""线性回归模型"""

return torch.matmul(x,w)+b

"""定义损失函数"""

def squared_loss(y_hat,y):

"""均方损失"""

return (y_hat-y.reshape(y_hat.shape))**2/2

"""定义优化算法"""

def sgd(params,lr,batch_size): # params参数 lr学习率

"""小批量随机梯度下降"""

with torch.no_grad(): #更新时不进行梯度计算

for param in params:

param -= lr * param.grad / batch_size

"""即theta=theta-lr*grad 此时求了一下均值:除以batch_size"""

param.grad.zero_() #梯度清零训练过程

"""训练过程"""

lr = 0.03

num_epochs = 3 #模型跑三遍

net = linreg

loss = squared_loss

for epoch in range(num_epochs): #扫一边模型

for x,y in data_iter(batch_size,features,labels):

l = loss(net(x,w,b),y) #小批量x和y的损失

l.sum().backward() #求梯度

sgd([w,b],lr,batch_size) #使用参数的梯度更新参数

with torch.no_grad():

train_l = loss(net(features,w,b),labels)

print(f'epoch{epoch+1},loss{float(train_l.mean()):f}')比较真实参数和通过训练学到的参数来评估训练的成功程度

"""真实的w和b 训练的w和b之间的误差"""

print(f'w的估计误差:{true_w - w.reshape(true_w.shape)}')

print(f'b的估计误差:{true_b - b}')3、线性回归简洁实现

通过使用深度学习框架来简洁实现线性回归模型生成数据集

import numpy as np

import torch

from torch.utils import data

from d2l import torch as d2l

"""和之前手动一样,构造一个真实的w和b,通过人工数据合成的函数,生成特征和标签"""

true_w = torch.tensor([2,-3.4])

true_b = 4.2

features, labels = d2l.synthetic_data(true_w, true_b, 1000)

"""人工数据合成函数"""参考博文:线性回归简洁实现

4284

4284

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?