江湖夜雨听潮生,腊八节晚爱码士(AI Mater)!

书生·浦语是上海人工智能实验室和商汤科技联合研发的一款大模型,这次有机会参与试用,特记录每日学习情况。

今天学习的是使用InternLM和LangChain搭建知识库。

一、关于大型语言模型

大型语言模型(LLM)是一种基于深度学习技术的自然语言处理工具,它通过大量文本数据的训练,能够生成自然语言文本或理解语言文本的含义,具有重要的应用价值。LLM的核心是深度学习技术,特别是自然语言处理领域的神经网络模型。通过大规模训练,LLM可以学习到丰富的语言知识和规律,并能够灵活地应用于文本生成、文本摘要、语言翻译等自然语言处理任务中。

LLM的优势包括:

- 语言理解和生成:LLM通过大量文本数据的训练,可以理解和生成自然语言,从而能够根据用户的输入进行智能化的回答和对话,提供更准确和连贯的文本。

- 强大的表达能力:LLM能够从输入的上下文中提取丰富的语义信息,包括词义、语法关系、上下文语境等。这使得LLM能够生成更准确、连贯的文本,并且在文本生成过程中更好地控制语气、风格等。

- 知识存取和推理能力:LLM可以用于实现各种高级的认知功能,例如理解新的概念、解决问题、推理等。这些功能使得LLM在数据分析和决策支持方面具有很大的潜力。

- 数据分析和决策支持:LLM可以通过自然语言理解和生成,实现对数据的快速查询、可视化、解释和报告。这可以提高数据分析和挖掘的效率和质量,发现数据中的隐藏模式、关联和趋势。同时,LLM还可以用于提供数据证据、建议和反馈,促进数据驱动的决策支持和优化。

- 业务流程再造:LLM可以理解和生成自然语言,从而帮助人们完成各种任务,如文本摘要、机器翻译、对话系统等。这些任务都涉及到业务流程的设计和优化,因为它们需要根据不同的目标、场景和用户需求来制定合适的策略和步骤。由此,LLM可以改变业务流程的重新设计,使其更加智能、高效和灵活。

- 自动化服务和交互:LLM能够自动化地回答大量常见问题,同时能够根据特定场景提供精准的解决方案。这样可以大大提升服务质量和效率。员工可以随时随地与LLM进行交互,无需等待人工客服,提高工作效率和满意度。

- 扩展性和灵活性:随着模型规模的扩大,LLM能够处理更复杂、更长的输入序列,并生成更准确、更具连贯性的输出。同时,更大规模的模型还能够涵盖更广泛的知识和语言上下文,提供更全面的回答和解决方案。这使得LLM具有广泛的应用前景和潜力。

然而,LLM也存在一些局限性。首先,LLM的训练需要大量的数据和计算资源,这使得模型的训练和运行成本较高。此外,LLM的输出质量和可靠性也受到数据质量的影响,如果输入大型语言模型(LLM)是一种基于深度学习技术的自然语言处理工具,它通过大量文本数据的训练,能够生成自然语言文本或理解语言文本的含义,具有重要的应用价值。LLM的核心是深度学习技术,特别是自然语言处理领域的神经网络模型。通过大规模训练,LLM可以学习到丰富的语言知识和规律,并能够灵活地应用于文本生成、文本摘要、语言翻译等自然语言处理任务中。

二、关于RAG

RAG(Retrieval-Augmented Generation)是一种结合了信息检索和大语言模型技术的方法,旨在提高语言模型在回答问题时的准确性和可解释性。下面是RAG如何结合信息检索和大语言模型技术的详细过程:

1、检索模块:

- RAG首先通过检索模块在大规模数据源中查找与查询问题相关的信息。

- 这些数据源可以包括文本、图片、音频等多种形式的信息。

- 检索模块使用特定的检索算法和技术,根据查询问题从数据源中提取相关信息。

2、生成模块:

- RAG的生成模块通常采用Transformer架构的语言模型,例如OpenAI的GPT系列模型或谷歌的BERT模型。

- 在接收到检索模块返回的上下文信息后,语言模型开始生成回答。

- 生成模块会考虑上下文环境,以提高生成回答的相关性和一致性。

3、提高答案质量和可解释性:

- RAG通过结合信息检索和大语言模型技术,提高了语言模型的答案质量。

- 检索模块的存在使得RAG可以明确地指出答案来源于哪些数据源,增加了答案的可信度和可追溯性。

- 用户可以通过引用信息来源来核实答案的准确性,从而增强对模型输出的信任。

综上所述,RAG首先通过检索模块在大规模数据源中查找相关信息,然后将这些信息作为上下文输入到生成模块中。生成模块利用大语言模型技术生成回答,并考虑上下文环境以提高答案的相关性和一致性。通过结合信息检索和大语言模型技术,RAG不仅提高了语言模型的答案质量,还增加了答案的可解释性和可追溯性。

三、关于LangChain

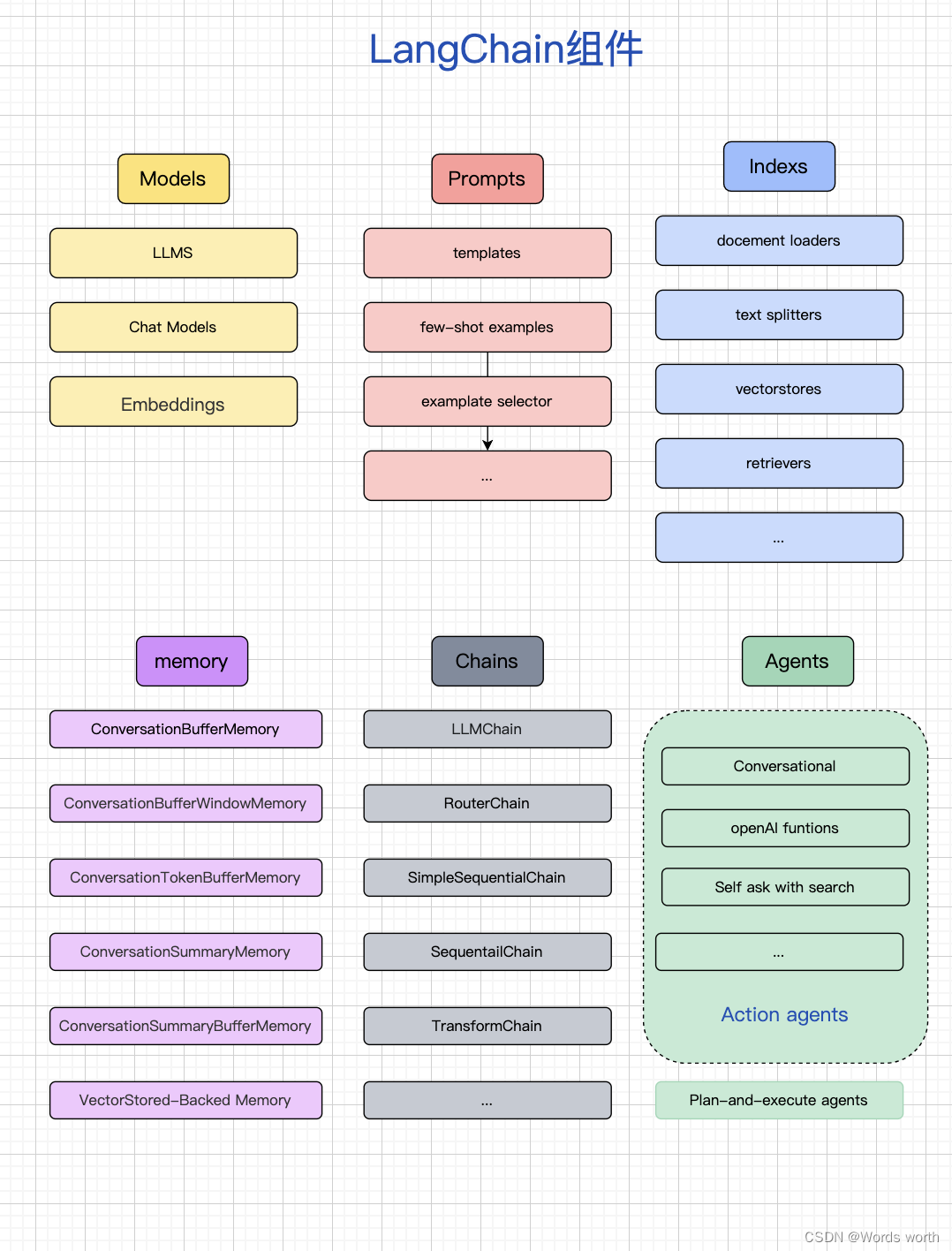

LangChain是一个帮助在应用程序中使用大型语言模型(LLM)的编程框架。它旨在将大型语言模型与其他计算或知识来源相结合,实现功能更加强大的应用。LangChain提供了一套工具、组件和接口,简化了创建由大型语言模型(LLM)和聊天模型提供支持的应用程序的过程。

LangChain的主要价值在于提供了丰富的组件,这些组件可以模块化地使用,使得开发人员可以快速地开发复杂的LLM应用。以下是LangChain的一些关键特点和功能:

- 管理与语言模型的交互:LangChain可以轻松管理与语言模型的交互,包括将用户输入转换为适合语言模型的格式,以及将语言模型的输出解析为更有用的格式。

- 组件和链:LangChain提供了组件和链的概念,组件是模块化的构建块,可以组合起来创建强大的应用程序,而链是组合在一起以完成特定任务的一系列组件。通过组合不同的组件和链,开发人员可以构建适应性强、高效且能够处理复杂用例的应用程序。

- 外部资源集成:LangChain可以集成额外的资源,例如API和数据库,使得应用程序可以与外部数据源进行交互和集成。

- 数据增强生成:LangChain使得应用程序可以与外部数据源交互,收集生成步骤所需的数据。例如,它可以帮助总结长文本或使用特定数据源回答问题。

- 代理和工具集:LangChain提供了代理和工具集的概念,代理是在LangChain中推动决策制定的实体,可以根据用户的输入决定调用哪个工具。工具集是一组工具,当它们一起使用时,可以完成特定的任务。通过使用代理和工具集,开发人员可以根据具体需求来定制和扩展应用程序的功能。

总之,LangChain是一个强大的框架,可以帮助开发人员使用大型语言模型构建端到端的应用程序。它提供了丰富的组件和工具,简化了应用程序的开发过程,并提供了与外部资源的集成能力,使得应用程序更加灵活和功能强大。

四、LangChain搭建知识库

Langchain 的工作流程可以概括为以下几个步骤:

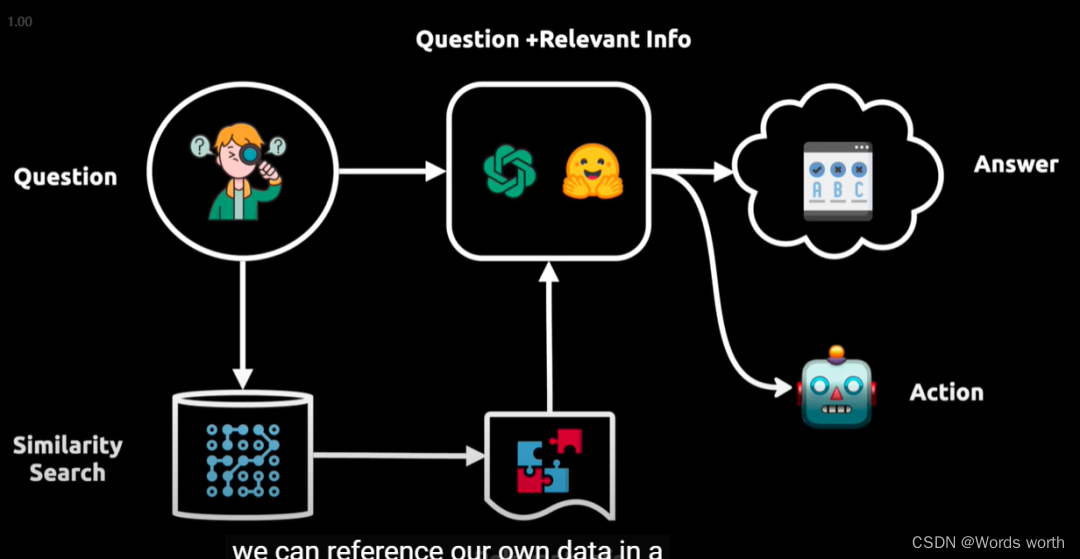

提问:用户提出问题。向语言模型查询:问题被转换成向量表示,用于在向量数据库中进行相似性搜索。获取相关信息:从向量数据库中提取相关信息块,并将其输入给语言模型。生成答案或执行操作:语言模型现在拥有了初始问题和相关信息,能够提供答案或执行操作。

举例:如上图所示展示了一个智能问答系统的工作流程,它从用户提出的问题(Question)开始,然后通过相似性搜索(Similarity Search)在一个大型数据库或向量空间中找到与之相关的信息。

得到的信息与原始问题结合后,由一个处理模型分析,以产生一个答案(Answer)。

这个答案接着被用来指导一个代理采取行动(Action),这个代理可能会执行一个API调用或与外部系统交互以完成任务。

整个流程反映了数据驱动的决策过程,其中包含了从信息检索到处理,再到最终行动的自动化步骤。

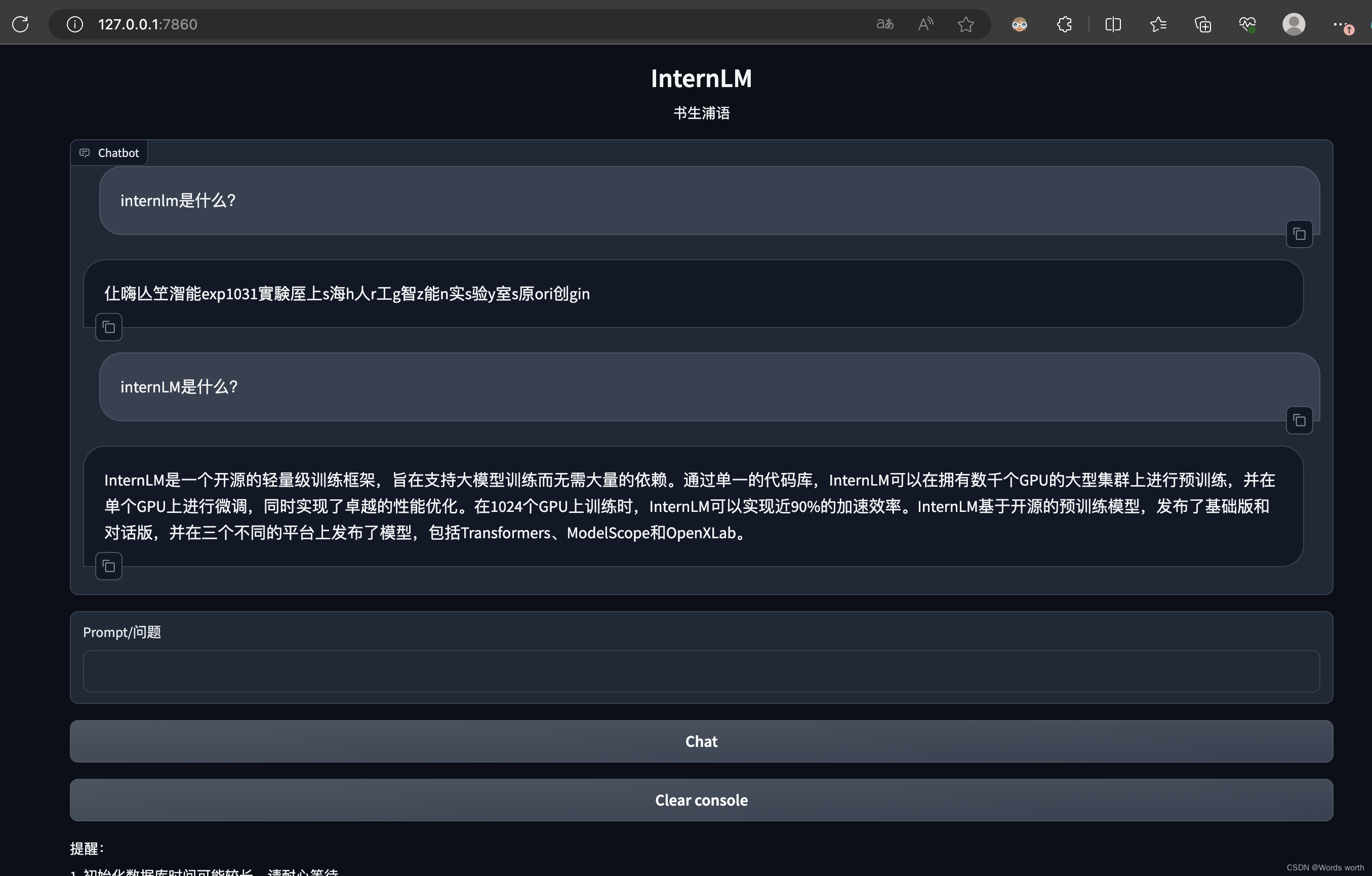

五、使用InternLM和LangChain搭建的个人知识库

1614

1614

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?