文章目录

论文标题:使用知识库嵌入改进知识图的多跳问答

论文链接:https://aclanthology.org/2020.acl-main.412/

摘要

知识图谱(KG)是由实体作为节点、实体之间的关系作为类型边缘组成的多关系图。在知识图谱上进行问答任务(KGQA)的目标是回答以自然语言提出的查询。多跳 KGQA 需要对知识图谱中的多个边缘进行推理,以便找到正确的答案。知识图谱(KG)通常不完整,有许多缺失的链接,这为KG问答(KGQA)带来了额外的挑战,特别是对于多跳KGQA。最近关于多跳KGQA的研究已经尝试使用相关的外部文本来处理KG的稀疏性,但这并不总是那么容易获得。在另一条研究路线上,已经提出了KG嵌入方法来通过执行缺失链接预测来减少KG的稀疏性。这类KG嵌入方法虽然高度相关,但尚未被用于多跳KGQA。本文填补了这一空白,并提出了EmbedKGQA。EmbedKGQA在稀疏KG上进行多跳KGQA特别有效。EmbedKGQA还放宽了从预指定邻域中选择答案的要求,这是先前多跳KGQA方法强制执行的一个次优约束。通过在多个基准数据集上进行大量实验,我们证明了EmbedKGQA相对于其他最先进的基线方法的有效性。

1 介绍

知识图谱(KG)是包含数百万实体(例如,圣何塞、加利福尼亚等)和它们之间关系(例如,圣何塞位于加利福尼亚州内)的多关系图。示例包括一些大型知识图谱(KG),如维基数据(Google,2013年)、DBPedia(Lehmann等人,2015年)、Yago(Suchanek等人,2007年)和NELL(Mitchell等人,2018年)。基于知识图谱(KG)的问题回答(KGQA)在近年来已成为一个重要的研究领域(Zhang等人,2018年;Sun等人,2019a年)。在KGQA系统中,给定一个自然语言(NL)问题和一个KG,通过分析问题与KG的上下文关系,得出正确的答案。

在多跳KGQA中,系统需要对知识图谱的多个边进行推理以推断正确的答案。知识图谱通常不完整,这为KGQA系统带来了额外的挑战,尤其是在多跳KGQA的情况下。最近的方法已经使用外部文本语料库来处理知识图谱的稀疏性(Sun等,2019a,2018)。例如,(Sun等人,2019a)提出的方法从知识图谱中构建一个与问题相关的子图,然后用支持性文本文档来增强这个子图。接着,图卷积神经网络(Graph CNN,Kipf和Welling,2016)被应用于这个增强的子图,以得到最终的答案。很不幸地,获取和确定相关文本语料库是一项挑战,这限制了这些方法的广泛应用。此外,这些方法还对答案所在的预设邻近范围有限制,使得真实答案往往无法被模型选择。

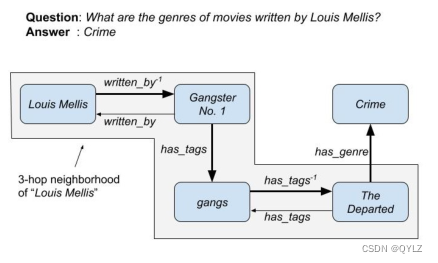

为了说明这些观点,请考虑图1中给出的例子。在这个例子中,Louis Mellis是输入自然语言问题的主实体,而Crime是我们期望模型选择的正确答案。如果在知识图谱中存在genre(Gangster No. 1, Crime)这个边,那么问题就可以比较容易地回答了。然而,由于这个边在知识图谱中缺失,就像许多类似不完整和稀疏的知识图谱一样,KGQA模型必须潜在地在知识图谱上推理一条更长的路径(在图中以粗体标出)。此外,KGQA模型施加了一个3跳的邻域大小限制,这使得真实答案“犯罪”无法触及。

图1:在稀疏和不完整的知识图谱(KG)中进行多跳问答(KGQA)的挑战:在不完整的KG中,缺少边genre(Gangster No. 1, Crime)使得回答输入的自然语言问题变得更加困难,因为KGQA模型可能需要在KG上推理一条更长的路径(用粗线标记的边)。现有基于多跳知识图谱的问题回答方法也施加了启发式邻域限制(图中阴影区域),这通常使得真实答案(例如本例中的犯罪)无法触及。我们提出的EmbedKGQA方法通过在多跳问题回答过程中利用输入知识图谱的嵌入来克服这些限制。有关更多详细信息,请参阅图2和第4节。

在另一条研究路线上,已经有很多工作利用知识图谱嵌入来预测知识图谱中缺失的链接,从而减少知识图谱的稀疏性(Bordes等人,2013;Trouillon等人,2016;Yang等人,2014a;Nickel等人,2011)。知识图谱嵌入方法学习知识图谱中实体和关系的高维嵌入,然后用于链接预测。尽管知识图谱(KG)嵌入方法具有很高的相关性,但它们尚未被用于多跳KG问答(multi-hop KGQA)——在这篇论文中,我们填补了这一空白。特别是,我们提出了一种名为EmbedKGQA的创新系统,该系统利用知识图谱嵌入来执行多跳知识图谱问答。我们在本文中做出了以下贡献:

- 我们提出了一种用于多跳知识图谱问答(KGQA)任务的新方法——嵌入式KGQA(EmbedKGQA)。据我们所知,EmbedKGQA是第一种将知识图谱嵌入用于此任务的方法。尤其在处理稀疏知识图谱的多跳KGQA时,EmbedKGQA表现得非常有效。

- 嵌入式KGQA(EmbedKGQA)放宽了从预设局部邻域中选择答案的要求,这是以前针对此项任务的方法强加的一个不理想的约束。

- 通过在多个真实世界数据集上进行大量实验,我们证明了Embed-KGQA相对于最先进的基线方法的有效性。

我们已经提供了EmbedKGQA的源代码,以鼓励可重复性。

2 相关工作 KGQA

在以往的工作中(李等,2018)使用了TransE, (Bordes等人,2013)嵌入式方法来回答事实性问题。然而,这需要为每个问题标注地面真相关系,并且不适用于多跳问题回答。在另一条研究线索中(Yih等人,2015) 和(Bao等人,2016)提出了提取特定子图来回答问题的方法。方法在(Bordes等人,2014a)中介绍的,为一个头部实体生成的子图被投影到高维空间中,以用于回答问题。记忆网络也被用于学习知识图谱中事实的高维嵌入以进行问答任务(Bordes等人,2015)。像(Bordes等人,2014b)这样的方法在训练过程中学习问题和相应三元组之间的相似函数,并在测试时为问题打分。 (Yang等人,2014b)和(Yang等人,2015)利用基于嵌入的方法将自然语言问题映射到逻辑形式。方法如(戴等,2016;董等,2015;郝等,2017;卢科夫尼科夫等,2017;尹等,2016)利用神经网络学习一个评分函数来对候选答案进行排名。一些工作如(穆罕默德等,2017;图尔和乔伊奇,2016)将每个关系视为一个标签,并将问答任务建模为分类问题。将这些方法扩展到多跳问题回答是具有挑战性的。

最近,有一些研究将文本语料库作为知识来源,除了知识图谱(KG)之外,用于回答关于KG的复杂问题(Sun等,2018,2019a)。这种方法在KG不完整的情况下很有用。然而,这给问答系统带来了另一个级别的复杂性,并且文本语料库可能并不总是可用。

知识图谱补全方法:近年来,使用知识图谱嵌入进行链接预测已经成为一个热门研究领域。一般的框架是为知识图谱中的三元组(头实体,关系,尾实体)定义一个得分函数,并以这种方式约束它们,使得正确三元组的得分高于错误三元组的得分。

RESCAL(Nickel等人,2011年)和DistMult(Yang等人,2015年)学习了一个包含头实体和尾实体向量之间的双线性乘积和关系矩阵的评分函数。ComplEx(Trouillon等人,2016年)在复数空间中表示实体向量和关系矩阵。SimplE(Kazemi和Poole,2018年)和TuckER(Balaˇzevi´c等人,2019年)分别基于Canonical Polyadic(CP)分解(Hitchcock,1927年)和Tucker分解(Tucker,1966年)。

TransE(Bordes等人,2013)将实体嵌入到高维实数空间中,而关系则表示为头部实体和尾部实体之间的平移。另一方面,RotatE(Sun等人,2019b)将在复数空间中投影实体,关系则用复平面上的旋转来表示。

ConvE(Dettmers等人,2018)利用卷积神经网络来学习头实体、尾实体和关系之间的评分函数。InteractE(Vashishth等人,2019)在ConvE的基础上进行了改进,增加了特征交互。

3 背景

在这一部分,我们正式定义了一个知识图谱(KG),然后描述了在不完整的KG上的链接预测任务。接下来,我们介绍KG嵌入,并解释ComplEx嵌入模型。

3.1 知识图谱

给定一组实体E和关系R,知识图谱G是一组三元组K,其中K是E × R × E的子集。一个三元组表示为(h, r, t),其中h, t属于E,分别表示主题和对象实体,r属于R,表示它们之间的关系。

3.2 链接预测

在链接预测中,给定一个不完整的知识图谱,任务是预测哪些未知链接是有效的。KG嵌入模型通过一个评分函数φ来实现这一点,该函数为每个三元组分配一个分数s = φ(h, r, t) ∈ R,以指示三元组是否真实,目的是能够正确地对所有缺失的三元组进行评分。

3.3 知识图谱嵌入

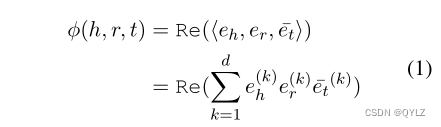

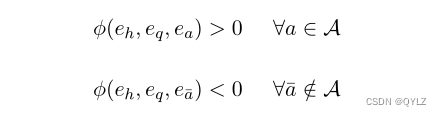

对于每个e∈E和r∈R,知识图嵌入(KGE)模型生成 e e ∈ R d e {\mathbf{e}_{e}} \in {{\mathbb{R}}^{d_e}} ee∈Rde 和 e r ∈ R d r {\mathbf{e}_{r}} \in {{\mathbb{R}}^{d_r}} er∈Rdr,其中ee和er分别是de和dr维向量。每种嵌入方法还具有一个评分函数φ:E×R×E→R,用于为可能的三元组(h,r,t)分配一些分数φ(h,r,t),其中h,t∈E且r∈R。模型的训练方式是这样的:对于每一个正确的三元组(头实体h,关系r,尾实体t)属于知识图谱K,以及每一个不正确的三元组(头实体h’,关系r’,尾实体t’)不属于知识图谱K,模型会给出评分,使得φ(h, r, t)大于0,而φ(h’, r’, t’)小于0。一个评分函数通常是一个关于(eh, er, et)的函数。

3.3.1复杂嵌入

复杂嵌入(ComplEx,Trouillon等人,2016年)是一种张量分解方法,它将在复数空间中对关系和实体进行嵌入。给定h, t属于集合E,r属于实数集R,ComplEx生成

e

h

,

e

r

,

e

t

∈

C

d

{\mathbf{e}_{h},\mathbf{e}_{r},\mathbf{e}_{t}} \in {{\mathbb{C}}^{d}}

eh,er,et∈Cd,并定义一个评分函数:

使得对于所有真实的三元组,φ(h, r, t) > 0,而对于错误的三元组,φ(h, r, t) < 0。Re表示复数的真实部分。

4 嵌入式知识图谱问答:提出的方法

在这一部分,我们首先定义了知识图谱问答(KGQA)的问题,然后描述我们的模型。

4.1 问题陈述

让E和R分别为知识图谱G中所有实体和关系的集合,K是E×R×E中所有可用的知识图谱事实的子集。在KGQA问题中,给定一个自然语言问题q和一个问题中出现的主题实体eh∈E,任务是从E中提取一个实体et,以正确回答问题q。

4.1.1 EmbedKGQA概述

我们在这个设置中工作,数据集中没有细粒度的注释,例如问题类型或精确的逻辑推理步骤。例如,共同演员是starred actor-1和starred actor关系的组合,但我们的模型不需要这个注释。

嵌入式知识图谱问答(EmbedKGQA)使用知识图谱嵌入来回答多跳自然语言问题。首先,它在嵌入空间中学习知识图谱的表示。然后,给定一个问题,它学习问题的嵌入表示。最后,它结合这些嵌入表示来预测答案。

在接下来的部分,我们将介绍EmbedKGQA模型。它由3个模块组成:

- KG嵌入模块为知识图谱中的所有实体创建嵌入向量。

- 问题嵌入模块找到一个问题的嵌入向量。

- 答案选择模块缩小候选答案实体集,并选择最终的答案。

4.2 知识图谱嵌入模块

为所有h, t ∈ E的实体和所有r ∈ R的关系训练ComplEx嵌入,使得 e h , e r , e t ∈ C d {\mathbf{e}_{h},\mathbf{e}_{r},\mathbf{e}_{t}} \in {{\mathbb{C}}^{d}} eh,er,et∈Cd。实体嵌入用于学习头实体、问题和答案实体之间的三元组评分函数。根据知识图谱实体在QA训练集中的覆盖率,学习到的实体嵌入可以在后续步骤中选择冻结或进行微调。

4.3 问题嵌入模块

该模块将自然语言问题q嵌入到一个固定维度的向量eq中, e q ∈ C d {\mathbf{e}_{q}} \in {{\mathbb{C}}^{d}} eq∈Cd。这是通过使用一个反馈神经网络实现的,首先使用RoBERTa(Liu等人,2019)将问题q嵌入到一个768维的向量中。然后将其通过4个具有ReLU激活的全连接线性层,最后投影到复数空间 C d {{\mathbb{C}}^{d}} Cd。

给定一个问题q、主题实体h ∈ E和一组答案实体A ⊆ E,它学习问题嵌入的方式是使得

在这里,φ表示ComplEx评分函数(1),ea和

e

a

‾

e_{\overline{a}}

ea是在上一步中学习到的实体嵌入。

对于每个问题,计算分数φ(.)时会考虑到所有候选答案实体a’∈E。模型通过最小化sigmoid分数和目标标签之间的二元交叉熵损失来进行学习,其中正确答案的目标标签为1,否则为0。当实体总数很大时,进行标签平滑处理。

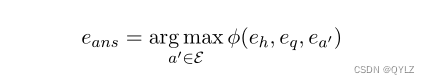

4.4 回答选择模块

在推理过程中,模型会对(头实体,问题)对和所有可能的答案a’ ∈ E进行评分。对于相对较小的知识图谱如MetaQA,我们只需选择得分最高的实体作为答案。

然而,如果知识图谱很大,修剪候选实体可以显著提高EmbedKGQA的性能。修剪策略在以下部分进行描述。

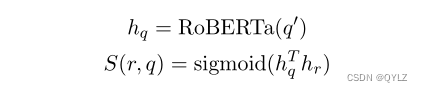

4.4.1 关系匹配

类似于PullNet(Sun等人,2019a),我们学习了一个评分函数S(r, q),用于对给定问题q的每个关系r ∈ R进行排名。令hr为关系r的嵌入向量,q’ = (< s >, w1, …, w|q|, < /s >)为问题q中的单词序列,这些单词作为输入提供给RoBERTa模型。得分函数被定义为RoBERTa最后一层隐藏层的最终输出(hq)与关系r的嵌入(hr)点积的sigmoid函数。

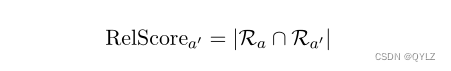

在所有关系中,我们选择那些得分大于0.5的关系,将其表示为集合Ra。对于到目前为止我们获得的每个候选实体a’(第4.4节),我们找到头实体h和a’之间最短路径中的关系。让这个关系集表示为Ra’。现在,每个候选答案实体的关系得分为它们交集的大小。

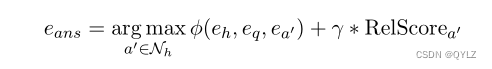

我们使用关系得分和ComplEx得分的线性组合来找到答案实体。

其中γ是一个可调的超参数。

5 实验细节

在本节中,我们首先描述了我们在其上评估我们的方法的数据集,然后解释了实验设置和结果。

5.1 数据集

- MetaQA(Zhang 等,2018)数据集是一个大规模的多跳知识图谱问答数据集,包含超过40万个与电影领域相关的问题。它包括1跳、2跳和3跳问题。在我们的实验中,我们使用了问题的“普通版”。除了问答数据外,MetaQA还提供了一个包含135,000个三元组、43,000个实体和九种关系的知识图谱。

- WebQuestionsSP(tau Yih等人,2016)是一个较小的问题回答数据集,包含4,737个问题。该数据集中的问题是1跳和2跳的问题,可以通过Free-base知识图谱来回答。为了方便实验,我们把知识库限定为Freebase的一个子集,该子集包含了所有与WebQuestionsSP问题中提到的实体在两步距离内的事实。此外,我们还进一步筛选知识库,仅包含数据集中出现的关系。这样得到的小型知识库包含180万个实体和570万个三元组。

5.2 基线

我们比较了我们的模型与键值记忆网络(Miller 等人,2016年)、嫁接网络(Sun 等人,2018年)和Pullnet(Sun 等人,2019a年)在WebQuestionsSP数据集上的表现。对于MetaQA数据集,我们还比较了VRN(Zhang 等人,2018年)。这些方法实现了多跳知识图谱问答,除了VRN外,它们还使用额外的文本语料库来缓解知识图谱稀疏性问题。

- VRN(张等,2018)使用变分学习算法来执行多跳QA(问题回答)在知识图谱上。

- 关键值存储网络(KVMem)(米勒等,2016)是最早尝试通过用文本补充不完整的知识库来进行问答的模型之一。它维护一个存储知识库事实和文本编码成键值对的记忆表,并利用这个表进行检索。

- GraftNet(孙等人,2018年)使用启发式方法创建一个问题特定的子图,其中包含知识图谱的事实、实体和文本语料库中的句子,然后使用图卷积神经网络的一个变体(Kipf和Welling,2016年)在上面进行推理。

- PullNet(孙等人,2019a)同样创建了一个与问题相关的子图,但它并没有使用启发式方法,而是通过从数据中“拉取”事实和句子来创建一个更相关的子图。它还采用了一种基于图卷积神经网络的方法来进行推理。

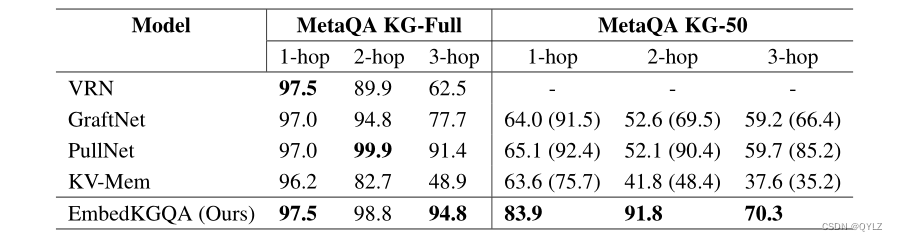

表2:在MetaQA数据集上的结果。所有基线结果均来自Sun等人(2019a)。我们考虑了完整知识图谱(MetaQA KG-Full)和50%知识图谱(MetaQA KG-50)两种设置。本表中的数字是击中率@1。括号内的数字对应于使用文本来增强不完整知识图谱的设置(MetaQA KG-50)。有关更多详细信息,请参阅第5.3.1节。

完整的知识图谱(KG)设置是问答(QA)中最简单的设置,因为数据集是以这样的方式创建的,使得答案总是在知识图谱中存在,而且路径中没有缺失的链接。然而,这不是一个现实的设置,QA模型也应该能够在不完整的知识图谱上工作。因此,我们通过随机删除知识图谱中的一半三元组来模拟不完整的知识库(我们以0.5的概率随机丢弃一条事实)。我们在文本中称这个设置为KG-50,而全知识图谱设置称为KG-全部。

在下一部分,我们将回答以下问题:

问题1:知识图谱嵌入是否可以用于执行多跳知识图谱问答?(第5.3节)

问题2:EmbedKGQA是否可以在头实体和答案实体之间没有直接路径的情况下用来回答问题?(第5.4节)

问题3:答案选择模块对于模型的最终性能有多大的帮助?(第5.5节)

5.3 知识图谱问答(KGQA)结果

在本节中,我们对我们的模型与基线模型在MetaQA和WebQuestionsSP数据集上的表现进行了比较。

5.3.1 元问答分析

元问答(MetaQA)具有针对1跳、2跳和3跳问题的不同数据集分区。在完整的知识图谱设置下(MetaQA KG-Full),我们的模型在2跳问题上与现有最先进水平相当,并在3跳问题上建立了最先进的水平。嵌入式知识图谱问答(EmbedKGQA)在处理1跳问题时表现类似于最先进的方法,这是可以预期的,因为答案节点直接连接到头部节点,并且能够从问题中学习相应的关系嵌入。另一方面,EmbedKGQA在两跳和三跳问题上的表现表明,它能够从相邻的边中推断出正确的关系,因为知识图谱嵌入可以模拟关系的组合。Pullnet和GraftNet也有类似的优秀表现,因为答案实体大多数情况下都位于问题子图中。

我们还像上一节所解释的那样,在不完整的知识图谱(KG)设置上测试了我们的方法。在这里,我们发现所有基线的准确度都比在完整知识图谱设置上显著降低,而EmbedKGQA实现了最先进的性能。这是因为MetaQA KG相当稀疏,只有43,000个实体的135,000个三元组。因此,当删除50%的三元组(如在MetaQA KG-50中所做的那样)时,图变得非常稀疏,每个实体节点平均只有1.66个链接。这导致许多问题的头实体节点到其答案节点的路径长度超过3个。因此,需要问题特定子图构建的模型(如GraftNet和PullNet)无法在生成的子图中回忆起答案实体,因此表现较差。然而,在包含额外文本语料库后,它们的性能仅有所提高。另一方面,EmbedKGQA不局限于子图,而是利用知识图谱嵌入的链接预测特性,EmbedKGQA能够推断出缺失链接上的关系。

5.3.2 对WebQuestionsSP的分析

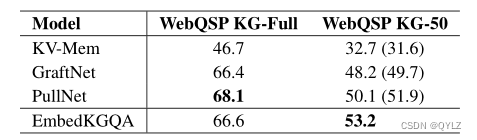

WebQuestionsSP的训练样本数量相对较少,但使用了一个大型知识图谱(Freebase)作为背景知识。这使得多跳知识图谱问答变得更加困难。由于知识图谱中的所有实体在训练集中并未全部覆盖,因此在知识图谱嵌入学习阶段(第4.2节)后冻结实体嵌入是必要的。WebQuestionsSP的结果(表3)强调了一个事实,即使只有少量的训练示例,EmbedKGQA也可以学习到良好的问题嵌入,从而推断出回答问题所需的多跳路径。

表3:在WebQuestionsSP数据集上的性能。所有基线结果均来自Sun等人(2019a)。报告的值是命中率@1。括号中的数字对应于使用文本来补充不完整的知识图谱(WebQSP KG-50)的设置。有关更多详细信息,请参阅第5.3.2节。

我们的方法在WebQSP KG-50上超越了所有基线模型,包括PullNet,它使用额外的文本信息且是当前最先进的模型。尽管WebQuestionsSP的问题数量较少,但EmbedKGQA能够学习到良好的问题嵌入向量,从而推断出知识图谱中的任务链接。这可以归因于通过知识图谱嵌入向量捕获到了相关且必要的信息,这种信息获取方式是隐含的。

5.4 针对缺失链接的知识图谱进行问答

最先进的KGQA模型,如PullNet和GraftNet,需要在知识图中存在一个从头部实体到答案实体的路径才能回答问题。例如,在PullNet中,答案仅限于提取的问题子图中存在的实体之一。对于只有原始三元组的50%存在的不完整知识图谱案例,PullNet(Sun等人,2019a)在MetaQA 1-跳数据集上的召回率为0.544。这意味着只有54.4%的问题所有答案实体都存在于提取的问题子图中,并且这限制了该模型在这种设置下可以回答多少问题。

另一方面,EmbedKGQA使用知识图谱嵌入而不是局部子图来回答问题。它使用头节点的嵌入和问题的嵌入,这在隐含地捕获了所有已观察到和未观察到的链接周围的知识。这是可能的,因为知识图谱嵌入具有链接预测属性。

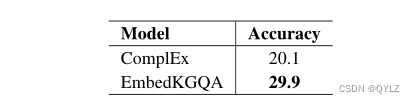

表4:在MetaQA 1-hop上的QA结果,用于没有头实体和答案实体之间链接的实验。我们已经将结果与已知问题的黄金关系的KG完成方法进行了比较。详细信息请参阅第5.4节。

因此,与其它问答系统不同,即使头部和答案实体之间没有路径,如果在知识图中提供了足够的信息以预测该路径(见图1),我们的模型也应该能够回答问题。

我们设计了一个实验来测试我们的模型的这种能力。对于MetaQA 1-hop数据集中的所有验证集问题,我们将从知识图谱中删除可以直接用于回答问题的所有三元组。例如,给定验证集中“[PK]使用什么语言”的问题,我们从KG中删除了(PK,in language,Hindi)这个三元组。该数据集还包含相同问题的释义,例如,“电影[PK]是什么语言制作的”和“电影[PK]中使用的是什么语言”。我们还将验证集中所有问题的释义从训练数据集中删除,因为我们只想评估模型的知识图谱补全属性,而不是语言概括能力。

在这种情况下,我们预计仅依赖子图检索的模型在hits@1上将达到0次命中。然而,我们的模型在这个设置下提供了显著更好的29.9次命中@1。这表明我们的模型能够捕捉到ComplEx嵌入的KG完成属性,并将其应用于回答那些原本不可能的问题。

此外,如果我们知道与每个问题相对应的关系,那么1-hop KG QA的问题就与不完整的知识图谱中的知识图谱补全相同。使用上述相同的训练KG,并将删除的三元组作为测试集,我们使用KG嵌入进行尾部预测。在这里,我们获得了20.1的命中率@1。较低的分数可以归因于ComplEx嵌入只使用了知识图谱(KG),而我们的模型还使用了问答数据(QA)-这本身代表了知识。我们的模型首先在知识图谱上进行训练,然后利用这些嵌入来训练问答模型,因此它可以利用知识图谱和问答数据中的知识。

5.5 答案选择模块的影响

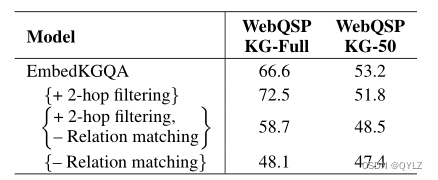

我们分析了答案选择模块(第4.4节)在WebQues-tionsSP数据集中的EmbedKGQA的影响,通过消融关系匹配模块。此外,为了与其他限制答案范围在知识图谱中邻域的方法进行比较(Sun等(2019a),Sun等(2018)),我们尝试将候选答案实体集合仅限制为头部实体的2跳邻域。结果如表5所示。我们可以看到,在WebQSP KG-full和WebQSP KG-50设置下,关系匹配对EmbedKGQA的性能有显著影响。

表5:此表显示了关系匹配模块(第4.4.1节)的重要性以及在EmbedKGQA中基于邻域过滤的效果在WebQuestionsSP数据集中的表现。EmbedKGQA本身包含了关系匹配模块。在这里,我们试图看看在答案选择过程中除去关系匹配模块和添加2跳邻域过滤的效果。有关更多详细信息,请参阅第5.5节。

此外,如前所述,WebQSP KG(Free-base子集)在实体数量上比MetaQA(1.8M与MetaQA的134k)多一个数量级,且可能的答案数量很大。因此,在WebQSP KG-Full的情况下,将答案集合缩小到头部实体的2跳邻域显示出了改进的性能。然而,这导致了在WebQSP KG-50上的性能下降。这是因为在一个不完整的知识图谱上限制答案为2跳邻居可能导致答案不在候选者中(请参阅图1)。

总之,我们发现关系匹配是EmbedKGQA的重要组成部分。此外,我们建议在EmbedKGQA的基础上,可以考虑包含n跳过滤来选择答案,这对于相当完整的知识图谱可能更有帮助。

6 结论

本文提出了一种用于多跳知识图谱问答的新型方法EmbedKGQA。知识图谱通常不完整且稀疏,这给多跳知识图谱问答方法带来了额外的挑战。近期针对这一问题的研究尝试通过利用额外的文本语料库来解决知识不完整性的问题。然而,相关文本语料库的可用性通常受到限制,从而降低了这些方法的广泛适用性。在另一条研究路线上,提出了知识图谱嵌入方法来通过进行缺失链接预测以减少知识图谱的稀疏性。EmbedKGQA利用知识图谱嵌入的链接预测特性来缓解知识图谱不完整性问题,而无需使用任何其他数据。该方法训练KG实体嵌入,并利用它来学习问题嵌入。在评估过程中,它对(头实体,问题)对再次进行所有实体的评分,最高分的实体被选为答案。EmbedKGQA还克服了现有多跳KGQA方法由于有限邻域大小约束而产生的缺点。嵌入式知识图谱问答(EmbedKGQA)在多个知识图谱问答设置中取得了最先进的性能,这表明知识图谱嵌入的链接预测特性可以被利用来缓解多跳知识图谱问答中的知识图谱不完整性问题。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?